13 июн. 2025 г.·8 мин

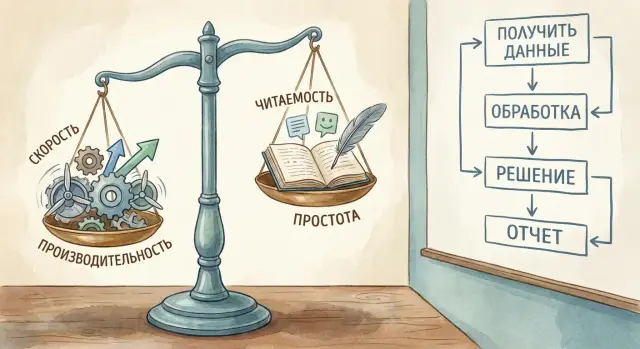

Как ИИ балансирует производительность, читаемость и простоту

Разберём, как ИИ генерирует логику приложения, балансируя скорость, читаемость и простоту: когда оптимизировать, как проверять и улучшать результат.

Разберём, как ИИ генерирует логику приложения, балансируя скорость, читаемость и простоту: когда оптимизировать, как проверять и улучшать результат.

Под «балансом» в логике приложения обычно понимают компромисс между тем, как быстро работает решение, насколько легко его читать и поддерживать, и насколько оно простое по устройству (без лишних слоёв, зависимостей и хитрых конструкций). ИИ может помочь найти этот компромисс — но только если вы заранее понимаете, что именно считаете «хорошим результатом».

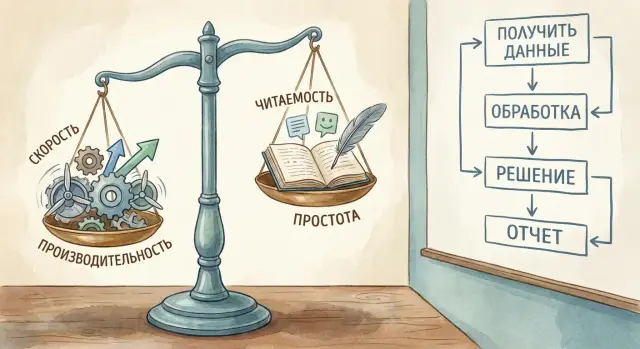

Логика приложения — это правила и шаги, по которым система принимает решения: валидация данных, расчёты, применение бизнес-правил, обработка ошибок, преобразование форматов, выбор сценария в зависимости от состояния.

Чаще всего ИИ полезен там, где нужно быстро:

Одно и то же правило можно реализовать по‑разному. Например, ради производительности добавляют кеширование, предварительные вычисления, индексы, пакетную обработку. Это ускоряет работу, но часто делает реализацию длиннее и сложнее.

А стремление к простоте может привести к прямолинейному решению: его легко читать, но оно может хуже масштабироваться на больших объёмах. Читаемость тоже иногда конкурирует с производительностью: оптимизации вроде сложных структур данных и «умных» приёмов обычно понятны меньшему числу людей.

ИИ хорошо генерирует типовые алгоритмы и аккуратные каркасы, но не всегда угадывает реальные ограничения: объёмы данных, частоту запросов, требования безопасности, нюансы домена. Поэтому результат стоит воспринимать как черновик, который вы проверяете на корректность и уместность.

Чтобы «баланс» был измеримым, заранее определите критерии:

Если вы фиксируете эти критерии в задаче, ИИ будет предлагать решения более осмысленно — и вы сможете оценивать результат не «на глаз», а по договорённости.

Когда ИИ генерирует логику приложения, он почти всегда балансирует между тремя силами: скоростью выполнения, читаемостью для людей и простотой решения. Улучшение одного параметра нередко ухудшает другой — и «идеального» варианта без контекста не существует.

Производительность важна, когда есть реальные ограничения: большие объёмы данных, частые запросы, строгие SLA. Но ускорение выполнения часто требует дополнительных структур, настроек и проверок — значит, растёт время разработки и вероятность ошибок.

Если задача не упирается в нагрузку, более простой алгоритм обычно выигрывает: его быстрее сделать, проверить и поменять. Для большинства продуктовых задач «достаточно быстро» лучше, чем «максимально быстро».

ИИ может сгенерировать очень плотный код: меньше строк, больше «умных» приёмов, сложнее цепочки преобразований. Для машины это нормально, но для команды это будущие расходы: дольше разбираться, сложнее ревью, выше риск неверных изменений.

Читаемость — это не эстетика, а снижение времени на поддержку. Часто лучший компромисс — немного больше строк, но понятные имена, явные шаги и предсказуемый поток данных.

Простота проявляется в минимуме зависимостей, ясных правилах, небольшом количестве ветвлений и точек, где можно «сломать» поведение. Простое решение легче тестировать и расширять, а ещё оно реже создаёт технический долг.

Кеширование ускоряет выполнение, но усложняет логику: нужно решать, что кешировать, когда инвалидировать, как избегать устаревших данных. Если ИИ предлагает кеш «на всякий случай», это классическая ранняя оптимизация.

Практичный критерий: сначала измерьте узкое место (хотя бы простыми метриками), затем добавляйте оптимизации точечно — так вы сохраняете и производительность, и читаемость, и простоту.

ИИ не «придумывает» архитектуру с нуля и не понимает ваш продукт так же, как команда. Он генерирует решение, собирая его из множества знакомых шаблонов, и подгоняет их под формулировку запроса.

Когда вы просите «реализовать логику», модель обычно выбирает наиболее типичный путь:

Это полезно: вы получаете предсказуемую основу. Но это же объясняет, почему ответы разных моделей часто похожи — они тянутся к «среднему» решению.

Если в запросе звучат слова вроде «масштабируемо», «расширяемо», «универсально», ИИ часто делает вывод: нужна архитектура «на вырост». Тогда появляются интерфейсы, фабрики, дополнительные уровни слоёв, конфигурации и обобщения.

Проблема в том, что модель не чувствует цену этой абстракции в вашем проекте: она не знает, как часто будет меняться логика, сколько разработчиков поддерживает модуль и какие у вас реальные точки расширения. В результате простая задача превращается в мини-фреймворк.

Самые опасные ошибки — не синтаксические, а смысловые. ИИ может:

Такие промахи трудно заметить по «красоте» реализации: всё может выглядеть аккуратно и даже покрываться простыми тестами, но нарушать реальную политику продукта.

Модель принимает решения по сигналам из контекста. Если есть ограничения (по памяти, времени ответа, зависимостям, формату данных), она будет пытаться встроить их в логику. Если ограничений нет — выберет наиболее общий вариант.

Особенно помогают примеры входов/выходов и граничные случаи: они фиксируют смысл правил лучше, чем абстрактные формулировки. А вот противоречивые требования или разрозненные фрагменты контекста заставляют ИИ «сшивать» несовместимое — и именно там чаще возникают логические расхождения.

Полезная привычка: воспринимать ответ ИИ как черновик решения и как гипотезу о правилах, а не как окончательную истину.

Качество сгенерированной логики почти всегда упирается в то, насколько точно вы задали рамки: что считать «хорошо», чем можно пожертвовать и какие ограничения нельзя нарушать. Если этого не сказать явно, ИИ будет «угадывать» приоритеты — и легко уедет либо в чрезмерную оптимизацию, либо в слишком многословное решение.

На практике это особенно заметно в vibe-coding подходе, когда вы собираете приложение через диалог: например, в TakProsto.AI удобно задавать такие рамки заранее в режиме планирования (planning mode), а затем просить платформу собрать реализацию под выбранные приоритеты и сохранить точку восстановления через снапшоты и откат.

Начните с описания контракта: какие входные данные приходят, какие выходные данные ожидаются, какие ошибки допустимы. Добавьте реалистичные ограничения по времени/памяти и объёму данных (например: «до 50 тыс. записей», «ответ ≤ 200 мс», «память ≤ 200 МБ»). Тогда ИИ будет выбирать структуры данных и алгоритмы осознанно, а не «на всякий случай».

Полезная техника — просить три решения:

Так вы получаете диапазон, а затем выбираете компромисс или объединяете подходы.

Попросите ИИ объяснить: почему выбрана именно эта структура данных, где узкие места, какие допущения сделаны. Это снижает риск скрытой сложности и помогает на код-ревью.

Сразу задайте требования к именованию, структуре файлов, формату ошибок и логированию. Например: «ошибки — с кодом и сообщением для пользователя», «функции не длиннее 30–40 строк», «побочные эффекты — только в одном слое».

Сгенерируй логику для задачи: <описание>.

Входы: <формат, примеры>.

Выходы: <формат, примеры>.

Ограничения: время <...>, память <...>, размер данных <...>.

Сделай 3 варианта: простое / читабельное / быстрое.

Для каждого: объясни ключевые решения простыми словами и перечисли компромиссы.

Стиль: <именования>, <структура>, <формат ошибок>.

Если вы формулируете задачу так, ИИ не «генерирует код», а следует вашему определению баланса — и результат легче принять в поддержку и развитие.

Оптимизация — не цель сама по себе. Для логики приложения важнее, чтобы решение оставалось понятным, проверяемым и безопасным для изменений. Если разработчик не может быстро понять, что делает участок кода и как его проверить, вы почти гарантированно заплатите «процентами» в виде багов и технического долга.

Хороший ориентир для работы с ИИ: просите не «сделай быстрее», а «сделай быстрее, не усложняя контроль». Практически это означает:

Если ради ускорения появляется сложная схема кеширования, нетривиальная синхронизация или «умная» магия — это красный флаг.

Оптимизация оправдана там, где вы бьёте по «горячим путям»:

Здесь ИИ полезно просить: «предложи 2–3 варианта и оцени сложность поддержки», а затем выбирать тот, что даёт измеримый выигрыш при минимальном росте сложности.

Чаще всего стоит отложить:

Они нередко ухудшают читаемость, добавляют точки отказа и усложняют отладку.

Договоритесь в команде о простых порогах: например, «95% запросов укладываются в N мс» или «обработка 10k элементов не дольше M секунд». Тогда ИИ можно задавать конкретную цель: «оптимизируй до порога, но не усложняй структуру», и оценка станет объективной, а не вкусовой.

Читаемость — это не «чем больше текста, тем лучше». Хороший результат можно быстро понять, объяснить коллеге и безопасно менять. Плохой — выглядит умно, но требует постоянного «вспоминания контекста».

Просите ИИ держать баланс: объяснять правила и намерение, а не пересказывать очевидное. Комментарий полезен там, где есть бизнес-условие («почему так»), а не там, где это видно из строки («увеличиваем i на 1»).

Отдельно оговорите длину: например, «функции до 20–30 строк, если больше — раздели по смысловым шагам».

Типичная ошибка — избыточные уровни абстракции: 5–7 мелких функций-обёрток, которые просто прокидывают параметры. Код становится «правильным», но по нему приходится прыгать, чтобы понять один сценарий.

Ещё одна проблема — слишком универсальные имена (processData, handleThing) и скрытые побочные эффекты (функция “validate” внезапно пишет в базу).

Попросите придерживаться практик:

calculateDeliveryFee, а не calc);Полезный формат: краткое резюме логики в начале модуля (5–8 строк) — входные данные, ключевые шаги, что возвращаем, важные ограничения.

Проверьте: можно ли понять основной поток за 1–2 минуты; нет ли «пустых» функций-слоёв; названия совпадают с доменными терминами; побочные эффекты видны; комментарии объясняют причины, а не синтаксис.

Простота в логике приложения — это не «сделать примитивно», а сделать так, чтобы поток данных был очевиден, а зависимости — минимальны и оправданы. Когда ИИ генерирует решение, его легко увлечь «умными» паттернами. Ваша задача — удержать результат в зоне, где его можно быстро понять, проверить и безопасно менять.

Обычно выигрывают базовые структуры данных и линейный сценарий: список, словарь, явные шаги обработки. Если задачу можно решить одним проходом по данным — лучше так и сделать, чем вводить цепочки посредников, фабрики и абстракции «на вырост».

Полезная формулировка для ИИ: «Сделай решение в один-два уровня вложенности, без сложных паттернов, с понятными именами, где каждый шаг — отдельная операция над данными». Так вы снижаете риск запутанного графа вызовов и неожиданных состояний.

«Магия» появляется, когда результат зависит от скрытого контекста: глобального состояния, неочевидных настроек, фоновых кешей, автоматики фреймворка, которая срабатывает «сама». ИИ может предложить такое решение, потому что оно выглядит элегантно на бумаге.

Просите явно: никакой скрытой мутации входных данных, никаких глобальных переменных, минимум синглтонов, зависимости — через параметры или явные интерфейсы. Если нужен кеш или конфигурация, пусть они будут видны в сигнатуре функций или в явной структуре контекста.

Логика должна вести себя так, как ожидает команда и пользователи: одинаковый ввод — одинаковый вывод; ошибки — предсказуемые; правила — прозрачные. Если есть исключения, их лучше оформить отдельными ветками с комментарием «почему так», чем прятать в хитрых условиях.

ИИ особенно полезен в «расчистке» логики: удалить лишние слои (например, ненужные обёртки сервисов), объединить дублирующиеся правила, вынести повторяющиеся проверки в одну функцию. Хороший запрос: «Найди дубли и сократи количество сущностей, сохранив поведение. Покажи, что именно было объединено и почему это безопасно».

Итоговый критерий простоты: новый участник команды должен проследить путь данных от входа до результата за несколько минут — без догадок о скрытых механизмах.

Даже если ИИ сгенерировал «красивую» логику, это ещё не гарантия правильности. Проверка — быстрый способ поймать ошибки до того, как они превратятся в баги у пользователей и технический долг у команды.

Пройдитесь глазами по результату и отметьте:

Этот короткий просмотр часто находит значительную часть проблем быстрее, чем запуск полноценного набора тестов.

Полезный приём — сразу запросить у ИИ набор тест-кейсов и примеры вход/выход. Формулировка может быть такой:

«Сгенерируй таблицу тест-кейсов: входные данные, ожидаемый результат, комментарий почему так. Отдельно — негативные сценарии и проверки ошибок».

Если ИИ не может уверенно описать ожидаемые результаты словами, вероятно, логика тоже «плавает».

Не обязательно начинать с идеального покрытия. Для большинства команд достаточно минимума:

Старайтесь фиксировать не «как реализовано», а что должно быть истинно. Тогда при рефакторинге тесты не будут мешать улучшениям.

Отдельно проверьте:

Сделайте 5–10 «живых» примеров и прогоните их вручную вместе с продуктом/аналитиком. Это помогает выловить ошибки трактовки требований: ИИ мог упростить так, что смысл поменялся. Если есть сомнения — зафиксируйте ожидания в виде примеров, а уже затем уточняйте промпт и просите ИИ правки.

Сгенерированная ИИ логика может быть «правильной», но оставаться непонятной команде — а значит, дорогой в сопровождении. Хорошая новость: объяснимость можно встроить в запрос и в результат, не превращая код в простыню комментариев.

Полезный приём — прямо в задаче попросить ИИ «объяснить как новичку» основную ветвящуюся логику. В идеале ответ должен содержать:

Затем это объяснение можно превратить в короткий комментарий над ключевой функцией или блоком.

Если правила (лимиты, статусы, исключения) лежат в отдельном документе, они быстро расходятся с реальностью. Лучше документировать бизнес-правила рядом с кодом: коротким блоком комментариев или докстрингом у точки принятия решения. Так при ревью и рефакторинге сразу видно, что именно нельзя «случайно улучшить».

Попросите ИИ добавлять примеры: типовые сценарии и ожидаемые результаты. Это может быть мини-таблица в комментарии или набор кейсов для тестов. Пример формулировки: «Приведи 5 сценариев входных данных и ожидаемый выход/ошибку».

Поддержка и аналитика выигрывают, когда ошибки предсказуемы. Заранее согласуйте формат ошибок и сообщений для поддержки и аналитики: коды, тексты для пользователя, технические детали (например, correlationId), и какие поля нельзя логировать. ИИ стоит просить возвращать ошибки строго по этому контракту — это снижает хаос в логах и тикетах.

Рефакторинг с ИИ удобен тем, что можно быстро «примерять» варианты. Риск в другом: модель легко делает правку, которая выглядит разумно, но незаметно меняет поведение. Поэтому цель рефакторинга — не «сделать красивее», а улучшить выбранный аспект (читабельность, простоту, производительность) при сохранении смысла.

Чаще всего встречаются:

if/else.if, которые никогда не срабатывают.Зафиксируйте поведение: коротко опишите ожидаемые входы/выходы, инварианты и крайние случаи.

Сделайте понятно: вынесите смысловые куски в функции, дайте имена, выровняйте поток данных, уберите дубли.

Проверьте измерениями: только после понятной версии ищите узкие места (профилирование, замеры времени/памяти). Оптимизация «вслепую» почти всегда добавляет технический долг.

Оптимизируйте точечно: меняйте минимальный участок, который даёт выигрыш, и сохраняйте объяснимость.

Формулируйте задачу как ограничение:

Полезно просить: «Покажи дифф-стиль изменения и кратко обоснуй каждую правку».

Перед любыми правками обеспечьте покрытие тестами (хотя бы на ключевые сценарии и регрессию). ИИ можно попросить: «Сгенерируй тесты, которые фиксируют текущее поведение, включая крайние случаи». После рефакторинга прогоните тесты и сделайте ручную валидацию критичных сценариев (особенно там, где есть права доступа, деньги, сроки или интеграции).

ИИ ускоряет работу, но не снимает ответственности с команды. Чтобы баланс производительности, читаемости и простоты не зависел от случая, полезно закрепить общий процесс: как мы принимаем изменения, как проверяем риски и кто финально «владеет» решением.

Если вы собираете приложение на TakProsto.AI (React на фронтенде, Go + PostgreSQL на бэкенде, Flutter для мобильных клиентов), эти договорённости особенно важны: платформа может быстро довести идею до работающего прототипа, но качество логики всё равно определяется вашими критериями, тестами и ревью. Плюс полезные практики вроде экспорта исходников, деплоя/хостинга, кастомных доменов и снапшотов с откатом хорошо ложатся на процесс «сначала корректно и понятно — потом оптимизируем».

Перед тем как принять сгенерированную (или частично сгенерированную) логику, пройдитесь по базовым пунктам:

Если хотя бы один пункт вызывает сомнения — лучше попросить ИИ перегенерировать фрагмент с уточнениями или сделать ручной рефакторинг до мерджа.

Финальная ответственность всегда на человеке: автор PR и ревьюер подтверждают, что понимают логику и готовы поддерживать её дальше. Хорошая практика — добавлять в PR короткое резюме: что изменилось, какие инварианты важны, как проверяли.

Есть случаи, где цена ошибки слишком высока:

Зафиксируйте в командном документе (и используйте в промптах) минимальный набор стандартов:

Так вы превращаете ИИ из «случайного автора» в управляемый инструмент, который работает в рамках ваших ожиданий. А если вы ещё и делитесь внутренними практиками и примерами промптов, многие платформы (включая TakProsto.AI) поощряют это через программы: можно получать кредиты за контент или приглашения по реферальной ссылке — удобно, когда вы системно выстраиваете процесс вокруг качества, а не вокруг разовых генераций.

«Баланс» — это компромисс между:

Правильный баланс зависит от контекста: данных, SLA, частоты изменений и состава команды.

Потому что усиление одного параметра часто ухудшает другие:

ИИ чаще всего полезен для:

Но результат стоит воспринимать как черновик, который вы проверяете на смысл и ограничения.

Реалистичные ожидания такие:

Всегда закладывайте время на ревью и тестирование.

Дайте модели контракт и рамки:

Чем точнее рамки, тем меньше «угадывания» и лишней абстракции.

Попросите сразу 3 реализации:

Затем сравните компромиссы и выберите вариант под текущие метрики и поддержку.

Красные флаги:

Практика: попросите ИИ перечислить, зачем каждый слой нужен, и что будет, если его убрать.

Попросите:

Если ожидаемый результат трудно сформулировать словами — высок риск смысловой ошибки.

Оптимизация оправдана, когда есть измеримая боль:

Сначала замерьте (хотя бы тайминг/профиль), затем оптимизируйте точечно. Избегайте микрооптимизаций без метрик.

Минимальный практичный набор:

Цель — фиксировать «что должно быть истинно», а не детали реализации.