19 апр. 2025 г.·8 мин

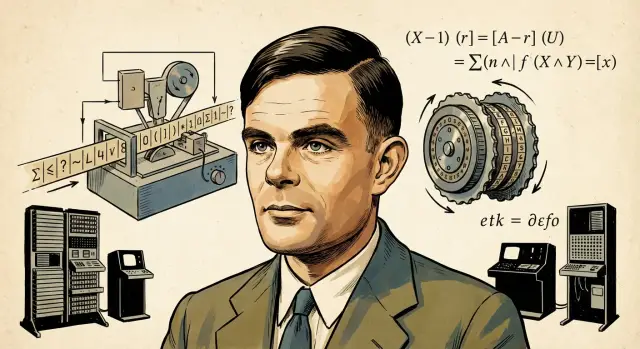

Алан Тьюринг и пределы вычислений: безопасность и ИИ

Разбираем идеи Алана Тьюринга: машина Тьюринга, проблема остановки и границы вычислений — и как это влияет на безопасность, криптографию и ИИ.

Разбираем идеи Алана Тьюринга: машина Тьюринга, проблема остановки и границы вычислений — и как это влияет на безопасность, криптографию и ИИ.

Алан Тьюринг — один из тех людей, чьи идеи «прошили» современную информатику на уровне базовых понятий. Он не просто решал отдельные инженерные задачи, а предложил язык, на котором удобно говорить о вычислениях вообще: что считается алгоритмом, что можно посчитать принципиально, а где существуют непреодолимые ограничения.

Эта статья — о том, как несколько идей Тьюринга связывают воедино три, на первый взгляд, разные темы: вычислимость, безопасность и машинный интеллект. Разберём, почему некоторые задачи нельзя решить «идеальной программой», почему криптография опирается на ограничения по ресурсам и почему разговоры об ИИ часто упираются не в фантазию, а в строгие границы вычислений.

Математика здесь будет в роли фонарика, а не экзамена. Почти каждую идею можно понять через бытовые аналоги:

Если вам важнее интуиция, чем формулы, ориентируйтесь на примеры и выводы — этого достаточно, чтобы уловить суть.

Ниже — короткий словарик (мы будем возвращаться к этим словам по ходу текста):

До появления строгих моделей «вычисление» понимали довольно широко. Это мог быть бухгалтерский расчёт, ручное составление таблиц навигации, работа «компьютеров» — людей, которые по инструкции шаг за шагом выводили числа, или использование механических счётных машин. Важнее всего было, чтобы метод работал на практике, а не чтобы его можно было строго описать и доказать.

Проблема началась там, где интуитивных «рецептов» стало недостаточно. Если два математика описывают процедуру разными словами, как понять, что это один и тот же метод? Можно ли проверить, что шаги не оставляют места для догадок? И главное — как сравнивать разные процедуры по возможностям.

Формальное понятие алгоритма решает сразу несколько задач:

В 1930-х логика стала инструментом, который связал вычисления с доказательствами. Возникла идея: «посчитать» — значит выполнить конечную последовательность элементарных действий по правилам. Тьюринг предложил предельно простой, но строгий способ зафиксировать эти правила. Это не про удобство записи, а про возможность доказать, что именно считается допустимым вычислением.

Как только у вас есть формальная модель, можно задавать вполне инженерные вопросы: существуют ли задачи, для которых никакая программа не может гарантированно дать ответ? Можно ли в принципе автоматически проверять программы на ошибки?

Эти границы важны для разработки ПО, безопасности и ИИ: они заранее показывают, где невозможна «идеальная автоматизация», а где придётся полагаться на приближения, ограничения области и проверки частных случаев.

Машина Тьюринга — это мысленная модель компьютера, придуманная не для железа, а для точного ответа на вопрос: что значит «выполнить алгоритм»? Она нарочно предельно простая, но при этом удивительно выразительная.

Представьте три вещи:

Любой алгоритм можно разложить на элементарные операции: прочитать вход, принять решение по условию, записать промежуточный результат, повторить шаги. Машина Тьюринга делает ровно это — просто в минималистичном виде.

Важно, что у неё есть вход (начальная запись на ленте), выход (то, что остаётся на ленте, когда машина остановится) и пошаговое выполнение: каждое правило — один чётко определённый шаг. Никакой «магии», только последовательность формальных действий.

Эта модель помогает говорить об алгоритмах строго: что именно дано на входе, какие шаги допустимы и когда процесс считается завершённым.

Обычная машина Тьюринга решает одну задачу: она «заточена» под конкретный алгоритм, как калькулятор под фиксированный набор операций. Но самый сильный ход Тьюринга — идея универсальности: можно описать такую машину, которая умеет имитировать любую другую, если ей дать описание той «другой» и входные данные.

Универсальная машина — это не «самая мощная» машина с бесконечными возможностями, а аккуратный принцип: поведение можно задавать не железом, а описанием. Сегодня мы назвали бы это программой.

Отсюда растёт понятие компьютера общего назначения: один и тот же процессор может считать налоги, проигрывать музыку или шифровать файлы — разница не в устройстве, а в инструкции, которую вы ему передали.

Чтобы универсальность работала, «описание машины» нужно представить в том же виде, что и обычные данные на ленте. Это ключевой поворот: программа становится данными.

Практическое следствие мы видим повсюду:

Если программа — это данные, то язык программирования можно понимать как формат записи таких данных, а интерпретатор — как универсальную «машину», которая читает этот формат и выполняет шаги.

Интуитивно: написав интерпретатор языка A на языке B, вы не «пересобираете компьютер», а просто добавляете новый способ описывать вычисления. Эта гибкость объясняет, почему вокруг нас так много языков, сред выполнения и переносимых форматов.

Кстати, этот же принцип «один движок — много задач через описание» хорошо видно и в современных продуктах для разработки. Например, TakProsto.AI использует чат как способ задавать «инструкцию» системе: вы формулируете задачу словами, а платформа собирает приложение (веб на React, бэкенд на Go с PostgreSQL, мобильные клиенты на Flutter) и позволяет управлять изменениями через planning mode, снимки и откат. Это не отменяет теорию вычислимости — но заметно сокращает путь от идеи до рабочего прототипа.

Когда говорят «задача вычислима», имеют в виду не скорость и не удобство, а сам факт: существует ли вообще алгоритм, который для любого входа когда‑нибудь выдаст правильный ответ.

Простой пример: «отсортировать список контактов по фамилии» — вычислимо, и алгоритмов много. Но «найти самый короткий маршрут по городу с учётом всех пробок за год вперёд» тоже может быть вычислимо в теории, однако на практике станет слишком долгим или потребует слишком много данных. В этом разделе важен только принцип: существует ли рецепт, а вопрос «успеем ли посчитать» оставим теме про ограничения по ресурсам.

Бытовая аналогия перечислимости: «есть ли в бесконечной ленте видеозаписей момент, где человек произносит конкретную фразу?» Если фраза есть, её можно однажды обнаружить при просмотре. Если нет — просмотр может тянуться бесконечно.

Тьюринг показал, что существуют задачи, для которых не может существовать универсального алгоритма, каким бы мощным ни был компьютер. Причина не в «слабом железе», а в логическом противоречии, возникающем при попытке построить такой алгоритм. Классический пример — вопросы о поведении произвольных программ.

Результаты про вычислимость полезны как «санитарный контроль» требований:

Понимание границ вычислимости помогает заранее отличить сложную задачу от невозможной — и не закладывать в проект невыполнимые обещания.

Представьте, что у вас есть программа и входные данные к ней. Вопрос звучит просто: завершится ли программа когда-нибудь или будет выполняться бесконечно?

Важно, что речь не о «зависла ли она сейчас», а о принципиальной возможности заранее ответить для любой программы и любого входа. Для калькулятора ответ очевиден, а для сложного сервиса с циклами, рекурсией, сетевыми запросами и обработкой исключений — уже нет.

Тьюринг показал, что не существует идеального алгоритма-проверяльщика, который всегда корректно отвечает «остановится/не остановится».

Идея доказательства — от противного. Допустим, что существует некая программа H, которая получает на вход код любой программы P и данные x и без ошибок говорит, остановится ли P(x).

Тогда можно сконструировать программу D, которая делает наоборот: берёт программу P, спрашивает у H, остановится ли P(P), и если H говорит «остановится» — D уходит в бесконечный цикл, а если «не остановится» — D сразу завершает работу.

Теперь подадим D саму на себя: D(D). Получается логическое противоречие в обоих вариантах ответа H. Значит, H в принципе не может существовать.

Это не означает, что анализ программ бесполезен. Это означает: не бывает инструмента, который для любого кода гарантированно найдёт все ошибки и при этом никогда не ошибётся.

В терминах безопасности это особенно важно для проверок на уязвимости: некоторые классы проблем алгоритмически «всеобщо» не распознаются.

Практические анализаторы выбирают компромисс:

Поэтому в реальности качество достигается сочетанием подходов: статический анализ + тесты + ревью + мониторинг в продакшене, а не ожиданием мифического «идеального отладчика».

Иногда задача в принципе решаема: существует алгоритм, который всегда даёт правильный ответ. Но это ещё не значит, что её реально решить на вашем компьютере — или даже на всех компьютерах человечества. Тут и начинается разговор не про «возможно/невозможно», а про «успеем ли мы за разумное время и влезем ли в доступную память».

«Невозможно» в строгом смысле — это когда не существует алгоритма, который гарантированно решит задачу для всех входов. А «очень долго» — когда алгоритм есть, но ресурсы растут так быстро, что на практике решение становится недостижимым.

Представьте два сценария. В первом время растёт линейно: вход увеличили в 2 раза — времени нужно примерно в 2 раза больше. Во втором время растёт экспоненциально: добавили всего несколько символов ко входу — а время увеличилось в тысячи и миллионы раз. Формально оба алгоритма «работают», но экспоненциальный быстро становится бесполезным.

Сложность — это способ описать, как меняются время и память при увеличении размера входных данных. Важно именно «поведение на больших размерах»: маленькие примеры часто обманчивы.

Ключевая мысль: разница между ростом n² и ростом 2ⁿ — это разница между «чуть медленнее» и «никогда не дождёмся». Поэтому в инженерных решениях постоянно задают вопрос: какой размер входа будет у нас в реальности и как алгоритм поведёт себя именно там.

Кибербезопасность часто опирается не на невозможность атаки, а на её непрактичность. Например, перебор ключа шифрования — вычислимая задача: если пробовать все варианты, правильный ключ когда-нибудь найдётся. Но при достаточно большом ключе «когда-нибудь» превращается в сроки, превышающие ценность добытых данных.

Отсюда правило: защищённость — это про экономику атаки. Если злоумышленнику нужны годы работы и огромные бюджеты, атака теряет смысл.

На практике размеры ключей и лимиты подбирают по оценкам:

Поэтому корректнее говорить не «невзламываемо», а «невыгодно взламывать при текущих предположениях». Это и есть граница по ресурсам: задача вычислима, но её цена становится неприемлемой.

Во время Второй мировой войны Тьюринг работал в Блетчли-парке — центре британского криптоанализа. Задача команды была не «угадать пароль», а системно взламывать поток перехваченных сообщений, зашифрованных машиной «Энигма».

Ключевой подход: использовать известные закономерности в сообщениях (типовые фразы, форматы отчётов, служебные маркеры) и превращать их в проверяемые гипотезы о настройках шифра. Дальше эти гипотезы проверялись механически — с помощью электромеханических устройств (в том числе «бомб»), которые быстро перебирали варианты и отсеивали невозможные.

Успех был не одной «гениальной идеей», а связкой дисциплин:

Модель угроз важнее моды на инструменты. Защитные меры работают только против конкретных сценариев атак.

Операционная дисциплина — часть криптографии. Ошибки людей, шаблоны, повторения и слабые процедуры часто «ломают» систему раньше, чем математика.

Проверяемые предположения. Хорошая защита строится на том, что можно тестировать: логирование, воспроизводимые проверки, регулярные упражнения (red team/blue team).

Истории про Блетчли-парк часто превращают работу в легенду о «единственном герое» или «волшебной машине». Реальность прозаичнее и полезнее: много людей, много итераций, строгие эксперименты и постоянное улучшение методов. Именно эта комбинация и дала результат — и именно её стоит переносить в кибербезопасность сегодня.

Идеи Тьюринга важны для безопасности не только как «теория». Они объясняют, почему поиск уязвимостей и проверка программ имеют фундаментальные пределы: невозможно построить универсальный анализатор, который для любой программы и любого входа гарантированно скажет «ошибок нет» и при этом всегда будет работать.

Сканеры, статический анализ и средства поиска вредоносного поведения неизбежно сталкиваются с компромиссом: либо они пропускают часть проблем (ложные отрицания), либо «поднимают тревогу» там, где всё нормально (ложные срабатывания). Это не «плохие инструменты», а следствие того, что поведение произвольной программы нельзя исчерпывающе предсказать во всех случаях.

В общем случае доказать корректность всего ПО невозможно, но реально:

Отсюда практические идеи: песочницы для запуска недоверенного кода, изоляция процессов и окружений, минимизация прав, принцип наименьших привилегий, строгие границы между компонентами. Если модуль взломан, он не должен автоматически получать доступ ко всему.

На практике лучше работает комбинация:

Ограничения вычислений подсказывают главный принцип защиты: рассчитывать не на идеальную проверку, а на грамотное управление риском и ущербом.

Тест Тьюринга часто описывают как «проверку, может ли машина думать», но в исходной постановке он гораздо конкретнее: может ли машина в диалоге убедительно имитировать человека так, чтобы судья не смог надёжно отличить одно от другого.

Тест фиксирует качество поведения в коммуникации: связность ответов, умение поддерживать контекст, находить правдоподобные объяснения. Но он не гарантирует ни «сознания», ни внутреннего понимания, ни устойчивой компетентности во всех областях. Система может хорошо выглядеть в разговоре и при этом ошибаться в логике, математике или фактах.

Ключевая развилка в интерпретациях: можно ли считать интеллектом способность правдоподобно действовать, даже если внутри — лишь правила и статистические закономерности? В прикладном смысле мы часто оцениваем систему по результату: помогла ли она пользователю, решила ли задачу. Но философски «похоже на понимание» не равно «понимает».

Любая оценка ИИ — это выбор сценария: диалог, поиск, диагностика, написание текста, планирование. Поменяйте метрику (точность, безопасность, полезность, устойчивость к провокациям) — и «лучший» ИИ тоже изменится. Поэтому тест Тьюринга — не универсальная линейка, а один из возможных режимов проверки.

Идея универсальной вычислительной машины подсказывает важный принцип: один и тот же механизм может выполнять разные задачи, если дать ему подходящую «инструкцию» (программу). Современные «общие» модели похожи этим духом: одна система способна вести диалог, суммировать текст, помогать с кодингом — но качество всё равно определяется тем, как именно сформулирована задача и чем система ограничена.

Идеи Тьюринга про границы вычислений хорошо объясняют, почему в реальном ИИ почти никогда нет «идеального алгоритма на все случаи». Проблема часто не в том, что инженеры «плохо постарались», а в самой постановке: часть задач не имеет точного решения за разумное время, часть — принципиально не допускает универсальной проверки, а часть зависит от данных и контекста, которые невозможно полностью формализовать.

ИИ обычно работает не как математическое доказательство, а как система, которая старается быть полезной при ограничениях по времени, памяти, стоимости вычислений и качестве данных. Поэтому вместо абсолютной гарантии появляются вероятности, пороги уверенности, допуски на ошибку и правила обработки исключений.

На практике используют подходы, которые дают хороший результат «в среднем» или «достаточно часто»:

Любая система балансирует несколько целей: точность ↔ скорость, интерпретируемость ↔ качество, безопасность ↔ удобство, универсальность ↔ устойчивость к редким сценариям. Например, более «понятная» модель может проигрывать по метрикам, а более точная — быть сложнее в аудите и защите.

Если продукт заявляет, что он «всегда правильно распознаёт», «полностью исключает риски» или «гарантирует отсутствие ложных срабатываний», попросите показать:

Практичный взгляд на ИИ — это не магия, а управляемые компромиссы и честные границы применимости.

Идеи Тьюринга полезны не как музейная теория, а как «проверка реальности» для любых проектов: что вообще можно автоматизировать, где вас подстерегают принципиальные ограничения, и почему некоторые обещания (например, «мы найдём все баги автоматически») невыполнимы в общем случае.

Если переносить этот чек-лист в прикладную разработку, полезно, когда платформа поддерживает управляемые изменения и быстрый откат. Например, в TakProsto.AI есть снимки и rollback, а также экспорт исходников: это упрощает итерации (в том числе при экспериментах с ИИ‑функциями), не создавая иллюзии, что «автоматизация всё проверит за вас».

Если хочется продолжения в прикладном ключе, загляните в другие материалы: /blog/what-is-static-analysis, /blog/cryptography-basics и /blog/secure-software-checklist.

Это способ говорить об алгоритмах строго: существует ли вообще процедура, которая для любого входа даст правильный результат.

Практически это помогает отличить:

Машина Тьюринга — минималистичная модель вычислителя: лента (память), головка чтения/записи и таблица правил.

Её ценность в том, что на ней удобно доказывать свойства алгоритмов и ограничения: если что-то невозможно даже для машины Тьюринга, то это невозможно и для реального компьютера (дело не в «железе», а в логике задачи).

Универсальная машина — это идея «одна машина исполняет описание другой машины». То есть поведение задаётся не конструкцией устройства, а программой.

Отсюда растут:

Потому что существует принципиальный предел: нельзя создать программу, которая для любой другой программы и любых данных всегда верно ответит, завершится ли выполнение.

Практический смысл не в том, что «анализ невозможен», а в том, что любой анализатор вынужден выбирать компромисс:

Проблема остановки говорит о фундаментальном ограничении для «всех программ». Поэтому в общем виде нельзя гарантировать: «найдём все уязвимости и докажем отсутствие багов».

Что реально работает в инженерии безопасности:

«Вычислимо» означает: алгоритм существует. Но он может быть настолько дорогим по времени/памяти, что в реальности неприменим.

Для продукта это означает, что нужно смотреть не только на корректность, но и на рост затрат при увеличении входа (сложность): иногда небольшое увеличение данных делает расчёт практически невозможным.

Многие схемы защиты опираются не на «невозможность» атаки, а на её невыгодность по ресурсам: перебор ключа теоретически возможен, но должен быть слишком дорог.

Практика выбора параметров обычно учитывает:

Главный урок — криптоанализ это сочетание:

В современной безопасности это напрямую перекладывается на практики: модель угроз, воспроизводимые проверки, логирование, регулярные учения red team/blue team.

Тест Тьюринга проверяет, насколько система может убедительно вести диалог так, чтобы её было трудно отличить от человека.

Он не гарантирует:

Поэтому его стоит воспринимать как один сценарий оценки, а не как универсальную линейку интеллекта.

Полезные вопросы, которые стоит задавать себе в проекте:

Для углубления можно начать с материалов по ссылкам: /blog/what-is-static-analysis, /blog/cryptography-basics, /blog/secure-software-checklist.