12 апр. 2025 г.·8 мин

Аутентификация и авторизация в современных фреймворках

Разбираем, как современные фреймворки реализуют вход и контроль доступа: сессии и JWT, OAuth/OIDC, роли и политики, защита и типичные ошибки.

Разбираем, как современные фреймворки реализуют вход и контроль доступа: сессии и JWT, OAuth/OIDC, роли и политики, защита и типичные ошибки.

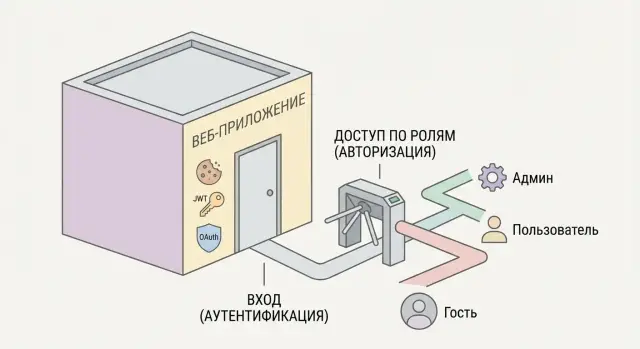

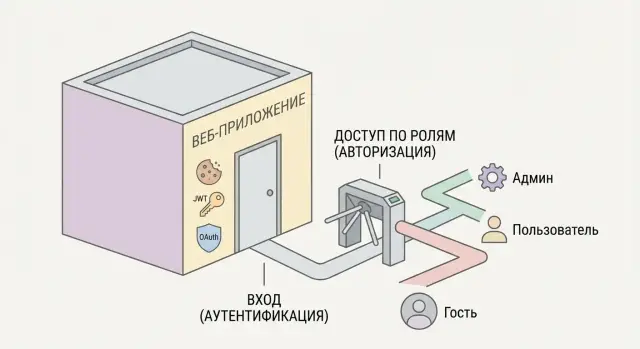

Аутентификация и авторизация часто звучат рядом, но отвечают на разные вопросы.

Аутентификация — это «кто вы». Система проверяет вашу личность: логин/пароль, одноразовый код, ключ в приложении‑аутентификаторе, вход через провайдера и т. п. Результат обычно бинарный: пользователь подтверждён или нет.

Авторизация — это «что вам можно». После того как система поняла, кто вы, она решает, какие действия разрешены: читать документ, менять настройки, удалять запись, просматривать чужие данные.

Фреймворкам выгодно давать эти механизмы «из коробки», потому что проверки должны быть единообразными и централизованными. Если каждая команда или каждый контроллер будет реализовывать проверки по‑своему, неизбежно появятся дырки: забыли проверить роль, перепутали условия, не учли новый тип пользователя.

Встроенные компоненты помогают сделать «единую точку контроля»: один и тот же способ проверять вход, права и доступ к маршрутам/эндпоинтам. Это снижает риск ошибок и упрощает поддержку.

Практически в любом современном фреймворке вы встретите одинаковые «кирпичики»:

Важно: сессия/токен не «дают права» сами по себе. Они лишь подтверждают, что запрос связан с конкретным пользователем; права определяются отдельными правилами.

В доках названия отличаются, но смысл похож:

Если вы видите эти слова в руководстве, ищите ответы на два вопроса: как система узнаёт пользователя и где именно проверяются права (в маршрутах, контроллерах, политиках или на уровне данных).

Большинство современных фреймворков предлагают готовый «скелет» для входа: маршруты, контроллеры/обработчики, шаблоны форм и набор проверок. Даже если вы пишете всё вручную, типовой поток почти всегда одинаковый.

Форма обычно собирает идентификатор (email/логин) и пароль, а сервер принимает данные и сравнивает их с записью пользователя.

Важный момент: пароль не хранят «как есть». Фреймворки и их библиотеки используют хеширование с солью, чтобы в базе лежал только результат вычисления, а не исходный пароль. На практике это выглядит так: при регистрации/смене пароля фреймворк вызывает функцию хеширования и сохраняет хеш; при входе — хеширует введённый пароль тем же способом и сравнивает.

После успешной проверки фреймворк создаёт контекст пользователя для текущего запроса и последующих запросов. Обычно это:

За счёт этого бизнес‑логика не должна каждый раз заново искать пользователя и проверять пароль: она опирается на уже сформированный контекст.

«Из коробки» часто есть сценарии: запрос на восстановление, генерация одноразовой ссылки/кода, ограничение времени действия и финальная установка нового пароля. Подтверждение email похоже: создаётся токен подтверждения и отправляется письмо; до подтверждения аккаунт может быть ограничен (например, запрет на вход или на критичные действия).

Чтобы защититься от перебора, фреймворки или популярные плагины добавляют rate limit: лимит попыток на IP/аккаунт, задержки после ошибок, временные блокировки и журналирование подозрительной активности. Обычно это настраивается параметрами, а не переписыванием логики входа.

Сессионная (stateful) модель — это когда после успешного входа сервер создаёт запись «сессия» и выдаёт браузеру cookie с идентификатором (session id). При каждом запросе браузер автоматически отправляет cookie, а приложение по этому идентификатору находит данные сессии на сервере (в памяти, базе, Redis) и понимает, кто пользователь.

Сервер хранит минимум: id пользователя, время жизни, признаки «прошёл ли MFA», возможно — CSRF‑токен и список активных устройств. Cookie при этом настраивается так, чтобы его было сложнее украсть или использовать не по назначению: HttpOnly, Secure, SameSite, корректный Domain/Path и разумный Max-Age.

Главное удобство — отзыв доступа. Достаточно удалить или инвалидировать сессию на сервере, и пользователь сразу «вылетит» (или потеряет доступ к чувствительным операциям). Это хорошо работает для личных кабинетов, админок и любых браузерных приложений, где важен контроль устройств.

Сессии нужно где-то хранить и обслуживать. При масштабировании (несколько инстансов приложения) либо включают «липкие» сессии на балансировщике, либо выносят хранилище в общий слой (часто Redis). Плюс есть риск ошибок в настройках cookie (слишком широкий домен, отсутствие Secure, неверный SameSite), что влияет на безопасность и стабильность.

Сессии обычно выбирают для классических веб‑приложений с браузером и серверным рендерингом/SPA, где важны простота отзыва и единая точка контроля.

Токены чаще удобнее для API, мобильных клиентов и интеграций между сервисами, где нет «браузерной магии» с cookie и нужно легко прокидывать авторизацию между доменами или клиентами.

Токенная аутентификация удобна там, где «классические» сессии и cookie работают хуже: в REST/GraphQL API, мобильных клиентах, SPA, интеграциях между сервисами. Клиент получает токен после входа и затем отправляет его с каждым запросом (обычно в заголовке Authorization: Bearer …). Сервер не обязан хранить состояние сессии на своей стороне — это упрощает масштабирование.

JWT (JSON Web Token) — это компактный токен, который содержит набор утверждений (claims) и подписан сервером. Внутри часто лежат идентификатор пользователя, время жизни (exp), идентификатор токена (jti), иногда — роли/права. Важно: JWT — не «шифрование», а в типовом варианте подпись. Любой, кто получил токен, может прочитать его содержимое.

На практике почти всегда используют пару:

Так уменьшается ущерб при утечке access‑токена: он быстро «протухнет».

Место хранения влияет на риск XSS/CSRF:

SameSite, Secure.Фреймворки обычно дают готовые middleware/настройки для обоих вариантов.

JWT «сам по себе» сложно отозвать до истечения срока, поэтому используют:

jti по списку отозванных токенов, если нужен жёсткий logout.Многие библиотеки аутентификации в современных фреймворках поддерживают эти паттерны из коробки: стратегии bearer, валидацию подписи/exp, хранилище refresh‑токенов и автоматическую ротацию.

Вход «через Google/Apple/GitHub» обычно построен на стандартах OAuth 2.0 и OpenID Connect (OIDC). Это не «магия кнопки», а протоколы, которые позволяют вашему приложению доверять внешнему провайдеру и при этом не хранить у себя чужие пароли.

OAuth 2.0 решает задачу делегирования: пользователь подтверждает, что ваше приложение может получить доступ к определённым данным или действиям в сервисе провайдера (например, прочитать профиль или список репозиториев). Важно: OAuth сам по себе не гарантирует «кто именно пользователь» — он описывает, как получить access token для обращения к API.

Типовые сценарии OAuth:

OIDC добавляет к OAuth слой идентификации. Вместе с токенами доступа появляется ID Token (часто в формате JWT), который содержит утверждения (claims) о пользователе: идентификатор, время аутентификации, иногда email и т. п. Именно OIDC обычно используют, когда цель — «войти» и получить подтверждённую личность.

Современные фреймворки обычно предлагают адаптеры/драйверы/плагины: вы задаёте client_id, client_secret, redirect URI и набор scopes, а библиотека берёт на себя редиректы, обмен кода на токены и базовую валидацию. На вашей стороне остаётся главное: связать внешний идентификатор с локальным пользователем, правильно обрабатывать обновление токенов и хранить их безопасно.

Почти все современные фреймворки стремятся вынести проверки доступа из бизнес‑логики в отдельный слой. В веб‑стеке он обычно называется middleware (промежуточный обработчик), а в некоторых экосистемах — guards, фильтры, interceptors или policy‑handlers. Суть одна: запрос проходит через цепочку проверок до того, как попадёт в контроллер.

Проверка может выполняться:

/admin);Так вы получаете «единую точку», где видно, что именно защищено и чем.

Хорошая практика — по умолчанию считать маршруты публичными и явно помечать защищённые, либо наоборот (secure-by-default). Важно, чтобы правило было единообразным: разработчик должен сразу понимать, почему /login доступен всем, а /profile — только после входа.

Аутентификация отвечает на вопрос «кто ты?» — middleware/guard может восстановить пользователя из cookie/токена и положить его в контекст запроса.

Авторизация — «что тебе можно?» — отдельный guard проверяет роль/политику/право на действие. Разделяйте эти шаги: иначе легко сделать эндпоинт, который требует входа, но забывает проверить конкретное право (например, доступ к чужому ресурсу).

Чтобы не размазывать проверки по контроллерам:

Итог — меньше повторов, проще ревью и ниже шанс пропустить критическую проверку.

Выбор модели контроля доступа определяет, насколько просто вам будет управлять правами, объяснять их бизнесу и сопровождать систему со временем. В современных фреймворках обычно поддерживаются несколько подходов — и их нередко комбинируют.

RBAC (Role-Based Access Control) строится вокруг ролей: «админ», «редактор», «просмотр». Пользователю назначается роль, а роли — набор разрешений (например, users.read, posts.edit).

Плюс RBAC — понятность и предсказуемость: легко выдать доступ группе людей и быстро провести аудит «кто что может». Минус — роли начинают разрастаться, когда нужны тонкие исключения: «редактор может править только свои материалы» или «в отделе продаж можно видеть только сделки своего отдела».

ABAC (Attribute-Based Access Control) опирается не на роли, а на атрибуты: пользователя (отдел, должность), ресурса (владелец, статус), контекста (время, канал, регион). Правило выглядит как условие: «можно читать документ, если отдел совпадает и статус не “архив”».

ABAC гибче RBAC и лучше подходит для сложных бизнес‑правил, но требует дисциплины: единых атрибутов, понятных правил и хорошего тестирования, иначе условия быстро становятся трудно читааемыми.

Многие фреймворки оформляют авторизацию через политики (policies) или «правила» вокруг конкретных объектов: canEdit(post, user). Это удобно для resource-based подхода: решение зависит от конкретного ресурса (владелец, состояние, принадлежность проекту).

На практике проверки обычно размещают:

Хорошее правило: базовые ограничения (роль, факт входа) — ближе к входу в запрос, а тонкие решения по данным — в политиках рядом с моделью ресурса.

Авторизация «в целом» (например, «пользователь — админ») часто недостаточна. В реальных приложениях важен контекст: к какому конкретному ресурсу идёт доступ и какие действия разрешены над ним. Цель — чтобы пользователь видел и менял только то, что ему действительно положено.

Считайте нормой правило: запрещено всё, что явно не разрешено. Разрешения выдаются минимальные — только на нужные экраны, операции и данные. Это снижает ущерб от ошибок и компрометации аккаунта: даже если злоумышленник вошёл, его возможности ограничены.

Одна и та же сущность (например, «заказ») обычно требует разных прав на действия: чтение/создание/изменение/удаление. Хороший шаблон — проверять доступ не просто к маршруту, а к операции:

read:order — просмотр;create:order — создание;update:order — изменение;delete:order — удаление.Это удобно реализуется через политики/правила в фреймворке (policy/guard), чтобы проверки были единообразными и не размазывались по контроллерам.

Самая надёжная защита — когда ограничения применяются в запросе к базе, а не «после того как данные уже получены». Для мультиарендности (multi-tenant) типичный приём: всегда добавлять фильтр по organization_id или owner_id, чтобы запрос физически не мог вернуть чужие записи.

IDOR (Insecure Direct Object Reference) появляется, когда пользователь может подставить чужой идентификатор в URL или тело запроса (/orders/123) и получить доступ «потому что запись существует».

Профилактика:

Аутентификация редко «ломается» из‑за самой формы логина. Чаще проблемы появляются вокруг: браузер автоматически прикрепляет cookie, фронтенд ходит в API с другого домена, а злоумышленник пытается подобрать пароль. Современные фреймворки закрывают многое по умолчанию, но настройки всё равно важно понимать.

CSRF (межсайтовая подделка запроса) актуальна прежде всего для схемы «сессия + cookie», потому что браузер сам отправляет cookie на ваш домен. Если пользователь уже вошёл, вредоносная страница может попытаться заставить браузер выполнить запрос (например, сменить email) — и сервер увидит «валидную» сессию.

Типичная защита — CSRF‑токен: сервер выдаёт уникальный маркер, а клиент обязан отправлять его в каждом изменяющем запросе (POST/PUT/PATCH/DELETE). Фреймворки обычно проверяют токен в middleware.

Правильные флаги cookie уменьшают риск атак и утечек:

CORS — это защита браузера, а не сервера. Ошибка — «разрешить всё» (Access-Control-Allow-Origin: *) и одновременно включить отправку cookie/учётных данных. Если API предназначено для вашего фронтенда, задавайте точный список origin, разрешённые методы и заголовки, корректно обрабатывайте preflight (OPTIONS) и не возвращайте лишние заголовки.

Для эндпоинтов логина и восстановления пароля почти всегда нужен rate limiting: ограничение попыток по IP, по аккаунту и по «отпечатку» устройства. Частая практика — экспоненциальные задержки и временная блокировка после N ошибок.

Важно: сообщения об ошибках не должны раскрывать, существует ли пользователь («неверный логин или пароль» вместо «пользователь не найден»), а события блокировок и превышения лимитов стоит логировать для расследований.

Многофакторная аутентификация (MFA/2FA) добавляет «второй замок» поверх пароля: даже если пароль утёк, злоумышленнику сложнее завершить вход. Во фреймворках это обычно реализуется как дополнительный шаг после успешной проверки логина/пароля: пользователь временно считается «частично вошедшим», пока не подтвердит второй фактор.

Типовые варианты второго фактора:

Важно, что второй фактор привязывают не только к аккаунту, но и к сессии/устройству: после успешной 2FA создаётся полноценная сессия (cookie/токен) с флагом mfa_passed.

Даже если пользователь уже вошёл, для критичных операций многие приложения требуют повторного подтверждения: платежи, смена пароля, добавление нового способа входа, просмотр секретных данных.

На уровне фреймворка это обычно выглядит как middleware/guard, который проверяет «свежесть» MFA (например, не старше 5–10 минут) или факт повторного ввода пароля. Это снижает риск, если сессия была украдена или компьютер оставили без присмотра.

«Выйти везде» — полезная функция после подозрительной активности. Практический подход: хранить список активных сессий (или их идентификаторов) в базе и при глобальном выходе инвалидировать их все.

Если используется JWT, одного удаления cookie недостаточно: нужен механизм отзывов (revocation) или короткий срок жизни access‑токена плюс ротация refresh‑токенов.

Многие фреймворки поддерживают список устройств: когда, где и с какого браузера был вход. «Доверенное устройство» обычно означает, что 2FA можно не спрашивать некоторое время — но только при строгих условиях:

Так MFA остаётся удобной, но не превращается в «одноразовую галочку», которую невозможно контролировать.

Даже самый удобный механизм входа ломается, если проверки размазаны по коду. В современных фреймворках безопасность проще поддерживать, когда аутентификация и авторизация встроены в архитектуру как «поток решений»: кто пользователь → что он может → что именно он делает с ресурсом.

Хорошая схема выглядит так:

Ключевая цель — чтобы правило можно было изменить в одном месте и быть уверенным, что оно применяется везде.

Логируйте события, а не секреты. Полезный минимум:

Не записывайте в логи access/refresh‑токены, cookie, одноразовые коды, полные персональные данные. Если нужен аудит, храните идентификаторы и технический контекст (IP/устройство) с разумным сроком хранения.

Покрывайте правила тестами на двух уровнях: unit‑тесты для политик (матрица «роль/атрибут → доступ») и интеграционные тесты для критичных эндпоинтов (статусы 401/403/200, фильтрация «чужих» данных). Важно тестировать не только «можно», но и «нельзя».

Планируйте короткие ревизии: обновление зависимостей и проверка CVE, пересмотр ролей и исключений, удаление устаревших разрешений, повторная проверка логирования и сроков жизни сессий. Это дешевле, чем разбирать инцидент постфактум.

Даже «правильно выбранная» схема аутентификации и авторизации часто ломается на деталях внедрения. Ниже — ошибки, которые встречаются чаще всего, и практичные ориентиры, как выбрать подход под ваш продукт.

1) Неправильное хранение токенов и слишком долгий срок жизни.

Частая проблема — хранить access‑токен в localStorage и выдавать его на недели. Это повышает риск кражи при XSS и усложняет отзыв доступа. Более безопасный вариант для браузерных приложений — короткоживущий access‑токен + обновление через refresh‑токен (часто в HttpOnly cookie) и обязательная ротация. В API‑клиентах (мобайл/сервер‑сервер) важны защищённое хранилище, привязка токена к устройству и понятная стратегия отзыва.

2) Смешивание ролей и прав без ясной схемы.

Когда «роль» одновременно означает и должность, и набор возможностей, и «флаг доступа», система быстро превращается в хаос. Хорошая практика — разделять:

Это упрощает переход от простого RBAC к более гибким политикам/ABAC, не переписывая всё с нуля.

3) Проверка только в UI, но не на сервере.

Скрыть кнопку недостаточно: запрос можно отправить напрямую. Любая критичная проверка должна выполняться на сервере (в middleware/guards/политиках), а интерфейс — лишь отражать результат.

/docs/security), включить мониторинг ошибок входа и отказов доступа.Если вы собираете приложение «с нуля», чаще всего сложность не в том, чтобы один раз прикрутить логин, а в том, чтобы поддерживать единообразие: одинаковые guards, одинаковые политики, аккуратные TTL, понятный logout «везде», журналы аудита и тесты на 401/403.

В TakProsto.AI это удобно закладывать на старте: платформа для vibe‑кодинга позволяет через чат описать требуемые потоки (сессии или JWT, refresh‑ротация, RBAC/ABAC, политики на ресурсы, CSRF‑защита) и быстро собрать каркас приложения на React + Go (с PostgreSQL), сохранив возможность экспортировать исходники, деплоить и откатываться через snapshots/rollback. Это особенно полезно, когда нужно быстро проверить продуктовую гипотезу, но при этом не «протянуть» небезопасные решения в продакшен.

Аутентификация отвечает на вопрос «кто вы»: система подтверждает личность (пароль, код, OAuth-вход).

Авторизация отвечает на вопрос «что вам можно»: после определения пользователя проверяются права на действия и ресурсы (прочитать, изменить, удалить).

Потому что проверки должны быть централизованными и единообразными: один способ восстановить пользователя и один способ проверить права.

Если проверки размазаны по контроллерам, легко получить дыры: забыли проверку роли, не учли новый тип пользователя, перепутали условия.

Чаще всего схема состоит из:

Пароли хранят не «как есть», а в виде хеша с солью.

Практически:

Используйте встроенные функции/библиотеки фреймворка и настраиваемые параметры (алгоритм, стоимость), а не самописные хеши.

Сессия (cookie + session id): сервер хранит состояние (данные сессии), браузер отправляет cookie автоматически.

Токены (Bearer/JWT): клиент хранит токен и отправляет его в Authorization: Bearer …, сервер может быть статeless.

Выбирайте сессии для классических веб-интерфейсов (удобный отзыв доступа), токены — для API/мобильных/интеграций (проще масштабировать и прокидывать между клиентами).

JWT — это подписанный контейнер с claims (например, exp, sub, jti). Обычно он не шифруется, поэтому содержимое может быть прочитано тем, кто получил токен.

Практика:

Access-токен — короткоживущий, ходит в каждый запрос к API.

Refresh-токен — долгоживущий, используется только для выпуска нового access-токена.

Чтобы снизить риск:

Компромисс такой:

localStorage/sessionStorage: проще, но токен доступен JavaScript → выше риск кражи при XSS.HttpOnly cookie: JS не прочитает → лучше против XSS, но нужно аккуратно закрывать CSRF (CSRF-токены, SameSite, корректные методы).Если это браузерное приложение, чаще выбирают HttpOnly cookie + защиту от CSRF и строгие cookie-флаги.

OAuth 2.0 — про делегирование доступа (получить access token к API провайдера), но не гарантирует «кто пользователь».

Для входа обычно нужен OpenID Connect (OIDC): он добавляет ID Token с утверждениями о личности.

Для веб/мобайл сценариев используйте Authorization Code + PKCE; для сервис-сервис — Client Credentials.

Типовой минимум:

owner_id/organization_id), чтобы предотвратить IDOR;Полезная проверка: токен/сессия подтверждают пользователя, но не являются правами сами по себе.

exp);Так меньше дублирования и ниже шанс забыть критичную проверку.