08 дек. 2025 г.·8 мин

Батлер Лэмпсон и масштаб: наследие инноваций Xerox PARC

Разбираем идеи Батлера Лэмпсона и Xerox PARC: от Alto и сетей до RPC, кэшей и каталогов — принципы, которые до сих пор формируют ОС и распределённые системы.

Разбираем идеи Батлера Лэмпсона и Xerox PARC: от Alto и сетей до RPC, кэшей и каталогов — принципы, которые до сих пор формируют ОС и распределённые системы.

Батлер Лэмпсон — инженер и исследователь, чьи идеи заметно повлияли на то, как устроены современные операционные системы и распределённые сервисы. Его имя часто всплывает рядом с Xerox PARC (Palo Alto Research Center) — местом, где в 1970–80‑е годы экспериментировали с «компьютером как рабочим инструментом» и одновременно переизобретали сети, интерфейсы и основы системного дизайна.

Важно не столько то, что Лэмпсон участвовал в создании нескольких знаковых технологий, сколько то, как он думал о системах: как сделать сложное пригодным для ежедневной эксплуатации, как проектировать границы между компонентами и как заранее учитывать ограничения реального мира — задержки, отказы, рост числа пользователей и машин.

Когда система маленькая, многие проблемы маскируются: всё «почти всегда» работает, сеть «почти мгновенная», а сбои «редкие». При росте масштаба эти допущения ломаются, и приходится принимать архитектурные решения: что кэшировать, как находить сервисы, как безопасно выдавать доступ, как диагностировать неполадки.

Лэмпсон помог сформулировать набор практичных принципов, которые до сих пор узнаваемы в больших инфраструктурах: простые интерфейсы, явные компромиссы, аккуратное обращение с состоянием и понимание того, что отказ — это не исключение, а режим работы.

Вместо исторических баек разберём идеи, которые можно применять на практике:

Распределённая система — это когда одна «общая» функция (например, хранение данных или обработка запросов) реализована не на одном компьютере, а на нескольких, соединённых сетью. Для пользователя это выглядит как единый сервис, а внутри постоянно решаются задачи координации, поиска нужных компонентов и устойчивости к сбоям.

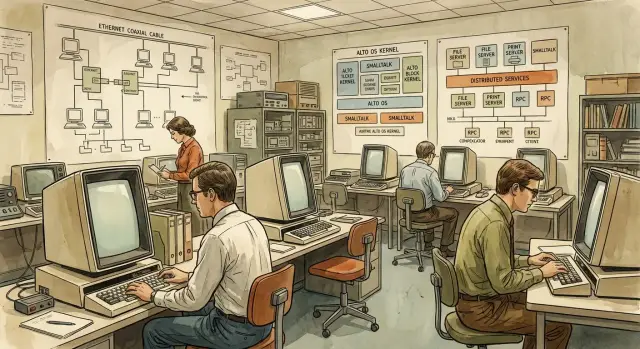

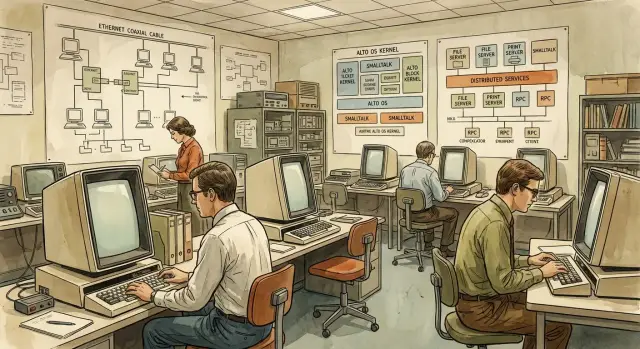

Xerox PARC часто вспоминают как место, где «изобрели будущее», но важнее другое: там сложилась среда, в которой идеи проверяли не в вакууме, а в виде работающих систем. Для Батлера Лэмпсона и его коллег это означало постоянное столкновение красивых концепций с железом, пользователями и эксплуатацией — и именно поэтому многие решения PARC звучат современно до сих пор.

В PARC не ограничивались отдельным компонентом вроде протокола или интерфейса. Команды могли продумывать сразу всё: рабочую станцию, операционную систему, сеть, сервисы и инструменты для разработчиков. Такой подход снижал разрыв между «исследованием» и «продуктом»: если идея не работала в связке с остальными слоями, это становилось видно быстро.

Решения 1970-х формировались под давлением очень конкретных ограничений:

Отсюда — внимание к кэшированию, аккуратным протоколам, таймаутам, минимизации лишних пересылок и продуманной диагностике.

Хотя это была исследовательская лаборатория, логика задач напоминала то, что сегодня происходит в кластерах: множество машин, общие ресурсы, сетевые сервисы, необходимость обновляться и «жить» под нагрузкой. Поэтому полезно смотреть на PARC как на раннюю модель того, что сейчас называют распределёнными системами.

Дальше пройдём по ключевым направлениям: дизайн ОС как части сетевой среды, Ethernet и сетевое мышление, RPC и взаимодействие сервисов, именование и каталоги, кэширование и репликация, работа с отказами и таймаутами, а также безопасность и управляемость на масштабе.

Alto в PARC часто вспоминают из‑за графического интерфейса и мыши, но не менее важна другая идея: рабочая станция — это не «одинокий компьютер на столе», а узел сети, который живёт за счёт окружения. Пользователь работает с документами, печатает, делится файлами и обращается к сервисам так же естественно, как открывает локальную папку.

В модели Alto на первом месте был пользовательский опыт, но за ним стояла инфраструктура: сетевой доступ к принтерам, файловым хранилищам и общим ресурсам. Периферия становилась «сетевой»: например, печать превращалась не в функцию конкретного кабеля, а в обращение к сервису. Это меняло ожидания: устройство может быть не подключено напрямую, но всё равно доступно.

Ключевой сдвиг — думать не отдельными компонентами, а комплектом: операционная система, сетевой стек, службы печати, хранения и именования должны проектироваться согласованно. Тогда сетевые возможности не выглядят «надстройкой», а становятся частью базовой среды.

Практический вывод: важны не только функции, но и договорённости — форматы, протоколы, единые правила доступа и администрирования. Когда всё собрано в одно целое, проще добиться предсказуемости для пользователя: «работает всегда и одинаково».

Подключение к сети делает критичными вещи, которые на одиночной машине можно игнорировать: стабильная работа драйверов и фоновых служб, управление ресурсами при параллельных сетевых задачах, понятные ошибки (что именно недоступно — принтер, сервер или сеть), а также безопасность по умолчанию. Даже интерфейс ОС начинает отражать сетевую реальность: список доступных ресурсов, очереди печати, учётные записи, права.

Современные ОС унаследовали эту «сетевую норму»: мы ожидаем, что ноутбук найдёт принтер, подключится к корпоративным ресурсам, синхронизирует файлы и будет обновляться через сеть. Идея Alto в том, что ОС не просто управляет железом, а организует удобную среду взаимодействия с сервисами вокруг.

Ethernet в PARC был не просто «проводом между компьютерами». Он закрепил новую норму: машина существует не в одиночку, а как узел общей среды, где рядом есть файловые сервисы, принтеры, каталоги и другие компьютеры. Это и есть сетевое мышление — проектировать систему так, будто взаимодействие по сети неизбежно и постоянно.

Локальная сеть дала редкую для своего времени комбинацию: относительно высокая скорость, низкая задержка и общая среда обмена. Это резко снизило «стоимость» распределения: можно было вынести хранение, печать или управление пользователями в отдельные сервисы, не превращая каждое обращение в мучительное ожидание.

Важно, что Ethernet делал совместное использование ресурсов обыденным. Когда принтер или файловое хранилище доступны по сети так же естественно, как локальный диск, появляется стимул строить более модульные системы: отдельные компоненты можно развивать и заменять независимо.

Пакетная передача подразумевает простую вещь: сеть не гарантирует, что «всё будет гладко» каждую секунду. Пакеты могут теряться, приходить с задержкой, сталкиваться с перегрузкой. Даже в локальной сети возможны коллизии, очереди, временные провалы.

Отсюда вытекают требования, которые позже станут классикой распределённых систем: повторные попытки, контроль времени ожидания, ограничение нагрузки, аккуратная работа с состоянием.

Как только узлов становится больше, усиливаются четыре фактора: задержки, потери, перегрузка и сбои. Неприятность в том, что они взаимосвязаны: перегрузка увеличивает задержки, задержки провоцируют повторы, повторы создают ещё большую перегрузку.

Сеть нужно считать частью архитектуры ОС: так же важной, как планировщик или файловая система. Если проектировать интерфейсы и сервисы, исходя из реальности сети (неидеальность, вариативность, частичные отказы), система на масштабе будет предсказуемее — и для разработчиков, и для пользователей.

RPC (Remote Procedure Call) задумывался как простой трюк: дать разработчику возможность вызывать удалённый сервис почти так же, как локальную функцию. Вместо «отправь сообщение → дождись ответа → распакуй данные» вы пишете user = GetUser(id) — и остальное будто бы «само».

Главная ценность RPC — снижение когнитивной нагрузки. Команда может разбивать систему на сервисы и при этом сохранять знакомую модель программирования: параметры, возвращаемые значения, ошибки. Это ускоряет разработку и делает код читабельнее.

Но за удобством скрывается важная оговорка: сетевой вызов принципиально отличается от локального, даже если синтаксис похож.

RPC маскирует три «неприятные правды»:

Отсюда рождаются типичные симптомы «странных» багов: двойные списания, дубли заказов, зависания из-за бесконечных ожиданий.

Если вы планируете ретраи (а без них часто нельзя), проектируйте операции так, чтобы повтор не ломал смысл:

Полная «прозрачность» RPC соблазнительна, но опасна: она заставляет забыть, что это сеть. Полезнее явность в критичных местах — таймауты, отмена запросов, бюджеты по времени, понятные коды ошибок.

Хорошее правило: RPC может быть похож на локальный вызов по форме, но по поведению должен оставаться «сетевым гражданином» — с ожиданием задержек, отказов и повторов.

Распределённая система начинается не с вычислений, а с поиска: где находится нужный сервис, какой узел отвечает за данные, куда отправить запрос. В PARC эта тема стала практической проблемой: сеть Ethernet связала множество машин, и «просто знать адрес» быстро перестало работать. Отсюда — интерес к каталогам и правилам именования.

Именование — это способ дать объекту (файлу, сервису, очереди, пользователю) понятное имя и затем разрешить его в конкретное место или набор мест. Сложность в том, что в распределённой системе всё меняется: узлы падают, сервисы переезжают, появляются реплики, а сеть даёт задержки и разделения.

Хорошая система именования должна жить в условиях неполной информации: иногда «истина» недоступна, и приходится выбирать между точностью, скоростью и доступностью.

Полезно разделять три понятия:

payments, user-profile, /home/alex/doc.txt.Когда эти уровни смешивают, начинаются боли: например, сервис «приклеивают» к одному IP, а затем любое перемещение превращается в аварию.

Каталог (directory service) почти всегда работает с кэшем и временем жизни записей. Поэтому лучше заранее принять неизбежное: клиенты иногда будут видеть устаревшие адреса.

Практики, которые уменьшают ущерб:

Перед тем как выбирать service discovery или писать свой каталог, проверьте:

Именование — это не «справочник», а контракт между людьми, кодом и постоянно меняющейся инфраструктурой. Чем яснее вы разделите имя, адрес и идентичность, тем спокойнее система переживёт рост и изменения.

Кэширование в сети — способ «приблизить» данные к месту, где они читаются: на рабочей станции, на сервере приложения, на прокси. В системах масштаба оно почти неизбежно, потому что задержки сети и стоимость удалённых запросов слишком велики. Но любой кэш покупает скорость ценой сложности: как только данные меняются, кэш начинает врать.

Самая неприятная часть — несоответствие между источником истины и копиями. Оно проявляется не только как «устаревшие данные», но и как цепочка эффектов: неверные решения в бизнес‑логике, повторные операции, странные баги, которые «пропадают после обновления страницы».

Классический принцип: ускорить чтение легко, сохранить правильность — трудно. Поэтому ключевой вопрос звучит не «нужен ли кэш», а как и когда кэш инвалидировать.

Есть два базовых подхода:

Пассивный подход проще и устойчивее при сбоях, но допускает «окно устаревания». Активный даёт более строгую свежесть, но добавляет каналы доставки событий, повторные попытки, дедупликацию и обработку ситуации «инвалидация потерялась».

Репликация похожа на кэширование, но цель чаще другая: доступность и устойчивость к отказам. Цена — необходимость договориться, какая копия «правильная», и что делать при параллельных изменениях.

На практике это выливается в компромисс между задержками и конфликтами: чем дальше и больше реплик, тем выше шанс разъезда состояний и сложнее запись.

Хорошо работают сочетания простых техник:

Главное — заранее решить, где нужна строгая свежесть, а где приемлема небольшая задержка. Тогда оптимизация перестаёт быть «магией» и становится управляемой инженерной сделкой.

Распределённая система редко падает «целиком» и сразу. Чаще она ломается фрагментами: один узел недоступен, другой отвечает медленнее, сеть теряет пакеты, а клиент в это время продолжает честно отправлять запросы. Именно поэтому в традиции системного дизайна, к которой причастен Батлер Лэмпсон, так много внимания уделяется не героическим оптимизациям, а поведению при сбоях.

Типовой набор выглядит буднично, но в комбинациях становится коварным: падение узла (процесс умер, диск недоступен), разрыв или «дрожание» сети, перегрузка (очереди растут, CPU занят), деградация (всё живо, но медленно из‑за GC, ретраев, фоновых задач). Важно, что эти состояния могут быть временными и циклическими.

В распределённых системах нет единой точки наблюдения: клиент может видеть сервис как «мертвый», пока сам сервис жив и обрабатывает запросы — просто ответы не доходят. Или наоборот: один сегмент сети доступен, другой — нет. Из этого следует неудобная истина: «не ответил» не равно «не выполнил». Отсюда проблемы с повторами запросов, двойными списаниями и «призрачными» операциями.

Таймауты нужны, чтобы освобождать ресурсы и не держать цепочки вызовов бесконечно. Но неверные значения опасны: слишком короткий таймаут порождает лавину повторов и ещё сильнее нагружает систему; слишком длинный — забивает пулы потоков, держит соединения и превращает локальную задержку в каскадный отказ.

Практичнее всего подбирать таймауты по наблюдаемой статистике задержек (p95/p99), разделять таймауты на соединение и на обработку, а также иметь общий «дедлайн» на весь пользовательский запрос.

Базовые приёмы просты: деградация сервиса (частичный функционал вместо падения), очереди с ограничениями, лимиты на параллелизм, изоляция (bulkheads) между компонентами, а также аккуратные ретраи с джиттером и только там, где операции идемпотентны. Цель не «не ломаться», а ломаться предсказуемо и локально.

Распределённая система почти всегда состоит из частей, которые видят мир по‑разному: клиент «снаружи», сеть с непредсказуемыми сбоями, сервисы с разными версиями и хранилища, живущие по своим правилам. Поэтому безопасность здесь — не надстройка, а свойство архитектуры. В PARC это понимали рано: если ОС и сеть срастаются, то и модель доверия должна быть встроена в дизайн.

Аутентификация отвечает на вопрос «кто ты?» (пользователь, сервис, устройство).

Авторизация — «что тебе можно?» (какие действия и над какими объектами).

Аудит — «что происходило на самом деле?» (кто, когда, откуда, с каким результатом). В распределённой среде аудит критичен: инциденты часто выглядят как цепочка мелких событий в разных местах.

Идея возможностей (capabilities) — выдавать не «роль вообще», а конкретный «ключ‑разрешение» на конкретное действие: прочитать этот объект, записать в тот каталог, вызвать этот метод. Это естественно поддерживает принцип наименьших привилегий: токен или capability должен быть достаточным для работы, но бесполезным вне нужного контекста.

Практический вывод: старайтесь раздавать права как можно ближе к операции, а не «на всякий случай». И избегайте универсальных секретов, которые открывают слишком много дверей.

Полезно явно нарисовать границы:

Перед тем как выбирать протоколы и форматы, ответьте на вопросы:

Если эти ответы не зафиксированы, безопасность обычно «расползается» по системе и становится непредсказуемой — как и задержки в сети.

Когда система становится распределённой, «правильный» API перестаёт быть гарантией предсказуемого поведения. Удобство интерфейса (например, прозрачный RPC) часто маскирует задержки, повторы, частичные отказы и деградацию кэшей. На масштабе это означает простую вещь: если вы не видите, что происходит, вы не управляете системой — вы только надеетесь.

Чем «магичнее» абстракция, тем важнее иметь рычаги управления:

Наблюдаемость нельзя «прикрутить потом»: формат логов, ключи корреляции, метрики и трассировка должны быть запланированы так же, как протоколы и кэш.

Практичный минимум:

Полезный сигнал обычно связан с пользовательским опытом и ресурсами: рост p99, всплеск таймаутов, очередь, троттлинг, падение hit rate кэша. Шум — это метрики без контекста. Если по сигналу нельзя принять решение (откатить релиз, увеличить лимит, отключить ретраи), он лишний.

Для RPC: latency по квантилям, timeouts, retries, доля ошибок по кодам, насыщение пулов соединений.

Для кэшей: hit/miss, возраст данных (staleness), evictions, fill latency, «штормы» при прогреве.

Для каталогов/именования: latency резолва, доля негативных ответов, размер/время распространения обновлений, частота изменений записей.

Эти измерения превращают масштабирование из гадания в инженерный процесс: вы видите узкое место, понимаете причину и выбираете действие, а не «крутите ручки» вслепую.

Идеи, которые обсуждали и проверяли в PARC, сегодня легко узнать в самых разных продуктах — от корпоративных сетей до облачных платформ. Важно не «назначать» одному месту все изобретения отрасли, а смотреть на повторяющиеся мотивы: сетевое мышление, удобные абстракции и честные компромиссы.

Современная операционная система почти всегда живёт в окружении сервисов: каталогов пользователей, политик доступа, сетевого хранилища, обновлений, телеметрии. Эта идея — что рабочая среда по умолчанию имеет сетевые зависимости — читается и в корпоративных доменах, и в управляемых рабочих местах, и в виртуальных десктопах. Даже когда компьютер выглядит «локальным», многое решается на стороне инфраструктуры.

RPC как обещание «вызов почти как локальный» сегодня виден в gRPC, внутренних SDK и service mesh‑подходах. При этом практика подтвердила старую оговорку: задержки, таймауты и частичные отказы никуда не исчезают. Поэтому в облаках так много внимания дедлайнам, идемпотентности и лимитам — это способ приручить разрыв между удобным интерфейсом и сетевой реальностью.

CDN, распределённые базы данных, кэши на периметре, реплики для чтения — всё это вариации на тему ускорения доступа и повышения доступности через копии. А service discovery, конфигурационные хранилища и системы имён в кластерах продолжают линию «как находить нужное», только уже на уровне тысяч экземпляров.

Самое устойчивое наследие — дисциплина дизайна: делать интерфейсы простыми, а ограничения — проговорёнными. В облаках это проявляется в SLA, в выборе consistency‑моделей, в документации по лимитам и в правилах эксплуатации: система масштабируется не магией, а тем, что её углы известны заранее.

Инновации PARC ценны не тем, что «там придумали всё», а тем, что многие грабли распределённых систем остаются теми же. Ниже — решения, которые стоит принять заранее и закрепить в команде.

Некоторые вещи становятся дорогими, если отложить:

Договорённости лучше фиксировать как контракт:

Все перечисленные принципы особенно заметны, когда вы быстро собираете продукт из нескольких компонентов: фронтенда, API и базы данных. В этом смысле TakProsto.AI (vibe‑coding платформа для российского рынка) полезен как «ускоритель практики»: вы формулируете требования в чате, а платформа помогает собрать приложение (React на вебе, Go + PostgreSQL на бэкенде, Flutter для мобильных клиентов) и быстро дойти до того этапа, где становятся важны таймауты, ретраи, идемпотентность, каталоги/конфигурация и наблюдаемость.

Отдельно удобно, что в TakProsto.AI есть planning mode (чтобы сначала зафиксировать контракты и границы сервисов), snapshots и rollback (для безопасных изменений), а также экспорт исходников и деплой/хостинг. Для команд, которым важна локальность, платформа работает на серверах в России и использует локализованные и open‑source LLM‑модели, не отправляя данные за пределы страны.

Полезные ориентиры: Butler Lampson «Hints for Computer System Design», Lamport «Time, Clocks, and the Ordering of Events», «End-to-End Arguments», «Fallacies of Distributed Computing».

Термины для уверенного разговора: CAP, PACELC, линейризуемость, саги, outbox/inbox, circuit breaker, exponential backoff + jitter, bounded staleness, idempotency.

Батлер Лэмпсон важен не «набором изобретений», а инженерной дисциплиной: как проектировать системы, которые остаются понятными, сопровождаемыми и устойчивыми при росте.

Практический фокус его подхода:

Потому что там идеи проверяли как работающие «полные стеки»: железо, ОС, сеть и сервисы, которыми реально пользовались.

Это быстро выявляло слабые места:

Распределённая система — это один сервис «снаружи», но набор компонентов «внутри», общающихся по сети.

Минимальный набор задач, который появляется сразу:

Потому что RPC делает сетевой вызов похожим на локальную функцию, и из-за этого легко забыть про реальность сети.

Чтобы не получить «странные» баги:

Имя, адрес и идентичность решают разные задачи и не должны смешиваться.

Практика: не «приклеивайте» сервис к одному IP/узлу — используйте резолв через каталог и учитывайте устаревание кэша (TTL).

Кэш ускоряет чтение, но вводит риск устаревания и рассогласования.

Рабочие варианты, которые проще всего внедрить:

Репликация чаще делается ради доступности и чтений под нагрузкой, но усложняет запись и согласованность.

Практичные правила:

В распределённых системах «не ответил» не означает «не выполнил»: мог потеряться ответ, а операция уже прошла.

Чтобы не устроить лавину:

Потому что частей много, они обновляются и ломаются независимо, а границы доверия не совпадают с границами сервисов.

Практический минимум:

Выберите 2–3 решения «сразу», иначе позже будет дорого переделывать.

Если нужно закрепить практики в команде, заведите короткий чек-лист в репозитории (например, ).

/docs/architecture-checklist.md