18 сент. 2025 г.·8 мин

Что такое Apache Kafka и как её используют в современных системах

Разберём, что такое Apache Kafka, зачем она нужна, как устроена, где применяется, и какие ошибки важно избежать при внедрении в продакшене.

Разберём, что такое Apache Kafka, зачем она нужна, как устроена, где применяется, и какие ошибки важно избежать при внедрении в продакшене.

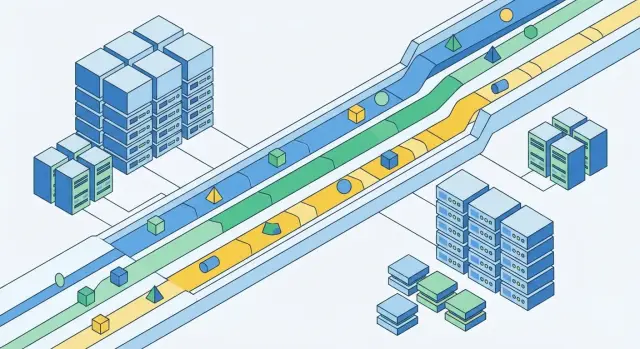

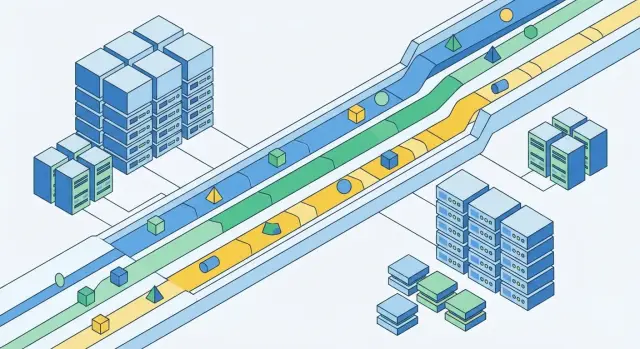

Apache Kafka — это платформа для потоковой передачи событий (event streaming). Проще говоря, она помогает системам обмениваться сообщениями не «вручную» и не напрямую друг с другом, а через общий «журнал событий», куда можно быстро записывать данные и так же быстро их читать.

Kafka часто называют «шиной событий» или «центральной нервной системой» для сервисов: один сервис публикует факт (например, «создан заказ»), а другие сервисы подписываются и реагируют — каждый по‑своему.

На практике Kafka особенно хорошо раскрывается в событийной архитектуре (event-driven): вы фиксируете бизнес‑факты в виде событий и подключаете к ним новые сценарии без переписывания существующих интеграций.

Интеграции без тесной связки. Вместо множества прямых интеграций «каждый с каждым» сервисы общаются через события. Это упрощает развитие системы: можно добавить нового потребителя, не меняя продюсера.

Асинхронность и устойчивость к пикам. Если один из сервисов временно перегружен или недоступен, события не пропадают: они остаются в Kafka и будут обработаны позже. Это сглаживает всплески нагрузки.

Масштабирование. Kafka спроектирована для больших потоков данных: когда сообщений становится больше, систему можно масштабировать так, чтобы запись и чтение шли параллельно.

Очередь задач в узком смысле обычно про «взял задачу — выполнил — удалил». Kafka же ближе к журналу: события хранятся некоторое время, и их могут читать несколько потребителей независимо. Это удобно, когда одно и то же событие нужно для аналитики, уведомлений, биллинга и других процессов одновременно.

Kafka может быть избыточной, если у вас один небольшой сервис, редкие сообщения и нет требований к высокой пропускной способности или множеству подписчиков. Для простых сценариев часто достаточно базы данных, HTTP‑вызовов, cron‑задач или классического брокера сообщений «полегче» — особенно если команда не готова поддерживать отдельный кластер и мониторинг.

Kafka удобно понимать как систему для потока событий (event streaming): она помогает фиксировать происходящее в сервисах и передавать эти факты другим системам так, чтобы их можно было обработать сразу или позже.

Событие — это запись о том, что что-то случилось: «создан заказ», «платёж подтверждён», «пользователь изменил email». В Kafka событие хранится как строка в журнале (логе): добавляется в конец и получает позицию. Важно, что такие записи обычно не изменяются, а только дополняются — как бухгалтерская книга.

Этот подход упрощает разбор инцидентов и «отматывание» состояния: можно вернуться к прошлым записям и заново воспроизвести обработку.

Поток событий можно обрабатывать в реальном времени: реагировать на оплату сразу, обновлять витрину, отправлять уведомления. Но те же данные подходят и для пакетной обработки: ночные отчёты, пересчёт метрик, обучение моделей. Kafka позволяет не выбирать одно из двух: события лежат в журнале и доступны в любом режиме.

Kafka работает по модели публикация/подписка (pub/sub): одни приложения публикуют события, другие подписываются и читают их. Это снижает связанность систем: продюсеру не нужно знать, кто и как будет использовать события.

Чтобы уверенно читать документацию и обсуждать архитектуру, важно договориться о базовых терминах Kafka. Они звучат «по‑инфраструктурному», но на практике довольно просты.

Брокер (broker) — это сервер Kafka, который принимает события от продюсеров, хранит их на диске и отдаёт консюмерам. Один брокер — это уже рабочая Kafka, но в реальных системах их объединяют в кластер (несколько брокеров), чтобы выдерживать нагрузку и переживать сбои.

Внутри кластера есть роль контроллера: он координирует «кто за что отвечает», отслеживает состояние брокеров и управляет назначением лидеров партиций. Это не отдельный продукт — контроллером становится один из брокеров.

Топик (topic) — это логическая категория событий: например, orders, payments, user-events. Kafka не «перемешивает» все сообщения в одну корзину: каждый топик — отдельный поток записей, который можно читать независимо.

Топик разбит на партиции — упорядоченные журналы внутри топика. Порядок гарантируется в пределах одной партиции, поэтому масштабирование обычно делается через увеличение числа партиций: больше партиций — больше параллельных читателей и выше пропускная способность.

Чтобы данные не потерялись при падении брокера, партиции обычно реплицируются на несколько брокеров (например, фактор репликации 3).

У каждой партиции есть лидер — брокер, который принимает записи и обслуживает чтение. Остальные реплики — «фолловеры», они догоняют лидера. Если лидер недоступен, кластер выбирает нового, и работа продолжается с минимальной паузой.

Kafka хранит данные в топиках — логических каналах событий (например, orders, payments, clicks). Чтобы топик мог переваривать больше нагрузки и параллелить чтение/запись, он делится на партиции.

У сообщения может быть key. Kafka использует ключ, чтобы стабильно направлять сообщения в одну и ту же партицию (обычно по хэшу ключа). Практический смысл:

user_id идут последовательно).Если ключ не задавать, сообщения распределяются по партициям более равномерно, но порядок «по сущности» теряется.

Kafka обеспечивает порядок только внутри одной партиции: консюмер читает события в том порядке, в котором они записаны в эту партицию.

Между партициями глобального порядка нет. Поэтому если вам важно, чтобы «события одного заказа» шли строго последовательно, все они должны попадать в одну и ту же партицию — чаще всего через key = order_id.

Партиция — это по сути последовательный лог на диске. Большие партиции обычно нормальны для Kafka, но есть нюансы:

На производительность часто сильнее влияет не «размер партиции в ГБ», а количество партиций и скорость диска/сети, а также настройки ретеншна.

Простой способ прикинуть:

Оцените целевую нагрузку (сообщений/с или МБ/с) и желаемый запас.

Определите нужный параллелизм чтения: сколько консюмеров вы хотите запускать одновременно.

Выберите число партиций так, чтобы оно покрывало параллелизм (обычно партиций ≥ консюмеров в группе), и оставьте запас на рост.

Партиции можно добавить позже, но это меняет распределение ключей по партициям. Поэтому для кейсов, где важна «стабильная привязка» сущности к партиции, лучше сразу закладывать разумный запас.

Kafka держится на простой роли участников: одни пишут события в топики, другие читают их и выполняют работу (обновляют витрины, запускают рассылки, считают метрики).

Producer (продюсер) публикует сообщения в конкретный топик (часто — с ключом, чтобы попадать в нужную партицию). При отправке важно, когда считать запись успешной — это задаётся подтверждениями acks:

На практике надёжность продюсера — это сочетание acks, ретраев и идемпотентности (чтобы повторная отправка не порождала лишние дубликаты).

Consumer (консюмер) читает сообщения из партиций и обрабатывает их. Важно, что чтение — это не «вытаскивание из очереди», а движение по журналу: консюмер сам контролирует, на каком месте он находится.

Consumer group позволяет масштабировать обработку: несколько экземпляров консюмера работают как одна логическая команда.

Внутри группы действует правило: одна партиция в момент времени назначается только одному консюмеру. Поэтому:

Когда консюмеры в группе добавляются/падают/перезапускаются, Kafka выполняет ребалансировку — перераспределяет партиции. В этот момент возможны паузы в обработке и повторная обработка части сообщений (если прогресс чтения был зафиксирован не вовремя).

Чтобы ребалансировки не становились проблемой, обычно следят за стабильностью консюмеров, временем обработки и тем, как часто меняется состав группы.

Оффсет (offset) — это «номер позиции» сообщения внутри конкретной партиции топика. Консюмер читает партицию последовательно и, по сути, запоминает: «я дошёл до сообщения с таким-то оффсетом». Важно: оффсеты существуют в рамках партиции, поэтому у топика с несколькими партициями нет одного общего «счётчика».

Когда консюмер получает сообщения, он может обработать их (например, обновить запись в базе, отправить уведомление) и затем зафиксировать оффсет. Зафиксированный оффсет означает: «всё до этой точки считается прочитанным и обработанным». Если консюмер перезапустится, он продолжит чтение с последней зафиксированной позиции.

Автокоммит — клиент периодически сам фиксирует оффсеты по таймеру. Это удобно и снижает риск забыть про коммит, но есть тонкость: если оффсет зафиксирован, а реальная обработка ещё не завершилась (или упала), часть сообщений может быть потеряна для вашей логики (Kafka будет считать их «пройденными»).

Ручной коммит — вы сами решаете, когда фиксировать прогресс (обычно после успешной обработки). Это даёт больше контроля и предсказуемости, но требует дисциплины: нужно учитывать ошибки, ретраи, пакетную обработку.

Сильная сторона Kafka — возможность «переиграть» события. Если вы обнаружили баг в обработчике, можно сбросить оффсеты назад и перечитать сообщения заново (в пределах ретеншна). Это особенно полезно для восстановления витрин данных, пересчёта агрегатов и исправления ошибок интеграций.

Обычно оффсеты consumer group хранятся в самой Kafka (служебный топик __consumer_offsets). Практики, которые помогают при сбоях:

Kafka часто описывают как систему, где «сообщения не теряются». На практике важно различать гарантии доставки (как запись/чтение переживают сбои) и семантику обработки (сколько раз ваш код применит эффект: запишет в БД, отправит письмо, начислит бонус).

Идемпотентный продюсер уменьшает риск дублей при повторных отправках из‑за ретраев (важно при нестабильной сети и высокой нагрузке).

Транзакции Kafka нужны, когда вы хотите атомарно: (1) прочитать сообщения, (2) записать результаты в другие топики, (3) зафиксировать прогресс чтения. Это основа семантики «exactly once» в потоковой обработке.

Если итоговый эффект вне Kafka (например, запись в БД или вызов API), полностью полагаться на «exactly once» нельзя. Обычно добавляют:

event_id и таблицу/кэш «уже обработано»;На уровне Kafka можно строго контролировать запись и чтение внутри самой Kafka. Но как только появляются внешние системы, «ровно один раз» становится не настройкой, а архитектурным решением: где хранить идентификаторы, как делать повторные попытки, какие эффекты допускают переигрывание и как безопасно откатываться.

Kafka не навязывает формат сообщений: в топик можно писать хоть строку, хоть двоичный массив. Но как только продюсеров и консюмеров становится много, «договорённости на словах» перестают работать — появляется необходимость в явном контракте данных (схеме) и правилах её изменения.

JSON удобен для старта: легко читать, отлаживать и быстро выпускать изменения. Минусы — нет строгой типизации, больше размер, сложнее гарантировать совместимость.

Avro хорошо подходит для Kafka: компактный бинарный формат, схема обычно хранится отдельно, есть поддержка эволюции схем. Часто выбирают, когда важны объём, скорость и строгие правила.

Protobuf похож по целям: бинарный, быстрый, типизированный, широко используется в gRPC. Отличный выбор, если у вас уже есть protobuf‑контракты или микросервисы активно общаются через protobuf.

Практическое правило: если у вас много команд/сервисов и важна дисциплина контрактов — Avro или Protobuf обычно окупаются.

Схема почти неизбежно меняется: добавляются поля, уточняются типы, появляются новые варианты событий. Чтобы обновления не ломали потребителей, используют режимы совместимости:

Типичные безопасные изменения: добавление необязательного поля с дефолтом, расширение enum (в зависимости от формата), сохранение уже существующих полей.

Schema Registry хранит версии схем, выдаёт идентификатор схемы, проверяет совместимость при публикации новой версии и помогает продюсерам/консюмерам автоматически сериализовать/десериализовать сообщения. Это снижает риск «тихих» поломок, когда сервисы по-разному трактуют одно и то же поле.

Хорошая практика — версионировать событие как контракт, а не только код:

orders.created.v2), а старую поддерживайте до завершения миграции.Так Kafka превращается не просто в транспорт, а в устойчивый слой взаимодействия между системами.

Kafka редко живёт «в вакууме»: её ценность раскрывается, когда вокруг выстроены каналы ввода/вывода данных и простая потоковая обработка. Для этого в экосистеме Kafka есть инструменты, которые закрывают самые частые сценарии интеграций.

Kafka Connect — это фреймворк, который переносит данные между Kafka и внешними системами с минимальной настройкой. Вы поднимаете Connect‑воркеры, выбираете коннектор и описываете параметры (куда читать, куда писать, как именовать топики, как преобразовывать поля).

Типичные задачи:

В реальных системах чаще всего встречаются коннекторы к реляционным БД и CDC (например, Debezium), к Elasticsearch/OpenSearch для поиска, к объектным хранилищам вроде S3‑совместимых для дешёвого долговременного хранения, а также к аналитическим системам (ClickHouse и др.).

Важно помнить: Connect переносит данные, но не «понимает» бизнес‑смысл. Поэтому нужно заранее продумать формат сообщений (ключи, поля, версии) и правила, что делать при ошибках (например, DLQ — отдельный топик для проблемных сообщений).

Kafka Streams — библиотека для приложений, которые читают топики, преобразуют данные и пишут результат обратно в Kafka. Её выбирают, когда нужна потоковая агрегация, join между потоками, окна по времени, дедупликация, обогащение справочниками — и всё это прямо в коде сервиса, без отдельного «тяжёлого» кластера обработки.

Если в вашей экосистеме есть ksqlDB, она позволяет описывать потоковые преобразования на SQL: удобно для быстрых прототипов, витрин и простых правил, когда писать отдельное приложение не хочется.

Kafka хранит данные в виде журнала (лога) внутри каждого топика и партиции. Сообщения записываются последовательно на диск и читаются консюмерами по смещению (offset). Это делает поведение предвосхищаемым: продюсер пишет, Kafka сохраняет, консюмеры читают в своём темпе.

Политики ретеншна определяют, сколько Kafka держит данные в партиции.

Важно: ретеншн — это про хранение в брокере, а не про то, успели ли консюмеры прочитать. Если консюмер «отстал» и данные уже вычищены, он физически не сможет их догнать.

Log compaction оставляет в партиции записи так, чтобы по каждому ключу со временем сохранялась самая свежая версия (а старые версии могут быть удалены). Типичные кейсы:

Компакция не равна «удалению всего старого»: в логе могут оставаться и старые записи, и «маркеры удаления» (tombstone) — полезно для синхронизации удалений между системами.

Когда обработка сообщения падает (невалидные данные, недоступен сервис, конфликт в БД), важно не превращать основной топик в свалку ретраев.

DLQ (dead letter queue) — отдельный топик, куда отправляют «ядовитые» сообщения, которые не удалось обработать после понятного лимита попыток. В DLQ обычно кладут само сообщение + причину ошибки + метаданные (время, сервис, offset), чтобы можно было разбирать инциденты без остановки потока.

Для повторных попыток лучше использовать схемы с задержкой:

retry-5s, retry-1m, retry-10m, где сообщение «переезжает» по мере роста задержкиnextAttemptAt и читать/перекидывать сообщения только когда пришло времяТак вы избегаете бесконечных мгновенных повторов, снижаете нагрузку на зависимые сервисы и сохраняете порядок работы с ошибками управляемым.

Kafka часто «падает» не из‑за самой технологии, а из‑за неправильных ожиданий от железа и невнимания к метрикам. Эксплуатация — это про баланс: пропускная способность, задержка, стоимость и устойчивость к сбоям.

Kafka в основном упирается в диск и сеть. CPU важен, но чаще становится узким местом только при тяжёлом сжатии/шифровании или большом количестве соединений.

Практические ориентиры:

Для продакшена обычно выбирают replication.factor = 3: переживёте потерю одного брокера без остановки. Важно не только число реплик, но и настройки согласованности:

У продюсера ключевые рычаги: linger.ms (батчинг), batch.size, compression.type, acks, enable.idempotence. У консюмера — fetch.min.bytes, fetch.max.wait.ms, max.poll.records. Чем больше батчи — тем выше throughput, но обычно выше p99 latency.

Минимальный набор сигналов, который реально помогает:

Регулярно проверяйте алерты и тренды: рост lag и under‑replicated partitions почти всегда предвещает инцидент раньше, чем «всё сломалось».

Kafka часто становится центральным каналом для бизнес‑событий и технических логов, поэтому к безопасности стоит относиться как к части архитектуры, а не «настройке напоследок». На практике важно закрыть три слоя: кто подключается, что ему можно делать и как защищён трафик.

Аутентификация отвечает на вопрос «кто ты». В Kafka это обычно SASL:

Авторизация отвечает на вопрос «что тебе можно». Чаще всего используют ACL (Access Control Lists): права на чтение/запись в конкретные топики, создание топиков, доступ к consumer group, транзакциям и т. п. Хорошая базовая практика — выдавать права по принципу минимально необходимого доступа: приложению‑продюсеру не нужен READ, а консюмеру — WRITE.

TLS защищает данные «в пути»: между продюсерами/консюмерами и брокерами, а также внутри кластера (межброкерная репликация). Он критичен, если:

Частая ошибка — включить TLS только для клиентов, но оставить межброкерный трафик незашифрованным.

Если один кластер обслуживает несколько команд или продуктов, разделяйте пространство имён: например, топики teamA.*, teamB.*, отдельные consumer groups и сервисные аккаунты. ACL удобно привязывать к префиксам топиков и конкретным группам, чтобы команды не «видели» чужие потоки. Дополнительно помогают квоты (quotas) — чтобы один клиент не «съел» ресурсы всего кластера.

Если вы только проверяете гипотезу (например, цепочку «заказ создан → оплата → уведомление → витрина»), полезно сначала быстро собрать минимальный вертикальный срез: продюсер, топик, один‑два консюмера, простая схема событий и базовый мониторинг lag.

Для таких прототипов удобно использовать TakProsto.AI: это vibe‑coding платформа для российского рынка, где веб‑, серверные и мобильные приложения можно собирать через чат. Вы можете накидать каркас сервиса (часто React на фронте и Go + PostgreSQL на бэкенде), описать события и обработчики, а затем итеративно уточнять контракты в «planning mode». Если эксперимент «не взлетел», помогают снапшоты и откат; если взлетел — можно экспортировать исходники и развивать решение дальше в своей инфраструктуре.

Kafka — это платформа для потоковой передачи событий (event streaming): сервисы пишут факты о происходящем в общий журнал (топик), а другие сервисы читают эти факты и реагируют.

Её ценность — в развязке интеграций (pub/sub), устойчивости к пикам нагрузки и возможности масштабировать запись/чтение параллельно.

Kafka обычно выбирают, когда:

Классическая очередь часто работает по схеме «взял задачу → выполнил → удалил». Kafka ближе к журналу:

Это удобно, когда данные нужны и «онлайн», и для последующей обработки.

Kafka может быть избыточной, если:

В таких случаях часто достаточно HTTP-вызовов, cron-задач, базы данных или более простого брокера.

Топик — это категория/канал событий (например, orders), а партиции — его внутренние упорядоченные журналы.

Практически это даёт:

Если вам нужна высокая параллельность обработки, партиции — ключевой рычаг.

Ключ (key) обычно используется, чтобы события стабильно попадали в одну и ту же партицию (по хэшу ключа).

Это важно, когда нужен порядок «по сущности»:

key = user_id;key = order_id.Без ключа сообщения распределяются равномернее, но последовательность по конкретной сущности теряется.

Consumer group — это группа консюмеров, которые вместе читают топик как «одна команда».

Внутри группы действует правило: одна партиция в момент времени назначается только одному консюмеру. Поэтому:

Оффсет — это позиция сообщения внутри конкретной партиции. Консюмер читает последовательно и фиксирует оффсет как отметку прогресса.

Типичная схема безопаснее при at least once:

Если закоммитить слишком рано (например, автокоммитом), можно потерять событие для вашей бизнес-логики при падении обработчика.

В Kafka чаще всего на практике получается:

Если конечный эффект во внешней системе (БД/API), обычно всё равно нужны идемпотентность и/или дедупликация по .

Минимальный практичный набор:

По безопасности: включите SASL+ACL, TLS для клиентов и межброкерного трафика, и выдавайте права по принципу минимально необходимого доступа.

event_id