16 окт. 2025 г.·8 мин

Даг Каттинг, Lucene и Hadoop: как бигдата стала нормой

История Дага Каттинга: от Lucene и Nutch до Hadoop. Разберём, как поиск и распределённая обработка данных стали стандартом индустрии.

История Дага Каттинга: от Lucene и Nutch до Hadoop. Разберём, как поиск и распределённая обработка данных стали стандартом индустрии.

История Дага Каттинга полезна не потому, что это «биография выдающегося инженера», а потому, что она показывает: крупные технологические платформы вырастают из приземлённых задач и ограничений — времени, железа, стоимости и надёжности. Его имя регулярно всплывает рядом с поиском и бигдатой, потому что он стоял у истоков проектов, которые задали стандарт: сначала — для быстрого и точного поиска по текстам, затем — для хранения и обработки огромных объёмов данных на кластерах.

Даг Каттинг — разработчик и один из ключевых участников Apache‑сообщества, который последовательно решал две связанные проблемы: как находить нужное в массе документов (Lucene), и как собирать/обрабатывать данные, когда их стало слишком много для одной машины (Nutch → Hadoop). Важно, что это не «теория», а цепочка решений, выросшая из реальных ограничений и практики.

В начале 2000‑х интернет и корпоративные системы резко увеличили объёмы данных: страниц, логов, писем, товаров, событий. Боли были простыми и неприятными:

Из этих проблем и родились идеи: индексировать, распределять, параллелить.

Мы разберём, как устроен Lucene и почему он стал «двигателем» для множества поисковых решений, как Nutch подтолкнул к распределённости, и почему Hadoop (с HDFS и MapReduce) стал ответом на масштаб. В конце станет понятно, как поиск и обработка данных сошлись в одну цепочку — от сырого события до ответа пользователю.

Поиск — способ быстро находить релевантные документы по запросу.

Индекс — структура данных, которая ускоряет поиск (как оглавление в книге, только для миллионов страниц).

Кластер — группа серверов, работающих как единая система.

Распределённые данные — данные, разложенные по нескольким машинам так, чтобы хранение и обработка шли параллельно и переживали сбои.

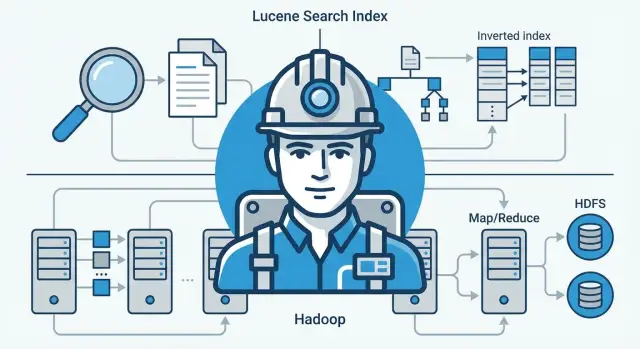

Apache Lucene — это не «готовый поисковик», а библиотека, из которой собирают поисковый движок внутри продукта: сайта, корпоративного портала, почтового архива, каталога товаров. Она отвечает за две ключевые вещи: быстро построить поисковый индекс и так же быстро находить в нём релевантные документы.

Если искать «в лоб» по всем текстам, система будет каждый раз перечитывать документы и сравнивать строки — медленно и дорого. Lucene заранее строит индекс: по сути, удобный справочник «слово → где встречается».

На уровне идей всё выглядит так:

Плюс Lucene умеет фильтры, фразы, поиск по нескольким полям, подсветку совпадений, а также обновление индекса без полной пересборки — всё это критично для «живых» систем.

Открытый исходный код означал, что компании могли взять Lucene как основу и не начинать с нуля: улучшения возвращались в проект, появлялись плагины, документация, примеры. Это снижало риск «завязнуть» во внутреннем самописном поиске, который держится на одном-двух авторах.

Самописный поиск часто ограничивался подстрочным совпадением и быстро деградировал на объёмах. Lucene давал промышленную базу: эффективный индекс на диске, продуманную модель полей, адекватную релевантность и предсказуемую скорость даже на больших коллекциях документов.

Nutch появился как попытка сделать полноценный веб‑поисковик, опираясь на Apache Lucene. Если Lucene отвечал за «сердце» поиска — индекс и быстрый ответ по запросу, то Nutch должен был закрыть всё остальное: сходить в интернет, собрать страницы, привести их к понятному виду и регулярно обновлять результаты.

В начале 2000‑х был заметен разрыв: существовали библиотеки для поиска по уже готовым документам, но не хватало открытого проекта, который решал бы задачу «от нуля до выдачи» для веба. Nutch стал таким экспериментом: как построить цепочку от обхода сайтов до индекса и ранжирования, сохранив всё это в виде понятной, расширяемой системы.

У веб‑поиска есть практические блоки, без которых Lucene один не справится:

Важно, что эти части работают не «один раз», а постоянно: сеть меняется, документы устаревают, нужно переиндексировать и поддерживать актуальность.

На маленьких объёмах всё выглядит просто: один сервер, одна база, один индекс. Но веб быстро упирается в пределы одного компьютера: страниц много, они скачиваются медленно, индексы растут, а обновление требует переработки огромного массива данных. Узким местом становится не один алгоритм, а сам подход к обработке: как параллелить задачи, как переживать сбои, как распределять хранение.

Работая над Nutch, команда фактически «нащупала» требования к будущей платформе: распределённое хранение, автоматическое восстановление при падениях узлов и модель пакетной обработки, которую можно запускать снова и снова на больших объёмах. Эти выводы и стали мостиком к Hadoop: Nutch показал, что для реального веб‑поиска нужна не только хорошая библиотека поиска, но и фундамент для распределённой работы с данными.

Когда объёмы данных были «умеренными», их можно было держать на одном сервере: там же хранить, там же считать, там же бэкапить. Но рост логов, документов, кликов и файлов быстро упирался не в одну магическую цифру, а сразу в несколько ограничений.

Первая боль — хранение. Дисков не хватает, а вертикально наращивать один сервер (больше дисков, более дорогой RAID, мощнее контроллер) становится всё дороже и сложнее.

Вторая — отказоустойчивость. Чем больше данных на одном узле, тем выше цена любой поломки: диск «умер» — и часть данных недоступна; сервер упал — остановилась и работа, и восстановление.

Третья — время обработки. Даже если данные где-то лежат, их нужно регулярно пересчитывать: агрегаты, отчёты, обновления индексов, поиск аномалий. На одном сервере такие задачи начинают выполняться часами и сутками, а бизнесу нужен более предсказуемый цикл.

Исторически крупные системы решали это железом «классом выше»: большими, дорогими, мощными машинами. Альтернативная идея, которая и стала фундаментом Hadoop, звучит проще: распределить хранение и вычисления по множеству обычных серверов (commodity hardware) и научиться переживать их регулярные отказы программно.

Это меняет экономику: вместо редких, но очень дорогих апгрейдов — постепенное добавление новых узлов по мере роста данных.

Первые массовые сценарии были пакетными: собрать большой объём сырья за период и «прогнать» его ночным/регулярным джобом. Это лучше ложилось на реальные потребности того времени:

Ключевой инсайт масштаба: дорого не только считать, но и перемещать терабайты по сети. Поэтому правильнее отправлять вычисления туда, где данные уже лежат. Такая логика уменьшает сетевые «пробки», ускоряет обработку и делает систему устойчивее: если один узел недоступен, работу можно перераспределить, не останавливая весь процесс.

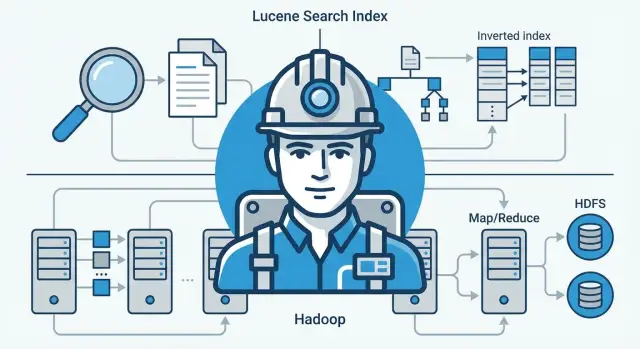

Hadoop стал практичным ответом на простой вопрос: что делать, когда данных так много, что они не помещаются на один сервер — и при этом их нужно регулярно обрабатывать. Два ключевых компонента решают эти задачи «в паре»: HDFS хранит, MapReduce считает.

HDFS (Hadoop Distributed File System) — распределённая файловая система. Её идея: разбить большой файл на блоки (например, по 128 МБ) и разложить эти блоки по разным машинам кластера.

Зачем так делать:

В реальности серверы ломаются, диски умирают, сеть «моргает». HDFS исходит из того, что сбои — норма, и потому каждый блок хранится в нескольких копиях (часто в трёх). Если один узел пропал, система берёт копию на другом и автоматически восстанавливает недостающую реплику. Для пользователя это выглядит как обычный файл, который «просто есть», даже если в кластере что-то вышло из строя.

MapReduce предложил понятную модель распределённых вычислений:

Эта схема избавляла команды от ручного управления потоками, пересылкой промежуточных данных и повторным запуском «упавших» кусочков работы — платформа брала это на себя.

MapReduce особенно хорошо работал там, где нужно много однотипных вычислений над большими объёмами:

Важно: это прежде всего пакетная обработка — не про мгновенные ответы, а про надёжный «конвейер», который переваривает большие массивы данных.

Долгое время «поиск» и «обработка данных» жили в разных мирах: поисковый движок отвечал на запросы людей, а вычислительные системы считали отчёты и агрегации «на ночь». Но с ростом объёмов логов, событий и документов выяснилось, что это одна и та же труба: данные сначала нужно собрать и привести в порядок, а затем сделать их удобными для поиска и аналитики.

Lucene решает задачу интерактивного доступа: построить индекс и быстро отвечать на вопросы вида «найди все записи, где…». Hadoop (HDFS + MapReduce) закрывает тяжёлую часть: недорого хранить сырьё и выполнять массовую обработку — фильтрацию, обогащение, дедупликацию, подсчёты.

Вместе они дают понятную связку:

Представьте сервис, который пишет миллиарды строк логов в сутки.

Собрать логи в единый формат и сложить в распределённое хранилище.

Обработать пакетно: убрать мусор, нормализовать поля (время, ID, статус), добавить признаки (гео по IP, тип устройства), посчитать производные метрики.

Построить индекс по итоговой «чистой» таблице/набору документов: чтобы можно было искать по пользователю, ошибке, периоду, компоненту.

Искать интерактивно: инженер вводит запрос и за секунды получает релевантные события вместо многочасового сканирования сырья.

Интерактивный поиск нужен, когда важны секунды ответа и гибкие фильтры по полям. Пакетная обработка — когда вы считаете метрики на огромном объёме, строите витрины, обучающие выборки или пересчитываете данные целиком. На практике эти режимы дополняют друг друга: обработка готовит качественные данные, а поиск превращает их в удобный инструмент для людей и продуктовых сценариев.

Многие технологии остаются «сильными внутри команды авторов», пока их использование не становится предсказуемым для внешних людей и компаний. В случае Lucene, Nutch и Hadoop решающим ускорителем оказалось Apache‑сообщество — не как бренд, а как набор привычек: прозрачные правила, публичные обсуждения и регулярные релизы.

Apache‑проекты жили по понятной схеме: код попадает через ревью, решения фиксируются публично, релизы собираются повторяемо, а обратная совместимость считается важной. Для бизнеса это превращало «проект энтузиастов» в управляемый риск: можно планировать обновления, обучать новых людей по документации и рассчитывать, что завтра интерфейсы не изменятся внезапно.

Отдельно важна культура ревью. Когда изменения смотрят не только авторы, но и другие мейнтейнеры, появляются единые стандарты качества: как проектировать API, как измерять производительность, как документировать настройки. Это снижает порог входа и для контрибьюторов, и для компаний‑пользователей.

«Де‑факто стандарт» чаще появляется не из-за лозунгов, а из-за совместимости. Если данные лежат в открытых форматах, а доступ к ним идёт через понятные API, то вокруг ядра начинают собираться разные поставщики и команды: кто-то делает удобнее хранение, кто-то — обработку, кто-то — мониторинг.

Так и возникает экосистема: не список «обязательных компонентов», а набор взаимозаменяемых инструментов, которые умеют работать с теми же данными и теми же интерфейсами.

Типичный путь выглядел прагматично. Сначала — пилот на ограниченном объёме (часто для логов или поиска по документам), затем — небольшой кластер, после — выделенная команда эксплуатации.

На этапе масштабирования выяснялось, что важны не только вычисления, но и процессы: кто отвечает за обновления, как делаются бэкапы, где смотреть метрики, что считать инцидентом. Когда ответы становились стандартными и повторяемыми, технология переставала быть экспериментом — и начинала распространяться массово.

В первых версиях Hadoop всё крутилось вокруг связки HDFS + MapReduce. Это давало понятную «фабрику» пакетной обработки: загрузили данные в распределённое хранилище, запустили джобы, получили результат. Но довольно быстро проявились ограничения такого подхода.

MapReduce отлично подходит для больших батчей, но плохо — для задач, где нужна низкая задержка или много шагов подряд.

Иными словами, Hadoop решал проблему масштаба, но требовал мириться с тем, что скорость и удобство разработки иногда страдают.

Ключевой архитектурный шаг — отделить управление ресурсами кластера от конкретной модели вычислений. Эту роль взял на себя YARN (Yet Another Resource Negotiator).

YARN превратил кластер из «кластера под MapReduce» в универсальную среду, где разные типы задач могут делить одни и те же ресурсы: CPU, память, очереди, приоритеты. В результате Hadoop перестал быть «одной программой» и стал фундаментом, на который можно ставить разные движки обработки.

Когда хранение (HDFS) и вычисления (движок) перестали быть жёстко связаны, начали активно развиваться другие подходы:

Практически это означало: данные могут оставаться в том же «озере», а способ вычисления подбирается под задачу.

Hadoop со временем стал не «одной кнопкой», а набором компонентов и практик: хранение, управление ресурсами, разные вычислительные движки, инструменты доступа и управления данными. Успех внедрения зависит не только от установки, но и от того, как вы проектируете пайплайны, выбираете модели обработки и настраиваете эксплуатацию кластера.

Появление связки «дешёвое хранение + распределённые вычисления + поисковые индексы» превратило данные из побочного артефакта в полноценный актив компании. Это быстро отразилось на том, кого нанимают, как строят процессы и что считают «готовым результатом».

Раньше часто хватало администратора БД и аналитика с отчётами. С ростом объёмов стало важно уметь:

Именно здесь сформировался спрос на дата-инженеров и специалистов по эксплуатации данных: людей, которые делают так, чтобы данные стабильно приезжали, не ломались и были пригодны для использования.

Когда данных стало много, выяснилось, что важнее не один запрос, а весь путь данных: от источника до витрины, отчёта или поиска.

Команды начали мыслить категориями схемы и контрактов (что означает поле и кто за него отвечает), пайплайнов (какие шаги преобразований и где может произойти сбой), мониторинга (сигналы о задержках и деградации качества) и воспроизводимости (одинаковый результат при повторном прогоне, понятная версия входных данных и правил обработки).

Как только на одни и те же наборы данных начали опираться разные команды — маркетинг, финансы, антифрод, поиск — стало ясно: данные должны иметь владельца, SLA по обновлению, документацию и понятный интерфейс потребления. Это и есть «данные как продукт» — не лозунг, а способ снизить хаос и цену ошибок.

Даже если вместо Hadoop используются облачные хранилища, Spark или стриминг-платформы, неизменными остаются принципы: распределённость требует дисциплины, качество данных — системной работы, а ценность дают не технологии сами по себе, а стабильные и понятные цепочки поставки данных.

В историях про Lucene и Hadoop легко увлечься «большими» технологиями и забыть простой вопрос: что именно вы пытаетесь решить — быстрый поиск по документам или тяжёлые расчёты на больших объёмах? На практике эти задачи часто соседствуют, но выбираются по разным сигналам.

Поисковый движок (в духе Apache Lucene) стоит доставать, когда основной запрос звучит как «найди и отсортируй».

Ключевые признаки:

Распределённые системы обработки данных (в логике Hadoop/MapReduce) оправданы, когда основной вопрос — «посчитай».

Сигналы:

Если данных мало, запросов немного, а «поиск» — это пара фильтров по полям, часто хватает обычной БД и аккуратных индексов. Аналитику на старте нередко закрывает один сервер и простой пайплайн на SQL/скриптах: важнее скорость изменений, чем масштаб.

На практике часто выигрывает связка: обработка готовит данные и признаки, а поиск отдаёт их пользователю быстро и удобно.

Большие данные редко «включаются» кнопкой. Лучше двигаться маленькими шагами, чтобы быстро увидеть эффект и не утонуть в инфраструктуре.

Начните с прототипа на небольшой, но репрезентативной выборке: например, 1–5% событий, ограничение по одному региону или одному типу документов.

Сразу договоритесь о метриках выигрыша:

Важно, чтобы прототип отвечал на конкретный вопрос бизнеса («сможем быстрее находить X» или «сократим время расчёта Y»), а не просто демонстрировал технологию.

До масштабирования зафиксируйте основы, которые потом сложно менять:

Заложите «обслуживание» сразу: мониторинг задержек и ошибок, алерты по понятным порогам, журналирование. Для пайплайнов полезны правила управления версиями: где хранится конфигурация, как выкатываются изменения, как делается откат.

Если вы на этапе, когда важнее скорость проверки гипотез, чем идеальная инфраструктура, часть задач можно ускорить за счёт инструментов, которые сокращают путь от идеи до прототипа. Например, TakProsto.AI — vibe-coding платформа для российского рынка: она помогает собирать веб‑приложения, серверные компоненты и мобильные клиенты через чат (с режимом планирования, снапшотами и откатом), а при необходимости — экспортировать исходники. Это удобно, когда нужно быстро сделать внутренний интерфейс поиска/аналитики или сервис для доступа к данным, не раздувая цикл разработки.

Если хотите углубиться, посмотрите разборы и кейсы в /blog. А если вы оцениваете продуктовую часть (стоимость, уровни поддержки, SLA), логично свериться с /pricing и заранее понять бюджет на рост.

Даг Каттинг — разработчик и участник Apache‑сообщества, который последовательно решал две практические задачи:

Ценность истории в том, что инструменты выросли из реальных ограничений по объёмам, сбоям и времени расчёта.

В начале 2000‑х резко выросли объёмы страниц, логов, писем и событий. Типовые проблемы были такими:

Ответом стали индексирование, распределённое хранение и параллельная обработка.

Lucene — это библиотека, из которой собирают поисковый движок внутри продукта. Обычно её используют, когда нужно:

Это не «готовый поисковик», а базовый строительный блок для поиска.

Индекс — это структура, которая помогает находить документы без полного перебора текстов. В упрощённом виде это справочник вида «термин → где встречается».

Практический смысл:

Потому что самописный поиск часто упирается в типовые ограничения:

Открытый код и экосистема вокруг Lucene снижают риск и ускоряют внедрение за счёт готовых практик, документации и предсказуемых релизов.

Nutch пытался закрыть весь цикл веб‑поиска поверх Lucene: обойти сайты, собрать страницы, хранить сырьё и метаданные, очистить контент и построить индекс.

Ключевые компоненты:

Именно масштаб этих задач быстро показал пределы «одного сервера».

Hadoop понадобился, когда стало ясно, что важны сразу три вещи:

Идея — собирать систему из множества обычных серверов и компенсировать их отказы программно.

HDFS (распределённая файловая система) делит большие файлы на блоки и раскладывает их по узлам кластера.

Чтобы переживать поломки, используется репликация:

Для пользователя это выглядит как «файл просто доступен», даже если в кластере что-то сломалось.

MapReduce — модель распределённых вычислений из двух фаз:

Лучше всего подходит для пакетных задач на больших объёмах:

Ориентируйтесь на тип результата и требования к задержке:

Часто выигрывает связка: обработка готовит данные, а поиск даёт быстрый интерактивный доступ.

Для старта без лишней боли полезно идти от малого пилота и зафиксировать метрики успеха; дальше можно углубляться через материалы в /blog и заранее прикинуть бюджет и поддержку в /pricing.