12 авг. 2025 г.·8 мин

Datadog: как обсервабилити становится платформой, а не набором

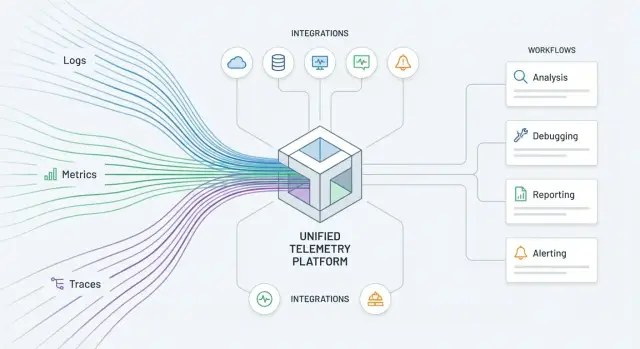

Разбираем, как Datadog эволюционирует от мониторинга к платформе: единая телеметрия, интеграции и встроенные workflows для команд DevOps и SRE.

Почему обсервабилити превращается в платформу

Раньше «мониторинг» часто означал набор разрозненных экранов: графики по инфраструктуре, отдельный APM, где-то ещё логи, а инциденты — в чате. Это работало, пока системы были относительно простыми. Но когда сервисов десятки, а релизы происходят постоянно, ценность смещается: важно не столько «увидеть график», сколько быстро понять причину и выполнить нужное действие.

Коротко: чем платформа отличается от набора инструментов

Набор инструментов отвечает на вопрос «что происходит?» — но в разных местах и разными способами.

Платформа наблюдаемости (вроде Datadog) делает три вещи одновременно:

- Собирает и связывает сигналы в единую картину (не отдельные панели, а контекст).

- Даёт общий язык для команд: одни и те же сущности, теги, сервисы, окружения.

- Встраивает действия: от диагностики к исправлению, не «выпрыгивая» в десяток систем.

Именно связность и возможность действовать превращают наблюдаемость в платформу, а не в «зоопарк».

Почему «продуктом» становятся данные и действия, а не графики

График сам по себе редко решает проблему. Решает её цепочка: сигнал → объяснение → решение. Поэтому «продуктом» становятся:

- Данные с качеством: правильные теги, корректная агрегация, достаточная детализация, понятные единицы измерения.

- Контекст: привязка метрик к логам, трассировкам, версиям релиза, региону, конкретному сервису.

- Действия: созданный тикет, запуск runbook, блокировка неудачного релиза, оповещение нужной смены.

Когда эти элементы живут в одной системе и не требуют ручной «склейки», команды начинают воспринимать обсервабилити как рабочую среду, а не витрину.

Кому это полезно

- DevOps/SRE — чтобы управлять надёжностью через общие правила, SLO и приоритеты, а не бесконечные «пожары».

- Разработке — чтобы быстрее находить корень проблемы в программировании и видеть влияние релизов.

- Поддержке — чтобы отвечать пользователям фактами (что сломалось, кого затронуло, когда восстановится).

- Безопасности — чтобы связывать события и аномалии с сервисами и изменениями, а не искать по отдельным источникам.

Что вы получите из статьи

Дальше разберём практические критерии: как оценить, вы строите платформу или коллекцию инструментов, какие интеграции дают максимальный эффект, как управлять стоимостью и шумом, и как выстраивать workflows так, чтобы наблюдаемость приводила к конкретным решениям. Если хотите сразу перейти к практической части — смотрите раздел про /blog/plan-vnedreniya-datadog.

От мониторинга к обсервабилити: что меняется по сути

Мониторинг обычно отвечает на вопрос «что сломалось?»: красный график, превышен порог, сервис недоступен. Обсервабилити отвечает на более практичный вопрос: «почему это произошло и что делать дальше?» Разница не в модном термине, а в том, как быстро команда переходит от сигнала к конкретному решению.

Три кита и типичные разрывы

В основе — метрики, логи и трассировки. В мониторинге их часто собирают разрозненно: метрики живут в одной системе, логи — в другой, трассы — «когда-нибудь подключим». Из-за этого возникает знакомый сценарий: алерт пришёл по CPU, инженер уходит в логи, потом пытается вручную сопоставить это с конкретным запросом и релизом.

В обсервабилити эти три источника должны «склеиваться» вокруг одного контекста: конкретного сервиса, эндпоинта, версии, пользователя, региона. Тогда Datadog становится не витриной графиков, а местом, где путь от симптома до причины сокращается за счёт связей между сигналами.

«Разные источники правды» и почему это дорого

Когда у команд разные инструменты и разные определения «нормы», появляется несколько источников правды:

- продукт смотрит на бизнес-метрики в одном дашборде;

- разработка — на APM в другом;

- SRE — на инфраструктуру в третьем.

В итоге спорят не о причине инцидента, а о данных. Цена такой задержки — время: пока вы ищете первопричину, сервис продолжает деградировать. Часто восстановление (mitigation) возможно быстрее, чем идеальный RCA, но без единого контекста даже временное решение находится медленно.

От наблюдения к управлению

Обсервабилити — это переход от пассивного «наблюдаем» к активному «управляем»: алерт не просто сообщает, что стало плохо, а помогает выбрать действие. Хорошая практика — строить сигналы вокруг пользовательского опыта (латентность, ошибки, насыщение) и привязывать их к понятным шагам: кто отвечает, что проверить, как откатить, где посмотреть связанный лог/трейс.

Так система наблюдаемости становится операционным инструментом, а не набором разрозненных датчиков.

Телеметрия как реальный продукт: качество и контекст

Когда вы выбираете Datadog, вы на самом деле «покупаете» не только интерфейс и красивые графики. Главная ценность — телеметрия, которая постоянно поступает в систему и помогает отвечать на вопросы о работе сервиса. Если относиться к ней как к побочному эффекту мониторинга, быстро появляются слепые зоны, спорные цифры и лишние расходы.

Телеметрия как продукт: сбор, качество, контекст, доступность

«Телеметрия как продукт» означает, что у данных есть владелец, требования к качеству и понятные правила потребления.

Сбор — это не просто поставить агент. Важно, чтобы данные были полными (покрывали ключевые компоненты), регулярными (без провалов) и сопоставимыми между командами.

Качество — это корректные таймстемпы, понятные единицы измерения, отсутствие дублей и предсказуемая задержка доставки. Иначе алерты «прыгают», а расследование инцидента превращается в угадывание.

Контекст — это то, что делает метрику или лог полезными: к какому сервису относится, в каком окружении случилось, какая версия была развёрнута, какой пользовательский путь затронут.

Доступность — это возможность быстро находить и использовать данные: единые названия, стабильные теги, понятные права доступа и отсутствие сюрпризов в стоимости запросов.

Нормализация терминов: сервис, хост, окружение, версия

Чтобы данные «склеивались», договоритесь о словаре. Что такое service — приложение, микросервис или команда? Что считается environment: prod/stage или отдельные регионы? Как обозначаете version: git sha, semver, номер релиза?

Хорошая практика — закрепить эти определения и следить, чтобы они одинаково попадали в метрики, логи и трейсы. В Datadog это часто реализуют через стандартизированные теги и атрибуты, которые команда воспринимает как контракт.

Единые теги/атрибуты как основа связности данных

Связность строится вокруг нескольких обязательных полей: service, env, version, region/zone, team, а для запросов — request_id/trace_id. Тогда вы можете провалиться из алерта по SLO в конкретные трейсы и тут же увидеть связанные логи без ручного «сопоставления по времени».

Риски: шум, кардинальность, стоимость, приватность

Если отправлять всё подряд, вы получите шум: тысячи малозначимых сигналов, которые скрывают важные.

Кардинальность (слишком много уникальных значений тегов, например user_id или полный URL) быстро увеличивает стоимость хранения и усложняет запросы.

Отдельный риск — приватность: персональные данные и секреты не должны попадать в логи и атрибуты. Нужны фильтры, маскирование и понятные правила, что разрешено отправлять в телеметрию, а что — нет.

Единая модель данных: как связать метрики, логи и трейсы

Главная ценность единой модели данных в Datadog — корреляция. Она превращает «сработал алерт» в цепочку ответов: какой сервис деградировал, какой endpoint или конкретный запрос дал всплеск, какие логи подтвердят причину, и что изменилось в релизе за последние 30–60 минут. Без этой связности обсервабилити остаётся набором разрозненных экранов.

Смысл корреляции: от алерта до конкретного факта

Когда метрика, трейс и лог описывают одну и ту же реальность одинаковыми идентификаторами (сервис, окружение, версия, хост/контейнер), Datadog может «проваливать» вас по контексту: от графика latency к медленным trace-спанам и дальше к логам именно того запроса.

Сценарий: инцидент в проде

Допустим, алерт по росту p95 latency на API в prod. Дальше рабочий путь выглядит так:

-

Открываете график и видите, что проблема локализуется на одном сервисе и конкретном ресурсе (endpoint).

-

Переходите в APM и находите трейсы с аномальной длительностью: например, узкое место в запросе к базе или внешнем API.

-

По тому же trace_id/корреляционным тегам открываете логи запроса и видите конкретную ошибку (таймаут, ретраи, лимиты) и параметры, которые её воспроизводят.

-

Сверяете временную точку с деплоем и понимаете, связано ли ухудшение с изменениями кода или конфигурации.

Единые представления: карты и зависимости

Единая модель данных позволяет строить сервисные карты и dependency-графы, где видно не только «что упало», но и «кого потянуло за собой». Отдельно полезна привязка к релизам: вклад версий в ошибки и задержки становится наблюдаемым, а не предметом догадок.

Что важно настроить заранее

Чтобы корреляция работала стабильно, договоритесь о стандартах:

- Именование сервисов и ресурсов (одинаково в APM, метриках и логах).

- Теги: env (prod/stage), service, team, region.

- Версии: version для релизов и git sha при возможности.

- Единые поля в логах (например, trace_id/span_id), чтобы «переходы» были в один клик.

Эти базовые правила обычно дают больший эффект, чем добавление ещё одного дашборда.

Интеграции как мультипликатор ценности платформы

Интеграции — это то, что превращает Datadog из «ещё одной панели с графиками» в платформу, которую реально удобно разворачивать и масштабировать. Когда новые команды, сервисы и инфраструктурные компоненты подключаются за часы, а не за недели, вы получаете не только видимость, но и охват: меньше слепых зон, быстрее поиск причин, легче стандартизация.

Почему интеграции важнее очередного дашборда

Один идеально сделанный дашборд не решает проблему, если половина критичных систем не шлёт телеметрию, а метки (теги) не совпадают. Хорошая интеграция сразу даёт «скелет» наблюдаемости: правильные метрики/логи/трейсы, базовые дашборды, типовые алерты и общую схему тегирования. Это снижает порог входа для команд и делает данные сопоставимыми между сервисами.

Какие классы интеграций дают максимальную отдачу

На практике ценность быстрее всего дают интеграции с:

- облаком (учётные записи, биллинг, managed-сервисы);

- контейнерами и оркестраторами (Docker/Kubernetes);

- базами данных и кэшами;

- очередями и стримингом;

- CI/CD и репозиториями (чтобы видеть связь релиза и деградации);

- коммуникациями и ITSM (чтобы алерты попадали туда, где принимают решения).

Важно не количество подключений, а то, насколько они закрывают ключевые точки отказа и цепочки зависимостей.

Антипаттерн: разрозненные агенты и дублирующие источники

Частая ошибка — ставить «по агенту на каждую задачу» или тянуть одни и те же метрики из двух систем. Итог: разные названия показателей, несовпадающие теги, двойная стоимость хранения и море шума в алертах. Лучше заранее определить один основной путь сбора (агент/интеграция/шлюз), а всё остальное подключать только при явной пользе.

Критерии хорошей интеграции

Перед тем как считать интеграцию «готовой», проверьте четыре вещи: поддерживаются ли единые теги (service/env/region/team), есть ли автодашборды, есть ли рекомендованные алерты, и можно ли связать данные с остальными сигналами (например, метрики с логами по одинаковым тегам). Тогда интеграции действительно умножают ценность платформы, а не добавляют ещё один источник разрозненных данных.

Обработка и управление данными: стоимость, шум, доступ

Деплой с данными в РФ

Разместите приложение на инфраструктуре в России и держите данные внутри страны.

Когда обсервабилити становится платформой, «данные» перестают быть побочным продуктом мониторинга. Их нужно сознательно формировать: снижать шум, контролировать стоимость и обеспечивать правильный доступ. Иначе вы быстро получите дорогую свалку логов и метрик, где трудно найти причину инцидента.

Пайплайны логов и метрик: меньше мусора, больше смысла

Практика, которая окупается почти сразу — настроить обработку на входе. В Datadog это обычно делается через пайплайны:

- Фильтрация: отбрасывайте повторяющиеся/неинформативные события (например, health-checks), чтобы не платить за шум.

- Обогащение: добавляйте контекст (service, env, region, version, team), чтобы потом связывать логи, метрики и трейсы без ручного поиска.

- Маскирование: скрывайте чувствительные данные (токены, телефоны, email), чтобы не превратить телеметрию в риск для комплаенса.

Важно: правила лучше делать «по умолчанию безопасными» — проще разрешить нужное, чем потом вычищать лишнее.

Кардинальность и бюджет телеметрии

Главный скрытый драйвер стоимости — кардинальность (количество уникальных комбинаций тегов). Один невинный тег вроде user_id в метриках может «взорвать» объём.

Полезный подход: заранее определить бюджет телеметрии по командам/сервисам (что собираем, с какой частотой, какие теги разрешены) и закрепить это в стандартах. Для метрик — ограничивайте высококардинальные теги, для логов — используйте семплирование там, где допустимо.

Ретеншн и уровни детализации

Не все данные должны жить одинаково долго. Обычно лучше хранить:

- агрегированные метрики и SLO — дольше (для трендов и планирования);

- детальные логи и трейсы — короче (для расследований), оставляя повышенную детализацию только для критичных сервисов или во время инцидентов.

Политики доступа: кто видит какие данные

Платформа наблюдаемости — это ещё и система контроля. Разделяйте доступ по окружениям (prod/dev), по командам и по типам данных. Это снижает риск утечек, упрощает аудит и помогает не «раздавать всем всё», сохраняя при этом удобство работы инженеров и SRE.

Workflows: когда действия встроены в наблюдаемость

Обсервабилити становится платформой в тот момент, когда она помогает не только «увидеть проблему», но и провести вас по цепочке «заметил → понял → сделал». Workflows — это встроенные сценарии действий, которые соединяют сигналы (алерты, аномалии, события деплоя) с конкретными шагами реагирования. Тогда наблюдаемость перестаёт быть витриной графиков и превращается в операционный инструмент.

«Заметил → понял → сделал» на практике

Сильный workflow начинается с контекста: алерт сразу показывает, какой сервис затронут, что поменялось (релиз, конфиг, рост нагрузки), какие зависимости могли повлиять и какие симптомы уже видны в метриках/логах/трейсах. Следующий шаг — действие, причём максимально близко к месту, где человек уже работает.

Типовые примеры, которые хорошо «приземляются» в платформе наблюдаемости:

- Триаж алертов: автогруппировка похожих сигналов, подавление дублей, приоритизация по влиянию на SLO.

- Эскалация: маршрутизация по расписаниям, критичности и владению сервисом (чтобы сигнал попадал к тем, кто реально может исправить).

- Создание тикета/задачи: автозаполнение данными из телеметрии (ссылки на дашборд, временной диапазон, подозреваемый релиз).

- Запуск runbook: переход к инструкции и запуск проверок/скриптов с фиксированным набором шагов.

Автоматизация и снижение MTTR

Когда повторяющиеся действия автоматизированы, уменьшается время на «поиск входа» в инцидент: меньше ручных переключений между инструментами, меньше ошибок от усталости, быстрее первые осмысленные шаги. Итог — снижение MTTR не за счёт героизма, а за счёт процесса.

Где нужна дисциплина

Workflows не «чинят» хаос сами по себе. Нужны чёткое владение сервисом (owner), правила эскалации, критерии критичности и договорённости: какие алерты считаются actionable, какие — информационные, кто обновляет runbook после инцидента. Без этой дисциплины автоматизация лишь ускорит шум, а не восстановление.

Алерты, SLO и дашборды: управление, а не просто графики

Релизы с быстрым откатом

Делайте изменения спокойнее с помощью снимков и отката, когда метрики ухудшаются после деплоя.

Наблюдаемость становится управляемой, когда сигналы приводят к решению: «что делать и кому». В Datadog это обычно сводится к трём опорам — алерты, SLO и дашборды — и к дисциплине их настройки.

Алерты: на симптом или на причину

Главный источник шума — алерты, которые ловят «всё подряд» и не отвечают на вопрос, есть ли реальная проблема для пользователя.

- Алерт на симптом: рост p95 latency, ошибка 5xx, падение успешных оплат. Такие алерты ближе к пользовательскому эффекту и реже «ложатся» из‑за фоновых флуктуаций.

- Алерт на причину: CPU, память, длина очереди, saturation пула, ошибки конкретной зависимости. Они полезны, но должны помогать разбору, а не будить ночью сами по себе.

Практика: сначала ставьте алерты на симптомы (и/или на SLO burn rate), а «причины» держите как диагностические сигналы в дашборде и в привязанных runbook.

SLO/SLI: общий язык продукта и инженеров

SLI — измерение (например, доля успешных запросов), SLO — цель (например, 99.9% успешных запросов за 30 дней). Когда SLO согласованы, разговор «плохо/хорошо» превращается в управление риском.

В Datadog удобно вести SLO на основе метрик и использовать их для:

- приоритизации задач (что реально влияет на пользователей),

- контроля релизов (не «страшно», а «съедаем бюджет ошибок»),

- настройки алертов по скорости выгорания бюджета вместо отдельных всплесков метрик.

Дашборды под роли, а не «один на всех»

Один и тот же сервис нужен разным людям по‑разному:

- On-call: текущий статус, SLO, последние инциденты, топ ошибок, быстрые ссылки на трейсы/логи.

- Тимлид/SRE: тренды по надёжности, hot spots, нагрузка, ёмкостное планирование, качество деплоев.

- Менеджер продукта: пользовательские KPI (успешность сценариев, конверсия, время ответа), влияние инцидентов и релизов.

Чек-лист базового набора сигналов

-

Для ключевого user journey определите SLI (успех/латентность) и цель SLO.

-

Создайте 2–3 алерта на симптомы: 5xx, p95 latency, отказ критической транзакции.

-

Добавьте алерт на burn rate SLO (короткое и длинное окно).

-

В дашборд диагностики включите «причины»: saturation, ошибки зависимостей, очереди, БД.

-

Для каждого алерта прикрепите краткий runbook: что проверить в первую минуту и как эскалировать.

Инциденты и runbooks: от реагирования к предсказуемости

Инцидент-менеджмент — это не «что-то сломалось, починили». Если обсервабилити становится платформой, то инцидент превращается в управляемый процесс с понятными входами (сигналы), выходами (восстановление сервиса) и измеримой эффективностью. В Datadog это особенно заметно, когда мониторинги, логи и трейсы не живут отдельно, а поддерживают единый сценарий работы команды.

Инцидент как процесс, а не чат в панике

Предсказуемость появляется, когда у инцидента есть стандартные этапы:

- Обнаружение: сигнал достаточно точный, чтобы не будить людей по ложным срабатываниям.

- Диагностика: быстрое сужение области поиска (какой сервис, какой релиз, какой регион, какая зависимость).

- Коммуникация: один канал, один ответственный, единый статус и понятный таймлайн.

- Ретро: фиксация причин, решений и улучшений, чтобы следующий раз был дешевле и быстрее.

Важно: если шаги повторяемы, их можно улучшать — если каждый раз импровизация, улучшать нечего.

Runbooks: как связать инструкции с сигналами

Runbook (плейбук) нужен не для «новичков», а чтобы даже опытные инженеры не тратили время на вспоминание. Хорошая практика — привязывать runbook прямо к сигналу: в тексте алерта указывать ссылку на плейбук, владельца сервиса, ожидаемый эффект и первый безопасный шаг.

Runbook становится частью платформы, когда в нём есть:

- критерии, что считать инцидентом (и что не считать);

- быстрые проверки (что посмотреть в первую минуту);

- решения с границами применения (когда можно откатывать, когда нельзя);

- шаги для временной стабилизации и для окончательного исправления.

Постмортемы и обучение системы

Постмортем — это не «поиск виноватого», а настройка системы на будущее. Помимо технических метрик, полезно собирать метрики процесса: MTTD/MTTR, долю ложных алертов, количество эскалаций, время до первого обновления статуса, процент выполненных action items и частоту повторных инцидентов по той же причине.

Как избегать «героизма»

«Героизм» выглядит эффективно, но делает результат случайным. Помогают роли (инцидент-командир, коммуникации, технический лидер), смены и стандарты качества сигналов. Цель — чтобы инцидент решался не «тем самым человеком», а предсказуемо любой дежурной командой по понятным правилам.

Наблюдаемость в жизненном цикле разработки и релизов

Если обсервабилити включается только «когда уже горит», вы теряете половину ценности. Платформенный подход в Datadog проявляется тогда, когда телеметрия сопровождает фичу от первого теста до реального трафика — и помогает принимать решения о качестве релиза, а не просто фиксировать симптомы.

Сдвиг влево: наблюдаемость в разработке и тестовых средах

Начните с того, чтобы в dev/stage окружениях были те же базовые сигналы, что и в production: метрики сервисов, логи, трейсы, ошибки. Это позволяет ловить проблемы раньше, но без «шума» продакшена.

Практика, которая хорошо работает: одинаковые теги (service, env, version) во всех средах и минимальный набор дашбордов «здоровья» на каждую команду. Тогда графики и трейсы сравнимы, а регрессии видны сразу.

Трассировка релиза: версии, фичефлаги, ошибки после деплоя

Связывайте деплой с телеметрией: version и git SHA в трейсы/метрики, событие деплоя на таймлайне, а также привязка к фичефлагам (через интеграции). После выката можно быстро ответить на вопросы:

- выросла ли ошибка 5xx именно в новой версии;

- какие endpoints деградировали по latency;

- какие пользователи/сегменты увидели проблему (если подключён RUM).

Улучшение производительности и UX на основе данных

Комбинация APM и RUM позволяет связать «медленно на сервере» с «плохо у пользователя»: например, рост TTFB в браузере можно подтвердить ростом времени в конкретном span в бэкенде. Это превращает оптимизацию в управляемый процесс: выбираете топ-страницы/сценарии, находите узкое место, проверяете эффект после релиза.

Связь с CI/CD: проверки качества и критерии отката

Когда Datadog подключён к CI/CD (например, через CI Visibility, синтетические тесты или API), обсервабилити становится частью релизных «гейтов». Типовые критерии: SLO-ошибки, рост p95 latency, всплеск Error Tracking, ухудшение ключевых RUM-метрик. Если порог превышен — автоматический стоп релиза или откат по заранее согласованному правилу.

Практическая связка для команд, которые делают много релизов

Если вы быстро запускаете новые сервисы (в том числе через vibe-coding, когда приложение собирается из диалога, а не вручную через долгий цикл разработки), требования к «телеметрии по умолчанию» становятся ещё жёстче: единые теги, базовые SLO и стандартные пайплайны логов нужны сразу, иначе скорость релизов превращается в скорость накопления хаоса.

В этом смысле TakProsto.AI удобно использовать как точку стандартизации: вы создаёте веб/серверные/мобильные приложения через чат, а затем фиксируете в шаблонах проекта обязательные поля (service/env/version/team), типовые алерты и базовые интеграции. При этом важно, что платформа ориентирована на российский рынок: данные и инфраструктура остаются в России, что упрощает требования по хранению и доступу к телеметрии.

План внедрения: как подойти к Datadog без перегруза

Стандарты тегов для команды

Сформулируйте единый словарь сервисов и окружений и примените его ко всем новым приложениям.

Самая частая ошибка при старте с Datadog — пытаться «подключить всё» за неделю. В итоге команда тонет в алертах, тегах и полуготовых дашбордах, а ценность для бизнеса не появляется. Гораздо эффективнее — идти как с продуктом: короткими итерациями, с измеримыми результатами.

0–2 недели: минимально жизнеспособная платформа (MVP)

Цель первых 30–60 дней — не идеальная наблюдаемость, а работающий базовый контур.

Что обычно стоит внедрить в первую очередь:

- сбор инфраструктурных метрик (хосты/контейнеры) и базовые APM-трейсы для 1–2 ключевых сервисов;

- централизованные логи для этих же сервисов (хотя бы error/warn + корреляция с трейсами);

- 1–2 дашборда: «здоровье сервиса» и «путь пользователя»;

- начальный набор алертов: доступность, ошибки, задержки — без тонкой настройки.

2–6 недели: выбор ключевых сервисов и критичных пользовательских путей

Выберите 3–5 сервисов, которые реально определяют опыт клиента: авторизация, оплата, поиск, оформление заказа — зависит от продукта. Хороший критерий: если этот компонент падает, вы теряете деньги или доверие.

Далее зафиксируйте 2–3 критичных пользовательских пути и стройте наблюдаемость вокруг них: метрики успеха (конверсия/успешные запросы), задержки, доля ошибок. Так Datadog становится инструментом управления продуктом, а не только «графиками для инженеров».

Проект №1: единые стандарты тегирования и именования

Без стандартов вы быстро получите «зоопарк»: разные названия одного и того же, невозможность фильтровать и сравнивать.

Минимальный набор стандартов:

- обязательные теги: service, env, team/owner, version, region;

- правила именования метрик и логгеров;

- единый подход к статус-кодам/типам ошибок.

Зафиксируйте это в коротком гиде и добавьте в чек-лист релиза.

Как измерять успех внедрения

Чтобы не спорить на уровне ощущений, договоритесь о метриках прогресса:

- MTTR (время восстановления) по инцидентам;

- «шум алертов»: доля неактуальных/дублирующих срабатываний;

- покрытие телеметрией: сколько ключевых сервисов имеют метрики + логи + трейсы;

- доля инцидентов, где причина найдена через Datadog (без «догадок»).

Если через 60 дней MTTR снижается, а команда реже «вслепую» ищет причину — вы внедряете платформу, а не очередной инструмент.

Как понять, что вы строите платформу, а не зоопарк инструментов

Платформа наблюдаемости — это не «ещё один интерфейс для графиков», а единый способ видеть систему, договариваться о качестве и быстро выполнять действия. Проверить, в какую сторону вы движетесь, можно по практическим признакам.

Сигналы, что платформа действительно работает

Если наблюдаемость стала платформой, это заметно не по числу интеграций, а по снижению трения в ежедневной работе:

- Меньше ручной рутины: типовые проверки и триаж автоматизированы (обогащение алертов контекстом, автопривязка владельцев, шаблоны диагностики).

- Быстрее диагностика: от алерта можно за минуты перейти к связанным трассам, логам, изменениям в релизе и владельцу сервиса.

- Единые правила: SLO, теги, именование, уровни критичности и права доступа стандартизированы, а не «у каждой команды по‑своему».

Типовые ошибки, которые превращают всё в зоопарк

Чаще всего деградация начинается с трёх установок:

- «Собираем всё» — стоимость растёт, сигнал тонет в шуме, команды перестают доверять данным.

- «Нет владельцев» — дашборды и алерты живут сами по себе, никто не отвечает за качество телеметрии и правила.

- «Алерты без действий» — уведомления не ведут к конкретному шагу: нет runbook, нет понятного next step, нет привязки к приоритету.

Вопросы для оценки решения и поставщика

Чтобы понять, потянет ли система роль платформы, задайте себе (и вендору) несколько вопросов:

- Интеграции: можно ли быстро подключать ключевые сервисы и получать связанный контекст, а не разрозненные панели?

- Workflows: поддерживаются ли встроенные сценарии действий (создание тикета, запуск проверки, уведомление владельца) прямо из сигнала?

- Управление данными: есть ли контроль стоимости, фильтрация шума, ретеншн, роли и аудит доступа?

Следующие шаги

Начните с аудита текущей телеметрии (что действительно используется в инцидентах, а что лежит мёртвым грузом), затем сделайте пилот на одном сервисе: минимальный набор SLO, алертов с действиями, единые теги и короткий runbook. Если после пилота время диагностики и число «пустых» срабатываний заметно снизились — вы строите платформу, а не коллекцию инструментов.

FAQ

В чём практическая разница между платформой наблюдаемости и набором отдельных инструментов?

Платформа связывает метрики, логи и трассировки в один контекст (service/env/version/region) и ведёт от сигнала к действию.

У «набора инструментов» обычно:

- разные источники правды,

- ручная склейка по времени,

- алерты без понятного next step.

Почему «продуктом» становятся данные и действия, а не дашборды?

Потому что график редко отвечает на вопрос «что делать дальше». Ценность появляется, когда данные:

- качественные (единицы, таймстемпы, без дублей),

- контекстные (привязаны к сервису, версии, релизу),

- приводят к действию (тикет, эскалация, runbook, откат).

Какие теги и термины нужно стандартизировать в первую очередь?

Начните со словаря и «контракта» тегов.

Минимальный обязательный набор:

serviceenv(prod/stage и т.п.)versionregion/zoneteam/owner

И добейтесь, чтобы те же значения попадали и в метрики, и в логи, и в трейсы — тогда корреляция будет работать стабильно.

Что чаще всего ломает корреляцию метрик, логов и трассировок?

Самые частые причины:

- разные имена сервисов/ресурсов в APM, логах и метриках;

- нет

trace_id/span_idв логах; versionне проставляется при деплое;- теги «гуляют» между окружениями.

Проверка: от алерта по latency вы должны за 1–2 клика открыть связанные трейсы и логи того же запроса.

Что такое кардинальность и как она влияет на стоимость?

Кардинальность — это слишком много уникальных значений тегов (например, user_id, полный URL, случайные параметры).

Практика:

- запрещайте высоко-кардинальные теги в метриках по умолчанию;

- для логов используйте семплирование и фильтрацию;

- нормализуйте URL (шаблоны вместо полного пути).

Так вы снижаете стоимость и сохраняете запросы быстрыми.

Как быстро уменьшить шум и риск в логах без потери полезности?

Настройте обработку «на входе», чтобы не платить за мусор и не плодить риск.

Обычно достаточно трёх шагов:

- фильтрация (health-checks, повторяющиеся события),

- обогащение (service/env/version/team),

- маскирование (секреты и персональные данные).

Правило: безопасные настройки по умолчанию, точечные исключения — осознанно.

Как правильно разделять алерты «на симптом» и «на причину»?

Делайте алерты в два слоя:

- симптомы (5xx, p95 latency, падение успешных транзакций) — будят и требуют реакции;

- причины (CPU, очереди, лимиты) — помогают диагностике и чаще живут в дашборде/runbook.

Хороший старт — алерты на симптомы + burn rate по SLO, а причины привязать ссылками в описание алерта.

Зачем вводить SLO и как они помогают в релизах и инцидентах?

SLO — общий язык продукта и инженеров: вы управляете не «страшными графиками», а бюджетом ошибок.

Практичные применения:

- приоритизация работ (что реально бьёт по пользователям),

- релизные решения (когда откатывать),

- алерты по выгоранию бюджета (короткое + длинное окно).

Что дают workflows и как понять, что они реально снижают MTTR?

Потому что цель — сократить путь «заметил → понял → сделал».

Полезные элементы workflow:

- группировка и подавление дублей,

- маршрутизация по владению и расписанию,

- автосоздание задачи с контекстом (ссылки, таймрейндж, подозреваемый релиз),

- запуск runbook прямо из алерта.

Без дисциплины владения и критериев actionable-алертов автоматизация лишь ускорит шум.

С чего начать внедрение Datadog, чтобы не утонуть в алертах и настройках?

Идите итерациями, а не «подключить всё сразу».

Типовой план:

- 0–2 недели: MVP (1–2 сервиса, APM+логи, 1–2 дашборда, базовые алерты)

- 2–6 недель: 3–5 ключевых сервисов и 2–3 пользовательских пути, первые SLO

- параллельно: стандарты тегирования/именования и владельцы данных

Если нужна опора на шаги, используйте практический раздел: /blog/plan-vnedreniya-datadog.