03 янв. 2026 г.·6 мин

Disruptor Pattern для низкой задержки: стабильный отклик

Disruptor Pattern для низкой задержки: разберем, что влияет на предсказуемый отклик, и какие архитектурные решения подходят для real-time приложений.

Что делает систему быстрой на практике

Низкая задержка - это не «самый быстрый ответ, когда повезло», а предсказуемый отклик почти всегда. Для real-time систем важнее ровность: пользователь терпит 40-60 мс стабильно, но сразу замечает редкие «подвисания» на 300-800 мс. Поэтому цель обычно формулируют так: не рекордный минимум, а узкий разброс и короткие хвосты.

Важно различать throughput и latency. Throughput - сколько событий в секунду система может переварить. Latency - сколько времени проходит от «событие пришло» до «результат готов». Можно добиться высокой пропускной способности, но нарастить очереди и пакетную обработку. Тогда отдельные события ждут своей очереди, и задержка растет. Бывает и наоборот: на малом потоке задержка низкая, но при нагрузке система начинает «сыпаться».

Пользователь ощущает не среднее, а p95/p99 - то, что случается «иногда». Среднее сглаживает проблему: 99 быстрых ответов и один очень долгий дают красивую цифру, но именно тот один ломает впечатление и способен сорвать SLA. Поэтому в low-latency разговорах почти всегда обсуждают хвосты: что происходит в худших 1-5% запросов.

Неожиданные паузы чаще рождаются не в «медленном коде», а там, где система вынуждена ждать: в планировщике ОС и переключениях контекста, в блокировках и конкуренции за общий ресурс, в паузах сборщика мусора и аллокациях памяти, в сетевом джиттере и повторах передач, в дисковом I/O и зависимых внешних сервисах.

Практическая «быстрота» получается, когда вы заранее убираете причины ожидания, а не просто ускоряете вычисления. Тогда и p99 начинает быть похож на p50, и система ведет себя как real-time, а не как «иногда быстро».

Задержка чаще ломается не из-за кода

Когда говорят про низкую задержку, часто обсуждают «быстрый код». Но в real-time системах p95 и p99 обычно портят не инструкции CPU, а ожидания: кто-то держит блокировку, поток стоит в очереди, сеть дала небольшой джиттер, затем это складывается в заметные хвосты.

Главные враги предсказуемости - места, где поток не делает полезной работы. Можно ускорить функцию в 2 раза, но если раз в минуту она ждет 50 мс, пользователю все равно будет «тормозить».

Откуда берутся неожиданные паузы

Первая причина - очереди и блокировки. Очередь выглядит невинно: положили событие, другой поток забрал. Но под нагрузкой появляются очереди ожидания, contention и эффект «пробки», когда одно медленное событие задерживает следующие.

Вторая причина - планировщик ОС. Поток может быть готов, но его снимут с процессора, чтобы дать время другим. Переключение контекста стоит времени, а момент переключения сложно предсказать, поэтому latency становится рваной.

Третья причина - память и кэш CPU. Доступ к данным из кэша быстрый, а промах по кэшу уводит чтение в оперативную память. Одна и та же операция начинает занимать в разы больше времени, особенно когда данные плохо укладываются в локальность.

Четвертая причина - аллокации и сборка мусора. Даже если паузы редкие, именно они раздувают p99. В системах на GC это может быть «stop-the-world», а в системах без GC - фрагментация и накладные расходы аллокатора.

Пример: сервис котировок обрабатывает 20k событий в секунду. Обычно ответ за 2-3 мс, но раз в несколько минут p99 прыгает до 80 мс. Профилирование показывает совпадение со всплеском аллокаций и конкуренцией за общую очередь.

Если цель - предсказуемая задержка, думайте не только про скорость кода, а про контроль ожиданий и редких длинных пауз.

Идея Disruptor Pattern простыми словами

Martin Thompson известен работами про низкие задержки в системах реального времени, особенно в финансовых и биржевых платформах. Там важны не только миллионы операций в секунду, но и ровный отклик: p99 и p99.9 не должны внезапно «взрываться».

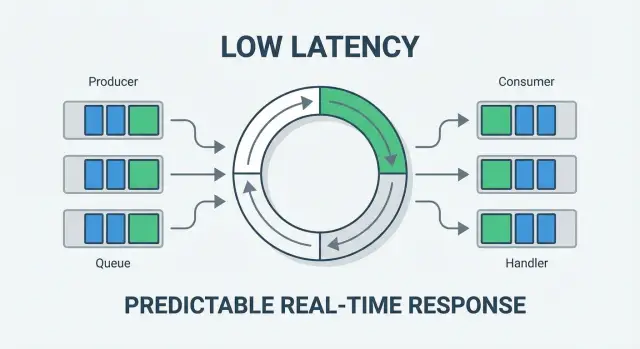

Disruptor Pattern можно представить как аккуратно организованный конвейер событий. В центре - ring buffer: заранее выделенный массив фиксированного размера, по которому события идут по кругу. Продюсер пишет данные в следующий слот, а потребители читают их в определенном порядке.

Как это устроено

Ключевая идея не в «хитрой очереди», а в последовательностях (sequence). У каждого участника есть счетчик: продюсер знает, в какой индекс записывать, а каждый потребитель - какой индекс уже обработан. Так можно координировать работу без постоянных блокировок и без «толкотни» между потоками.

В обычной очереди и пуле потоков часто появляется непредсказуемость: локи, конкуренция за память, переключения контекста, просадки из-за планировщика, всплески аллокаций и паузы GC. Даже если средняя скорость хорошая, хвосты распределения растут.

Disruptor пытается сделать путь события максимально регулярным: память выделена заранее, доступ идет по последовательным адресам, зависимости между стадиями конвейера описаны явно. Цель здесь не рекорды throughput любой ценой, а стабильность задержки.

Простой пример - поток котировок или игровых событий. Если обработчик иногда «подвисает», Disruptor позволяет контролируемо тормозить запись (backpressure) через счетчики, а не наращивать хаотичную очередь, которая копит задержку и ломает предсказуемость.

Почему ring buffer помогает держать задержку ровной

Ring buffer ценен не тем, что он «быстрее очереди» в лаборатории, а тем, что делает поведение системы более предсказуемым. В real-time почти всегда важнее ровный p99, чем редкие рекорды средней скорости.

Меньше давления на память и кэш

Обычные очереди нередко создают много мелких объектов и двигают данные по памяти. Это добавляет работы сборщику мусора, увеличивает промахи по CPU-кэшу и дает скачки задержки, которые сложно поймать тестами.

Ring buffer заранее выделяет фиксированный кусок памяти и переиспользует его. Данные лежат компактно и рядом, поэтому процессор чаще попадает в кэш, а система реже делает непредсказуемые паузы.

Один писатель и ровный ритм

Классический Disruptor опирается на простой принцип: один поток записывает события по порядку, потребители читают по индексам. Это снижает конкуренцию за блокировки и уменьшает случайные задержки из-за синхронизации.

На практике поток приема событий только публикует запись и двигает курсор. Тяжелая работа вынесена в последующие стадии обработки.

Отдельно помогает batching: вместо того чтобы будить потребителя на каждое событие, он забирает небольшую пачку за один проход. Это снижает накладные расходы на переключения и чтение счетчиков и часто улучшает p99, пока размер пачки ограничен.

Backpressure, когда потребитель не успевает

Если потребитель отстает, ring buffer заставляет явно выбрать стратегию, а не «копить вечно» до аварии. Обычно делают одно из трех: блокируют публикацию до освобождения места, допускают потерю части событий (с метриками), либо деградируют качество обработки.

Пример: в real-time панели мониторинга можно считать метрики пачками раз в 20-50 мс и при перегрузе пропускать часть промежуточных точек. Пользователь увидит стабильный отклик, а не зависания каждые несколько минут из-за хвостов.

Когда Disruptor уместен, а когда лучше выбрать другое

Контроль перегруза без хаоса

Смоделируйте backpressure и политики перегруза, чтобы задержка не «взрывалась».

Disruptor обычно выбирают не ради максимальной скорости «в среднем», а ради ровной задержки на хвостах (p95, p99). Он хорошо работает там, где поток событий предсказуемый, сообщения небольшие, а обработку можно разложить на понятные стадии с явными зависимостями.

Он уместен, если у вас непрерывный поток событий, важен порядок и сами сообщения компактные (обновление котировки, клик, событие датчика, изменение статуса). В таких сценариях выгодно заранее выделить память под ring buffer и пройти по данным без лишних аллокаций и блокировок.

Не лучший выбор - приложения с запрос-ответ логикой и сильной разнородностью: много веток, случайные чтения, тяжелые зависимости («сходи в БД», «сделай несколько внешних вызовов»). Плохо переносится и сильная вариативность времени обработки: один «медленный» обработчик способен растянуть очередь и испортить p99 для всех.

Если Disruptor не ложится на задачу, часто лучше подходят другие модели: очереди сообщений (когда важнее доставка и масштабирование между сервисами), акторы (много независимых сущностей со своим состоянием), каналы (когда важна простота и нагрузка умеренная), event loop (когда много I/O и нужна единая точка управления временем).

Правило выбора простое: сначала формулируйте SLO по задержке (например, p99 меньше 20 мс), затем измеряйте, где рождаются хвосты. Если хвосты идут от конкуренции за ресурсы, аллокаций и очередей между стадиями, Disruptor часто помогает. Если хвосты приходят от I/O, блокировок в БД или непредсказуемых внешних вызовов, вкладывайтесь в архитектуру вокруг этих узких мест.

Пошагово: как собрать pipeline для real-time обработки

Быстрый real-time отклик чаще получается не от «ускорения кода», а от понятного конвейера: один вход, несколько четких этапов и измерения на каждом из них. Важно заранее решить, где порядок обязателен, а где можно дать параллельность.

Этапы конвейера

Начните с одного входного потока событий. Это снижает хаос: меньше гонок, проще найти, где растет p99.

Типовой конвейер выглядит так: прием (минимум логики на входе) -> валидация и нормализация -> парсинг и легкое обогащение -> бизнес-логика -> запись и «выход наружу». Критичная мысль: прием должен быть простым, а все, что может ждать (сеть, диск, внешние сервисы), лучше изолировать.

Порядок фиксируйте там, где он важен для смысла (например, изменения состояния одного пользователя). Для независимых ключей используйте шардинг по ключу: внутри ключа порядок сохраняется, между ключами можно распараллелить.

Работа со временем и измерения

Вводите дедлайны на бизнес-логике: если событие не успевает, лучше вернуть контролируемый результат (например, «принято, обработка позже»), чем создавать хвост, который убьет p99 у всех.

Собирайте метрики по этапам, а не только «вход-выход». Минимальный набор - время ожидания перед этапом, длительность этапа, доля таймаутов и ретраев, размер буфера и частота backpressure, а также p50/p95/p99 отдельно по ключевым типам событий. Так вы быстро увидите, где именно задержка скачет: в очереди, в логике, в записи или на внешнем вызове.

Практичные архитектурные решения для предсказуемой задержки

Предсказуемая задержка достигается не ускорением одной функции, а тем, что вы заранее ограничили хаос: где копится очередь, кто кого блокирует, что может внезапно занять CPU или диск. Disruptor помогает внутри одного процесса, но вокруг него все равно нужна дисциплина.

Первое правило для real-time: срочные события не должны стоять в одной очереди с фоновыми. В чате важно быстро обработать входящее сообщение и показать статус доставки, а обновление аналитики или пересчет рекомендаций можно отложить. Разведите потоки так, чтобы фон не влиял на отклик.

Обычно ровную задержку дают несколько простых решений: приоритизация (отдельный канал для срочного и фонового), сглаживание нагрузки (rate limiting и небольшой входной буфер), изоляция «шумных» задач (сжатие, тяжелые запросы, массовые импорты) в отдельные воркеры или сервисы, минимум синхронных обращений в сеть и хранилище на критичном пути, а также стабильный и компактный формат событий, чтобы не платить за лишние преобразования.

Хороший тест - взять один пользовательский запрос и нарисовать его путь. Где он может ждать? Где берется блокировка? Где есть дорогие преобразования данных?

Частые ошибки, которые раздувают p99

Сервис событий за один вечер

Опишите этапы обработки в чате и получите каркас сервиса на Go и PostgreSQL.

p99 почти никогда не портится из-за «медленного алгоритма». Обычно его раздувают редкие паузы: ожидание блокировок, всплески нагрузки, сборка мусора, внезапные I/O операции. Поэтому даже если средняя задержка красивая, хвост может жить своей жизнью.

Типичная причина - смешивание блокирующих и неблокирующих действий в одном потоке. Вы обрабатываете событие быстро, а затем в том же обработчике делаете сетевой вызов, чтение диска или ждете мьютекс. Один «неудачный» запрос задерживает всех, и p99 улетает.

Еще одна ловушка - аллокации на горячем пути. Даже в языках без GC лишние выделения памяти бьют по кэшу, а в языках с GC добавляют редкие, но дорогие паузы. Особенно обидно, когда вы строите «ровный» конвейер, а вокруг него заводите поток объектов-однодневок.

Часто p99 портит «случайное» логирование: форматирование строк, сбор контекста, сериализация больших объектов. Это выглядит безобидно, пока не включится более подробный уровень логов или не сработает редкий путь ошибки.

Вот что чаще всего прячет проблему до продакшена: неограниченные очереди, отсутствие backpressure, отсутствие лимитов на тяжелые операции, отсутствие таймаутов и деградации, а также отсутствие p95/p99 по этапам (видите итоговую задержку, но не понимаете, где хвост).

Пример: real-time лента обновляется каждые 50 мс. В обработчике вы иногда дергаете внешний API за допданными и пишете подробный лог с форматированием JSON. 99% событий проходят быстро, но 1% ждет сеть и тратит время на сериализацию. Очередь раздувается, и уже следующий «быстрый» поток упирается в хвост.

Чеклист перед запуском в прод

Перед релизом real-time сервиса важнее всего не средняя скорость, а предсказуемость. Пользователь заметит не p50, а редкие подвисания.

Сначала зафиксируйте цель в цифрах: p50, p95, p99 и максимально допустимый хвост (например, единичные запросы не дольше X мс). Без этого вы не поймете, улучшили вы систему или просто поменяли форму графика.

Затем проверьте типовые точки, которые ломают p99:

- Метрики и трассировка: таймеры для очереди/буфера, обработки и отправки ответа, чтобы видеть, где растет задержка.

- Блокировки и ожидания: mutex/lock на горячем пути, конкурирующие очереди, ожидание диска/сети и синхронные вызовы наружу.

- Аллокации и GC: где создаются временные объекты и что можно переиспользовать.

- Лимиты и backpressure: размер буфера, политика переполнения и обязательные аварийные метрики.

- Разделение контуров: срочные задачи отделены от фоновых.

Если используете Disruptor, отдельно проверьте: действительно ли один писатель, не просачиваются ли блокирующие операции в обработчики, и понятна ли стратегия при перегрузе.

Небольшой тест перед продом: дайте системе ступеньку нагрузки на 10-20 минут и посмотрите, как ведут себя p99 и хвост при прогреве, пиках и восстановлении после пика.

Пример: real-time приложение с предсказуемым откликом

Прототипирование с локальной инфраструктурой

Стройте прототипы на платформе, которая работает на серверах в России и не гоняет данные за рубеж.

Представьте сервис, который раздает уведомления о сделках или изменениях цен. Пользователь ожидает реакцию за десятки миллисекунд, а не «когда получится». Тут важна не средняя скорость, а ровная задержка на p95-p99.

Поток событий может выглядеть так: прием (gateway) -> нормализация -> расчет (правила, риск, агрегации) -> публикация результата (push, websocket, запись в журнал).

Где здесь полезен Disruptor? Внутри горячего контура расчета, где нужно стабильно и быстро прогонять события через несколько стадий без лишних аллокаций и блокировок. Например, ring buffer можно поставить между нормализацией и расчетом, а также между расчетом и публикацией, если публикация тоже CPU-bound и контролируема.

А вот где лучше оставить обычную очередь или event loop: на границах системы. Прием из сети, запись в базу, обращение к внешним сервисам, отправка уведомлений в сторонние каналы - это I/O и непредсказуемые паузы. Эти части стоит изолировать, чтобы они не «заражали» хвосты критического пути.

Практичная раскладка часто такая: входной слой быстро кладет события в буфер (минимум работы на потоке приема), нормализация и расчет идут в фиксированном числе воркеров через ring buffer, публикация разделена на быстрый ответ и отдельный контур для тяжелого I/O, а для I/O используется очередь с backpressure и явными лимитами.

Хвосты тестируют не только ровной нагрузкой. Нужны всплески, длинные прогоны и «плохие дни»: замедление внешнего сервиса, паузы GC, переполнение очередей, деградация диска. Смотрите p99 по стадиям, а не только end-to-end, и фиксируйте, где растет очередь и где скачет время обработки.

Что делать дальше и как подойти к прототипу

Начните с измерений. Нужно увидеть, где рождается p99: в очереди, в блокировках, в GC, в сетевых прыжках или из-за пауз на стороне базы. Простой прототип часто дает больше ответов, чем недели обсуждений.

Перед кодом опишите систему как поток событий. Что является событием (тик цены, клик, сообщение), какие у него поля, сколько их в секунду, и какие этапы обработки обязаны уложиться в цель по задержке. Когда этапы названы, проще решить, где обработка должна быть последовательной ради стабильности, а где можно добавить параллельность.

Дальше соберите минимальный pipeline и усложняйте только по данным:

- Зафиксируйте SLO: например, p99 не выше 20 мс при 5k событий/с.

- Добавьте метрики по каждому этапу: время в очереди, время обработки, размер буфера, доля ошибок.

- Сделайте нагрузку рядом с реальной: равномерный поток и всплески.

- Проверьте один узкий сценарий end-to-end, а не десятки функций.

План экспериментов лучше записать заранее, иначе легко «улучшить» среднее и ухудшить хвост. Проверьте разные размеры ring buffer, batching (по времени или по количеству) и стратегии backpressure: отбрасывать, замедлять продюсеров или деградировать функциональность. Измеряйте не только latency, но и потери событий и рост памяти.

Если вам нужно быстро собрать и сравнить несколько вариантов архитектуры real-time пайплайна, это удобно делать на TakProsto (takprosto.ai): описываете этапы, поднимаете каркас приложения и быстрее доходите до нагрузочных тестов, где видно, что именно раздувает p99.