29 нояб. 2025 г.·8 мин

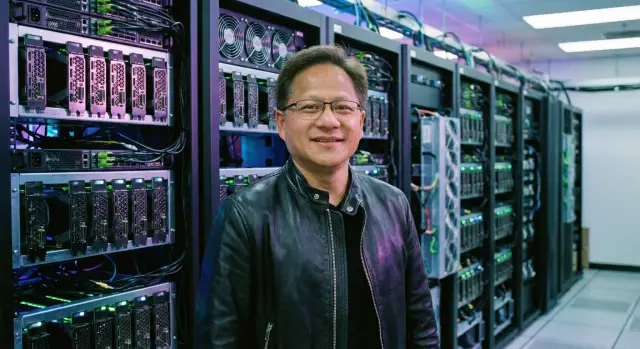

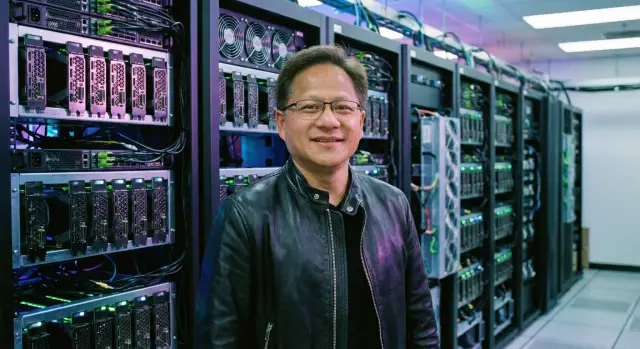

Дженсен Хуанг: как NVIDIA стала опорой ИИ‑революции

Разбираем, как Дженсен Хуанг выстроил стратегию NVIDIA: ставка на GPU, CUDA и дата-центры сделала компанию ключевой опорой ИИ.

Разбираем, как Дженсен Хуанг выстроил стратегию NVIDIA: ставка на GPU, CUDA и дата-центры сделала компанию ключевой опорой ИИ.

Дженсен Хуанг — сооснователь и бессменный CEO NVIDIA. Его имя всё чаще звучит рядом с бумом генеративного ИИ не потому, что он «изобрёл нейросети», а потому что NVIDIA сумела превратить вычисления для ИИ в массовую, доступную и воспроизводимую инфраструктуру. Когда компании по всему миру говорят «нам нужны GPU для обучения модели», они нередко имеют в виду именно NVIDIA — как стандарт де‑факто.

ИИ держится не на одном компоненте. Нужны:

NVIDIA оказалась в точке, где эти три части усиливают друг друга: более удобный софт повышает спрос на железо, массовость железа стимулирует партнёров и разработчиков, а экосистема закрепляет выбор.

В этом материале мы разложим историю и текущую позицию NVIDIA по полочкам — без лишнего технического «шума», но с пониманием причин:

Итоговая цель — понять, как решения одного руководителя и одной компании сформировали инфраструктурный слой ИИ, и какие уроки из этого могут извлечь команды в технологиях и бизнесе.

Дженсен Хуанг — инженер по образованию и предприниматель по темпераменту. До NVIDIA он успел поработать в индустрии полупроводников и компьютерных систем, где быстро стало ясно: «железо» побеждает не само по себе, а когда точно попадает в волну задач и умеет масштабироваться.

В 1993 году Хуанг вместе с Крисом Малаховски и Кёртисом Приэмом основал NVIDIA. Изначальная ставка была прагматичной: сделать вычисления для графики быстрее и дешевле, чем это могли позволить универсальные процессоры. Эта ниша казалась узкой, но именно она требовала предельно эффективного параллелизма — навыка, который позднее станет решающим для ИИ.

В 90‑е и начале 2000‑х компания делала продукты для игр и профессиональной визуализации. Хуанг последовательно продавливал идею, что графические ускорители — это не «дополнение к ПК», а отдельный вычислительный класс.

Важно, что это было не только про чипы. Решения принимались с оглядкой на то, как разработчики будут писать софт и как производители железа смогут встроить продукты NVIDIA в свои системы.

Хуанг известен готовностью ставить на направления, которые окупаются годами: улучшать архитектуру поколение за поколением, переживать спады спроса и продолжать инвестировать в платформу. Такой подход требует дисциплины: выбирать несколько приоритетов и доводить их до зрелости, даже когда рынок «переключается».

Внутри NVIDIA культивируется инженерное мышление: мерить успех не обещаниями, а производительностью, стабильностью и повторяемыми результатами. Для Хуанга продукт — это связка «чип + софт + поддержка разработчиков», и именно так формировалась культура компании: долгий цикл разработки, высокий барьер качества и постоянная обратная связь от тех, кто реально строит решения на базе технологий NVIDIA.

ИИ‑модели — особенно нейросети — по сути делают одно и то же миллиарды раз: умножают матрицы, складывают массивы чисел и применяют простые функции. Это «много одинаковых операций над большим количеством данных», и именно здесь GPU оказались в своей стихии.

Обучение — это подбор весов модели на огромных датасетах. На каждом шаге нужно прогнать данные через сеть, посчитать ошибки и обновить параметры. Это повторяется тысячи раз и включает колоссальные объёмы линейной алгебры.

Инференс — применение уже обученной модели (например, когда чат‑бот отвечает пользователю). Здесь тоже много матричных операций, но ключевыми становятся задержка и стоимость: чем быстрее и дешевле один ответ, тем выгоднее сервис.

Оба режима выигрывают от параллелизма: когда тысячи небольших вычислений выполняются одновременно.

CPU можно представить как несколько «очень умных» универсальных рабочих, которые отлично справляются с разными задачами, ветвлениями и управлением программой.

GPU — это «армия» более простых вычислительных блоков. Каждый из них не так универсален, зато вместе они умеют одновременно выполнять один и тот же тип операций над разными данными. Для матриц и тензоров (многомерных массивов) это критично.

Проще говоря: CPU хорош, когда задач много разных; GPU хорош, когда задача одна, но её нужно выполнить сразу в огромном масштабе.

Ускоритель — специализированное устройство, которое берёт на себя тяжёлую часть вычислений и делает её быстрее и энергоэффективнее, чем CPU. В дата‑центрах ускорители нужны, чтобы:

Параллельные вычисления — выполнение множества операций одновременно.

Матрица/тензор — таблица чисел (или «таблица в нескольких измерениях»), основной формат данных в нейросетях.

Обучение — процесс, когда модель «учится» на примерах.

Инференс — когда модель применяют на практике, чтобы получить результат.

CUDA часто описывают как «язык для GPU», но по сути это единая модель программирования, которая сделала графические ускорители удобным вычислительным ресурсом для обычных разработчиков. До CUDA GPU оставались мощными, но специфичными: требовали нестандартных подходов, а переносимость кода была болью. NVIDIA предложила понятный путь: писать вычислительные ядра (kernels) и управлять памятью на GPU, используя привычные инструменты и языки (C/C++, позже — Python через обёртки).

Главное — предсказуемость и повторяемость результата. Команда могла один раз вложиться в оптимизацию под CUDA и получить ускорение на широком спектре задач: от линейной алгебры и обработки изображений до обучения нейросетей.

Важно, что CUDA — это не только API. Это компилятор, библиотеки, профилировщики, документация и практики оптимизации. В сумме это снижает порог входа: чтобы использовать GPU, не нужно «изобретать» собственный стек.

Когда появилась CUDA, вокруг неё начали расти готовые «кирпичики»: cuDNN для нейросетей, cuBLAS для матричных операций, NCCL для обмена данными между GPU, а также интеграции с популярными фреймворками. Чем больше таких библиотек, тем выгоднее оставаться в экосистеме: вы получаете скорость «из коробки», меньше рискуете сроками и проще находите специалистов.

Этот эффект сам себя усиливает. Больше пользователей → больше обратной связи и коммерческого спроса → больше оптимизации и новых библиотек → ещё больше пользователей.

Редко кто выбирает ускорители только по пиковым TFLOPS. В реальных проектах решают детали: стабильные драйверы, понятные обновления, совместимость с предыдущими версиями, профилировщики, отладка, контейнеры. CUDA дала ощущение «платформы», где код живёт дольше, чем одно поколение чипов.

Для бизнеса это критично: модели и пайплайны могут разрабатываться месяцами, и риск «сломать всё апдейтом» дороже, чем выигрыш в процентах производительности.

Железо можно купить, но время команды — ограниченный ресурс. Если платформа экономит недели на настройке, даёт готовые оптимизации и предсказуемо масштабируется, решение о закупке становится очевидным.

В этом смысле CUDA — фундамент преимущества NVIDIA: она превратила GPU из компонента в инфраструктуру, на которой удобно строить продукты и исследования.

Путь NVIDIA к роли «двигателя ИИ» начался не с нейросетей, а с игр и 3D‑графики. Ранние поколения видеокарт решали задачу реалистичной картинки — и именно эта гонка за FPS неожиданно создала фундамент для параллельных вычислений: тысячи однотипных операций над пикселями и вершинами очень похожи на операции над матрицами.

Когда стало понятно, что GPU можно использовать не только для рендеринга, начался постепенный сдвиг продуктовой логики: «графический процессор» превратился в «массово‑параллельный вычислитель». Сначала это выглядело как побочный сценарий для энтузиастов и научных задач, но со временем NVIDIA стала явно проектировать железо так, чтобы оно было удобно для расчётов — и на стороне «железа», и в связке с программной средой.

Для ИИ важны другие узкие места, чем для игр. На первый план вышли:

Эта смена приоритетов объясняет, почему в линейках ускорителей так много внимания к памяти, интерконнектам и оптимизации под типичные операции машинного обучения.

С ростом больших языковых моделей и генеративных систем «просто быстрый GPU» перестал быть достаточным. Появились специализированные блоки и режимы работы, ориентированные на матричные операции и более низкую точность вычислений там, где это допустимо — чтобы получать кратный прирост скорости обучения и инференса без пропорционального роста затрат.

В быстро меняющемся ИИ‑рынке выигрывает не только тот, у кого самый изящный чип, но и тот, кто стабильно поставляет поколение за поколением и успевает под волну спроса. Иногда ранний, «достаточно хороший» продукт, поддержанный экосистемой и доступностью, приносит больше эффекта, чем поздний идеал — потому что команды и компании строят решения вокруг того, что можно купить и запустить сегодня.

Когда NVIDIA сделала приоритетом дата‑центры, она перестала конкурировать только «железом» и начала продавать способ строить вычислительные фабрики для ИИ. Для крупных компаний важно не наличие отдельного ускорителя, а предсказуемый результат: сколько моделей можно обучить, за какое время и по какой цене владения.

Платформа в понимании NVIDIA — это связка из вычислительных ускорителей, высокоскоростных соединений между ними и программного слоя, который превращает всё это в управляемую систему.

Условно:

Без этой связки масштабирование ИИ упирается не в количество GPU, а в задержки и потери эффективности.

Обучение больших моделей — это постоянный обмен градиентами и параметрами между устройствами. Если соединения медленные, часть ускорителей простаивает, а стоимость часа вычислений растёт.

Поэтому критичны NVLink/NVSwitch внутри узла и быстрые сетевые технологии между узлами (часто на базе InfiniBand или высокопроизводительного Ethernet). Важен не только «пик TFLOPS», а то, насколько близко кластер может держаться к этой мощности в реальной задаче.

Часто начинают с 1–8 GPU в одном сервере для пилотных проектов. Дальше переходят к узлам, где несколько ускорителей объединены быстрым внутренним коммутатором, и затем — к стойкам и кластерам, где решают вопросы сети, хранения данных, охлаждения и мониторинга.

Корпорации и облака покупают платформу, потому что им нужны:

В итоге ставка на дата‑центры превращает NVIDIA из поставщика ускорителей в поставщика «конвейера» для ИИ — от отдельного узла до вычислительных кластеров промышленного масштаба.

Успех NVIDIA в ИИ держится не только на железе. Решающим фактором стала экосистема, которая делает GPU «понятными» разработчикам: готовые библиотеки, интеграции с фреймворками и инструменты профилирования позволяют быстрее перейти от идеи к работающей модели.

В практических задачах редко начинают с нуля. Команда берёт знакомый стек и собирает решение из компонентов. Поэтому набор оптимизированных библиотек важен почти так же, как и сами чипы: они дают высокую производительность без ручной настройки низкоуровневых деталей.

Для обучения и инференса ценны готовые реализации типовых операций (умножение матриц, свёртки, attention, квантование, смешанная точность). Когда эти «кирпичики» уже оптимизированы под GPU, инженеры фокусируются на данных, качестве и продуктовой логике.

Рынок ИИ живёт в фреймворках — прежде всего PyTorch и TensorFlow, а также в экосистемах вокруг них. Если GPU и драйверы «из коробки» работают нестабильно, медленно или требуют необычных обходных путей, компании выбирают альтернативы, даже если железо теоретически мощное.

Плотная интеграция с фреймворками означает простую установку, предсказуемое поведение на разных версиях, совместимость с распространёнными моделями и быстрые обновления под новые архитектуры. Для бизнеса это снижает риск: меньше сюрпризов при переносе экспериментов в продакшн и проще планировать сроки.

Большая часть затрат — не в цене GPU, а в людях и времени. Когда инструменты стандартные, новичка легче онбордить, документация и примеры уже есть, а на рынке труда больше специалистов с нужными навыками.

Плюс важны утилиты для разработки: профилировщики, отладка производительности, мониторинг памяти, инструменты для распределённого обучения. Они уменьшают количество «чёрной магии» и превращают ускорение в управляемый процесс, где можно измерять, оптимизировать и повторять.

Интересно, что логика «платформа важнее отдельного компонента» сегодня работает не только в железе. Например, TakProsto.AI — это vibe‑coding платформа для российского рынка, где приложения (веб, серверные и мобильные) собираются из диалога в чате: вы формулируете задачу, а система с LLM и архитектурой агентов помогает спланировать и реализовать продукт быстрее, чем в классическом программировании или в типичных no‑code.

Смысл здесь тот же, что и у связки GPU + CUDA: снизить стоимость изменений и ускорить переход от идеи к работающему сервису. А дальше уже включаются «инфраструктурные» атрибуты платформы: экспорт исходников, деплой и хостинг, снапшоты и откат, кастомные домены, режим планирования.

Компьютерное зрение. Обучение детектора/сегментации на большом датасете. Оптимизированные операции свёрток и аугментации, готовые пайплайны и поддержка смешанной точности позволяют быстрее получить приемлемое качество и уложиться в бюджет обучения.

Генеративные модели. Здесь критичны эффективность attention, работа с длинным контекстом, распределённое обучение и быстрый инференс. Когда типовые компоненты уже оптимизированы, команды чаще могут позволить себе итерации — пробовать архитектуры и гиперпараметры, а не «стоять» в очереди на GPU.

Рекомендательные системы. В продакшне важны латентность и стоимость запроса. Инструменты оптимизации инференса (включая компиляцию графов, квантование и эффективную работу с эмбеддингами) помогают обслуживать больше пользователей на той же инфраструктуре.

В итоге экосистема — это не «дополнение» к GPU, а механизм, который превращает вычислительную мощность в массовый продукт: быстрее прототипировать, дешевле обучать команду и безопаснее запускать модели в реальном сервисе.

NVIDIA стала «опорой» ИИ не только за счёт чипов и CUDA, но и благодаря тому, как технологии доходят до пользователей. В ИИ важна скорость внедрения: кто быстрее оказывается в привычных для рынка каналах — тот и задаёт стандарты.

Партнёрства с крупными облаками превращают новые GPU и платформы в услугу «в один клик». Для бизнеса это снимает барьеры: не нужно ждать поставок, собирать стойки и рисковать CAPEX — можно протестировать идею на небольшом бюджете и масштабировать по мере роста.

Для NVIDIA это означает быстрый цикл обратной связи: облака видят реальные нагрузки, делятся требованиями к производительности, сети, памяти и наблюдаемости. В результате новые поколения железа и софта лучше попадают в практические сценарии — от обучения моделей до инференса.

Большая часть корпоративных закупок всё ещё идёт через производителей серверов, системных интеграторов и дистрибьюторов. Они отвечают за то, чтобы ускорители «доехали» до клиента в виде готовых конфигураций: совместимые CPU, питание, охлаждение, сеть, поддержка и гарантия.

Именно через эти каналы формируются типовые архитектуры в дата‑центрах. Если решение заранее сертифицировано и повторяемо, его проще закладывать в проекты, тендеры и SLA.

Университеты, лаборатории и стартапы проверяют новые подходы раньше корпораций: нестандартные модели, новые методы обучения, оптимизации инференса. Их успехи быстро превращаются в кейсы, библиотеки и практики, которые затем подхватывают большие компании.

Когда технология становится стандартом де‑факто, её выбирают «по умолчанию» в закупках и архитектурах: проще найти специалистов, больше готовых решений, ниже риск несовместимости. Это не формальная монополия, а эффект привычки и предсказуемости — ключевой фактор в инфраструктурных решениях.

Когда обсуждают NVIDIA, чаще говорят о производительности и новых GPU. Но для клиентов не менее важен простой вопрос: «Когда и в каком объёме это можно получить?» В эпоху ИИ поставки — это не логистика «со склада», а результат многолетнего планирования и жёстких компромиссов.

Рынок ускорителей растёт рывками: крупные облака и компании могут одномоментно запустить закупки на миллиарды, а затем взять паузу, пока строятся новые дата‑центры и подключается энергия. Такие волны означают, что производственные мощности нельзя включить «по кнопке» — их нужно резервировать заранее, иначе в момент пика появляется дефицит, а в момент спада — риск перепроизводства.

Для заказчиков важна предсказуемость: если они строят платформу под конкретную архитектуру, им нужен понятный горизонт на несколько лет. Долгий цикл разработки помогает согласовать дорожные карты железа, драйверов и системных решений, чтобы инвестиции в стойки, сеть и софт не устарели через квартал.

Ускорители ИИ зависят не только от самих кристаллов. Узкие места часто возникают на стороне памяти, подложек и «упаковки» (как именно чипы и память собираются в один модуль). Эти компоненты ограничены по мощностям, и конкуренция за них идёт не меньше, чем за производственные линии.

Когда спрос превышает предложение, компании вынуждены выбирать: расширять линейку продуктов или упрощать портфель ради объёмов. NVIDIA обычно балансирует так, чтобы сохранить ключевые платформы для дата‑центров и одновременно не «перегреть» рынок: лучше поставить меньше моделей, но гарантировать сроки, чем обещать всё и всем — и сорвать проекты клиентов.

NVIDIA выглядит фаворитом ИИ‑вычислений, но это лидерство держится не только на «самых быстрых чипах». Рынок активно ищет варианты дешевле, энергоэффективнее или проще в интеграции — и иногда находит.

AMD с линейкой Instinct делает ставку на высокую производительность и более открытую экосистему (ROCm), что привлекает часть крупных заказчиков.

Intel развивает ускорители и программный стек oneAPI, пытаясь сыграть на привычности корпоративным ИТ‑командам.

Облачные провайдеры (например, Google с TPU, AWS с Trainium/Inferentia) продвигают собственные ASIC: они оптимизированы под типовые нагрузки в их облаке и нередко дают лучшую цену за обучение/инференс.

Стартапы и специализированные чипы (Cerebras, Graphcore и др.) ищут выигрыш в архитектуре — под конкретные модели и сценарии.

На практике стоимость владения — это не только цена ускорителя. Важны готовые библиотеки, драйверы, поддержка фреймворков, профилирование, стабильные релизы и то, насколько быстро команда может перенести модель в продакшен. Если перенос и отладка съедают месяцы, «экономия на железе» легко превращается в дополнительные зарплаты и упущенную выручку.

Для рынка опасна концентрация: очереди на поставки, условия лицензирования, ценовая политика и приоритеты вендора начинают напрямую влиять на темпы внедрения ИИ. Поэтому многие компании держат «план Б»: мультиоблако, смешанный парк ускорителей, абстракции в софте.

Чем сильнее альтернативы, тем больше давления на стоимость, тем быстрее появляются новые форм‑факторы (модули, стойки, сетевые решения) и тем активнее развиваются переносимые подходы — от оптимизаций под разные ускорители до стандартов на уровне компиляторов и рантаймов.

Даже при сильном спросе на ускорение ИИ рост NVIDIA не «автоматический». Ограничения упираются не только в конкурентов, но и в физику, экономику и правила игры на рынке.

Современные GPU для ИИ потребляют много энергии. Чем выше плотность вычислений в стойке, тем сложнее обеспечить питание, охлаждение и стабильную работу без простоев.

Отдельная тема — память и обмен данными. Большие модели требуют много VRAM и высокой пропускной способности, а узкие места возникают в:

Если инфраструктура клиента не готова, дорогой ускоритель может простаивать, а эффект от внедрения окажется ниже ожиданий.

Полупроводниковый рынок цикличен: периоды ажиотажа сменяются коррекцией бюджетов. Для NVIDIA это означает риск более резких колебаний выручки — особенно если крупные облака и корпорации одновременно замедлят закупки.

Регулирование и геополитика влияют на поставки и доступ к рынкам: экспортные ограничения, требования по безопасности, правила по использованию ИИ. Это может менять конфигурации продуктов, сроки поставок и структуру спроса.

Покупка GPU — только часть расходов. Существенную долю составляют электроэнергия, охлаждение, сеть, лицензии, поддержка и обновления. Добавьте дефицит инженеров по ML‑инфраструктуре и эксплуатации кластеров — и стоимость владения (TCO) растёт.

Компании обычно действуют прагматично: оптимизируют энергопотребление и загрузку кластеров, переходят на более эффективные архитектуры и жидкостное охлаждение, стандартизируют стеки софта, обучают команды и часть задач отдают в облака. Со стороны поставщиков — развитие инструментов мониторинга, готовых платформ и более «предсказуемых» вариантов поставки и поддержки.

ИИ‑инфраструктура движется в сторону большего масштаба и большей эффективности одновременно. Это означает не только «больше GPU», но и более плотную интеграцию вычислений, сети и памяти: ускорители, высокоскоростные интерконнекты, оптимизированные стойки, готовые референс‑архитектуры для дата‑центров. Для NVIDIA следующая волна — продавать не отдельные чипы, а предсказуемую производительность «из коробки» на уровне узла, кластера и целой платформы.

Один из главных уроков рынка — выигрывает тот, кто снижает стоимость изменений. Стандарты, обратная совместимость и понятный жизненный цикл важны не меньше, чем пиковые TFLOPS.

Если платформа позволяет переносить модели и пайплайны между поколениями железа без переписывания кода, бизнес получает редкую роскошь: планировать обновления, а не тушить пожары. Именно поэтому софт и экосистема (драйверы, библиотеки, инструменты профилирования, контейнеры) становятся стратегическим активом наравне с кремнием.

Перед инвестициями в AI‑инфраструктуру полезно «приземлить» выбор на практические вопросы:

Если смотреть шире, похожие вопросы полезны и при выборе инструментов разработки продуктов на базе ИИ. Когда команда строит сервис, ей важно не только «какая модель лучше», но и насколько быстро можно пройти цикл «идея → прототип → запуск → итерации». В этом контексте TakProsto.AI может быть практичным вариантом для команд в России: платформа работает на российских серверах, использует локализованные (в том числе open‑source) LLM и не отправляет данные за пределы страны — что часто критично для корпоративных требований и комплаенса.

Определяющими решениями Дженсена Хуанга и NVIDIA стали ставка на GPU как универсальный ускоритель, превращение CUDA и библиотек в стандарт де‑факто для разработчиков и переход от «железа» к платформам для дата‑центров. Для рынка главный вывод прост: побеждает не тот, у кого самый быстрый чип, а тот, кто предлагает самый короткий и надёжный путь к результату — от кода до масштабируемого сервиса.

Дженсен Хуанг — сооснователь и CEO NVIDIA, который последовательно двигал компанию от «видеокарт для графики» к вычислительной платформе для дата‑центров.

Практический вывод: его влияние — не в отдельном чипе, а в долгих ставках на связку железо + софт + экосистема, которая снижает риски внедрения ИИ для бизнеса.

Потому что обучение и инференс нейросетей сводятся к огромному числу однотипных операций (в первую очередь матричных), которые хорошо распараллеливаются.

Если задача — «много одинаковых вычислений над большими массивами данных», GPU почти всегда выигрывает по скорости и цене за результат. Если же много ветвлений, логики и разнородных операций — CPU остаётся важным.

CUDA — это модель программирования и набор инструментов, которые делают GPU доступными для обычной разработки: компилятор, библиотеки, профилировщики, драйверы, практики оптимизации.

Критично то, что CUDA создаёт повторяемость: вы инвестируете время в код и оптимизацию — и этот код живёт дольше одного поколения железа.

Потому что скорость «в реальном проекте» часто определяется не пиковыми TFLOPS, а тем, насколько легко получить производительность:

Если платформа экономит недели на настройке и снижает риск срывов сроков, она выигрывает даже при схожем «железе».

Обычно под «платформой» подразумевают связку:

Проверка на практике: спросите у поставщика какую эффективность масштабирования вы получите на ваших моделях (а не «сколько GPU в стойке»).

При обучении больших моделей ускорители постоянно обмениваются градиентами и параметрами. Если сеть/интерконнект медленные, часть GPU простаивает.

Мини‑чеклист:

Стартуйте с минимально жизнеспособной конфигурации и измерений:

Так вы уменьшите риск купить «мощное железо», которое простаивает из‑за инфраструктуры.

Смотрите на полную стоимость владения (TCO), а не только на цену ускорителей:

Практика: заранее посчитайте стоимость и при целевой нагрузке — это самый честный KPI.

Есть несколько типовых альтернатив:

Ключевые риски упираются в физику и рынок:

Практическая защита: держать «план Б» (мультиоблако/смешанный парк), стандартизировать окружения (контейнеры), и регулярно проверять переносимость пайплайнов.

Выбор обычно упирается в баланс стоимость железа vs стоимость миграции и поддержки софта.