20 апр. 2025 г.·8 мин

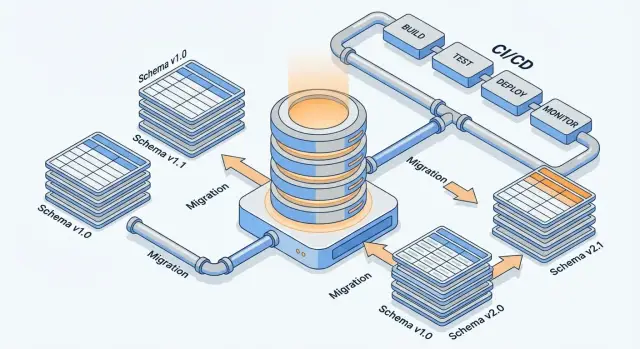

Эволюция схемы и миграции в системах, созданных ИИ

Как планировать изменения схемы, миграции и совместимость данных в системах, где ИИ генерирует код: практики, риски, тесты и чек‑листы.

Что значит «эволюция схемы» в AI-built системах

Эволюция схемы — это управляемое изменение структуры данных: таблиц, полей, типов, связей и правил валидации. Она происходит не «разово», а постоянно: продукт растёт, требования уточняются, а данные начинают использоваться по‑новому. Важно воспринимать схему как живой контракт между приложением и данными, а не как статичную диаграмму.

Почему изменения схемы неизбежны

Схема чаще всего меняется по трём причинам.

Во‑первых, появляются новые функции: нужно хранить дополнительные атрибуты, поддержать новые сущности или связи (например, несколько адресов вместо одного).

Во‑вторых, возникает потребность в производительности: индексы, денормализация, разделение больших таблиц, перенос части данных в отдельные структуры.

В‑третьих, растут требования к качеству данных: ограничения NOT NULL, уникальность, справочники, очищенные форматы дат и валют. Такие изменения помогают убрать «мусор» и снизить количество ошибок в бизнес‑логике.

Почему в AI-built системах риск выше

В системах, где значительная часть логики сгенерирована ИИ или быстро собрана с его помощью, миграции ломаются чаще по вполне практичным причинам:

- неоднородность кода (разные стили, разные библиотеки, разные подходы к ORM и SQL в соседних модулях);

- очень быстрые итерации: схема меняется чаще, чем успевают обновляться контракты и тесты;

- скрытые зависимости: поле может использоваться не только в БД, но и в очередях, кэше, аналитике, интеграциях — и ИИ нередко «не видит» весь путь данных.

Отсюда цель этой статьи: сделать миграции предсказуемыми, сохранить совместимость (API и внутренних интерфейсов) и снизить вероятность простоя — даже когда изменения происходят быстро.

Короткий словарь

Схема — описание структуры данных и ограничений.

Миграция — шаг(и), которые меняют схему и/или данные, чтобы привести систему к новой версии.

Backfill — заполнение новых полей историческими данными или пересчёт значений в существующих записях.

Контракт — договорённость о формате данных между частями системы (приложение↔БД, сервис↔сервис, продюсер↔консюмер).

Версия — фиксированное состояние схемы/контрактов, с которым можно согласованно выпускать изменения и откатываться при необходимости.

Типы изменений схемы и их риск-профиль

Изменения схемы отличаются не только «сложностью», но и тем, насколько вероятно, что они сломают приложение, отчёты или интеграции. В AI-built системах риск обычно выше: ИИ может сгенерировать миграцию «в вакууме», не учитывая реальные запросы и требования по обратной совместимости.

1) Добавление полей и таблиц — обычно безопасно

Добавить новую таблицу или nullable‑колонку в существующую — один из самых «мягких» видов изменений: старый код продолжит читать прежние поля.

Ограничения всё же есть. Если новое поле сразу объявить NOT NULL без значения по умолчанию, запись начнёт падать. Также добавление тяжёлых индексов на большой таблице может занять заметное время и повлиять на производительность.

2) Переименование и удаление — почти всегда ломающие

Переименование колонки/таблицы в БД «ломает» всё, что обращается по старому имени: SQL‑запросы, ORM‑модели, ETL, BI‑дашборды.

Удаление ещё опаснее, потому что откат сложнее: данные могли уже перестать записываться или быть затёртыми. На практике переименование лучше рассматривать как миграцию с «периодом сосуществования» старого и нового.

3) Изменение типов и ограничений — зона частых ошибок

Типы и ограничения выглядят невинно, но именно здесь чаще всего возникают инциденты:

NULL → NOT NULL: внезапно находятся строки с пустыми значениями, и запись/обновление начинают падать.- Добавление уникальности: «исторические» дубликаты ломают миграцию или новые вставки.

- Смена типа (например,

int → bigint,text → json): часть кода может продолжить слать данные в старом формате.

4) Индексы и ключи — влияние на запросы и блокировки

Новый индекс может ускорить чтение, но замедлить запись. Перестройка индексов и изменение внешних ключей иногда вызывают блокировки и очереди транзакций. Это особенно критично для таблиц с высокой нагрузкой.

5) Разделение/слияние таблиц — высокий риск

Нормализация (разделение) или денормализация (слияние) меняют модель данных и запросы одновременно. Ошибки проявляются не сразу: часть функций начинает читать «не ту» версию, появляются рассинхронизации, усложняется поддержка отчётности.

Главное правило риск‑профиля: чем больше изменение требует одновременно переписать чтение и запись, тем выше шанс простоя и скрытых багов.

Контракты и совместимость: база для безопасных изменений

Эволюция схемы безопасна, когда у вас есть понятный контракт: что именно гарантируют друг другу база данных, сервисы, клиенты (UI, интеграции, внешние потребители) и событийная шина. Без этого любое «маленькое» изменение превращается в угадайку — особенно в системах, где часть кода сгенерирована ИИ.

Что должно оставаться стабильным

Контракт фиксирует не таблицы как таковые, а поведение:

- какие поля/атрибуты обязательны, какие опциональны;

- какие значения допустимы (диапазоны, форматы, перечисления);

- как трактуются

null, пустые строки и отсутствующие поля; - какие дефолты применяются, если поле не передано;

- какие изменения считаются совместимыми (добавили поле) и несовместимыми (переименовали/изменили смысл).

Обратная и прямая совместимость: на чтение и на запись

Обратная совместимость: новый код должен уметь читать «старые» данные.

Пример: вы меняете price из строки "10.00" на число 10.0. Новый сервис при чтении поддерживает оба формата (строка и число) и нормализует в один.

Прямая совместимость: старый код должен уметь работать с «новыми» данными.

Пример: вы добавили новое поле currency. Старые клиенты его не отправляют — сервер подставляет дефолт (например, RUB) и продолжает принимать запросы.

Подход «не ломай чтение»

Практичный принцип: сначала делайте изменения так, чтобы читатели не падали. Временная поддержка старых полей/форматов почти всегда дешевле, чем аварийные фиксы.

Типовой приём — держать старое поле рядом с новым, например phone и phone_e164, а в коде чтения предпочитать новое, но уметь подхватить старое.

Контракт на уровне API и событий

Для API и событий удобнее придерживаться правил:

- новые поля — только как расширения (опциональные);

- дефолты — на стороне потребителя или сервиса-источника, но явно описаны;

- версии — либо в пути/заголовках API, либо в схеме события (например,

event_version); - запрет на «скрытые переименования»: это фактически удаление + добавление.

Подробнее про практику версий/совместимости можно вынести в отдельный гайд и ссылаться на него из PR‑шаблона, например: /blog/schema-compatibility-rules.

Как документировать контракт, чтобы ИИ не «додумывал»

ИИ часто заполняет пробелы «разумными» предположениями. Уберите пробелы:

- храните контракт рядом с кодом: OpenAPI/AsyncAPI/JSON Schema и миграционные заметки;

- добавьте примеры: 2–3 валидных и 2–3 невалидных payload;

- явно прописывайте семантику: «если поле отсутствует — считать X», «null запрещён»;

- закрепите правила совместимости в чек‑листе ревью (что нельзя менять без major‑версии).

Так контракт становится не только документом для людей, но и точной инструкцией для генераторов кода и автотестов.

Стратегия Expand-Contract (двухфазные миграции)

Expand-Contract — практичный способ менять схему без простоя и «ломающих» релизов. Суть: сначала расширяем схему так, чтобы старый и новый код могли работать параллельно, затем переключаем приложение и данные, и только после стабилизации сжимаем схему, удаляя устаревшее.

Фаза Expand: расширяем, не ломая

На этом шаге вы добавляете новые поля/таблицы/индексы, но не удаляете старые. Важно, чтобы текущая версия приложения продолжала нормально читать и писать.

Иногда нужен переходный режим dual-write: приложение пишет и в старое, и в новое поле (или в две таблицы), чтобы новые данные сразу появлялись в правильном месте.

Фаза Migrate: перенос и проверка

Далее выполняется backfill: вы заполняете новые структуры историческими данными, синхронизируете расхождения и проверяете полноту.

Хорошая практика — заранее определить критерии готовности: процент заполнения, количество несовпадений, контрольные суммы по выборкам, метрики ошибок чтения/записи. Здесь же важно учитывать «плавающие» данные: пока идёт backfill, система продолжает принимать новые записи — поэтому процесс миграции должен быть идемпотентным и повторяемым.

Фаза Contract: убираем старое с дедлайном

Когда новый код стабильно работает и данные проверены, назначьте дедлайн и удалите старые поля/таблицы/ветки логики. До этого момента поддержка старого формата — осознанный долг, а не вечная обязанность.

Как выбрать длительность «переходного окна»

Переходное окно зависит от частоты релизов, времени backfill, требований к откату и времени жизни старых клиентов (например, мобильных приложений). Практическое правило: держите окно достаточно длинным для безопасного отката, но достаточно коротким, чтобы не разрастались условные ветки в коде и не забывалось удаление старого.

Версионирование схемы и дисциплина релизов

Версионирование — это не «красивые номера», а способ связать изменения данных с релизами так, чтобы команда понимала: что именно изменилось, когда, почему и какие старые клиенты ещё должны жить.

Что именно версионировать

Важно версионировать не только схему БД. В AI-built системах часто меняются сразу несколько «контуров» данных:

- Схема БД (таблицы, индексы, ограничения).

- Набор миграций (SQL/DDL‑скрипты и их порядок).

- Модели приложения (ORM‑модели, DTO, валидация).

- Схемы сообщений (очереди, event payload, Avro/JSON schema).

- Контракты API (OpenAPI, gRPC proto) — даже если БД не менялась.

Практический подход: версия продукта/сервиса живёт в релизах, а версия схемы/контракта — в артефактах, которые можно проверить и воспроизвести.

Семантика версий: major/minor и связь с релизами

Используйте простую семантику:

- Major — вы ломаете обратную совместимость (удаляете поле, меняете смысл, вводите обязательность, которую старые клиенты не переживут).

- Minor — добавляете совместимые расширения (новые nullable‑поля, новые необязательные атрибуты в сообщениях, новые эндпоинты).

- Patch — исправления миграций/метаданных без изменения внешнего контракта (например, индекс, правка default).

Дисциплина релизов: если меняется контракт, номер версии меняется в том же PR/мерже, что и миграции/обновление схем.

Маппинг версий к миграциям

Правило: одна версия — определённый набор миграций. Для этого миграции должны быть:

- упорядочены (монотонные идентификаторы, timestamp или sequence);

- с явными зависимостями (не полагайтесь на «вроде раньше создаётся таблица»);

- по возможности идемпотентны (проверки существования, безопасные

ALTER), чтобы повторный прогон не ломал окружение.

«История схемы»: таблицы миграций и метаданные

Храните факт применения миграций в БД (как минимум schema_migrations), а рядом — метаданные: версия сервиса, хеш миграции, время применения, исполнитель/пайплайн. Это упрощает расследования: «почему на стенде A поле есть, а на B нет».

Политика депрекейта

Договоритесь о сроках: например, 2 минорных релиза поле помечено как устаревшее, затем удаляется в следующем major.

Коммуникация должна быть формальной: заметка в release notes, тикет на удаление, и предупреждения в логах/метриках при использовании устаревших полей или эндпоинтов. Это снижает риск, что ИИ «оптимизирует» код и преждевременно выкинет поддержку старого формата.

Backfill и преобразование данных без сюрпризов

Проверьте переход без рубильника

Соберите переходный режим с dual-read и фиче-флагами, чтобы смена схемы была мягче.

Когда вы добавляете поле, меняете формат или переносите данные в новую таблицу, главный риск — получить «смешанное» состояние: часть записей уже новая, часть — старая, а приложение не всегда готово к обоим вариантам. Backfill (массовое заполнение/пересчёт) помогает выровнять данные, но его важно спланировать так, чтобы не уронить систему и не получить скрытые ошибки.

Backfill vs lazy-migration

Есть два базовых подхода:

- Backfill сразу: пересчитываете все существующие данные заранее. Подходит, когда новое поле критично для бизнес‑логики, отчётности, поиска, или когда нельзя допускать «пустых» значений.

- Lazy-migration: пересчитываете «по запросу» — например, при чтении/записи конкретной сущности. Полезно, когда данных очень много, нагрузка непредсказуема, или вы хотите растянуть миграцию во времени.

Практичный компромисс: начать с lazy‑варианта (чтобы быстрее включить совместимость), затем сделать фоновый backfill и убрать временную ветку после завершения.

Пакетная обработка без перегрева

Backfill почти всегда должен быть пакетным:

- используйте батчи (например, по 1–10 тыс. записей) и фиксируйте порядок (по id/времени);

- ставьте лимиты на QPS/CPU/IO и внедряйте паузы;

- запускайте в окна низкой активности;

- делайте операции идемпотентными (повтор запуска не ломает результат).

Консистентность: как не получить «частично обновлено»

Главное — определить, что считается корректным состоянием на время миграции. Частые приёмы:

- обновлять запись атомарно (в одной транзакции, когда это возможно);

- использовать маркер вроде

migrated_at/schema_versionи читать данные по правилам: «если маркер есть — новый формат, иначе — старый»; - не смешивать несовместимые изменения в одном проходе.

Отслеживание прогресса

Чтобы backfill не стал «вечным», заведите наблюдаемость:

- метрики: обработано/всего, скорость, ошибки, ретраи;

- маркеры прогресса (последний обработанный id/временной диапазон);

- выборочные контрольные суммы или сравнение агрегатов «до/после».

План завершения

Заранее определите критерии «готово»: 100% записей обновлено, ошибки ниже порога, выборочные проверки прошли. После этого уберите временные артефакты: служебные поля/таблицы, миграционные флаги, лишние ветки кода и джобы.

Полезно зафиксировать итог в инженерной заметке или runbook (например, /blog/runbook-migrations), чтобы следующий backfill проходил быстрее и спокойнее.

Переходные режимы: dual-write, фиче-флаги и постепенный rollout

Когда меняется схема данных, самый опасный момент — переход. Переходные режимы позволяют не «переключать рубильник», а пережить период, когда старая и новая модели существуют одновременно.

Параллельное существование старой и новой схемы

Держать две схемы приходится ровно столько, сколько нужно, чтобы:

- обновить все сервисы/клиенты, которые читают или пишут данные;

- выполнить backfill (если он нужен) и проверить качество;

- убедиться, что новые запросы и индексы не ломают производительность.

Практическое правило: период параллельности должен быть ограничен по времени и зафиксирован в плане релиза (например, «2 недели или до достижения 99,9% запросов через новую схему»). Иначе «временное» станет постоянным.

Dual-write и dual-read: как снизить расхождения

Dual-write — запись в старые и новые поля/таблицы одновременно. Dual-read — чтение из двух источников (или чтение из нового с фолбэком на старый).

Плюсы: можно безопасно откатываться и постепенно переводить трафик. Минусы: риск расхождений и усложнение логики.

Чтобы минимизировать расхождения:

- делайте один источник истины на период миграции (например, пишем в старое, новое заполняем как производное) или наоборот — но не «оба главные»;

- фиксируйте правила приоритета чтения (что считать верным при конфликте);

- добавляйте идемпотентность записей и повторяемость операций.

Фиче-флаги и постепенный rollout

Флаги позволяют включать новую схему «по частям»: сначала для внутренних пользователей, затем канареечный процент, затем постепенное расширение. Важно разделять флаги на чтение и запись: сначала безопаснее включать read-path, и только после проверки — write-path.

Проверки на дрейф данных и транзакционность

Нужны автоматические проверки «дрейфа данных»: сравнение старого и нового представления, метрики расхождений, алерты по порогам.

Не забывайте про транзакционность: dual-write часто расширяет границы транзакций, повышая блокировки. Хорошая практика — держать критическую транзакцию минимальной, а вторичную запись (в «новую» схему) выполнять асинхронно с гарантией доставки и наблюдаемостью, если бизнес-правила это допускают.

Инструменты и автоматизация в CI/CD для миграций

Спланируйте миграцию в чате

Зафиксируйте контракт и шаги Expand-Contract в Planning mode перед генерацией изменений.

Миграции ломаются не потому, что «кто-то невнимательно написал SQL», а потому что процесс допускает опасные действия без страховки. В CI/CD стоит относиться к миграциям как к коду: они должны быть воспроизводимыми, проверяемыми и понятными по истории изменений.

Структура миграционного репозитория

Хорошая база — предсказуемый порядок и именование. Например:

- одна папка на тип хранилища (postgres/, clickhouse/, etc.);

- миграции в строгой последовательности:

2025-12-26_1200_add_orders_status.sql; - рядом — файл описания:

2025-12-26_1200_add_orders_status.md(что меняем и почему, как откатывать).

Правило для ревью: миграция без объяснения intent (и плана отката) не проходит.

CI для миграций: две проверки вместо одной

В пайплайне полезно прогонять миграции в двух режимах:

-

На пустой базе: гарантирует, что новый разработчик/окружение поднимется «с нуля» одним прогоном.

-

На «приближенной к бою» базе: восстановление из обезличенного снапшота или сгенерированного датасета с похожими объёмами и индексами. Здесь проявляются блокировки, долгие операции и ошибки преобразований.

Генерация миграций ИИ: правила по умолчанию

Если миграции пишет ИИ (или он помогает), задайте жёсткие шаблоны:

- запрет опасных операций по умолчанию:

DROP COLUMN, массовыеUPDATEбез батчинга, изменение типа колонки без явного плана backfill; - требование «без простоя»: добавления через

ADD COLUMN NULL, индексы — в неблокирующем режиме, изменения — через двухфазный подход; - обязательный комментарий в миграции: что должно быть совместимо со старым кодом и как долго.

Автопроверки: ловим риски до продакшена

Добавьте автоматические гейты:

- SQL‑линтер и форматтер;

- анализ блокировок/DDL‑рисков (например, детект потенциально блокирующих

ALTER); - поиск операций, которые могут вызвать full table scan или переписывание таблицы;

- проверка наличия

WHEREу обновлений, ограничений по батчам, таймаутов/lock timeout.

Документация рядом с миграциями

Короткий markdown рядом с файлом миграции экономит часы: цель, обратная совместимость, порядок выката, метрики для контроля и шаги отката. Это удобно линковать из PR и внутренних runbook’ов (например, /runbooks/migrations).

Как это выглядит в AI-built разработке на практике (пример TakProsto.AI)

В vibe-coding командах скорость изменений часто выше «классических» процессов, поэтому особенно важно, чтобы платформа помогала удерживать дисциплину миграций.

Например, в TakProsto.AI (платформа для создания веб‑, серверных и мобильных приложений через чат) полезно опираться на несколько встроенных практик:

- Planning mode перед изменениями данных: сначала фиксируете контракт и план Expand‑Contract, и только потом генерируете шаги миграции и изменения в приложении.

- Снапшоты и rollback: перед рискованными DDL‑операциями делаете контрольную точку, а при регрессии быстро возвращаетесь к рабочему состоянию.

- Экспорт исходников: даже если вы ускоряете разработку через чат, артефакты (SQL‑миграции, модели, контракты) остаются проверяемыми в репозитории.

Это особенно хорошо ложится на типовой стек «PostgreSQL + backend», где миграции неизбежны, а цена ошибки высока.

Тестирование и наблюдаемость: как поймать проблемы заранее

Миграции чаще ломаются не из‑за «сложных SQL», а из‑за мелочей: неожиданных NULL, неучтённых индексов, несовместимых сериализаторов и фоновых backfill‑задач, которые внезапно съедают I/O. Поэтому для изменений схемы полезно заранее иметь набор проверок и наблюдаемость, которые запускаются каждый релиз.

Тесты миграций: вперёд/назад и идемпотентность

Минимальный «пакет доверия» к миграции:

- Применение вперёд и откат назад на копии боевых данных (или на репрезентативном сэмпле). Даже если откаты в проде не планируются, тест отката выявляет необратимые шаги.

- Повторное применение: миграция должна быть безопасна при повторном запуске (идемпотентность), иначе при ретраях в CI/CD и при частичных сбоях вы получите «плавающие» состояния.

- Проверка порядка: миграции должны корректно работать при последовательном прогоне с нуля, а не только «поверх текущей базы».

Тесты совместимости: старая версия + новая схема (и наоборот)

Схемные изменения ломают систему чаще всего на стыке версий. Проверьте два сценария:

-

Старый сервис → новая схема (например, старый код читает таблицу, где добавилось поле, индекс или триггер).

-

Новый сервис → старая схема (важно для постепенного rollout и откатов приложения).

Практично делать это как интеграционные тесты в контейнерах: поднимаете две версии сервиса и две версии схемы, прогоняете типовые запросы и сериализацию/десериализацию.

Нагрузочные проверки: индексы и backfill без сюрпризов

Добавление индекса и массовый backfill могут резко увеличить задержки и блокировки. Перед релизом стоит измерить:

- время выполнения ключевых запросов до/после;

- рост CPU/I/O во время backfill;

- влияние размера батча на latency.

Наблюдаемость: что мониторить во время миграции

На период изменений включите «сигналы раннего предупреждения»:

- метрики времени запросов (p95/p99) по критичным endpoint’ам;

- время и количество блокировок/ожиданий;

- ошибки сериализации (например, «поле отсутствует», «не тот тип», «unexpected null»);

- прогресс backfill (скорость, отставание, процент завершения).

Playbook инцидентов: кто и что делает

План реагирования должен быть конкретным:

- кто on‑call и кто принимает решение остановить rollout;

- где смотреть метрики/логи и какие пороги считаются аварийными;

- как поставить миграцию/бэкфилл на паузу и как безопасно продолжить;

- какие шаги отката приложения допустимы.

Хорошая практика — держать playbook рядом с релизным процессом (например, в /docs/runbooks) и раз в квартал прогонять «сухую тренировку» на тестовом окружении.

Откаты и восстановление: план Б должен быть реальным

Когда миграция идёт не по плану, «откат» кажется очевидным решением. Но в реальности откат схемы и откат кода — разные задачи: приложение можно быстро развернуть назад, а база уже могла принять новые данные, изменить формат, пересчитать поля или удалить часть информации.

Rollback схемы vs rollback кода

Откат кода чаще всего безопаснее: вы возвращаете предыдущую версию приложения и продолжаете работать со старым контрактом. Откат схемы сложнее, потому что:

- данные могли быть записаны в новом формате (и старый код их не поймёт);

- миграция могла быть частичной (часть таблиц обновилась, часть — нет);

- некоторые изменения необратимы (drop/rename без сохранения копии, пересчёт агрегатов без исходников).

Reversible миграции: когда это реально

Реверсивные миграции возможны, если вы добавляете новое (колонки, таблицы, индексы) и не ломаете старое. Чем больше «сжатия» (удалений, переименований, изменения типов), тем чаще разумнее выбрать forward-fix: быстро выпустить исправление, которое корректно работает с текущим состоянием данных.

Снапшоты и бэкапы: что проверить заранее

Перед запуском убедитесь, что у вас есть:

- свежий бэкап/снапшот и понятный RPO/RTO;

- проверенная процедура восстановления (не «на бумаге», а тестом на стенде);

- контроль доступа: кто и как запускает restore.

Если восстановление никогда не тестировали, считать его надёжным нельзя.

Мягкое отключение вместо «рубильника»

Заранее заложите возможность вернуться на старое чтение/запись: фиче‑флаг, переключение read-path на прежние поля, временный отказ от dual-write. Это часто быстрее и безопаснее, чем пытаться откатить саму схему.

Критерии остановки (triggers)

Определите триггеры, при которых миграцию нужно прервать: рост ошибок записи/чтения, деградация латентности, увеличение очереди задач backfill, расхождение метрик данных (например, доля NULL, дубликаты, несходимость агрегатов). Решение «стоп» должно быть заранее согласованным, а не эмоциональным.

Специфика AI-built систем: где ИИ ошибается в миграциях

Прототип на вашем стеке

Быстро поднимите приложение на React и Go с PostgreSQL, чтобы обкатать изменения на практике.

Системы, где значимая часть кода и миграций сгенерирована ИИ, чаще страдают не от «плохого SQL», а от мелких несостыковок, которые проявляются только в проде. ИИ легко «угадывает» намерение, но не чувствует реальный контракт данных, историю решений и скрытые ограничения.

Частые ошибки генерации

Типовой набор проблем повторяется из проекта в проект:

- Несогласованные имена: колонка

user_idв базе, ноuseridв коде; разные имена индексов в разных миграциях. - Типы и длины:

varchar(255)вместоtext,intвместоbigint, неправильная точность для денег. - Дефолты и NULL-логика: добавление

NOT NULLбез безопасного дефолта; дефолт «для красоты», который меняет бизнес‑смысл. - Ограничения: преждевременный

UNIQUE, внешний ключ без учёта существующих «грязных» данных, каскадные удаления, которые неожиданно чистят связанные таблицы.

Как давать ИИ правильный контекст

Качество миграции резко растёт, если перед генерацией вы передаёте:

- текущую схему (DDL) и пару реальных примеров строк,

- примеры запросов/эндпоинтов, которые читают и пишут эти поля,

- ограничения по downtime и допустимым блокировкам,

- требование к обратной совместимости на период релиза.

Формулировка «добавь колонку и заполни» без этих данных почти гарантирует риск.

Человеческое ревью: обязательный минимум

В ревью миграций стоит проверять блокировки, порядок операций (сначала безопасные изменения), корректность дефолтов, наличие индексов под критичные запросы и план отката. Полезно также прогонять миграцию на копии данных, близкой к продакшену по объёму.

Политика запретов и трассируемость

Закрепите правило: опасные операции (drop/rename, массовые update/delete, изменение типов на больших таблицах) — только с ручным подтверждением и явным планом восстановления.

Каждая миграция должна быть трассируемой: ссылка на задачу, короткое обоснование «зачем» и договорённость, когда можно удалить временную совместимость. Это дисциплинирует и людей, и ИИ‑генерацию.

Управление изменениями: процессы, чек‑листы и следующий шаг

Даже если большую часть кода и миграций генерирует ИИ, управление изменениями остаётся человеческой ответственностью: кто принимает риск, кто утверждает контракт, кто откатывает. Хороший процесс снижает вероятность «тихих» поломок — когда всё развернулось, но данные стали не теми.

Кто владелец схемы: роли, зоны ответственности, правила согласования

Определите владельца схемы (обычно команда/продукт, отвечающие за доменную модель) и владельца платформы данных (DBA/infra). Первый отвечает за смысл и контракты, второй — за безопасность выполнения и эксплуатационные риски.

Минимальный набор правил согласования:

- Любое изменение схемы сопровождается описанием влияния на данные и клиентов (сервисы, отчёты, интеграции).

- Изменения, затрагивающие контракты (API/события/таблицы, читаемые другими), требуют ревью владельцев потребителей.

- Для AI-built кода обязательно human‑in‑the‑loop: миграции и преобразования данных утверждаются человеком, который понимает доменную логику.

Единый каталог схем и контрактов: где хранить и как обновлять

Сделайте «единственный источник правды»: репозиторий (или папку в монорепо) с версионируемыми артефактами — DDL, миграции, OpenAPI/AsyncAPI, JSON Schema/Avro/Protobuf, и короткие ADR (решения по изменениям).

Практика, которая хорошо работает: каждое изменение схемы — это PR, где рядом лежат миграция, обновлённый контракт и заметка «что меняется/как откатывать». Каталог обновляется тем же коммитом, что и приложение.

Чек‑лист перед миграцией

- Совместимость: кто читает/пишет, есть ли обратная совместимость, нужен ли переходный режим.

- Тесты: миграция на копии данных, проверка запросов/индексов, прогон критичных сценариев.

- Бэкап: подтверждённая точка восстановления и время восстановления (RTO/RPO).

- Окно: есть ли ограничение по нагрузке/блокировкам, выбран ли безопасный момент.

- Мониторинг: метрики ошибок, задержек, рост объёма таблиц, алерты на аномалии.

Чек‑лист после миграции

- Валидации данных: контрольные выборки, инварианты, сверка агрегатов/счётчиков.

- Уборка: удалить временные колонки/индексы, выключить dual-write, почистить флаги.

- Закрытие депрекейта: объявить сроки удаления старого поля/эндпойнта и выполнить их.

Что дальше

Если вы настраиваете процесс с нуля, начните с каталога контрактов и двух чек‑листов — это даёт быстрый эффект без больших переделок.

Дальше полезно пройтись по связанным темам в /blog, а если нужна помощь с планированием миграций без простоя и дисциплиной релизов в быстро меняющихся AI-built проектах — посмотрите /pricing и обратите внимание на TakProsto.AI: чат‑подход к разработке хорошо ускоряет итерации, но наибольшую ценность даёт тогда, когда вы сразу закрепляете контракты, план миграции и возможность безопасного отката.