06 авг. 2025 г.·8 мин

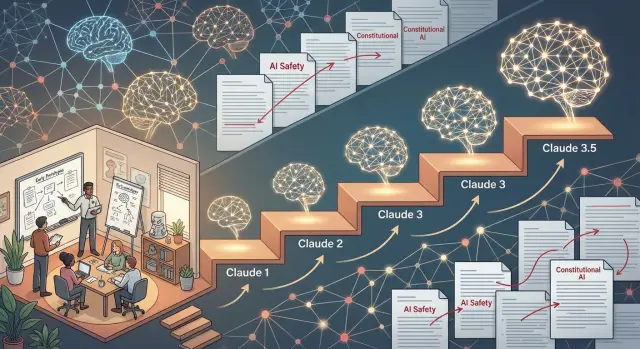

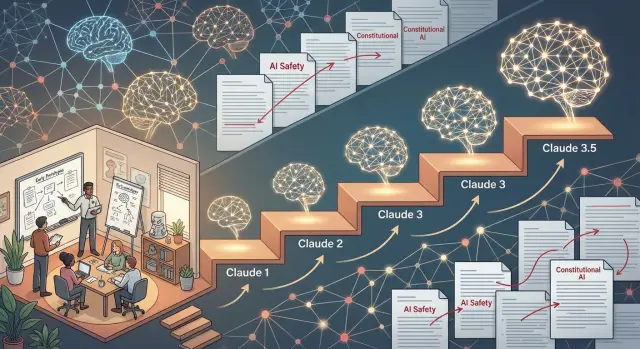

История Anthropic: путь компании и эволюция моделей Claude

Обзор истории компании Anthropic: от основания исследовательской командой до создания линеек моделей Claude 1, 2, 3 и 3.5 Sonnet и их роли на рынке ИИ.

Обзор истории компании Anthropic: от основания исследовательской командой до создания линеек моделей Claude 1, 2, 3 и 3.5 Sonnet и их роли на рынке ИИ.

Anthropic — это компания, которая специализируется на разработке крупномасштабных моделей искусственного интеллекта, прежде всего семейства Claude. Эти модели умеют писать тексты, помогать в программировании, анализировать документы, проводить исследования и поддерживать сложный диалог на естественном языке.

В русскоязычном интернете название компании нередко пишут неправильно — «Antropic», «Antropik» и подобные варианты. Корректное написание — Anthropic. Это не просто придирка к орфографии: за правильным названием стоит особый подход компании к тому, как должен развиваться ИИ.

Anthropic изначально позиционирует себя как исследовательскую компанию, которая делает ставку не только на мощность, но и на безопасность и надёжность моделей. Для них важно не просто научить ИИ генерировать впечатляющие ответы, а сделать так, чтобы система:

Именно этим объясняется внимание Anthropic к методам выравнивания ИИ (alignment), интерпретируемости и новым подходам к обучению моделей. Один из ключевых таких подходов — Constitutional AI, о котором пойдёт речь в отдельном разделе статьи.

Модели Claude сегодня — один из заметных игроков среди систем генеративного ИИ. Понимание того, как и почему они развивались от первых версий до актуальных поколений, полезно по нескольким причинам:

В этой статье мы последовательно проследим путь Anthropic: от основания компании и её миссии до появления отдельных поколений Claude. Разберём, чем Claude 1 отличался от последующих версий, как Claude 2 стал шагом к массовому использованию, чем интересна линейка Claude 3 (Opus, Sonnet, Haiku) и зачем появился Claude 3.5 Sonnet с новым форматом взаимодействия Artifacts.

Разбираясь в истории Anthropic и эволюции Claude, проще понять не только текущие возможности этих моделей, но и то, куда движется индустрия ИИ, если делать упор на безопасность, управляемость и ответственность систем, а не только на «сырую» вычислительную мощность.

К 2020–2021 годам крупные языковые модели перестали быть экспериментом в лабораториях и начали превращаться в основу реальных сервисов. GPT‑3 показала, насколько масштабные модели могут быть полезны для письма текстов, программирования и поддержки пользователей. Одновременно усилились опасения: модели иногда выдавали вредоносный контент, галлюцинировали факты и вели себя непредсказуемо при сложных запросах.

Вокруг вопроса безопасности и управляемости ИИ шли оживлённые дискуссии: как сделать мощные модели, которые можно доверенно внедрять в продукты, не создавая дополнительных рисков для пользователей и общества.

На этом фоне в 2021 году появляется Anthropic — компания, основанная группой исследователей, ранее работавших в других ведущих ИИ‑организациях. Ключевая фигура среди основателей — Дарио Амодеи (Dario Amodei), занявший позицию CEO. До Anthropic он руководил исследованиями в области безопасности и масштабирования моделей в другой крупной ИИ‑компании и хорошо видел как потенциал, так и уязвимости современных систем.

Команда основателей исходила из простой, но амбициозной идеи: мощный генеративный ИИ нельзя развивать только по принципу «больше параметров и данных». Нужен другой акцент — на предсказуемость, интерпретируемость и чёткие рамки поведения моделей. Иначе каждое следующее поколение ИИ будет всё труднее контролировать.

С самого начала Anthropic позиционировала себя не как продуктовый стартап, а как исследовательскую компанию, сосредоточенную на фундаментальных вопросах безопасности ИИ. Первые годы основной упор делался на разработку методов обучения, которые позволили бы:

Миссия Anthropic формулировалась как создание полезных, масштабируемых моделей, которые остаются управляемыми даже при росте их возможностей. Именно из этой установки позже выросли подходы к обучению, ставшие фирменной чертой компании и определившие развитие всей линейки моделей Claude.

Основатели Anthropic пришли из команд, которые видели, как крупные языковые модели становятся всё более сильными, но при этом — непредсказуемыми. Ошибки моделей уже не ограничивались «смешными промахами»: возникали риски вредных советов, дезинформации, предвзятых или токсичных ответов.

Anthropic изначально решила: если модель будет становиться всё мощнее, безопасность и управляемость не могут быть «надстройкой поверх» продукта. Они должны быть встроены в саму методику обучения. Отсюда и идея Constitutional AI — подхода, при котором модель учится следовать формализованным принципам, а не бесконечной ручной модерации.

Классический подход (RLHF) основан на том, что люди оценивают ответы модели и корректируют её поведение. Это полезно, но плохо масштабируется: нужно всё больше разметчиков и всё равно остаются «слепые зоны».

Constitutional AI предлагает другой путь:

Так модель учится не просто избегать запрещённых формулировок, а применять общие правила к новым, ранее не встречавшимся ситуациям.

В «конституцию» могут входить ценности и принципы разного типа:

Часть принципов Anthropic заимствует из существующих деклараций прав человека, биоэтических и исследовательских кодексов, часть формулирует сама.

Constitutional AI стал не одноразовым экспериментом, а основой для всей эволюции линейки Claude. Первая публичная версия уже использовала «конституционный» подход, но в более ограниченном виде. В последующих моделях (Claude 2, серия Claude 3 и затем Claude 3.5) Anthropic:

Это позволило одновременно повышать и общие способности, и устойчивость к вредоносным запросам. Подход подробно описан в научных работах Anthropic — в том числе в их ключевой статье о Constitutional AI, где раскрываются как методические детали, так и результаты экспериментов на реальных задачах безопасности.

Первый Claude стал результатом нескольких лет исследований Anthropic и был представлен внешнему миру в начале 2023 года. К этому моменту внутри компании уже шли длительные закрытые эксперименты с прототипами, обученными по принципам Constitutional AI, а Claude 1 стал первой версией, которую начали показывать более широкой аудитории.

В период запуска Claude 1 рынок обсуждал в основном модели семейства GPT и их многочисленные клоны. На этом фоне Anthropic сделала акцент не на креативности любой ценой, а на предсказуемости и безопасности ответов.

Ключевые особенности Claude 1:

Модель была заметно осторожнее тогдашних популярных чат‑ботов: она чаще отказывалась отвечать на пограничные запросы, фильтровала контент и меньше поддавалась на попытки «обойти» ограничения с помощью хитрых подсказок.

До публичных анонсов Claude 1 проходил испытания в ограниченном круге партнёров Anthropic. Компания давала доступ через приватный API и интеграции: модель тестировали в службах поддержки, образовательных продуктах, внутренних помощниках для сотрудников.

Чуть позже Anthropic открыла бета‑доступ большему числу компаний, сохраняя при этом строгий контроль над сценариями использования. Основная цель была не только показать возможности модели, но и собрать данные о том, как она ведёт себя в реальных продуктах и где именно срабатывают или, наоборот, не срабатывают механизмы безопасности.

Даже первая версия Claude уверенно закрывала базовые задачи:

Во многих из этих сценариев пользователи отмечали спокойный тон, отсутствие агрессии и относительную устойчивость к попыткам «вывести модель из себя» или спровоцировать на токсичный ответ.

На практике вскрылись и ограничения Claude 1. Модель:

Claude 1 стал для Anthropic экспериментом «живого» запуска: компания проверила на практике, можно ли сделать коммерческую языковую модель с приоритетом безопасности, не потеряв при этом полезность для реальных пользователей. Этот опыт напрямую повлиял на появление последующих поколений Claude.

Claude 2 стал следующей крупной вехой в развитии линейки Anthropic: модель из экспериментального исследования превратилась в основу реальных продуктов и сервисов для компаний.

Главное отличие Claude 2 от первой версии — значительное расширение контекста и рост стабильности ответов на сложные задачи.

Anthropic сделала Claude 2 доступным сразу в двух форматах:

Это стало переломным моментом: Claude из исследовательского проекта превратился в платформу, вокруг которой начали строить реальные бизнес‑процессы, интеграции и стартапы.

С появлением Claude 2 компании начали использовать модель в повторяемых, измеримых сценариях:

Массовое использование Claude 2 дало Anthropic огромный объём практической обратной связи. По логам и отзывам стало ясно:

Эти наблюдения легли в основу дорожной карты следующих поколений — отточены механизмы безопасности, улучшено управление стилем и форматом ответов, а линейка моделей стала более сегментированной по задачам и производительности. Именно опыт эксплуатации Claude 2 в реальных продуктах подготовил почву для дальнейшего развития серии Claude 3 и 3.5.

Переход к семейству моделей Claude 3 стал для Anthropic логичным этапом. Клиентам нужны не только «самые умные» модели, но и гибкий выбор по цене, скорости и качеству. Одна универсальная модель неизбежно оказывается либо слишком дорогой для массовых сценариев, либо недостаточно мощной для сложных задач. Семейство Claude 3 решает эту дилемму: каждая версия оптимизирована под свой тип нагрузок, но опирается на общую архитектуру и подход к безопасности.

Opus — флагман линейки Claude 3. Это модель для задач, где критичны качество рассуждения и точность формулировок:

По сравнению с Claude 2, Opus заметно лучше справляется с задачами, требующими длинной цепочки рассуждений, точнее следует инструкциям и устойчивее к запутанным или наводящим формулировкам. Улучшилась способность работать с крупными документами и смешанным контентом (текст, структура, фрагменты кода) в рамках одного диалога.

Sonnet — сбалансированная модель среднего размера. Она рассчитана на ежедневные рабочие сценарии, где важны и качество, и скорость, и цена:

В сравнении с Claude 2, Sonnet лучше понимает длинный контекст, реже «теряет нить» разговора, увереннее пишет и читает код, аккуратнее обращается с многоязычными запросами. Для многих компаний это базовая модель, на которой строятся внутренние ассистенты и рабочие приложения.

Haiku — самая быстрая и компактная модель линейки. Её главные сценарии:

Haiku жертвует частью глубины рассуждений ради минимальной задержки. При этом она всё равно превосходит Claude 2 в базовом понимании текста и устойчивости к неоднозначным инструкциям, что важно для массовых пользовательских сервисов.

Во всех трёх моделях семейства Claude 3 Anthropic заметно усилила ключевые аспекты качества:

Запуск линейки Claude 3 сопровождался ускорением коммерческого развития Anthropic. Модели стали доступны через крупных облачных провайдеров, что упростило подключение для компаний по всему миру. Появились новые интеграции в корпоративные продукты, контакт‑центры, инструменты для разработчиков и аналитиков.

Расширение каналов доступа и географии использования закрепило за Anthropic статус поставщика не одной модели, а полноценной линейки решений, которую можно подстроить под задачи конкретной команды или бизнеса — от глубокой аналитики до быстрых массовых запросов.

Claude 3.5 Sonnet стал логичным развитием линейки Claude 3: он по‑прежнему занимает «средний» уровень между Haiku и Opus по стоимости и вычислительным требованиям, но по качеству во многих задачах приблизился к старшему Opus, а местами и превосходит его. Это превратило Sonnet в модель по умолчанию для большинства практических сценариев.

По сравнению с Claude 3 Sonnet новая версия заметно сильнее в долгих цепочках рассуждений и сложных задачах, где нужно удерживать контекст и проверять собственные выводы. Это чувствуется в аналитике, разборе документов, проектировании архитектур и планировании процессов.

Вторая ключевая зона улучшения — программирование. Claude 3.5 Sonnet лучше понимает большие кодовые базы, аккуратнее вносит правки, реже «ломает» рабочий код и лучше объясняет предлагаемые изменения. Он уверенно справляется с генерацией нетривиальных алгоритмов, написанием тестов и миграциями между фреймворками.

Отдельно заметен прогресс в креативных задачах: сценарии, концепции продуктов, тексты для лендингов и презентаций стали более структурированными, с меньшим количеством повторов и воды.

Появление режима Artifacts изменило сам формат взаимодействия с моделью. Ответ Claude больше не ограничивается сообщением в чате — он превращается в живой артефакт: документ, фрагмент кода, прототип интерфейса, схему.

Пользователь может:

Фактически, Claude становится напарником в общем редакторе, а не только собеседником. Это особенно удобно при длительных проектах: требования, заметки, прототипы и код хранятся в одном контексте, рядом с обсуждением.

Claude 3.5 Sonnet в сочетании с Artifacts хорошо проявляет себя в нескольких типовых сценариях:

Запуск Claude 3.5 Sonnet вызвал заметный отклик у разработчиков и продвинутых пользователей. Отмечали три вещи:

В результате многие команды стали рассматривать именно Claude 3.5 Sonnet как основной рабочий ИИ‑инструмент, оставляя более тяжелые модели для редких, особо сложных задач.

Развитие Anthropic хорошо видно по тому, как смещались её приоритеты: от почти «академического» фокуса на безопасности ИИ к сочетанию глубоких исследований и коммерческих продуктов на базе семейства Claude.

В первые годы Anthropic вела себя скорее как исследовательская лаборатория. Основное внимание шло на интерпретируемость моделей, снижение вредоносного поведения и концепцию Constitutional AI. Публикации и технические отчёты были не менее важны, чем сами прототипы моделей.

С выходом Claude 1 и особенно Claude 2 компания стала переходить к продуктовой логике: появился стабильный API, документация для разработчиков, первые корпоративные клиенты. Приоритеты расширились: к исследованиям добавились надежность сервиса, масштабируемость, инструменты для интеграции в существующие бизнес‑процессы.

Линейка Claude 3 и 3.5 уже проектировалась как платформа: разные модели под разные сценарии (от прототипирования до сложной аналитики), мультиязычность, функции для командной работы. Исследовательская повестка не исчезла, но стала тесно связана с практическими запросами пользователей.

Anthropic начинала как компактная команда специалистов по безопасности ИИ и крупным языковым моделям. По мере успеха моделей штат быстро рос: появились отдельные команды по продукту, инфраструктуре, работе с корпоративными клиентами, а позже — офисы в нескольких городах США и Европе.

Организационный рост был необходим не только ради разработки моделей, но и ради всего, что вокруг них: юридическая экспертиза, политика использования ИИ, поддержка клиентов, партнёрские программы, обучение разработчиков.

Интерес к Anthropic со стороны технологических гигантов и венчурных фондов сопровождался крупными раундами инвестиций и многомиллиардными оценками. К компании присоединились стратегические инвесторы из числа ведущих облачных и платформенных игроков.

Для Anthropic такие партнёрства критичны по двум причинам:

Без таких альянсов даже сильная исследовательская команда рисковала бы остаться нишевым игроком, тогда как Anthropic сумела выйти на глобальный рынок.

Коммерческий успех не отменил исходный приоритет Anthropic — безопасность ИИ. Компания по‑прежнему инвестирует в интерпретируемость, оценку рисков, «красные команды» и политику ответственного развёртывания моделей.

По мере роста число стейкхолдеров и давление рынка увеличиваются, но публичные заявления, структура команд и продолжающие выходить исследования показывают: для Anthropic безопасность — не второстепенное направление, а рамка, внутри которой строится продуктовая стратегия Claude.

Anthropic развивает Claude в окружении сильных конкурентов — прежде всего GPT‑4/4o от OpenAI, Gemini от Google и открытых моделей вроде Llama и Mistral. Это не только борьба за качество, но и за подход к безопасности и прозрачности.

Ключевое отличие Claude — акцент на управляемости и предсказуемом поведении через метод Constitutional AI. Модель обучают следовать заранее сформулированным принципам, а не только набору примеров «что можно, а что нельзя».

На этом фоне Claude обычно воспринимают как более «осмотрительную» и объяснимую модель: он чаще проговаривает риски, предлагает шаги проверки, мягче формулирует спорные тезисы. Слабая сторона — возможная излишняя осторожность и отказы там, где продвинутому пользователю хотелось бы более смелых гипотез.

С появлением GPT‑4 и Gemini команды Anthropic стали быстрее добавлять новые возможности: большие контексты, улучшенную работу с кодом, мультимодальные функции, а позже — Artifacts и более «живой» диалог в Claude 3.5 Sonnet.

Функции часто развиваются «ступенчато»: одна компания первой показывает коммерчески жизнеспособное решение (например, интеграцию с инструментами разработчика), остальные отвечают своими версиями. Конкуренция не только давит по метрикам качества, но и заставляет Anthropic удерживать баланс между мощностью и безопасностью, не откатываясь к чрезмерно ограниченным моделям.

Несмотря на конкуренцию, крупные игроки регулярно публикуют исследовательские работы, протоколы оценки безопасности, отчёты о рисках. Подходы Anthropic к Constitutional AI, механизмы «самокоррекции» моделей и обсуждения принципов безопасного масштабирования стали предметом анализа и переосмысления в других командах.

В свою очередь, Anthropic использует общепринятые бенчмарки (MMLU, GSM8K, HumanEval и др.) и участвует в обсуждении новых тестов для оценки вредоносного поведения, устойчивости к социальным манипуляциям и утечкам чувствительных данных. Стандартизированные бенчмарки и открытые методики аудита позволяют сравнивать Claude с другими моделями не только по «ощущениям», но и по формализованным показателям качества и безопасности.

Заметная часть ценности Anthropic — в разъяснении того, как обучаются и регулируются модели Claude. Публикации о принципах, внутренние политики безопасного развёртывания и готовность обсуждать ограничения помогают компаниям и госструктурам понимать риски и строить процессы вокруг Claude.

На рынке, где многие модели выглядят схожими по качеству, именно прозрачность подходов, чёткие принципы безопасности и готовность к внешнему аудиту становятся для Anthropic конкурентным преимуществом. Это снижает барьер для внедрения Claude в чувствительных областях — от образования и медицины до финансов и государственного сектора.

Эволюция Anthropic — от первых экспериментов до линеек Claude 3 и 3.5 — показывает одну устойчивую линию: компания не гналась за эффектными демо любой ценой, а выстраивала модели вокруг идеи управляемости, интерпретируемости и безопасности.

Claude 1 доказал, что большую языковую модель можно сделать более предсказуемой и «принципиальной». Claude 2 показал, что такой подход масштабируется до реальных бизнес‑кейсов. Серия Claude 3 и особенно Claude 3.5 Sonnet продемонстрировала, что высокие показатели качества, длинный контекст и удобство использования могут сочетаться с дизайном, в центре которого — риск‑ориентированная архитектура и прозрачные правила поведения модели.

История Anthropic — это пример того, как приоритет безопасности и контролируемости может определять технические и продуктовые решения:

По мере роста возможностей Claude именно эти принципы удерживают баланс между силой модели и приемлемым уровнем риска.

Можно ожидать, что следующие поколения Claude пойдут в нескольких направлениях:

По мере того как модели Anthropic становятся мощнее и доступнее, возрастает важность открытого обсуждения с исследователями, регуляторами, отраслевыми экспертами и гражданским обществом. От решений по лицензированию, стандартам безопасности и прозрачности будет зависеть, насколько широко и ответственно Claude будет применяться в образовании, медицине, науке, государственном секторе и бизнесе.

Путь Anthropic показывает, что эволюция генеративного ИИ — это не только гонка за качеством и скоростью, но и конкуренция подходов к безопасности, управлению и ответственности. Если история Claude продолжит развиваться в том же ключе, мы увидим модели, которые:

Понимание того, как Anthropic пришла к сегодняшним версиям Claude, помогает лучше оценить и будущее генеративного ИИ: какие направления развития будут поощряться рынком и обществом, какие практики безопасности станут стандартом и как совместить инновации с ответственностью. Именно в этой точке — на стыке возможностей и ограничений — и будет формироваться следующее поколение моделей Claude и их роль в нашей повседневной жизни и работе.

Anthropic — это компания, которая разрабатывает крупные языковые модели семейства Claude с упором на:

В отличие от многих конкурентов, Anthropic изначально строит модели вокруг принципов безопасного ИИ, а не добавляет защиту «поверх» уже обученных систем.

Constitutional AI — это метод обучения, при котором модель направляют не только через человеческую разметку, но и через формализованный набор принципов — «конституцию».

Основная идея:

Так модель учится применять общие правила к новым ситуациям, а не просто запоминать списки запретов.

Упор на безопасность и принципы делает Claude:

Обратная сторона — иногда излишняя осторожность там, где опытный пользователь ожидает более смелых гипотез или интерпретаций.

Ключевые этапы развития:

Ориентируйтесь на задачу и ограничения по бюджету/скорости:

Основные отличия:

Режим Artifacts превращает ответы Claude в редактируемые артефакты: документы, код, прототипы интерфейсов и др.

Вы можете:

Фактически, это общий рабочий редактор, где ИИ выступает напарником, а не просто собеседником. Это особенно удобно для прототипирования продуктов, ведения документации и разработки внутренних инструментов.

Типичные сценарии:

Выбор сценариев стоит начинать с задач, где легко измерить эффект: скорость обработки обращений, время подготовки документов, нагрузку на разработчиков.

Несмотря на акцент на безопасности, у Claude остаются ограничения:

Поэтому важно строить вокруг Claude процессы проверки, логирования и ответственности людей за финальные решения.

Из статьи можно ожидать, что развитие пойдёт в трёх направлениях:

При этом Anthropic, вероятно, сохранит центральный фокус на безопасности, прозрачности и диалоге с обществом и регуляторами, чтобы модели оставались управляемыми даже при росте их возможностей.

Если сомневаетесь, чаще всего разумно начинать с Claude 3.5 Sonnet.

Выбор зависит от того, что для вас критичнее: максимальная мощность, гибкость настройки или предсказуемая безопасность.