01 окт. 2025 г.·8 мин

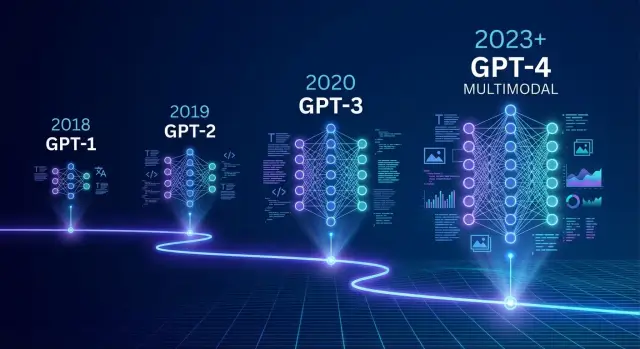

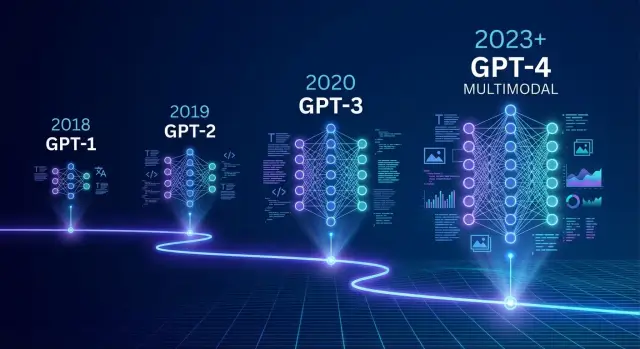

История развития моделей GPT: путь от GPT-1 до GPT-4 и дальше

Подробная история развития моделей GPT: от идей трансформеров и GPT-1 до GPT-4 и мультимодальных систем, ключевые вехи, прорывы и ограничения.

Подробная история развития моделей GPT: от идей трансформеров и GPT-1 до GPT-4 и мультимодальных систем, ключевые вехи, прорывы и ограничения.

Модели GPT (Generative Pre-trained Transformer) — это семейство нейросетей, которые учатся понимать и генерировать текст, опираясь на огромные массивы данных. Проще говоря, это универсальные «двигатели языка», которые можно настроить для сотен задач: от автодополнения кода до анализа документов и диалоговых ассистентов.

Разобраться, как GPT развивалась от первых экспериментов до современных версий, важно не только из любопытства. История GPT — это история того, как меняется сам подход к созданию ИИ: какие идеи сработали, какие ограничения вскрылись и почему сегодня модели выглядят именно так.

Отправная точка — статья про архитектуру трансформеров 2017 года, которая предложила новый способ работы с последовательностями текста. На её основе в 2018 появилась первая GPT, затем GPT-2 (2019), GPT-3 (2020), промежуточные версии вроде GPT-3.5 и ChatGPT (2022), а затем GPT-4 (2023) и более новые мультимодальные модели.

В статье мы проследим не просто смену «версий продукта», а эволюцию ключевых идей:

Материал ориентирован на разработчиков, продакт-менеджеров, архитекторов решений и энтузиастов ИИ, которым важно понимать, что стоит за брендом “GPT”:

Понимание истории GPT поможет осознанно выбирать инструменты, ставить реалистичные ожидания и лучше использовать потенциал генеративных моделей в своих проектах.

Появление GPT опирается на один ключевой технический сдвиг — архитектуру трансформера, предложенную в статье Google Research “Attention Is All You Need” (Васвани и соавт., 2017).

Трансформер — это архитектура нейросети для работы с последовательностями (текст, код, аудио), которая почти полностью отказалась от рекуррентных и свёрточных слоёв. В классическом варианте она состоит из:

Ключевой строительный блок и в энкодере, и в декодере — self-attention (само-внимание).

До трансформеров доминировали RNN и LSTM:

Трансформер решает эти проблемы:

В механизме self-attention каждый токен кодируется тремя векторами: query, key, value. Модель учится вычислять, какие другие токены важны для данного, и смешивает их представления с разными весами внимания.

Для генеративных моделей, вроде GPT, используется маскированное self-attention: токен «видит» только предыдущие токены, чтобы не «подглядывать» будущее.

На трансформерах стало заметно, что увеличение числа параметров, объёма данных и вычислений стабильно улучшает качество. Позже это формализовали как «scaling laws»: при правильном масштабировании ошибка плавно падает с ростом модели. На этом наблюдении и строилась стратегия GPT — делать модели всё больше и обучать их на всё более крупных корпусах.

После статьи Васвани появились первые крупные трансформерные модели:

GPT выбрал иной путь: чистый декодер, авто-регрессия и предсказание следующего токена на гигантском общем корпусе текста. Именно эта простая, но масштабируемая схема и стала основой всей последующей линейки GPT — от GPT‑1 до GPT‑4 и мультимодальных моделей.

GPT-1 представила команда OpenAI в 2018 году в статье Improving Language Understanding by Generative Pre-Training. Руководителем работы был Алек Радфорд (Alec Radford), соавторы — Картик Нарасимхан, Тим Салименс и Илья Суцкевер.

По меркам последующих поколений модель была небольшой и малозаметной, но именно она задала сам формат Generative Pre-trained Transformer — «генеративный предобученный трансформер».

GPT-1 строилась на архитектуре только декодер трансформера (uni-directional transformer):

Ключевая особенность — однонаправленное внимание: при обработке текста каждый токен «видит» только предыдущие токены, но не будущие. Это делает модель естественной для задачи генерации текста слева направо.

Для обучения использовался корпус BooksCorpus (около 7 тыс. книг, ~700 млн слов). Это сравнительно небольшой, но более связный и литературный датасет по сравнению с типичными интернет-сборками того времени.

Основная идея GPT-1 предельно проста: модель обучается предсказывать следующий токен по уже увиденной последовательности. Никаких специальных меток, разметки по классам, ручной аннотации.

Позже, после такого предобучения, ту же модель дообучали (fine-tune) на конкретных задачах: классификация, вопрос-ответ, распознавание настроений и т.д. Это показало, что общее «языковое чувство», полученное из задачи предсказания следующего токена, хорошо переносится на разные NLP-задачи.

GPT-1 стала доказательством жизнеспособности подхода:

Именно этот результат убедил исследовательское сообщество, что стоит масштабировать модель и данные. GPT-1 была не «готовым продуктом», а экспериментом, который показал: чем больше модель и корпус, тем больше универсальных языковых способностей можно получить из простой задачи предсказания следующего токена.

GPT-2 стал первой версией GPT, которая привлекла широкое внимание за пределами исследовательского сообщества. Именно с него начались серьёзные разговоры о рисках генеративного ИИ и необходимости отвечать за публикацию мощных моделей.

Главное отличие — масштаб и качество данных.

GPT-2 работал в том же парадигме: одна универсальная модель, обученная предсказывать следующий токен и используемая затем для множества задач без отдельного дообучения.

На практике это означало:

Эти возможности были логическим развитием идей GPT-1, но скачок в качестве сделал их практически применимыми для прототипов продуктов и экспериментов.

При релизе GPT-2 OpenAI впервые решила не выкладывать сразу полную модель. Стратегия Gradual Release включала:

Это вызвало широкую дискуссию:

GPT-2 стал первым сигналом, что генеративные модели перестают быть просто исследовательским прототипом и начинают затрагивать вопросы информационной безопасности, регулирования и этики. Именно вокруг него появилась первая волна публичных обсуждений о рисках масштабного применения генеративного ИИ.

Появление GPT-3 в 2020 году стало поворотным моментом для генеративного ИИ. Модель увеличилась до 175 млрд параметров — примерно на два порядка больше GPT-2 (1,5 млрд). Это потребовало колоссальных вычислительных ресурсов: недель тренировки на больших кластерах GPU/TPU и тщательно подобранных датасетов из сотен миллиардов токенов.

Ключевая особенность GPT-3 — умение «обучаться по подсказке»:

Например, для перевода в few-shot режиме промпт выглядит так:

Переведи на английский:

"Привет, как дела?" -> "Hi, how are you?"

"Я люблю машинное обучение" -> "I love machine learning"

"Сегодня хорошая погода" ->

Модель по шаблону продолжает: "The weather is good today".

Статья «Language Models are Few-Shot Learners» показала, что достаточно масштабировать архитектуру трансформера и обучить её на огромном корпусе текста — и модель начинает решать новые задачи без дообучения, только с помощью правильно составленного промпта. Это радикально упростило экспериментирование: вместо сложных пайплайнов с fine-tuning стало можно просто «объяснить задачу текстом».

GPT-3 уверенно продемонстрировала:

Именно на GPT-3 стало очевидно, что универсальная языковая модель может выступать «общим интерфейсом» к множеству задач без специализированного обучения для каждой из них.

GPT-3.5 стал промежуточным звеном между «сырыми» языковыми моделями и тем, что пользователи узнали как ChatGPT. Ключевым шагом было не только улучшение архитектуры и данных, но и появление метода RLHF — обучения с подкреплением от человеческой обратной связи.

Классическая модель предсказывает следующее слово, стремясь быть правдоподобной, но не обязательно полезной или безопасной. RLHF добавляет ещё один слой обучения:

В результате модель начинает лучше следовать инструкциям, избегать токсичных ответов и выдавать более структурированную, понятную информацию.

GPT-3.5 дообучили на диалоговых данных: вопрос–ответ, уточнения, контекст всей переписки. Появились привычные сегодня особенности:

Интерфейс ChatGPT оформил это в удобный чат: история диалога, быстрый перезапуск сессии, общий доступ из браузера. С технической точки зрения это всё та же модель, но обёрнутая в формат, знакомый мессенджерам.

ChatGPT сделал генеративный ИИ массовым продуктом. Пользователю больше не нужно знать термины вроде «prompt engineering» — достаточно задать вопрос естественным языком.

Это сильно подняло ожидания: от чат-ботов стали ждать осмысленной беседы, точных инструкций и помощи в реальных задачах — от программирования до творчества и обучения. Бизнес, в свою очередь, увидел готовый паттерн интерфейса и начал встраивать похожие диалоговые решения в продукты и сервисы.

GPT-4 стал первым поколением GPT, которое многие пользователи восприняли не как «умный автодополнитель», а как универсальный интеллектуальный инструмент. По сравнению с GPT-3.5 изменения затронули сразу несколько ключевых аспектов: качество ответов, устойчивость к ошибкам, следование инструкциям и работу с контекстом.

Главное отличие GPT-4 — заметно более глубокое понимание сложных запросов. Модель лучше держит логическую линию, аккуратнее работает с многошаговыми рассуждениями и реже «ломается» при длинных диалогах.

GPT-4 показал результаты уровня человека или выше на ряде стандартных тестов и экзаменов. Например, модель продемонстрировала высокий балл на симуляции экзамена по юриспруденции (bar exam) и уверенно справилась с рядом академических и профессиональных тестов. Это не делает её юристом или врачом, но показывает уровень сформированных языково-логических навыков.

Одна из наиболее ощутимых новинок — увеличение контекстного окна. GPT-4 способен обрабатывать значительно больше текста за один запрос: длинные документы, обсуждения с десятками сообщений, большие объёмы кода. Это позволило использовать модель как «собеседника по проекту», а не только как инструмент для отдельных задач.

Улучшилось и следование инструкциям. GPT-4 аккуратнее соблюдает формат ответа, стилистические требования, ограничения по длине и структуре, лучше различает роли и задаваемые сценарии. Для бизнеса это означает более предсказуемое поведение модели в реальных процессах.

Несмотря на прогресс, GPT-4 по‑прежнему подвержен галлюцинациям: он может уверенно выдавать неправдивые факты, не всегда явно сигнализируя о неуверенности. Модель всё ещё чувствительна к формулировке промпта, может ошибаться в расчётах и логике, особенно в нестандартных задачах.

GPT-4 не обладает собственным пониманием реальности и опирается на вероятностные паттерны в данных. Поэтому для ответственных сценариев по‑прежнему требуются проверка фактов, инструкции по безопасному использованию и продуманные ограничения в продуктах, которые строятся на базе модели.

Первые версии GPT работали только с текстом: на вход — строка символов, на выход — продолжение. Следующий крупный шаг в эволюции — переход к мультимодальности, когда модель может одновременно работать с разными типами данных: текстом, изображениями, звуком и, постепенно, видео.

Мультимодальный GPT-4 научился «видеть» и описывать картинки. Модель может:

Это вывело модель из мира чистого текста в область сложных документов, где текст тесно смешан с визуальными элементами.

Следующий шаг — поддержка речи и, постепенно, видео. Уже сейчас мультимодальные модели на базе GPT могут:

Для бизнеса это значит, что единая модель может обслуживать чат, голосовую линию, визуальную аналитику и поиск по медиаархивам.

Мультимодальность расширяет пространство продуктов:

При этом медиа несут больше рисков приватности, чем текст: на фото могут быть лица, номера авто, медицинские данные; в аудио — имена, номера карт, фрагменты конфиденциальных переговоров.

Поэтому при работе с мультимодальными GPT критично:

Мультимодальные поколения GPT кардинально расширяют границы применения генеративного ИИ, но одновременно требуют куда более серьёзного отношения к конфиденциальности и управлению данными.

Если упростить историю, каждая новая версия GPT — это одновременно:

Оценочно (публичные данные и сторонние оценки):

GPT-1 → GPT-2: основной упор — просто масштабирование корпуса и модели. Модель училась предсказывать следующий токен, без сложной надстройки.

GPT-2 → GPT-3: помимо роста масштаба, сильно усложняется смесь данных: добавляются специализированные наборы (код, научные тексты, диалоги), улучшается дедупликация, фильтрация по качеству, баланс доменов.

GPT-3 → GPT-3.5 → GPT-4: фокус смещается от «голого» предсказания текста к обучению выполнять инструкции.

Появляются несколько ключевых этапов:

С определённого момента простой рост параметров даёт всё меньший прирост качества. Поэтому важны:

Сочетание этих факторов объясняет, почему GPT‑4 сильно превосходит GPT‑3, даже если «сухие» числа параметров или объём данных известны не полностью: критична именно методология — от отбора данных до тонкой настройки и выравнивания поведения модели.

Модели GPT за несколько лет прошли путь от экспериментальных демо до инструмента, который тихо встроился в повседневную работу миллионов специалистов.

В офисной среде GPT стал универсальным помощником для работы с текстом:

Во многих продуктах GPT встроен прямо в поле ввода текста: пользователь набирает пару фраз, а система дописывает, переформулирует, предлагает варианты ответов клиентам или коллегам.

Для программистов GPT изменил сам процесс разработки:

Многие среды разработки получили встроенные «ИИ-подсказчики», а системы управления задачами научились предлагать технические описания фич на основе кратких бизнес-требований.

GPT активно используют для анализа больших массивов текста: от отзывов и анкет до внутренних документов. Распространены сценарии, где модель:

Во многих сервисах поиска по документам появились «диалоговые слои»: пользователь задает вопросы естественным языком, а система отвечает, ссылаясь на найденные фрагменты.

В образовании GPT используют как репетитора и редактора: разбор решений, объяснение тем разными способами, генерация заданий с автоматической проверкой. Важно, что преподаватели учатся строить задания так, чтобы студент не просто «спросил ответ у модели», а использовал её для проверки и доработки собственных решений.

В маркетинге GPT ускоряет подготовку контента: варианты текстов для кампаний, сегментированные сообщения, адаптация материалов под разные площадки. Планирование воронок, сценарии рассылок, описания продуктов — всё это теперь можно быстро набросать и затем доработать вручную.

Команды продуктов применяют GPT для быстрых прототипов интерфейсов и текстов: от подсказок в формах до FAQ и сценариев онбординга. Это снижает порог для экспериментов: проще проверить несколько вариантов формулировок или сценариев и выбрать лучший по реакции пользователей.

Появление GPT не только изменило существующие профессии, но и создало новые. Наиболее заметны:

Одновременно многие роли всё чаще требуют умения использовать GPT как базовый инструмент: от маркетолога и юриста до преподавателя и продакт-менеджера. Не столько исчезают профессии, сколько растёт разрыв между теми, кто умеет эффективно работать с ИИ-инструментами, и теми, кто продолжает действовать по старым процессам.

Модели GPT кажутся «магическими», но по сути это статистические системы, у которых есть фундаментальные ограничения. Игнорировать их рискованно — особенно в бизнес-критичных и общественно значимых сценариях.

Галлюцинации. GPT может уверенно выдавать неправду: придумывать факты, ссылки, цитаты, статистику. Модель не «знает», что истинно, а лишь продолжает текст по вероятности. Поэтому:

Предвзятость (bias). Модели обучаются на больших массивах реальных текстов, где уже присутствуют стереотипы, дискриминация и перекосы. Это может проявляться в:

Утечки данных и приватность. Ввод пользовательских данных в модель создаёт риск:

Минимум практик: не передавать в GPT пароли, коммерческие тайны, персональные данные без чётких правовых и технических гарантий.

Чтобы снизить вред, вокруг моделей строятся системы модерации и фильтрации: блокировка незаконного, токсичного, насильственного, сексуализированного и иного нежелательного контента. Это достигается сочетанием:

Для организаций этого недостаточно. Нужны собственные регламенты: какие задачи разрешено решать с помощью GPT, какие данные можно загружать, кто отвечает за проверку результата и за нарушения.

Правовой статус ИИ-контента ещё формируется и отличается по странам. Но уже сейчас важно разделять несколько уровней:

Во многих юрисдикциях автором считается человек, внёсший творческий вклад: выбрал концепцию, структуру, отредактировал текст. При этом:

Этическое использование GPT — это не только фильтры и юридические документы, но и культура работы с моделью.

Для компаний разумно:

Пользователям стоит воспринимать GPT как ассистента, а не как авторитет. Это инструмент для генерации идей, черновиков и анализа, но окончательные решения — юридические, медицинские, финансовые, управленческие — должны принимать информированные люди, понимающие ограничения технологии.

Будущее GPT всё яснее связано не только с ростом масштаба, но и с умным комбинированием моделей, данных и инструментов.

Дальнейшее увеличение числа параметров даёт всё меньшую отдачу, поэтому акцент смещается на:

Модели будут всё лучше понимать контекст человека и задачи: от чтения документов и экранов до работы с интерфейсами приложений. GPT станет не только «писать текст», но и выполнять последовательности действий: заполнять формы, анализировать панели мониторинга, запускать сценарии в ИТ‑системах.

Параллельно растёт спрос на:

Это приведёт к появлению «уровня адаптации»: базовый GPT + слой дообучения на корпоративных данных + тонкие настройки под конкретного пользователя. Для бизнеса это фактически новый тип ИТ‑инфраструктуры — «уровень интеллекта» между данными, сотрудниками и системами.

GPT уже всё чаще соединяют с:

Будущие системы будут работать как команды агентов, где один агент пишет код, другой проверяет, третий общается с пользователем и управляет процессом. GPT выступает «мозгом‑координатором», а не единственным компонентом.

Для бизнеса это:

Для специалистов — сигнал, что ценность смещается от выполнения рутинных задач к постановке задач, проверке результатов и интеграции ИИ в процессы. Следить за развитием GPT важно, чтобы:

Те, кто начнёт экспериментировать с GPT‑системами уже сейчас — через несколько лет будут диктовать стандарты в своей отрасли, а не догонять конкурентов.

История показывает, какие задачи GPT решает хорошо, а какие — нет, и почему.

Практические выгоды:

Ключевые отличия GPT‑4:

RLHF (Reinforcement Learning from Human Feedback) — это способ дообучить модель не только быть правдоподобной, но и более полезной и безопасной.

Как это работает:

Результат — меньше токсичных и откровенно вредных ответов, лучшее следование инструкциям и более структурированные, вежливые ответы.

Мультимодальность означает, что модель умеет работать не только с текстом, но и с картинками, звуком, позже — с видео.

Примеры бизнес‑кейсов:

Это позволяет строить единые ассистенты, которые понимают и текст, и визуальный/звуковой контекст процессов.

Базовые меры безопасности:

Полностью доверять ответам GPT нельзя: модель генерирует правдоподобный текст, а не истину.

Чтобы минимизировать риск:

GPT автоматизирует рутину и работу с текстом, кодом и коммуникациями, но не заменяет человека целиком.

Ожидаемые сдвиги:

Чтобы не «выпасть» из профессии, важно учиться использовать GPT как инструмент и строить вокруг него более сложные, экспертные компетенции.

Имеет смысл, когда:

Чаще всего не нужно «обучать свою модель с нуля»: достаточно взять базовый GPT и или подключить его к вашей базе документов через RAG. Это дешевле и надёжнее, чем строить полный аналог GPT.

История GPT показывает, что модель хорошо «учится по подсказкам» (few‑shot, zero‑shot). Практические приёмы:

Практичный план на 6–12 месяцев:

При этом GPT‑4 всё ещё способен на галлюцинации и не заменяет профильных экспертов в ответственных доменах.

Это снижает риски утечки данных и помогает соответствовать требованиям GDPR и локального законодательства.

Относитесь к GPT как к ассистенту, который помогает собрать и структурировать информацию, но не как к конечному источнику истины.

Так вы лучше используете сильные стороны современных GPT без сложного fine‑tuning.

Те компании, которые начнут системно экспериментировать сейчас, будут лучше готовы к следующему поколению мультимодальных и агентных GPT‑систем.