14 дек. 2025 г.·8 мин

Как абстракции фреймворков «протекают» при росте

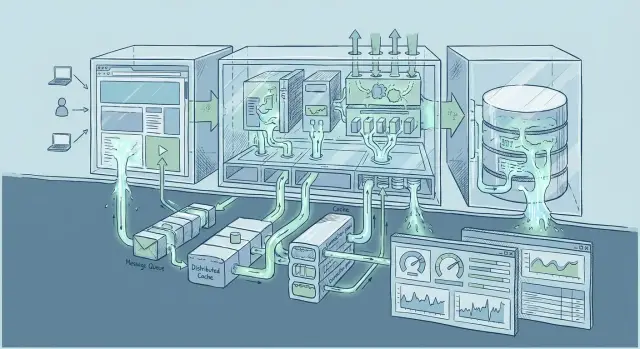

Разбираем, как «утекают» абстракции фреймворков при росте нагрузки: где появляются узкие места, как их выявлять и что менять в архитектуре.

Почему абстракции начинают «протекать» при масштабе

«Утечка абстракции» — это момент, когда удобный слой (фреймворк, библиотека, ORM, «автоматические» ретраи) перестаёт скрывать детали и внезапно заставляет разбираться с тем, что было «под капотом». До определённого момента абстракция помогает двигаться быстрее. После — её скрытые допущения становятся вашими инцидентами.

Простыми словами: что именно «протекает»

Абстракция обещает: «Думай о задачах бизнеса, а не о сетевых таймаутах, блокировках в БД и очередях». Но при росте нагрузки реальность начинает просачиваться: появляются ограничения на соединения, конкуренция за ресурсы, задержки сети, непредсказуемые пики. И вы вынуждены принимать решения на более низком уровне, чем планировали.

Почему на малой нагрузке всё выглядит идеально

На небольшом трафике система прощает ошибки архитектуры:

- редкие медленные запросы не заметны на фоне общей скорости;

- кэш «случайно» попадает в нужные данные;

- пул соединений никогда не исчерпывается;

- фоновые задачи успевают выполняться до следующей волны.

Фреймворк в этот момент действительно кажется магическим: он сглаживает острые углы, потому что углы ещё не острые.

Симптомы, которые первыми видят команды

Когда трафик растёт, проблема редко выглядит как «всё стало в 10 раз медленнее». Чаще она проявляется как:

- скачки времени ответа (p95/p99 растут быстрее, чем среднее);

- периодические таймауты «без причины»;

- рост ошибок при пиках, хотя код не менялся;

- зависающие воркеры, «забитые» очереди, внезапная деградация после релиза, который «ничего не трогал»;

- эффект домино: один медленный компонент тянет за собой остальные.

Какие части приложения протекают чаще всего

Чаще всего «вскрываются» места, где много скрытых допущений:

- слой данных (ORM, ленивые загрузки, транзакции, N+1 запросы);

- сеть (таймауты по умолчанию, повторные запросы, лимиты соединений);

- кэширование (устаревание, прогрев, шторм промахов);

- фоновые задачи и очереди (повторные выполнения, идемпотентность, конкуренция воркеров);

- память и конкурентность рантайма (очереди в памяти, блокировки, внезапный рост потребления).

Ключевая мысль: при масштабе «удобно» и «предсказуемо» — не одно и то же. И чем больше система, тем важнее знать, какие детали ваша абстракция скрывает — и при каких условиях перестаёт скрывать.

Что именно меняется, когда система масштабируется

Пока приложение небольшое, многие допущения фреймворка выглядят «естественными»: запросы приходят ровно, данные помещаются в память, сеть почти не ошибается, а редкие сценарии не встречаются неделями. При росте эти допущения перестают быть безопасными — и именно тут проявляются утечки абстракций.

Рост параллелизма: больше запросов одновременно

При увеличении числа одновременных запросов становятся видны скрытые очереди: пул соединений к базе, лимиты потоков/воркеров, блокировки, синхронные вызовы. То, что «просто работало», внезапно начинает давать каскад задержек: один медленный ресурс тормозит всех.

Рост объёма данных: таблицы, индексы, кэши

С ростом данных меняется стоимость привычных операций. Поиск, сортировка, пагинация, подсчёты — всё это может перейти из «мгновенно» в «секунды», если запросы опирались на неудачные индексы или делали лишние выборки. Кэши тоже меняют характер: промахи становятся дороже, прогрев — заметнее, а объём «горячих» данных может не помещаться в памяти.

Рост распределённости: больше сервисов и внешних зависимостей

Когда появляется больше интеграций, сеть перестаёт быть «прозрачной». Добавляются таймауты, ретраи, частичные отказы, разные версии API. Абстракция «вызов функции» превращается в цепочку удалённых вызовов, где важны лимиты, дедлайны и обратное давление.

Рост вариативности: «холодные» пути кода и редкие кейсы

На большом трафике редкие ветки становятся ежедневными: необычные входные данные, крайние значения, нестандартные роли пользователей. Вылезают проблемы с форматами данных, миграциями, правами доступа и обработкой ошибок — то, что не попадало в тесты при малом масштабе.

ORM и слой данных: где скрывается реальная цена удобства

ORM делает работу с базой данных «похожей на работу с объектами», и на малых объёмах это ощущается как чистая победа. Но при росте нагрузки скрытые решения ORM начинают определять стоимость каждого запроса — и вы внезапно платите временем, блокировками и перегревом базы.

N+1 и неожиданные каскадные загрузки

Классическая утечка абстракции — N+1: вы загрузили список сущностей, а затем для каждой ORM «незаметно» добирает связанные данные отдельным запросом. На тестовом наборе это 11 запросов и терпимо, на проде — тысячи запросов, очередь в пуле соединений и рост латентности.

Похожая проблема — каскадные загрузки (eager/lazy), когда одно «удобное» обращение к полю приводит к серии JOIN’ов или дополнительных SELECT’ов. В итоге один экран приложения превращается в непредсказуемый запросный шторм.

Долгие транзакции и блокировки

ORM упрощает транзакции, но легко сделать их слишком широкими: открыть транзакцию, выполнить несколько запросов, пройти бизнес-логику, сходить во внешний сервис — и только потом commit. Под нагрузкой это означает блокировки строк/таблиц, рост конфликтов, «залипание» очереди запросов и каскадные таймауты.

Практика: держите транзакции максимально короткими, отделяйте чтение от записи, не смешивайте внутри транзакции сетевые вызовы.

Индексы и планы запросов: без контроля — без предсказуемости

ORM часто генерирует SQL, который «выглядит нормально», но плохо использует индексы: функции в WHERE, неудачный порядок условий, лишние JOIN’ы. Без привычки смотреть план (EXPLAIN) можно месяцами лечить симптомы на уровне приложения, когда корень — в неправильном индексе или в запросе, который не селективен.

Массовые операции: пагинация, сортировки, фильтры

На масштабе ломается наивная пагинация OFFSET/LIMIT: чем дальше страница, тем дороже запрос. Сортировки по неиндексированным полям превращают базу в «сортировочную машину», а фильтры по тексту/JSON без продуманной структуры дают полный скан.

Для массовых операций полезны: keyset-пагинация, явный выбор полей (не SELECT *), батчи для вставок/обновлений и отдельные запросы под отчётные сценарии — даже если это немного «выходит за рамки» ORM.

Сеть и соединения: таймауты, ретраи и узкие места

Фреймворк часто делает сеть «невидимой»: отправили запрос — получили ответ. Под нагрузкой сеть перестаёт быть прозрачной, и абстракции начинают протекать: у каждого вызова появляются ожидания, очереди, повторные попытки и неожиданные блокировки.

Пулы соединений к БД: исчерпание и очереди ожидания

Даже если база данных справляется, приложение может упереться в пул соединений. Когда активных запросов больше, чем соединений, новые операции не «работают медленнее» — они встают в очередь ожидания.

Симптомы: скачки времени ответа без роста CPU, таймауты на уровне приложения, «случайные» ошибки при пиках. Важно различать таймаут запроса к БД и таймаут ожидания соединения в пуле — это разные причины и разные решения (увеличить пул, оптимизировать запросы, уменьшить конкуренцию, ввести лимиты на параллелизм).

Keep-alive, таймауты и повторные попытки

Keep-alive экономит время на установке соединения, но при неправильной настройке даёт «зависшие» сокеты и долгие ожидания. Таймауты тоже должны быть многослойными: отдельный таймаут на установку соединения, на чтение ответа и общий дедлайн.

Ретраи добавляют устойчивости, но легко превращаются в мультипликатор нагрузки: один сбой → 3 повтора × 1000 запросов = внезапный шторм. Правила: ретраить только идемпотентные операции, добавлять экспоненциальную паузу и джиттер, ограничивать число попыток и всегда иметь общий дедлайн.

Лимиты внешних API и хвостовые латентности (p95/p99)

Внешние сервисы отвечают не только «быстро/медленно», а с длинным хвостом задержек. Среднее время может выглядеть нормально, но p95/p99 растут — и именно они создают очереди в потоках, воркерах и пулах.

Если есть rate limit, нужна деградация: кэш, очереди, «мягкие» ошибки, частичные ответы. Иначе приложение будет тратить ресурсы на заведомо обречённые вызовы, ухудшая ситуацию для остальных пользователей.

Форматы данных и (де)сериализация под нагрузкой

Когда система небольшая, формат данных кажется деталью: «передаём JSON и всё». Под нагрузкой именно (де)сериализация часто становится незаметным потребителем CPU, памяти и времени ответа — и абстракции фреймворка перестают «скрывать» цену.

JSON, protobuf и большие payload

JSON удобен, но дорог: парсинг текста, преобразование строк, частые аллокации и создание промежуточных объектов. На малых объёмах это не видно, но при росте количества запросов или размеров ответов стоимость умножается.

Бинарные форматы (например, protobuf) обычно быстрее и компактнее, но требуют схем, версионирования и более строгой дисциплины контрактов. Это обмен: меньше CPU/сети — больше внимания к совместимости.

Отдельная проблема — большие payload. «Просто добавить поле» в ответ кажется безопасным, пока этот ответ не начнёт весить сотни килобайт и не станет повторяться тысячи раз в минуту.

Валидация и маппинг моделей: скрытые аллокации

Многие фреймворки автоматически валидируют вход, преобразуют DTO в доменные модели и обратно. Каждый такой шаг может:

- копировать структуры (особенно при вложенных объектах);

- создавать временные строки/коллекции;

- выполнять рефлексию или динамическое преобразование типов.

В итоге вы платите не только за бизнес-логику, но и за «красоту» слоя моделей.

Стриминг vs буферизация целиком

Частая утечка абстракции: фреймворк «удобно» собирает весь запрос/ответ в памяти. Для больших файлов, длинных списков или отчётов это приводит к скачкам потребления памяти и паузам сборщика мусора.

Если сценарий позволяет, выбирайте стриминг (постраничная выдача, chunked-ответ, чтение/запись потоками), чтобы обрабатывать данные по частям.

Лимиты размеров и защита от перегруза

Под нагрузкой важно не только ускоряться, но и ограничивать ущерб:

- лимиты на размер тела запроса и ответа;

- ограничение глубины/сложности вложенных структур;

- отказ от «универсальных» эндпоинтов, которые возвращают «всё сразу».

Эти меры делают систему предсказуемее: даже если клиент ошибся (или злоупотребляет), сервер не уйдёт в перерасход CPU и памяти из‑за одной слишком «тяжёлой» сериализации.

Кэширование: от ускорения к новым отказам

Держите код под контролем

Выведите исходники и проверьте SQL, транзакции, ретраи и сериализацию там, где важен p99.

Кэш часто выглядит как «быстрая кнопка»: добавили Redis или CDN — и нагрузка исчезла. На практике кэш ускоряет только то, что уже хорошо понимаете. Если база данных медленная из‑за неверных запросов, если API нестабильно, если в приложении гонки и блокировки — кэш может лишь замаскировать проблему, а при пике сделать сбой более резким.

Почему «кэш всё исправит» — опасная идея

Кэш полезен, когда:

- данные читаются гораздо чаще, чем меняются;

- есть чёткая стратегия обновления;

- вы готовы к тому, что кэш иногда пуст, истёк или недоступен.

Если же обновления частые или требования к актуальности жёсткие, кэш начинает «протекать»: появляются устаревшие значения, сложные правила инвалидации и неожиданные пики нагрузки.

Ключи, TTL и инвалидация: где рождаются инциденты

Хороший кэш начинается с ключей. Ключ должен однозначно кодировать контекст: версию схемы/формата, язык, права доступа, параметры запроса. Иначе вы получите неправильные данные «из чужого запроса».

TTL (время жизни) — не универсальное лекарство. Слишком короткий TTL ведёт к постоянным промахам и нагрузке на источник данных; слишком длинный — к устареванию. Инвалидация «по событию» точнее, но требует дисциплины: любое место, которое меняет данные, должно уметь сбрасывать связанные ключи.

Отдельная боль — шторм кэша: когда множество ключей истекает одновременно (или кэш очищен), и тысячи запросов одновременно идут в базу.

Уровни кэширования: CDN, приложение, БД

CDN хорошо снимает статические и публичные ответы, но плохо подходит для персонализированного контента. Кэш на уровне приложения гибче (можно кэшировать результаты вычислений), но требует контроля памяти и конкурентности. Кэш на стороне БД (план/страницы) помогает «сам по себе», однако не отменяет необходимость оптимизации запросов.

Прогрев и защита от cache stampede

Чтобы избежать stampede, используйте:

- «single flight»/блокировку на ключ: один запрос пересчитывает, остальные ждут;

- soft TTL (stale-while-revalidate): отдаём слегка устаревшее и обновляем в фоне;

- jitter для TTL, чтобы ключи не истекали одновременно;

- предварительный прогрев популярных ключей перед запуском релиза.

Кэш ускоряет систему, но добавляет новые режимы отказа. Его нужно проектировать как часть архитектуры, а не как пластырь поверх боли.

Очереди и фоновые задачи: где исчезает «магия»

Очередь часто выглядит как простой рычаг: «вынесем тяжёлое в background — и всё полетит». На небольших объёмах так и бывает. Но при росте абстракция очереди начинает «протекать»: всплывают задержки, дубли, перекосы по приоритетам и пределы инфраструктуры.

Очереди как способ сгладить пики

Правильная роль очереди — сгладить всплески и отделить некритичные действия от пользовательского запроса. Например: отправка писем, генерация отчётов, пересчёт статистики, синхронизация с внешними сервисами.

Но очередь не ускоряет «математику» сама по себе. Она лишь переносит работу в другое место и время. Если потребители (воркеры) в сумме обрабатывают меньше, чем вы производите, вы получите растущую задержку, а пользователи — «вроде всё приняли», но результат появляется через часы.

Идемпотентность и обработка дублей

Под нагрузкой дубли — норма, а не исключение: ретраи, таймауты, повторная доставка, падение воркера после выполнения, но до подтверждения.

Поэтому задача должна быть идемпотентной: повторный запуск не должен ломать данные и создавать лишние побочные эффекты. Практичные приёмы: уникальные ключи операции, таблица выполненных задач (dedup), условные обновления («обнови, если версия совпадает»), «вставь, если не существует».

Backpressure: когда очередь растёт быстрее обработки

Когда очередь раздувается, «магия» заканчивается и нужен контроль потока:

- ограничение скорости постановки задач (rate limiting) и отказ/деградация для некритичных событий;

- авто-масштабирование воркеров, но с учётом лимитов БД и внешних API;

- отдельные очереди по типам работ и приоритетам, чтобы тяжёлое не вытесняло важное.

Важно измерять не только длину очереди, но и «возраст» сообщений (сколько ждут до старта).

Границы ответственности: синхронно vs асинхронно

Синхронно оставляйте то, без чего нельзя завершить запрос корректно (проверка прав, запись заказа, резервирование). Асинхронно — всё, что можно «догнать» позже: уведомления, аналитика, обогащение данных.

Ключевой критерий: можно ли безопасно показать пользователю промежуточный статус («принято в обработку») и гарантировать завершение через надёжную цепочку ретраев и мониторинга.

Память, CPU и конкурентность: реальный предел рантайма

Делайте проекты локально в РФ

TakProsto работает на серверах в России и использует локализованные open source LLM модели.

Когда нагрузка растёт, «фреймворк сам разрулит» перестаёт быть правдой: у рантайма есть конкретные физические границы — ядра CPU, пропускная способность памяти, лимиты планировщика и стоимость сборки мусора. Абстракции скрывают эти детали ровно до момента, когда вы упираетесь в них одновременно.

Пулы потоков/воркеров и конкуренция за ресурсы

Пулы создают иллюзию бесконечной параллельности: вы «просто» запускаете задачи, а дальше всё работает. На масштабе проявляется обратная сторона — очередь задач растёт, латентность скачет, а воркеры начинают конкурировать за:

- CPU (контекстные переключения и прогрев кэшей процессора)

- память (аллокации, давление на кэш L3)

- общие блокировки (логирование, метрики, пул соединений)

Симптом: средняя загрузка CPU высокая, но полезная работа не увеличивается; p95/p99 резко хуже среднего.

GC/управление памятью и непредсказуемые паузы

Сборщик мусора и аллокатор незаметны, пока объёмы небольшие. Под нагрузкой любые «мелочи» — лишние временные объекты, сериализация в промежуточные структуры, копирование строк — превращаются в постоянный шум. Итог: чаще запускается GC, появляются паузы (иногда краткие, но частые), а задержки запросов становятся рваными.

Практический маркер: рост времени в GC, увеличение RSS/heap, «пила» по памяти и деградация p99 при стабильном трафике.

Блокирующие операции в «неблокирующих» контурах

Даже если фреймворк обещает асинхронность, один блокирующий вызов в горячем пути (файловая система, DNS, внешний HTTP, медленный драйвер) может остановить целый пул. На малой нагрузке это незаметно, на большой — превращается в цепочку: блокировка → очередь → таймауты → ретраи → ещё больше блокировок.

Профилирование CPU и памяти: что измерять и где искать

Чтобы поймать утечки абстракций, нужны не догадки, а профили:

- CPU: «топ» функций по времени, блокировки/синхронизация, горячие участки сериализации

- Память: аллокации по типам, удержания (retained), рост кэшей и очередей

- Конкурентность: длины очередей пулов, время ожидания воркеров, количество активных задач

Если профили показывают, что значимая доля времени уходит в GC, синхронизацию или обвязку фреймворка, это прямой сигнал: пора упрощать горячий путь и возвращать контроль над ресурсами приложению.

Отказоустойчивость: когда «по умолчанию» недостаточно

Фреймворки часто создают ощущение «страховки»: если сервис упал или база ответила медленно, «оно само повторит запрос» или «как‑то переживёт пик». На небольших объёмах это может выглядеть правдой. Но при росте нагрузки скрытые решения «по умолчанию» превращаются в ускоритель аварии: ретраи множат трафик, очереди растут, потоки ждут, а сбой из одной зависимости разъезжается по всей системе.

Ожидания от фреймворка: «сам восстановится» vs реальность

Автоматические механизмы полезны, пока вы явно контролируете границы: сколько запросов можно выполнять одновременно, сколько времени ждать, что считать ошибкой и когда прекращать попытки. Без этих границ система ведёт себя как «слишком вежливый» клиент: терпеливо ждёт и пробует снова, пока не закончится память, соединения или терпение пользователей.

Circuit breaker, bulkheads, лимиты и деградация

Circuit breaker нужен, чтобы быстро перестать стучаться в явно больную зависимость и дать ей восстановиться.

Bulkheads (переборки) — чтобы проблема в одном компоненте не «затопила» остальные: отдельные пулы соединений, отдельные лимиты конкурентности, отдельные очереди.

Лимиты должны сопровождаться деградацией функциональности: временно отключить второстепенные функции (поиск, рекомендации, отчёты), вернуть упрощённый ответ, показать кэшированную версию. Важно заранее решить, что именно можно «урезать», а что нельзя.

Таймауты и ретраи без каскадных сбоев

Хорошее правило: таймауты короче, чем ожидание пользователя, и согласованы между слоями (клиент → сервис → база). Ретраи — только для безопасных операций, с джиттером и ограничением попыток; лучше один контролируемый повтор, чем пять синхронных, которые добьют и без того перегруженную систему.

Тестирование отказов: простые сценарии

Команде достаточно 4–5 регулярных упражнений:

- замедлить внешнюю зависимость (искусственная задержка) и проверить, что срабатывают таймауты;

- «уронить» сервис и убедиться, что circuit breaker открывается, а не копит ожидания;

- ограничить пул соединений и посмотреть, не блокируется ли весь процесс;

- включить частичные ошибки (например, 1 запрос из 10) и проверить, что ретраи не создают бурю.

Такие проверки превращают отказоустойчивость из веры в поведение «по умолчанию» в управляемую характеристику системы.

Наблюдаемость: как увидеть утечки абстракций вовремя

Когда абстракция «протекает», проблема редко выглядит как «виноват фреймворк». Чаще вы видите странные таймауты, скачки задержек или рост ошибок — и без наблюдаемости это превращается в гадание. Хорошая новость: утечки почти всегда оставляют измеримые следы.

Метрики, которые ловят протечки

Не ограничивайтесь средними значениями. Для пользовательского опыта важнее хвосты распределения:

- Latency p95/p99 по ключевым ручкам/операциям (отдельно: API, фоновые задачи, обращения к БД).

- Ошибки: доля 5xx/4xx, таймауты, отмены, ретраи, rate-limit.

- Насыщение ресурсов: CPU, память, GC/паузы рантайма, размер очередей, количество соединений, время ожидания в пуле.

Когда p99 растёт, а среднее «в порядке», это часто означает скрытую очередь: пул соединений, блокировки, синхронные вызовы, сериализация.

Трейсинг сквозь сервисы и БД

Распределённый трейсинг помогает увидеть, где именно «удобный вызов» превращается в цепочку дорогих операций. Важно:

- прокидывать correlation id от входящего запроса до запросов в БД и внешние сервисы;

- фиксировать спаны для ORM-операций (время построения запроса, выполнение, маппинг результата);

- выделять ожидания: очередь, локи, пул, DNS/TLS.

Логи: структура, корреляция, стоимость

Логи должны быть структурированными (JSON-поля), чтобы фильтровать по request_id, пользователю, endpoint, ошибке. Отдельно считайте объём и цену логов: под нагрузкой «безобидный» debug может съесть I/O и бюджет.

Алёрты без шума: SLO и приоритеты

Алёрт должен отвечать на вопрос «пользователям плохо?». Задайте SLO (например, 99% запросов быстрее X и ошибок меньше Y) и алёртите по нарушению бюджета ошибок, а не по единичным всплескам. Пороговые алёрты по насыщению (очереди, пул соединений, память) ставьте как ранние сигналы, но с подавлением шума и чёткой приоритизацией. Сводный чек-лист можно держать в /runbook/observability.

План действий: диагностика и улучшения шаг за шагом

Проверьте нагрузку до релиза

Быстро поднимите окружение, чтобы прогнать нагрузочные тесты и поймать очереди и таймауты.

Когда «протекла» абстракция, хочется срочно переписать половину сервиса. Лучше действовать как инженер-диагност: сначала измерить, затем сузить гипотезы, и только потом менять.

1) Нагрузочное тестирование: цель и профиль трафика

Начните с формулировки цели: что именно должно выдержать приложение — RPS, количество параллельных пользователей, время ответа для ключевых сценариев, скорость обработки очереди.

Соберите профиль трафика, близкий к реальности: соотношение чтение/запись, «тяжёлые» эндпоинты, распределение по времени, размеры payload. Заранее задайте критерии успеха: p95/p99 латентности, допустимый процент ошибок, потолок CPU/памяти, стабильность при прогреве кэша.

2) Найти «узкое место №1» и зафиксировать эффект

Ищите не «всё сразу», а главный ограничитель. Обычно он один: база, пул соединений, сериализация, блокировки, GC, внешние API.

Выберите один показатель, который улучшаете, и один способ проверки. После изменения обязательно фиксируйте эффект тем же тестом и тем же трафиком — иначе легко принять шум за прогресс. Если прироста нет, откатывайте и возвращайтесь к гипотезам.

3) Канареечные релизы и контроль регрессий

Выкатывайте оптимизации постепенно: 1–5% трафика на новую версию, сравнение метрик со «старой» (латентность, ошибки, saturation ресурсов). Держите быстрый план отката.

Добавьте производительные «сигналки» в CI/CD: бюджет латентности, алерты на рост p99 и на увеличение количества ретраев/таймаутов.

4) Документирование: превращаем «магию» в знание

Записывайте решения коротко и предметно: симптом → причина → как измеряли → что изменили → какой эффект получили → какие риски остались. Это снижает повторение ошибок и помогает выбирать правильный уровень абстракции в следующих задачах.

Небольшая ремарка для команд, которые активно ускоряют разработку через LLM-инструменты: быстрый старт (особенно в формате vibe-coding) не отменяет инженерных границ под нагрузкой. Например, в TakProsto.AI можно собрать веб/серверное/мобильное приложение через чат (React на фронте, Go + PostgreSQL на бэкенде, Flutter для мобайла) — и именно поэтому полезно заранее «вшивать» в проект базовые лимиты, таймауты, ретраи, метрики и сценарии деградации, чтобы абстракции не начали протекать в самый неподходящий момент.

Как выбирать уровень абстракции для масштаба

Рост нагрузки редко требует «переписывать всё». Чаще он заставляет честно ответить на вопрос: какие части системы можно оставлять под «зонтиком» фреймворка, а где нужна более явная инженерия.

Когда оставаться на фреймворке — и усиливать дисциплину

Оставайтесь на стандартных абстракциях, если узкие места не в «горячем пути» и их можно закрыть практиками:

- стабильные лимиты: пул соединений, таймауты, ретраи, ограничения на размер запросов/ответов;

- предсказуемый доступ к данным: индексы, понятные запросы, контроль N+1;

- договорённости в команде: «не делаем тяжёлую работу в запросе пользователя», «всё асинхронное — через очередь», «включены метрики по умолчанию».

Это выгодно, когда важнее скорость разработки и единые правила, чем выжимание последней миллисекунды.

Когда выделять компоненты/сервисы для горячих путей

Выносите части системы из общих абстракций, если:

- именно они дают большую долю задержки или стоимости (например, 10% эндпоинтов делают 80% нагрузки);

- вам нужен отдельный жизненный цикл: независимое масштабирование, разные SLO, отдельные лимиты;

- оптимизации упираются в «невидимую магию» (ORM, middleware, универсальные сериализаторы).

Практичный подход: сначала отделите модуль внутри монолита (чёткий интерфейс), и только затем — сервис, если выигрыш подтверждён измерениями.

Границы абстракций: где нужны явные решения

Обычно явных решений требуют три зоны: база данных (пулы, транзакции, конкретные запросы), кэш (инвалидация, TTL, защита от stampede) и очередь (идемпотентность, дедупликация, ретраи, DLQ). Здесь «по умолчанию» часто работает до первой серьёзной нагрузки.

Дальше по теме

Смотрите связанные разборы и чек-листы в /blog. Если вы выбираете между «дожать текущий стек» и выделять отдельные компоненты, ориентиры по подходам и стоимости можно сравнить на /pricing.