24 июн. 2025 г.·8 мин

Как построить сайт под programmatic SEO: пошаговый план

Пошаговый план: как спроектировать сайт под programmatic SEO — данные, шаблоны, структура URL, индексация, перелинковка и контроль качества при масштабировании.

Пошаговый план: как спроектировать сайт под programmatic SEO — данные, шаблоны, структура URL, индексация, перелинковка и контроль качества при масштабировании.

Programmatic SEO — это способ создавать и продвигать множество поисковых страниц по шаблону, подставляя в него данные. Проще говоря: вы один раз проектируете «скелет» страницы (заголовки, блоки, тексты, таблицы, FAQ, ссылки), а затем автоматически выпускаете сотни или тысячи вариантов — например, под разные города, модели, характеристики, категории или комбинации параметров.

Важно: цель здесь не «нагенерировать URL», а дать пользователю предсказуемо полезный ответ на конкретный запрос, масштабируя его за счёт данных.

Подход особенно полезен, когда людям нужны однотипные ответы, но по большому числу запросов. Типичные кейсы — «много похожих страниц по данным»: каталоги, справочники, агрегаторы, витрины услуг, подборки и сравнения. Главное, чтобы каждая страница реально отвечала на свой запрос и давала конкретику (цифры, варианты, ограничения, шаги, сравнение), а не просто повторяла общий шаблон.

Programmatic SEO подходит, если:

Лучше сделать меньше страниц вручную, если данных мало, запросы уникальные, а ценность создаётся экспертным текстом, исследованиями и кейсами. В таких ситуациях шаблон часто даёт слабый результат и больше рисков, чем пользы.

Основные риски: «тонкие» страницы (мало смысла), дубли (похожие URL и контент) и «мусор» в индексе — когда поисковик видит тысячи страниц без полезной нагрузки.

Успех измеряется не только ростом трафика. Важнее, чтобы росли полезные действия: заявки, покупки, регистрации, клики по ключевым CTA, а также улучшались поведенческие метрики и доля страниц, которые стабильно получают показы и переходы.

Programmatic SEO работает там, где пользователи задают однотипные вопросы, а ответы можно собирать из данных и аккуратно упаковывать в шаблоны. Поэтому начинать стоит не с «сколько страниц можем сделать», а с того, какую задачу человек решает в поиске.

Сформулируйте 2–3 ключевых сценария: выбрать, сравнить, найти рядом, понять стоимость, проверить совместимость, изучить условия. Затем проверьте их в выдаче: если по запросам стабильно ранжируются каталоги/агрегаторы/справочники, ниша чаще подходит для масштабирования.

Определите параметры, из которых действительно имеет смысл собирать страницы:

Важно: сущность должна быть популярной в поиске и подтверждаться данными (иначе страницы будут пустыми).

Обычно масштабируются:

Быстро прикиньте потенциал: количество сущностей × частотность × наличие предложения. Если прогноз даёт десятки тысяч страниц, но данных на карточки мало, лучше начать с листингов и 1–2 атрибутов.

Сразу зафиксируйте правила: какие комбинации фильтров индексируются, а какие нет (например, редкие фильтры, дубли, «нулевые» листинги). Это сэкономит бюджет обхода и снизит риск появления мусорных страниц.

Programmatic SEO держится на дисциплине в семантике: вы не «пишете статьи», а проектируете повторяемые ответы на группы запросов.

Начните с выгрузки запросов из Search Console/Яндекс.Вебмастера, Wordstat и любых SEO‑инструментов. Далее сгруппируйте их по смыслу (кластеризация) и отметьте те кластеры, где намерение пользователя одинаковое и результат можно собрать из данных.

Признак, что кластер подходит под шаблон: запросы отличаются параметром (город, модель, категория, цена), а ожидаемый ответ — одного типа.

Удобная градация:

Для каждого кластера выпишите, что человек должен увидеть «сразу»: цена/диапазон, наличие, сравнение, карта, список, FAQ, условия. Это станет требованиями к блокам шаблона и данным.

Пример (упрощённо):

| Тип страницы | Кластер | Основной интент |

|---|---|---|

| Категория | «купить X» | выбор из списка |

| Фильтр/комбинация | «X + параметр» | быстро уточнить |

| Карточка | «X модель Y» | детали и решение |

Семантика «стареет»: появляются новые модели, бренды, формулировки. Поставьте правило пересмотра раз в 4–8 недель (для быстрых рынков — чаще): добавлять новые кластеры, удалять «мусор» и корректировать соответствие, чтобы не плодить лишние страницы.

Programmatic SEO держится не на «шаблонах», а на данных: чем они полнее, чище и актуальнее, тем полезнее страницы и тем меньше риск получить тысячи пустых карточек.

Типовые источники:

Важно заранее зафиксировать, кто «владелец правды» по каждому полю (например, цены — партнёр, описания — ваша редакция).

Даже для простых страниц стоит определить обязательный набор:

Если обязательных полей нет — лучше не генерировать страницу, а ставить запись в очередь на уточнение.

Задайте правила нормализации до генерации страниц:

Проверки качества стоит автоматизировать: пустые значения, некорректные диапазоны (цена = 0, площадь = 10 000), дубликаты, резкие выбросы относительно медианы, устаревшие записи (не обновлялись N дней).

Частота обновлений зависит от бизнеса: цены и наличие — ежедневно/почасово, справочники — раз в неделю/месяц. Любые загрузки логируйте: что изменилось (diff), когда, из какого источника, сколько записей добавлено/удалено, и какие записи заблокированы из-за ошибок. Это ускоряет диагностику, когда трафик проседает из‑за «поплывших» данных.

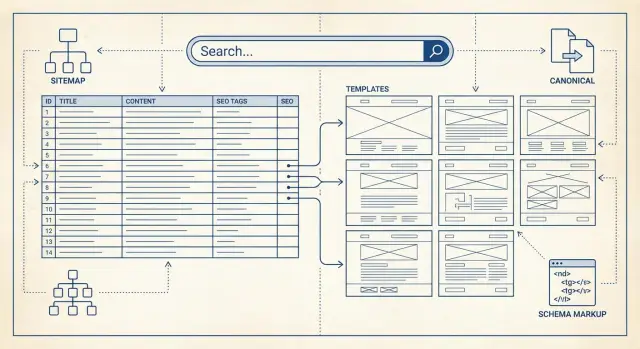

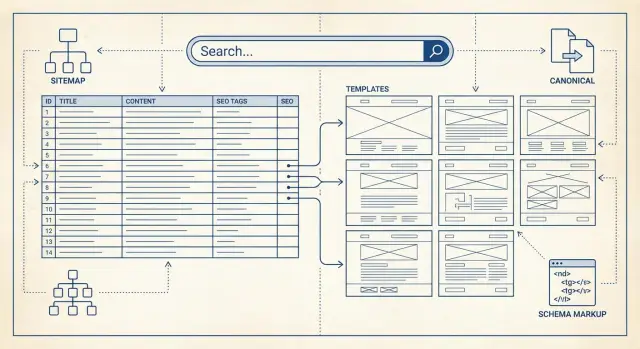

Архитектура в programmatic SEO — это «скелет» проекта: она определяет, какие типы страниц будут существовать, как они связаны между собой и как поисковик поймёт масштаб сайта без хаоса.

Базовый и понятный путь: главная → категории → подкатегории → детальные страницы. Важно, чтобы каждый уровень имел смысл сам по себе (не был просто «ступенькой»), а детальные страницы логично наследовали тему от родителя.

Пример:

Такой подход упрощает навигацию, перелинковку и дальнейшее расширение структуры.

Зафиксируйте правила до генерации тысяч страниц:

Плохой сигнал — когда один и тот же тип страниц имеет разные шаблоны адресов.

Фильтры часто удобнее реализовывать параметрами, но ими легко «размножить» мусорные URL.

Практика: индексируйте только заранее выбранные комбинации (например, самые частотные), а остальное:

У каждой страницы должен быть канонический URL — «главная версия». Сортировку обычно лучше оставлять неиндексируемой (каноникал на базовый список). Для пагинации придерживайтесь единого формата:

Сделайте короткий документ «карта URL» по всем типам страниц: по 3–5 примеров на тип + правила (каноникал, индексация, параметры). Это станет опорой для разработки и контента, а позже — для аудита.

Шаблон — это «контейнер» для данных и текста. В programmatic SEO он должен одновременно масштабироваться и давать пользователю понятный ответ без ощущения, что страница собрана из заготовок.

Хороший минимум для большинства типов страниц:

Уникальность — не только подстановка переменных. На каждой странице должны отличаться:

Сделайте так, чтобы «съедобное» было сразу: H1, интро и первый фрагмент таблицы/списка. Длинные объяснения и второстепенные блоки — ниже.

Предусмотрите состояния: нет данных (что сделать пользователю), мало данных (порог и предупреждение), устаревшие данные (дата, причина, альтернативы).

Если страница по смыслу ближе к статье на ~3000 слов, зафиксируйте правила: обязательные H2/H3, минимальный объём для интро/объяснений/FAQ, допустимая плотность списков и то, какие блоки генерируются из данных, а какие пишутся редактором.

Programmatic SEO легко скатывается в тысячи страниц с одинаковым текстом и минимальной ценностью. Цель шаблона — давать человеку ответ и ориентиры, а не просто «выдавать таблицу по фильтрам».

Держите заголовки понятными и разными, но без «ёлки» из ключей:

Избегайте повторов вроде «купить купить купить» и одинаковых Title на соседних комбинациях.

Добавьте 2–3 блока, которые меняются от страницы к странице:

Для близких страниц заранее задайте правила:

Если страница не получает показов/переходов и не расширяет ассортимент:

Повышайте доверие аккуратно: указывайте источник данных («цены — с сайтов школ»), дату обновления, методику расчёта (как считается рейтинг) и добавляйте ссылку на /about или /methodology. Это работает лучше, чем громкие заявления без подтверждений.

Programmatic SEO быстро создаёт сотни и тысячи URL — и поисковику нужно «объяснить», какие страницы действительно важны. Техническая настройка здесь решает две задачи: ускоряет попадание нужных страниц в индекс и защищает сайт от индексации мусора (фильтры, параметры, дубли).

Сначала разделите страницы на категории: целевые посадочные (их нужно индексировать), служебные (логин, корзина, внутренние результаты поиска), фильтры и параметры (часто дают дубли).

Для служебных и «параметрических» страниц используйте комбинацию:

robots.txt — чтобы ограничить обход (crawl) явно «плохих» зон (например, /search, параметры ?sort=).meta robots на странице — чтобы запретить индексацию там, где URL всё же доступен: noindex,follow часто подходит для фильтров, когда вы хотите сохранить переход по ссылкам.Важно: robots.txt не равно noindex. Если вы запретили URL в robots, бот может не увидеть meta robots и rel=canonical. Поэтому для дублей чаще лучше разрешить обход, но ставить noindex и/или canonical.

Сгенерируйте sitemap.xml только для канонических, индексируемых страниц. При большом объёме делайте разбиение на несколько файлов (например, по типам страниц или по алфавиту) и добавляйте sitemap-index.

Обновляйте карту при:

На каждой странице задайте rel=canonical на её «главный» URL (без лишних параметров, с правильным слэшем/без слэша). Если есть региональные версии, добавьте hreflang и убедитесь, что языковые пары ссылаются друг на друга и имеют self-referencing.

404 — если страницы не существует и, возможно, появится позже.410 — если удалили навсегда (часто быстрее вычищается из индекса).301 — при переездах, изменении структуры или замене шаблонов.Эти правила стоит закрепить в чек‑листе релиза и проверять после выкладки (см. /blog/seo-checklist).

Schema.org — это «словарь» разметки, который помогает поисковику понять, что именно находится на странице: статья, услуга, список вопросов, хлебные крошки и т. д. В programmatic SEO разметка особенно важна: одно хорошо продуманное решение можно раскатать на тысячи шаблонных страниц и получить более заметный сниппет.

Ориентируйтесь на смысл страницы и не пытайтесь «натянуть» неподходящий тип ради красивых звёздочек.

Разметьте BreadcrumbList на всех страницах, где есть навигационная цепочка. Это укрепляет понимание структуры сайта и часто отображается в выдаче вместо длинного URL.

Важно: крошки должны совпадать с реальной навигацией (и с вашей иерархией URL), а не быть «нарисованными» только в JSON-LD.

Добавляйте поля, которые поддерживаются и реально присутствуют на странице: заголовок, автор, дата, цена, наличие, рейтинг, FAQ‑блок. Не заполняйте недостоверные значения и не добавляйте поля «на всякий случай» — это частая причина ручных ограничений или игнорирования разметки.

Соберите 2–3 варианта разметки на разных шаблонах.

Проверьте валидность в Rich Results Test и Schema Markup Validator.

Оцените эффект (CTR, показы, ошибки в Search Console).

Только после этого раскатывайте на весь массив страниц, сохраняя единые правила в шаблонах и мониторинг ошибок (см. раздел /blog/monitoring).

Перелинковка в programmatic SEO — это «дороги» между тысячами страниц. Если их нет или они устроены хаотично, поисковик тратит краулинговый бюджет впустую, а пользователь быстро теряется. Цель — дать понятные маршруты и распределить вес на важные комбинации.

Продумайте три направления:

Отдельно выделите популярные комбинации: они должны получать больше внутренних ссылок (из хаба, из списков, из блоков «популярное»).

Автоматизируйте блоки, но с правилами:

Ограничивайте количество ссылок в блоке (например, 6–12) и показывайте только то, что имеет спрос или конверсионную ценность.

Фасетная навигация легко создаёт бесконечные URL. Практика: индексируйте только заранее выбранные «посадочные» сочетания, а остальное ведите в неиндексируемые состояния (например, через параметризацию с закрытием или через UI без генерации новых URL).

Анкор должен быть понятным и вариативным: «Квартиры в Казани», «Казань — студии», «Студии в Казани» — без однотипного повторения и без переспама.

Проверьте глубину: ключевые страницы обязаны открываться за 2–4 клика от главных хабов. Удобный тест — пройти путь вручную и параллельно посмотреть отчёт по глубине в краулере.

Programmatic SEO почти всегда означает тысячи и десятки тысяч URL. Если каждая страница «тяжёлая», медленно рендерится или генерируется на сервере слишком долго, вы получите проблемы сразу в трёх местах: сканирование поисковиками, пользовательский опыт и стабильность инфраструктуры.

Начните с простого: уменьшите то, что грузится в браузер.

srcset, ленивую загрузку оставляйте только ниже первого экрана.font-display: swap, по возможности — системные.Цель — быстрый первый рендер и минимальный объём критических ресурсов.

Для страниц, которые должны стабильно индексироваться, предпочтительнее серверный рендеринг (SSR) или пререндер HTML. Это снижает риск, что бот увидит «пустую оболочку» или дождётся данных слишком долго.

Практичный подход: критические блоки (заголовок, основной контент, таблица/карточки) — в HTML сразу, второстепенное (фильтры, отзывы, интерактив) — догружается позже.

При большом каталоге кэш — это не оптимизация, а условие выживания.

Следите за LCP/INP/CLS на шаблонах, а не на единичных URL: одна ошибка в компоненте размножается на тысячи страниц.

План публикации: выкатывайте партиями, включайте лимиты на генерацию (rate limit), прогревайте кэш, держите возможность быстро остановить выпуск новых страниц.

Практическая ремарка: если вы собираете продукт с нуля, ускорить путь «от идеи до работающего каталога» помогает vibe‑coding. Например, в TakProsto.AI можно через чат описать структуру сущностей, правила URL и состав блоков, а затем быстро собрать прототип на React с бэкендом на Go и PostgreSQL — с экспортом исходников, деплоем и откатом через снапшоты (удобно, когда тестируете шаблоны партиями и хотите быстро возвращаться к стабильной версии).

Programmatic SEO даёт масштаб, но вместе с ним легко «размножить» ошибки: пустые карточки, дубли и страницы без реальной пользы. Поэтому качество нужно встраивать в процесс публикации так же строго, как в продукт.

Перед тем как включать генерацию на тысячи URL, зафиксируйте минимальные требования к каждой странице:

Сделайте «публикацию» финальным шагом после валидации:

Главное правило: не публиковать страницы без спроса или без данных. На старте ставьте пороги: минимальная частотность, минимум заполненных атрибутов, достаточное покрытие данных по региону/категории. Всё, что ниже порога — в черновики.

Настройте алерты на рост 404/5xx, всплеск noindex, ошибки рендеринга и резкие провалы кликов в поиске. Раз в месяц проводите чистку: страницы без трафика/конверсий переводите в noindex, объединяйте дубли, удаляйте «пустышки» и обновляйте данные — так каталог остаётся полезным и индексируется стабильнее.

Programmatic SEO живёт на цифрах: без регулярного мониторинга вы не поймёте, какие шаблоны приносят трафик и где сайт «раздувается» бесполезными страницами. Сразу заложите рутину измерений и цикл улучшений.

Минимальный набор метрик:

Важно: фиксируйте не только общие цифры по сайту, а то, «что происходит» внутри конкретного шаблона.

Сегментируйте отчёты по двум осям: тип страницы (шаблон) и тип сущности (город, услуга, модель, категория). На практике это удобно делать через:

Так вы быстро увидите, где просела индексация, где CTR ниже нормы, а где страницы дают трафик без конверсий.

Тестируйте изменения небольшими итерациями: заголовки и сниппет, порядок и наличие блоков, FAQ, таблицы, варианты перелинковки. Если A/B на SEO сделать сложно, используйте последовательный подход: меняйте один элемент на группе страниц и сравнивайте «до/после» с контрольной группой.

Схема, которая снижает риск:

Соберите чек‑лист запуска и ежемесячного контроля (технические проверки, контент, ссылки) — пригодится материал /blog/seo-checklist.

Если вы параллельно строите сам продукт (каталог/агрегатор/справочник) и хотите быстрее проверять гипотезы по шаблонам, структуре и индексации, удобно держать процесс в «плановом режиме» с быстрыми откатами. В TakProsto.AI это решается через planning mode и снапшоты/rollback: вы можете быстро выпускать партии страниц, сравнивать метрики и возвращаться к стабильной версии без долгих циклов разработки. Дополнительно у платформы есть программа начисления кредитов за контент и реферальные приглашения — это может частично компенсировать эксперименты на старте.

Programmatic SEO — это подход, при котором вы проектируете шаблон страницы и автоматически создаёте много посадочных под разные параметры (город, модель, категория, атрибуты), подставляя данные из таблиц/БД/API.

Ключевое условие: каждая страница должна давать конкретный ответ по своему запросу (цифры, варианты, ограничения), а не быть «копией» с заменой одного слова.

Подход оправдан, когда есть повторяющийся спрос и структурированные данные:

Если ценность держится на экспертном тексте, кейсах и уникальном исследовании, чаще лучше сделать меньше страниц вручную.

Основные риски:

Профилактика — пороги публикации (минимум данных/спроса), жёсткие правила индексации фильтров и регулярная чистка неэффективных URL.

Сначала сформулируйте сценарии пользователя (выбрать, сравнить, узнать цену, найти рядом) и проверьте выдачу: если по похожим запросам ранжируются каталоги/справочники, шанс выше.

Дальше определите «сущности», из которых будут собираться страницы:

Не генерируйте страницы для сущностей, которые не подтверждаются данными.

Соберите запросы из Search Console/Яндекс.Вебмастера, Wordstat и SEO‑инструментов, затем сгруппируйте по смыслу.

Кластер подходит под шаблон, если:

Зафиксируйте матрицу «кластер → тип страницы», чтобы не плодить лишние URL и не смешивать интенты.

Минимальный практичный набор полей:

Если обязательных полей нет, страницу лучше не публиковать (держать в черновиках до уточнения).

Зафиксируйте единые правила до генерации:

Индексируйте только выбранные комбинации, а остальное закрывайте через meta robots/canonical и не создавайте лишние ссылки на редкие сочетания.

Чтобы страница не выглядела как «заготовка», кроме подстановок должны меняться смысловые элементы:

Полезный минимум: H1 + интро, основной блок данных, короткая интерпретация, FAQ, источники и дата обновления.

Базовые правила:

sitemap.xml включает только канонические индексируемые URL;Оценивайте не только рост трафика, но и качество:

Масштабируйтесь поэтапно: пилот 20–50 страниц → 100 → 1000+, параллельно добавляя алерты, отчёты и регулярную чистку «мусора».

noindexrel=canonical404/410 по ситуации, переезды — 301.Это помогает экономить краулинговый бюджет и быстрее индексировать важные страницы.