07 дек. 2025 г.·8 мин

Как создать сайт для матрицы сравнения техрешений

План создания сайта для матрицы сравнения техрешений: сценарии, структура данных, интерфейс, расчёты, совместная работа, экспорт и безопасность.

План создания сайта для матрицы сравнения техрешений: сценарии, структура данных, интерфейс, расчёты, совместная работа, экспорт и безопасность.

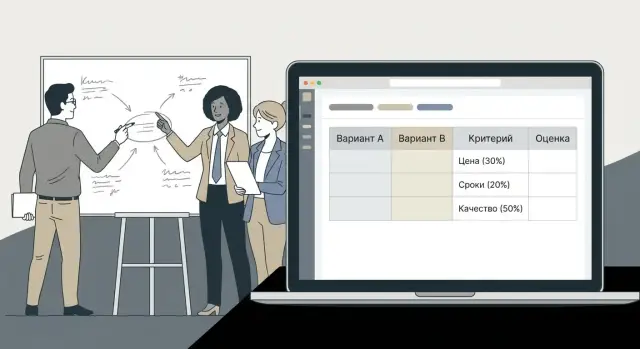

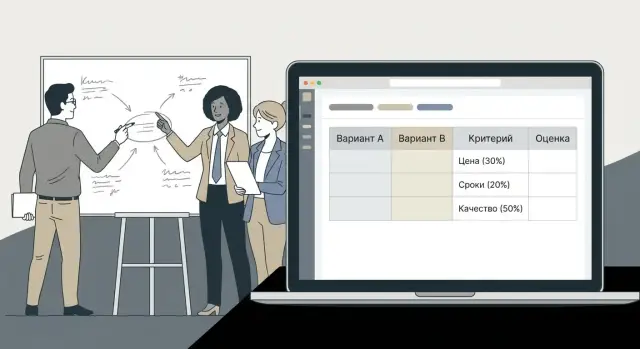

Матрица сравнения (или матрица решений) — это способ выбрать вариант не «по ощущениям», а по заранее согласованным критериям. Вы задаёте критерии (например, стоимость владения, сроки внедрения, риски, совместимость), назначаете им веса и выставляете оценки каждому варианту. В итоге видно, почему побеждает конкретное решение — и где именно оно сильнее или слабее.

Матрица решений хорошо работает в ситуациях, где вариантов больше двух, а аргументы у разных участников противоречат друг другу:

Сайт для сравнения решений нужен не для того, чтобы «заменить таблицу», а чтобы превратить разовый документ в управляемый, повторяемый процесс.

В таблицах быстро возникает хаос: копии файлов, разные версии оценок, неясно кто и когда менял веса, а итог сложно защитить перед руководством.

Сайт решает эти проблемы за счёт:

Обычно в процессе участвуют несколько ролей:

Главный эффект — прозрачность выбора: решение можно объяснить, повторить и проверить.

Дополнительно появляется повторяемость процесса: похожие сравнения делаются быстрее, а знания не теряются в переписках и «финал_v7_точно_финал.xlsx».

Чтобы матрица сравнения работала предсказуемо, сначала договоритесь, что именно хранит система и как это связано. Хорошая модель данных избавляет от хаоса в таблице, упрощает историю изменений и делает экспорт отчёта «в один клик».

Проект — верхний уровень, в котором живёт матрица и вся переписка вокруг неё. Минимальный набор полей:

Практично сразу заложить атрибуты управления: теги (например, «инфраструктура», «CRM»), подразделение, ссылку на внутренний документ.

Вариант — это продукт/подход/поставщик, который участвует в сравнении. Для каждого варианта удобно хранить:

Важно: вариант — сущность, а не «колонка». Тогда один и тот же вариант можно переиспользовать в разных проектах (с разными оценками).

Критерий описывает, что измеряем и как это вводится:

Частая ошибка — смешивать «стоимость» и «оценку стоимости» в одном поле. Лучше хранить исходное число (например, руб./год) и отдельно — нормализованную оценку.

Вес — это важность критерия (проценты или баллы). Шкала — правила перевода значения в оценку (1–5, 1–10 или пользовательская).

Оценку храните вместе с метаданными:

На уровне данных это обычно выглядит как связь: Проект → набор Критериев и Вариантов, а оценки — как отдельные записи «критерий × вариант», чтобы легко добавлять новые критерии и не ломать структуру.

Хороший сайт для матрицы сравнения держит пользователя «за руку»: от чистого листа до понятного вывода, не заставляя разбираться в методологии. Поток работы удобно спроектировать как последовательный мастер, но оставить возможность свободно перемещаться по шагам.

«Быстрый шаблон» — для типовых задач (выбор поставщика, сравнение облаков, оценка фреймворков). Пользователь выбирает шаблон, получает заранее подготовленные критерии и примерные веса, и сразу переходит к заполнению.

«Настраиваемая матрица» — когда критерии уникальны или нужна своя структура. Здесь старт пустой, но интерфейс подсказывает обязательные поля и рекомендуемый порядок.

Оптимальная последовательность:

Создать проект: название, команда/отдел, краткая цель (1–2 строки).

Добавить варианты: решения/поставщики/технологии. Важно сразу предусмотреть поле «ссылка/источник», чтобы потом было чем подтверждать оценки.

Добавить критерии: сгруппировать по категориям (стоимость, риск, безопасность, скорость внедрения), указать шкалу оценок и подсказку «как оценивать».

Задать веса: на уровне критериев (и при необходимости — групп). Рядом с ползунком/полем — быстрый индикатор, что сумма корректна.

Заполнить оценки: таблица с удобной навигацией по клавиатуре, автоподстановкой, комментариями и прикреплёнными источниками.

Автосохранение каждые несколько секунд и явный статус («Сохранено» / «Есть несохранённые изменения») снижает стресс.

Ошибки лучше делать не блокирующими: подсветить незаполненные обязательные поля, показать подсказку «что именно нужно», но не выкидывать пользователя из контекста.

Импорт полезен в начале: загрузить список вариантов и критериев, а затем «дочистить» в интерфейсе.

Ограничения стоит обозначить заранее: поддерживаемые форматы, максимальный размер файла, требования к заголовкам. После загрузки нужен экран валидации: что распознано, что пропущено, где дубликаты, какие значения вне допустимой шкалы — с возможностью исправить до применения.

Финальная точка потока — понятная сводка: что лидирует и за счёт каких критериев, чтобы решение можно было объяснить, а не просто «посчитать».

Матрица сравнения почти всегда превращается в «большую таблицу», где легко потеряться. Поэтому главный UX‑принцип простой: пользователь должен видеть структуру и быстро вносить оценки, не прокручивая страницу туда‑сюда и не открывая десятки модальных окон.

На первом экране держите ядро продукта — таблицу «варианты × критерии» с закреплением строки заголовков и первого столбца. Так пользователь всегда видит, какой вариант он оценивает и по какому критерию, даже на длинных матрицах.

Полезно добавить компактную строку итогов: суммарный балл по варианту, покрытие (сколько критериев заполнено) и индикатор «требует внимания» (например, есть нулевые/пропущенные оценки по важным критериям).

Чтобы не перегружать таблицу текстом, подробности уводите в боковую панель: описание критерия, правила выставления оценки, источник данных/ссылка на документ, а также комментарии и допущения. При клике по заголовку критерия или по ячейке открывайте панель в контексте — это снижает число ошибок и ускоряет работу.

Оценка должна редактироваться прямо в ячейке. Поддержите горячие клавиши: стрелки для перемещения, Enter для ввода, Ctrl/Cmd+C/V для копирования, и массовое заполнение (протянуть значение, вставить блок, применить «как у варианта X»). Для командной работы важно явно показывать «кто редактирует» и аккуратно обрабатывать конфликты.

Дайте сортировку по итоговому баллу, по группе критериев и по владельцу оценок. Фильтры должны быть видимыми (чипы над таблицей) и объяснимыми: пользователь должен понимать, почему строки/столбцы скрыты.

Ставьте контрастные состояния фокуса, обеспечьте полноценную навигацию с клавиатуры и понятные подписи (не только цвет). Ошибки ввода (например, диапазон 1–5) показывайте рядом с ячейкой и дублируйте текстом в подсказке, чтобы таблица оставалась удобной для всех.

Чтобы матрица сравнения не превращалась в «таблицу мнений», правила расчёта должны быть однозначными: как приводятся разные шкалы к общему виду, как учитываются веса и что делать с критериями «обязательного прохождения».

На практике чаще всего используют взвешенную сумму: каждый критерий переводится в нормализованный балл (например, 0…1), умножается на вес, затем всё суммируется.

score(variant) = Σ ( weight_i * normalized_i )

Важно закрепить два правила:

как задаются веса (например, сумма весов = 1 или 100%),

как именно считается normalized_i, чтобы разные шкалы (рубли, миллисекунды, «1–5») были сопоставимы.

Для критериев «чем больше — тем лучше» (например, производительность, надёжность) можно использовать линейную нормализацию:

normalized = (x - min) / (max - min)

Для критериев «чем меньше — тем лучше» (стоимость, задержка, время внедрения) — инверсию:

normalized = (max - x) / (max - min)

Если max = min (все значения одинаковы), система должна явно фиксировать поведение: например, считать нормализованный балл = 1 для всех или = 0 (но одинаково для всех вариантов) и пометить критерий как «не влияющий на итог».

Пропуски в оценках неизбежны, и лучше заранее выбрать один из режимов на уровне проекта или критерия:

Для требований «обязательное условие» (например, сертификат, совместимость, лимит бюджета) добавьте пороги:

Пользователь должен понимать, откуда взялся итоговый балл: показывайте «вклад» критериев по клику на результат (вес, нормализованное значение, исходное значение). Параллельно ведите журнал изменений: кто поменял вес, шкалу, порог или оценку — с датой и причиной. Это повышает доверие к матрице и упрощает согласование.

Таблица хороша для ввода данных, но решение чаще принимают «глазами». Визуализация нужна не ради красоты, а чтобы за минуту ответить на три вопроса: кто лидирует, почему лидирует и что изменится, если приоритеты сдвинутся.

Сделайте минимум два вида графиков рядом с матрицей:

Важно: показывайте не только «итог», но и почему он получился. Тогда спор переходит от эмоций к фактам.

Добавьте переключатель «что если» с быстрым изменением весов (ползунки или ввод процента). При каждом изменении пересчитывайте рейтинг и подсвечивайте:

Хороший UX‑приём: кнопка «Сбросить к базовым весам» и возможность сохранить сценарий как отдельную версию (это пригодится в /blog/совместная-работа-история-изменений).

Анализ чувствительности показывает, при каком изменении весов лидер может смениться. В интерфейсе это можно подать без сложной математики:

Добавляйте краткие подсказки прямо в контекст: «Этот критерий даёт 28% итогового балла, потому что его вес высокий и оценки вариантов сильно отличаются». Так пользователь понимает выводы, даже если не хочет разбираться в формулах.

Матрица сравнения почти всегда заполняется командой: архитектор приносит требования, закупки — данные по поставщикам, безопасность — ограничения, руководитель — приоритеты. Поэтому сайт должен поддерживать совместную работу так, чтобы никто не боялся «сломать» чужие расчёты и всегда можно было объяснить, откуда взялась цифра.

Начните с простой, понятной модели:

Важно разделить права не только «по проекту», но и по чувствительным зонам: например, веса критериев меняет ограниченный круг, а оценки по вариантам может вносить широкий состав.

Табличный интерфейс провоцирует одновременное редактирование. Чтобы избежать потерь:

Комментарии должны жить рядом с данными:

Полезна подписка на изменения: участник получает уведомление, когда кто-то ответил в обсуждении конкретного критерия или варианта.

Для доверия к результату нужны не «черновики в чате», а прозрачный журнал:

Такой аудит снижает число споров: любое решение можно восстановить и аргументировать фактами.

Руководству обычно не нужна вся «кухня» расчётов — нужен понятный вывод, почему выбрали именно так, и что может пойти не так. Поэтому отчёт лучше строить как один компактный итоговый экран, который можно показать на встрече и отправить письмом без дополнительных пояснений.

Сделайте отдельную страницу‑резюме с чёткой структурой:

Эта страница — «витрина». Детали должны быть доступны по раскрытию или ссылке внутрь проекта, но не перегружать первое впечатление.

Экспорт стоит разделить по задачам:

Полезен готовый шаблон, который автоматически заполняется из проекта: что сравнивали, по каким критериям, кто участвовал, какие были версии и когда принято решение. Такой протокол упрощает согласование и снижает риск споров «почему мы выбрали это» через месяц.

Публичный доступ включайте только вручную и с ограничениями: срок действия, пароль/одноразовый токен, запрет индексации, возможность открыть только итог без редактирования. По умолчанию всё должно оставаться приватным.

Шаблоны снимают самый частый барьер: «с чего начать критерии и шкалы». Вместо пустой таблицы пользователь выбирает тип решения — например, облако, база данных, подрядчик/аутсорс, инструмент аналитики — и получает стартовый набор критериев, весов и подсказок. Это ускоряет запуск проекта и делает сравнение более сопоставимым между командами.

Хорошая библиотека — это не просто список пунктов, а структурированные «пакеты»:

Шаблон должен быть редактируемым: команда может добавлять критерии, убирать лишнее, менять веса — но исходник остаётся доступным для повторного использования.

Сразу разбивайте критерии на группы — так оценщикам проще ориентироваться и не пропускать важное:

Группы удобно сворачивать/разворачивать и показывать промежуточные итоги по каждой группе.

Даже идеальный шаблон ломается, если люди по‑разному понимают «5 из 5». Сделайте встроенный словарь терминов и короткие подсказки к каждому критерию: что означает шкала, какие источники данных допустимы (бенчмарки, договор, пилот), и примеры для крайних значений.

Часто проще не начинать с шаблона, а клонировать прошлый проект: сохраняются варианты, критерии, веса, словарь и структура групп. При создании копии дайте опции: сбросить оценки, обновить список вариантов, пометить устаревшие критерии. Так матрицы становятся «живыми», а качество сравнения растёт от проекта к проекту.

Минимальная версия сайта должна решать одну задачу: быстро и прозрачно сравнить варианты и получить итог, который можно показать руководству.

В MVP обычно достаточно:

Такой набор закрывает 80% повседневных сценариев и помогает проверить, «заходит» ли продукт командам.

Думайте не про названия инструментов, а про свойства:

Для MVP полезно держать архитектуру простой: один сервис + база + хранилище файлов (для экспортов). Микросервисы лучше отложить.

Если вы планируете быстро собрать рабочий прототип и проверить UX на живых пользователях, это удобно делать на TakProsto.AI: платформа позволяет через чат описать сущности (проекты/критерии/оценки), роли, расчёты и экраны, а затем получить приложение со стандартным стеком (React на фронтенде, Go + PostgreSQL на бэкенде) и возможностью деплоя, снапшотов и отката.

Даже если интерфейс выглядит «как обычная таблица», внутри это набор строгих правил. На уровне API заранее задайте схемы и ограничения:

Ошибки возвращайте понятными: что именно неверно и как исправить, а не просто «400».

Фокус тестов для такого продукта:

Логичные следующие шаги:

Главное — развивать продукт вокруг доверия к цифрам: чтобы любой итог можно было объяснить и воспроизвести.

Матрица сравнения техрешений почти всегда содержит чувствительную информацию: бюджеты, требования, комментарии по поставщикам, внутренние риски. Если безопасность «прирастает» позже, это обычно заканчивается компромиссами в архитектуре и сложными миграциями. Лучше заложить базовые принципы сразу.

Сделайте понятную модель ролей и доступов: владелец рабочего пространства, редактор, наблюдатель. По умолчанию — доступ «только чтение», а права на редактирование критериев, весов и итоговых выводов выдаются явно.

Практичные меры, которые быстро повышают доверие:

Обязательный минимум: шифрование при передаче (TLS) и продуманное хранение секретов (ключи, токены, строки подключения) вне кода и репозитория.

Дальше — операционная надёжность:

Пользователям важно понимать «кто и что изменил» в матрице. Сделайте аудит действий (создание/изменение критериев, весов, оценок, экспорт), но не превращайте логи в хранилище персональных данных: минимизируйте содержимое, задайте сроки хранения, ограничьте доступ.

Добавьте функции экспорта и удаления в интерфейс проекта: выгрузка отчёта, архив проекта, удаление по запросу, удаление рабочего пространства. Это снижает барьеры покупки и ускоряет согласование с безопасностью заказчика. Отдельную страницу с обещаниями и конкретикой разместите на /security, а условия и планы — на /pricing.

Для вводного объяснения самой методики можно вести пользователей на /blog/decision-matrix.

Матрица решений помогает выбрать вариант по заранее согласованным критериям, а не «по ощущениям». Вы задаёте критерии, назначаете им веса, выставляете оценки вариантам и получаете итоговый рейтинг с объяснимой логикой.

Когда вариантов больше двух и у участников разные приоритеты: выбор технологии/стека, сравнение поставщиков, выбор архитектуры (on‑prem vs облако), приоритизация инициатив. Ещё полезна, если результат нужно защищать перед руководством и аудитом.

Сайт превращает разовый файл в управляемый процесс:

Базовая модель обычно такая:

Так проще добавлять новые критерии и вести аудит.

Разделяйте факты и итоговые баллы:

Это делает расчёты проверяемыми и повторяемыми.

Заранее выберите режим на уровне проекта или критерия:

Главное — чтобы правило было видно и одинаково применялось ко всем вариантам.

Для must-have критериев добавьте пороги/правила прохождения:

Минимально полезный набор:

Остальное (интеграции, расширенная аналитика, сложные сценарии) лучше добавлять после проверки, что продукт реально используется.

Критично предусмотреть:

Это снижает споры и помогает объяснять итог по фактам.

Минимальные меры:

Полезно вынести детали политики на /security, а правила доступа и тарифы — на /pricing.