08 сент. 2025 г.·8 мин

Как создать веб‑приложение для контроля соблюдения SLA

Пошаговый план веб‑приложения для контроля соблюдения SLA: метрики, модель данных, расчёты, алерты, отчёты, интеграции и безопасный запуск.

Цели и терминология: SLA, SLO и SLI

Система контроля SLA нужна не «для мониторинга ради мониторинга», а чтобы договорённости с клиентом были измеримыми и проверяемыми. Когда правила и цифры зафиксированы, спорные ситуации решаются быстрее, а команды понимают, что именно считается успехом, а что — нарушением.

Простыми словами: SLA, SLO и SLI

SLA (Service Level Agreement) — это обещание клиенту в договоре: какие показатели вы гарантируете (например, доступность 99,9% в месяц), как их считаете и что происходит при нарушении (компенсации, штрафы, сервисные кредиты).

SLO (Service Level Objective) — внутренняя цель команды, обычно строже SLA. Например, при SLA 99,9% команда может держать SLO 99,95%, чтобы оставался «запас» на непредвиденные сбои.

SLI (Service Level Indicator) — конкретная измеряемая метрика, из которой строятся SLO/SLA: доступность, доля успешных запросов, процент ответов быстрее 300 мс, время решения инцидентов и т. п.

Важно: SLA — это не просто «аптайм». Он может включать время реакции поддержки, сроки восстановления, окна обслуживания, исключения и правила округления.

Кто использует контроль SLA

- Поддержка — видит, где «горит» и какие тикеты/инциденты влияют на обязательства.

- Продукт и инженерия — понимают, какие улучшения реально повышают качество сервиса и снижают риск нарушений.

- Продажи и аккаунт‑менеджеры — заранее видят риски, объясняют клиенту цифры и готовят отчёты.

Типовые риски, которые снижает трекер SLA

Нарушение SLA часто означает прямые потери (штрафы, компенсации) и косвенные (эскалации, потеря доверия, заморозка сделок). Отдельный риск — «разные калькуляторы» в командах, когда каждый считает по‑своему и данные расходятся.

Какие вопросы должен закрывать трекер SLA

Хорошее приложение отвечает на практичные вопросы: какое SLA у конкретного клиента и сервиса, сколько «бюджета ошибок» осталось до конца периода, какие события ухудшили показатель, где первопричина и что нужно сделать, чтобы избежать нарушения (и кто за это отвечает).

Определяем требования и правила расчёта SLA

Прежде чем строить веб‑приложение для контроля SLA, важно договориться, что именно считается «соблюдением», а что — нарушением. Ошибки на этом этапе приводят к спорным отчётам: одна команда уверена, что «всё ок», другая уже видит штрафы.

Что именно покрывает SLA

Сначала зафиксируйте границы услуги: какой сервис/часть продукта оценивается и в каких условиях.

- Объект SLA: веб‑сервис целиком, конкретное API, мобильный backend, платёжный модуль.

- Компоненты: например, «API авторизации» отдельно от «поиска».

- География и окружение: регионы, зоны доступности, prod/песочница.

- Точка измерения: «снаружи» (как видит клиент) или «изнутри» (между микросервисами).

Чем точнее описаны границы, тем легче потом связывать метрики с реальными пользовательскими ожиданиями.

Какие метрики фиксировать

Типовой набор для SLA‑контроля:

- Доступность: доля успешных запросов или время «сервис доступен».

- Время ответа: чаще всего p95/p99, а не среднее (среднее скрывает пики).

- Время решения инцидента: от момента обнаружения до восстановления (MTTR) или до закрытия по регламенту.

Сразу зафиксируйте формулу: что считается «успешным запросом», какие коды/ошибки включаются, какой порог по времени ответа считается нарушением.

Окна измерения и часовые пояса

Укажите период, в котором считается SLA: 5 минут, час, день, месяц — и как агрегируются данные.

Важно явно прописать:

- календарный месяц или скользящие 30 дней;

- таймзона отчёта (например, MSK или UTC);

- что делать с неполными интервалами (первые/последние 5 минут месяца).

Исключения и спорные случаи

В правилах должны быть описаны исключения, иначе отчётность будет конфликтной:

- плановые работы (как объявляются и где фиксируются);

- форс‑мажор (кто и как подтверждает);

- периоды деградации: учитываем ли частичную недоступность, «серые» таймауты, снижение качества.

Сразу определите, как исключения вычитаются: из общего времени периода или из количества измерений.

Как записать правила простым языком в ТЗ

Хороший формат — короткие формулировки, которые можно превратить в тесты:

«Доступность API /auth считается за календарный месяц по таймзоне MSK. Запрос считается успешным при HTTP 2xx/3xx. Интервал 5 минут считается недоступным, если доля успешных запросов ниже 99% или p95 времени ответа выше 800 мс. Плановые работы исключаются при наличии зарегистрированного окна обслуживания в системе и уведомления не позднее чем за 24 часа.»

Такие правила легко перенести в движок расчёта и объяснить заказчикам без “технического перевода”.

Пользовательские сценарии и MVP-функционал

Прежде чем рисовать экраны и выбирать технологии, зафиксируйте, кто именно будет пользоваться приложением контроля SLA и какие решения они принимают на основе данных. Это сразу задаёт структуру MVP: минимум функций, который закрывает ключевые вопросы без «зоопарка» настроек.

Кто пользователи и что им важно

Обычно в продукте встречаются три группы:

- Менеджеры сервиса/аккаунта: быстро понять, выполнен ли SLA, где риски, чем объяснить отклонения клиенту.

- Инженеры/дежурные: найти первопричину нарушений, увидеть таймлайн событий и подтверждённые метрики.

- Руководители: агрегированная картина по сервисам и командам, тренды, прогноз “успеем/не успеем” по текущему периоду.

У каждой группы свой уровень детализации, поэтому MVP должен уметь «масштабироваться по глубине»: от общего статуса к конкретному инциденту и исходным данным.

Основные сценарии (то, ради чего открывают приложение)

-

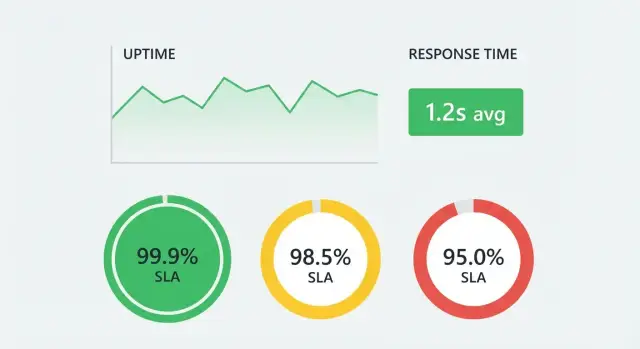

Просмотр статуса SLA/SLO за период: текущий процент, оставшийся бюджет ошибок, сервисы в риске.

-

Разбор нарушения: что именно просело (доступность, время ответа), когда началось, как долго длилось, какие инциденты связаны.

-

Экспорт отчёта: PDF/CSV или ссылка на отчёт для клиента и внутреннего контроля.

Набор экранов MVP

Минимальный набор, который покрывает сценарии без лишней сложности:

- Дашборд: карточки сервисов, статус, бюджет ошибок, фильтры по периоду/клиенту.

- Инциденты/нарушения: список, поиск, таймлайн, вклад в потери по SLA.

- Конфигурации: сервисы, правила SLA, календарь (окна обслуживания), источники метрик.

- Отчёты: шаблон отчёта, выгрузки, история отправок.

Роли и права доступа (минимально необходимое)

На старте достаточно трёх ролей: Viewer (только просмотр), Operator (просмотр + разбор инцидентов/комментарии), Admin (настройки SLA, источники, доступы). Важно отделить право “видеть данные клиента” от права “менять правила расчёта”.

Нефункциональные требования для MVP

MVP должен быть быстрым в ежедневном использовании: загрузка дашборда за секунды, предсказуемые фильтры, кэширование агрегатов. Также заранее заложите доступность самого приложения (иначе контроль SLA теряет смысл) и аудит: кто менял конфигурации и когда, чтобы любые расхождения в отчётах можно было объяснить.

Практический вариант ускорить старт — собрать MVP в режиме «vibe‑coding» на TakProsto.AI: вы описываете экраны, роли, формулы и интеграции в чате, а платформа помогает быстро получить основу (React на фронте, Go + PostgreSQL на бэкенде) и затем доработать логику расчётов под ваше ТЗ.

Источники данных и сбор метрик

Чтобы контролировать SLA, важно не «рисовать» показатели вручную, а выстроить надёжный поток событий из нескольких источников. Практика показывает: чем раньше вы нормализуете данные в единый формат, тем проще считать доступность, время ответа и исключения.

Откуда брать данные

Основные источники обычно такие:

- Мониторинг (синтетические проверки и метрики инфраструктуры): даёт факты down/up, коды ответов, latency, таймауты.

- Логи приложений и прокси: помогают уточнить процент ошибок, детали по endpoint’ам и всплески задержек.

- Трассировка (distributed tracing): удобна, когда SLA зависит от цепочки сервисов и нужно понимать, где возникает деградация.

- Тикетинг/ITSM: фиксирует жизненный цикл инцидента — когда завели, подтверждён ли, когда сняли.

- Ручные отметки: полезны для исключений (плановые работы, спорные кейсы), но их нужно строго ограничивать правами и аудитом.

Какие события собирать

Минимальный набор событий, который покрывает большинство SLA:

- Состояние доступности:

up/down(с указанием причины, если известна). - Ошибки: HTTP 5xx/4xx, исключения, таймауты, отказ зависимого сервиса.

- Задержки: значения latency (лучше — распределение или p95/p99 по интервалу).

- Инциденты: смена статуса (создан, подтверждён, в работе, решён), привязка к сервису/компоненту.

Важно заранее решить, что является «нарушением» для конкретного SLO: например, недоступность по синтетической проверке, или превышение p95, или доля ошибок выше порога.

Периодичность: стриминг vs пакетная загрузка

- Стриминг (почти реальное время) нужен, если вы хотите быстро алертить и видеть текущий риск нарушения SLA.

- Пакетная загрузка (раз в 5–60 минут/раз в сутки) проще и дешевле; подходит для отчётности, если SLA считается постфактум.

Часто используют гибрид: инциденты и down/up — стримингом, тяжёлые агрегаты по latency — пакетно.

Единый формат события и обязательные поля

Даже если источники разные, внутренний «канонический» формат стоит сделать единым. Рекомендуемые поля:

event_id(для дедупликации)timestamp(в UTC) и при необходимостиobserved_atservice_id/component_id/environment(prod/stage)event_type(availability, error, latency, incident_status)value(например,down, код ошибки, миллисекунды)source(мониторинг/логи/тикетинг)correlation_idилиincident_id(если есть)

Контроль качества данных

Данные почти всегда «грязные», поэтому предусмотрите проверки:

- Пропуски: что делать, если нет событий (считать как unknown, а не up).

- Дубликаты: одинаковые события от ретраев или нескольких агентов.

- Рассинхрон времени: разные часовые пояса, дрейф часов, задержки доставки.

Эти правила лучше заложить на этапе приёма событий: тогда расчёт SLA будет стабильным, а споры по отчётности — реже.

Модель данных: что хранить и как связывать

Правильная модель данных — основа доверия к отчётам по SLA. Если хранить «всё в одной таблице», быстро появятся споры: почему цифры изменились задним числом, откуда взялись пропуски, как повторить расчёт за прошлый месяц.

Ключевые сущности

На минимальном уровне удобно разделить данные на несколько доменных объектов:

- Сервис — то, для чего измеряется SLA (например, «Платежи»).

- Компонент (опционально) — часть сервиса, чтобы детализировать причины (API, база, очередь).

- SLA‑политика — набор правил: какие метрики считаем, какие пороги и окно расчёта.

- Метрика — что измеряем (доступность, время ответа, доля ошибок).

- Измерение — конкретное значение метрики в момент времени.

- Инцидент — событие, влияющее на SLA (простои, деградации), с временем начала/окончания и причиной.

- Отчёт — зафиксированный результат расчёта за период.

Сырые события отдельно от агрегатов

Практика, которая экономит нервы: хранить сырые события (логи проверок, пинги, трассировки, результаты синтетических тестов) отдельно от агрегатов (почасовые/дневные итоги). Сырые данные нужны для разборов и пересчётов, агрегаты — для быстрых дашбордов и API.

Агрегации по окнам и разрезам

Заранее заложите агрегирование по окнам день/неделя/месяц и по разрезам сервис → компонент → метрика. Тогда вы сможете ответить на вопросы «где просели» без тяжёлых запросов к первичным событиям.

Версионирование правил SLA

Правила меняются: исключили плановые работы, поменяли порог времени ответа, добавили новый компонент. Чтобы отчёты не «переехали», привязывайте расчёты к версии политики:

sla_policy(id, service_id, version, valid_from, valid_to, rules_json)

report(id, service_id, period_start, period_end, policy_id, computed_at)

Отчёт всегда ссылается на конкретный policy_id (и версию), а не на «текущие настройки».

Идентификаторы и связи сервисов

Определите единый service_key (стабильный строковый идентификатор), а также схему связей:

service1→Ncomponentservice/component1→Nmetricmetric1→Nmeasurement_rawи 1→Nmeasurement_aggincidentсвязывается сservice_idи при необходимости сcomponent_id

Так вы получите трассируемость: от числа в отчёте — к агрегату — к исходным событиям и инцидентам.

Движок расчётов и бизнес-логика SLA

Данные остаются внутри страны

Запускайте проекты на серверах в России с локализованными open source LLM моделями.

Движок расчётов — это «сердце» системы контроля SLA: он превращает сырые события (метрики, логи, инциденты) в юридически и операционно значимые показатели. Важно сразу зафиксировать: для каждого показателя должна существовать однозначная формула, окно агрегации и правила обработки исключений.

Основные алгоритмы расчёта

Доступность (availability) обычно считается как доля времени (или интервалов), когда сервис был «в апе»:

- по времени:

uptime / (total_time - excluded_time) - по интервалам (например, минута):

ok_intervals / (total_intervals - excluded_intervals)

Процент успешных запросов — доля запросов с успешными статусами (например, 2xx/3xx) от всех, с возможностью исключить «шум» (health-check, тестовые ручки): success / (total - excluded).

Перцентили времени ответа (p95/p99) лучше считать по агрегированным гистограммам или t-digest, а не «сырым» значениям, чтобы выдерживать нагрузку. Обязательно закрепите, какие перцентили входят в SLA и какое окно: 5 минут, час, сутки.

Исключения и «заморозки»

Maintenance windows и согласованные исключения должны вычитаться из знаменателя, но только если они корректно оформлены: период, затронутые сервисы/эндпоинты, тип исключения. Практика: хранить исключения как интервалы времени и при расчёте делать «вычитание интервалов» (merge/clip), чтобы не было двойного вычитания при пересечениях.

Округления и пограничные случаи

Заранее задайте правила:

- на каком шаге округлять (в конце расчёта, а не на промежуточных стадиях);

- что делать при

total=0(например, «нет данных», а не 100%); - как трактовать «частичную деградацию» (таймауты/ошибки против повышенной задержки).

«Время до ответа/решения» по инцидентам

Для инцидентов важно формализовать точки времени:

- TTFR (time to first response): от момента открытия/детекта до первого «принятого» комментария/статуса;

- TTR (time to resolve): до перевода в «решён» с проверкой, что не было повторного открытия.

Учитывайте рабочие часы (если SLA на рабочее время) и исключайте паузы ожидания клиента/вендора как отдельные статусы, иначе метрика будет конфликтовать с реальностью.

Проверка формул

Перед запуском заведите наборы тестовых данных: 1) идеальный день без сбоев, 2) один инцидент на 17 минут, 3) сбой, попавший в maintenance window, 4) пересекающиеся исключения. Для каждого набора — ожидаемый результат и автотесты, чтобы любое изменение логики сразу было заметно.

Интерфейс: дашборды, детализация и отчёты

Хороший интерфейс для контроля SLA отвечает на три вопроса: «что происходит сейчас», «почему это случилось» и «что показать клиенту/руководителю». Поэтому полезно разделить UI на обзорный дашборд, карточки сервисов и детальный разбор нарушений.

Дашборд: статус, тренды и прогноз

На главном экране покажите текущий статус по всем сервисам: выполнение/риск/нарушение, актуальные значения доступности и времени ответа, а также «ошибочный бюджет» (сколько ещё можно «потратить» до конца периода).

Добавьте тренды за выбранный период и простой прогноз до конца расчётного окна: если темп деградации сохранится, выполнится ли SLA. Прогноз можно визуально делать как «линия факта + коридор до конца месяца», чтобы не перегружать пользователя формулами.

Страница сервиса: цели, факт и история нарушений

Карточка сервиса (например, /services/{id}) должна содержать:

- цели SLA/SLO и правила расчёта (что входит/не входит в простой);

- фактические значения по периоду и по подокнам (день/неделя);

- историю нарушений с быстрыми ссылками на разбор.

Важно показывать не только проценты, но и «время» (минуты простоя, медиана/95-й перцентиль времени ответа), чтобы метрики были понятны бизнесу.

Разбор нарушения: таймлайн и контекст

В детальном разборе сделайте временную шкалу: начало/конец инцидента, изменения статуса, всплески ошибок и задержек. Рядом — первичные метрики (ошибки, латентность, насыщение ресурсов) и комментарии/постмортем: кто подтвердил, причина, меры, ссылка на тикет.

Фильтры, сравнение периодов и экспорт

Дайте фильтры по сервисам, регионам, типу SLI и причинам, а также сравнение периодов (например, «этот месяц vs прошлый»).

Для отчётности добавьте экспорт CSV/PDF и стабильные ссылки на /reports и /services/{id}, чтобы отчёты можно было прикладывать в письма и регламенты без ручных скриншотов.

Алерты и эскалации: как не пропустить нарушение

Интеграции для метрик и инцидентов

Подключите мониторинг и тикетинг через API и сведите события к единому формату.

Даже идеальные дашборды бесполезны, если о проблеме узнают слишком поздно. Система алертов должна не просто «шуметь», а вовремя подсказывать, что сервис приближается к границе SLA, фиксировать факт нарушения и подтверждать восстановление.

Типы уведомлений: от риска до восстановления

Практично выделить три базовых события:

- Предупреждение о риске: бюджет ошибок быстро расходуется, растёт время ответа, увеличивается доля недоступности — ещё не нарушение, но уже сигнал действовать.

- Факт нарушения: SLA/SLO пересечён по правилам расчёта, важно зафиксировать момент и затронутые измерения (регион, клиент, метод API).

- Восстановление: метрика вернулась в норму, можно закрывать инцидент и прекращать эскалации.

Каналы доставки и формат сообщения

Поддержите несколько каналов: email, webhooks и корпоративные мессенджеры (без привязки к конкретным брендам). Сообщение должно быть коротким и прикладным: что случилось, насколько критично, когда началось, ссылка на карточку события и следующий шаг (например, /incidents и /reports/sla).

Пороги, частота и защита от «шторма»

Настройки нужны на уровне сервиса и показателя: пороги, окна агрегации, «тихий период» и дедупликация. Добавьте гистерезис (разные пороги для срабатывания и снятия) и rate limit на повторные уведомления, чтобы один затянувшийся сбой не породил сотни сообщений.

Эскалации по времени и критичности

Эскалации должны зависеть от критичности сервиса и расписания дежурств: сначала команда продукта/поддержки, затем инженерная смена, затем руководитель направления. Полезно учитывать «время до нарушения» и усиливать уровень, если риск становится неизбежным.

Журнал уведомлений для аудита

Храните журнал: кто и куда отправил, содержимое, статус доставки, подтверждение получения, корреляция с инцидентом. Это ускоряет разбор причин и помогает доказательно обсуждать выполнение SLA с заказчиком.

Интеграции и API для экосистемы

Даже самое удобное веб‑приложение для контроля SLA не будет работать в вакууме: данные о доступности сервиса, инцидентах и изменениях конфигурации уже живут в других системах. Поэтому интеграции и API нужно проектировать как «первый класс» продукта — чтобы подключение новых источников занимало часы, а не недели.

Интеграции с мониторингом и тикетингом через API

Минимальный набор интеграций обычно включает два потока:

- Мониторинг: метрики доступности сервиса, время ответа, статусы проверок, события деградаций.

- Тикетинг/инциденты: создание и обновление заявок, смена статусов, привязка к сервису и компоненту, отметки о причинах (плановые работы vs аварии).

Практика: вместо «толстых» адаптеров под каждую систему сделайте единый слой коннекторов с нормализацией данных (например, service_id, started_at, ended_at, impact, source). Так отчётность по SLA и расчёты не зависят от вендора.

Webhook‑подписки на события инцидентов

Пуллинг API удобен на старте, но для оперативности лучше поддержать вебхуки:

incident.created,incident.updated,incident.closedmaintenance.started,maintenance.ended

Важно предусмотреть повторную доставку, подпись запросов (HMAC), идемпотентность (ключ события) и журнал обработки. Это снижает риск «пропустить нарушение» из‑за сетевых сбоев.

Импорт/экспорт конфигураций SLA

Для масштабирования нужны шаблоны и массовые изменения:

- экспорт SLA/SLO (JSON/YAML) для ревью и версионирования

- импорт для развёртывания одинаковых правил на десятки сервисов

- «dry-run» проверка: что изменится в расчёте и отчётах

Это особенно полезно, когда меняются цели по SLO и SLA, окна измерений или правила исключений.

Единый справочник сервисов (Service Catalog)

Service Catalog — «скелет» связей: сервис → команда → компоненты → критичность → контакты. Он помогает:

- унифицировать названия сервисов между системами

- связывать метрики мониторинга, инциденты и отчётность по SLA

- ускорять онбординг новых сервисов

Документация API и примеры запросов

Документация должна быть практичной: схемы, коды ошибок, примеры, и отдельный раздел «как получить отчётность по SLA».

curl -X GET \

'/api/v1/sla/reports?service_id=svc_123\u0026period=2025-12' \

-H 'Authorization: Bearer \u003ctoken\u003e'

Хороший ориентир — публиковать OpenAPI-спецификацию и поддерживать примеры интеграций в разделе /docs/api.

Безопасность, доступы и аудит

Система контроля SLA почти всегда содержит чувствительные данные: имена клиентов и сервисов, внутренние метрики доступности и времени ответа, ссылки на инциденты, токены интеграций. Поэтому безопасность лучше заложить в архитектуру сразу, а не «докрутить» после пилота.

Аутентификация: SSO и логин/пароль

Для корпоративных установок базовый вариант — SSO (SAML/OIDC) с привязкой пользователя к организации и командам. Для небольших команд оставьте логин/пароль как запасной сценарий: обязательный 2FA, политика сложности пароля, лимиты на попытки входа и защита от перебора.

Практика: храните идентификатор пользователя из провайдера SSO и историю связок аккаунтов, чтобы корректно переживать смену e-mail.

Авторизация по ролям (RBAC)

Разделите права минимум на три уровня:

- Просмотр: чтение дашбордов и отчётов, доступ к детализации нарушений.

- Настройка: создание/редактирование SLA, SLO, расписаний, исключений, правил расчёта.

- Администрирование: управление пользователями, ролями, интеграциями, политиками хранения.

Важно, чтобы права проверялись на уровне API, а не только в интерфейсе. Для крупных компаний полезны «проектные» или «клиентские» области (tenant boundaries), чтобы исключить случайный доступ к чужим данным.

Секреты, ключи API и токены

Не храните секреты в открытом виде. Используйте KMS/Secret Manager или шифрование на уровне приложения с ротацией ключей. Токены интеграций делайте скоупированными (минимальные права) и сроком действия, поддержите ротацию без простоя.

Аудит действий и соответствие требованиям

Ведите неизменяемый аудит: кто и когда изменил SLA/порог, расписание, исключение, канал уведомлений. В лог пишите «до/после», инициатора (пользователь/сервис), IP/клиент, корреляционный идентификатор запроса.

Отдельно определите политику хранения: сроки ретенции метрик и аудита, маскирование персональных данных, доступ по принципу минимальных привилегий и регулярные ревизии ролей. Для прозрачности добавьте страницу журнала действий и экспорт в CSV/JSON (например, /audit-log).

Качество и запуск: тесты, наблюдаемость, деплой

Снизьте стоимость разработки

Получайте кредиты за контент о TakProsto или приглашайте коллег по реферальной ссылке.

Запуск системы контроля SLA — это не только «выложить в прод». Ошибка в формуле, неверная обработка таймзоны или задержка агрегаций может привести к неправильным штрафам и потере доверия. Поэтому качество здесь — часть продукта.

Тестируем формулы и пограничные условия

Начните с unit‑тестов для расчётов: окна доступности, исключения (maintenance), округления, правила «что считать инцидентом», работу с календарями и временными зонами. Особенно важны пограничные случаи: пустые периоды, пересекающиеся события, дубликаты, поздно пришедшие метрики.

Дальше добавьте интеграционные тесты: от записи сырых событий до итогового отчёта. Полезно хранить набор «эталонных» сценариев с заранее посчитанным ожидаемым SLA — это защитит от незаметных регрессий при изменении бизнес‑правил.

Нагрузочные проверки

Проверьте, выдерживает ли система ваш реальный поток: объём событий в час/день, скорость агрегаций, построение отчётов за месяц по десяткам сервисов. Важно измерить не только «может ли», но и «за сколько»: время ответа API, время пересчёта после дозагрузки данных, влияние параллельных пользователей.

Наблюдаемость приложения

Настройте метрики самого продукта: задержка обработки событий, длина очередей, время выполнения джобов пересчёта, ошибки импорта, доля «непривязанных» событий, P95/P99 времени ответа. Логи делайте структурированными и связывайте запросы по correlation/request id. Добавьте алерты на деградацию расчётов и рост ошибок — иначе SLA‑контроль будет «слепым».

План деплоя и надёжность данных

Разделите окружения dev/stage/prod и прогоняйте миграции БД сначала на stage с реалистичным объёмом данных. Миграции должны быть идемпотентными и по возможности без длительных блокировок.

Отдельно продумайте резервное копирование и восстановление: расписание бэкапов, проверку восстановления на тестовом контуре, RPO/RTO, хранение ключей и доступов. Для SLA‑системы потеря истории может быть критичнее кратковременного простоя.

Метрики успеха и план развития продукта

Чтобы продукт для контроля SLA приносил пользу, заранее договоритесь, как измеряете успех — не только по «красивым графикам», а по реальным изменениям в работе команд и клиентов.

Как оценить успех

Точность расчётов. Сведите результаты системы с эталонными расчётами (например, вручную по выгрузке инцидентов) на ограниченном периоде. Введите допустимую погрешность и сценарии, где расхождения критичны: окна исключений, пересечение инцидентов, разные часовые пояса.

Скорость отчётности. Измеряйте время от запроса до готового отчёта и время подготовки регулярного SLA‑пакета для клиента. Хороший ориентир — сделать так, чтобы отчёт формировался автоматически, а ручная работа сводилась к проверке комментариев.

Adoption (принятие пользователями). Отслеживайте: долю команд, которые используют дашборды еженедельно, долю клиентов, получающих отчёты из системы, количество решений, принятых на основе данных (например, пересмотр SLO или алертинга).

Бэклог улучшений

Следующий слой ценности — не просто фиксировать нарушения, а помогать предотвращать их:

- Прогнозирование риска нарушения SLA по трендам доступности и времени ответа.

- Сегментация по клиентам и тарифам: разные правила, разные окна обслуживания.

- Перцентили для времени ответа (p95/p99), чтобы отражать реальный пользовательский опыт.

Автоматизация постмортемов и связь с RCA

Сделайте шаблон постмортема, который автоматически подтягивает таймлайн инцидента, затронутые SLO, величину «потерь» SLA и ссылки на задачи. В идеале — связывать нарушение с причиной (RCA) и типом изменения (релиз, инфраструктура, внешняя зависимость).

Внедрение в процессы

Зафиксируйте регламент: кто подтверждает инциденты, кто закрывает периоды, кто подписывает отчёты, как обрабатываются спорные случаи. Назначьте ответственность по ролям (владелец сервиса, саппорт, менеджер по клиенту) и дедлайны по эскалациям.

Если вы делаете такой продукт для внутренней команды или как отдельный сервис, полезно заранее продумать цикл разработки: планирование, снапшоты окружений и откаты. В TakProsto.AI это поддерживается «из коробки» (снапшоты/rollback, деплой и хостинг, экспорт исходников), что удобно для итераций над критичной логикой расчёта SLA и отчётности.

Что почитать дальше

- Про метрики и мониторинг: /blog/monitoring-metrics

- Про варианты поставки и стоимость: /pricing