06 мар. 2025 г.·8 мин

Как создать веб‑приложение для сегментации и когорт

Пошаговый план создания веб-приложения для сегментации клиентов и когортного анализа: данные, модель, метрики, UI, безопасность и запуск.

Цели продукта и ключевые сценарии использования

Это приложение нужно не «для аналитики вообще», а чтобы регулярно отвечать на продуктовые и коммерческие вопросы на одних и тех же данных — быстро, повторяемо и без ручных выгрузок.

В центре — сегментация клиентов и когортный анализ. Они помогают управлять:

- удержанием (кто и когда перестаёт пользоваться продуктом),

- LTV и выручкой (какие группы приносят больше в долгую),

- реактивацией (кого имеет смысл возвращать и чем),

- ростом (какие сегменты увеличиваются, а какие деградируют).

Важно договориться заранее: приложение должно не только «показывать цифры», но и помогать действовать — например, собрать список пользователей для кампании, проверить результат и сохранить выводы.

Кому это нужно внутри компании

Обычно одним и тем же интерфейсом пользуются разные роли, и у каждой свои ожидания:

- продукт — увидеть, где ломается воронка и где падает удержание;

- маркетинг/CRM — найти аудитории для коммуникаций и оценить эффект кампаний;

- поддержка — понять, какие группы чаще сталкиваются с проблемами;

- продажи/аккаунтинг — выделять «ценные» сегменты и отслеживать риск оттока.

Отсюда базовое требование: единые определения метрик и возможность быстро сравнивать сегменты без споров «у кого цифры правильнее».

Типовые вопросы, которые приложение должно закрывать

- Кто отваливается после первого опыта: через 1 день, 7 дней, 30 дней?

- Какие сегменты растут: по регионам, тарифам, источникам, поведению?

- Как изменилось удержание/ARPU после запуска функции или кампании?

- Чем отличаются пользователи с высоким LTV от остальных (поведение, частота, путь)?

Решения, которые нельзя принимать без контекста

Когортные графики и сегменты часто показывают корреляции, но не всегда причины. Например, рост удержания в «новом тарифе» может объясняться тем, что на него переходят уже лояльные пользователи.

Поэтому продуктовая цель приложения — не «доказать гипотезу любыми графиками», а дать инструменты для корректных сравнений: контрольные группы, разрезы, заметки к событиям релиза и возможность быстро перепроверить допущения.

Данные и источники: что нужно собрать для аналитики

Качество сегментации и когортного анализа почти всегда упирается не в «красивые графики», а в то, какие данные вы реально собираете и насколько они сопоставимы между системами. На старте важно договориться, какие источники считаются «истиной» и как вы склеиваете пользователя между ними.

Какие источники подключать в первую очередь

Для MVP обычно хватает 4–6 потоков данных:

- События продукта: регистрации, логины, просмотры ключевых экранов, клики по CTA, активация фич, ошибки.

- Заказы/платежи: чек, валюта, статус (успех/возврат), дата оплаты, тариф/товар, промокод.

- CRM: стадия лида, менеджер, источник привлечения, B2B-атрибуты (компания, отрасль).

- Рассылки и пуши: отправка/доставка/открытие/клик, кампания, UTM.

- Поддержка: обращения, тема, канал, SLA, CSAT (если есть).

Позже можно добавить рекламные кабинеты, офлайн-точки, данные о контенте, рекомендации и т. п. — но они редко критичны для первых когорт удержания и базовой RFM.

Идентификаторы и правила склейки

Сразу определите, какие идентификаторы «главные»:

- user_id — стабильный внутренний ID (лучший якорь для аналитики).

- device_id — для анонимных событий до регистрации.

- email/phone — для CRM/рассылок (персональные данные; хранить и использовать аккуратно).

Минимальные правила: анонимные события по device_id должны «приклеиваться» к user_id после регистрации/логина. При конфликте приоритет обычно у user_id, а email/phone используются как вспомогательные ключи (и только если есть юридическое основание).

Нормализация: время, деньги, мусор в данных

Договоритесь об одной временной зоне (часто UTC) и храните исходный timestamp + нормализованный.

По деньгам: храните сумму, валюту, курс/приведение (или хотя бы сумму в базовой валюте).

Обязательно заложите:

- дедупликацию событий (idempotency key, event_id),

- фильтрацию тестовых данных (test_user, internal_domain, sandbox-окружение),

- единые справочники статусов (например, «оплачен/возврат/отмена»).

Минимальный набор полей для MVP

Для большинства сценариев достаточно: event_time, event_name, user_id/device_id, session_id (желательно), source/utm, и для платежей — order_id, amount, currency, status.

Всё остальное (гео, устройство, дополнительные свойства фич) можно добавлять постепенно — когда появятся вопросы, на которые текущих данных не хватает.

События и схема данных: как проектировать трекинг

Трекинг — это контракт между продуктом, разработкой и аналитикой: какие действия пользователей фиксируем, с какими параметрами и как затем интерпретируем. Чем раньше вы договоритесь о правилах, тем меньше «дыр» в данных и споров о метриках.

Трекинг событий: соглашение об именовании и обязательные параметры

Заведите единый стиль имён событий: например, object_action (checkout_started, plan_selected, invoice_paid). Избегайте «общих» событий вроде click без контекста.

Минимальный набор обязательных параметров для каждого события:

event_id(уникальный идентификатор) иevent_time(UTC),user_id(если известен) и/илиanonymous_id,session_id,source/platform(web, ios и т. п.) иapp_version.

Схема событий: user, session, event, properties

Думайте о данных как о четырёх сущностях:

- User: постоянные атрибуты (страна, тариф, дата регистрации),

- Session: контекст визита (канал, устройство),

- Event: факт действия (что произошло и когда),

- Properties: детали события (например,

plan_id,price,currency).

Важно разделять свойства пользователя и события: тариф пользователя может измениться, а событие оплаты должно хранить тариф «на момент оплаты» в properties.

Качество данных: пропуски, дубли, последовательность

Проверяйте: (1) обязательные поля не пустые, (2) нет дублей по event_id, (3) события укладываются в ожидаемую последовательность (нельзя оплатить до старта оформления).

Для этого полезны автоматические тесты на входящем потоке и отчёты о доле «плохих» событий.

Версионирование событий и обратная совместимость

События неизбежно меняются. Добавляйте поля без удаления старых, используйте schema_version и ведите changelog. Если поле переименовали — поддержите оба варианта в обработке на период миграции, иначе когорты и сегменты «поплывут».

Пайплайн ETL/ELT и витрина данных для сегментов и когорт

Чтобы сегменты и когорты считались стабильно, нужен понятный «конвейер» данных: от сырых событий до витрин, на которых строятся отчёты и API. Хороший пайплайн делает результаты воспроизводимыми, а ошибки — заметными.

Слои данных: сырьё → очищение → витрины

Обычно достаточно трёх слоёв:

- Сырьё (raw/landing): как пришло из источника (события, заказы, платежи), с минимальными преобразованиями. Здесь важно хранить историю и не терять детали.

- Очищенные данные (clean/staging): нормализация типов, дедупликация, приведение временных зон, сопоставление идентификаторов (user_id, device_id), базовая валидация.

- Витрины/марты (marts): таблицы, оптимизированные под задачи сегментации и когорт: факты (покупки, сессии), измерения (пользователь, тариф, канал), агрегаты по дням/неделям.

Пакетная загрузка vs near-real-time

Пакетная (batch) подходит, если отчёты обновляются раз в день/час и нет критичности «видеть прямо сейчас». Она проще, дешевле и легче отлаживается.

Near-real-time стоит выбирать, когда сегменты используются в продукте немедленно: триггерные сообщения, персонализация на сайте, антифрод. Часто компромисс — события почти онлайн, а витрины пересчитываются, например, каждые 15–60 минут.

План обновления: инкремент, расписание, бэкапы

Договоритесь о правилах пересчёта:

- Инкрементальная загрузка по watermark (timestamp/sequence) вместо полного перерасчёта.

- Переигровка (backfill) за окно N дней для опоздавших событий.

- Снапшоты и бэкапы витрин/агрегатов, чтобы быстро откатиться и сравнить версии метрик.

Контроль качества: проверки и журнал ошибок

Встройте автоматические проверки: уникальность ключей, доля null, диапазоны дат, баланс событий/заказов, аномальные скачки.

При провале — алерт, запись в журнал ошибок, и понятный статус последнего успешного обновления витрины (важно для доверия к сегментам и когортам).

Определения когорт и метрик: чтобы все считали одинаково

Самая частая причина «споров про цифры» — разные определения. Перед тем как строить отчёты и API, зафиксируйте словарь терминов в одном месте (например, в README репозитория или в /docs внутри приложения) и привяжите его к конкретным полям схемы событий.

Фиксируем термины

Активный пользователь — не «зашёл на сайт», а совершил выбранное значимое событие (например, app_open, view_product, purchase). Важно заранее указать, какое именно событие считается активностью в разных контекстах: для продукта, для маркетинга, для платежей.

Возврат — повторная активность после периода неактивности. Здесь нужен порог: например, «возвратился, если был неактивен ≥ 7 дней и совершил событие активности».

Повторная покупка — вторая и последующие транзакции, где «покупка» определяется однозначно: только успешные платежи? учитывать возвраты средств? что делать с частично оплаченными заказами?

Когорты по дате: что именно фиксируем

Когорта — это группа пользователей, объединённых датой первого события выбранного типа:

- по дате регистрации (

signup_date), - по первой покупке (

first_purchase_date), - по первому событию (например, первое

app_open).

В интерфейсе полезно явно показывать выбранный «якорь когорты», чтобы один и тот же пользователь не попадал в разные когорты незаметно.

Окна времени и правила округления

Заранее выберите гранулярность: день/неделя/месяц. Зафиксируйте правила: неделя начинается с понедельника или воскресенья, месяц — календарный, таймзона — какая (UTC или локальная), округление — до начала периода.

Метрики: считаем одинаково

- Retention: доля пользователей когорты, которые были активны в период N.

- Churn: обычно 1 − retention, но только если определения периодов и активности совпадают.

- Revenue retention: отношение выручки от когорты в период N к выручке в базовом периоде (важно решить, что делать с возвратами).

- ARPU: выручка / число пользователей в периоде.

- LTV: накопленная выручка на пользователя за выбранный горизонт. Не обещайте «точный LTV навсегда» — фиксируйте окно (например, 30/90/180 дней) и метод расчёта.

Модели сегментации: от простых правил до признаков

Планируйте изменения безопасно

Меняйте правила расчета через planning mode, чтобы не ломать отчеты в проде.

Сегментация — это способ превратить «всех пользователей» в понятные группы, с которыми можно работать: запускать кампании, сравнивать удержание, находить точки роста. Практично начинать с простых правил, а затем усложнять модель, когда появятся стабильные данные и запрос на точность.

Правила сегментации: RFM, поведение, демография

RFM — базовый и очень полезный набор правил для продуктов с транзакциями:

- Recency: как давно пользователь был активен/покупал;

- Frequency: как часто;

- Monetary: сколько потратил.

Даже простая сетка (например, «активен за 7 дней», «покупок ≥ 3», «выручка ≥ X») даёт сегменты вроде «новые», «возвращающиеся», «VIP», «уснувшие».

Поведенческие признаки добавляют глубину там, где денег мало или они не главный сигнал: частота сессий, использование ключевой функции, завершение онбординга, просмотр N экранов, глубина воронки.

Демография (если есть и законно собрана): страна/город, язык, тип устройства, тариф. Важно: такие поля часто неполные, поэтому в интерфейсе полезно иметь значение «неизвестно» и отдельные правила обработки пропусков.

Онлайн и офлайн сегменты: предрасчёт vs расчёт по запросу

Есть два режима, и обычно нужен гибрид.

Офлайн (предрасчёт) — сегменты считаются по расписанию и записываются в витрину/таблицу принадлежности пользователя к сегменту.

Подходит для: больших аудиторий, частых выборок, стабильных правил (RFM, жизненный цикл, «активен/неактивен»). Плюсы — быстро и дёшево в интерфейсе. Минусы — сегмент «устаревает» между пересчётами.

Онлайн (по запросу) — сегмент собирается динамически по условиям в отчёте.

Подходит для: разовых исследований, сложных фильтров, «а что если» анализа. Плюсы — гибкость. Минусы — риск долгих запросов и разной воспроизводимости, если данные обновились.

Фильтры и условия: пороги, периоды, исключения

Чтобы сегменты были управляемыми, в конструкторе условий полезно поддержать:

- Пороги и периоды: «за последние 14 дней», «не было события 30 дней», «конверсий ≥ 2».

- Комбинации: AND/OR, группировка условий.

- Исключения: тестовые пользователи, внутренние сотрудники, технические аккаунты; иногда — пользователи без согласия на аналитику.

- Окна активности: важно явно выбирать, что считается «активностью» (сессия, покупка, ключевое событие).

Обновление сегментов и влияние на отчёты

Частота пересчёта влияет на доверие к цифрам. Хорошая практика — для каждого сегмента фиксировать:

- расписание пересчёта (каждый час/день/неделя);

- «время среза» (на какую дату актуален сегмент);

- версию правил (если пороги или логика менялись).

Так отчёты становятся воспроизводимыми: пользователь понимает, почему «вчера в сегменте было 12 000, а сегодня 11 400» — это изменение поведения или смена правил/среза.

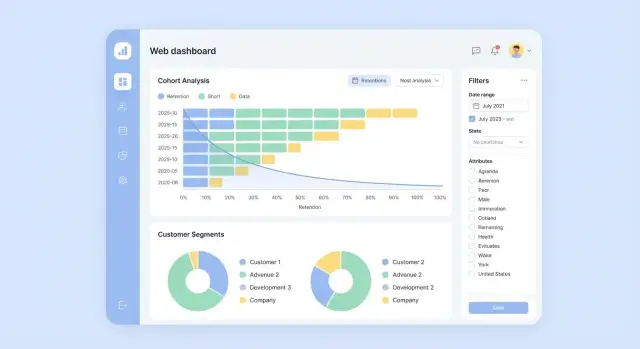

Интерфейс приложения: экраны, фильтры и понятные отчёты

Хороший интерфейс для сегментации и когорт — это не «BI для аналитиков», а рабочее место для продакта, маркетолога и customer success. Главная цель: чтобы человек без SQL мог собрать сегмент, понять, что он означает, и уверенно применить.

Основные экраны

1) Список сегментов

Покажите таблицу с названием, кратким описанием, владельцем, датой обновления, размером аудитории и пометкой «в проде/черновик». Полезно добавить быстрые действия: дублировать, архивировать, поделиться ссылкой (/segments/123).

2) Конструктор сегмента

Сделайте фильтры «как в интернет‑магазине»: выпадающие списки, диапазоны дат, понятные названия событий и свойств. Важный элемент — live‑превью размера сегмента и пример 10 анонимизированных строк («типичный пользователь»), чтобы ловить ошибки логики.

3) Просмотр когорты

Отдельный экран /cohorts/… с матрицей удержания, переключателями периода (день/неделя/месяц), выбором события «активации» и «возврата». Рядом — краткая «легенда»: как именно считается удержание в этом отчёте.

4) Детализация

Drill‑down из любой ячейки: кто именно входит, какие общие характеристики, топ‑каналы/страны/планы, плюс сохранение «среза» как нового сегмента.

UX для нетехнарей: подсказки и шаблоны

Добавьте встроенные шаблоны:

- Retention: «зарегистрировались → вернулись и совершили действие N»

- Повторные покупки: «первая покупка → следующая покупка в 30 дней»

- RFM: готовая форма с пояснениями терминов

Каждый фильтр снабдите подсказкой «что это значит» и примером. Отдельно полезна кнопка «Проверить»: показать, какие условия исключили больше всего пользователей.

Экспорт и интеграции

Минимум для MVP — экспорт CSV (с учётом прав) и сохранённый share link на отчёт.

Для интеграций по необходимости: webhook или вызов API, чтобы внешний сервис мог запросить список user_id сегмента на конкретную дату.

Права и доступ

Разделите роли: создатель (может создавать/редактировать/публиковать сегменты), наблюдатель (только просмотр), админ (управление источниками и доступами).

На уровне объекта добавьте «владелец» и «проект/пространство», чтобы сегменты не превращались в общий хаос.

Расчёты и производительность: как считать быстро и воспроизводимо

Сегменты и когорты быстро превращаются в «тяжёлые» запросы: фильтры по событиям, окнам времени, атрибутам пользователей, плюс пересчёт метрик удержания. Чтобы интерфейс оставался быстрым, а цифры — воспроизводимыми, расчёты нужно проектировать как продуктовую функцию.

Хранилище результатов: где «живут» когорты

Храните результаты в отдельных таблицах, а не вычисляйте их каждый раз «на лету». Обычно достаточно трёх уровней:

- Сырые факты (events, users) — неизменяемые.

- Агрегаты (daily_user_metrics, daily_event_counts) — компактные слои для быстрых группировок.

- Таблицы когорт (cohorts, cohort_metrics) — финальные расчёты по размеру когорты, retention, ARPU и т. д.

Для популярных срезов используйте materialized views или расписание пересчёта (например, каждый час), чтобы UI не зависел от сложности исходных таблиц.

Производительность: предагрегации, кэш и «ограничители»

Скорость чаще всего дают предагрегации: считать «уникальных активных пользователей по дням» один раз дешевле, чем каждый раз пересобирать из событий.

Добавьте кэширование на уровне API: одинаковые запросы «Когорта по неделям за 90 дней» должны отдавать ответ быстро. Практика — кэш по ключу (параметры фильтров + версия данных) с TTL.

Чтобы пользователи не «уронили» систему, вводите ограничения: максимум периодов, максимум одновременно выбранных фильтров, запрет на тяжёлые комбинации. Важно объяснять это в интерфейсе и документации, а не оставлять «тихие» таймауты.

Масштабирование: рост событий и пользователей

При росте объёма событий критично партиционирование по датам (например, по дню/месяцу) и индексы по user_id + event_time. Для когортных таблиц полезны партиции по cohort_start_date — пересчёт затронет только новые периоды.

Точность и задержка: как говорить о свежести

Пользователь должен видеть, насколько данные актуальны: «обновлено 12:30, задержка ~45 минут». Разделяйте понятия:

- Freshness: до какого времени данные загружены.

- Completeness: насколько «досчитан» период (например, текущий день неполный).

Это снижает споры о метриках и помогает правильно интерпретировать тренды.

API и архитектура доступа: как отдавать сегменты и когорты

Прототип конструктора сегментов

Быстро набросайте конструктор сегментов с фильтрами и превью размера аудитории.

API — это «точка выдачи» результатов сегментации и когорт в другие системы: CRM, рассылки, BI, внутренние сервисы продукта. Хорошая архитектура доступа помогает избежать утечек данных и «магии» в расчётах.

Базовые эндпоинты

Минимальный набор обычно выглядит так:

GET /api/v1/projects— список доступных проектов/воркспейсов.GET /api/v1/segmentsиGET /api/v1/segments/{id}— каталог сегментов и их параметры (фильтры, период, источник данных, владелец).POST /api/v1/segments— создание сегмента (лучше хранить не только результат, но и декларативное описание условий).GET /api/v1/cohortsиGET /api/v1/cohorts/{id}— определения когорт (правила попадания) и срезы метрик.GET /api/v1/metadata/eventsиGET /api/v1/metadata/properties— справочники схемы данных для UI и валидации запросов.POST /api/v1/exports— экспорт результата (например, список пользователей/организаций) с отслеживанием статуса.

Модель доступа: роли и ограничения

Обычно хватает RBAC: админ, аналитик, читатель. Поверх ролей добавьте изоляцию по воркспейсам/проектам и ограничения по данным (например, доступ только к агрегатам, запрет выгрузки идентификаторов, лимиты по объёму).

Полезна отдельная роль «экспортёр» для контроля выгрузок.

Аудит действий

Логи аудита должны фиксировать: кто создал/изменил сегмент или когорту, какие параметры поменялись, кто и когда запускал экспорт, какие объёмы данных ушли. Это упрощает разбор инцидентов и повышает воспроизводимость.

Версионирование и стабильность

Закладывайте версию в URL (/v1/) и используйте контрактные изменения аккуратно: добавляйте поля без удаления, помечайте устаревшие параметры, публикуйте changelog.

Для «тяжёлых» расчётов часто лучше асинхронный паттерн: POST создаёт задачу, GET проверяет статус и забирает результат.

Приватность и безопасность: работа с данными клиентов

Если в приложении для сегментации и когорт появляются данные о клиентах, безопасность — это не «фича потом», а часть дизайна. Правильнее считать, что инциденты возможны всегда, и строить систему так, чтобы даже в худшем случае ущерб был минимальным.

Персональные данные: минимизация и псевдонимизация

Начните с принципа минимизации: для когорт и сегментов часто не нужны ФИО, телефон или точный адрес. В витрине и аналитических таблицах держите только то, что влияет на расчёты: идентификатор пользователя, события, атрибуты (например, тариф, канал, страна/регион в укрупнённом виде).

Идентификаторы лучше псевдонимизировать: хранить внутренний user_id (UUID) и отдельно — сопоставление с реальным идентификатором (email/телефон) в изолированном хранилище с более строгими правами.

Токены авторизации и ключи интеграций не должны попадать в витрину, логи или экспорт.

Согласия и правовые требования

До разработки зафиксируйте с бизнесом и юристами:

- какие данные считаются персональными в вашей юрисдикции;

- основание обработки (согласие, договор, легитимный интерес);

- сроки хранения и правила удаления;

- кто и для чего имеет доступ (роль, задача, аудит).

Эти решения должны отражаться в продукте: чекбоксы согласия, политики ретенции, процедуры удаления и выгрузки данных по запросу.

Техническая безопасность

Базовый набор: шифрование «в пути» (TLS) и «на диске», RBAC/ABAC для доступов, разделение окружений, ротация секретов (через secret manager), запрет «широких» выгрузок по умолчанию.

Экспорт сегментов делайте с лимитами, водяными знаками и журналом действий.

Логи и мониторинг без утечек

Логи — частый источник утечек. Правило простое: не писать чувствительные поля (email, телефон, токены, содержимое запросов), маскировать идентификаторы, ограничивать срок хранения логов.

Для мониторинга используйте агрегаты и метрики качества расчётов, а не «сырые» события.

Тестирование и валидация: как не ошибиться в метриках

Стартуйте с правильной схемы

Зафиксируйте сущности users, events, segments, cohorts и получите основу API и админки.

Ошибки в метриках редко выглядят как «падение системы». Чаще это тихие расхождения на 1–3%, которые потом превращаются в неверные продуктовые решения. Поэтому тестирование аналитики — это не «потом», а часть разработки.

Проверки: юнит‑тесты метрик и интеграционные тесты пайплайна

Начните с юнит‑тестов для каждой метрики и правила включения в когорту/сегмент. Лучший формат — маленькие синтетические наборы данных, где ответ очевиден: один пользователь, два заказа, возврат, отмена, смена тарифа.

Что особенно важно покрыть тестами:

- границы периодов (UTC vs локальная зона, конец/начало суток, календарные месяцы);

- дедупликацию событий (повторная отправка трекера, ретраи ETL);

- изменение статусов (создан → оплачен → отменён) и выбор «правильного момента» для выручки;

- уникальность (пользователь vs устройство vs аккаунт).

Интеграционные тесты пайплайна (ETL/ELT) должны гарантировать, что данные корректно доезжают от «сырья» до витрины: схема не сломалась, типы не поплыли, а инкрементальная загрузка не создаёт дублей.

На практике это набор проверок качества данных (data tests) в CI и регулярные мониторинги.

Сверка: контрольные суммы и сравнение с финансовыми отчётами

Валидация на реальных данных — это сверка агрегатов. Введите контрольные суммы и «ожидаемые коридоры»:

- число событий по дням/источникам;

- число уникальных пользователей;

- сумма выручки и количество оплаченных заказов.

Если продукт связан с платежами, делайте регулярное сравнение с финансовой отчётностью (где применимо): разница допустима (комиссии, возвраты, момент признания выручки), но она должна быть объяснимой и зафиксированной в правилах.

Отладка: разбор конкретного пользователя/заказа по цепочке данных

Когда метрика «поехала», самый быстрый путь — разбор одного конкретного случая. Подготовьте возможность пройти по цепочке:

событие в сырье → нормализация → витрина → попадание в сегмент/когорту → отображение в отчёте.

Полезный приём — «trace‑страница» в админке или служебный endpoint, который по user_id/order_id показывает все связанные события, версии преобразований и причину включения/исключения из сегмента.

Документация: словарь метрик и примеры расчётов

Большая часть ошибок — не баги, а разные трактовки. Сделайте словарь метрик: формула, единицы измерения, фильтры, окно времени, источники, исключения (тестовые аккаунты, отменённые заказы) и примеры расчёта «на пальцах».

Документацию удобно хранить рядом с репозиторием и ссылаться на неё из интерфейса отчётов (например, «i» рядом с метрикой) или из раздела /docs/metrics.

Запуск MVP и развитие: что сделать за один цикл

MVP для сегментации и когорт — это не «всё и сразу», а минимальный набор, который реально начнут использовать. Цель запуска — проверить, что данные считаются одинаково, отчёты понятны, а сегменты можно применить в работе (маркетинг, продукт, поддержка).

MVP: минимальный набор функций

Сфокусируйтесь на трёх вещах: несколько полезных сегментов, один‑два когортных отчёта и возможность вынести результат наружу.

1) 2–3 шаблона сегментов

Выберите шаблоны, которые чаще всего обсуждают на встречах:

- RFM‑сегменты (например, «активные и ценные», «уснули», «новые»).

- Сегмент по событию/фиче: «выполнили ключевое действие N раз за 7 дней».

- Сегмент по тарифу/каналу/региону (если это влияет на поведение).

Важно: каждый шаблон должен быть настраиваемым без SQL и иметь чёткое описание, что именно попадает внутрь.

2) 1–2 отчёта когорт

Достаточно:

- когорты по дате первого ключевого события (активации/первой покупки);

- метрика удержания (например, D1/D7/D30) и/или повторная покупка.

Сделайте акцент на воспроизводимости: одинаковые фильтры, фиксированная временная зона, понятные определения.

3) Экспорт/выгрузка

Даже в MVP нужен «мост» в работу: CSV‑экспорт, сохранённые сегменты, ссылка на сегмент для коллег. Если API ещё рано — хотя бы стабильный экспорт с историей запусков.

План релизов: короткие итерации

Оптимальный ритм — 1–2 недели на итерацию.

- Итерация 1: один сегмент + один когортный отчёт + базовые фильтры.

- Итерация 2: сохранённые сегменты, сравнение периодов/когорт, экспорт.

- Итерация 3: права доступа, валидация данных, ускорение расчётов.

Сбор обратной связи делайте конкретным: «какой вопрос вы хотели закрыть и получилось ли», «где недоверие к цифрам», «чего не хватает для применения результата».

Метрики успеха продукта

Не измеряйте успех только количеством экранов. Лучше — несколько простых продуктовых метрик:

- Adoption: сколько людей и команд регулярно открывают отчёты/сегменты.

- Точность/доверие: число найденных расхождений, доля согласованных определений.

- Время до ответа: сколько секунд/минут занимает расчёт типового отчёта.

- NPS внутри команды: готовы ли коллеги рекомендовать инструмент как «источник правды».

Что дальше (опции, а не обещания)

Когда MVP стабилен, появляются естественные расширения:

- прогнозирование оттока как отдельный модуль, когда накопится история;

- эксперименты (A/B) поверх когорт и сегментов, чтобы связывать изменения с эффектом;

- персонализация: использовать сегменты для коммуникаций и внутри продукта, но только после проверки качества данных и прав доступа.

Главная идея развития: каждое улучшение должно уменьшать ручной труд и повышать доверие к цифрам, а не просто добавлять новые фильтры.

Как ускорить разработку такого приложения с TakProsto.AI

Если задача — быстро собрать рабочий MVP (экраны сегментов/когорт, роли, экспорт, базовый API) и уже потом доращивать пайплайн и витрины, полезно рассмотреть TakProsto.AI как «виб‑программирование» подход для прототипирования и доставки функциональности короткими итерациями.

Платформа позволяет описать продукт в чате (экраны, модели данных, права доступа, эндпоинты), а затем получить каркас приложения на типовом стеке: React для веб‑интерфейса, Go для бэкенда и PostgreSQL для базы. В контексте сегментации и когорт это удобно, потому что вы быстро:

- фиксируете сущности (users/events/segments/cohorts/exports) и RBAC;

- поднимаете API и админ‑часть для источников/метаданных;

- добавляете «планирование» изменений (planning mode), снапшоты и откат (rollback), чтобы безопаснее менять правила расчётов.

Отдельный практичный плюс для российского рынка: TakProsto.AI работает на серверах в России, использует локализованные и open‑source LLM‑модели и не отправляет данные за пределы страны. Когда MVP стабилизируется, можно экспортировать исходники, подключить свой контур хранилища/ETL и перейти на нужный тариф (free/pro/business/enterprise) по мере роста нагрузки и требований к доступам.