18 июл. 2025 г.·8 мин

Как создать веб‑приложение для SLA‑отчётности по клиентам

Пошаговый план веб‑приложения для централизованной SLA‑отчётности по всем клиентам: данные, мультиарендность, метрики, дашборды, алерты и безопасность.

Цель и сценарии использования

Единая SLA‑отчётность становится критичной, когда вы обслуживаете несколько клиентов одновременно: у каждого свои договорённости, свои сервисы и свой взгляд на «нормально» и «плохо». Цель такого веб‑приложения — дать всем участникам одну точку правды по SLA, чтобы отчёты были сопоставимыми, проверяемыми и собирались без ручного труда.

Какие проблемы решаем

Когда SLA считают «как привыкли» в разных командах и инструментах, быстро появляются типовые боли: цифры не сходятся, формулы отличаются, источники данных противоречат друг другу, а отчёты делаются в таблицах вручную и зависят от конкретного человека.

Централизованный подход убирает хаос: правила расчёта фиксируются, данные подтягиваются автоматически, а история изменений сохраняется. В результате спор «у нас 99,9%» превращается в разговор «по какой методике и по каким событиям считаем».

Кому полезно

- Сервис‑менеджеру — чтобы видеть выполнение обязательств по всем договорам и быстро находить зоны риска.

- Аккаунт‑команде — чтобы готовить клиентские встречи на основе фактов, а не «ощущений».

- Руководству — чтобы понимать качество сервиса по портфелю клиентов и управлять приоритетами улучшений.

- Клиенту — чтобы самостоятельно смотреть показатели и статус без ожидания ежемесячного файла.

Ожидаемые результаты

- Прозрачность и доверие: одинаковые цифры для всех сторон.

- Меньше споров: понятная методика и воспроизводимый расчёт.

- Быстрее реакция: отклонения по SLA видны сразу, а не в конце отчётного периода.

- Снижение операционных затрат: меньше ручной подготовки отчётов и согласований.

Что именно измеряем: метрики SLA и правила расчёта

Прежде чем строить дашборды и автоматизировать отчёты, нужно договориться о «языке цифр»: какие SLA/KPI считаем, в каких единицах и по каким правилам. Иначе один и тот же месяц может получиться «99,95%» в одном отчёте и «99,5%» в другом — просто из‑за разных трактовок.

Базовый набор SLA/KPI

Обычно достаточно 3–5 метрик, которые понятны клиенту и привязаны к договору:

- Доступность (Availability, %) — доля времени, когда услуга работала в рамках SLA.

- Время реакции (Response Time) — сколько прошло от регистрации обращения/алерта до первого ответа или принятия в работу.

- Время восстановления (MTTR / Restore Time) — сколько заняло возвращение услуги в норму.

- Объём нарушений — число инцидентов/обращений с нарушением SLA и их суммарная «стоимость» (например, минуты простоя сверх лимита).

Единицы измерения и частота отчётности

Сразу фиксируйте:

- единицы: минуты/часы для времени, проценты для доступности;

- периодичность: неделя/месяц/квартал (и правило округления);

- часовой пояс и календарь (рабочие часы 8×5 или 24×7).

Пример расчёта доступности:

Availability = 1 - (Downtime_SLA / Total_Time)

Где Downtime_SLA — только тот простой, который по договору влияет на SLA.

Срезы для отчётов

Чтобы отчёт был полезным, закладывайте разрезы: клиент → услуга → регион, а также критичность, канал поддержки (почта/портал/телефон) и тип инцидента.

«Источник истины»: что считаем инцидентом и простоем

Самое важное — формализовать правила:

- что считается инцидентом (например, подтверждённый деградацией сервиса);

- как определяем начало/конец простоя (по мониторингу или по тикету);

- как учитываем плановые работы (исключаем из SLA или считаем отдельно);

- как обрабатываем спорные случаи: дубли, массовые инциденты, зависимость от внешних провайдеров.

Эти договорённости стоит закрепить в справочнике правил — это снижает количество разбирательств и делает отчётность сопоставимой от периода к периоду.

Мультиарендность: как разделить клиентов и не перепутать данные

Мультиарендность в SLA‑отчётности — это не только про экономию инфраструктуры, но и про доверие: клиент должен быть уверен, что видит только свои инциденты, свои расчёты и свои правила.

Два базовых подхода к хранению данных

Отдельная БД на клиента упрощает изоляцию и аудит: меньше риск «протечки» через ошибку в запросе, легче делать экспорт/удаление данных. Минусы — больше операционных затрат, сложнее выпускать миграции и поддерживать одинаковые версии схем.

Общий кластер с разделением данных (одна БД, общий набор таблиц) обычно выгоднее и удобнее для развития продукта. Но тогда изоляция должна быть встроена в архитектуру: и в данных, и в доступах.

tenant_id и защита на уровне запросов

Практика по умолчанию — добавлять tenant_id во все «арендные» сущности и делать фильтрацию неизбежной:

- на уровне ORM/репозитория (глобальный фильтр);

- на уровне БД (Row Level Security, отдельные роли/политики);

- в логике API (проверка соответствия токена/организации).

Важно не полагаться только на один слой: ошибки случаются, а дублирование барьеров снижает риск.

Модель «клиент → контракты → сервисы → SLO/SLA → измерения»

Такой граф позволяет корректно отвечать на вопрос «по какому договору и по каким правилам считать этот отчёт». Измерения (инциденты, даунтайм, окна обслуживания) должны ссылаться на конкретный сервис и версию правил.

Часовые пояса, календари и версионирование

Для SLA с рабочими часами критично хранить:

- часовой пояс клиента/контракта;

- календарь (рабочие дни, праздники, исключения).

И обязательно версионировать правила SLA: отчёт за март должен считаться по правилам, действовавшим в марте, даже если в июле вы обновили формулу или расписание. Это защищает от «пересчёта задним числом» и упрощает разбор спорных ситуаций.

Источники данных и интеграции

Чтобы SLA‑отчётность была доверенной, важно заранее договориться, откуда берутся факты об инцидентах и как вы «склеиваете» их в единую картину. Чаще всего данные приходят из нескольких источников, и каждый закрывает свой кусок правды.

Основные источники

Мониторинг даёт точные таймстемпы (начало/конец деградации), но не всегда содержит бизнес‑контекст.

Тикет‑система фиксирует коммуникации, приоритеты, ответственных и этапы обработки. Это ключ к метрикам типа MTTA/MTTR и соблюдению регламентов.

Статус‑страницы полезны как независимое подтверждение публичных объявлений (когда сообщили клиенту, что именно признали инцидентом).

Ручные корректировки нужны для исключений: плановые работы, спорные интервалы, ошибки источников. Их важно ограничивать ролями и обязательно протоколировать.

Коннекторы и частота синхронизации

Выбирайте режим по природе данных:

- Near‑real‑time (каждые 1–5 минут или вебхуки) — для мониторинга и алертов по SLA, где важна оперативность.

- Пакетная загрузка (раз в час/сутки) — для тикетов и статус‑страниц, где изменения чаще «догоняют» событие.

Практика: разделить «оперативный поток» (для алертов) и «витрину отчётности» (для финального расчёта), чтобы корректировки и запоздавшие статусы не ломали онлайн‑логику.

Нормализация: общий словарь

У разных систем разные статусы, приоритеты и названия сервисов. Нужен слой нормализации:

- единые типы событий (инцидент/деградация/плановые работы);

- справочник приоритетов и их маппинг;

- каталог сервисов/компонентов (то, к чему привязывается SLA).

Дедупликация и связывание

Один и тот же инцидент может появиться в мониторинге, нескольких тикетах и на статус‑странице. Закладывайте правила связывания: по временным окнам, затронутому сервису, корреляционному ключу (если есть) и признакам «родитель/дочерний» для крупных аварий.

Логи импорта и идемпотентность

Каждая загрузка должна быть повторяемой: если вы импортируете один и тот же период дважды, результат не должен удваиваться.

Храните журнал импорта: источник, диапазон времени, количество записей, версии маппингов, ошибки и предупреждения. Это ускоряет разбор расхождений и помогает на этапе аудита (см. также /blog/konfidencialnost-audit-sla если у вас есть отдельный материал).

Модель данных и расчёт SLA

Чтобы SLA‑отчётность была воспроизводимой и «доказуемой», модель данных лучше строить от фактов (что случилось) к вычислениям (как посчитали). Тогда любое число в отчёте можно разложить на исходные события, правила и историю правок.

Схема хранения: от событий к отчётным периодам

Минимальный набор сущностей обычно выглядит так:

- Сырые события (events): сигналы мониторинга, статусы сервисов, изменения конфигурации, входящие вебхуки.

- Инциденты (incidents): объединяют события в связный эпизод деградации/недоступности с временем начала/окончания, затронутыми компонентами и клиентами.

- Окна простоя (downtime_windows): нормализованные интервалы «не работало/работало плохо» по конкретному SLI (например, доступность API) — именно их удобно суммировать.

- Измерения SLI (sli_measurements): периодические замеры (аптайм‑пинги, latency, error rate) с привязкой к арендатору, сервису и метрике.

- Отчётные периоды (reporting_periods): месяц/квартал, границы часовых поясов, правила округления.

«Сырые» данные отдельно от агрегатов

Практика, которая экономит время на спорных кейсах: хранить две зоны данных.

-

Raw‑слой — неизменяемые события «как пришли» (допускается только добавление).

-

Report‑слой — агрегаты для дашбордов: итоговый downtime, доступность, количество инцидентов по категориям, топ причин. Агрегаты пересчитываются по версии правил и фиксируются на момент публикации отчёта.

Расчёт доступности и исключения

Базовая формула для доступности на период:

- Availability = 1 − суммарный downtime / суммарное время периода (с учётом правил исключений и того, что именно считается downtime по договору).

Важно явно моделировать исключения, иначе цифры будут «плавать»:

- Плановые работы (maintenance_windows): интервалы, которые вычитаются из знаменателя и/или не входят в downtime.

- Разрешённые исключения (allowed_exclusions): например, простои по внешнему провайдеру или по клиентской сети — учитываются по правилам договора.

Каждое правило исключения должно быть применено детерминированно: по типу сервиса, клиенту, региону, времени и причине.

«Пояснения» к цифрам

Отдельно храните слой объяснений (например, sla_explanations): ссылки на инциденты, причины, комментарии, приложенные файлы и отметки «почему не считается в SLA». Это превращает отчёт из таблицы в аргументированный документ.

Аудит изменений

Для доверия критичны требования «кто и когда»: журналируйте правки данных и правил.

- кто изменил (пользователь/сервисный аккаунт),

- что изменил (поле, старое/новое значение),

- когда и почему (комментарий/тикет),

- по какой версии правил SLA пересчитан результат.

Так вы сможете восстановить расчёт за любой период и объяснить расхождения между предварительными и финальными цифрами.

Роли, доступ и безопасность

Обновляйте формулы без страха

Пробуйте изменения правил без риска: сохраняйте снимки и возвращайтесь к рабочей версии.

Доступ к SLA‑отчётности — это не только «кто может войти», но и «что именно он увидит» и «какие действия сможет выполнить». Ошибка в настройках быстро превращается в утечку данных между клиентами, поэтому роли и правила доступа лучше заложить в продукт с самого начала.

Роли и типовые сценарии

Обычно достаточно четырёх ролей:

- Администратор платформы — управляет настройками системы, интеграциями, политиками безопасности, шаблонами расчёта и глобальными справочниками.

- Менеджер аккаунта — ведёт конкретных клиентов: настраивает их сервисы, проверяет корректность данных, готовит отчёты.

- Клиент — просматривает только свою организацию, сервисы и отчёты, может оставлять комментарии или подтверждать согласование (если процесс предусмотрен).

- Наблюдатель — доступ «только чтение» (например, для аудитора или руководителя со стороны клиента).

Авторизация и приглашения

Поддержите несколько способов входа:

- SSO, если у клиента есть корпоративный провайдер идентификации (упрощает управление доступом и увольнения).

- Email‑логин как универсальный вариант.

- Приглашения в организацию: менеджер аккаунта или админ отправляет инвайт, пользователь автоматически привязывается к нужному арендатору.

Важно: отдельно храните «пользователь» и «принадлежность к организациям», чтобы один человек мог иметь доступ к нескольким клиентам (например, подрядчик) без смешивания прав.

Матрица доступа и уровни видимости

Помимо роли, задайте ограничение по:

- клиенту (организации),

- сервисам/контрактам внутри клиента,

- действиям (просмотр, экспорт, настройка, согласование).

Отдельно выделите доступ к черновикам и к утверждённым отчётам: черновики видят только админ и менеджер аккаунта, а клиент — после публикации.

Безопасность API

Для интеграций и автоматизации используйте:

- токены доступа с минимальными правами и сроком жизни,

- ротацию ключей и возможность отзыва без остановки сервиса,

- при необходимости — ограничение по IP для критичных API‑ключей.

Так вы снижаете риск компрометации и упрощаете контроль доступа при росте числа клиентов и интеграций.

Дашборды и отчёты: что показывать пользователям

Хороший SLA‑дашборд отвечает на два вопроса: «где мы сейчас относительно цели?» и «почему получилось именно так?». Пользователю не нужно разбираться в источниках данных — ему нужны ясные выводы, а при необходимости быстрый путь к деталям.

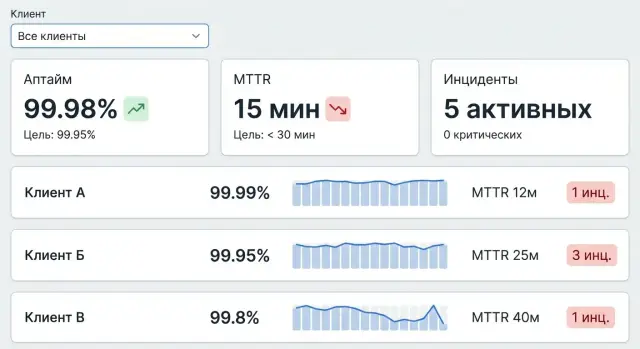

Главный экран: сводка и быстрые фильтры

На главной удобно показывать таблицу/плитки по всем клиентам: выполнение SLA за текущий период, отклонение от цели, статус (норма/риск/нарушение) и короткий список «что ухудшилось за 7 дней». Добавьте быстрые фильтры: период, клиент, сервис/компонент, регион, критичность.

Сразу отделяйте «плохие данные» от «плохого SLA»: например, индикатор покрытия (сколько инцидентов/метрик пришло корректно) рядом с итоговой цифрой.

Карточка клиента: тренды и причины

В карточке клиента — KPI за период (месяц/квартал), тренд по неделям, топ‑нарушения и «проблемные сервисы» с вкладом в общий простой. Полезны два вида сравнений: с целевым SLA и с прошлым периодом.

Детализация до инцидентов: таймлайн и вклад

При клике на сервис пользователь должен увидеть таймлайн инцидентов с длительностью, статусом и тем, как каждый простой повлиял на итоговую метрику (в минутах и процентах). Это снимает споры: «вот конкретные события, вот их вес в расчёте».

Экспорт и регулярные отчёты

Экспортируйте PDF/CSV по шаблонам ежемесячных отчётов: титульная страница, итоговые KPI, список нарушений, приложения с деталями. Поддержите брендирование клиента (логотип, цвета, реквизиты) и ссылку на онлайн‑версию отчёта (например, /reports/2025-11/client-123).

Объяснимость: «как посчитано» и исключения

Сделайте отдельный блок «Как посчитано»: формула, окно измерения, правила округления, таймзона, список исключений (плановые работы, неприменимые сервисы, инциденты вне охвата) и ссылки на первичные записи. Чем прозрачнее расчёт, тем меньше ручных согласований.

Алерты и проактивный контроль SLA

Соберите интеграции и нормализацию

Спроектируйте импорт мониторинга и тикетов с идемпотентностью и журналом загрузок.

Алерты в SLA‑отчётности нужны не для «поймать виноватых», а чтобы успеть исправить ситуацию до того, как период закроется с нарушением. Поэтому полезно проектировать уведомления как систему раннего предупреждения, а не как набор разрозненных писем.

Пороговые уведомления: прогноз риска до конца периода

Вместо простого правила «SLA нарушен» используйте предиктивные пороги: приложение считает, какой запас по SLA остаётся и насколько быстро он расходуется.

Примеры сигналов:

- «Осталось 15 минут downtime до лимита в этом месяце»

- «Если текущий темп инцидентов сохранится, SLA будет ниже 99,5% к концу периода»

Такой подход требует фиксировать период расчёта (месяц/квартал), учитывать окна обслуживания и исключения, а также показывать пользователю, что именно повлияло на прогноз.

Каналы доставки: email, мессенджеры, веб‑хуки

Разные роли предпочитают разные каналы. В интерфейсе задайте правила доставки по типу события и уровню критичности: письмо руководителю, сообщение в корпоративный мессенджер дежурной смене, веб‑хук во внутреннюю автоматизацию.

Добавляйте в уведомление краткую суть (клиент, сервис, риск/порог, период) и ссылку на карточку события внутри приложения.

Эскалации и окна дежурств

Эскалация должна учитывать расписание: кто «на линии» сейчас, кто резервный, какие часы нерабочие.

Обычно работает цепочка: исполнитель → старший смены → менеджер сервиса. Для каждой ступени задаются таймеры (например, 10/30/60 минут без реакции).

Статусы и подтверждение получения

Чтобы алерты превращались в управляемый процесс, используйте статусы: «открыто» → «в работе» → «закрыто». Добавьте подтверждение получения (ack) и комментарий о принятых мерах — это снижает дублирование и упрощает разбор.

Шумоподавление

Без контроля алерты быстро превращаются в спам. Помогают:

- группировка похожих событий (один инцидент — один тред)

- задержка отправки (например, 2–5 минут) для кратковременных всплесков

- «правила тишины» (maintenance, ночные окна, подавление повторов)

В результате пользователи получают меньше сообщений, но с более высоким сигналом и понятным следующим шагом.

Архитектура веб‑приложения и API

Архитектуру SLA‑сервиса лучше проектировать «от API», даже если вы сначала делаете только веб‑интерфейс. Это помогает заранее договориться о терминологии (инцидент, сервис, окно обслуживания, клиент) и избежать ситуации, когда отчёты «живут» в одном месте, а данные для пересчёта — в другом.

API‑первый подход: единые эндпоинты

Хорошая практика — выделить несколько понятных групп:

- /api/reports — выдача агрегированных отчётов (по периоду, сервису, клиенту), с фильтрами и версионированием.

- /api/incidents — инциденты и их статусы (создание/обновление, привязка к сервису, причины, таймлайны).

- /api/dictionaries — справочники (сервисы, клиенты, приоритеты, календарь рабочих часов, окна обслуживания).

Такой разрез упрощает интеграции: сначала можно подключить один источник инцидентов, а позже добавить второй, не меняя контракты для потребителей.

Монолит vs сервисы: когда усложнение оправдано

Для большинства команд разумно начинать с модульного монолита: одна кодовая база, но чёткие модули (импорт, расчёты, отчёты, доступ). Микросервисы становятся оправданными, когда у вас:

- разные команды отвечают за независимые части;

- расчёты SLA и импорт требуют отдельных циклов релизов;

- высокие нагрузки, где «узкое место» очевидно и стабильно.

Очереди и фоновые задачи

Импорт данных и пересчёты SLA почти всегда удобнее выносить в фон:

- загрузка событий из интеграций по расписанию;

- пересчёт после изменения правил (например, календаря или исключений);

- построение предагрегатов для дашбордов.

Очереди помогают «разгладить» пики и делают систему устойчивее к временным сбоям внешних API.

Кэширование и предрасчёт для быстрых дашбордов

Пользователь ожидает, что дашборд откроется за секунды. Для этого часто используют комбинацию:

- предрасчёт дневных/недельных агрегатов;

- кэш на уровне API (с учётом клиента и прав доступа);

- отдельные быстрые запросы для виджетов «текущий статус».

Наблюдаемость: чтобы SLA‑сервису доверяли

Добавьте базовую наблюдаемость с первого релиза: структурированные логи, метрики по импортам/очередям/ошибкам, трассировку ключевых запросов, а также журнал ошибок с привязкой к клиенту и интеграции. Это снижает время поиска причин, когда пользователи видят «не те цифры» и нужно быстро доказать, где произошёл разрыв в данных.

Как быстрее собрать MVP

Если задача — быстро проверить гипотезу (формулы, структуру данных, роли, формат отчёта) и показать первый прототип, удобно использовать TakProsto.AI. На платформе можно в режиме чата собрать веб‑приложение с личными кабинетами и базовыми дашбордами: фронтенд на React, бэкенд на Go с PostgreSQL, а затем при необходимости выгрузить исходники, подключить деплой/хостинг, настроить домен и откаты (snapshots/rollback). Это особенно полезно, когда нужно за 1–2 недели подготовить пилот для нескольких клиентов и параллельно уточнять требования к SLA‑правилам.

Качество данных, тестирование и надёжность

SLA‑отчётность ломается не из‑за формул, а из‑за «грязных» входных событий: пропущенных статусов, разъехавшихся таймзон, дублей и поздних обновлений. Поэтому надёжность системы начинается с дисциплины данных и проверок на каждом шаге — от импорта до вывода отчёта.

Разделение окружений и тестовые данные

Разведите dev/stage/prod не только по инфраструктуре, но и по правилам доступа к данным. В dev используйте синтетические наборы и анонимизированные копии, в stage — максимально близкие к продакшену объёмы, но без персональных данных, если это возможно.

Тестовые «клиенты» должны покрывать разные профили: круглосуточная поддержка, рабочие часы, разные часовые пояса, разные правила исключений (плановые работы, «заморозка» на ожидании клиента).

Проверки качества данных

Минимальный набор автоматических проверок перед расчётом:

- Пропуски и дыры во времени: инцидент создан, но нет события закрытия; отсутствуют переходы между статусами.

- Выбросы: отрицательная длительность, нереалистично длинные паузы, «закрыт раньше, чем открыт».

- Несоответствие таймзон: события в UTC, а расписание клиента в местном времени; переход на зимнее/летнее время.

- Дубли и рассинхрон: повторные вебхуки, частичные обновления, разные идентификаторы для одного и того же тикета.

Ошибки важно не «чинить молча»: сохраняйте исходное событие, помечайте проблему флагом качества и показывайте её в техотчёте для администраторов.

Тестирование формул SLA

Проверяйте расчёты на контрольных наборах: небольшой «эталонный» датасет с вручную посчитанными результатами. Отдельно заведите кейсы спорных инцидентов: переходы статусов в нерабочее время, перекрывающиеся паузы, переоткрытия, частичное выполнение SLA по нескольким целям. Полезен подход «golden tests»: одно изменение формулы — и сравнение с ожидаемыми значениями по всем сценариям.

Производительность и надёжность

Нагрузочно тестируйте два узких места: импорт (пики вебхуков/пакетная выгрузка) и тяжёлые отчёты (агрегации за квартал по множеству клиентов). Закладывайте лимиты, кэширование и предагрегации там, где пользователю нужен быстрый ответ.

Резервное копирование и восстановление

Регулярные бэкапы базы и хранилища событий дополняйте проверками восстановления: раз в месяц поднимайте копию и прогоняйте расчёт SLA, чтобы убедиться, что восстановление реально работает. Зафиксируйте RPO/RTO и храните «плейбук» действий на инцидент — кто, что и в каком порядке делает.

Конфиденциальность, аудит и соответствие требованиям

Автоматизируйте ежемесячные отчёты

Подготовьте шаблоны PDF и CSV с блоком «как посчитано» и списком исключений.

SLA‑отчётность быстро превращается в «витрину доверия»: клиенты смотрят не только на цифры доступности, но и на то, как вы обращаетесь с данными. Поэтому требования к конфиденциальности лучше заложить в продукт сразу, а не «докручивать» перед аудитом.

Шифрование и управление секретами

Шифруйте данные в транзите (TLS) и в хранении (например, на уровне дисков/базы). Для ключей и токенов интеграций используйте централизованное хранилище секретов, а не переменные в коде или конфиги в репозитории.

Разделяйте секреты по средам (dev/stage/prod), ограничивайте доступ по принципу минимальных привилегий и регулярно ротируйте ключи. Для внешних интеграций удобны короткоживущие токены и отдельные сервисные аккаунты на каждого арендатора.

Политики хранения и «право на удаление»

Определите сроки хранения сырых событий и агрегатов SLA: сырые логи обычно нужны недолго, а агрегированные показатели — дольше для сравнения периодов.

Продумайте:

- архивирование (дешёвое хранилище, недоступное из UI по умолчанию);

- автоматическое удаление по расписанию;

- удаление по запросу клиента (с фиксацией в аудите и с понятными последствиями для исторических отчётов).

Минимизация персональных данных

Если персональные данные не влияют на расчёт SLA, не тяните их в витрину. Чаще всего достаточно идентификаторов тикетов/инцидентов и технических атрибутов (время, сервис, приоритет). Если имена/почта всё же нужны, используйте маскирование в интерфейсе и раздельные права на просмотр.

Журнал аудита и соответствие требованиям

Сделайте аудит «первоклассной» сущностью: фиксируйте входы, попытки доступа, экспорты, изменения правил расчёта SLA и любых исключений (например, согласованные окна работ). Логи аудита должны быть неизменяемыми и иметь отдельные сроки хранения.

Для запросов клиентов подготовьте пакет подтверждений: перечень контролей, описание потоков данных, матрицу доступов, процедуры реагирования на инциденты и шаблоны документов. Удобно вести это в отдельном разделе, например /security, и обновлять вместе с релизами продукта.

Внедрение, миграция и план развития

У SLA‑отчётности высокий риск «споров о калькуляторе»: если расчёты и формат отчёта не совпадут с ожиданиями клиента, доверие к системе падает сразу. Поэтому внедрение лучше строить как управляемый проект с пилотом, прозрачной миграцией и заранее согласованными критериями успеха.

Пилот на 1–2 клиентах

Начните с пилота на одном «простом» и одном «требовательном» клиенте. Цель — не покрыть все кейсы, а подтвердить корректность формул (окна обслуживания, исключения, правила округления) и договориться о форматах: что считается инцидентом, какие периоды показываем, как выглядят комментарии к отклонениям.

Миграция и сверка исторических данных

Исторические данные полезны, чтобы сразу показать динамику и снять вопросы к новым отчётам. Загружайте историю порциями (например, последние 3–6 месяцев), фиксируйте источники и делайте сверку с прежними отчётами: выборочно по датам, сервисам и «крайним» случаям (пограничные интервалы, пересекающиеся инциденты). Любые расхождения оформляйте как правила: что именно меняем — данные или формулу.

Обучение и поддержка пользователей

Сработают короткие материалы: 1–2 страницы «как читать отчёт», памятка по ролям и правам, FAQ по частым вопросам. Хорошая практика — встроенные подсказки в интерфейсе и шаблоны комментариев к инцидентам.

Метрики успеха и план развития

Метрики внедрения можно измерять просто: меньше времени на подготовку отчёта, снижение числа спорных кейсов, быстрее реакция на риск нарушения SLA.

Дальше систему логично развивать в сторону прогнозирования (риск нарушения до конца месяца), сценариев улучшения (что даст сокращение MTTR) и каталога сервисов с едиными определениями SLA. Это позволяет перейти от «отчётности ради отчётности» к управлению качеством сервиса.

Если вы делаете продукт под российский контур и важны требования к данным, заранее продумайте размещение и стек: TakProsto.AI, например, работает на серверах в России, использует локализованные/opensource LLM‑модели и не отправляет данные в другие страны. На практике это упрощает прохождение внутренних проверок безопасности ещё на этапе пилота, а дальше можно выбрать подходящий тариф (free/pro/business/enterprise) и масштабировать решение по мере роста числа клиентов.

FAQ

С чего начать проект SLA‑отчётности, чтобы потом не спорить о цифрах?

Начните с фиксации методики в виде «справочника правил»:

- что считается инцидентом и простоем;

- какие исключения применяются (плановые работы, внешние провайдеры, клиентская сеть);

- какие единицы, таймзона, рабочий календарь и округление.

Пока правила не формализованы, любые дашборды будут воспроизводить разные трактовки.

Какие SLA/KPI лучше включить в первую версию приложения?

Минимально практичный набор — 3–5 метрик, привязанных к договору:

- доступность (Availability, %);

- время реакции (Response Time / MTTA);

- время восстановления (MTTR / Restore Time);

- количество нарушений и «стоимость» простоя (минуты сверх лимита).

Важно сразу указать, какие метрики считаются 24×7, а какие — в рабочих часах.

Как правильно учесть часовые пояса и рабочие календари в SLA?

Это «главный источник расхождений». Зафиксируйте:

- таймзону на уровне клиента/контракта;

- календарь рабочих дней/праздников и исключений;

- правило обработки переходов через границы периода (месяц/квартал).

И храните версию календаря вместе с версией правил, чтобы отчёты за прошлые месяцы не «пересчитывались задним числом».

Какой подход к мультиарендности выбрать: отдельная БД или общий кластер?

Есть два базовых варианта:

- отдельная база данных на клиента — проще изоляция и удаление данных, но дороже сопровождение и миграции;

- общий кластер с разделением по

tenant_id— дешевле и быстрее развивать, но требует строгой защиты на всех слоях.

На практике часто начинают с общего кластера и усиливают контроль: глобальные фильтры, политики на уровне БД и проверки в API.

Как избежать утечек данных между клиентами в отчётах и API?

Используйте несколько барьеров одновременно:

tenant_idво всех «арендных» сущностях и неизбежная фильтрация;- Row Level Security/политики доступа в БД (где применимо);

- привязка пользователя к организациям и проверка соответствия токена/организации в API.

Дополнительно полезны авто‑тесты, которые проверяют, что любой эндпоинт возвращает данные только своего арендатора.

Какие источники данных лучше использовать для расчёта SLA и почему?

Соберите факты из нескольких источников и нормализуйте их:

- мониторинг — точные таймстемпы начала/конца деградации;

- тикет‑система — коммуникации, статусы, приоритеты для MTTA/MTTR;

- статус‑страницы — публичное подтверждение и время объявления;

- ручные корректировки — только по ролям и обязательно с аудитом.

Ключевой слой — маппинг статусов/приоритетов/сервисов в единый словарь.

Как обрабатывать дубли, массовые инциденты и пересечения событий из разных систем?

Закладывайте правила корреляции заранее:

- связывание по сервису/компоненту + временное окно;

- использование корреляционного ключа (если есть) и связей «родитель/дочерний»;

- идемпотентный импорт: повторная загрузка того же периода не должна удваивать записи.

Обязательно ведите журнал импорта: источник, диапазон времени, количество записей, ошибки, версия маппингов.

Какую модель данных заложить, чтобы расчёты SLA были воспроизводимыми?

Практичный минимум — разделить хранение на два слоя:

- raw‑слой: неизменяемые события «как пришли» (только добавление);

- report‑слой: агрегаты для дашбордов (downtime, availability, нарушения), пересчитываемые по версии правил и фиксируемые на момент публикации.

Так любое число можно «развернуть» до исходных событий и понять, где появилась разница.

Что именно нужно логировать для аудита изменений и доверия к отчётности?

Сделайте аудит «первоклассной» функцией:

- кто, что и когда изменил (старое/новое значение);

- почему (комментарий/ссылка на тикет);

- какая версия правил и календаря применялась при пересчёте.

Это помогает объяснять расхождения между черновыми и финальными отчётами и выдерживать проверку безопасности.

Какие дашборды и элементы отчёта действительно нужны в SLA‑приложении?

Ориентируйтесь на два вопроса пользователя: «где мы относительно цели?» и «почему так вышло?»

- сводка по клиентам/сервисам с статусом (норма/риск/нарушение) и фильтрами;

- карточка клиента с трендами и вкладом сервисов в простой;

- детализация до таймлайна инцидентов и их влияния на итоговую метрику;

- блок «как посчитано»: формула, период, таймзона, округление, исключения и ссылки на первичные записи.

Экспорт (PDF/CSV) лучше делать по шаблонам и давать ссылку на онлайн‑версию вида /reports/2025-11/client-123.