18 окт. 2025 г.·8 мин

Как выбор модели данных фиксирует архитектуру на годы вперёд

Как выбор модели данных фиксирует интеграции, хранилища и способы разработки на годы вперёд. Практики, которые снижают риск архитектурной «привязки».

Как выбор модели данных фиксирует интеграции, хранилища и способы разработки на годы вперёд. Практики, которые снижают риск архитектурной «привязки».

Выбор модели данных часто воспринимают как «техническую деталь»: главное — запустить продукт, а потом «как‑нибудь поправим». На практике именно модель (сущности, поля, типы, ключи, связи, правила) становится одним из самых устойчивых решений в системе — потому что к ней начинают привязываться люди, процессы и другие сервисы.

«Привязка» — это рост цены изменений со временем. В начале изменить таблицу или документ просто: правите схему и пару запросов. Но чем успешнее система, тем больше вокруг неё появляется зависимостей: отчёты, интеграции, API, ETL/ELT, проверки качества данных, права доступа, кеши, поисковые индексы.

В какой-то момент вы меняете не «поле в базе», а целую экосистему ожиданий.

Решение «на сейчас» оптимизирует скорость разработки и локальное удобство: добавить поле без ограничений, хранить «как пришло», не думать о версиях. Это помогает стартовать, но создаёт долг, который начинает «капать проценты» после появления первых внешних потребителей данных.

Решение «на годы» исходит из того, что модель живёт дольше, чем конкретный код. Оно заранее думает о границах ответственности, стабильных идентификаторах, понятных контрактах и о том, как модель будет эволюционировать без массовых поломок.

Допустим, поле status в заказе переименовали в state или поменяли значения с NEW/PAID на created/paid. В базе вы это мигрируете быстро. Но дальше ломаются:

status;И даже если всё «починить», остаётся риск скрытых ошибок: часть потребителей обновилась, часть — нет.

Дальше разберём, где именно возникает этот «замок», какие решения особенно трудно откатывать, и какие практики (контракты, версионирование, миграции с путём назад) помогают выбрать более гибкий путь — без иллюзии, что модель можно менять без последствий.

Схема базы данных редко остаётся внутренним делом команды, которая её придумала. Она быстро обрастает зависимостями — и в какой-то момент любое изменение начинает ощущаться как переезд: дорого, долго и со множеством заинтересованных.

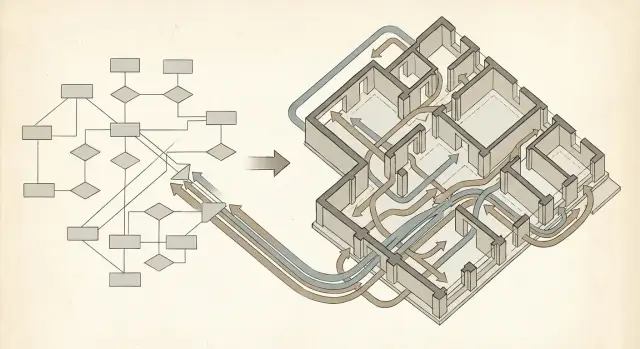

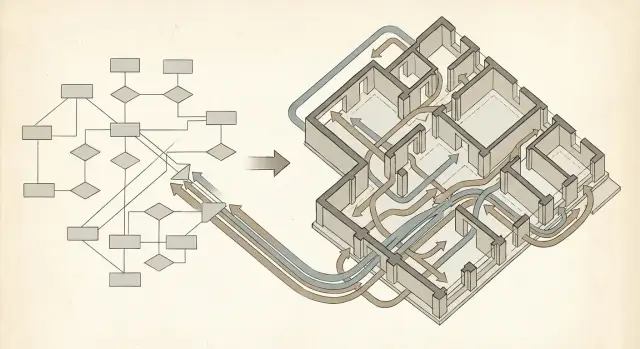

Обычно «замок» формируется по простой цепочке: БД → сервисы → интеграции → BI/аналитика.

Сначала сервисы жёстко привязываются к структуре таблиц: названия колонок, типы, обязательность полей, связи. Затем появляются интеграции — обмен с CRM, бухгалтерией, маркетингом, шинами данных или просто регулярные выгрузки партнёрам. После этого BI и аналитика закрепляют схему окончательно: отчёты, витрины, дашборды, KPI и регламентная отчётность начинают ожидать «вот такие» поля и «вот такие» связи.

Чем дальше по цепочке, тем дороже «невидимые» зависимости: даже если вы поменяли поле внутри, сломаться может внешний отчёт или загрузка, о которой разработчики узнают в конце месяца.

Частая причина привязки — схема проще всего доступна. Люди начинают считать таблицы первоисточником, потому что:

В итоге база превращается в неофициальный контракт, хотя никто формально не обещал его стабильность.

Партнёры, регуляторная отчётность, выгрузки в сторонние системы и даже Excel-процессы внутри компании создают дополнительные ожидания. У таких потребителей часто нет гибкости: им нужен фиксированный формат и предсказуемые сроки.

Если изменения схемы требуют согласования с множеством команд (и это стало нормой), значит «замок» уже сформирован. В этот момент любые улучшения модели данных нужно планировать как продуктовую миграцию: с коммуникацией, версионированием и периодом совместимости, а не как «быструю правку в таблице».

Доменная модель — это «карта реальности» вашего бизнеса: сущности, правила, роли и термины, которыми пользуются люди. Модель хранения (физическая схема БД) — это «карта склада»: как именно данные разложены по таблицам, индексам и ключам, чтобы система работала быстро и надёжно.

Проблема начинается, когда эти уровни смешивают и пытаются буквально «сделать как в бизнесе» прямо в таблицах. На бумаге это выглядит естественно: «Клиент», «Договор», «Сделка», «Статус». Но в операционных системах и интеграциях важны компромиссы: производительность, транзакционность, история изменений, требования отчётности и права доступа. Доменные понятия меняются чаще, чем удачная физическая структура.

Бизнес-термины неоднозначны: «клиент» может означать плательщика, пользователя сервиса или юридическое лицо. Если вы зафиксировали это одним названием таблицы и связями, дальше вы вынуждены либо «ломать» схему, либо плодить костыли вроде client_type, множества nullable-полей и исключений в коде.

Ещё хуже — когда процессы «зашиваются» в связи: например, одна жёсткая цепочка Order → Invoice → Payment предполагает единственный путь оплаты, а новые сценарии (частичные оплаты, возвраты, предоплаты) превращаются в боль.

Имена таблиц/полей, первичные и внешние ключи, обязательность связей — это не просто техника. Это публичное обещание всем потребителям данных (разработчикам, аналитикам, интеграциям) о том, «как устроен мир». Меняя их, вы меняете язык и правила игры.

Практический совет: ведите явный словарь/глоссарий домена рядом с моделью (в репозитории или в wiki) и фиксируйте определения, синонимы и границы сущностей. Тогда физическая схема сможет эволюционировать, не переписывая каждый раз смысл терминов.

Нормализация и денормализация часто обсуждаются как «скорость против порядка», но на практике это ещё и выбор того, насколько легко система будет меняться через год-два. Ошибка здесь редко выглядит критичной в момент запуска — она становится заметной, когда растут нагрузки, команды и число интеграций.

Нормализованная схема (разделение сущностей на таблицы без дублирования) обычно выигрывает там, где важны корректность и предсказуемые изменения.

Она облегчает:

Но у нормализации есть цена: чтение становится сложнее. Отчёты и экраны «всё про клиента» превращаются в цепочки JOIN-ов, растёт нагрузка на базу и сложнее кешировать результаты (слишком много «источников истины» для одного ответа).

Денормализация ускоряет чтение: данные лежат «готовыми» для конкретного запроса. Это полезно для витрин, списков, поисковых выдач, API-ответов.

Проблема — риск рассинхронизации. Как только одно и то же значение хранится в двух местах, появляется вопрос: кто обновляет копии, в каком порядке и что делать при сбое? Чем больше микросервисов, тем чаще денормализация приводит к скрытым зависимостям: один сервис меняет «источник», а другой продолжает читать устаревшую копию из своей базы или кэша.

Хороший компромисс — держать «модель для записи» ближе к нормализованной (чёткие правила и транзакции), а «модель для чтения» строить как отдельные проекции: кеш, поисковый индекс, аналитическая витрина.

Так вы упрощаете основной контур изменений и одновременно позволяете аналитике и интерфейсам работать с удобными денормализованными представлениями — не превращая каждую таблицу в компромисс для всех сценариев сразу.

Ключи и связи — это не просто «технические детали». Они определяют, как системы будут ссылаться друг на друга, как будут проходить миграции, и насколько болезненно вы переживёте изменения бизнес-правил через год или пять.

Суррогатный ключ (например, id как UUID/sequence) обычно не несёт бизнес-смысла. Его главный плюс — он стабилен и не меняется, поэтому проще:

Естественный ключ (email, номер договора, артикул) «закрепляет» бизнес-правило прямо в схеме. Это удобно на старте: меньше полей, проще искать. Но вы платите за это позже: как только правило меняется, меняется и ключ, а значит — все внешние ссылки, интеграции, кеши, отчёты.

Практическая стратегия: держать суррогатный ключ как первичный, а естественные значения — как уникальные атрибуты с ограничениями (UNIQUE) и явной историей изменений при необходимости.

Email, телефон, номер договора, паспортные данные — всё это может измениться из‑за ошибок, переоформлений, смены политики нумерации или требований регулятора. Если такой идентификатор стал первичным ключом, вы получаете каскадный ремонт: обновления в десятках таблиц, риск рассинхронизации и долгие блокировки.

Если бизнес требует «читаемых» ID, лучше разделять:

Каскадные операции (ON UPDATE/DELETE CASCADE) выглядят как экономия времени, но они могут неожиданно:

Рекомендации:

RESTRICT/NO ACTION) и «мягкое удаление» по статусу, если это соответствует домену;Желание «не думать о схеме» часто приводит к двум популярным решениям: хранить всё в одном JSON-поле или складывать атрибуты в EAV (Entity–Attribute–Value: объект—параметр—значение). На старте это выглядит как скорость: добавили новое свойство — просто записали ещё один ключ или строку. Но со временем такая гибкость превращается в долг.

Когда у сущности десятки разных типов и вариантов, возникает соблазн сделать «универсальную» таблицу: базовые колонки + одно большое поле properties (JSON). Или ещё хуже — одна таблица на всё с колонками «на всякий случай». Итог один: структура данных перестаёт быть видимой.

Оправдано:

Плохо подходит:

Главная издержка — контроль качества переезжает из базы в код и процессы.

Валидация. Ограничения уровня БД (NOT NULL, CHECK, FK) либо не работают, либо становятся сложными и выборочными. Ошибки находят поздно — в отчётах и интеграциях.

Поиск и индексация. Можно индексировать отдельные JSON-пути, но это быстро превращается в «зоопарк» индексов и нестабильную производительность. В EAV фильтры и агрегации часто требуют множественных self-join и начинают тормозить в самые неподходящие моменты.

Отчётность. BI-инструментам и аналитикам нужны явные колонки. Полуструктура приводит к постоянному «расплющиванию» данных, разным трактовкам одних и тех же ключей и сложному контролю версий.

Практичный подход — разделить данные на «ядро» и «расширения».

Так вы сохраняете скорость изменений, но не теряете управляемость схемы и предсказуемость для потребителей данных.

OLTP и аналитика решают разные задачи — и из‑за этого плохо уживаются в одной и той же модели данных.

Операционная БД (OLTP) оптимизирована под частые короткие операции: создать заказ, обновить статус, списать остатки. Здесь важны целостность, блокировки, индексы под точечные запросы и минимальная задержка. Модель обычно ближе к нормализованной: много таблиц, чёткие связи, понятные ограничения.

Аналитика (OLAP) про другое: посчитать выручку по каналам за год, построить когорты, сравнить недели, разложить показатели по десяткам разрезов. Такие запросы читают много данных сразу и регулярно «сканируют» большие диапазоны. Для этого часто нужна денормализация, агрегаты, звёздные схемы и отдельные структуры под вычисления.

Когда BI, выгрузки или внешние потребители читают данные напрямую из продовой OLTP‑схемы, схема превращается в публичный контракт. Любая миграция таблиц, переименование колонок или даже изменение смысла поля начинает ломать отчёты. Команда разработки вынуждена подстраивать продуктовую модель под запросы аналитиков, а аналитики — под технические детали транзакционной схемы. В результате:

Практичный компромисс — выделить отдельный аналитический контур: например, staging → витрина (data mart). В staging вы привозите «как есть» события/снимки из OLTP, а в витринах формируете удобные таблицы под отчёты и метрики. Так операционная модель остаётся чистой, а аналитическая — управляемой и версионируемой.

Если вы выбираете между хранилищем и озером данных, полезно сравнить подходы отдельно: /blog/data-warehouse-vs-data-lake.

Модель данных редко живёт только внутри одной базы. Её читают сервисы, отчёты, интеграции, BI-инструменты, партнёрские выгрузки, иногда — пользовательские SQL-запросы. Как только кто-то начинает «надеяться» на конкретные поля, типы и правила заполнения, схема превращается в контракт.

Контракт — это не только список колонок. Это ещё и смысл: какие значения допустимы, что означает NULL, какие поля обязательны, как формируются идентификаторы, какие записи считаются актуальными.

Полезная привычка — явно перечислять потребителей и сценарии: API, события, витрины, прямой доступ к таблицам, файлы в хранилище. У каждого канала свой риск: прямой доступ к таблицам обычно ломается быстрее всего.

Безопаснее всего добавлять новое: новые поля, новые таблицы/представления, новые версии сообщений. Опасные изменения — смена типа, переименование и удаление.

Практика: вместо переименования «в лоб» добавьте новое поле, начните писать в оба, переведите чтение, и только затем уберите старое по сроку деприкации. Для типов — аналогично: заведите новое поле (amount_minor вместо amount), мигрируйте данные и потребителей.

Планируйте изменения так, чтобы старые потребители продолжали работать: значения по умолчанию, толерантный парсинг, неизменность смыслов. Если изменение несовместимо — делайте новую версию контракта (например, v2), а старую поддерживайте параллельно ограниченное время.

Чтобы это не было «договорённостью в чате», заведите:

Так схема перестаёт быть источником сюрпризов и становится управляемой частью архитектуры.

Схема базы данных редко «застывает» навсегда: появляются новые продукты, меняются требования регуляторов, растут объёмы. Ошибка в ожиданиях обычно одна — воспринимать миграцию как набор SQL-скриптов. На практике это цепочка изменений: код приложений, фоновые джобы, отчёты BI, выгрузки в партнёрские системы, API-контракты, алерты и даже инструкции поддержки.

Если вы переименовали поле или вынесли атрибут в отдельную таблицу, то сломаться может не база, а потребитель: старый отчёт, интеграция через ETL, мобильное приложение, которое обновится позже, или внешняя система, у которой релиз раз в квартал. Поэтому план миграции должен начинаться не с DDL, а с карты зависимостей и списка потребителей.

Самый безопасный подход — расширение-сжатие (expand/contract):

Для систем с высокой нагрузкой часто нужна двойная запись: временно пишете данные в старую и новую схему, чтобы избежать сложного «окна переключения». Бэкфилл при этом лучше делать идемпотентным и возобновляемым, с чёткими чекпоинтами.

Кстати, если вы разворачиваете новый сервис и хотите безопаснее переживать итерации схемы на ранней стадии, полезны механики «снимков» и отката окружений. В TakProsto.AI это встроено на уровне платформы (snapshots и rollback), что упрощает эксперименты с архитектурой данных, пока контракт ещё не стал публичным.

Стоимость миграции определяется не «сложностью SQL», а параметрами:

План отката должен быть реальным: какие версии кода совместимы, как возвращаетесь на старые поля, что делаете с данными, записанными в новом формате.

После миграции включайте наблюдаемость качества данных: доля NULL в новых колонках, расхождения между старым и новым источником, количество «осиротевших» связей, задержка бэкфилла, ошибки валидации. Метрики и выборочные сверки — единственный способ понять, что «переехали» не только схемой, но и смыслом.

Схема фиксирует не только то, как вы храните данные, но и то, как вы делитесь ими с другими системами. Как только вокруг базы появляются подписчики (аналитика, интеграции, витрины, антифрод), любая структурная правка превращается в риск: вы меняете не таблицу — вы меняете «источник правды» для экосистемы.

Таблицы состояния удобны: в них лежит «как сейчас». Но они плохо отвечают на вопросы «как мы сюда пришли?» и «что изменилось?». Поэтому рядом часто появляется журнал: таблица аудита, append-only лог или отдельная шина.

Журнал событий хранит факты (создано, оплачено, отменено) в порядке времени. Это даёт воспроизводимость и возможность строить новые проекции без переписывания истории. Цена — дисциплина в моделировании событий и необходимость поддерживать проекции (read-модели) для быстрого чтения.

Event sourcing обещает гибкость: добавили новый сервис — он может «проиграть» события и построить своё представление. Плюсы:

Минусы:

CDC (change data capture) считывает изменения из журнала транзакций и публикует их наружу (например, в очередь). Это быстро даёт поток данных без переписывания приложения, но создаёт новую привязку: потребители начинают зависеть от структуры таблиц, типов полей и даже нюансов транзакций.

Если вы используете CDC, старайтесь не отдавать «сырые» изменения таблиц как публичный API. Введите слой публикации: доменные события (например, OrderPaid) формируются из внутренних изменений и версионируются отдельно. Тогда вы сможете менять таблицы, не ломая подписчиков, а поток останется стабильным контрактом.

Эта часть — про практику: какие вопросы задать до того, как вы «закрепите» схему в коде, интеграциях и отчётах. Цель — выбрать модель, которую можно развивать, не превращая каждое изменение в проект на месяцы.

Перед тем как рисовать таблицы и связи, зафиксируйте ответы:

Хорошая модель данных обычно узнаваема по последствиям:

NULL.Достаточно трёх вещей, чтобы снизить риск «замка»:

Если вы делаете продукт «с нуля», важно не только выбрать схему базы данных, но и быстро проверять гипотезы, не загоняя себя в невозвратные решения. В этом помогает TakProsto.AI: как vibe-coding платформа она позволяет собирать веб/серверные и мобильные приложения через чат, при этом типовой стек (React на фронтенде, Go + PostgreSQL на бэкенде, Flutter для мобайла) хорошо ложится на практики архитектуры данных из этой статьи. На позднем этапе можно экспортировать исходники и продолжить развитие в своей инфраструктуре.

Если вы хотите быстро пройти этот путь с командой и закрепить результат в процессе поставки (ревью, тесты, версионирование контрактов), обсудим формат — /contact или посмотрите варианты сопровождения на /pricing.

«Замок» — это рост стоимости изменений: чем больше вокруг схемы появляется потребителей, тем больше мест нужно синхронно обновлять.

Обычно привязки приходят из:

Сделайте быстрый инвентаризационный «паспорт поля/таблицы» перед изменением:

NULL).После этого любое изменение планируйте как миграцию с периодом совместимости, а не как «правку в БД».

Потому что транзакционная схема почти неизбежно становится «неофициальным контрактом»: её легко подключить, но она не предназначена для стабильного внешнего потребления.

Практичный подход:

Доменная модель описывает смысл и правила бизнеса, а модель хранения — компромиссы ради надёжности и скорости (индексы, транзакции, история, права доступа).

Чтобы не смешивать уровни:

NULL, единицы измерения, допустимые статусы);Почти всегда безопаснее: суррогатный первичный ключ стабилен и не зависит от изменений бизнес-правил.

Рекомендованный шаблон:

id (UUID/sequence) — первичный ключ и основа связей;UNIQUE и валидацией;Так вы избегаете каскадных перелинковок при изменении «читаемого» идентификатора.

CASCADE экономит время на старте, но может создать неожиданные эффекты: массовые удаления/обновления, долгие блокировки и «исчезающие» для потребителей записи.

Практика для критичных сущностей:

RESTRICT/NO ACTION для удаления;Оправдано, если:

Плохо подходит для:

Используйте принцип совместимости назад:

v2 (API/событий/представлений) и поддерживайте v1 ограниченное время.Полезные «артефакты процесса»:

Самый надёжный паттерн — expand/contract:

Если нужна бесшовность — временная двойная запись. Обязательно заранее продумайте откат: какие версии кода совместимы и что делать с данными, уже записанными в новом формате.

CDC быстро даёт поток изменений, но подписчики начинают зависеть от внутренних таблиц: названий колонок, типов и даже нюансов транзакций.

Чтобы снизить привязку:

OrderPaid) с отдельным версионированием;Так вы сможете менять внутреннюю схему, не ломая подписчиков и витрины.

Компромисс: «ядро» в явной схеме + расширения в JSON/EAV, но со списком разрешённых ключей, типами и версией.