29 окт. 2025 г.·8 мин

Какие обязанности разработчика заменяет ИИ, а какие нет

Практичный разбор задач разработчика: что ИИ реально берёт на себя, где ускоряет работу, а где почти не помогает. Примеры из команд и чек‑лист внедрения.

Практичный разбор задач разработчика: что ИИ реально берёт на себя, где ускоряет работу, а где почти не помогает. Примеры из команд и чек‑лист внедрения.

Цель этой статьи — трезво понять, какие обязанности разработчика ИИ действительно способен взять на себя, где он становится «усилителем», а где почти не помогает. Без хайпа и без страшилок: в реальных командах эффект измеряется не обещаниями, а изменением скорости, качества и рисков.

Важно сразу оговориться: результат зависит от контекста. На него влияют домен (финансы, медицина, e-commerce и т. п.), зрелость процессов, качество документации, наличие тестов, стиль ревью, а также доступ ИИ к данным (можно ли показывать код, логи, требования, тикеты). Один и тот же инструмент в стартапе без регламентов и в продуктовой команде с CI/CD даст разный итог.

Отдельный фактор — где именно живёт ИИ и как устроена работа с кодом и данными. Например, для российского рынка часто важно, чтобы сервис работал на инфраструктуре в России и позволял контролировать жизненный цикл результата: экспорт исходников, деплой, откат. В этом смысле полезно смотреть на платформы вроде TakProsto.AI: это vibe-coding подход (создание web/server/mobile приложений через чат), с опциями планирования, снапшотов и rollback, и с фокусом на локальную инфраструктуру.

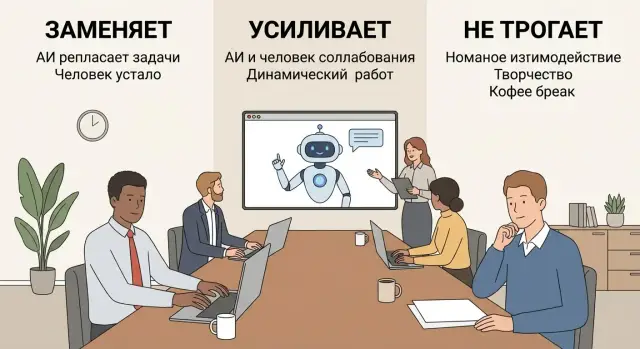

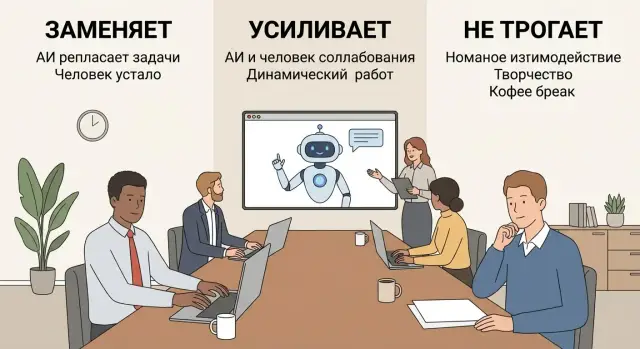

Заменяет — когда задача выполняется ИИ целиком с минимальным человеческим участием: человек скорее принимает результат или отклоняет его. Типичный критерий: можно стандартизировать входные данные и проверку выхода.

Усиливает — когда ИИ ускоряет работу, предлагает варианты, снижает рутину, но ключевые решения и ответственность остаются у разработчика. Критерий: нужен контекст продукта, компромиссы, понимание последствий.

Не трогает — когда ИИ либо бесполезен, либо потенциально опасен: цена ошибки высока, а проверка результата сложнее, чем сделать руками.

Далее мы разложим обязанности по типам: где ИИ заменяет полностью, где помогает, а где не закрывает потребность. По ходу будут практические риски (качество, безопасность, соответствие) и рекомендации по внедрению: пилот, метрики, правила работы и точки контроля — чтобы улучшения были измеримыми, а не «кажется, стало быстрее».

Чтобы трезво оценивать влияние ИИ, полезно разложить работу разработчика не по «языкам и фреймворкам», а по потоку ценности: требования → дизайн → реализация → проверка → релиз → сопровождение. Тогда видно, что ИИ может ускорять отдельные шаги, но не «делает продукт» целиком.

Разработчик участвует в прояснении целей, ограничений и критериев успеха: что именно должно измениться для пользователя, какие данные и интеграции затронем, что может пойти не так.

ИИ помогает быстро набросать вопросы к заказчику, составить черновик user story или чек‑лист допущений. Но ответственность за то, что задача понята верно, остаётся у команды: неправильная постановка превращает любой автогенерированный код в дорогую ошибку.

Здесь появляются решения о структуре: какие модули затрагиваем, как храним данные, какие API меняем, как обеспечиваем производительность и отказоустойчивость.

ИИ может предложить варианты и сравнение подходов, но не видит весь контекст — договорённости команды, «историю» системы, реальные ограничения инфраструктуры. Поэтому финальное решение — это выбор человека и команды.

Это наиболее «заменяемая» часть: генерация шаблонного кода, миграций, преобразований данных, типовых обработчиков, документации. Но даже здесь работа разработчика — не только написать строки, а встроить изменение в существующую систему: соблюсти стиль, договорённости, совместимость и читабельность.

Проверка включает тесты, диагностику, воспроизводимость багов и анализ регрессий. ИИ ускоряет подготовку тест‑кейсов и подсказки по краевым случаям, но не снимает обязанность обеспечить качество: «автоматизировали тест» не равно «снизили риск».

После выкладки начинается главное: мониторинг, алерты, инциденты, обратная связь пользователей, доработка по реальным сценариям. ИИ может помочь быстро разобрать логи или составить план расследования, но не несёт ответственности за решения, сроки и последствия.

Главная мысль: автоматизация одного шага ускоряет поток, но не отменяет ответственности команды за результат и влияние на пользователей.

Есть набор работ, где ценность разработчика — не в уникальном решении, а в скорости и аккуратности исполнения по понятному шаблону. В таких местах ИИ действительно может «закрыть» задачу почти целиком: вы формулируете требования и критерии, а дальше остаётся лишь проверить результат и встроить его в проект.

ИИ хорошо справляется с типовыми адаптерами, мапперами, простыми CRUD-операциями, повторяющимися слоями «получить данные → провалидировать → сохранить → вернуть ответ». Особенно когда структура уже принята в проекте, а задача — воспроизвести её ещё раз.

Почему это работает:

ИИ часто полностью пишет основу тестов: «успешный кейс», «пустой ввод», «невалидное значение», «нет прав доступа» — если правила явно сформулированы. Это экономит часы на механике.

Важно: такие тесты обычно хороши как стартовый слой. Их всё равно нужно прогнать, подогнать под реальные фикстуры и добавить проверки именно тех рисков, которые важны бизнесу.

Если вы точно задали действие — переименовать сущности, вынести функцию, убрать дублирование, упростить условие, привести стиль к договорённостям — ИИ делает это быстро и ровно. Это тот случай, когда «подумать» уже почти не нужно, а нужно аккуратно применить правило ко всему коду.

Небольшие утилиты, простые компоненты, чистые функции без сложных зависимостей ИИ переносит довольно надёжно. Чем меньше проектных особенностей (сборка, окружение, сторонние SDK, тонкие контракты), тем ближе результат к «готово сразу».

По уже написанному модулю ИИ способен собрать понятный черновик: что делает компонент, какие входы/выходы, где лежат ключевые файлы, примеры вызова. Это особенно полезно для README и внутренних заметок, которые иначе откладываются «на потом».

Общий принцип: ИИ заменяет разработчика там, где задача сводится к воспроизводству известного решения, а не к выбору правильного решения.

ИИ лучше всего работает как «второй пилот»: он ускоряет подготовительные этапы, помогает перебрать варианты и снять часть рутины. Но ответственность за корректность, целостность решения и последствия изменений остаётся на разработчике — потому что ИИ не видит весь контекст продукта, ограничений команды и реального поведения системы.

При доработке функциональности ИИ может накидать черновой код, предложить структуру модулей, подсказать типовые паттерны и даже учесть часть требований из описания. На практике всё упирается в уточнения: крайние случаи, миграции данных, обратная совместимость, договорённости по стилю, нюансы доменной логики.

Разработчик всё равно:

ИИ удобен для экспресс-обзора: сравнить API нескольких библиотек, накидать варианты интеграции, получить пример запроса/ответа, узнать типичные подводные камни. Но любой совет нужно сверять с актуальной документацией и условиями проекта: лицензии, версии, политика безопасности, требования к хранению данных.

Когда падают тесты или сервис ругается в логах, ИИ неплохо расшифровывает сообщения, предлагает вероятные причины и последовательность проверки. Это экономит время на поиске, но не заменяет диагностику: гипотезы могут быть правдоподобными, но неверными именно для вашей конфигурации.

Генерация миграций, конфигов, скриптов сборки, шаблонных проверок, небольших утилит — тут ускорение заметнее всего. Важно, чтобы разработчик просматривал результат как чужой код: безопасность, идемпотентность, корректные значения по умолчанию, отсутствие скрытых зависимостей.

ИИ может сделать резюме обсуждения, черновик комментария к PR или список вопросов к постановщику задачи. Но финальный текст должен отражать позицию команды, а не «самую убедительную формулировку»: иначе легко зафиксировать неправильное решение красивыми словами.

ИИ умеет предлагать схемы, паттерны и даже «типовые» разбиения на сервисы. Но архитектура в реальной команде — это не угадывание правильного шаблона, а принятие решений под ограничения: бюджет, сроки, компетенции людей, текущая инфраструктура и риски. Эти вводные редко полностью присутствуют в запросе к ИИ, а иногда их нельзя раскрывать целиком.

Человек-архитектор (или ведущий разработчик) удерживает систему в динамике: что уже есть, что можно переиспользовать, какие интеграции «болят», где узкие места по поддержке.

ИИ может подсказать варианты, но не несёт ответственности за последствия — например, что новая технология увеличит стоимость найма, усложнит онбординг или потребует пересмотра мониторинга и процессов релизов.

Архитектурный выбор почти всегда компромисс. Ускорим систему — поднимем счета за инфраструктуру. Сэкономим — получим рост задержек или ограничения по отказоустойчивости. Упростим ради сроков — накопим технический долг.

ИИ хорошо перечисляет «плюсы/минусы», но плохо оценивает вес каждого фактора именно для вашей компании: что критичнее — SLA или себестоимость, скорость вывода фич или риск утечки, независимость команд или простота сопровождения.

Определение границ сервисов/модулей, контрактов и правил их изменения — это решение про организацию работы: кто владеет компонентом, как обновляются зависимости, как проводить миграции без остановок.

ИИ может предложить разрез «по доменам», но только люди знают, где реально проходят границы ответственности, какие команды взаимодействуют, и как часто меняются требования.

Оценить технический долг — значит понять, что ломается чаще всего, где скрытая стоимость поддержки и какие изменения лучше делать поэтапно. ИИ способен помочь составить план миграции, но приоритизация и порядок шагов зависят от контекста: текущие релизы, риски, договорённости со стейкхолдерами.

Главная причина, почему «правильный ответ» зависит от контекста: архитектура — это не только код, а система решений и ответственности, привязанная к людям и бизнесу.

ИИ неплохо генерирует тексты «как бы ТЗ», но чаще всего ошибается именно там, где нужна проверка реальностью: контекст продукта, ограничения команды и последствия для пользователей. Поэтому роль разработчика в постановке задач остаётся критичной — как у переводчика между бизнесом и техникой.

Типичная ловушка ИИ: он подменяет цель решением. «Добавим кнопку» звучит конкретно, но не отвечает на вопросы «зачем» и «как поймём, что получилось». Разработчик превращает пожелание в:

ИИ может предложить шаблон, но не гарантирует, что критерии действительно проверяемы и не конфликтуют с реальностью.

ИИ часто «додумывает» отсутствующие данные, уверенно предлагая варианты. На практике нужно вскрывать неоднозначности: права доступа, пограничные случаи, совместимость, миграции данных, нагрузка, юридические ограничения.

Хорошая постановка включает список открытых вопросов и допущений — иначе команда начнёт строить на песке.

Требования живут не в вакууме: продукт, дизайн, поддержка, безопасность и иногда финансы имеют разные приоритеты. ИИ не чувствует напряжения между ними и не несёт ответственности за компромисс.

Задача разработчика — синхронизировать ожидания и заранее договориться, что будет «достаточно хорошо» для релиза.

Когда решение принято, его важно закрепить: ADR, договорённости по API, план миграции, флаги, этапность. ИИ может помочь оформить документ, но именно разработчик отвечает за то, чтобы запись отражала реальное решение и его последствия.

Если хотите углубиться в практику фиксации решений, удобно завести короткий шаблон в /blog/adr-template.

ИИ в код-ревью полезен там, где нужна скорость и внимательность к «мелочам»: он быстро прочитает дифф, сверит его с правилами стиля и подскажет места повышенного риска. Но код-ревью — это не только про код: это про ответственность за изменение в продукте. Поэтому ИИ должен оставаться помощником, а не финальным арбитром.

Практичный сценарий — использовать ИИ как «предревью» перед тем, как PR увидят коллеги:

Важно: ИИ лучше работает, если ему дать контекст — шаблон PR, описание задачи и критерии готовности.

Финальное решение («мерджим или нет») и принятие риска всегда остаются за человеком. ИИ не несёт ответственности за продакшн-инциденты, регрессию, нарушение требований безопасности или несоответствие договорённостям с бизнесом.

ИИ может выдавать правдоподобную, но неверную критику (например, «улучшения» сложности, которые ломают читаемость), или пропускать смысловые ошибки в бизнес-логике: неверные статусы, границы периодов, валюты/округления, права доступа. Поэтому «похоже на правду» — не критерий.

Закрепите правила: ИИ пишет подсказки, а ревьюер проверяет. Удобно включить в шаблон PR поля: «что меняется», «риски», «как протестировано», «план отката». Обязательные проверки: линтеры/форматтер, тесты, статический анализ, безопасность (секреты, зависимости), миграции.

Отслеживайте не «сколько комментариев дал ИИ», а результаты: дефекты после релиза, среднее время ревью, долю откатов/горячих фиксов и процент PR, которые прошли без доработок. Если скорость растёт, а откаты и дефекты тоже — ИИ ускоряет, но качество падает, и процесс нужно корректировать.

ИИ действительно ускоряет тестирование, но чаще как «усилитель» рутинных шагов, а не как автор гарантированного качества. Самая большая ошибка — считать, что если тестов стало больше, то продукт стал надёжнее.

ИИ полезен там, где нужно быстро расширить варианты и не забыть очевидные вещи:

Это хорошо работает как стартовая точка: вы получаете черновик, который потом приводится к стандартам команды и встраивается в структуру проекта.

Качество определяется не количеством сценариев, а их важностью. Здесь ИИ часто ошибается:

Особый риск — «тесты ради тестов»: покрытие растёт, но тесты проверяют второстепенные детали, дублируют друг друга или слишком завязаны на реализацию. Итог — медленный CI и ложная уверенность.

В CI ИИ обычно не нужен напрямую, но он помогает настроить и объяснить правила. Реальную пользу дают автоматические проверки:

Один-два сквозных сценария «счастливого пути» на ключевой пользовательский поток.

Набор критичных негативных проверок (авторизация, права доступа, валидация входных данных).

Тест на регрессию для каждого найденного серьёзного бага (чтобы он не вернулся).

Остальное ИИ может предложить и ускорить, но приоритизацию и смысл тестов должна держать команда.

ИИ может ускорять работу, но в вопросах безопасности он не «берёт ответственность на себя». Любая команда, которая подключает ИИ к коду и данным, должна заранее договориться о правилах и о том, кто отвечает за результат.

Утечки данных. В промптах легко «случайно» отправить фрагменты приватного кода, ключи, логи с персональными данными или внутренние документы.

Лицензии и права. Сгенерированный код может повторять чужие фрагменты или подтягивать зависимости с несовместимыми лицензиями. Это риск для коммерческих проектов и open source.

Уязвимости и небезопасные паттерны. ИИ иногда предлагает упрощённые решения: отключить проверку сертификата, вставить небезопасную сериализацию, пропустить авторизацию «для примера».

Ошибки логики. Модель уверенно пишет код, который компилируется, но нарушает бизнес-правила — и это может стать инцидентом не хуже технической уязвимости.

Зафиксируйте в политике команды, что нельзя отправлять в ИИ: секреты (API-ключи, токены), персональные данные, продакшн-логи, приватные репозитории целиком, внутренние регламенты, если это запрещено.

Что обычно можно: обезличенные примеры, синтетические данные, минимальные фрагменты кода без лишнего контекста, формулировки требований без коммерческих деталей.

Автоматизируйте контроль, чтобы не надеяться на внимательность:

Даже если 80% диффа предложил ИИ, апрувит человек: владелец компонента или назначенный ревьюер. Релиз «подписывает» ответственное лицо (tech lead/дежурный релиз-менеджер) по тем же правилам, что и без ИИ. ИИ — инструмент, не участник процесса.

ИИ отлично генерирует текст и подсказывает варианты, но в команде разработка — это не только «написать код». Большая часть результата достигается через согласование смысла, ожиданий и рисков между людьми. Здесь ИИ может помогать как инструмент, но не может «владеть» ответственностью.

Новичку важно не просто узнать, как устроена система, а почему она такая: какие были ограничения, какие договорённости приняты в команде, какие компромиссы осознанны.

ИИ может быстро собрать шпаргалку по терминам или суммаризировать документацию, но он не чувствует «тонких мест»: где команда обычно ошибается, какие негласные правила важнее регламентов, как устроены коммуникации с продуктом и поддержкой. Это объясняет человек — через примеры, совместные сессии, разбор реальных задач.

Во время инцидента ценится не скорость ответа в чате, а правильные решения: кого подключить, что считать корневой причиной, когда откатывать, как сообщить пользователям, что фиксировать в постмортеме.

ИИ способен помочь с черновиком отчёта или чек‑листом, но он не может:

Культура качества строится повторяющимися действиями: как мы проводим ревью, как пишем тесты, как обсуждаем спорные решения, как реагируем на ошибки без поиска виноватых. ИИ может подсказать паттерн или помочь сформулировать комментарий в ревью, но не создаёт доверие, не замечает выгорание и не обучает через личный пример.

Самые дорогие решения принимаются, когда данных мало или они противоречат: стоит ли резать функциональность, менять архитектурный подход, переносить релиз, брать техдолг. ИИ может предложить варианты, но не несёт ответственность за последствия и не обладает полномочиями для компромиссов между интересами людей.

Потому что они завязаны на доверие, власть и ответственность: умение задавать вопросы, слышать скрытые ограничения, договариваться о критериях готовности и защищать качество. ИИ может улучшить формулировки, но «сделать так, чтобы команда договорилась» — это работа лидера и инженеров, а не модели.

ИИ в разработке даёт эффект только там, где команда заранее понимает, что именно улучшаем, чем измеряем результат и где проходят границы ответственности. Иначе «быстрее писать код» легко превращается в «быстрее производить дефекты».

Начинайте с задач, где результат можно проверить и сравнить: генерация тестов для уже существующего кода, обновление документации по готовым интерфейсам, черновики changelog/release notes, помощь в шаблонных рефакторингах.

Важно ограничить пилот по времени и объёму (например, 2–4 недели и 1–2 команды), чтобы вы получили сигнал, а не бесконечный эксперимент.

Если вы хотите попробовать подход «делаем через чат, но с контролем результата», удобны платформы, где встроены жизненный цикл и управление изменениями: например, в TakProsto.AI полезны planning mode для согласования плана до генерации, а также снапшоты и откат, чтобы безопаснее экспериментировать с изменениями (и при необходимости быстро возвращаться к рабочему состоянию). Плюс, в типовом стеке (React для web, Go + PostgreSQL для backend, Flutter для mobile) проще стандартизировать шаблоны задач и критерии приёмки.

До первого запроса к модели договоритесь о правилах, иначе риски окажутся выше пользы:

Смотрите не только на скорость, но и на качество:

Дайте разработчикам базу: как формулировать запрос, как проверять ответ, какие типовые ошибки моделей (галлюцинации, уверенный тон при неверных фактах, пропуск крайних случаев). Введите критерии приёмки: тесты должны падать без фикса, документация должна ссылаться на реальные эндпоинты, предложения по рефакторингу — сопровождаться аргументами и рисками.

Останавливайте или сужайте использование, если растёт число регрессий, увеличивается время ревью, команда чаще «чинит» сгенерированное, чем пишет сама, или появляются спорные решения без понятного автора и ответственности. В пилоте это нормально: цель — не доказать пользу любой ценой, а найти места, где ИИ действительно усиливает процессы команды разработки.

ИИ «заменяет» задачи, где вход можно стандартизировать, а выход легко проверить: шаблонные CRUD-слои, мапперы/адаптеры, простые миграции, черновики README.

Ключевое условие — у вас есть понятные критерии приёмки (тесты, линтеры, контракт API, ожидаемые форматы ошибок).

Когда нужна продуктовая ответственность и выбор компромиссов: архитектура под ограничения, доменная логика, приоритизация техдолга, решения по безопасности и релизу.

Также плохо «заменяется» работа, где проверка результата дороже, чем сделать руками (сложные интеграции, рисковые миграции данных).

Используйте простую рамку:

Если нет чёткой верификации — это почти всегда «усиливает» или «не трогает».

Дайте ИИ роль «помощника по уточнениям»:

Но финально требования проверяет команда: ИИ склонен «додумывать» отсутствующие детали, поэтому всё сомнительное фиксируйте как вопрос/допущение в тикете.

Попросите ИИ:

Дальше сверяйте с реальными ограничениями: версиями, SLA, бюджетом, компетенциями команды и политиками безопасности. Решение и ответственность остаются у людей.

Это хороший «ускоритель рутины»:

Обязательно дополняйте:

Больше тестов ≠ выше надёжность, если тесты проверяют второстепенное.

Лучший сценарий — «предревью» перед отправкой PR:

Но мердж и принятие риска — только человеком. ИИ может пропустить смысловые ошибки в доменной логике или уверенно предложить неверные улучшения.

Минимальные правила:

Поддержите это автоматикой: сканер секретов, SAST/SCA, линтеры и обязательные тесты в CI — независимо от того, кто писал код.

Да, если задачи «чистые» и без сложных зависимостей:

После генерации обязательно:

Выберите пилот на 2–4 недели и 1–2 сценария с проверяемым результатом (например, генерация тестов или обновление документации).

Метрики, которые стоит смотреть:

Если скорость растёт, а дефекты и время ревью тоже — сокращайте область применения и усиливайте проверки.