22 дек. 2025 г.·8 мин

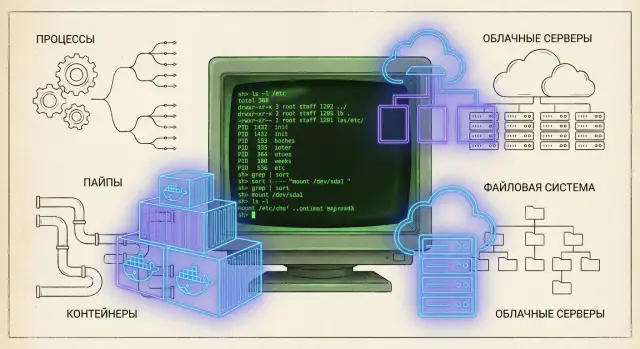

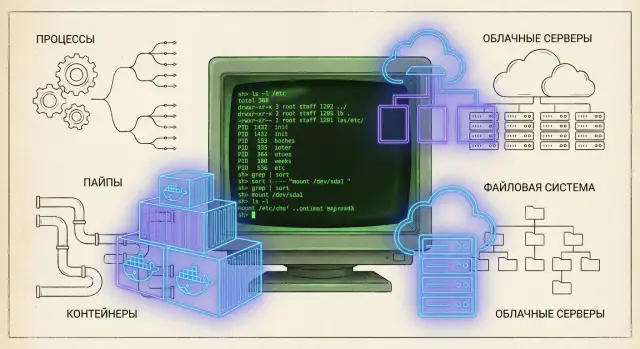

Кен Томпсон и UNIX: принципы, влияющие на контейнеры и облака

Разбираем принципы UNIX, заложенные Кеном Томпсоном: простые инструменты, пайпы, процессы и файлы — и как это влияет на контейнеры и облака сегодня.

Разбираем принципы UNIX, заложенные Кеном Томпсоном: простые инструменты, пайпы, процессы и файлы — и как это влияет на контейнеры и облака сегодня.

Кен Томпсон — один из ключевых инженеров, стоявших у истоков UNIX. В конце 1960‑х — начале 1970‑х он вместе с коллегами искал способ сделать удобную, понятную и практичную систему для повседневной работы на тогдашних машинах. Важен не только сам факт «кто придумал», а то, как это было придумано: решения принимались с оглядкой на реальные ограничения и на то, чтобы систему было легко развивать.

UNIX не стремился быть монолитным «комбайном». Напротив, вокруг небольшой основы вырастал набор простых утилит и соглашений, которые можно комбинировать. Такой подход неожиданно хорошо пережил смену эпох: от больших машин и терминалов — к персональным компьютерам, затем к серверам, виртуализации и облакам.

Причина долговечности — в ставке на несколько устойчивых идей: ясные интерфейсы, небольшие компоненты, предсказуемое поведение и возможность собирать решение из частей. Когда меняется железо, сетевые модели и способы доставки приложений, такие принципы оказываются полезнее, чем конкретные технологии.

Мы пройдём цепочку влияния: базовые принципы UNIX → современные системы семейства UNIX (включая Linux как наследника идей) → контейнеры и инфраструктура, которая управляет ими в облаке.

Важно уточнить: контейнеры и облачные платформы — не «просто UNIX в новой упаковке». Но многие привычные сегодня практики — от запуска изолированных процессов до автоматизации эксплуатации через небольшие инструменты — логически продолжают те решения, которые Томпсон и его коллеги закладывали как норму инженерной культуры.

Главное наследие здесь — инженерное мышление: строить системы так, чтобы их можно было менять частями, собирать в цепочки, переносить на новые среды и объяснять простыми словами.

Это актуально и в 2025 году — когда скорость изменений высокая, а требования к надежности и управляемости только растут. Именно на таких принципах держатся современные практики: от контейнеризации до «инфраструктуры как кода» — и до новых подходов вроде виб‑кодинга, где важно быстро собирать решение из модулей и проверяемых контрактов.

UNIX стал влиятельным не потому, что «умел всё», а потому, что задавал дисциплину мышления: проще — значит надёжнее, дешевле в сопровождении и легче переносится в другие условия. Это заметно даже тем, кто никогда не работал с классическим UNIX напрямую: многие современные инструменты и подходы унаследовали именно этот стиль.

В UNIX множество маленьких программ решают узкую задачу максимально качественно. Примеры понятны без углубления в программирование:

cat выводит содержимое файловgrep находит строки по шаблонуsort сортирует строкиwc считает строки/слова/байтыКаждая утилита проста, предсказуема и проверяема. Важно не то, что эти команды «старые», а то, что они задают формат мышления: лучше сделать маленький инструмент, который делает одно действие без сюрпризов, чем «комбайн» на все случаи.

Сила подхода UNIX — в том, что из маленьких деталей легко собирать большие решения. Вместо того чтобы расширять одну огромную систему бесконечными настройками, вы комбинируете несколько простых шагов.

Это напрямую влияет на дизайн и сегодня: в сервисах, в автоматизации, в построении процессов. Система получается из модулей, которые можно заменять по одному, не ломая всё целиком. Такой подход снижает риск изменений: вы улучшаете компонент — и остальная цепочка продолжает работать.

UNIX ценит простые интерфейсы: понятный ввод, понятный вывод, минимум скрытых зависимостей. Когда интерфейс ясен, его легче тестировать, документировать и переносить между средами.

Ограничения тоже помогают: они вынуждают формулировать задачу точнее и не смешивать ответственность. Если инструмент должен быть маленьким, вы заранее думаете о границах: где заканчивается его роль и начинается роль следующего элемента. В итоге появляется архитектура, которую проще поддерживать годами.

Если хочется увидеть эти принципы в действии на современных примерах, полезно читать секции про процессы и изоляцию далее по статье (см. /blog/ken-thompson-unix-principles).

Одна из самых узнаваемых идей UNIX звучит почти как шутка: «почти всё — файл». За ней стоит практичная цель — дать программам единый способ работать с вводом-выводом, не заставляя каждую утилиту «знать» детали конкретного устройства или канала связи.

Если приложение умеет читать и писать обычные файлы, оно почти автоматически умеет читать и писать:

Ключевой элемент здесь — файловый дескриптор: маленькое «число-ручка», через которое процесс читает и пишет байты. За этой ручкой может скрываться что угодно, но интерфейс для программы остаётся понятным и одинаковым.

Эта унификация позволяет собирать систему из простых частей. Вывод одной утилиты можно направить в другую, результат — в файл, а ошибки — в отдельный лог. И всё это без специальных интеграций: перенаправления и пайпы работают на уровне оболочки и ядра, а утилиты просто «читают из stdin» и «пишут в stdout».

Для автоматизации это золото: одинаковые приёмы применяются и к данным, и к диагностике. Логи можно перенаправлять, фильтровать, хранить, сравнивать; утилиты мониторинга — подключать в цепочки. Наблюдаемость выигрывает за счёт предсказуемости: поток байтов легко записать, воспроизвести, протестировать.

«Всё — файл» не означает, что всегда достаточно лишь операций чтения/записи. Иногда нужны специальные команды управления устройствами (например, через ioctl), иногда — особенности сетевых сокетов, неблокирующий режим, ожидание событий (select/poll/epoll). Ещё один нюанс: не всё удобно представлять как последовательность байтов (например, некоторые системные состояния). UNIX не скрывает эти исключения, но старается держать базовый путь простым — чтобы 80% задач решались единым, понятным способом.

UNIX сделал простую ставку: многие задачи удобнее решать не одним «комбайном», а цепочкой маленьких утилит, каждая из которых делает ровно одно действие — и делает его хорошо. Чтобы это работало, нужен общий «язык» между инструментами. Им стал поток данных, чаще всего обычный текст.

Когда программа принимает данные из стандартного ввода и пишет результат в стандартный вывод, её легко встроить в любую схему. Текстовые строки (или хотя бы предсказуемые, простые форматы) позволяют быстро смотреть, дебажить и менять обработку без специальных библиотек и сложных протоколов.

Пайп (|) соединяет вывод одной команды со вводом другой. Это не только удобство командной строки — это модель мышления: строить решения как конвейер, где этапы независимы.

Типичный подход выглядит так: сначала получить «сырой» поток, затем отфильтровать, нормализовать, отсортировать, агрегировать.

cat access.log | grep " 500 " | awk '{print $1}' | sort | uniq -c | sort -nr | head

Здесь каждая утилита решает микро-задачу, а общий результат появляется из композиции.

Фильтр в UNIX — это программа, которая берёт поток, преобразует его и отдаёт дальше. grep выбирает строки, sed редактирует, awk извлекает и считает. Важно не то, какие именно инструменты вы используете, а привычка проектировать обработку как набор простых преобразований с ясными входами/выходами.

Эта философия напрямую ощущается в современных практиках:

В этом же духе удобно оценивать и современные платформы разработки: например, в TakProsto.AI можно собирать приложение из независимых частей (веб, бэкенд, база, мобильный клиент) через чат‑интерфейс, а затем поддерживать предсказуемые контракты между компонентами, сохраняя возможность экспорта исходников и дальнейшей доработки.

UNIX сделал процесс базовой «ячейкой» работы системы. Процесс — это не просто запущенная программа, а единица учёта ресурсов, изоляции и контроля: у него есть владелец, права, окружение, текущая директория, открытые файлы и понятный жизненный цикл.

Когда мыслить процессами, многие задачи становятся стандартными операциями: запустить, ограничить, дождаться завершения, перезапустить, собрать вывод, убить по сигналу. Администратору и автоматизации не нужно «разговаривать» с каждым приложением по-своему — достаточно управлять процессом и его интерфейсами.

Одна из ключевых идей UNIX — разделить:

Практический эффект — гибкость. Сначала можно подготовить условия (права, переменные окружения, перенаправления ввода-вывода), а затем запустить нужную программу. Эта модель до сих пор лежит в основе того, как запускаются «воркеры», утилиты в пайплайнах и дочерние процессы серверов.

UNIX задаёт простой контракт между процессами:

Простой пример в оболочке:

my_job \u003eresult.txt 2\u003eerrors.log

if [ $? -ne 0 ]; then

echo "Задача завершилась с ошибкой"

fi

Современные сервисы и планировщики во многом повторяют UNIX-логику: запускать много однотипных процессов-воркеров, следить за их статусом, перезапускать при сбоях, разделять «полезный результат» и ошибки, управлять остановкой через сигналы.

Чем ближе приложение следует этому контракту (корректные коды возврата, аккуратный stdout/stderr, реакция на сигналы), тем проще его эксплуатация — от локального запуска до продакшн-среды.

UNIX изначально делали системой для нескольких людей одновременно. Это сразу заставило думать о безопасности не как о «дополнительной функции», а как о базовой гигиене: кто что может читать, изменять и запускать — и почему.

В UNIX доступ к данным и действиям во многом выражается через файловую модель: у файла (и каталога) есть владелец, группа и набор прав. Три знакомых бита rwx (чтение/запись/выполнение) задают, что разрешено владельцу, группе и всем остальным.

Важно, что это не только про документы. Конфигурации сервисов, сокеты, устройства, логи — всё подчиняется единой схеме. Благодаря этому администратор может управлять доступом «простыми» правилами и быстро понять, почему что-то не работает: чаще всего причина в правах, владельце или группе.

Принцип минимальных привилегий в UNIX — не лозунг, а способ снижать риски без лишней сложности:

Так уменьшается «радиус поражения»: даже если приложение уязвимо, злоумышленник не получает автоматически полный контроль.

Права доступа напрямую влияют на эксплуатацию. Когда роли разделены, становится проще:

Логи и владельцы файлов дают понятный след: «какой процесс» и «под каким пользователем» что изменил.

Современные системы (в том числе Linux) развили идеи UNIX. Вместо «или всё, или ничего» для привилегий появились capabilities — можно выдать процессу ровно одну «суперсилу» (например, открыть привилегированный порт), не делая его полноценным администратором.

Плюс добавились механизмы песочниц и политик (например, SELinux/AppArmor, seccomp): они ограничивают системные вызовы, доступ к сетям и файлам даже тогда, когда обычных прав недостаточно. В итоге доверие становится более формализованным: не «мы верим этому сервису», а «мы разрешаем ему только строго определённые действия».

UNIX с самого начала строился вокруг чёткого разделения ответственности. Ядро занимается базовыми вещами: процессами, памятью, драйверами устройств, файловой системой и правами доступа. Оболочка (shell) — это пользовательский слой, который запускает программы, соединяет их между собой и позволяет автоматизировать повторяющиеся действия.

Такой подход оказался стратегически сильным: систему можно развивать, не «перепаивая» всё целиком. Улучшаются драйверы и планировщик — скрипты продолжают работать. Появляются новые утилиты — их можно сразу использовать в существующих сценариях.

В UNIX важно, что «ум» распределён по слоям:

В результате модульность становится не абстрактной идеей, а ежедневной практикой: новые инструменты не требуют нового «суперприложения», достаточно добавить ещё одну команду в существующий поток.

Shell — это не просто командная строка, а язык оркестрации: запуск программ, подстановка параметров, циклы, условия, перенаправление ввода-вывода. В эксплуатации и CI/CD это по-прежнему удобно: быстро собрать «клей» вокруг готовых утилит, не создавая отдельный сервис.

При этом shell хорошо поддерживает принцип «делай одно, но хорошо»: вместо монолита — короткий сценарий, который связывает несколько инструментов. Если вы строите внутренние утилиты для команды, полезно держать эту логику и в документации, и в интерфейсах (см. также /blog/).

Текстовые интерфейсы устойчивы, потому что:

Это одна из причин, почему командные утилиты переживают поколения технологий: меняются среды, но сценарии, форматы и привычки работы остаются.

Сила shell — одновременно и риск. Скрипты быстро разрастаются и становятся хрупкими: неочевидные кавычки, пробелы, особенности окружения, «тихие» ошибки в пайплайнах. Плюс безопасность: подстановка пользовательского ввода, случайное выполнение не того бинарника из PATH, утечки секретов в логах.

Практика на 2025 год простая: держите скрипты короткими, явно проверяйте ошибки, цитируйте переменные, не храните секреты в открытом виде и ограничивайте права выполнения. Модульность работает лучше всего, когда модули понятны и предсказуемы.

UNIX часто воспринимают как «старую» систему, но его главное достижение — не возраст, а способность выживать при смене поколений железа и подходов к разработке. В этом смысле UNIX стал не продуктом, а идеей, которую можно переносить — и именно поэтому его наследие заметно в Linux, серверной инфраструктуре и в том, как устроены современные платформы.

Ранние версии UNIX были тесно привязаны к конкретному компьютеру. Поворотным моментом стало переписывание системы на языке C. Смысл был не в «модном» языке, а в том, что C позволял описывать операционную систему на уровне выше ассемблера, сохраняя при этом контроль над ресурсами.

Практический эффект прост: чтобы запустить UNIX на новой машине, требовалось переписать сравнительно небольшой слой, который «общается» с процессором и устройствами, а большая часть кода оставалась прежней. Это резко снизило цену адаптации и ускорило распространение.

UNIX закрепил несколько удачных абстракций, которые почти не зависят от конкретного железа: процессы, права доступа, файловые дескрипторы, единообразный ввод-вывод, предсказуемые системные вызовы. Когда менялись процессоры, компиляторы и устройства хранения, эти «строительные блоки» оставались узнаваемыми — а приложения могли переноситься с минимальными правками.

Когда систем стало много, потребовалась общая «грамматика». Стандарты семейства POSIX зафиксировали, какие интерфейсы и поведение можно ожидать от UNIX-подобной системы. Это важно не только разработчикам: стандартизация помогает бизнесу снижать риск привязки к одному поставщику и упрощает эксплуатацию — инструменты и скрипты легче переносить между средами.

Главный урок портируемости UNIX в том, что долговечность создают стабильные интерфейсы. Реализацию можно переписать, оптимизировать, перенести на другую архитектуру — но если API и поведение сохраняются, экосистема (приложения, инструменты, привычки команд) продолжает работать.

Поэтому при выборе технологий и проектировании платформ полезно задавать вопрос: «Какие интерфейсы мы обещаем не ломать?» Это одинаково применимо и к системным API, и к контрактам микросервисов, и к внутренним инструментам команды.

Контейнеры часто подают как «новую» технологию, но их ядро — это аккуратное использование идей, знакомых по UNIX: процессы, единая файловая модель и чёткие границы прав.

В UNIX процесс — базовая единица выполнения, а права доступа (пользователь, группа, режимы) задают, что ему разрешено. Контейнеры опираются на то же: приложение в контейнере — это набор обычных процессов, которым просто ограничили «видимость» системы и доступ к ресурсам.

Вторая опора — файловая абстракция. Логи, сокеты, устройства, конфигурации — всё подаётся через единые интерфейсы и файловые пути. Контейнер использует это, чтобы дать приложению предсказуемую «картинку» файловой системы и окружения, не меняя само приложение.

Linux развил UNIX-подход к разделению ответственности: не «магия» внутри приложения, а изоляция на уровне ОС.

В результате контейнер — это тот же процессный мир UNIX, но с дополнительными «перегородками» и квотами.

Контейнерные образы устроены как слоёный набор изменений файловой системы. Это напрямую продолжает UNIX-идею: приложение — это файлы (бинарник), библиотеки, конфиги, сертификаты, плюс договорённость о путях. Слои позволяют повторно использовать общий «базовый» набор, а поверх накладывать только то, что отличается.

Важно помнить: контейнеры разделяют одно ядро. Это значит, что:

Контейнеры — это сильная, но не абсолютная форма изоляции: они усиливают практики UNIX, а не заменяют их.

UNIX задумывался как среда, где небольшие программы делают одну работу хорошо и «договариваются» о взаимодействии через простые, понятные интерфейсы. В облаках эта идея стала повседневной практикой: мы строим системы из независимых сервисов, а успех чаще зависит не от «магии платформы», а от качества контрактов между частями.

Микросервис — это, по сути, отдельный «инструмент» с ограниченной ответственностью: принимает запрос, выполняет конкретную функцию, возвращает результат. Чтобы такая архитектура не рассыпалась, сервисам нужны чёткие контракты: API, схемы событий, правила версионирования.

Здесь наследие UNIX проявляется в подходе к интерфейсам: меньше скрытых предположений, больше явных форматов и проверяемых соглашений. Хороший контракт позволяет заменить реализацию без переделки всего остального — как можно заменить утилиту, сохранив формат входа/выхода.

Операционные практики в облаках во многом выросли из привычки UNIX работать с текстом и скриптами. Когда конфигурация хранится в репозитории, её можно:

Эта логика лежит и в IaC-подходах (Terraform, Ansible, Helm), и в GitOps: не «кликаем» настройки вручную, а описываем желаемое состояние и повторяем его при необходимости.

Логи, метрики и трассировки удобнее воспринимать как потоки данных, которые можно фильтровать, обогащать и направлять дальше: в хранилище, алерты, дашборды. Практический эффект — быстрый поиск причин инцидентов и измеримое понимание, что именно происходит в продакшене.

Сильная эксплуатация в облаке — это когда действия безопасно повторяются. Идемпотентные деплой-скрипты и пайплайны CI/CD уменьшают риск «случайных» состояний.

Полезное правило: каждую ручную операцию (выкат, миграцию, масштабирование, выдачу доступа) стоит превращать в автоматизированный шаг с понятным входом и предсказуемым выходом.

На практике это всё чаще означает и требования к платформам разработки: быстрый деплой, управляемый откат, контроль изменений. Например, в TakProsto.AI есть снапшоты и rollback, планирование изменений (planning mode) и развёртывание с хостингом — это хорошо сочетается с «облачной» дисциплиной, выросшей из UNIX-логики предсказуемых операций.

Принципы UNIX полезны не как «ностальгия по терминалу», а как практичный способ принимать решения: какие инструменты брать, как строить сервисы, как устранять сбои и как избегать «магии» в инфраструктуре.

Выбирайте компоненты, которые делают одну работу хорошо, имеют понятные входы/выходы и легко комбинируются. В 2025 это означает: небольшие утилиты в CI, прозрачные форматы данных (текст, JSON, строки логов), сервисы с ясными API и предсказуемым поведением.

В инфраструктуре это читается так же: контейнер — это процесс с изоляцией и лимитами, а не «мини‑виртуалка». Поэтому полезно строить пайплайны и эксплуатацию вокруг простых операций: собрать → запустить → проверить → логировать → заменить.

Отдельно стоит помнить о практической стороне: принципы легче внедряются, когда команда быстро получает рабочий результат и может его улучшать итерациями. В этом смысле формат «собрали прототип, закрепили контракт, автоматизировали деплой» хорошо ложится и на виб‑кодинг: в TakProsto.AI можно быстро собрать приложение (например, React на фронте и Go + PostgreSQL на бэкенде), а затем уже доводить контракты, наблюдаемость и безопасность — без потери управляемости и с возможностью экспорта исходного кода.

Чаще всего философия UNIX нарушается не «сложностью», а скрытностью:

Проверьте продукт и инфраструктуру по нескольким вопросам:

Если вы выстраиваете стандарты для команды, полезно собрать короткие внутренние гайды и примеры (у нас это обычно оформляют в базе знаний и в /blog). А когда встаёт вопрос, как ускорить выпуск внутренних инструментов без тяжёлого наследия «классических» пайплайнов, можно посмотреть, как это решается в TakProsto.AI: от бесплатного до enterprise‑тарифа, с развёртыванием, кастомными доменами и возможностью получать кредиты за контент или рекомендации (подробнее — /pricing).

Кен Томпсон был одним из инженеров, которые сформировали практичный стиль UNIX: небольшое ядро, простые утилиты и ясные интерфейсы.

Ценность здесь не в «персональном изобретении», а в инженерных решениях, которые:

Потому что система строилась вокруг устойчивых абстракций и контрактов: процессы, файлы, дескрипторы, права, предсказуемые системные вызовы.

Когда меняются платформы (виртуализация, контейнеры, облака), выигрывают подходы, которые:

Это дисциплина: писать инструменты, у которых одна основная задача, минимум скрытых зависимостей и стабильное поведение.

Практическая польза:

Пайпы позволяют соединять программы в конвейер: одна команда пишет в stdout, следующая читает из stdin.

Это удобно для:

Важно следить за контрактом: чёткий формат вывода, корректные коды возврата, ошибки — в stderr.

Это единая модель ввода-вывода: многие сущности (файлы, устройства, сокеты, пайпы) доступны через похожий интерфейс чтения/записи и файловые дескрипторы.

Практический эффект:

fork() создаёт новый процесс (почти копию), а exec() заменяет его содержимое нужной программой.

Это важно, потому что можно сначала подготовить среду:

а затем запускать приложение предсказуемо — так устроены многие рантаймы, воркеры и системные сервисы.

Проверяемый контракт процесса обычно включает:

0 — успех, иначе ошибка;Если приложение соблюдает эти правила, его проще оборачивать в оркестрацию: перезапускать, мониторить, строить ретраи и алёрты.

Минимальный набор, который работает почти всегда:

Современные системы дополняют это механизмами вроде capabilities, seccomp и политик (SELinux/AppArmor), но базовая гигиена начинается с простых прав и владельцев.

Контейнер — это не «мини‑виртуалка», а набор обычных процессов с ограничениями на уровне ОС.

Чаще всего используются:

Поэтому контейнеризация хорошо сочетается с философией UNIX: ясные границы, предсказуемый запуск, единая файловая модель.

POSIX фиксирует ожидаемое поведение интерфейсов UNIX-подобных систем: системные вызовы, утилиты, форматы и семантику.

Практическая ценность:

Если вам важно продолжение темы про применимость принципов, удобно держать под рукой связанный материал: /blog/ken-thompson-unix-principles.