23 июн. 2025 г.·8 мин

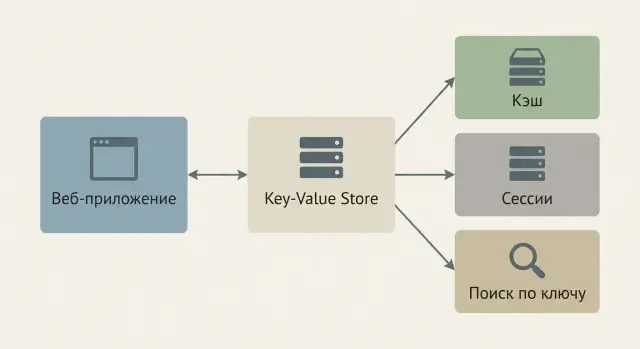

Key-Value хранилища: кэш, сессии и быстрые запросы

Разбираем, как key-value хранилища ускоряют приложения: кэш, хранение сессий и быстрые обращения по ключу. Паттерны, TTL, масштабирование и ошибки.

Что такое key-value хранилище и зачем оно нужно

Key-value хранилище — это база данных, где каждый объект лежит под уникальным ключом, а по этому ключу можно получить значение. Аналогия с обычным словарём простая: ключ — это слово, значение — его определение. Важный момент: вы не «ищете по смыслу», вы обращаетесь к записи по точному идентификатору.

Эта модель кажется примитивной, но именно она делает key-value хранилища отличным инструментом для задач, где важны скорость и предсказуемость.

Почему чтение и запись обычно быстрые

Главная причина скорости — простая модель доступа. Запрос выглядит как «дай значение по ключу», без сложных JOIN, фильтров и сканирования больших таблиц.

Обычно такие системы:

- держат данные в памяти (полностью или частично), поэтому чтения очень быстрые;

- используют структуры данных, оптимизированные под обращение по ключу;

- минимизируют накладные расходы на обработку запросов.

На практике это делает key-value удобным «ускорителем» рядом с основной базой данных.

Какие задачи решают лучше всего (и какие — нет)

Key-value хранилища отлично подходят, когда вам нужно:

- мгновенно получать данные по идентификатору (например, по user_id или token);

- хранить временные данные с автоматическим истечением;

- выдерживать много коротких запросов в секунду.

А вот где они не лучший выбор:

- аналитические запросы «посчитать по всем», выборки по нескольким полям, сложные отчёты;

- строгие транзакции на множество объектов и богатые связи между сущностями (это сильная сторона SQL).

Примеры типов значений

Значение — не обязательно просто строка. В зависимости от конкретного продукта (например, Redis и его альтернативы) вы можете хранить:

- строку:

"user:42:name" → "Анна"; - JSON/объект: профиль пользователя или настройки;

- список: очередь задач или последние действия;

- счётчик: количество попыток входа, просмотров, лайков.

Итог: key-value хранилище — это инструмент для быстрых обращений по ключу и временных данных, который часто дополняет, а не заменяет основную БД.

Чем key-value отличается от SQL и документных БД

В key-value вы заранее формулируете ключ доступа, и система возвращает значение. В SQL и документных БД основной сценарий другой: вы описываете какие данные нужны через условия и фильтры, а база решает, как их эффективно найти.

Доступ: «по ключу» vs запросы с условиями

В key-value обычно нет богатого языка запросов уровня WHERE age > 30 AND city = .... Вы не спрашиваете «найди всех», вы спрашиваете «дай объект с ключом X».

Отсюда важный нюанс:

- «Быстро по ключу» означает высокую скорость, когда вы заранее знаете идентификатор.

- Это не означает «быстро по любому полю». Если вам нужно искать по email, статусу, диапазону дат — эти поля нужно заранее превращать в ключи/индексы на уровне приложения или выбирать другую БД.

Когда реляционная БД избыточна для простых операций

SQL-базы сильны транзакциями, связями и сложными выборками. Но за универсальность часто платят: схемой, джойнами, индексами, блокировками, более дорогими операциями записи/чтения при высокой конкуренции.

Если задача сводится к операциям вроде «получить значение по ID», «обновить счётчик», «положить и быстро забрать результат», то полноценная реляционная модель может быть лишней — key-value будет проще и быстрее в эксплуатации.

Компромисс: функциональность vs скорость

Документные БД (например, с JSON-документами) занимают середину: они дают гибкую схему и более удобные запросы по полям, но обычно проигрывают чистому key-value в предсказуемости и скорости именно точечных обращений по ключу.

Практический вывод: выбирайте key-value, когда вы можете заранее сформулировать ключ доступа и вам важны быстрые чтения/записи. Если же бизнес-логика требует «умных» выборок, агрегаций и аналитики — лучше смотреть в сторону SQL или документных решений.

Кэширование: зачем выносить горячие данные в key-value

Когда приложение слишком часто читает одни и те же данные из основной БД, оно начинает «платить» за каждое обращение: время на сетевой запрос, парсинг, выполнение SQL, блокировки, конкуренцию за соединения. В пиковые часы это выливается в рост задержек для пользователей и лавинообразное увеличение нагрузки на базу — даже если сами данные почти не меняются.

Что именно делает кэш

Key-value хранилище хорошо подходит для кэша, потому что отдаёт значение по ключу очень быстро и с предсказуемой задержкой. Вместо повторного похода в основную БД приложение сначала проверяет кэш:

- Есть значение — возвращаем его сразу.

- Нет значения — читаем из БД, кладём в кэш и отдаём пользователю.

Так кэш снижает среднее время ответа (особенно на популярных запросах) и разгружает основное хранилище: меньше запросов, меньше конкуренции за ресурсы, больше «запаса прочности» на реальные обновления данных.

Когда кэш особенно полезен

Кэш выигрывает там, где есть «горячие» данные — небольшое число объектов, которые запрашивают часто:

- Популярные страницы и витрины: главная, подборки, топы, результаты фильтров.

- Профили и настройки: карточка пользователя, признаки доступа, флаги.

- Каталоги и справочники: категории, бренды, валюты, география.

Важно, что кэш не обязан хранить «всё». Часто достаточно держать только наиболее востребованные фрагменты: например, отрендеренный JSON ответа или вычисленный результат сложного запроса.

Риски: устаревание и инвалидация

Главная цена кэша — риск вернуть устаревшие данные. Поэтому заранее продумайте, когда и как очищать/обновлять ключи:

- используйте ограниченный срок жизни (TTL) для естественного «самоочищения»;

- обновляйте кэш при изменении данных (например, после записи в БД);

- задавайте версионирование ключей, чтобы проще «сбрасывать» целые наборы.

Кэш — это ускоритель. Он приносит максимум пользы, когда у вас есть повторяемые чтения и понятные правила актуальности данных.

Основные паттерны кэша и где они применяются

Выбор паттерна кэширования влияет не только на скорость, но и на простоту кода, нагрузку на базу данных и риск получить устаревшие данные. Ниже — три самых популярных подхода и ситуации, где они работают лучше всего.

Cache-aside (lazy loading)

При cache-aside приложение само управляет кэшем: сначала пытается прочитать данные по ключу, при промахе идёт в основную БД, а затем кладёт результат в key-value хранилище с TTL.

Плюсы: гибкость, кэшируется только реально востребованное («горячее»), легко внедрять точечно.

Минусы: нужно аккуратно обрабатывать промахи и «шторм» при одновременных запросах (когда много клиентов одновременно идут в БД).

Где подходит: каталоги, карточки товара, профили, любые сценарии с преобладанием чтений и терпимостью к кратковременной устарелости.

Read-through / Write-through

Read-through: приложение читает как будто из кэша, а кэш (через библиотеку/прослойку) сам подтягивает данные из БД при промахе.

Write-through: запись идёт через кэш, и кэш синхронно записывает в БД.

Плюсы: проще бизнес-коду — меньше ветвлений «если промах, то…», единая точка контроля.

Минусы: write-through увеличивает задержку записей (нужно дождаться БД), а read-through требует готовой интеграции/абстракции.

Где подходит: сервисы, где важна предсказуемость и единый механизм чтения/записи; команды, которые хотят меньше «кэш-логики» в приложении.

Write-behind (write-back)

При write-behind запись сначала попадает в кэш, а в основную БД уходит асинхронно (пачками или с задержкой). Это даёт очень быстрые ответы на запись.

Главный риск: можно потерять данные при сбое кэша/узла до того, как изменения будут зафиксированы в БД. Снизить риск помогают: журналирование/очередь, репликация, ограничение окна задержки, периодические флеши и чёткая политика восстановления.

Где подходит: счётчики, метрики, лайки/просмотры, агрегаты — то, что можно пересчитать или где допустима небольшая потеря.

Как выбрать паттерн под ваш профиль нагрузок

Если чтений много, а записи редки — чаще всего выигрывает cache-aside. Если важны простота и единый путь данных — смотрите в сторону read-through/write-through. Если записи должны быть максимально быстрыми и допустим «eventual» подход — write-behind, но только с продуманной защитой от потерь.

TTL, истечение ключей и стратегии выселения

TTL (time-to-live) — это «срок годности» записи в key-value хранилище. Вы задаёте время, после которого ключ автоматически удалится. Для кэша и сессий это базовый механизм: он ограничивает рост данных, снижает риск устаревшей информации и помогает системе оставаться предсказуемой под нагрузкой.

Что такое TTL и почему он важен

- Кэш: TTL определяет, как долго можно доверять сохранённому ответу (например, карточке товара или результату поиска).

- Сессии пользователей: TTL — естественный способ завершать неактивные сессии без ручной уборки.

Без TTL хранилище постепенно заполняется «мусором», и вы платите памятью (и деньгами) за данные, которые больше никому не нужны.

Политики выселения: LRU/LFU простыми словами

Даже при TTL память может закончиться: новые ключи приходят быстрее, чем старые успевают протухать. Тогда включаются стратегии выселения (eviction) — правила, какие ключи удалить первыми.

- LRU (Least Recently Used): выкидываем то, чем давно не пользовались. Логика «если не трогали — скорее всего, не нужно».

- LFU (Least Frequently Used): выкидываем то, чем пользовались редко. Подходит, когда есть устойчивые «хиты».

- По TTL/времени: удаляем то, что ближе к истечению, или уже просрочено.

Выбор зависит от того, как ведут себя запросы: всплески и тренды чаще любят LRU, а стабильные популярные данные — LFU.

Как подобрать TTL: баланс свежести и экономии

Хорошее правило: TTL должен отражать допустимую устарелость данных.

- Если цена меняется раз в час — TTL в несколько минут может быть разумным.

- Если справочник обновляется раз в день — можно кэшировать дольше.

- Для сессий TTL часто равен времени неактивности (например, 30–60 минут), иногда с продлением при каждом запросе.

Почему «вечный» кэш часто приводит к проблемам

«Кэш без истечения» выглядит заманчиво, но обычно приводит к трём вещам: переполнению памяти, накоплению устаревших данных и сложным ручным чисткам. В итоге кэш перестаёт ускорять систему и начинает быть источником инцидентов. Лучше управлять сроком жизни явно — TTL + понятная стратегия выселения дают контролируемое поведение даже при росте нагрузки.

Сессии пользователей: быстрый доступ и масштабирование

Внедрите cache-aside паттерн

Смоделируйте cache-aside с TTL и защитой от cache stampede в одном проекте.

Сессия — это способ «узнать» пользователя между запросами: кто он, какие права имеет, что лежит в корзине и т. п. Чтобы ответы были быстрыми, данные сессии часто читаются при каждом запросе. Поэтому key-value хранилище хорошо подходит: доступ по ключу (ID сессии) обычно занимает миллисекунды и не требует сложных запросов.

Что хранить в сессии (и чего лучше избегать)

Главный принцип — хранить минимум, а всё остальное получать из профильных систем по необходимости.

- Идентификатор пользователя и/или ссылку на профиль.

- Токены/признаки авторизации (например, refresh token или отметку о прохождении 2FA) — если это соответствует вашей модели безопасности.

- Минимальные атрибуты, которые нужны «прямо сейчас»: язык, выбранный регион, версия A/B-теста.

Не стоит складывать в сессию крупные объекты (полный профиль, длинные списки, историю действий). Это увеличивает память, усложняет миграции формата и повышает риск утечки.

Почему «сессии в памяти приложения» плохо масштабируются

Когда сессии хранятся в RAM конкретного инстанса приложения, появляются проблемы:

- при рестарте инстанса пользователь «вылетает»;

- при горизонтальном масштабировании запросы попадают на разные инстансы, и сессия становится недоступной без sticky sessions;

- сложнее балансировать нагрузку и проводить деплой без потерь.

Как key-value помогает при нескольких инстансах

Вынос сессий в отдельное key-value хранилище делает приложение более «без состояния»: любой инстанс может обслужить любой запрос, просто прочитав session:{id}. Это упрощает автоскейлинг, отказоустойчивость и катящиеся обновления.

Безопасность: TTL, ротация и защита от фиксации

Задавайте TTL для сессий и продлевайте его при активности (sliding expiration) — но с верхним лимитом. Используйте ротацию идентификатора сессии после логина/повышения привилегий, чтобы снизить риск фиксации сессии. Храните идентификатор в cookie с флагами HttpOnly, Secure, SameSite, а при выходе из аккаунта удаляйте ключ (инвалидация) и при необходимости ведите список отозванных токенов с TTL.

Высокоскоростные обращения: типичные сценарии по ключу

Key-value хранилище особенно полезно там, где запрос почти всегда выглядит одинаково: «вот ключ — верни значение». Такой доступ предсказуем, хорошо кэшируется в памяти и даёт минимальную задержку даже при большом трафике.

Автодополнение и быстрые справочники

Для автодополнения важны быстрые чтения маленьких фрагментов данных. Частый приём — держать «справочник» по ключу: префикс → список подсказок, или префикс → id набора подсказок.

Главное — избегать тяжёлых вычислений в момент ввода пользователя: лучше заранее подготовить значения и обновлять их фоном. Тогда каждое нажатие клавиши превращается в дешёвый запрос по ключу.

Таблицы соответствий (mapping tables)

Key-value отлично подходит для «переводчиков» между идентификаторами:

- email → user_id (быстрый поиск пользователя)

- token → права/роль (проверка доступа)

- код → объект/идентификатор (поиск сущности по короткому коду)

Такой слой часто снижает нагрузку на основную БД: вместо сложного запроса вы делаете одно чтение по ключу и получаете нужный id или набор атрибутов.

Счётчики, лимиты и rate limiting

Сценарии типа «сколько раз пользователь сделал действие за минуту» требуют атомарных операций: увеличить счётчик и сразу проверить порог.

Типичная схема: ключ вида rl:<user_id>:<minute> → значение-счётчик, плюс TTL чуть больше окна. Это позволяет ограничивать:

- попытки входа

- запросы к API

- отправку сообщений/комментариев

Короткоживущие данные

Одноразовые коды, временные ссылки, подтверждение email/телефона — идеальные кандидаты для key-value: запись создаётся, живёт ограниченное время и автоматически исчезает.

Практика: хранить минимум данных (например, code → user_id), выставлять короткий TTL и делать одноразовое «погашение» кода, чтобы исключить повторное использование.

Проектирование ключей и структуры данных

Настройте быстрые сессии

Сделайте хранение session:{id} в key-value и масштабируйте бэкенд без sticky sessions.

Хороший дизайн ключей — это половина успеха при работе с key-value хранилищем. Он влияет на скорость, предсказуемость, удобство миграций и даже на стоимость инфраструктуры.

Организация ключей: префиксы, пространства имён, версии

Практичный подход — строить ключи из «кирпичиков» через разделитель (обычно :):

- Пространство имён (сервис/модуль):

billing,auth,catalog - Тип сущности/назначение:

session,user,cache,rate - Идентификатор:

userId,orderId, хэш параметров - Версия схемы:

v1,v2(особенно полезно при изменении формата значения)

Пример: auth:session:v2:9f2c... или catalog:product:v1:sku-12345.

Схемы именования и защита от коллизий

Коллизии чаще всего возникают, когда разные команды/сервисы «случайно» выбирают одинаковые ключи. Чтобы этого избежать:

- закрепите единый стандарт (разделитель, порядок частей, допустимые символы);

- не используйте «слишком общие» ключи вроде

user:123без namespace; - для вычисляемых ключей (например, кэш поисковой выдачи) используйте хэш от нормализованных параметров: сортируйте параметры, приводите регистр, убирайте лишние пробелы.

Размеры значений: объект или ссылка

Key-value идеально подходит для быстрых чтений, но хранить огромные значения не всегда выгодно:

- большие JSON/объекты увеличивают сеть, память и время (де)сериализации;

- обновление «толстого» значения часто приводит к лишним перезаписям.

Частая практика: хранить в key-value короткий «указатель» (ID, URL, версию), а сам объект — в основной БД или object storage. В кэше держать только то, что реально ускоряет критичный путь.

Наблюдаемость: метрики по ключам/префиксам и горячие точки

Проектируйте ключи так, чтобы их можно было агрегировать. Метрики по префиксам помогают быстро находить проблемы: рост miss rate, «взрывы» кардинальности, неожиданные объёмы памяти.

Полезно отслеживать: топ ключей по частоте, топ префиксов по памяти, распределение размеров значений и время операций. Так вы заранее заметите горячие точки и сможете разделить нагрузку или пересмотреть структуру ключей.

Частые проблемы кэша и как их предотвращать

Кэш ускоряет систему, но добавляет свои «болезни роста»: редкие баги превращаются в пики нагрузки, а пики — в простой. Ниже — самые частые сценарии и практики, которые обычно дают быстрый эффект.

Кэш-шторм (cache stampede)

Шторм возникает, когда популярный ключ одновременно истёк (или был вытеснен), и множество запросов параллельно идут в основную БД за одним и тем же значением. Итог — лавинообразный рост нагрузки на БД и рост задержек.

Как смягчить:

- Блокировка на ключ: первый запрос «берёт замок» и пересчитывает значение, остальные ждут или получают слегка устаревшие данные.

- Single-flight/дедупликация запросов на уровне приложения: объединяйте одинаковые запросы в один пересчёт.

- Мягкое истечение: храните значение чуть дольше, а обновление делайте в фоне (если допустима кратковременная устарелость).

Кэш-проникновение/пробой (miss по несуществующим ключам)

Если злоумышленник или просто «шумный» клиент запрашивает несуществующие ключи, кэш не помогает: каждый раз идёт запрос в БД, а кэш остаётся пустым.

Что помогает:

- Отрицательное кэширование: кэшируйте факт отсутствия (например, «not_found») с коротким TTL.

- Валидация ключей: отсекайте явно неверные идентификаторы до обращения к БД.

- Блум-фильтр/список допустимых ID (если подходит по модели данных): дешёвая проверка «может ли существовать».

Кэш-лавина

Лавина — это массовое истечение TTL у большой группы ключей примерно в одно время (часто после деплоя, прогрева или установки одинаковых TTL). В результате нагрузка резко возвращается в БД.

Как предотвратить:

- TTL-джиттер: добавляйте случайную «дельту» к TTL, чтобы ключи истекали в разное время.

- Пороговые ограничения: лимитируйте частоту регенерации и защищайте БД от пиков (rate limiting, очереди).

- Постепенный прогрев: не прогревайте весь кэш разом; разнесите по времени и по сегментам.

Мини-чеклист практик

Сочетайте несколько приёмов: джиттер TTL + отрицательное кэширование + блокировка на ключ для самых горячих данных. И обязательно добавьте метрики: hit/miss, p95 задержки, количество пересчётов и долю запросов, ушедших в БД — без наблюдаемости кэш «ломается молча».

Масштабирование: шардинг, репликация и согласованность

Когда key-value хранилище перестаёт помещаться в память одного сервера или упирается в лимит запросов в секунду, его масштабируют. Обычно это сочетание шардинга и репликации — и почти всегда компромисс по согласованности.

Шардинг: распределение ключей по узлам и последствия

Шардинг — это разбиение пространства ключей на «кусочки» и размещение их на разных узлах кластера. Часто используется хеш ключа: один и тот же ключ всегда попадает на один и тот же шард.

Последствия простые, но важные:

- Некоторые операции усложняются. Всё, что требует «пробежать по всем ключам» или сделать сложную выборку, становится дороже: нужно обращаться к нескольким узлам.

- Ключи нужно проектировать заранее. Если у вас есть операции по группе объектов (например, все данные пользователя), продумайте, как они будут располагаться, чтобы не вызывать лишние межузловые запросы.

Репликация: зачем нужна и как влияет на чтения

Репликация копирует данные с основного узла на один или несколько реплик. Это даёт:

- Отказоустойчивость: при проблемах с узлом можно переключиться.

- Масштабирование чтений: часть чтений можно направить на реплики.

Но цена — задержка доставки обновлений на реплики.

Согласованность: что значит «возможна задержка обновления»

Если вы читаете с реплики, вы можете получить устаревшее значение — новое ещё не успело доехать. Для кэша это часто нормально, для сессий и денег — уже риск.

Практика: критичные чтения направляйте на основной узел или используйте режимы, где подтверждение записи ждёт реплики (если поддерживается), понимая, что латентность вырастет.

Планирование ёмкости: память, размер ключей, рост данных

Key-value чаще всего держит данные в памяти, поэтому планируйте:

- средний размер ключа и значения (метаданные тоже занимают место);

- запас под пики и рост (например, +30–50%);

- влияние репликации: каждая копия увеличивает общий расход памяти.

Хорошее правило: сначала посчитать объём, затем выбрать стратегию шардинга и только потом добавлять реплики под чтения и отказоустойчивость.

Как выбрать key-value хранилище под вашу задачу

Откатывайте изменения без стресса

Используйте снапшоты и rollback, чтобы безопасно менять кэш-логику и схемы ключей.

Выбор key-value хранилища начинается не с названия продукта, а с ответа на вопрос: что именно вы храните и какие гарантии нужны приложению. Для кэша одной и той же страницы и для хранения счётчиков в реальном времени требования будут разными — по задержке, по операциям и по тому, что считать «потерей данных».

1) Базовые требования: задержка, объём, отказоустойчивость

Сначала зафиксируйте три параметра:

- Допустимая задержка: единицы миллисекунд или «можно и 20–50 мс».

- Объём данных и рост: сколько ключей/значений сейчас и через 6–12 месяцев.

- Отказоустойчивость: что происходит при падении узла — деградация сервиса, частичная недоступность или полный стоп.

Если приложение чувствительно к пикам, смотрите не только среднюю задержку, но и хвосты (p95/p99) и поведение под нагрузкой.

2) Нужна ли персистентность или достаточно временного хранения

Для многих сценариев (кэш, rate limiting, временные токены) допустимо временное хранение: перезапуск узла очищает данные, но сервис живёт.

Если же ключи — это фактически «источник правды» (например, баланс лимитов, важные счётчики, очереди задач), потребуется персистентность и понятная стратегия восстановления: журналирование, снапшоты, репликация, а также ожидаемое время возврата в строй после сбоя.

3) Типы данных и атомарные операции

Проверьте, что хранилище поддерживает ваши примитивы:

- простые значения (строки/байты) vs структуры (списки, множества, хэши);

- атомарные операции: инкременты, compare-and-set, транзакции или скрипты;

- блокировки и семафоры (если планируете координацию между воркерами).

Если вам нужны богатые структуры и атомарность «из коробки», часто смотрят в сторону Redis и его альтернатив. Если достаточно простого get/set при большом масштабе — важнее окажутся горизонтальное масштабирование и стабильные хвосты задержек.

4) Чек-лист перед внедрением в продакшен

- Какие данные можно потерять без последствий, а какие — нет?

- Какой целевой SLA и что будет при деградации кэша?

- Нужны ли TTL, массовое истечение ключей и защита от всплесков пересоздания?

- Как будете делать шардинг и репликацию, кто управляет фейловером?

- Какие метрики обязательны: p95/p99, hit rate, eviction rate, память, сетевые ошибки?

- Как выглядят бэкапы/восстановление (если требуется), и проверяли ли вы это на практике?

Если пройтись по этому списку до выбора технологии, вы заметно сократите риск «не того» хранилища и неприятных сюрпризов после запуска.

Как быстро применить это в реальном проекте

Частая проблема на старте — не выбрать «идеальную» технологию, а быстро собрать рабочую архитектуру и проверить нагрузочный профиль: где у вас повторяющиеся чтения, какие ключи «горячие», где нужен TTL и какие хвосты задержек допустимы.

Если вы делаете продукт и хотите быстрее дойти до прототипа (например, API + веб-интерфейс + сессии и кэш), это удобно собрать в TakProsto.AI — платформе для vibe-кодинга, где приложение создаётся через чат. Вы описываете сценарии (кэширование профиля, хранение session:{id} с TTL, rate limiting по ключу), а платформа помогает развернуть основу: веб на React, бэкенд на Go, PostgreSQL для «источника правды», плюс интеграции под кэш и сессии. При необходимости можно экспортировать исходники, включить деплой/хостинг, подключить домен, а также пользоваться снапшотами и откатом.

Для российских команд отдельно полезно, что TakProsto.AI работает на серверах в России и использует локализованные и open-source LLM-модели, не отправляя данные за пределы страны — это иногда становится решающим фактором, когда обсуждаются сессии, токены и пользовательские данные.