31 июл. 2025 г.·8 мин

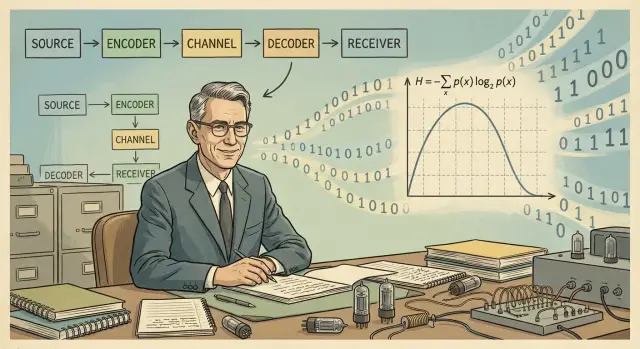

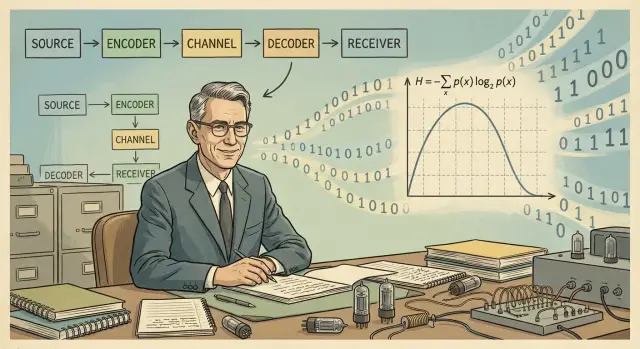

Клод Шеннон и теория информации: сжатие, связь и ошибки

Как идеи Шеннона объясняют сжатие данных, передачу по шумным каналам и надёжность сетей: энтропия, пределы связи и исправление ошибок.

Как идеи Шеннона объясняют сжатие данных, передачу по шумным каналам и надёжность сетей: энтропия, пределы связи и исправление ошибок.

Клод Шеннон — человек, который в середине XX века предложил простой, но мощный способ думать о данных: как о сообщениях, которые можно измерять, сжимать и передавать по шумному каналу так, чтобы смысл доходил до получателя.

Его вклад важен не потому, что он «придумал интернет», а потому что дал математический язык для того, что ежедневно делают продукты и команды: пересылают данные между устройствами, экономят трафик, уменьшают задержки и борются с ошибками.

Теория информации отвечает на три практических вопроса:

«Сколько информации?» — измерение в битах и степень предсказуемости сообщения.

«Насколько шумно?» — шум не только про радиопомехи; это и потери пакетов, и ошибки памяти, и неверные биты при хранении.

«Какой нужен запас?» — где выгоднее сжимать, где выгоднее дублировать, и как найти баланс между скоростью, стоимостью и надёжностью.

Дальше пройдём эти идеи простым языком и свяжем их с привычными вещами: компрессией, ограничениями канала, кодами исправления ошибок и надёжностью сетей.

Информация у Шеннона — не «смысл» и не «полезность», а очень практичная величина: насколько сообщение уменьшает неопределённость.

Если вы заранее почти уверены в исходе, то даже точное сообщение добавит немного информации. А если вариантов много и все выглядят одинаково вероятными — одно короткое сообщение может снять большую неопределённость.

Представьте, что вы ждёте ответ на вопрос «что произошло?». До ответа у вас есть набор гипотез. Сообщение ценно ровно тем, насколько оно сужает этот набор.

Шеннон предложил измерять эту «убранную неопределённость» математически — так, чтобы можно было сравнивать разные сообщения и проектировать системы связи, сжатия и защиты от ошибок.

Бит связан с выбором между двумя равновероятными вариантами. Один бит — это ответ на вопрос, который делит мир на два одинаково вероятных исхода.

Эта единица удобна, потому что:

Бросок честной монеты. До броска два исхода равновероятны. Сообщение «орёл» или «решка» снимает неопределённость ровно на один двоичный выбор — то есть примерно на 1 бит.

Редкое событие. Если событие случается, скажем, в 1% случаев, то сообщение «оно произошло» неожиданнее. Интуитивно оно несёт больше информации, потому что до сообщения вы почти были уверены в обратном.

Отсюда важная мысль для практики: система сжатия и передачи должна «ценить» редкие символы/события выше частых — именно это потом превращается в идеи вроде переменной длины кодов и оптимального кодирования.

В повседневной речи «данные» и «информация» часто смешивают, но у Шеннона различие полезно:

Один и тот же файл данных может содержать много «символов», но мало новой информации (например, повторяющийся шаблон), или наоборот — быть коротким, но очень информативным (например, сообщение о критическом инциденте). Это различие напрямую связывает «информацию» и со сжатием данных, и с надёжной связью.

Энтропия в теории информации — способ оценить, сколько информации в среднем несёт один символ сообщения. Не «насколько оно важное», а насколько оно непредсказуемое. Чем больше неожиданности, тем больше информации приходится передавать.

Если символ встречается часто, получатель почти ожидает его увидеть — значит, сообщать его можно более коротко. Такой символ в среднем «стоит дешевле». А редкий символ — неожиданность, его нужно обозначить более «дорогим» способом: больше битов, более длинный код.

Представьте алфавит из четырёх символов: A, B, C, D.

Интуитивно: тратить одинаковое число битов на A и на D невыгодно. Если кодировать все символы одинаково, мы будем постоянно переплачивать за очень частую A. Сжатие делает наоборот: даёт A короткое представление, B — чуть длиннее, C — ещё длиннее, а D — самое длинное.

Важно, что энтропия — это среднее. Иногда попадётся редкий D, и «цена» конкретного символа окажется высокой, но по длинному сообщению средняя стоимость стремится к энтропии.

Энтропия задаёт нижнюю границу: насколько компактным вообще может стать сообщение при идеальном сжатии без потерь. Если ваши данные очень предсказуемы (много повторов, перекосы частот), энтропия низкая — сжимать можно сильно. Если символы почти равновероятны и «случайны», энтропия высокая — заметного выигрыша не будет.

Поэтому, прежде чем обещать кратное снижение размера, полезно спросить: данные правда предсказуемы или уже близки к максимальной энтропии?

Сжатие данных — практическое применение идеи Шеннона: в сообщениях часто есть избыточность, и её можно убрать, не разрушая передаваемую информацию. Важно разделять два режима: сжатие без потерь и сжатие с потерями.

Без потерь означает, что после распаковки получаем точную копию исходных данных, бит-в-бит. Это критично для текста, логов, таблиц, исходников, конфигураций — всего, где «почти то же самое» не подходит.

На уровне идей это обычно сводится к двум вещам:

С потерями мы сознательно выбрасываем часть данных, которые для человека или задачи менее заметны/важны. Так обычно сжимают изображения и звук: небольшие искажения допустимы ради кратного выигрыша в размере.

Ключевое слово здесь — контролируемо: вы выбираете качество (и размер), понимая компромисс. Для продуктовых команд это часто означает настройку профилей: быстрый предпросмотр vs финальная выгрузка, «экономия трафика» vs «максимум качества».

Энтропия — ориентир того, насколько вообще можно ужать данные, если вы хорошо понимаете их статистику. Если источник почти случайный (энтропия высокая), чудес не будет: без потерь сжать почти не получится. А если в данных много повторов и предсказуемости (как в логах или типовом тексте), потенциал сжатия большой.

Практический вывод: улучшая модель (предсказание, повторное использование фрагментов), вы приближаетесь к теоретическому пределу — и перестаёте ждать невозможного от «ещё одного архива».

Шеннон предложил модель, которая одинаково хорошо описывает и радиосвязь, и интернет, и чтение данных с диска. Её сила в том, что она разделяет «что мы хотим передать» и «что мешает передать это идеально».

В упрощённом виде цепочка выглядит так:

источник → кодер → канал → декодер → получатель

Шум — всё, что непредсказуемо искажает сигнал по пути. Он может выглядеть по‑разному:

Реальные каналы почти никогда не идеальны. В радио сигнал ослабевает и отражается, в кабеле есть затухание и внешние помехи, в хранении данных — физические дефекты и старение памяти.

На бытовом уровне:

Эта разница практична: с ошибками борются кодами исправления, с задержками — управлением очередями и скоростью, с потерями — повторными передачами и буферизацией.

Предел Шеннона — честный ответ на вопрос: сколько полезных данных в секунду вообще можно выжать из данного канала связи при заданном уровне шума. Эту величину называют пропускной способностью канала (capacity). Она задаёт теоретический потолок: быстрее — можно, но уже не для полезной информации, а для ошибок.

Представьте, что вы кричите через шумную улицу. Можно говорить громче или повторять, но в какой-то момент часть усилий уходит на то, чтобы «перекричать» шум, а не донести новый смысл.

В цифровом канале похожая логика: чем больше шума и помех, тем меньшую долю передаваемых изменений приёмник способен уверенно отличить от случайных искажений. Предел Шеннона фиксирует максимум этой «доли смысла» в битах/сек.

Если скорость передачи ниже пропускной способности, то существуют такие коды, которые позволяют сделать вероятность ошибки сколь угодно малой (теоретически — почти нулевой).

Если скорость выше предела, то никакая магия кодов не спасёт: ошибки будут неизбежны, и снижение их до приемлемого уровня станет невозможным.

Для инженеров и продуктовых команд это превращается в набор реальных решений:

Главный вывод: ускорить передачу «просто настройками» удаётся лишь пока есть запас по отношению к физическим условиям канала. Дальше упираемся в теорию информации — и в реальный мир.

Когда мы отправляем данные по реальному каналу (радио, кабель, Wi‑Fi), в них неизбежно появляются искажения: отдельные биты «переворачиваются», пакеты теряются, фрагменты приходят не в том порядке. Интуитивный ответ — добавить избыточность: немного «лишних» данных, которые помогут понять, что пошло не так, и восстановить исходное сообщение.

Избыточность — это страховка. Мы жертвуем частью полезной скорости ради того, чтобы получатель не гадал, что имел в виду отправитель.

Простейший пример — контрольная сумма: отправитель считает число (или хэш) по содержимому, а получатель пересчитывает и сравнивает. Если не совпало — значит, где-то ошибка.

Важно различать два режима:

Паритетный бит — минимальный пример обнаружения: к набору битов добавляется ещё один, чтобы сумма единиц была чётной/нечётной. Он ловит часть ошибок, но не умеет уверенно «лечить» данные.

Исправление начинается там, где избыточность организована умнее: например, блочные коды добавляют несколько проверочных символов к каждому блоку так, чтобы по их комбинации можно было вычислить и исправить определённое число ошибок.

Каждый проверочный бит занимает место в канале. Чем сильнее защита, тем ниже доля полезной нагрузки: условно, пакет становится тяжелее, а «пользы» в нём меньше.

Здесь проявляется идея Шеннона: у канала есть предельная пропускная способность при данном уровне шума. Коды исправления ошибок помогают приблизиться к этой границе, но не отменяют её. Если пытаться передавать быстрее, чем канал в принципе позволяет, никакая избыточность не спасёт — ошибки будут накапливаться.

На практике выбор кода — баланс между скоростью, задержкой и требуемой надёжностью: для потокового аудио допустимы редкие огрехи, а для банковской транзакции — нет.

Когда мы говорим «сеть работает», это почти всегда заслуга комбинации нескольких уровней защиты. Часть проблем решают на физическом уровне (сигнал, помехи, кодирование на линии). Остальное берут на себя протоколы выше: они замечают потери и организуют повторные доставки.

В реальных каналах данные портятся и пропадают по разным причинам: радиопомехи и затухание сигнала, одновременные передачи (коллизии), перегрузка очередей в оборудовании, ошибки синхронизации. В пакетных сетях это выглядит так: пакет пришёл с ошибкой, не пришёл вообще или пришёл слишком поздно — и система должна как-то восстановиться.

Коды исправления ошибок добавляют в поток небольшую избыточность так, чтобы приёмник мог восстановить исходные биты без запроса повтора. Это особенно важно там, где повторная передача дорогая или невозможна:

Идея простая: мы жертвуем частью скорости ради меньшего числа сбоев.

ARQ (Automatic Repeat reQuest) работает по принципу «не дошло — переспросим»: получатель подтверждает доставку, а при ошибке отправитель шлёт пакет заново. Это эффективно, когда задержка небольшая и канал в целом неплохой.

Но если задержка велика (спутник) или связь нестабильна, постоянные повторы раздувают время доставки и рвут предсказуемость. Тогда выгоднее исправлять больше ошибок сразу на стороне приёмника (FEC), даже если полезная скорость ниже.

Проектирование надёжности — это всегда компромисс:

На практике надёжная сеть получается «слоёным пирогом»: физический уровень снижает число ошибок, а протоколы аккуратно закрывают оставшиеся потери.

Сжатие и защита от ошибок выглядят как взаимные противоположности. Сжатие старается убрать избыточность (повторы, предсказуемые паттерны), чтобы передать меньше данных. А коды исправления ошибок, наоборот, добавляют избыточность, чтобы получатель мог восстановить потерянные или искажённые биты.

В типичном пайплайне сначала применяют сжатие (например, аудио/видео-кодек или архиватор), а затем поверх результата добавляют защиту: контрольные суммы, повторные передачи или FEC-коды.

Причина простая: если вы добавили «защиту» заранее, сжатие часто воспримет её как шум и частично уничтожит. В итоге вы заплатили лишними битами за избыточность, которая не доживёт до канала.

Есть и экономический аргумент: сжатие уменьшает объём, значит на ту же пропускную способность можно потратить больше «бюджета» на надёжность.

Иногда требования реального времени заставляют отходить от идеальной схемы.

Например:

На практике чаще не переворачивают порядок полностью, а дробят данные на небольшие блоки, добавляют лёгкую защиту и отправляют поток так, чтобы потери не убивали целые секунды контента.

Для голоса в звонке обычно важнее задержка, чем безупречная точность каждого звука. Поэтому выбирают кодек и настройки, которые быстро работают, а ошибки маскируют: небольшим FEC, интерполяцией, скрытием потерь.

Для видео в стриме компромисс другой: можно позволить буфер (чуть больше задержки), чтобы реже видеть «квадратики» и рывки.

Теория информации даёт язык для расчёта компромиссов: сколько битов вы экономите сжатием, сколько «покупаете» надёжности избыточностью, и как это превращается в качество, задержку и стоимость передачи. Поэтому спор «сжатие или защита» лучше переводить в цифры и ограничения канала.

Теория информации часто воспринимается как «абстрактная математика», но для продукта она работает как набор ограничений и ориентиров: что в принципе достижимо при заданной скорости, шуме, задержке и допустимых потерях.

Не всегда. Есть сжатие без потерь (например, для текстов, логов, исходников, некоторых типов данных), где цель — уменьшить объём, сохранив точные байты. Оно упирается в энтропию источника: если данные уже «случайные» (зашифрованы, хорошо перемешаны, уже сжаты), выигрыш будет минимальным.

Есть сжатие с потерями (аудио/видео/изображения), где качество действительно меняется, но это управляемый компромисс. Практический вывод: качество падает не «из-за сжатия вообще», а из-за выбранного уровня потерь и особенностей контента. Команде важно отделять: где нужен абсолютный бит-в-бит, а где важнее скорость, стоимость хранения и пользовательское восприятие.

Ошибки в канале действительно возникают, но неизбежность не означает безнадёжность. Шеннон показал: при скорости ниже пропускной способности канала можно передавать данные сколь угодно надёжно — ценой вычислений и/или избыточности. На практике это реализуется через коды исправления ошибок, повторные передачи, интерливинг, адаптивные профили.

Она не обещает «идеальный мир», но даёт:

В повседневной разработке эти вопросы всплывают и при создании приложений: логирование, доставка событий, офлайн‑режим, ретраи, выбор форматов и компрессии. Если вы собираете прототип или внутренний сервис в TakProsto.AI (vibe‑coding платформа для российского рынка), удобно быстро накидать поток данных (веб/сервер/мобайл), а затем уже «докрутить» надёжность: где нужен FEC/повторы, где достаточно контрольных сумм, где полезнее сжатие. Плюс, при необходимости можно экспортировать исходники и продолжить оптимизацию в привычном пайплайне.

Теория информации ценна не тем, что даёт «магические» формулы, а тем, что помогает быстро оценить пределы: где можно выиграть, а где вы упрётесь в физику, статистику и экономику.

Если свести идеи Шеннона в одну «картинку», получится цепочка, понятная даже без математики:

Ставьте реалистичные цели по качеству связи. Если команда хочет «и быстрее, и без ошибок, и без трафика», это повод вернуться к ограничениям: скорость, надёжность и избыточность связаны.

Разделяйте задачи сжатия и защиты. Сжатие убирает лишнее, а исправление ошибок добавляет служебные данные. Это противоположные инструменты, и их порядок/настройки влияют на итоговую задержку и стоимость.

Планируйте измерения заранее. Теория подсказывает, какие метрики важны (ошибки, пропускная способность, задержка, доля служебных данных), и помогает сформулировать гипотезы.

Теория не заменяет тесты: реальная сеть, устройства и пользовательские сценарии часто ломают красивую модель. Зато она помогает не тратить недели на заведомо недостижимые обещания и выбирать, что оптимизировать в первую очередь.

Если хотите углубиться — загляните в другие материалы в блоге: /blog.

Если у вас есть прикладная задача (сжатие, надёжность передачи, стоимость трафика), можно обсудить требования и ограничения и понять, какие возможности продукта подходят — при желании посмотрите детали на /pricing.

У Шеннона «информация» — это не смысл, а уменьшение неопределённости.

Потому что бит естественно соответствует выбору между двумя равновероятными вариантами.

На практике это удобно, потому что:

Энтропия — это средняя непредсказуемость символов источника: сколько бит в среднем нужно на «один символ».

Практически она отвечает на вопрос: есть ли вообще запас для сжатия без потерь? Если данные уже похожи на случайные, энтропия высокая и выигрыш будет маленьким.

Потому что такие данные уже близки к «шуму» с точки зрения статистики.

Типичные примеры:

Полезная тактика: сначала оценить эффект на небольшом сэмпле и мерить выигрыш в байтах и CPU/задержке.

Предел Шеннона (пропускная способность) — это теоретический потолок полезной скорости для данного канала при заданном уровне шума.

Если вы пытаетесь передавать быстрее этой границы, ошибки становятся неизбежными. Если ниже — существуют схемы, которые позволяют сделать вероятность ошибки очень маленькой, но ценой избыточности и вычислений.

Шум — это всё, что непредсказуемо портит данные по пути.

В прикладных системах он проявляется как:

Важно разделять: ошибка ≠ потеря ≠ задержка — лечатся разными механизмами.

Контрольная сумма (например, CRC) в основном обнаруживает повреждение: «что-то не так».

Коды исправления ошибок (FEC) устроены так, что приёмник может восстановить данные без повтора — если ошибок не больше, чем заложено в схему.

Практический выбор:

Обычно да: сначала убирают избыточность сжатием, потом добавляют «служебные» биты для надёжности.

Если сделать наоборот, сжатие может «сломать» структуру защиты и уменьшить её пользу.

Исключения бывают в real-time сценариях, где критична задержка: тогда чаще не меняют порядок, а дробят данные на небольшие блоки и добавляют лёгкую защиту на уровне пакетов.

ARQ (повторы) хорошо работает, когда:

FEC выгоднее, когда:

Часто используют гибрид: немного FEC + повторы для редких провалов.

Минимальный набор метрик, который помогает принимать решения:

Дальше решения становятся проще: снижать скорость, менять профили качества, добавлять/убирать избыточность или улучшать канал.