30 нояб. 2025 г.·8 мин

Кнут и TAOCP: зачем основы важны в эпоху фреймворков и ИИ

Зачем читать Кнута и TAOCP, когда есть фреймворки и ИИ-инструменты: переносимые навыки, мышление об алгоритмах и план изучения.

Зачем читать Кнута и TAOCP, когда есть фреймворки и ИИ-инструменты: переносимые навыки, мышление об алгоритмах и план изучения.

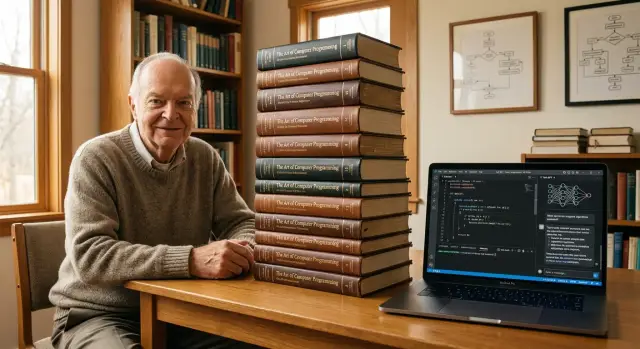

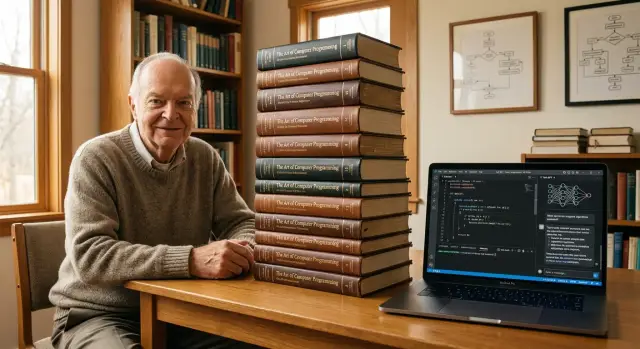

Дональд Кнут — один из тех редких авторов, чьи книги читают не «для галочки», а чтобы навести порядок в голове. Его имя всплывает в спорах инженеров, когда разговор упирается в базовые вещи: почему алгоритм вообще работает, где границы применимости, и что мы теряем, когда выбираем «быстро собрать» вместо «понять».

The Art of Computer Programming (TAOCP) — серия томов, которая устроена не как учебник «с нуля» и не как справочник по API. Это тщательно выстроенная энциклопедия алгоритмов и методов с акцентом на строгость: определения, доказательства, оценки сложности, аккуратные примеры и упражнения.

Уровень входа: уверенное программирование, математика на уровне дискретной математики и готовность разбирать материал медленно. Нормально, если одна глава растягивается на недели — так книга и задумана.

TAOCP ценна не тем, что вы «выучите правильные реализации», а тем, что начнёте точнее выбирать инструменты и видеть цену решений.

Книга не научит продуктовым решениям, коммуникации, приоритизации, работе с требованиями и компромиссами в команде. Она также не заменяет опыт эксплуатации: мониторинг, инциденты, безопасность, интеграции и неизбежные ограничения сроков.

Хороший ориентир: относитесь к TAOCP как к тренажёру инженерного мышления. Вы не обязаны помнить детали, но полезно знать, как Кнут рассуждает, и переносить эту дисциплину в повседневные проекты.

Фундаментальные знания в программировании — это не «набор трюков», привязанных к конкретному языку или библиотеке. Это идеи и модели мышления, которые остаются верными, даже когда меняются синтаксис, инструменты и модные подходы. Кнут ценен именно этим: он учит видеть за кодом структуру задачи.

Под глубокими основами обычно понимают: как устроены вычисления, как представляются данные, какие операции реально выполняет машина и как доказать, что алгоритм работает правильно. Это не обязательно «академическая математика», скорее привычка рассуждать точно.

Например, вы можете забыть API конкретного фреймворка, но не забудете, что поиск по отсортированному массиву устроен иначе, чем по неупорядоченному списку, и что цена операции «вставить в середину» зависит от выбранной структуры данных.

Есть несколько принципов, которые «переезжают» между стеками почти без потерь:

Фреймворки оптимизированы под текущие практики: меняются требования бизнеса, появляются новые платформы, авторы пересобирают API, а сообщество мигрирует. Поэтому знания про конкретные «правильные» аннотации, хуки или конфигурации легко устаревают.

А вот базовые модели вычислений — что такое алгоритм, как растёт сложность, почему кэш помогает, а лишние аллокации вредят — привязаны не к моде, а к физике железа и логике задач.

Фундаментальная база проявляется сильнее всего там, где «погуглить ошибку» уже недостаточно:

Именно поэтому TAOCP читают не ради ностальгии, а ради навыка думать на уровень глубже, чем текущий набор инструментов.

Фреймворк экономит время: он берёт на себя маршрутизацию, доступ к данным, сериализацию, ретраи, очереди, наблюдаемость. Но вместе с удобством он прячет детали, которые напрямую влияют на деньги и нервы: сколько запросов уйдёт в базу, где появится лишняя сортировка, почему «просто фильтр» внезапно стал O(n²), и откуда берутся таймауты.

Обычно скрыты три слоя:

Риск в том, что система работает «нормально» на тестовых данных, а при росте — деградирует скачками. И отладка превращается в гадание, потому что источник проблемы спрятан за красивым API.

«Думать алгоритмами» — это привычка задавать вопросы: что является входом, какой размер данных, сколько раз я прохожу по ним, где сортирую, что храню в памяти. Это особенно полезно в типовых задачах:

TAOCP не требует переписывать всё «по Кнуту». Достаточно взять принцип: описать задачу, выбрать структуру данных, оценить сложность, проверить инварианты.

Практичный приём: когда используете метод фреймворка, мысленно замените его на «чёрный ящик» и сформулируйте, какой алгоритм может быть внутри и какова цена на ваших объёмах. Если цена неясна — измерьте (профилирование, метрики) и только потом оптимизируйте.

Структуры данных — это не «учебные контейнеры», а способ управлять стоимостью изменений. Когда требования меняются (а они меняются всегда), выбранная структура определяет, насколько больно будет: дописать фичу, ускорить узкое место, внедрить кэш, обеспечить целостность или объяснить поведение системы новому человеку.

Практичный вопрос звучит не «что быстрее в среднем», а «какие операции у нас главные и какие гарантии нужны».

В проектах важны не только средние оценки, но и свойства, влияющие на сопровождение:

«Сначала всё в JSON» часто означает: нет явной схемы, нет ограничений, сложно валидировать и оптимизировать запросы. А «потом разберёмся с производительностью» нередко заканчивается тем, что данные уже сформированы так, что быстрый доступ требует дорогих миграций.

Подход Кнута здесь приземлённый: сначала формализуйте операции и инварианты данных, а уже затем выбирайте структуру — так решения становятся инженерными, а не вкусовыми.

Когда алгоритм «вроде работает», но вы не можете объяснить почему — это сигнал, что не хватает опоры. Инвариант даёт эту опору: это утверждение, которое остаётся истинным на каждом шаге выполнения (чаще всего — внутри цикла или рекурсивного процесса). Кнут постоянно возвращает читателя к такой дисциплине мышления: сначала формулируем, что должно быть верно всегда, а уже потом оптимизируем и «причёсываем» реализацию.

Инвариант превращает код в проверяемую историю. Вместо «мы двигаем указатели, пока не найдём» вы говорите: «после каждой итерации мы точно знаем X». Это уменьшает количество скрытых допущений и делает правки безопаснее.

Пример: в сортировке вставками типичный инвариант звучит так: «к началу каждой итерации префикс массива до i уже отсортирован». С ним легко проверить, что шаг вставки действительно сохраняет порядок.

Доказательство корректности часто можно свести к трём вопросам:

Предусловия: что обязано быть верно на входе (например, массив не null, индексы в диапазоне)?

Постусловия: что должно быть верно на выходе (например, «массив отсортирован по неубыванию, и это перестановка исходных элементов»)?

Крайние случаи: пустой ввод, один элемент, повторы, максимальные значения, уже отсортировано/обратно отсортировано.

Если инвариант + предусловия логически ведут к постусловиям — алгоритм перестаёт быть магией.

Инварианты и постусловия удобно переводятся в свойства для property-based тестирования: вы генерируете много входов и проверяете не конкретный результат, а правило.

Пример для сортировки: «результат отсортирован» и «мультимножество элементов не изменилось». Генерация случаев (случайные массивы, в том числе с повторами и крайними значениями) быстро ловит ошибки, которые сложно придумать вручную.

Почти в любой команде звучит мысль: «Если что — добавим серверов или возьмём побольше ресурсов». Это работает, пока рост нагрузки близок к линейному и проблема действительно в «железе». Но сложность алгоритма может сделать рост затрат взрывным: при O(n²) удвоение данных даёт примерно четырёхкратное время. И тогда масштабирование превращается в бесконечную закупку ресурсов и деградацию пользовательского опыта.

Чаще всего «падает» не из-за сложной математики, а из-за незаметных решений в бытовом программировании:

contains() на массиве, сортировка на каждой итерации.TAOCP приучает задавать простой вопрос: «Как растёт стоимость операции, когда данных становится больше?» — и находить узкие места ещё до того, как их заметит мониторинг.

Сначала оценка на бумаге: прикинуть порядок сложности и точки роста (где появляется вложенность, сколько раз выполняется дорогая операция, сколько памяти выделяется).

Потом профилирование: подтвердить гипотезу цифрами и найти конкретные функции/запросы, которые «жгут» время или память.

Этот порядок экономит время: профилировщик отлично показывает «где», но не всегда отвечает «почему так растёт».

Оптимизируйте то, что даёт крупный выигрыш: смена алгоритма, правильная структура данных, уменьшение числа обращений к базе/сети, кэширование горячих результатов. Микрооптимизации часто добавляют сложность, но не меняют картину.

Правило: сначала устраняйте очевидные O(n²) и лишние I/O, затем думайте о тонкой настройке — и обязательно фиксируйте эффект измерениями.

TAOCP читается медленно — и это нормально. Кнут пишет так, чтобы вы не просто «узнали факт», а поняли, почему он верен и где ломается. Поэтому скорость чтения здесь почти не показатель эффективности: важнее глубина усвоения и способность применить идею в своей задаче.

Не обязательно идти строго с первой страницы до последней. Лучше начать с вопроса: «Что мне сейчас нужно усилить — сортировки, структуры данных, генерацию, анализ?» Затем выбирайте небольшие фрагменты и доводите их до понятного состояния.

Хороший ритм: 30–60 минут чтения → 30–60 минут практики. Практика может быть простой: реализовать алгоритм, сравнить варианты, написать тесты, подобрать контрпримеры.

Чтение «в стол» быстро утомляет. После каждой ключевой идеи делайте один артефакт:

Так вы превращаете книгу из «энциклопедии» в рабочий инструмент.

Обозначения у Кнута плотные. Не пытайтесь держать всё в голове. Сделайте отдельный файл/тетрадь «Символы и термины» и пополняйте его по мере чтения:

Через пару недель это начинает экономить время сильнее, чем любая «быстрая» техника чтения.

Рабочие метрики:

Если после главы вы можете объяснить идею коллеге и применить её в небольшом эксперименте — вы продвинулись, даже если прочитали всего несколько страниц.

Читать TAOCP полезно, но настоящий «щелчок» происходит, когда вы берёте одну идею и проверяете её руками. Формат, который хорошо работает: одна концепция из раздела — один мини‑проект на 1–2 вечера. Это достаточно мало, чтобы не утонуть в перфекционизме, и достаточно конкретно, чтобы появилась инженерная привычка: «понял → реализовал → проверил».

Ограничьте масштаб заранее: один алгоритм, одна структура данных, один сценарий использования. Важно не «сделать продукт», а довести эксперимент до ясного результата.

Примеры упражнений (выбирайте по интересу):

Мини‑проект считается завершённым, когда:

В конце добавьте в README блок «Наблюдения»: что оказалось важнее, чем ожидалось (например, влияние распределения данных на хеширование или цена лишних копирований), какие инварианты помогли не ошибиться, и что бы вы проверили дальше, если было бы ещё два часа. Такой дневник прогресса превращает чтение Кнута в прикладной навык, а не в коллекцию теории.

ИИ‑инструменты могут заметно ускорять работу с алгоритмами и структурами данных, но они опасны тем, что создают иллюзию понимания: «ответ выглядит убедительно — значит, верно». Подход Кнута полезен как противоядие: сначала смысл и корректность, потом удобство.

Во-первых, как «поясняющий собеседник»: попросите развернуть идею простыми словами, привести маленький пример и пройтись по шагам.

Во-вторых, как генератор проверок: он хорошо предлагает набор тестов, включая случайные тесты и свойства (например, монотонность, идемпотентность, сохранение суммы и т. п.).

В-третьих, как источник альтернатив: ИИ может подсказать другой алгоритм или структуру данных, о которой вы не думали, и это ценно для расширения кругозора.

Отдельный практичный сценарий — быстро собрать учебный прототип и проверить гипотезу. Например, в TakProsto.AI можно в формате чата набросать небольшое веб‑приложение (React) или сервис на Go с PostgreSQL, добавить генерацию тестов и простую страницу со сравнением замеров — а затем экспортировать исходники и продолжить доработку привычными инструментами. Для таких экспериментов особенно полезны snapshots и откат, чтобы смело пробовать разные реализации.

Наиболее частые провалы — крайние случаи и неявные предположения (пустой ввод, повторы, переполнение, нестабильность сортировки, особенности сравнения).

Второй класс ошибок — «доказательства»: текст может выглядеть логично, но содержать скачки мысли или подмену тезиса.

Третий — оценка сложности: ИИ путает амортизированную и худшую сложность, игнорирует константы и реальные ограничения памяти/кэша.

Просите не только решение, а форму мысли:

Никогда не принимайте ответ «на доверии». Проверяйте на примерах, тестами и измерениями: прогоните граничные случаи, сделайте случайное тестирование, сравните с эталонной (пусть медленной) реализацией, померьте время и память. ИИ полезен, пока он ускоряет вашу проверку — а не заменяет её.

Подход Кнута ценен не тем, что «все должны прочитать TAOCP от корки до корки», а тем, что он задаёт стандарт мышления: формулируй задачу точно, проверяй корректность, измеряй стоимость решений и честно описывай компромиссы. Это полезно не только разработчикам, но и тем, кто принимает продуктовые и управленческие решения.

TAOCP приучает считать «цену» решения шире, чем время написания:

Для лида это превращается в понятный вопрос на планировании: «Какой сценарий роста/нагрузки мы считаем нормой и где у решения предел?» — вместо абстрактного «потом оптимизируем».

Кнутовский стиль — фиксировать допущения. Если берём быстрое решение, проговорите:

Так компромисс становится управляемым, а не скрытым.

Хорошее ревью — это не про вкус. Просите автора коротко ответить:

Какой инвариант/условие должно быть истинным всегда?

Какова асимптотика в худшем случае и почему это приемлемо?

Что будет самым частым изменением и насколько легко его внести?

Закрепите норму: аргументы важнее авторитета. Если человек не может объяснить выбор алгоритма/структуры данных простыми словами, решение ещё не готово — даже если тесты сейчас проходят.

Хороший план по Кнуту — это не «прочитать том», а выстроить ритм: чуть теории, чуть практики, и обязательная проверка понимания на задачах. Ниже — ориентир, который можно адаптировать под 3–5 часов в неделю.

Цель: вернуть чувство опоры в базовых идеях (алгоритмы, структуры данных, оценка сложности) и не перегореть.

Простые метрики прогресса:

Цель: перейти от понимания к инженерной привычке.

Если вы делаете внутренние учебные мини‑проекты или хотите быстрее превращать идеи из книг в рабочие прототипы, попробуйте выстроить процесс так, чтобы эксперимент занимал часы, а не недели: короткая постановка, быстрый прототип, тесты, замеры, выводы. В этом смысле чат‑подход TakProsto.AI хорошо ложится на дисциплину Кнута: сначала формулируете инварианты и критерии корректности, затем быстро собираете минимальную реализацию, измеряете и при необходимости откатываетесь к предыдущему снимку.

TAOCP — это не учебник «с нуля» и не справочник по библиотекам. Он полезен, если вы хотите:

Если цель — быстро освоить фреймворк или собрать продуктовый прототип, TAOCP будет избыточен.

Комфортный минимум:

Практический тест: если вы можете объяснить разницу между O(n) и O(n log n) и написать простую структуру данных без подсказок — вход обычно достаточный.

Рабочая стратегия:

Так книга превращается в инструмент, а не в марафон на выносливость.

Полезный шаблон на 1–2 вечера:

В README запишите, что удивило: где упёрлись в память, где выросли константы, где помог инвариант.

Фреймворк часто скрывает цену операций. Практичный чек-лист:

Если стоимость не ясна — измеряйте профилировщиком и метриками, а не предположениями.

Быстрый выбор начинается с вопроса: какие операции главные.

Дальше уточните ограничения: память, предсказуемость задержек, стоимость сопровождения (инварианты должны быть простыми).

Потому что ошибки чаще всего живут в допущениях. Минимальная схема:

Если вы можете проговорить эти пункты простыми словами, код становится легче ревьюить и безопаснее менять.

Начинайте с самого дорогого и самого частого:

O(n²) (поиск внутри цикла, сортировка на каждой итерации);Микрооптимизации трогайте только после этого и только с замерами «до/после».

Удобная последовательность:

«На бумаге» прикиньте порядок роста: где вложенность, сколько проходов, где память.

Профилированием подтвердите, где именно тратится время/память.

Оптимизируйте гипотезу с наибольшим потенциалом (алгоритм/структура/I/O), затем снова измерьте.

Так вы избегаете ситуации, когда профилировщик показывает симптом, а причина остаётся непонятной.

ИИ полезен как ускоритель, но не как источник истины. Практика:

Если нужно больше идей упражнений и разборов — смотрите /blog. Для системного обучения команды и трекинга прогресса может пригодиться /pricing.