05 июл. 2025 г.·8 мин

Лесли Лэмпорт и распределённые системы: время и порядок

Разбираем идеи Лесли Лэмпорта о логическом времени, порядке событий и корректности: happens-before, часы Лэмпорта, Paxos, TLA+ и выводы.

Почему распределённым системам нужна теория времени

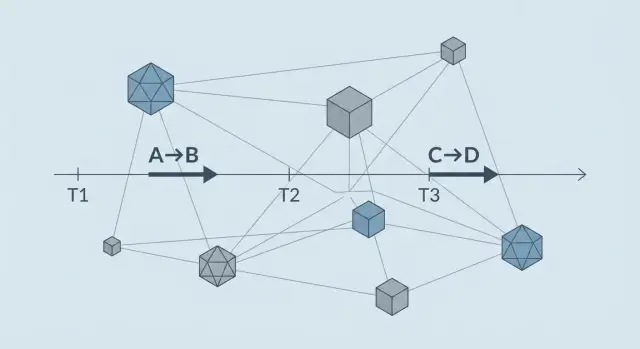

Распределённая система — это множество компьютеров, которые делают «одно дело», но видят мир по‑разному. У каждого узла свои часы, своя очередь сообщений и своя реальность. Поэтому привычная интуиция «сначала произошло A, потом B» часто не работает: два события могут быть одновременны с чьей‑то точки зрения и строго упорядочены — с другой.

Почему «время» и «порядок» становятся проблемой

На одном компьютере порядок действий задаёт процессор и ОС. В распределённой системе порядок рождается из обмена сообщениями, а сообщения:

- приходят с задержкой и в разном порядке;

- могут потеряться или дублироваться;

- могут «застрять» из‑за перегрузки сети;

- иногда приходят уже после того, как отправитель перезапустился.

В результате два сервиса могут принять взаимоисключающие решения, оба «будучи уверенными», что действовали первыми. Именно здесь и нужна теория времени: она помогает формально описать, что значит “раньше/позже”, когда физические часы не дают надёжного ответа.

Какие сбои ломают интуицию «сначала/потом»

Даже без аварий достаточно переменной задержки сети: одно и то же событие может быть видно одним узлам почти сразу, а другим — через секунды. Добавьте перезапуски, сетевые разделения и асимметричные потери пакетов — и «общая хронология» распадается.

Что будет дальше

Дальше соберём базовую «грамматику» распределённых систем: причинность (happens-before), логическое время (часы Лэмпорта и векторные), а также модели согласования и корректности.

Чем подход Лэмпорта отличается от «просто синхронизируем часы»

Синхронизация часов улучшает метки времени, но не гарантирует правильного порядка причинно связанных событий. Лэмпорт предлагает начинать не с секунд, а с причинности: кто на что мог повлиять через сообщения — и только затем строить порядок, которому можно доверять.

Лесли Лэмпорт: идеи, которые стали базовой грамматикой

Лесли Лэмпорт — один из тех исследователей, чьи термины и модели незаметно вошли в повседневную инженерную речь. Даже если вы никогда не читали академические статьи, вы наверняка сталкивались с проблемами, которые он помог «разложить по полочкам»: почему два сервиса видят события в разном порядке, как договориться в присутствии сбоев и как доказать, что система делает именно то, что вы задумали.

Что именно он формализовал

Главный вклад Лэмпорта — не «ещё один алгоритм», а язык описания распределённой реальности:

- Порядок событий и причинность: отношение happens-before объясняет, почему «кто раньше» в сети — не про часы на сервере, а про то, какие действия могли повлиять друг на друга.

- Логическое время: часы Лэмпорта дают способ упорядочивать события без веры в идеально синхронизированные таймеры.

- Консенсус и модели сбоев: от Paxos до «Византийских генералов» — это попытки честно ответить, что возможно, а что нет, когда узлы и сеть подводят.

- Спецификации и проверка: TLA+ продвигает мысль, что сложные протоколы нужно сначала точно описывать и проверять на уровне идеи, а не только «отлаживать в продакшене».

Почему это полезно не только авторам протоколов

Идеи Лэмпорта помогают избегать «магических гарантий» вроде «ну у нас же время везде одинаковое» или «повторы запросов не страшны». Они учат смотреть на ограничения: задержки непредсказуемы, сообщения могут дублироваться, узлы — падать, а согласованность — всегда компромисс.

В итоге вы проектируете понятнее: где нужен строгий порядок, где допустима eventual consistency, какие операции должны быть идемпотентными, и какие свойства системы важнее — безопасность (safety) или живучесть (liveness).

Физическое время против причинности: где возникает путаница

В распределённых системах легко перепутать два разных вопроса: «когда это произошло?» и «могло ли одно событие повлиять на другое?». Первое — про физическое время (миллисекунды на часах). Второе — про причинность: цепочку влияний через сообщения, чтения/записи и наблюдаемые эффекты.

Почему синхронизация часов не спасает

Даже если на серверах настроен NTP, точного общего времени всё равно нет. Часы могут дрейфовать, синхронизация происходит рывками, а сеть добавляет задержки. В результате два узла могут честно поставить «правильные» временные метки, но порядок по этим меткам не будет отражать реальный порядок влияния.

Важно: NTP помогает уменьшить расхождение, но не даёт гарантии, что событие A с меньшей меткой действительно произошло «раньше» события B в смысле причинности.

Примеры, где ломается интуиция

Представьте:

- Задержки сети: сервис A отправил сообщение в B, но оно пришло через 2 секунды. За это время B обработал другие запросы и только «потом» получил «раннее» сообщение.

- Перестановка сообщений: два сообщения отправлены подряд, но в сети приходят в обратном порядке — и логика, основанная на физическом времени, делает неверные выводы.

- Частичные отказы: узел временно недоступен, затем возвращается с устаревшим временем или данными; клиент видит скачки и «путешествия во времени».

Что действительно важно

В распределённом дизайне чаще нужно не знать точные миллисекунды, а понимать: могло ли событие X повлиять на событие Y. Это и есть причинность. Из этой точки вырастают логическое время, отношение happens-before и методы упорядочивания событий, устойчивые к задержкам, дрейфу часов и сбоям.

Отношение happens-before: простая модель сложного мира

Когда мы говорим про «порядок» в распределённой системе, чаще всего нас интересует не то, какие события произошли раньше по часам, а могло ли одно событие повлиять на другое. Именно это и фиксирует отношение happens-before (обычно пишут A → B): событие A могло причинно повлиять на событие B.

Интуитивное определение: «могло повлиять»

Если результат B мог зависеть от A (например, B читает данные, записанные в A, или выполняется после получения сообщения, отправленного в A), то A происходит до B в смысле причинности.

Важно: если влияния быть не могло, то «кто раньше» может не иметь смысла — даже если по вашим часам одно выглядит более ранним.

Три источника порядка

Отношение happens-before строится из простых правил:

-

Внутри одного процесса (потока выполнения) события упорядочены программой: если A стоит раньше B, то A → B.

-

Передача сообщений: отправка сообщения происходит раньше, чем его получение. Если A — отправка, а B — получение этого сообщения, то A → B.

-

Транзитивность: если A → B и B → C, то A → C. Так причинная цепочка «склеивается» через несколько узлов.

Несравнимые события: что такое параллельность

Если ни A → B, ни B → A доказать нельзя, события несравнимы. Это не «хаос», а нормальная ситуация: они могли происходить параллельно, и система не обязана иметь единый истинный порядок между ними.

Зачем это нужно: гонки и видимость данных

Happens-before помогает формулировать вопросы правильно: «может ли клиент увидеть запись?», «возможна ли гонка между двумя обновлениями?». Если между записью и чтением нет причинной связи, то чтение может увидеть старое значение — и это не «баг сети», а следствие модели порядка.

Часы Лэмпорта: логическое время для упорядочивания

Часы Лэмпорта — это способ «нумеровать» события в распределённой системе так, чтобы получить согласованное упорядочивание без синхронизации физических часов. Здесь время — не про секунды, а про порядок.

Как назначаются метки времени

У каждого узла есть счётчик (логические часы).

- На каждом локальном событии узел увеличивает счётчик на 1.

- Отправляя сообщение, узел прикладывает текущую метку времени.

- Получая сообщение с меткой

t, узел выставляет свои часы какmax(свои, t) + 1.

Интуиция простая: если событие «узнало» о другом событии через сообщение, оно должно получить больший номер.

Что гарантируют (и чего не гарантируют)

Гарантия: если событие A причинно предшествует B (A могло повлиять на B через цепочку сообщений), то метка времени A будет меньше метки B.

Но обратное неверно: меньшая метка не доказывает причинность. Два независимых события на разных узлах тоже получат разные числа — просто потому, что счётчики где‑то росли быстрее.

Пример: упорядочение логов без глобального времени

Представьте аудит‑лог в микросервисах: платежи, склад, уведомления. Физические часы могут расходиться, а сообщения приходить с задержками. Если каждую запись помечать часами Лэмпорта (и переносить метки дальше по событиям), вы сможете отсортировать события в единый, воспроизводимый порядок и избежать «прыгающих» временных отметок.

Практический вывод: тотальный порядок ≠ причинность

Чтобы получить тотальный порядок (когда любые два события сравнимы), часто добавляют тай‑брейкер: (метка, id_узла). Это удобно для репликации и логов, но важно помнить: тотальный порядок — лишь договорённость об очередности, а не точный учёт причинных связей.

Векторные часы: когда нужен точный учёт причинности

Заберите код с собой

Выгрузите исходники и продолжайте разработку в привычном репозитории и пайплайне.

Часы Лэмпорта дают полезный порядок событий, но они не отвечают на главный практический вопрос: связаны ли два события причинно или произошли параллельно. Если в системе важно различать эти два случая (а не просто выстроить «какую-то» очередь), появляются векторные часы.

Зачем понадобились векторные часы

Векторные часы придуманы, чтобы фиксировать причинность точнее: не только «это раньше/позже», а «это могло повлиять на то».

Идея проста: каждый узел ведёт «вектор» счётчиков — по одному на участника. Когда узел делает событие, он увеличивает свой счётчик. При обмене сообщениями узлы «сливают» векторы, беря по каждой позиции максимум, — как будто сверяют заметки о том, что уже известно системе.

Как читать векторные метки (без математики)

Два правила уровня интуиции:

- Если метка A «не больше» метки B по всем позициям и хотя бы по одной меньше, значит A happens-before B: B точно знало о последствиях A.

- Если в одном месте A больше, а в другом месте B больше, события параллельны: ни одно не доказывает знание о другом.

Когда хватает часов Лэмпорта, а когда — нет

Часы Лэмпорта достаточно хороши, когда нужен общий порядок для обработки (например, журналирование или упорядочивание сообщений), и ошибки от «ложной причинности» допустимы.

Векторные часы нужны, когда параллельность влияет на корректность: репликация, разрешение конфликтов, кэширование с конкурентными обновлениями, CRDT‑подобные схемы.

Пример: конфликты при параллельных обновлениях

Представьте профиль пользователя, реплицируемый на два узла. Узел A меняет email, узел B одновременно меняет номер телефона. Если система хранит только время Лэмпорта, один апдейт может «победить» и затереть другой, хотя изменения независимы.

С векторными часами видно, что обновления параллельны. Тогда система может:

- объединить изменения по полям (email взять из A, телефон из B);

- либо пометить конфликт и потребовать явного разрешения.

Так векторные часы превращают «случайную потерю данных» в управляемое правило.

Консенсус как ключевая проблема согласования

Консенсус — это задача «договориться» о едином решении в системе, где узлы могут падать, перезапускаться, а сеть — задерживать, терять и переупорядочивать сообщения. В распределённой среде нельзя полагаться на идею «все видят одно и то же одновременно»: у каждого участника своя картина мира, и именно это делает согласование нетривиальным.

О чём на самом деле спор

Формулировка простая: выбрать одно значение (например, «какой запрос считать принятым», «какую конфигурацию применить», «кто лидер») так, чтобы все корректные узлы в итоге пришли к одному и тому же результату — даже если по пути были сбои и задержки.

Safety и liveness на примере

В консенсусе обычно разделяют два типа требований:

- Safety (безопасность): «не сделать неправильно». Например, нельзя, чтобы два узла одновременно решили разные значения для одного и того же раунда.

- Liveness (живучесть): «когда-нибудь сделать правильно». Например, система должна в конечном итоге принять решение, а не зависнуть в вечных попытках.

Важно: можно легко получить safety без liveness (вечно ждать «идеальной уверенности») или liveness без safety (быстро принимать решения, но иногда разные). Смысл протоколов консенсуса — найти баланс.

Почему «просто выберем лидера» не всегда работает

Кажется логичным назначить лидера и доверить ему выбор. Проблема в том, что при сетевых разделениях или долгих задержках часть узлов может считать лидером одного, а часть — другого. Если нет строгих правил, что считать «легитимным» лидерством и как узлы подтверждают решения, система получает расхождение состояний.

Компромиссы, которые неизбежны

Плата за согласование выражается в практических вещах: дополнительные раунды сообщений (задержки), ограничения на доступность во время проблем со связью, усложнение реализации и эксплуатации. Хороший дизайн честно фиксирует эти компромиссы: что важнее для продукта — всегда отвечать или никогда не расходиться.

Paxos: как договариваться, когда сеть и узлы подводят

Paxos — это семейство идей о том, как группе машин выбрать одно значение (например, «какая запись следующая в журнале»), даже если часть узлов недоступна, а сообщения могут задерживаться или теряться. Важный момент: Paxos не «делает сеть надёжной», он учит систему принимать решения так, чтобы сбои не ломали уже достигнутые договорённости.

Роли и фазы: предложения и принятие

На высоком уровне есть три роли:

- Proposer (предлагающий): выдвигает кандидатуру значения.

- Acceptor (принимающий): голосует; именно их голоса определяют результат.

- Learner (узнающий): фиксирует, какое значение стало выбранным.

Две ключевые фазы:

-

Prepare/Promise: proposer объявляет номер предложения; acceptor обещает не принимать более «старые» предложения.

-

Accept/Accepted: proposer просит принять конкретное значение; acceptor подтверждает, если обещания не нарушены.

Что обеспечивает Paxos

Главная гарантия — safety: если значение уже выбрано, другое значение выбрать нельзя (при условии корректного кворума). Paxos может «тормозить» при проблемах связи или конкурирующих лидерах — это про liveness, и её обычно добиваются дополнительными механизмами (например, стабильным лидером).

Типичные заблуждения

- «Слишком сложно»: базовая идея проста, но детали важны из‑за редких гонок.

- «Работает как магия»: нет, всё держится на кворумах и правилах, которые запрещают противоречивые решения.

Где Paxos встречается в практике

В общих чертах Paxos‑подход живёт в системах с реплицированным журналом, выбором лидера, распределёнными блокировками и координацией конфигураций — часто в виде «упрощённых» или родственных протоколов (Multi‑Paxos и аналоги).

«Византийские генералы»: границы доверия и модели сбоев

Панель для причинности и трасс

Сделайте интерфейс наблюдаемости на React для трассировки причинных цепочек и статусов.

История про «византийских генералов» — это не сказка про древнюю армию, а постановка задачи: часть узлов в распределённой системе может вести себя произвольно. Не просто «упал и молчит», а отправляет разным участникам разные сообщения, путает порядок, повторяет старые данные, выдаёт мусор вместо корректного протокола.

Почему это важно даже без «злонамеренности»

Такое поведение возможно и без атак. Достаточно редких, но реальных причин: ошибки в реализации, повреждённая память, неправильная конфигурация, баг в сериализации, несовместимые версии протокола, сбой криптографии/проверок, некорректная маршрутизация. Снаружи это выглядит как «узел врёт», хотя он просто сломан необычным образом.

Crash-fault vs Byzantine-fault — в чём разница

Есть две разные модели сбоев, и под каждую нужна своя математика и протоколы:

- Crash-fault (fail-stop): узел либо работает корректно, либо перестаёт отвечать.

- Byzantine-fault: узел может отвечать, но делать это как угодно (включая противоречия).

Разница не косметическая: система, рассчитанная на crash-fault, может «логически развалиться» при одном византийском участнике — потому что доверяет сообщениям сильнее, чем следует.

Практический вывод

Не смешивайте модели сбоев в требованиях. Если вы пишете: «выдерживаем падения узлов», это crash-fault. Если добавляете: «и данные не должны портиться при странных ответах/подмене/рассинхроне версий», вы уже частично переходите к Byzantine‑модели — и должны явно определить, какие проверки, кворумы, подписи и допущения нужны.

Хороший вопрос для дизайн‑ревью: что именно считается «неисправностью», и какие гарантии должны сохраняться при таком поведении?

Корректность: safety и liveness простыми словами

Когда говорят, что распределённая система «корректна», обычно имеют в виду не «всё работает быстро», а то, что система ведёт себя предсказуемо даже при сбоях, задержках и повторах сообщений. У Лэмпорта это выражается через свойства и строгие формулировки.

Базовые термины

Состояние — снимок важных данных системы (например, значения в базе и кто лидер). Допустимые состояния — все состояния, которые мы считаем приемлемыми.

Инвариант — утверждение, которое должно быть истинным всегда. Например: «баланс счёта не становится отрицательным» или «в кластере не бывает двух лидеров одновременно».

Корректность — соответствие поведения системы заданным свойствам (в первую очередь safety и liveness).

Safety: «ничего плохого не случится»

Safety — это запреты. Нарушение safety видно сразу: произошла «катастрофа».

Примеры формулировок:

- «Запрос подтверждается клиенту только если запись действительно сохранена на кворуме».

- «Операция списания не может примениться дважды» (идемпотентность или защита от дублей).

- «Чтение не возвращает значение, которое никогда не было записано».

Liveness: «что-то хорошее когда-нибудь случится»

Liveness — это гарантии прогресса. Нарушение liveness может выглядеть как вечное ожидание.

Примеры:

- «Если сеть стабилизировалась, лидер будет выбран».

- «Запрос при доступном кворуме завершится за конечное время».

Как это переводится в требования и SLA

Safety обычно превращается в требования уровня продукта: «нет потерь подтверждённых данных», «нет двойных списаний», «строгая уникальность». Это часто важнее скорости.

Liveness ближе к SLA/SLO: задержки, время восстановления, максимальная длительность недоступности. Например: RTO (за сколько восстановимся) и SLO по латентности (сколько запросов укладывается в N мс) — это про «прогресс», а не про запреты.

Ключевой момент: можно временно пожертвовать liveness (система «подождёт»), чтобы не нарушить safety. Обратный обмен обычно слишком дорогой.

TLA+: как проверять идеи, а не только код

Кредиты за контент и рефералов

Расскажите о TakProsto или пригласите коллег и получите кредиты на разработку.

Когда проектируют распределённую систему, главные ошибки часто возникают ещё до первой строки программирования: разные участники по‑разному понимают порядок событий, сбои, таймауты и «что считается успехом». Спецификация до реализации снижает двусмысленность: вы фиксируете, какое поведение допустимо, а не то, как именно вы его напишете.

Что такое TLA+

TLA+ — язык и подход для описания поведения системы как набора состояний и переходов между ними. Важная часть — проверка свойств с помощью model checker’а (обычно TLC): вы перебираете возможные сценарии (включая неприятные — задержки, повторные сообщения, параллельные действия) и смотрите, нарушаются ли заявленные инварианты.

На практике это выглядит так: сначала задаёте абстрактную модель (например, «сообщение может дойти, потеряться или прийти дважды»), затем формулируете свойства вроде «не бывает двух лидеров одновременно» или «данные не теряются».

Что особенно хорошо описывать

TLA+ полезен там, где сложно удержать в голове все межпоточные и сетевые варианты:

- протоколы согласования и выбор лидера;

- очереди, репликация, дедупликация сообщений;

- блокировки, lease’ы, таймауты и retry.

Как внедрять без перегруза

Не обязательно «специфицировать всё». Часто достаточно описать критичные части: протокол, границы атомарности, условия сбоев и ключевые safety/liveness‑свойства. Это даёт быстрый эффект: обсуждение становится предметным, а ошибки логики всплывают до этапа интеграции.

Отдельная практическая мысль: когда вы быстро собираете прототип сервиса (API, очередь задач, репликацию состояния), полезно держать рядом короткую «табличку свойств» — что считаем инвариантами и какие сценарии сбоев допускаем. В TakProsto.AI это удобно делать в planning mode: сначала фиксируете требования (safety/liveness, модель сбоев, идемпотентность), а затем уже генерируете приложение и итеративно проверяете поведение. Плюс можно выгрузить исходники и доработать вручную, если прототип превращается в продукт.

Современная инфраструктура: где «время Лэмпорта» прячется в практике

Идеи Лэмпорта редко торчат наружу как «логические часы» в интерфейсе продукта. Обычно они спрятаны в повседневных механизмах: журналировании событий, очередях сообщений, репликации и в правилах, по которым система решает, что считать «раньше» и «позже».

Журналы, очереди и репликация — это про порядок

Когда вы пишете событие в append‑only log или публикуете сообщение в очередь, вы на самом деле фиксируете порядок наблюдения: «это произошло после того». В реплицируемых хранилищах и стриминговых платформах порядок часто гарантируется не глобально, а внутри ключа/партиции. Это практический компромисс между удобством и реальностью распределённой сети.

Если система доставляет сообщения «как получится», приложению приходится самому отвечать на вопросы: что делать с опоздавшими событиями, как склеивать состояния, какие операции можно безопасно повторять.

Вопросы, которые стоит задавать при дизайне

- Какой порядок доставки реально гарантирован: общий, по ключу или никакой?

- Возможна ли повторная доставка (at‑least‑once), и есть ли идемпотентность?

- Как устроена дедупликация: ключ операции, версия, уникальный идентификатор?

- Что будет при повторной обработке: двойное списание, лишнее письмо, конфликт состояния?

Причинность vs «часы на сервере»: типовая ошибка

Частая ловушка — смешивать причинный порядок с физическими таймстемпами в бизнес‑логике: «берём самое свежее по времени». Часы на разных узлах могут расходиться, а задержки сети делают «позже пришло» не равным «позже произошло».

Для наблюдаемости полезнее мыслить причинностью: распределённая трассировка и корреляционные идентификаторы связывают события в цепочку «что породило что», даже если реальные времена не совпали. Это и есть практическая версия happens-before, только в инструментах эксплуатации.

Практический чек-лист: что нельзя игнорировать в распределённом дизайне

Распределённая система ломается не там, где «медленно», а там, где вы не договорились о времени, порядке и допустимых сбоях. Ниже — компактный чек‑лист, который помогает не перепутать требования с реализацией.

1) Определите модель сбоев и требования к порядку

- Какие сбои считаем нормой: падение узла, перезапуск, сетевые задержки «вплоть до бесконечности», разбиение сети, дубликаты сообщений.

- Где важен порядок: достаточно ли «примерного времени» (физические часы), или нужна причинность (happens‑before).

- Какие свойства требуются:

- Safety — «ничего плохого не случится» (например, не спишем деньги дважды).

- Liveness — «что-то хорошее когда-нибудь случится» (операция не зависнет навсегда).

2) Выберите инструмент под свой риск и цену

- Логические метки (часы Лэмпорта/векторные часы) — чтобы упорядочивать события и разруливать конкуренцию без «магии» физического времени.

- Консенсус (например, Paxos/его потомки) — когда нужен один источник истины: лидерство, конфигурация, уникальные номера, порядок команд.

- Транзакции — когда важна атомарность в пределах одной системы хранения.

- Саги — когда транзакцию «на весь мир» не потянуть: проектируйте компенсации заранее.

3) Мини-набор проверок (до продакшена)

Прогоните сценарии: задержки, потери, дубликаты, переупорядочение сообщений, частичные отказы узлов. Отдельно проверьте идемпотентность обработчиков и повторяемость операций.

Если вам нужно быстро проверить архитектурную гипотезу на живом прототипе (например, сервис на Go + PostgreSQL, очередь, обработчики с retry и дедупликацией), удобно собрать черновик в TakProsto.AI: платформа позволяет сделать веб‑или серверное приложение через чат, с деплоем и откатом снапшотами, а затем при необходимости — экспортировать исходники и продолжить разработку в привычном пайплайне.

4) Куда углубляться дальше

Если хочется «страховки от сюрпризов», изучите спецификации и проверку моделей: /blog/tla-plus-intro. Из первоисточников полезны статьи Лэмпорта про happens-before, логическое время и консенсус.