11 окт. 2025 г.·8 мин

Nginx vs Caddy: сравнение для продакшн‑веб‑серверов

Подробно сравниваем Nginx и Caddy: настройка, TLS, производительность, прокси, модули, наблюдаемость, контейнеры и как выбрать под задачу.

Что сравниваем и как будем выбирать

Эта статья — про практичный выбор веб‑сервера для продакшена, а не про «кто быстрее на синтетике». Сравним Nginx и Caddy как инструменты, которые чаще всего стоят на входе в проект: принимают HTTP(S), раздают статику, проксируют запросы к приложению и помогают держать инфраструктуру в порядке.

Кому и зачем это сравнение

Материал пригодится, если у вас один из типовых сценариев:

- Сайт или лендинг: статика, кеширование, сжатие, понятная конфигурация.

- API/бэкенд: reverse proxy, ограничения по времени/размеру запросов, безопасные заголовки.

- Прокси перед несколькими сервисами: маршрутизация по доменам/путям, базовая балансировка.

- Edge‑узел: терминация TLS, HTTP/2 и (где уместно) HTTP/3, защита и наблюдаемость.

Короткое резюме различий

Если упростить, Nginx обычно выбирают за максимальный контроль и распространённость в индустрии, а Caddy — за скорость старта и «работает из коробки», особенно когда хочется автоматический TLS и читаемую конфигурацию в формате Caddyfile.

Что будет считаться «лучше»

Оцениваем не абстрактную «мощь», а то, что реально влияет на проект:

- Время на настройку и изменения (сколько шагов до рабочего конфига)

- Уровень контроля (насколько тонко можно управлять поведением)

- Поддержка и сопровождение (насколько удобно поддерживать конфиги командой)

- Предсказуемость в продакшене (как ведёт себя при обновлениях и росте нагрузки)

Какие версии и окружение держим в голове

Ориентируемся на актуальные стабильные сборки Nginx и Caddy, с прицелом на Linux как основную платформу. Отдельно учитываем запуск в Docker и типичные деплои в облаке, где важны автоматизация, повторяемость и минимум ручных операций.

Nginx и Caddy в двух словах: главные отличия

Nginx: сильные стороны и привычные кейсы

Nginx — зрелый «рабочий стандарт» для reverse proxy, раздачи статики и высоконагруженных HTTP‑сервисов. Его часто выбирают, когда нужны предсказуемость, тонкая настройка поведения, совместимость с огромным числом гайдов/шаблонов и уже привычный стек в компании.

Caddy: ключевая идея и подход к конфигу

Caddy делает ставку на «безопасно по умолчанию» и простую конфигурацию. Главная фишка — автоматический HTTPS (получение/продление сертификатов) и лаконичный Caddyfile, который читается как набор правил. Это особенно удобно для небольших команд и проектов, где важна скорость внедрения и минимум ручных действий.

Сравнение по пунктам

| Пункт | Nginx | Caddy |

|---|---|---|

| Конфигурация | Гибкая, но многословная; много директив и контекста | Короче и «человечнее» в Caddyfile; есть JSON для автоматизации |

| TLS/HTTPS | Обычно настраивается явно: сертификаты, редиректы, параметры | Часто включается автоматически и поддерживается без рутины |

| Расширения | Большая экосистема, но модули зависят от сборки/пакетов | Плагины подключаются через сборку (xcaddy); меньше «исторического багажа» |

| Логирование | Зрелые форматы, тонкая настройка, много примеров | Удобная настройка, структурированные логи проще внедрять |

| Reverse proxy | Классика: проксирование, буферы, таймауты — всё детально | Отличный прокси «из коробки», часто меньше конфигурации для типовых задач |

Кому обычно подходит каждый вариант

Nginx чаще выбирают команды, где:

- уже есть опыт и готовые конфиги;

- важны тонкие оптимизации и контроль каждого параметра;

- много легаси‑сервисов и нестандартных сценариев.

Caddy обычно выигрывает, если:

- проект небольшой/средний и хочется быстрее выйти в продакшн;

- вы не хотите вручную сопровождать сертификаты;

- важна простота поддержки конфигов без «магии», которую знает только один человек.

Установка и базовая конфигурация: порог входа

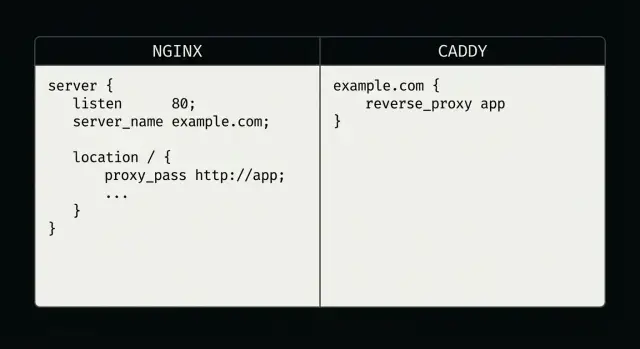

Разница между Nginx и Caddy чувствуется уже на старте: оба ставятся быстро, но «первый рабочий конфиг» обычно быстрее получается у Caddy. Причина проста — Caddyfile ближе к человеческому языку, а Nginx требует понимать контексты директив и структуру блоков.

Как выглядит базовая конфигурация: nginx.conf vs Caddyfile

Минимальный Nginx для раздачи статики (фрагмент сайта):

server {

listen 80;

server_name example.com;

root /var/www/site;

index index.html;

location / {

try_files $uri $uri/ =404;

}

}

Похожее в Caddyfile обычно короче:

example.com {

root * /var/www/site

file_server

}

На практике ощущение такое: у Nginx больше «строительных блоков», у Caddy — больше «готовых команд». Это не про «лучше/хуже», а про стиль и скорость старта.

Порог входа: синтаксис, читаемость, типовые ошибки новичков

У Nginx типовые ошибки — пропущенная точка с запятой, неправильная вложенность блоков (например, location не там), и путаница с тем, где какая директива разрешена. Ещё часто ошибаются с root vs alias.

В Caddy чаще спотыкаются о порядок матчеров и обработчиков (что применится раньше), а также о неявные поведения «по умолчанию». Конфиг читается легче, но важно помнить: запись короче не всегда означает меньше нюансов внутри.

Горячая перезагрузка и проверка конфигов перед применением

В Nginx стандартный цикл: проверить, затем перезагрузить без простоя.

nginx -t

nginx -s reload

У Caddy похожая логика: валидировать конфигурацию и применять изменения.

caddy validate --config /etc/caddy/Caddyfile

caddy reload --config /etc/caddy/Caddyfile

Практический совет: закрепите эти команды в деплой‑скрипте/CI, чтобы не выкатывать «битый» конфиг на прод.

Структура проекта: где хранить файлы, как делить на окружения

Для Nginx удобно держать базовые настройки в /etc/nginx/nginx.conf, а сайты раскладывать по include‑файлам (например, «один файл — один сайт») и отдельно иметь конфиги для dev/stage/prod.

Для Caddy часто достаточно одного /etc/caddy/Caddyfile, но при росте проекта тоже лучше дробить конфиг на части (через импорт) и явно разделять окружения: разные домены, разные upstream’ы, разные политики логирования.

HTTPS и TLS: автоматизация против ручного контроля

HTTPS — это не только «замочек», но и регулярная операционная рутина: выпуск сертификатов, продление, протоколы, шифры, заголовки. Здесь Caddy и Nginx расходятся сильнее всего.

Caddy: TLS «из коробки»

Caddy по умолчанию старается включить HTTPS и сам получает сертификаты через ACME (обычно Let’s Encrypt), автоматически продлевает их и добавляет редирект с HTTP на HTTPS.

На практике это означает меньше ручных шагов и меньше шансов забыть про продление. Для типового reverse proxy достаточно указать домен и апстрим в Caddyfile — TLS «подхватится» сам.

Nginx: больше контроля, но больше ручной работы

В Nginx TLS нужно собирать из нескольких частей: указать пути к сертификату и ключу, настроить редиректы, протоколы/шифры, иногда OCSP stapling и HSTS. Это даёт тонкий контроль, но и вероятность ошибок выше.

Частые промахи:

- забыли HTTP→HTTPS редирект или сделали его циклическим;

- положили неверную цепочку сертификатов (intermediate), из‑за чего часть клиентов ругается;

- оставили слабые протоколы или «наследованные» наборы шифров;

- не учли, что сертификат нужно обновлять и перезагружать конфигурацию.

HTTP/2 и HTTP/3: когда включать

HTTP/2 почти всегда имеет смысл: быстрее загружаются страницы с множеством ресурсов, меньше накладных расходов. В Caddy он включается автоматически при HTTPS. В Nginx обычно достаточно включить http2 на TLS‑листенере.

HTTP/3 (QUIC) полезен на мобильных сетях и при потерях пакетов, но требует поддержки со стороны клиентов и инфраструктуры. В Caddy поддержка чаще включается проще, а в Nginx — зависит от сборки/версии и окружения.

Локальная разработка и staging

Чтобы не «ломать» сертификаты и домены:

- используйте отдельные поддомены для staging;

- для тестов выбирайте ACME staging‑endpoint (иначе можно упереться в лимиты);

- локально удобнее внутренняя CA/самоподписанные сертификаты или режим без авто‑HTTPS, чтобы не тратить время на пляски с DNS.

Reverse proxy и балансировка нагрузки

Reverse proxy — это режим, когда веб‑сервер принимает запросы от пользователей и пересылает их во внутренние сервисы (приложение, API, несколько инстансов). Здесь Nginx и Caddy решают одну задачу, но с разной «философией» конфигурации.

Маршрутизация и переписывание

Обе системы умеют маршрутизировать по хостам и путям: например, api.example.com → сервис API, а /static/ → отдельный контейнер или CDN‑прокси. В Nginx это обычно делается через server/location и директивы вроде proxy_pass, в Caddy — через матчи и хендлеры в Caddyfile.

Переписывание URI (когда внешний путь отличается от внутреннего) реализуемо в обоих вариантах, но отличается синтаксисом. Важно заранее договориться о правилах со стороны приложения: где ожидаются завершающие слэши, как передаются Host и X-Forwarded-*, и нужен ли «обрезанный» префикс пути.

Балансировка: алгоритмы и проверки

Для нескольких бэкендов Nginx традиционно силён и предсказуем: есть разные стратегии распределения и много опций вокруг отказоустойчивости. Caddy тоже умеет балансировать и хорошо подходит для типового «несколько одинаковых инстансов».

На практике различия чаще всплывают в деталях:

- Health checks и failover: важно, как проверяется живость (по TCP/HTTP), какие коды считаются успешными, как быстро узел исключается и возвращается.

- Алгоритмы: round‑robin vs учёт «наименее загруженного» — выбирайте исходя из профиля нагрузки и того, одинаковы ли инстансы.

WebSocket, gRPC, таймауты и буферы

Если у вас WebSocket или долгие запросы, критичны таймауты, размер буферов и корректная передача заголовков. Для gRPC важно правильное проксирование HTTP/2 и ограничения по размерам сообщений.

Здесь Nginx часто требует более явной настройки, зато даёт тонкий контроль; в Caddy многие сценарии «заводятся» быстрее, но при нестандартных требованиях придётся внимательнее читать документацию.

Rate limiting и базовая защита

Ограничение частоты запросов на уровне прокси помогает против простых всплесков трафика и грубого брутфорса. В Nginx это обычно настраивается стандартными механизмами лимитов; в Caddy — через соответствующие возможности/расширения. Заранее проверьте, что нужная политика (по IP, по пути, с «бурстом») поддерживается именно в вашей сборке.

Статика, кеш и компрессия

Экспорт исходного кода проекта

Экспортируйте исходный код и продолжайте развивать проект в привычном репозитории.

Статические файлы — это то, что пользователи видят чаще всего: HTML, JS, CSS, шрифты, картинки. Здесь важны два параметра: скорость отдачи и то, насколько просто добиться «правильных» заголовков кеша.

Раздача статики: скорость и настройка

Nginx исторически силён в статике: sendfile, тонкая настройка буферов, удобные правила по типам файлов. Но конфигурация быстро обрастает деталями.

Caddy проще «из коробки»: достаточно включить file_server, и вы уже получаете корректную раздачу директорий, MIME‑типы и понятные ошибки. Для типового сайта порог входа заметно ниже.

Кеширование, Cache-Control/ETag и компрессия

Обычно делают так: долгий кеш для версионированных ассетов (app.3f2c1.js), короткий или без кеша — для index.html.

В Nginx это выглядит привычно через add_header/expires и опционально etag on;. Компрессия — gzip on;, а brotli часто требует отдельного модуля.

В Caddy заголовки удобно задаются директивой header, ETag можно включить в file_server, а компрессия включается одной строкой (encode). Важно: Caddy поддерживает gzip и zstd стандартно; brotli зависит от сборки/плагинов.

SPA: fallback на index.html и типичные ловушки

SPA обычно требует fallback:

- Nginx:

try_files $uri $uri/ /index.html; - Caddy:

try_files {path} /index.html

Ловушка — случайно «завернуть» API‑роуты в index.html. Решение: явно отделяйте /api/* (или другой префикс) от SPA‑правил.

Большие файлы и лимиты

Для загрузок и крупных запросов почти всегда нужно поднять лимиты:

- Nginx:

client_max_body_size, аккуратно с буферизацией и таймаутами - Caddy:

request_body { max_size ... }

Даже при отличной статике неверный лимит на upload превращает «всё работает» в редкие и труднообъяснимые ошибки у пользователей.

Динамические приложения: FastCGI и проксирование

Динамика — место, где различия особенно заметны: Nginx исторически силён в «классической» схеме с PHP‑FPM и тонкой настройкой FastCGI, а Caddy чаще выбирают как удобный reverse proxy для приложений (Node/Go/Java) с минимумом конфигурации.

PHP‑FPM и FastCGI: что важно и где спотыкаются

В Nginx связка с PHP‑FPM обычно выглядит предсказуемо: вы явно задаёте параметры FastCGI и контролируете поведение при ошибках.

location ~ \\.php$ {

include fastcgi_params;

fastcgi_param SCRIPT_FILENAME $document_root$fastcgi_script_name;

fastcgi_pass unix:/run/php/php-fpm.sock;

fastcgi_read_timeout 60s;

}

Частые проблемы: неправильный SCRIPT_FILENAME (404/502), несоответствие сокета/порта PHP‑FPM, слишком маленькие таймауты при тяжёлых запросах и «внезапные» 502 из‑за переполнения пула.

В Caddy FastCGI тоже возможен (через php_fastcgi), но философия другая: меньше ручных параметров, проще старт. При нетипичных сценариях (нестандартные переменные, сложные правила) гибкости Nginx может не хватить.

Проксирование к приложению: заголовки и real IP

Для Node/Go/Java обычно важнее корректные X-Forwarded-* и реальный IP клиента. В Caddy это часто работает «из коробки» через reverse_proxy, а в Nginx — вы явно прописываете заголовки:

location / {

proxy_set_header Host $host;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

proxy_pass http://app:3000;

}

Если у вас есть промежуточные балансировщики/Ingress, заранее определите доверенные прокси (иначе реальный IP будет «потерян» или подменяем).

Пулы, таймауты, лимиты: что держать под контролем

При росте нагрузки следите за размером пулов (PHP‑FPM workers/соединения к upstream), read/connect‑таймаутами, лимитами на тело запроса и параллелизм.

В Nginx это часто настраивается точечно на локациях; в Caddy — проще начать, но всё равно придётся осознанно выставлять таймауты и лимиты, чтобы не «повесить» воркеры долгими запросами.

Когда нужен API‑gateway, а не только веб‑сервер

Если появляется сложная маршрутизация (версии API, канареечные релизы), централизованная аутентификация, rate limiting по клиентам/ключам, трансформация запросов/ответов или много сервисов с разными политиками — одного Nginx/Caddy в роли веб‑сервера может быть мало.

Тогда логичнее выделить API‑gateway, а веб‑сервер оставить для TLS/статики/простого проксирования.

Наблюдаемость: логи, метрики, отладка

В продакшене веб‑сервер — это не только «отдаёт трафик», но и источник сигналов: что сломалось, где тормозит, кто и как атакует. У Nginx и Caddy подходы к наблюдаемости заметно отличаются.

Доступные метрики и статусы: что можно получить штатно

Nginx из коробки даёт базовую картину через stub_status (активные соединения, чтение/запись, принятые/обработанные запросы). Для полноценной наблюдаемости (коды ответов, апстримы, латентность, ошибки по бэкендам) обычно ставят экспортер в Prometheus и/или сторонние модули.

Caddy больше ориентирован на включаемую телеметрию: есть административный API и удобные JSON‑логи, а метрики чаще подключают через плагины (например, Prometheus‑экспортер). Учитывайте: «из коробки» метрик может быть меньше, чем ожидают после Nginx с привычным набором экспортеров.

Логи доступа и ошибок: форматы, структурированные логи, ротация

Nginx силён в контроле форматов: log_format позволяет собрать нужные поля (включая времена апстрима, коды, размеры, user‑agent) и писать в отдельные файлы. Ротацию почти всегда делают системно через logrotate.

Caddy удобен тем, что структурированные логи (JSON) — нормальный путь, а не «хак»: проще отправлять события в Loki/ELK и фильтровать по полям. Ротация и размер логов обычно настраиваются прямо в конфиге.

Трассировка запросов и корреляция (request id) на практике

Минимальный must‑have — единый request_id, прокинутый до приложения.

- В Nginx это обычно

$request_id+add_headerиproxy_set_header X-Request-ID .... - В Caddy можно добавлять/пробрасывать заголовок через

headerи использовать встроенный идентификатор запроса.

Для распределённой трассировки (OpenTelemetry) в обоих случаях часто прибегают к модулям/плагинам или выносят трассировку в ingress/sidecar.

Интеграции с мониторингом: что обычно настраивают в продакшене

Типичный набор одинаковый: Prometheus + Grafana для метрик, Loki/ELK для логов, алерты по 5xx, росту латентности и проблемам апстримов. Разница в том, что в Nginx интеграции чаще «собираются» из стандартных кирпичиков (экспортеры, logrotate, формат логов), а в Caddy — из встроенных возможностей + точечных плагинов под вашу систему наблюдения.

Безопасность и типовые практики hardening

Приложение на React и Go

Опишите продукт в чате, и TakProsto соберет фронт React и бэкенд Go с PostgreSQL.

Безопасность веб‑сервера — это не только «включить TLS». В продакшене важно уменьшить привилегии процесса, выставить корректные заголовки и понимать границы ответственности Nginx/Caddy.

Изоляция и права: минимум привилегий

Оба сервера должны работать от непривилегированного пользователя. Типовая практика: отдельный системный пользователь без shell, изолированные директории, ограниченные права на конфиги и логи.

Для портов 80/443 есть два подхода: временно стартовать с повышенными правами и затем сбросить привилегии, либо выдать бинарнику capability (например, cap_net_bind_service). У Nginx это часто решается через systemd unit и директиву user, у Caddy — через capability/пакетные настройки, чтобы не держать процесс «вечным root».

Заголовки безопасности: где задавать

В Nginx заголовки обычно добавляют через add_header (важно учитывать наследование и флаг always). В Caddy — через директиву header в Caddyfile.

Минимальный набор:

- HSTS — только после уверенности, что HTTPS включён везде (иначе можно «заблокировать» доступ)

- CSP — вводить постепенно, начиная с отчётов

- X-Frame-Options/

frame-ancestors(в CSP) — защита от clickjacking

WAF и защита от ботов: что внутри, а что снаружи

Nginx и Caddy умеют базовые вещи: лимиты запросов, ограничения по IP, простые правила. Полноценный WAF и антибот чаще выносят наружу: CDN/WAF, отдельный reverse‑proxy, специализированные сервисы.

В мире Nginx популярны связки с ModSecurity (где это оправдано), а для блокировок по логам — fail2ban.

Обновления и зависимости/модули

С Nginx проще жить на репозиториях дистрибутива/официальных пакетах и явно контролировать версии модулей (особенно динамических).

У Caddy важно следить за тем, как собран бинарник: плагины через xcaddy повышают риск supply‑chain, поэтому фиксируйте версии, храните рецепт сборки и обновляйтесь регулярно из проверяемых источников.

Расширяемость и экосистема модулей

Расширяемость — это про то, насколько легко добавить нестандартную функциональность: новый способ аутентификации, дополнительные заголовки, специфичную маршрутизацию или интеграцию с внешними системами.

Nginx: зрелая экосистема, но есть нюансы со сборкой

У Nginx огромная база готовых модулей и практик. В open‑source версии часть возможностей подключается как динамические модули (loadable modules), но на практике часто упираются в то, что модуль должен быть собран под конкретную версию Nginx и с совместимыми флагами сборки.

Что важно учитывать:

- Пакеты дистрибутива: проще всего, но набор модулей ограничен тем, что собрал репозиторий.

- Собственная сборка: максимум гибкости, но появляется «зоопарк» версий и ответственность за обновления.

- Коммерческие возможности (например, в Nginx Plus) закрывают часть задач без сторонних модулей, но это уже другая модель владения.

Caddy: плагины и удобное подключение, но следите за совместимостью

У Caddy расширения обычно ставят через сборку кастомного бинарника (часто используют xcaddy). Это удобно: вы получаете один исполняемый файл «под задачу». Но есть риски:

- плагин может отставать от свежих релизов Caddy;

- при обновлении можно столкнуться с ломающими изменениями в API;

- важна проверка происхождения и поддержки плагина (активность репозитория, релизы, issues).

Гибкость маршрутизации и «тонкий контроль»

Если нужен предельно детальный контроль поведения на уровне директив и фаз обработки запроса, Nginx часто ощущается более «низкоуровневым» и предсказуемым.

Caddy выигрывает, когда важнее быстро описать правила и поддерживать их без сложного шаблонирования.

Совместимость конфигураций между командами и окружениями

Nginx — де‑факто стандарт, поэтому новый инженер почти всегда «прочитает» конфиг. Caddyfile обычно короче и проще, а для строгой воспроизводимости есть JSON‑конфигурация.

В обоих случаях команде важно договориться о стиле и правилах, чтобы разные окружения (dev/stage/prod) не разъехались из‑за локальных привычек.

Контейнеры и Kubernetes: деплой без сюрпризов

Прокси конфиг под ваш домен

Опишите статику и /api, TakProsto сгенерирует Caddyfile или nginx конфиг.

Контейнеризация у Nginx и Caddy выглядит похоже (конфиг + тома + порты), но различается «по умолчанию»: Nginx чаще требует явной сборки конфигурации и дополнительных утилит, а Caddy обычно быстрее стартует с минимальным Caddyfile и уже включает автоматический TLS (если это уместно в вашем окружении).

Docker: минимальные образы, конфиги, тома, healthcheck

Для обоих серверов практичный базовый подход — монтировать конфиг read‑only и отделять данные от образа.

У Caddy важно помнить про каталог данных (хранилище сертификатов и состояния), иначе при пересоздании контейнера он будет «заново» получать сертификаты.

services:

web:

image: caddy:2

ports:

- "80:80"

- "443:443"

volumes:

- ./Caddyfile:/etc/caddy/Caddyfile:ro

- caddy_data:/data

- caddy_config:/config

healthcheck:

test: ["CMD", "wget", "-qO-", "http://localhost/healthz"]

interval: 10s

timeout: 2s

retries: 5

volumes:

caddy_data:

caddy_config:

У Nginx вместо /data чаще появляются тома под /etc/nginx/conf.d и (если нужно) под кеш/временные файлы. Healthcheck удобно делать через отдельный location (/healthz) без логирования.

Kubernetes/Ingress: где чаще встречается Nginx, где удобен Caddy

В Kubernetes Nginx максимально распространён как Ingress Controller: много готовых манифестов, примеров и «предсказуемых» интеграций.

Caddy чаще используют как sidecar/edge‑proxy в приложении или как самостоятельный Deployment/Service, когда важна простота конфигурации и быстрые правки без огромного набора аннотаций.

Секреты и сертификаты

Если TLS завершается на Ingress (cert-manager), то и Nginx, и Caddy просто читают сертификат из Kubernetes Secret, а автоматический TLS Caddy обычно отключают, чтобы не конфликтовать с централизованной выдачей.

В Docker чаще выбирают один из трёх вариантов: переменные окружения (для мелких настроек), тома (для конфигов и ключей) или внешнее secret‑хранилище (Vault/SSM). Главное правило — не запекать ключи в образ.

Blue/green и canary

В раскатках веб‑сервер участвует как «точка переключения»: либо через балансировку на разные upstream’ы, либо через маршрутизацию по заголовкам/кукам.

В Kubernetes это чаще решают на уровне Service/Ingress (веса, отдельные Ingress для canary), а Nginx/Caddy оставляют простыми прокси — так меньше сюрпризов при откате.

Где помогает TakProsto.AI (не только «написать конфиг»)

Если вы часто поднимаете окружения, правите правила роутинга и хотите быстрее проходить путь «идея → прод», часть рутины можно вынести в TakProsto.AI. Это vibe‑coding платформа для российского рынка: вы описываете задачу в чате, а система собирает проект и инфраструктурные заготовки под него (React на фронте, Go + PostgreSQL на бэкенде, Flutter для мобильных).

Практичные сценарии именно для темы Nginx/Caddy:

- сгенерировать стартовый Caddyfile/nginx‑конфиг под ваш домен, статику, SPA‑fallback и

/api/*reverse proxy; - подготовить docker‑compose или черновик манифестов (Deployment/Service) вместе с healthcheck’ами;

- в «planning mode» зафиксировать требования (таймауты, лимиты, заголовки, кеш‑политики), а затем быстро итеративно обновлять конфиг;

- использовать snapshots/rollback как дисциплину для безопасных правок (полезно, когда «поменяли одну строку — сломали редиректы»).

Плюс для проектов с требованиями по локализации и данным: TakProsto.AI работает на серверах в России и использует локализованные/opensource‑модели, не отправляя данные за пределы страны.

Миграция между Nginx и Caddy: план и риски

Миграция чаще всего сводится к тому, чтобы аккуратно перенести «контракты» вашего сервиса: домены, редиректы, заголовки, кеширование и маршрутизацию на апстримы. Риск почти всегда не в «поднять сервер», а в несовпадениях поведения, которые всплывают уже в продакшене.

Что переносится легко, а где будет переписывание

Проще всего переносятся: раздача статики, базовый reverse proxy, gzip/brotli (если использовали стандартно), простые редиректы (HTTP→HTTPS, смена www).

Чаще требуют переписывания: сложные location‑правила с регулярками, «цепочки» rewrite с флагами, тонкая настройка кеша (ключи, исключения, bypass), нестандартные заголовки/условия по if, и всё, что завязано на порядок обработки директив Nginx.

Пошаговый план и чек‑лист тестов

-

Зафиксируйте текущее поведение: снимите конфиги Nginx, список доменов, upstream’ов, портов, сертификатов, задач ACME/cron.

-

Поднимите параллельный стенд: Caddy на отдельном порту/хосте, подключите тестовый домен или временно прокиньте трафик через балансировщик.

-

Перенесите правила и включите логи.

-

Прогоните чек‑лист:

- TLS: версии протоколов, цепочка, HSTS (если был), ALPN/HTTP2.

- Редиректы: 301/302, сохранение пути и query, каноникализация slash.

- Кеш:

Cache-Control,ETag/Last-Modified,Vary, корректность bypass для авторизации.

Как сравнить поведение

Делайте одинаковые запросы к обоим серверам и сравнивайте коды/заголовки:

curl -sS -D- -o /dev/null https://example.com/path?x=1

curl -sS -D- -o /dev/null https://caddy-test.example.com/path?x=1

Отдельно проверьте «пограничные» URL: несуществующие страницы, большие файлы, методы POST/PUT (если есть), CORS, range‑запросы.

Откат и минимизация простоя

Держите быстрый откат: возможность вернуть запись балансировщика/Ingress на Nginx, сохранённые предыдущие конфиги и автоматизированный деплой.

Идеально — переключение трафика через health‑checks и постепенный rollout (например, 5% → 50% → 100%), чтобы проблемы проявились до полного перевода.

Итог: как выбрать сервер под ваш проект

Выбор между Nginx и Caddy чаще упирается не в «кто быстрее», а в то, что важнее вашей команде: предсказуемый ручной контроль или скорость внедрения с минимумом рутины.

Когда выбирать Nginx

Nginx стоит брать, если вам нужен максимум контроля и гибкости: сложные правила маршрутизации, тонкая работа с кешем, нетривиальные лимиты, специфические модули (в том числе сторонние) и уже отлаженные практики в компании.

Это также хороший вариант, когда инфраструктура давно стандартизирована под Nginx (шаблоны конфигов, мониторинг, SRE‑процессы), а стоимость изменений выше потенциальной выгоды от упрощения.

Когда выбирать Caddy

Caddy логичен, если важны быстрый старт и автоматический HTTPS «из коробки»: меньше конфигурации, проще поддержка, понятнее входной порог для команды без глубокого опыта веб‑серверов.

Часто он выигрывает там, где нужно быстро поднимать и часто менять окружения (небольшие проекты, пилоты, отдельные сервисы), а приоритет — скорость поставки и снижение числа ручных настроек.

Рекомендации по типам проектов

- Лендинг/маркетинг‑сайт: обычно Caddy — проще и быстрее получить HTTPS и базовую отдачу статики.

- SaaS: оба подойдут; выбирайте Nginx при сложной периферийной логике и зрелых процессах, Caddy — если хотите минимизировать рутину и упростить конфиги.

- API: Nginx часто удобнее для тонкой настройки лимитов/защиты и нестандартных правил; Caddy хорош для простых прокси‑схем.

- Внутренние сервисы: Caddy удобен для быстрого развёртывания и поддержки; Nginx — когда есть жёсткие требования к политикам и унификации.

Короткий чек‑лист выбора

- Опыт команды: кто будет дежурить и чинить ночью — и с чем ему комфортнее?

- Время на запуск: нужно «сегодня» или можно инвестировать в детальную настройку?

- Требования: нужны ли специфические модули/правила и строгая управляемость TLS?

- Операции: как у вас устроены релизы, секреты, наблюдаемость и стандарты конфигов?

Если сомневаетесь, практичный путь — начать с Caddy для простого сервиса и закрепить решение, а Nginx выбирать там, где упираетесь в тонкие требования или экосистему.

P.S. Если вы делаете технический контент и делитесь практиками вокруг инфраструктуры (в том числе про Nginx/Caddy), у TakProsto.AI есть программа earn credits: можно получать кредиты за публикации или за рекомендации через реферальную ссылку — удобно, если вы и так пишете разборы и чек‑листы для команды.