13 окт. 2025 г.·8 мин

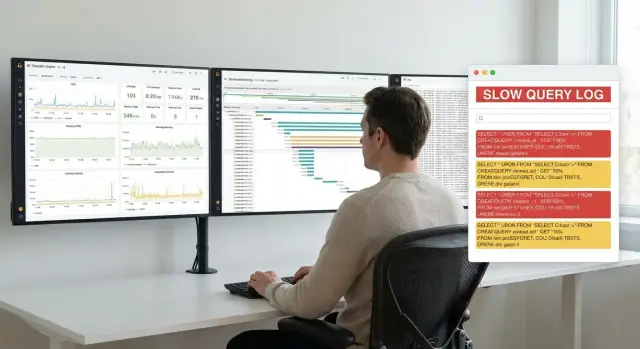

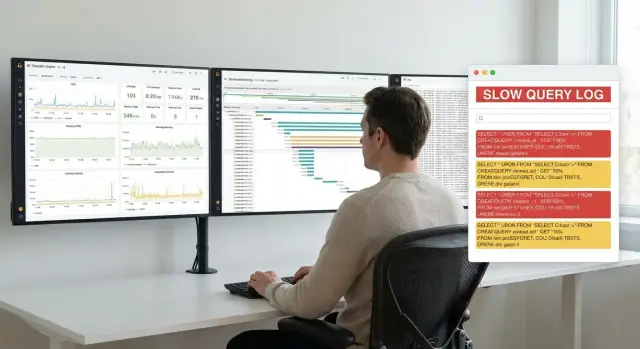

Как observability и slow query logs спасают продакшен

Разбираем, как observability и slow query logs помогают находить и предотвращать сбои в продакшене: от симптомов до причин, приоритизации и исправлений.

Разбираем, как observability и slow query logs помогают находить и предотвращать сбои в продакшене: от симптомов до причин, приоритизации и исправлений.

Продакшен ломается редко «в одном месте». Чаще это цепочка: чуть выросла задержка — пользователи стали чаще нажимать «повторить» — очереди раздулись — сервис начал таймаутиться — поддержка получила шквал обращений. В такие моменты мало знать, что «CPU высокий» или «ошибок стало больше». Нужны ответы на вопрос «почему так произошло именно сейчас» — и здесь наблюдаемость (observability) отличается от привычного мониторинга.

Мониторинг обычно показывает состояние: графики, алерты, «красные лампочки». Observability помогает объяснять причины: что изменилось в поведении системы, какие компоненты стали узким местом, какой пользовательский сценарий деградировал.

Практически это означает, что вы можете связать симптомы (рост латентности) с конкретными событиями (релиз, изменение трафика, новая функциональность), запросами и зависимостями — и быстрее перейти от догадок к проверяемым гипотезам.

База данных часто обслуживает сразу много сервисов. Один «тяжёлый» запрос способен занять пул соединений, заблокировать важные операции или просто съесть время на диске/CPU — и дальше страдают все:

Именно поэтому slow query log — не «дополнительная диагностика», а системный инструмент. Он фиксирует конкретные запросы, которые превысили порог по времени или по затратам ресурсов, и даёт точку опоры для расследования.

Наблюдаемость и slow query log уменьшают время восстановления и число «слепых» правок:

Итог: меньше простоев, меньше паники и больше предсказуемости в продакшене.

Observability держится на трёх опорах — метриках, логах и трассировках. По отдельности они полезны, но настоящая сила появляется, когда вы связываете их общим контекстом: request_id/trace_id, пользователь/tenant, версия релиза, регион.

Метрики отвечают на вопрос «что и насколько плохо». Минимальный набор:

Метрики быстро показывают, где «горит»: сервис, база, кэш, внешний провайдер.

Логи отвечают на вопрос «что именно произошло». Делайте их структурированными (JSON) и договоритесь об уровнях (debug/info/warn/error). Важно:

request_id/trace_id для корреляции;Распределённая трассировка показывает «путешествие» одного запроса между сервисами и где именно он тормозит — по спанам. Это помогает отличить медленную БД от, например, внешнего API или перегруженной очереди.

Если метрики говорят «CPU 90%», а трассировки — «время внутри сервиса», подключайте профилирование: оно отвечает, на каких функциях реально тратится время/процессор.

Рабочая последовательность такая: метрики находят аномалию → трассировка локализует узкое место в цепочке → логи дают детали (параметры, версии, ошибки) → при необходимости профилирование подтверждает, где уходит CPU/время.

Slow query log — это журнал запросов, которые выполнялись дольше заданного порога. Его ценность в том, что вы получаете не «в целом база тормозит», а конкретные примеры запросов, на которых теряется время.

На уровне СУБД (PostgreSQL, MySQL и т. п.) лог обычно самый «истинный»: фиксируется реальное время выполнения и контекст сессии. Минус — нужно аккуратно настроить объём.

На уровне прокси (между приложением и базой) удобно собирать единый формат логов и связывать их с клиентскими метаданными (маршрут, сервис). Но прокси видит запрос «снаружи» и иногда хуже отделяет сетевые задержки от серверных.

На уровне ORM/драйвера проще добавить бизнес-контекст (какая операция/эндпоинт вызвал запрос). Риск — измерения могут искажаться из‑за ожидания пула соединений или сериализации.

Чтобы лог был полезным для расследований, фиксируйте минимум:

Важная развилка: с параметрами или без. Логировать «как есть» удобно, но опасно для приватности; чаще выбирают шаблон запроса + хеш/ID набора параметров.

Основные риски — взрыв объёма, утечки данных и давление на диск/I/O. Практика:

Настройте:

Так slow query log остаётся точным инструментом диагностики, а не источником новых проблем.

Когда в продакшене «всё стало медленно», редко помогает смотреть только на один график. Наблюдаемость работает как триангуляция: метрики показывают симптом и масштаб, трассировки — где именно теряется время, а логи подтверждают или опровергают гипотезу деталями.

Начните с пользовательской задержки: p95/p99 latency. Если p99 резко вырос, а p50 почти не изменился, проблема может затрагивать лишь часть запросов (например, отдельные ключи, редкие маршруты или «тяжёлые» пользователи).

Дальше проверьте контекст:

Важно быстро привязать всплеск к конкретной операции: смотрите метрики по эндпоинтам/методам, tenant’ам или типам операций (например, /checkout vs /search). Так вы переходите от «сервис тормозит» к «тормозит конкретный сценарий».

Distributed tracing помогает разложить запрос на спаны и увидеть, где накапливается задержка:

Сравните «хорошие» и «плохие» трассы одного эндпоинта: различие обычно быстро указывает на конкретный шаг.

Метрики и трассировки подсказывают направление, а логи дают доказательства:

pool exhausted, долгий checkout, рост wait time;Финальный шаг — сопоставить времена: один и тот же интервал на графике, конкретный эндпоинт в метриках, «длинный» спан в трассировке и подтверждающая запись в логах. Так симптом превращается в проверяемую первопричину.

Когда продакшен «тормозит», важно действовать по чек‑листу: сначала стабилизировать ситуацию и собрать факты, а уже потом строить гипотезы.

Начните с конкретного сигнала, который поднял тревогу:

Сразу зафиксируйте: какой порог нарушен и какой пользовательский эффект наблюдается (ошибки, рост времени ответа, деградация части функциональности).

Выберите точный интервал: когда началось, когда стало заметно, есть ли «пилообразность». Затем сопоставьте с изменениями:

Если у вас есть аннотации релизов на графиках — это экономит часы.

Не расследуйте «всё сразу». Цель — свести инцидент к одному из вариантов: один сервис → один эндпоинт → один тип запросов.

Практика: начните с самого «тяжёлого» пути по трассировке или самого частого медленного запроса, а не с редких аномалий.

Сохраните набор доказательств, чтобы сравнивать гипотезы и подтверждать эффект исправлений:

После этого переходите к проверке гипотез — и делайте изменения так, чтобы их эффект был измеримым.

«Медленный запрос» — понятие относительное: 500 мс для редкой админской операции и 200 мс для массового пользовательского эндпоинта дают разный эффект. Поэтому важны не только сами логи, но и правила отбора и приоритизации.

Стартовое значение выбирайте прагматично: так, чтобы лог не превращался в поток шума, но и не пропускал явные проблемы. Частая практика — начать с 200–500 мс для онлайн-запросов и 1–2 с для бэкграунд-джобов.

Дальше порог пересматривайте регулярно: раз в релиз/спринт или после заметных изменений (новые индексы, рост трафика, миграции). Ориентир — ваши SLO и типичные p95/p99 задержек по операциям.

Вместо «логируем всё медленнее X» часто полезнее:

Если сравнивать запросы по сырым строкам, один и тот же шаблон раздуется на тысячи вариантов из‑за разных id и дат. Нормализуйте: заменяйте параметры плейсхолдерами и агрегируйте метрики по «отпечатку» запроса (fingerprint). Так вы увидите настоящих лидеров по затратам.

Один запрос может быть быстрым «в среднем», но медленным в конкретном контексте. Полезные разрезы: эндпоинт, клиент/план, регион/шард, тип операции (чтение/запись), фича‑флаг.

Простой рабочий скоринг:

Impact = QPS × (p95_latency − baseline) × Criticality

Где Criticality — вес (например, 1–5) для ключевых сценариев. Такой подход быстро отделяет «редкие, но длинные» от «частых и болезненных».

Медленный запрос в продакшене редко бывает «просто медленным». Обычно это эффект паттерна нагрузки, конкуренции за ресурсы или неудачного способа доступа к данным.

Если один пользовательский запрос в API порождает десятки/сотни одинаковых SQL-вызовов, база может быть в порядке — её «забивают» сетевые походы и повторяющиеся чтения.

Признаки по трассировке: внутри одного trace видны многие однотипные спаны к БД, каждый может быть «не слишком долгим», но суммарное время становится огромным. В slow query log такие случаи часто не попадают, если каждый запрос по отдельности не превышает порог.

Классика: запросы начинают делать последовательное сканирование (или использовать не тот индекс), и время растёт нелинейно с объёмом данных.

Признаки: скачок p95/p99 у конкретного эндпоинта, рост CPU/IO на БД, а в slow query log — одинаковые шаблоны запросов с растущей длительностью. Вопросы к EXPLAIN (ANALYZE): использует ли план индекс, какова оценка кардинальности, нет ли сортировок/хэшей, которые «проливаются» на диск.

Запрос может быть быстрым по плану, но долго ждать блокировку.

Признаки: в логах — большие времена ожидания при относительно малом execution time (если метрики доступны), в метриках — рост активных сессий и ожиданий. Часто виноваты длинные транзакции, массовые обновления, неудачный порядок операций.

Истощение пула превращает БД в «узкое горлышко» даже без медленного SQL.

Признаки: рост времени ожидания получения соединения, всплеск ретраев, очереди на уровне приложения — при этом сама БД может быть не перегруженной. Частые причины: неверные лимиты, отсутствие таймаутов, ретраи без джиттера.

Длинные аналитические запросы и бэч-джобы легко «съедают» IO/CPU и ухудшают всё остальное.

Признаки: деградация начинается по расписанию, в логах видны редкие, но очень долгие запросы, а метрики показывают общий рост нагрузки. Обычно помогают изоляция (отдельные реплики/очереди), лимиты и перенос выполнения на «тихие» окна.

Когда slow query log показал «виновника», важно выбрать самое дешёвое и безопасное ускорение. Часто достаточно небольших правок, которые не меняют бизнес-логику, но резко снижают нагрузку на базу.

Начните с плана выполнения: медленный запрос нередко «сканирует всё», потому что нет подходящего индекса или условие не позволяет его использовать.

LOWER(email)=...), если из‑за этого индекс не применяется — лучше нормализовать данные или хранить вычисляемое значение.Кэш помогает, когда много одинаковых чтений и данные меняются предсказуемо.

Используйте TTL для «почти актуальных» данных (списки, карточки, справочники) и инвалидацию по событию там, где нужна точность (например, после обновления профиля). Обязательно измеряйте hit rate и время ответа: кэш без метрик превращается в чёрный ящик.

Если запрос возвращает тысячи строк «случайно», это быстро становится инцидентом.

Ставьте разумные LIMIT, вводите обязательную пагинацию, а для больших списков предпочитайте keyset-pagination (по стабильному ключу), чтобы не «перелистывать» через OFFSET.

Задайте таймауты на запросы и внешние вызовы так, чтобы система успевала деградировать, а не зависать. Ретраи делайте с экспоненциальной паузой и джиттером, и не повторяйте бездумно неидемпотентные операции.

Если чтения доминируют — вынесите их на read‑реплики. Тяжёлые расчёты и массовые операции лучше отправлять в очередь или выполнять батчами, чтобы сглаживать пики и держать SLO по интерактивным запросам.

Observability ценна только тогда, когда она включена постоянно, даёт сопоставимые данные и не превращается в «праздник по запросу». Цель — сделать так, чтобы при любом инциденте у вас уже были следы: где болит, как сильно и что изменилось.

Начните с дисциплины логирования: пишите логи в структурном виде (JSON), одинаковыми полями во всех сервисах.

Критически важно, чтобы request_id и trace_id присутствовали в каждом сообщении (и в HTTP-ответах). Тогда вы сможете за секунды связать:

Практика: генерируйте request_id на входе (ingress/API gateway), прокидывайте его в заголовках и контексте логгера, а trace_id — из системы трассировки.

Распределённая трассировка быстро дорожает, если «снимать всё». Рабочая схема — сочетать несколько режимов:

Так вы сохраняете видимость в проблемных случаях и контролируете стоимость хранения.

Дашборды должны отвечать на вопросы «что происходит?» и «где узкое место?». Соберите «золотые сигналы» по каждому сервису:

Алерты лучше строить вокруг SLO: нарушение задержки/доли ошибок для пользовательских операций, а не только CPU/память/диски. CPU может быть «нормальным», а p99 — уже разрушать UX.

Надёжность — это повторяемость действий. Подготовьте внутренние плейбуки:

Храните их рядом с дашбордами и ссылками на процедуры (например, /runbooks/incident-db-latency). Тогда новичок сможет действовать так же эффективно, как и дежурный «ветеран».

Логи медленных запросов и трассировки часто становятся самым «честным» слепком продакшена — и именно поэтому они опасны. В них легко случайно зафиксировать то, что по правилам безопасности вообще не должно покидать контур приложения.

Не допускайте попадания в тексты запросов, параметры, сообщения ошибок и атрибуты трасс:

Если запрос строится конкатенацией строк, риск особенно высокий: значения могут оказаться прямо в SQL и уйти в slow query log.

Практичное правило: храните форму запроса, а не содержимое.

Логи и трассы — это те же данные, что и база.

Храните достаточно для расследований и трендов, но без избыточности: отдельные TTL для «сырых» логов (короткий) и агрегатов/метрик (дольше). Это упрощает соответствие требованиям и снижает ущерб при утечке.

Зафиксируйте правила в чек‑листе ревью: «нет секретов в логах», «параметризация», «маски». Добавьте автопроверки в CI (поиск токен‑паттернов) и регулярно проводите выборочные проверки логов на продакшене.

Инциденты с «внезапно медленными» запросами почти всегда повторяются по одному сценарию: незаметная регрессия в коде, изменение данных (рост таблиц, перекос распределения), индекс «как будто помог», но сломал соседний кейс. Профилактика — это привычка держать производительность измеряемой и сравнимой.

Заведите ритуал: еженедельно (для быстрорастущих систем) или ежемесячно просматривать top медленных запросов из slow query log.

Смотрите не только на среднее время, а на:

время × количество.Фиксируйте решения: что оптимизировали, какой эффект получили, какие риски приняли.

Перед выкладкой сравнивайте «до/после» на одинаковых сценариях:

Важно сохранять baseline, чтобы регрессии ловились автоматически, а не «по ощущениям».

Привяжите оптимизацию к SLO. Если ошибки/задержки «съедают» бюджет, оптимизация становится обязательной работой, а не «когда-нибудь». Это помогает приоритизировать: исправляем то, что влияет на пользователей и деньги.

Держите базовые метрики (latency, throughput, saturation) и алерты на изменения p95/p99, рост времени блокировок, увеличение доли медленных запросов. Добавьте контрольные запросы (canary): несколько критичных SQL, которые выполняются по расписанию и дают ранний сигнал.

Если вы собираете сервис «с нуля», проще заложить наблюдаемость сразу — вместе с архитектурой и контрактами логирования. В TakProsto.AI это удобно делать в режиме чата: вы описываете сценарии (эндпоинты, ключевые операции, SLO), а затем фиксируете требования к логам/метрикам/трассировкам как часть плана (planning mode) и разворачиваете изменения итеративно.

Практичный подход:

request_id/trace_id;Если нужно — в TakProsto.AI можно экспортировать исходники, а также настроить деплой и хостинг, чтобы наблюдаемость сопровождала проект на всём жизненном цикле.

Если хотите упаковать это в процесс с прозрачными целями и SLA — посмотрите /pricing.

Больше практических заметок по логам, метрикам и поиску причин — в /blog.

Observability помогает ответить на вопрос «почему стало плохо» за счёт связки сигналов: метрики показывают масштаб, трассировки — где теряется время по цепочке сервисов, логи — что именно произошло (ошибка, таймаут, ретрай, параметры контекста). Мониторинг чаще ограничивается «что сломалось/выросло».

Потому что БД — общий ресурс для многих сервисов. Один тяжёлый запрос может:

Дальше запускаются таймауты, ретраи, растут очереди — и деградация быстро становится системной.

Минимальный практичный набор:

Полезные поля:

Так вы сможете агрегировать по «отпечатку» запроса и связывать его с инцидентом.

Три частых уровня включения:

Часто лучший вариант — СУБД + корреляция через trace_id, а бизнес-контекст брать из логов приложения.

Чтобы не «убить» продакшен:

Дальше корректируйте пороги по вашим SLO и реальным p95/p99.

Рабочая схема расследования:

Цель — быстро перейти от симптома к проверяемой гипотезе и измеримому фиксe.

Ротация и лимиты — обязательны:

Отдельно полезно хранить агрегаты (top‑N/fingerprint статистику) дольше, чем «сырые» логи.

Частые причины:

Практичные первые шаги:

request_id/trace_idendpointduration_msdb_time_msКлючевое — общий контекст (trace_id/release/region/tenant), чтобы быстро сопоставлять сигналы.

Их удобно отличать как раз через сочетание трассировок + slow query log + метрик saturation.

Выбирайте изменения, которые дают измеримый эффект при минимальном риске.