14 апр. 2025 г.·8 мин

От идеи простыми словами до приложения: перевод LLM

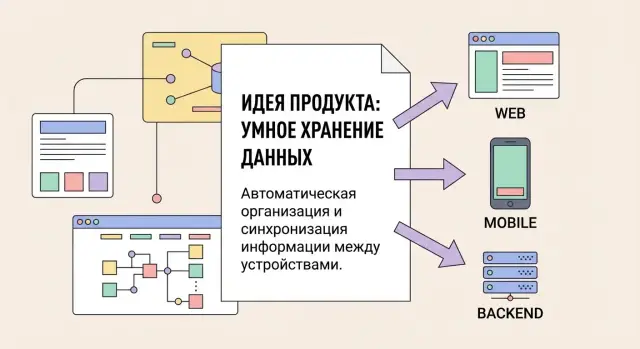

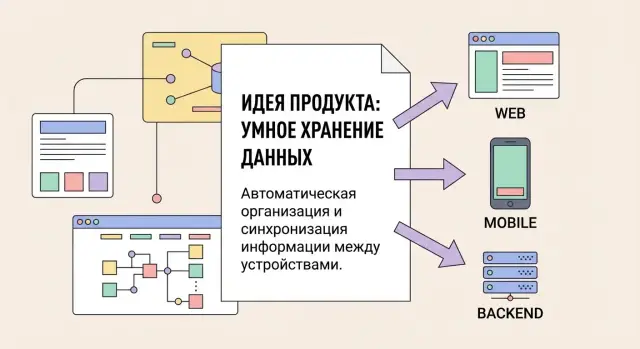

Разбираем, как LLM превращают описание продукта простыми словами в сценарии, дизайн, код и запуск web-, mobile- и backend‑частей приложения.

Разбираем, как LLM превращают описание продукта простыми словами в сценарии, дизайн, код и запуск web-, mobile- и backend‑частей приложения.

LLM лучше всего работает не с «гениальными инсайтами», а с ясным описанием задачи — как если бы вы объясняли её коллеге, который будет делать продукт завтра. «Простой язык» — это не примитивность, а отсутствие скрытых предположений: кто пользователь, что он пытается сделать, что считается успехом.

На практике это особенно заметно в формате vibe-coding, где вы двигаетесь от диалога к результату итерациями. Например, в TakProsto.AI можно начать с короткого описания сценария, а затем шаг за шагом уточнять экраны, данные и ограничения — платформа будет собирать прототип web/mobile и backend вокруг вашей формулировки.

Хорошая формулировка описывает действие и результат, а не только тему. Вместо «нужно приложение для спорта» — «пользователь выбирает тренировку на 20 минут, приложение ведёт по таймеру, сохраняет прогресс и напоминает 3 раза в неделю».

Полезный ориентир: если из текста можно построить 3–5 экранов и понять, какие данные нужно хранить, — ввод уже достаточный для первого прототипа.

Плохо: «Сделайте сервис доставки еды для студентов. Должно быть удобно и быстро».

Почему плохо: непонятно, доставка откуда, как оформляется заказ, что значит «быстро», чем сервис отличается от обычной доставки.

Хорошо: «Нужен web и mobile сервис для студентов кампуса. Пользователь выбирает столовую (3 точки), видит меню на сегодня, собирает заказ, оплачивает картой, выбирает окно выдачи (15‑минутные слоты). Цель — сократить очереди. Ограничение: без доставки, только самовывоз. Админ столовой обновляет блюда и стоп-лист».

Такое описание даёт LLM опору для ролей, экранов, сущностей данных и базовых сценариев.

Аудитория и контекст: кто пользуется и где (город, офис, кампус, домашнее использование).

Цель и метрика успеха: «сократить время оформления до 30 секунд», «уменьшить ошибки в заказах».

Ограничения: платформы (web/mobile), язык, регион, бюджет на инфраструктуру, сроки, офлайн/онлайн режим.

Нужно/не нужно: регистрация обязательна? уведомления? чат? интеграции?

Пишите проверяемыми утверждениями: не «удобный поиск», а «поиск по названию и фильтр по цене/категории». Если есть слова вроде «быстро», «безопасно», «современно», добавляйте критерий: время отклика, уровни доступа, какие данные храним.

И главное — прямо перечислите то, чего точно не будет в первой версии. Тогда модель не «достроит» лишнее по умолчанию, а сфокусируется на MVP.

LLM не «понимает бизнес» как человек, но умеет превращать текст в структуру: выделять сущности, связи и пробелы. На практике это похоже на интервью: модель сначала собирает карту предметной области, а потом проверяет её вопросами.

Из фразы «сделайте приложение для записи к мастерам» LLM обычно достаёт базовые блоки:

Этот «скелет» важен, потому что на нём держатся экраны, API, модель данных и тестовые сценарии.

Неявные требования — это то, что подразумевается, но не сказано: часовые пояса, уведомления, права доступа, восстановление доступа, история действий, требования к модерации, работа без сети в мобильном приложении.

LLM может выявлять их через уточняющие вопросы. Хорошие вопросы выглядят так:

Чтобы требования не расплывались, полезно просить LLM фиксировать цель, метрики и границы версии 1. Например: «цель — снизить количество звонков», метрика — «доля записей онлайн», границы — «без программы лояльности и без сложных ролей». Так модель сможет предлагать решения и одновременно отбрасывать лишнее.

LLM может:

Противоядие простое: просите модель помечать предположения, перечислять «что нужно уточнить у владельца продукта» и показывать альтернативы с плюсами и минусами.

Пока идея живёт в одном абзаце, её легко понять «в целом» — и почти невозможно одинаково реализовать. Цель этого шага — превратить свободный текст в набор сценариев, экранов и границ первой версии.

Начните с того, чтобы попросить LLM выделить роли (кто пользуется) и цели (зачем). Хороший результат — не «пользователь», а 2–5 конкретных ролей.

Пример формулировки для модели: «Выдели роли, их главные задачи и что считается успехом. Не придумывай новые роли без оснований в тексте».

На выходе вы получаете краткую таблицу: роль → задачи → частота → критичность. Это помогает сразу увидеть, что важнее: например, «создать заявку за 30 секунд» важнее, чем «настроить тему интерфейса».

Дальше каждую ключевую задачу превращаем в user story простым языком:

И рядом — 3–6 критериев приёмки, которые можно проверить без споров. Например: «Заявка отправляется, если заполнены поля A и B», «Пользователь видит понятную ошибку, если поле B пустое», «После отправки открывается экран статуса».

Попросите LLM составить карту экранов/страниц: список экранов + основной сценарий переходов. Полезно сразу фиксировать состояния: пустой список, загрузка, ошибка, нет доступа.

Так вы получаете скелет продукта: «Вход → Список → Карточка → Создание → Подтверждение». Это уже основа для прототипа.

В конце сделайте «разрез» по версиям:

Главный критерий: MVP должен решать одну-две задачи целиком (end-to-end), а не «чуть-чуть всё».

Прототип — это быстрый способ проверить, правильно ли вы друг друга поняли: вы, команда и LLM. Не нужно начинать с «идеального дизайна». Достаточно чернового UI, который показывает навигацию, ключевые экраны и то, как пользователь проходит сценарий от начала до результата.

Попросите LLM разложить вашу идею на 5–9 основных экранов и нарисовать структуру переходов: «список → карточка → действие → подтверждение». Затем уточните набор компонентов на каждом экране: кнопки, поля ввода, фильтры, табы, таблицы, карточки.

Важно отдельно описать состояния, которые обычно забывают:

LLM удобно использовать как «контролёра полноты»: вы даёте один экран, а модель предлагает, какие состояния и микротексты нужны, чтобы интерфейс был понятным.

Для web-прототипа заранее определите, где будет таблица (с сортировкой, фильтрами, пагинацией), а где — карточки. Попросите LLM подготовить требования к адаптивности: что происходит на узком экране, как сворачивается боковое меню, какие элементы прячутся в «ещё».

Ещё один полезный запрос: чек-лист доступности. Например, фокус в формах, подсказки для ошибок ввода, контраст и подписи к иконкам. Это легко заложить в прототип, пока всё дёшево менять.

Для mobile-прототипа уточните навигацию (нижняя панель, стек экранов), жесты (свайп, pull-to-refresh) и то, что должно работать без сети: просмотр последних данных, очередь действий, понятные сообщения о синхронизации.

Если нужны пуши, зафиксируйте типы уведомлений и куда ведёт тап: на экран, на конкретный объект или в центр уведомлений.

Практика: сделайте 1–2 итерации «прототип → комментарии → правки». LLM может быстро:

Так вы получите прототип, по которому удобно собирать обратную связь, не тратя недели на детализацию, которая может оказаться не нужна.

Когда идея уже разложена на сценарии, следующий шаг — понять, «где живёт логика»: что делает клиент, что делает сервер, а что должно выполняться в фоне. Хороший backend начинается не с технологий, а с границ системы.

Если вы собираете продукт через vibe-coding, полезно заранее зафиксировать стек и договорённости по данным: это снижает количество «дрейфа» в решениях между итерациями. В TakProsto.AI типовой стек под это уже заточен (React для web, Go для backend, PostgreSQL для данных, Flutter для mobile), а дальше важнее всего качество требований и приоритетов.

Разделите продукт на несколько понятных частей:

LLM полезен тем, что по описанию продукта может предложить список операций и сразу подсветить спорные места: например, «это действие должно быть мгновенным или может выполняться асинхронно?»

Если команда небольшая и продукт только запускается, чаще выигрывает монолит: проще деплой, меньше интеграционных ошибок, одна база данных.

К сервисам есть смысл идти, когда появляются разные домены с независимыми темпами изменений (например, платежи, рекомендации, аналитика) или нужны отдельные требования к масштабированию. Важно фиксировать причину выбора, а не «как модно».

Начните с сущностей из сценариев: Пользователь, Проект, Задача, Комментарий, Оплата — и определите:

Чтобы не потерять контекст, ведите короткую документацию: 1–2 страницы на модуль.

Так LLM и команда работают в одном поле: меньше неявных ожиданий, меньше переделок.

ИИ лучше всего ускоряет работу там, где много повторяющихся решений: типовые экраны, CRUD-операции, валидации, проклейка маршрутов, заготовки для API и тестов. Важно воспринимать результат как «черновик, который уже компилируется», а не как готовую систему.

Обычно хорошо получается сгенерировать:

Экономия времени максимальна, когда вы заранее ограничили рамки: какие сущности есть, какие поля обязательны, какие ошибки показываем пользователю.

Чтобы код не превратился в «зоопарк», задайте правила до первой генерации и закрепите их в репозитории:

Практика: начните с короткого «гайда проекта» в README и просите ИИ следовать ему при каждом изменении.

Наибольшую пользу обычно дают:

ИИ быстро набрасывает тест-кейсы и каркас тестов, но ожидаемо путается в реальных зависимостях: токены, права, миграции, фикстуры данных. Поэтому лучше просить его генерировать тесты «по одному сценарию» и сразу запускать.

Сильная схема — маленькие итерации:

Так ИИ экономит часы на рутине, а вы сохраняете управляемость и качество кода.

Интеграции чаще всего «ломают» сроки не из‑за сложного кода, а из‑за недосказанностей: как подтверждается оплата, когда приходит вебхук, что делать при таймауте, какие лимиты у провайдера. LLM может помочь заранее разложить эти вопросы по полкам — если дать ей правильный ввод.

Обычно в продукте быстро появляются: платежи (подписки, возвраты), почта и push/SMS‑уведомления, карты/геокодинг, аналитика и атрибуция. Даже если вы «пока не планируете», полезно обозначить будущие точки расширения, чтобы архитектура не упёрлась в стену.

Чтобы ИИ не «додумывал» за вас, фиксируйте:

Попросите LLM сформировать контракты до реализации: таблицу эндпоинтов (метод, URL, поля, статусы), схемы JSON (вход/выход), а также модель данных: какие сущности храним у себя (например, payment_intent_id, provider, status, amount, currency, last_error). Контракт — это «правило игры» для frontend, backend и внешнего провайдера.

Заранее опишите сценарии: сервис недоступен, вебхук не пришёл, пришёл дважды, очередь переполнена. Хороший минимум: таймауты, повторы с экспоненциальной задержкой, очередь задач, ручная сверка, режим “мы приняли запрос и обработаем позже” и понятные статусы в интерфейсе.

LLM удобны как «ускоритель» для анализа требований, генерации текстов, кода и тестов. Но модель — это внешний обработчик данных (или отдельный компонент внутри вашей инфраструктуры), поэтому важно сразу определить: какие данные можно передавать, как они защищаются и кто имеет к ним доступ.

Если вы работаете с требованиями к приватности, учитывайте и инфраструктуру инструмента. Например, TakProsto.AI рассчитан на российский контур: запуск на серверах в России, использование локализованных/opensource LLM и принцип «данные не уезжают за пределы страны» — это может быть важным ограничением уже на этапе выбора процесса разработки.

Начните с фундамента приложения, а не с промптов. Если LLM помогает генерировать backend, проверьте, что в проекте предусмотрены:

Сформулируйте принцип: «отправляем минимум, храним минимум». Для персональных и коммерчески чувствительных данных:

Запрещайте в правилах команды и в интерфейсе: пароли, ключи, приватные ключи, токены доступа, полные дампы БД, персональные данные, внутренние документы «как есть». Если нужен пример для отладки — используйте синтетические данные.

Логи должны помогать отвечать на вопрос «что произошло и кто это сделал», но не становиться хранилищем секретов. Полезно фиксировать: вход/выход пользователя, смену ролей, ошибки авторизации, вызовы внешних API, операции экспорта, админские действия, а для LLM — факт обращения, идентификатор запроса и объём данных (без содержимого). Для реагирования настройте алерты по аномалиям и сохранение аудита изменений.

LLM ускоряет путь от текста к продукту, но качество появляется не «с первого промпта», а через короткие циклы: сформулировали правку → получили результат → проверили → зафиксировали. Именно итерации превращают разрозненные ответы модели в предсказуемую систему.

Фидбек вроде «сделай удобнее» не исполняется. Нужны наблюдаемое поведение и критерии:

Такой формат одинаково полезен и модели, и команде: он сводит «мнение» к проверяемому сценарию.

LLM нередко меняет код шире, чем вы просили: поправили форму — и внезапно сломалась авторизация. Это регрессия, и лечится она не поиском виноватых, а страховочной сеткой:

Минимальный «сигнал тревоги» — список 5–10 ключевых проверок, которые прогоняются после каждой правки.

Попросите модель сделать одну измеримую вещь за раз: добавить поле, изменить валидацию, обновить один эндпоинт. После — быстрый прогон: сборка, запуск, ручной сценарий, (если есть) тесты. Чем короче цикл, тем легче понять, какая конкретно правка вызвала побочный эффект.

Используйте единый шаблон на каждую итерацию:

Этот шаблон снижает хаос: даже если часть работы делает LLM, результат остаётся проверяемым и воспроизводимым.

LLM помогает быстрее превращать описание идеи в требования, сценарии, прототипы и даже заготовки кода. Но ответственность за решения и их последствия остаётся у людей: модель не «владеет» продуктом, не чувствует бизнес-риски и может уверенно ошибаться.

ИИ хорош там, где требуется скорость и варианты: набросать пользовательские истории, предложить edge cases, собрать список экранов, разложить логику по модулям, сгенерировать черновики тестов или документации.

Человек обязателен там, где есть цена ошибки:

Продакт формулирует цель, аудиторию, ценность и ограничения. Он превращает «хочу приложение» в проверяемые гипотезы и критерии готовности.

Дизайнер отвечает за пользовательский опыт: сценарии, информационную архитектуру, тексты, визуальную систему. LLM может предложить варианты, но дизайнер принимает решения и проверяет их на людях.

Разработчик отвечает за реализацию: качество кода, читаемость, производительность, тесты, поддержку. LLM ускоряет рутину, но разработчик проверяет корректность и интегрирует изменения в реальный репозиторий.

Удобный минимум: задачи в трекере, ветки под фичи, обязательное ревью, короткие демо по итогам итерации. LLM используйте как «второго автора» — просите подготовить план PR, список проверок, варианты миграций. При этом все изменения должны проходить через обычный процесс: ветка → PR → ревью → тесты → демо.

Чтобы ответы были точнее, передавайте контекст блоками: цель и аудитория, ключевые сценарии, ограничения (платформы, сроки, бюджет), текущие решения (стек, структура данных), стандарты команды (стиль кода, правила именования) и «что считаем правильным результатом» (acceptance criteria). Тогда модель меньше фантазирует и чаще выдаёт применимые артефакты.

Самый быстрый способ получить пользу от LLM — не пытаться «описать всё», а собрать минимальный, но связный пакет вводных. Ниже — практический стартовый набор, который помогает превратить идею в понятный план MVP без бесконечных уточнений.

Скопируйте и заполните:

Ты — продуктовый аналитик и архитектор. Помоги превратить идею в спецификацию MVP.

1) Идея в 2–3 предложениях:

...

2) Для кого продукт и какая главная польза:

...

3) MVP: 3–7 ключевых функций (в порядке важности):

- ...

4) Что точно НЕ делаем в первой версии:

- ...

5) Платформы:

- web (обязательно/желательно)

- mobile (iOS/Android/оба)

6) Данные и роли:

- какие сущности храним

- роли пользователей и права

7) Интеграции:

- платежи/почта/карты/аналитика/CRM и т.д.

8) Нефункциональные требования:

- скорость, офлайн, доступность, локализация

9) Риски и ограничения:

- сроки, бюджет, юридические ограничения, приватность

Выход: список вопросов, пользовательские сценарии, список экранов, модель данных, план релиза.

Чтобы LLM не «додумывала» важное, заранее соберите:

Попросите LLM разложить MVP на «единицы поставки»: экран/эндпоинт/интеграция/тест. Затем:

Если вы делаете проект в TakProsto.AI, эту декомпозицию удобно использовать как «план режима планирования» (planning mode): сначала согласовать структуру и границы версии, а уже потом переходить к генерации модулей, снимкам (snapshots) и откатам (rollback) при изменениях.

Про стоимость и форматы — /pricing. Больше разборов и шаблонов — /blog. Примеры решений и результатов — /examples.

Если вы хотите пройти путь «идея → прототип → приложение» в одном месте, посмотрите TakProsto.AI: там есть бесплатный тариф, экспорт исходников, деплой/хостинг, кастомные домены, а также программа кредитов за контент и реферальные приглашения.

Достаточный ввод — это описание действий пользователя и результата, а не только темы.

Практический тест: если по вашему тексту можно набросать 3–5 экранов, понять какие данные хранить и какие роли есть, этого достаточно для первого прототипа.

Пишите проверяемыми критериями и цифрами:

И обязательно добавьте пункт: что точно не делаем в первой версии, чтобы модель не достраивала лишнее.

Дайте структуру, которую модели легко «распарсить»:

Можно прямо взять шаблон из поста и заполнить его одним экраном текста.

Обычно LLM превращает текст в «скелет»:

Полезная практика: попросить модель перечислить допущения и отдельно — вопросы к владельцу продукта.

Попросите:

Так вы получаете требования, которые можно проверить: тестом, демо или чек-листом, без споров «мне кажется».

Сделайте короткую карту:

Это быстрее, чем «рисовать дизайн», но уже позволяет собрать фидбек и увидеть дыры в сценариях.

Зафиксируйте границы системы:

Для старта чаще выигрывает монолит: проще деплой и меньше интеграционных рисков. К сервисам переходят, когда есть реальные причины (разные домены, масштабирование, независимые команды).

Да, особенно для типовых частей:

Чтобы не получить «зоопарк», заранее задайте правила: линтер, стиль именования, архитектурные ограничения и формат ошибок API.

Опишите интеграцию как набор договорённостей:

Попросите модель сначала сделать контракт (эндпоинты, схемы JSON, статусы), и только потом — реализацию.

Следуйте принципу «передаём минимум, храним минимум»:

Если есть сомнения — сначала сформулируйте правила данных для команды и закрепите их в README.