01 июл. 2025 г.·8 мин

Паттерны мультиарендного SaaS и роль ИИ в архитектуре

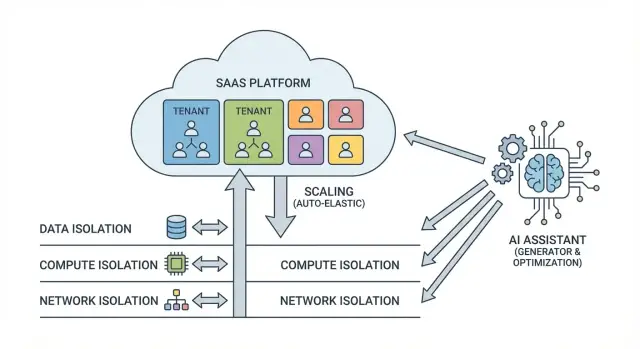

Разбираем паттерны multi-tenant SaaS: изоляцию данных и ресурсов, масштабирование, миграции и то, как ИИ помогает генерировать и проверять архитектуры.

Что такое multi-tenant SaaS и какие задачи он решает

Multi-tenant SaaS (мультиарендный SaaS) — это модель, где один и тот же продукт и его инфраструктура обслуживают сразу много клиентов (арендаторов, tenants). У каждого арендатора — свои пользователи, настройки и данные, но приложение и операционная «кухня» общие.

Какие задачи решает мультиарендность

Главная идея — экономия и управляемость за счёт стандартизации.

Во‑первых, снижение стоимости владения: вместо отдельных окружений на каждого клиента вы разделяете вычисления, хранение и поддержку. Это особенно заметно на ранних стадиях, когда важно не раздувать инфраструктуру.

Во‑вторых, быстрое масштабирование: добавление нового арендатора часто сводится к онбордингу и конфигурации, а не к развёртыванию нового «мини‑продукта».

В‑третьих, простое обновление: вы выкатываете новую версию один раз, а не обслуживаете множество разрозненных инсталляций. Это ускоряет выпуск функций и исправлений.

Ключевые риски, о которых важно помнить

-

Утечки данных между арендаторами. Любая ошибка в запросах, кэшировании или логике авторизации может привести к тому, что один клиент увидит данные другого.

-

«Шумный сосед» (noisy neighbor). Один арендатор может нагрузить общие ресурсы и ухудшить качество сервиса для остальных.

-

Сложность миграций. Схемы данных и изменения функциональности нужно обновлять так, чтобы не нарушать работу разных сегментов клиентов и их конфигураций.

Как выбрать подход к изоляции под сегменты клиентов

Практика обычно начинается с общей инфраструктуры и усиливает изоляцию по мере роста требований. Небольшим клиентам часто достаточно логической изоляции (например, через идентификатор арендатора в данных), а для крупных или регулируемых отраслей может потребоваться более жёсткое разделение — вплоть до отдельных баз данных или выделенных ресурсов.

Чтобы решение не было «на глаз», заранее зафиксируйте градации изоляции по тарифам и типам клиентов: базовая (shared) для большинства и усиленная (dedicated) для тех, кто платит за повышенный контроль.

Уровни изоляции: данные, вычисления и сеть

Мультиарендность — это компромисс между экономией на общем инфраструктурном слое и ожиданиями клиентов по безопасности и предсказуемости сервиса. Удобно думать об изоляции как о трёх независимых «ручках»: данные, вычисления и сеть. Их можно усиливать по отдельности, не обязательно сразу «выделять всё каждому».

Изоляция данных: логическая vs физическая

Логическая изоляция означает, что арендаторы делят один и тот же контур хранения, но доступ разделяется правилами: tenant_id в таблицах, ограничения на уровне запросов, политики доступа. Это дешевле и проще масштабировать, но требует дисциплины в разработке и проверок.

Физическая изоляция — когда у арендатора свой отдельный контур хранения (схема или база данных, иногда даже отдельный кластер). Это увеличивает стоимость и сложность операций (бэкапы, миграции, мониторинг), зато проще объяснить безопасность и ограничить «радиус поражения».

Изоляция вычислений: общий пул vs выделенные воркеры

В общем пуле (общие сервисы, общие очереди, общие воркеры) легче утилизировать ресурсы, но выше риск noisy neighbor: один крупный клиент может «съесть» CPU/память/коннекты.

Выделенные воркеры или отдельные сервисы для части арендаторов дают предсказуемость по задержкам и SLA. Частый компромисс: общий API‑слой, но фоновые задачи и тяжёлые отчёты — в выделенных очередях/воркерах.

Сетевая изоляция: VPC/подсети и политики доступа

Сетевая изоляция добавляет барьеры поверх логики приложения: отдельные VPC/подсети, сегментация, правила east‑west трафика, отдельные endpoint’ы к хранилищам. Это помогает снизить риск бокового перемещения при инцидентах и лучше удовлетворяет требованиям аудиторов.

Что обычно требуют крупные клиенты и регуляторы

Чаще всего запрашивают: доказуемое разделение данных, управляемые ключи шифрования, минимизацию прав доступа, журналирование действий и возможность изолировать «критичных» арендаторов (хотя бы на уровне БД/вычислений). Важно заранее определить градации: базовый уровень для большинства и усиленный — для тех, кому нужна (и оплачивается) повышенная изоляция.

Одна база данных и общий набор таблиц (tenant_id)

Этот вариант часто называют подходом «всё в одном»: у всех арендаторов одна и та же база данных и один общий набор таблиц, а принадлежность строк конкретному клиенту определяется полем tenant_id. По сути, вы строите один продукт и одно хранилище, но логически делите данные.

Когда это уместно

Подход хорошо подходит, если вы запускаете SaaS с нуля, хотите быстро выйти на рынок и ожидаете много небольших арендаторов с похожими сценариями и объёмами данных. Администрирование проще: одна схема, единые миграции, меньше вариативности.

Плюсы и минусы: коротко и по делу

Плюсы — простота и низкая стоимость владения: меньше баз, меньше операций, проще мониторинг и обновления.

Минусы — конкуренция за ресурсы и высокая цена ошибки. Один тяжёлый отчёт или неудачный запрос может замедлить работу для других (noisy neighbor). А неверное условие в запросе или баг в логике фильтрации может привести к утечке данных между арендаторами.

Индексы и уникальности с учётом tenant_id

Ключевое правило: tenant_id должен присутствовать в индексах и ограничениях там, где это влияет на поиск и уникальность. Практический эффект:

- запросы быстрее, потому что база сразу сужает выборку до арендатора;

- уникальные значения становятся «уникальными внутри арендатора» (например,

UNIQUE (tenant_id, email)вместо глобальногоUNIQUE (email)).

Также полезно договориться о стандарте в приложении: любые выборки из мультиарендных таблиц обязаны фильтроваться по tenant_id, а «исключения» оформляются явно и проходят отдельное ревью.

Резервное копирование и восстановление для отдельных арендаторов

С одной базой сложнее «точечно» восстановить данные одного клиента. Поэтому заранее продумайте процедуры:

- регулярные бэкапы + возможность восстановления в отдельную временную среду;

- экспорт/импорт данных конкретного

tenant_id(как часть поддержки и требований клиентов); - журналирование изменений, чтобы откатывать ошибки без полной остановки сервиса.

Если вам важно быстрое восстановление отдельного арендатора по SLA, фиксируйте это требование заранее — позже может оказаться, что удобнее перейти на модель с отдельными схемами или базами.

Одна база данных, отдельная схема на арендатора

Подход «одна база данных, отдельная схема (schema) на арендатора» выбирают, когда хочется балансировать между простотой управления инфраструктурой (одна БД) и более наглядной изоляцией на уровне структуры данных.

Где это удобно

Схема на арендатора хорошо работает, если у клиентов есть отличия в наборе таблиц или темпах роста, но вы не готовы поднимать отдельную базу под каждого.

Практические плюсы:

- Логическая изоляция: таблицы, индексы и представления разделены по схемам — проще объяснить аудиторам и команде поддержки.

- Гибкость: можно точечно добавлять индексы или материализованные представления «тяжёлым» арендаторам, не трогая остальных.

- Проще перенос: при необходимости отдельного арендатора можно мигрировать в другую БД более предсказуемо (экспорт/импорт схемы).

Миграции без простоя

Главная сложность — обновлять десятки/сотни схем синхронно.

Хорошая практика — делать миграции идемпотентными и раскатывать их поэтапно:

-

сначала изменения, совместимые со старой версией приложения (добавили колонку, но ещё не используем),

-

затем выкатываем код,

-

потом «чистим хвосты» (удаляем старое).

Также полезны «батчи» (миграция группами арендаторов) и отдельный сервис/джоб для миграций с повторными попытками и отчётностью по прогрессу.

Границы изоляции и цена обслуживания

Схема не является границей безопасности сама по себе: нужно строго настроить роли/права, запретить доступ «мимо приложения», аккуратно работать с search_path и подключениями.

Чем больше схем, тем выше операционная нагрузка: растёт время миграций, увеличивается число объектов для мониторинга, бэкапов и восстановления. Когда число арендаторов и частота релизов растут, схема на арендатора часто становится тяжёлой операционно — и тогда рассматривают tenant_id в общих таблицах или выделение отдельных баз для крупных клиентов.

Отдельная база данных на арендатора и гибридные модели

Модель «отдельная база данных (БД) на арендатора» часто выбирают, когда цена ошибки высока: финансы, медицина, крупные B2B‑контракты, строгие требования к резидентности данных или аудитам. Вы получаете максимальную изоляцию: отдельные файлы данных, отдельные планы бэкапов/восстановления, проще доказать границы доступа и ограничить «соседей» по ресурсам.

Плюсы и цена сильной изоляции

Плюсы очевидны: проще выполнять запросы на удаление/экспорт данных конкретного клиента, точнее настраивать политики шифрования, легче делать «точечные» миграции.

Но за это платят эксплуатацией: больше объектов для мониторинга, больше бэкапов, больше секретов и ролей, выше риск упереться в лимиты СУБД и инфраструктуры (соединения, число инстансов/БД, IOPS).

Важно заранее посчитать не только стоимость хранения, но и стоимость «пустоты»: даже небольшая БД требует обслуживания, резервного копирования и регулярных проверок восстановления.

Гибрид: shared для малых, dedicated для enterprise

На практике выигрывает гибридный подход: малые и средние арендаторы живут в shared‑пуле, а крупным выдаётся dedicated‑БД. Это позволяет:

- держать низкую себестоимость для «длинного хвоста» клиентов;

- продавать enterprise‑опции (SLA, отдельные ключи шифрования, выделенные лимиты);

- снижать риск noisy neighbor без тотального раздробления инфраструктуры.

Планирование лимитов и операционных затрат

Заранее зафиксируйте бюджеты: максимальное число БД, допустимое количество одновременных соединений на пул, частоту бэкапов, RPO/RTO и стоимость восстановления. Проверьте, как меняется цена при росте числа арендаторов и при пиковых нагрузках. Полезно привязать лимиты к тарифам и описать их в /pricing.

Перенос арендатора из shared в dedicated

Безболезненный «upgrade» — это управляемый процесс:

-

заморозка схемы и версий миграций (чтобы данные и приложение совпадали);

-

создание dedicated‑БД по шаблону, выдача ролей/секретов;

-

копирование данных (snapshot/логическая репликация), валидация объёма и контрольных сумм;

-

переключение трафика (feature flag/маршрутизация по tenant), короткое окно записи или dual‑write;

-

пост‑контроль: метрики ошибок, задержки, целостность, план отката.

Ключ к снижению рисков — автоматизация шагов и заранее отрепетированные сценарии восстановления.

Изоляция на уровне приложения: контекст арендатора

Каркас приложения под арендаторов

Соберите каркас React и Go с PostgreSQL-моделью под tenant_id или схемы на арендатора.

Даже если база данных настроена идеально, мультиарендность часто «ломается» на уровне приложения: запросы выполняются без tenant_id, фоновые задачи теряют контекст, а конфигурация смешивается между клиентами. Поэтому важно сделать «контекст арендатора» обязательной частью любого входа и любого выполнения кода.

Tenant context: как передавать tenant_id через API, очереди и фоновые задачи

В HTTP API tenant_id обычно выводят из: поддомена (acme.example), JWT/Access Token (claim) либо заголовка (например, X-Tenant-Id). Главное — выбрать один канонический источник и валидировать его на границе.

Для очередей и фоновых задач правило то же: tenant_id должен быть частью полезной нагрузки сообщения и/или метаданных (headers). При постановке задачи в очередь сохраняйте tenant_id вместе с user_id, idempotency key и версией схемы, чтобы обработчик не «догадывался» о контексте по косвенным признакам.

Мидлвары и фильтры: запрет запросов без контекста

Сделайте защиту по умолчанию: если tenant_id не установлен — запрос отклоняется. Это удобно реализовать через middleware (веб) и через базовый класс/декоратор (фоновые воркеры). На уровне ORM добавьте глобальный фильтр по tenant_id и запретите «сырые» запросы в обход репозиториев без явного разрешения.

Разделение конфигурации по арендаторам

Храните настройки по арендаторам отдельно от бизнес‑данных: планы, лимиты, включенные фичи, интеграции, ключи. Хорошая практика — единый Config Service/таблица с версионированием и кэшем, чтобы изменения вступали в силу предсказуемо и не влияли на других клиентов.

Тестирование: как ловить кросс-арендные утечки до продакшена

Добавьте авто‑тесты, которые создают два арендатора и прогоняют одинаковые сценарии: чтение, поиск, экспорт, фоновые задачи. Полезны property‑based тесты (случайные данные) и негативные проверки: «запрос без tenant_id должен падать».

В staging включайте аудит: логируйте tenant_id на каждом запросе к данным и поднимайте алерт, если он пустой или неожиданно меняется в рамках одного запроса.

Безопасность данных: RLS, шифрование и управление доступом

Мультиарендность усиливает цену ошибки: одна неверная настройка может открыть данные чужому арендатору. Поэтому безопасность лучше строить слоями: ограничение доступа в самой БД, защита данных «на диске» и «в пути», плюс строгие права для сервисов и прозрачный аудит.

Row-Level Security (RLS): когда помогает и как не ошибиться

RLS (например, в PostgreSQL) полезен, когда арендаторы делят одни и те же таблицы, а фильтрация по tenant_id должна быть гарантирована на уровне базы. Это снижает риск «забыли добавить WHERE» в одном из запросов.

Типичные ошибки:

- Полагаться на переменную с

tenant_id, которую может подменить клиент. Контекст арендатора должен приходить из проверенного источника (токен/сессия), а в БД — устанавливаться сервером. - Оставлять роль с правом

BYPASSRLSили выдавать доступ к таблицам «напрямую». Лучше работать через ограниченные роли и/или представления. - Не покрывать политиками все таблицы, включая справочники, очереди, таблицы связей.

Шифрование данных и управление ключами по арендаторам

Шифрование «на диске» (TDE/шифрование томов) — базовая гигиена, но для сильной изоляции часто добавляют прикладное шифрование чувствительных полей.

Практика, которая хорошо масштабируется:

- Envelope encryption: данные шифруются DEK‑ключом, а DEK шифруется мастер‑ключом в KMS.

- Раздельные ключи по арендаторам для наиболее критичных данных: так проще делать «крипто‑удаление» арендатора и ограничивать ущерб при инциденте.

Секреты и доступы: принцип наименьших привилегий для сервисов

Каждый сервис должен иметь минимально необходимые права: отдельные роли для чтения/записи, запрет админских операций из приложения, временные креденшелы, ротация секретов. Секреты храните в менеджере секретов, а не в переменных окружения в открытом виде.

Аудит доступа и требования к журналированию событий

Журналы должны отвечать на вопросы «кто, что, когда, откуда и для какого арендатора». Минимум: события входа, смена прав, доступ к чувствительным данным, экспорт/удаление, ошибки авторизации и срабатывания политик RLS.

Полезно заранее определить сроки хранения, неизменяемость (WORM/append‑only) и быстрый поиск по tenant_id — это заметно ускоряет расследования и ответы на запросы соответствия.

Масштабирование хранения и запросов

Миграции и откаты без боли

Соберите чек-лист миграций без простоя и сценарии отката с помощью снапшотов.

Когда продукт растёт, мультиарендность быстро упирается не в «как хранить данные», а в «как стабильно выполнять запросы при разной нагрузке арендаторов». Ниже — практичные приёмы, которые помогают держать стоимость и задержки под контролем.

Шардирование по tenant_id: варианты и компромиссы

Самый понятный способ масштабировать хранение — разделять арендаторов по шардам (нескольким БД/кластерам), выбирая шард по tenant_id.

- Хеш‑шардирование равномерно распределяет нагрузку, но усложняет выбор «особых» арендаторов (VIP, тяжёлые отчёты).

- Диапазоны (range) удобны для управляемого размещения (например, крупные клиенты отдельно), но требуют дисциплины при росте.

- Каталоги/таблицы маршрутизации добавляют гибкости: можно переносить арендатора между шардами без смены

tenant_id, но нужно следить за консистентностью маршрутизации.

Компромисс почти всегда один: чем проще распределение, тем сложнее точечная оптимизация под «тяжёлых» клиентов.

Партиционирование и горячие/холодные данные

Внутри шарда помогает партиционирование таблиц: по времени (события, логи, транзакции) и/или по tenant_id. «Горячие» данные держите в быстрых таблицах/индексах, а «холодные» — выносите в архивные партиции с более редким обслуживанием. Это ускоряет типовые запросы и делает дешевле хранение.

Пулы соединений и защита от исчерпания ресурсов

Даже идеальная схема данных не спасёт, если арендаторы «съедят» соединения.

- Используйте пул соединений на уровне приложения и/или прокси.

- Вводите лимиты: максимум соединений/запросов на арендатора, таймауты, ограничение параллелизма для тяжёлых отчётов.

- Планируйте очереди для дорогих операций, чтобы не блокировать интерактивные запросы.

Кеширование и инвалидация: общий кеш vs кеш по арендаторам

Общий кеш эффективнее по объёму, но риски выше: ошибки ключей могут привести к утечкам данных между арендаторами. Кеш «по арендатору» проще и безопаснее (ключи с префиксом tenant_id, отдельные пространства/неймспейсы), но дороже.

Практика: кешируйте «неопасные» общие справочники общим кешем, а всё, что связано с пользовательскими данными, — строго с привязкой к арендатору и с понятной стратегией инвалидации (TTL + событие обновления).

Noisy neighbor: как удерживать качество сервиса для всех

Multi-tenant даёт экономию и скорость развития, но приносит классическую проблему noisy neighbor: один арендатор (или отдельный «тяжёлый» сценарий) начинает потреблять непропорционально много ресурсов и ухудшает опыт остальных. Важно не только «поймать» соседа, но и сделать так, чтобы система предсказуемо держала качество сервиса.

Признаки и типовые причины noisy neighbor

Обычно это выглядит как внезапные пики времени ответа, рост ошибок 5xx, «провалы» фоновых задач и очередей, а также деградация только части клиентов (например, в одном регионе или на одном шарде).

Частые причины:

- Тяжёлые запросы (полные сканы таблиц, неудачные индексы, отчёты «за всё время»).

- Массовые импорты/экспорты, бэкапы, генерация документов.

- Неограниченные фоновые задания (пересчёты, рассылки) без троттлинга.

- Пиковые нагрузки у одного арендатора (кампания, интеграция, батч‑процессы).

Лимиты и квоты: ставим «перила»

Практика №1 — заранее ввести измеримые квоты и обеспечить их техническое исполнение, а не только прописать в договоре. Типичные лимиты:

- CPU и память на воркеры/поды (контейнерные limits/requests).

- I/O к базе и хранилищам (лимиты на соединения, пул, частоту запросов).

- Ограничение запросов: rate limiting на API, лимиты на «дорогие» эндпойнты.

- Фоновые задачи: ограничение параллелизма и скорости обработки по арендатору.

Важный нюанс: лимиты должны быть привязаны к tenant_id (или другому признаку арендатора), иначе вы ограничите «всех сразу», а не источник проблемы.

Очереди и приоритезация по планам/тарифам

Фоновые работы лучше организовывать через очереди с управлением справедливостью:

- Отдельные очереди по планам (например, Free/Pro/Enterprise) или веса в одной очереди.

- Round‑robin/weighted fair scheduling по арендаторам, чтобы один клиент не «съедал» весь конвейер.

- Отдельные worker‑пулы под критичные задачи (оплата, авторизация) и под «тяжёлые» (отчёты, экспорт).

Так вы сохраняете предсказуемость: премиальные клиенты получают приоритет, а бесплатные — не ломают общий SLA.

Деградация по плану: что отключать первым при перегрузке

Когда перегрузка уже случилась, нужен заранее продуманный план деградации (graceful degradation). Обычно первыми отключают или ограничивают:

-

Необязательные фоновые функции: пересчёты, превью, рекомендации.

-

Тяжёлые пользовательские операции: экспорт, сложные отчёты, массовые действия.

-

Менее важные интеграции и вебхуки (с буферизацией в очередь), чтобы не терять события.

Ключевой принцип: сохраняйте «ядро» продукта (вход, основные CRUD‑операции, платежи), а всё остальное переводите в режим ограничений — лучше немного медленнее и предсказуемо, чем нестабильно для всех.

Онбординг, миграции и управление жизненным циклом арендатора

Жизненный цикл арендатора — это не только «создали аккаунт и пошли работать». Это цепочка повторяемых операций: подготовка хранилища, выдача доступов, настройка лимитов, обновления схем и корректное удаление. Чем меньше ручных шагов, тем ниже риск ошибок и утечек.

Автоматизация онбординга арендатора

Хорошая практика — оформлять онбординг как детерминированный workflow (с логированием и возможностью повторного запуска). Обычно он включает:

- создание записи арендатора и первичного пользователя;

- подготовку изоляции хранения: создание схемы/БД (если выбран такой паттерн), дефолтных ролей и политик;

- генерацию и привязку ключей (API‑ключи, ключи шифрования, секреты интеграций) с ротацией по расписанию;

- выставление квот и начальных настроек (тариф, лимиты, регионы хранения).

Важно иметь идемпотентность: если процесс оборвался на середине, повторный запуск не должен дублировать ресурсы.

Инфраструктура как код (IaC)

IaC делает окружения воспроизводимыми: одно и то же описание создаёт одинаковые ресурсы для всех арендаторов. Это упрощает проверки изменений (code review), откаты и аудит.

Практически полезно разделять «общую» инфраструктуру и «per‑tenant» сущности, чтобы изменения не затрагивали всех сразу.

Миграции и откаты

Выберите стратегию версионирования схем (например, миграции по порядку с фиксированными версиями). Продумайте, как миграции применяются:

- синхронно при деплое (жёстко, но просто);

- асинхронно в фоне (меньше риск простоев, но нужна координация версий приложения и схемы).

Откат — это не только «вниз» по миграциям: часто безопаснее делать forward‑fix (новая миграция, исправляющая проблему), особенно при преобразовании данных.

Удаление арендатора без «хвостов»

Деактивация должна запускать гарантированную очистку: данные, индексы/схемы/БД, ключи и секреты, фоновые задачи, файлы в хранилищах и сетевые правила.

Полезно иметь чек‑лист «сборщика» (garbage collector) и отчёт об удалении, чтобы подтвердить, что ресурсы действительно освобождены.

Наблюдаемость и эксплуатация в мультиарендности

Наблюдаемость по арендаторам

Добавьте метрики и логи по tenant_id, чтобы быстрее находить локальные деградации.

Мультиарендность усложняет эксплуатацию: один и тот же инцидент может затронуть всех, а может «болеть» только у одного арендатора. Поэтому наблюдаемость здесь должна быть не просто «по сервисам», а ещё и «по арендаторам», чтобы быстро отвечать на вопросы: кого затронуло, почему и сколько это стоило.

Метрики и логи «по арендаторам»: что собирать в первую очередь

Начните с минимального набора, который даёт управляемость:

- латентность (p50/p95/p99) и ошибки (4xx/5xx) в разрезе

tenant_id; - throughput (запросы/сек) и тяжёлые эндпоинты по

tenant_id; - потребление ресурсов: CPU/память/подключения к БД, очередь, кеш — с разметкой по арендаторам, если возможно;

- «стоимость» запросов: время в БД, количество строк/байт, hits/misses кеша.

В логах держите единый формат событий и обязательно добавляйте tenant_id, environment, версию приложения, а также причину отказа (например, quota_exceeded vs validation_error).

Трассировка запросов с tenant_id и корреляционными идентификаторами

Распределённая трассировка полезна только если можно связать фронт, API, фоновые задачи и БД в одну цепочку. Пробрасывайте correlation_id (или trace_id) во все сервисы, а tenant_id — как атрибут спана. Тогда расследование noisy neighbor превращается из догадок в измерения: где именно возник «затор» и на каком шаге.

SLO и алерты: общие и per-tenant

Делайте два уровня контроля:

- общие SLO на весь сервис (чтобы не пропустить системную деградацию);

- per‑tenant SLO/алерты для ключевых клиентов и для обнаружения локальных проблем (например, рост p99 только у одного арендатора из‑за специфических данных или нагрузки).

Важно не утонуть в алертах: используйте бюджет ошибок и пороги по трендам, а не по единичным всплескам.

Отчётность по использованию: основа для биллинга и квот

С самого начала считайте потребление «единиц» (запросы, активные пользователи, объём хранения, фоновые задачи, egress). Эти отчёты нужны не только для счёта, но и для квот, ограничений и честного управления ресурсами.

Если у вас есть страница /billing, данные для неё должны рождаться из тех же метрик, что и для эксплуатации — так меньше расхождений и спорных ситуаций.

Как ИИ помогает проектировать архитектуры для изоляции и масштаба

ИИ в архитектуре мультиарендного SaaS полезен не как «автопилот», а как ускоритель мышления: он помогает быстро перебрать варианты, зафиксировать решения и снизить риск пропусков в безопасности и эксплуатации.

Где ИИ полезен

Во‑первых, для генерации нескольких архитектурных опций под конкретные ограничения: бюджет на инфраструктуру, требования к изоляции (общая БД vs отдельные схемы/БД), география и регионы, требования по восстановлению.

Хорошая практика — задавать ИИ «рамки» (например, «PostgreSQL + RLS, 2 региона, SLO 99.9%, отдельные ключи шифрования на арендатора») и просить сравнение с явными компромиссами по стоимости, сложности миграций и рискам noisy neighbor.

Автосборка артефактов

ИИ отлично справляется с рутиной: черновики диаграмм (контекст арендатора, потоки данных), чек‑листы онбординга, наброски IaC и политик доступа, шаблоны runbook’ов для инцидентов.

Важно воспринимать это как «первую версию», которую команда доводит до стандарта. Полезно хранить итоговые артефакты рядом с репозиторием и обновлять их через ревью (например, в /docs/architecture).

Практичный пример: прототипирование multi-tenant в TakProsto.AI

Когда нужно быстро проверить гипотезу по мультиарендности (например, выбрать между tenant_id в общих таблицах и отдельными схемами), удобно начинать с прототипа, который можно итеративно менять без тяжёлого «ручного» программирования. В TakProsto.AI это можно сделать в формате чата: описать требования к изоляции, лимитам и онбордингу — и получить каркас веб‑приложения (React), бэкенда (Go) и PostgreSQL‑модели.

Дальше полезны режим планирования (чтобы зафиксировать решения и компромиссы), снапшоты с откатом (чтобы безопасно пробовать миграции/изменения RLS) и экспорт исходников — когда прототип созрел и его нужно забрать в привычный пайплайн. Отдельный плюс для B2B‑сценариев в РФ — данные и окружения размещаются на серверах в России и не требуют передачи данных за рубеж.

Проверка рисков и спорных мест

Попросите ИИ составить список угроз и точек отказа: утечки между арендаторами, ошибки в RLS, неожиданные пути обхода авторизации, слабые места миграций схем, проблемы с бэкапами/восстановлением на уровне арендатора. Это помогает сформировать план тестов и «красные флаги» для ревью.

Ограничения и контроль

Чтобы ИИ не навредил, нужны правила: утверждённые шаблоны, запрет на небезопасные паттерны, обязательное ревью человеком, автоматические тесты (включая негативные на изоляцию), валидация IaC и политик доступа перед деплоем.

ИИ ускоряет работу, но ответственность за архитектурные решения остаётся у команды.