10 июн. 2025 г.·8 мин

Почему документные базы популярны при смене моделей данных

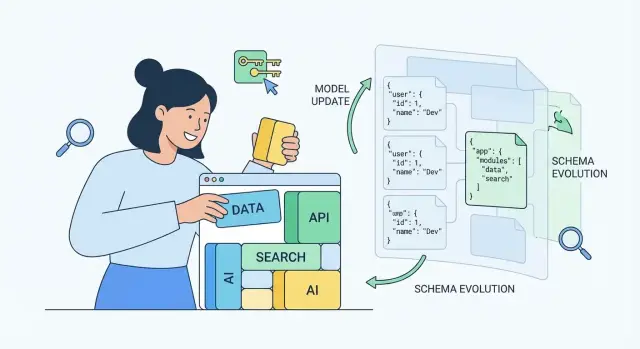

Разберём, почему документные базы данных удобны при частых изменениях модели: гибкая схема, быстрые итерации, но и риски — валидация, запросы и миграции.

Что такое «быстро меняющаяся модель данных»

«Быстро меняющаяся модель данных» — это ситуация, когда структура сущностей и набор полей в продукте заметно меняются от релиза к релизу. Не «раз в год добавили колонку», а регулярные корректировки: сегодня у заказа есть один набор атрибутов, через месяц появляется новый тип доставки, затем — несколько вариантов оплаты, промокоды, статусы, дополнительные сведения для поддержки.

Как это выглядит на практике

Обычно изменения идут небольшими порциями, но постоянно:

- появляются новые поля (например,

delivery.instructions,customer.segment,experimentVariant); - меняется формат старых полей (строка → объект, одно значение → массив);

- вводятся новые типы документов или подтипы (например, «заказ» для B2C и B2B);

- часть данных становится необязательной, потому что зависит от сценария.

Важно, что в реальных системах данные редко обновляются «одним махом»: в базе одновременно живут документы разных «поколений», потому что старые записи ещё не мигрировали, а новые уже пишутся по обновлённым правилам.

Почему модель начинает часто эволюционировать

На практике это почти всегда следствие темпа продукта:

- новые фичи и упаковка продукта под разные рынки;

- A/B‑эксперименты и быстрые проверки гипотез;

- интеграции с партнёрами (у каждого свой набор обязательных атрибутов);

- юридические и бухгалтерские требования, которые меняются внезапно.

Строгая схема в таких условиях иногда тормозит итерации: любое изменение требует синхронной правки схемы, миграции, обновления всех сервисов и отчётности — и всё это нужно аккуратно раскатывать.

При этом цель — не «свобода любой ценой». Даже при гибкости важно не потерять управляемость: понимать, какие поля обязательны, как валидировать входные данные и как отслеживать версии структуры, чтобы качество данных не деградировало.

Коротко о документных базах данных

Документные базы данных хранят информацию не в виде таблиц и строк, а как документы — самостоятельные записи, близкие к тому, как данные выглядят в приложении. Чаще всего это JSON (или близкий по смыслу BSON), где внутри одного документа можно держать и простые поля, и вложенные структуры.

Документ как единица хранения

Один документ обычно описывает «целый объект»: пользователя, заказ, карточку товара, событие. Внутри можно хранить вложенные массивы и объекты — например, адреса, позиции заказа, настройки уведомлений. За счёт этого многие данные читаются и записываются «одним куском», без необходимости собирать их из нескольких таблиц.

«Схема по договорённости»

Во многих документных БД схема не фиксируется жёстко на уровне базы: разные документы в одной коллекции могут иметь разные наборы полей.

Это не означает «полный хаос». Просто контроль того, какие поля допустимы и как они выглядят, часто задаётся договорённостью: через код приложения, правила валидации, контракты между сервисами и постепенную эволюцию формата документов.

Коллекции и документы вместо таблиц и строк

Если говорить упрощённо, вместо «таблица → строки» используется подход «коллекция → документы». Коллекция — это группа однотипных документов (например, users или orders), а документ — конкретная запись с уникальным идентификатором.

Примеры популярных решений

К распространённым документным базам относят MongoDB, CouchDB и облачные решения вроде Firestore. Они отличаются деталями (способом репликации, моделью запросов, режимами работы), но общий принцип остаётся один: данные хранятся как документы с гибкой структурой.

Почему документные базы популярны при частых изменениях

Когда продукт активно развивается, модель данных меняется вместе с интерфейсом, логикой, интеграциями и аналитикой. Документные базы данных ценят за то, что они позволяют переживать такие изменения с меньшим количеством «болевых» операций.

Добавление новых полей без сложных миграций

В документной модели новое поле обычно можно просто начать записывать в новые документы. Старые записи при этом остаются валидными: приложение может подставлять значения по умолчанию или вычислять их на лету. Это снижает потребность в крупных миграциях схемы «в одно окно» и уменьшает риск остановки продукта из‑за изменения структуры.

Хранение разных версий объекта рядом

При эволюции модели данных нередко приходится поддерживать несколько форматов одной сущности: например, «профиль пользователя v1» и «v2». В документной базе реально хранить эти версии параллельно (через поле schemaVersion или по структуре), а в коде обрабатывать их условно. Такой подход удобен при постепенных релизах, когда часть трафика уже на новой логике, а часть — ещё на старой.

Быстрое прототипирование и A/B‑эксперименты

Для прототипов и экспериментов важно быстро добавлять параметры и собирать метрики, не тратя недели на согласование и перестройку таблиц. Документы позволяют добавлять экспериментальные поля, не ломая существующие данные, и так же быстро их убрать, если гипотеза не подтвердилась.

Полуструктурированные данные без «выравнивания»

Многие реальные данные не идеально табличные: события, настройки, ответы внешних API, атрибуты товаров, пользовательские свойства. Документные базы позволяют хранить такие полуструктурированные поля естественно — без множества вспомогательных таблиц и сложной сборки обратно в объект.

Документы хорошо совпадают с объектной моделью приложения

Документная база «ложится» на то, как большинство приложений уже думают о данных: как об объектах или агрегатах, которые удобно получать и сохранять целиком. Вместо того чтобы раскладывать сущность по множеству таблиц, вы храните один JSON‑документ, в котором рядом лежат основные поля и связанные подструктуры.

Модель «объект целиком» и агрегаты рядом

Во многих доменах есть естественные агрегаты: заказ со списком позиций, профиль пользователя с настройками, карточка товара с вариантами. Когда эти части почти всегда читаются вместе, хранение «рядом» упрощает жизнь: меньше точек синхронизации, проще понимать структуру данных, меньше риск забыть обновить «второстепенную» таблицу.

Меньше джоинов — больше чтения одним запросом

Документная модель особенно выгодна для сценариев «прочитать и показать»: API получает один документ и сразу отдаёт его фронтенду. Это снижает количество запросов и сложность сборки ответа на стороне сервиса.

Важно не переусердствовать: если подчасть объекта обновляется и читается отдельно (например, комментарии к посту), хранить её внутри большого документа может быть неудобно из‑за частых перезаписей и конфликтов.

Естественное соответствие API и фронтенду

Большинство API уже используют JSON. Когда хранилище тоже оперирует JSON‑документами, исчезает лишний слой преобразований «таблицы → объекты → JSON». Это ускоряет разработку и снижает вероятность ошибок на стыках.

Когда вложенность помогает, а когда мешает

Вложенность помогает, когда данные имеют общий жизненный цикл и нужны вместе. Она мешает, когда подданные растут без ограничений (например, бесконечный список событий), требуют отдельных прав доступа или должны эффективно фильтроваться и сортироваться независимо от «родителя».

Проектирование модели: вложенность, ссылки и денормализация

Документная база даёт свободу в структуре, но хорошая модель всё равно нужна. Иначе «гибкая схема данных» быстро превращается в набор разрозненных JSON‑документов, которые сложно искать, обновлять и поддерживать.

Встроенные документы vs связи через идентификаторы

Вложенность удобна, когда данные живут вместе и почти всегда читаются одним запросом: например, заказ и его позиции. Один документ — меньше запросов, проще выдача API.

Ссылки по идентификаторам полезны, когда часть данных используется многими объектами (например, профиль пользователя, справочники, общие настройки) или часто меняется отдельно. Тогда вы храните userId/productId и подтягиваете детали при необходимости.

Как выбирать границы документа: правило «что читаем вместе»

Практичное правило: кладите в один документ то, что приложение обычно читает вместе и показывает в одном экране/ответе. Если для типового сценария вам всегда нужен «родитель + дети», вложенность снижает задержку и упрощает индексацию под конкретный запрос.

Если же сущность нужна в разных контекстах, имеет самостоятельный жизненный цикл или редактируется отдельно, лучше отделять и связывать через идентификаторы.

Денормализация: ускорение чтения ценой обновлений

Денормализация — это осознанное дублирование полей ради быстрых чтений: например, сохранить в документе заказа customerName, чтобы не делать дополнительный запрос к клиенту.

Плата за это — обновления. При смене имени клиента нужно обновить много документов (массово или постепенно), иначе появится рассинхронизация.

Опасности: дублирование, рассинхронизация, рост размера документов

Главные риски:

- Дублирование усложняет поддержку и повышает шанс ошибок.

- Рассинхронизация требует стратегии: фоновые задачи, версионирование данных, периодическая «починка».

- Рост документа может ухудшить производительность и привести к превышению лимитов размера.

Хорошая модель в документной базе — это компромисс между скоростью чтения, частотой изменений и тем, насколько критична согласованность данных.

Запросы и индексация при изменяющихся полях

Контракты данных под контролем

Зафиксируйте контракты, обязательные поля и версии, чтобы данные не расползались.

Когда поля в документах появляются, переименовываются или уходят в архив, запросы становятся главным источником сюрпризов. Хорошая новость: в документных БД можно эволюционировать схему, не переписывая всё хранилище. Плохая — если не следить за индексами и шаблонами запросов, вы быстро упрётесь в полные сканы коллекций.

Какие индексы нужны при «плавающих» полях

Обычно начинают с индексов по отдельным полям (например, status, createdAt, tenantId). Но при росте продукта почти всегда нужны:

- Составные индексы под типичные фильтры вида «клиент + статус + дата». Они помогают не только фильтровать, но и сортировать без дополнительной работы.

- Индексы по вложенным атрибутам (например,

profile.cityилиitems.sku). Это особенно важно, если вы активно используете вложенность, а не ссылки.

Практика: держите список «официальных» полей, которые индексируются и поддерживаются долго. Новые экспериментальные поля сначала живут без индекса — пока не появится доказанная потребность в запросах.

Фильтрация и сортировка без полных сканов

Частая ошибка — фильтровать по одному полю, а сортировать по другому, не имея индекса, который поддерживает оба требования. Итог: база находит много кандидатов и долго сортирует в памяти.

Правило: если запрос часто выглядит как «filter + sort», проектируйте индекс так, чтобы он покрывал оба шага. И отдельно следите за запросами по «редким» полям: они соблазнительны, но часто приводят к сканам, особенно если поле есть не во всех документах.

Шаблоны запросов, которые стоит продумать заранее

Чтобы изменения модели не ломали производительность, заранее определите 5–10 ключевых паттернов:

- поиск сущности по идентификатору и

tenantId; - выборка списка по статусу и времени (пагинация);

- поиск по вложенному атрибуту (например, элементы заказа);

- «последние N событий» по пользователю.

Под эти паттерны легче поддерживать индексы и тестировать регрессии при добавлении новых полей.

Ограничения: аналитика и «многотабличность»

Документные БД хорошо решают OLTP‑запросы, но сложная аналитика, большие агрегации по множеству сущностей и богатые связи «многие‑ко‑многим» часто требуют либо отдельного аналитического хранилища, либо более реляционного подхода. Это лучше признать заранее, чтобы не пытаться «втиснуть» BI‑нагрузку в оперативную базу.

Как удержать порядок: валидация и контроль схемы

Гибкая схема в документных базах данных не означает «как получится». Если не договориться о правилах, через несколько релизов вы получаете коллекцию, где одно и то же поле то строка, то массив, а часть документов вообще без ключевых атрибутов. Лечится это не усложнением хранилища, а дисциплиной вокруг данных.

Проверка на уровне приложения: DTO, схемы, типизация

Самая практичная линия обороны — валидация до записи. Опишите DTO/контракты (например, схемы для входных команд и событий) и проверяйте:

- типы и форматы (дата, email, валюты, UUID);

- обязательные поля и допустимые значения;

- запрет «пустышек» ("", null, пустые массивы там, где они бессмысленны).

Плюс: вы ловите ошибки ближе к источнику, в логике сервиса. Минус: если пишут несколько сервисов, правила должны быть синхронизированы (общая библиотека схем или единый контракт в репозитории).

Валидация на уровне базы (если СУБД поддерживает)

Если выбранная СУБД умеет валидировать JSON‑документы, включайте это как страховку от «обходных путей»: прямых записей, скриптов, багов в старых версиях сервиса. Обычно хватает базовых ограничений: наличие ключей, типы полей, диапазоны, паттерны строк.

Версионирование документов: schemaVersion и правила чтения

Добавьте в документ поле schemaVersion и договоритесь: новые сервисы пишут только актуальную версию, а чтение поддерживает несколько версий. Часто эффективнее «исправлять при чтении» (read-repair): если документ старый — аккуратно привести к новому виду и сохранить обратно.

Мониторинг качества: обязательные поля и аномалии

Контроль схемы — это ещё и наблюдаемость. Настройте регулярные проверки: доля документов без обязательных полей, всплески null/пустых значений, неожиданные типы, рост количества версий. Эти метрики быстро показывают, где процесс эволюции модели данных начал расползаться.

Миграции данных без остановки продукта

Когда модель данных меняется часто, «большая миграция в выходные» быстро превращается в риск. В документных БД обычно выбирают эволюционный путь: продукт продолжает работать, а данные постепенно приводятся к новой форме.

«Read old, write new»: совместимость версий

Самый практичный приём — читать документы в старых форматах, но записывать только в новом.

Приложение при чтении распознаёт версию (например, по schemaVersion) и умеет интерпретировать несколько вариантов. При записи и обновлениях документ нормализуется и сохраняется уже в новом формате. Так вы получаете автоматическую «миграцию по мере касания» без отдельного окна простоя.

Фоновые миграции партиями и безопасные откаты

Чтобы ускорить переход, запускают фоновый джоб, который проходит коллекцию батчами: выбирает ограниченное число документов, преобразует, сохраняет, фиксирует прогресс (чекпойнт). Важно ограничивать нагрузку: лимиты по QPS, паузы, работа вне пиков.

Откаты проще, если миграция идемпотентна и обратима: храните предыдущие значения критичных полей, ведите журнал изменений или применяйте «двойную запись» на время перехода.

«Грязные» данные и единые правила преобразований

Реальность: пропуски полей, неожиданные типы, устаревшие значения. Договоритесь об одном месте, где живут правила трансформаций (библиотека/сервис), и одинаково используйте их в API, фоновых задачах и админских скриптах. Ошибочные документы лучше помечать и складывать в отдельную очередь на разбор.

Когда всё же лучше сделать явную миграцию

Явная миграция оправдана, если меняются ключи индексов/шардирования, требуется жёсткая консистентность «в один момент», или старый формат нельзя безопасно поддерживать в коде (например, из‑за требований комплаенса). Тогда планируйте миграцию как релиз: измерения, обратный план и чёткое окно работ.

Консистентность и транзакции: чего ожидать

Быстрый деплой и хостинг

Разверните приложение и подключите свой домен, когда прототип готов к пользователям.

Документные базы часто выбирают за гибкость, но важно заранее понять, какие гарантии целостности вы реально получаете — особенно когда данные «размазаны» по нескольким документам.

Одиночный документ и атомарность

Обычно главный плюс — атомарность на уровне одного документа. Это значит: обновление полей внутри одного JSON‑документа происходит целиком, без «половинчатых» состояний. Поэтому критичные взаимосвязанные данные часто стараются держать в одном документе (например, заказ и его позиции), чтобы меньше зависеть от распределённых гарантий.

Транзакции и их стоимость (если поддерживаются)

Многие современные документные СУБД поддерживают транзакции на несколько документов, но это почти всегда дороже:

- больше сетевых раунд‑трипов и блокировок;

- выше задержки (latency) и ниже пропускная способность;

- сложнее масштабировать «горячие» участки.

Практический вывод: транзакции используют точечно для действительно важных операций, а не «по умолчанию» на каждую запись.

Согласованность между документами: паттерны и компромиссы

Когда нужно согласовать несколько документов, часто выбирают компромисс «в итоге согласовано» (eventual consistency). Типовые приёмы:

- Денормализация: хранить копию нужных данных рядом, принимая риск рассинхронизации.

- Саги/оркестрация: цепочка шагов с компенсациями при ошибках.

- Outbox‑паттерн: запись события рядом с изменением, затем надёжная доставка в очередь.

Идемпотентность операций и обработка повторов

В распределённых системах повторы неизбежны (ретраи, таймауты). Делайте операции идемпотентными: используйте уникальные ключи запросов, версионирование (optimistic locking) и обработку «повторного» события без повторного эффекта. Это снижает зависимость от тяжёлых транзакций и упрощает жизнь при сбоях.

Производительность и масштабирование: типичные узкие места

Документные базы часто дают быстрый старт, но при росте нагрузки проявляются характерные проблемы: часть связана с форматом хранения, часть — с тем, как приложение обновляет данные.

Размер документа и рост вложенных массивов

Частый сценарий — документ «обрастает» историей событий, комментариями, логами, вложенными списками. Вначале это удобно (всё в одном месте), но затем:

- увеличивается время чтения/записи: каждый апдейт может затрагивать большой объём данных;

- растут расходы на сеть и память (документ чаще «ездит» целиком);

- появляются лимиты на максимальный размер документа или практические лимиты по времени ответа.

Профилактика: ограничивать рост массивов (архивировать «хвост», выносить историю в отдельную коллекцию), хранить тяжёлые вложения отдельно и подтягивать по необходимости.

«Горячие» документы и конкуренция за запись

Если много пользователей или процессов постоянно пишут в один и тот же документ (например, общий счётчик, «последнее состояние», корзина с высокой частотой обновлений), начинаются конфликты и ожидания блокировок/повторов. На практике это выражается в скачках латентности и непредсказуемой пропускной способности.

Подходы: распределять записи по нескольким документам (шарды на уровне данных), использовать идемпотентные операции, по возможности переводить частые инкременты в поток событий/очередь.

Шардирование/партиционирование: влияние выбора ключа

Масштабирование «вширь» почти всегда упирается в выбор ключа шардирования (партиции). Плохой ключ создаёт перекос: один узел перегружен, остальные простаивают. Особо опасны монотонные значения (временная метка) или «популярные» идентификаторы.

Хороший ключ равномерно распределяет нагрузку и соответствует типичным запросам (чтобы не собирать ответ со всех узлов).

Кэширование и материализованные представления (когда нужно)

Когда чтений много, а запросы сложные или требуют агрегирования, помогает кэш на уровне приложения или материализованные представления (предрасчитанные документы/сводки). Их стоит вводить, если нагрузка стабильно упирается в CPU/диск, а данные допускают небольшую задержку обновления. Важно заранее продумать пересчёт и инвалидирование таких «срезов», чтобы они не стали новым узким местом.

Когда документная база — не лучший выбор

Документные базы данных ценят за гибкую схему данных и удобство работы с JSON‑документами, но есть классы задач, где цена этой гибкости становится слишком высокой.

Сложные отчёты, BI и множество связей между сущностями

Если вам регулярно нужны «табличные» отчёты, витрины для BI, сводные по десяткам измерений и активные джойны между сущностями (клиенты → заказы → товары → поставщики), реляционная модель часто оказывается проще. В документной базе такие запросы нередко превращаются в тяжёлые агрегации, которые труднее оптимизировать и поддерживать по мере эволюции модели данных.

Жёсткие требования к целостности и сложные ограничения

Когда бизнес‑правила опираются на строгую целостность (уникальность по сложному составному ключу, запреты на «висящие» ссылки, каскадные ограничения, проверяемые на уровне базы), реляционные СУБД обычно дают больше «из коробки». В документных хранилищах часть ограничений придётся переносить в приложение, усложняя программирование, тестирование и расследование инцидентов.

Сценарии, где реляционная модель проще и безопаснее

Если данные стабильны, структура редко меняется, а команда уверенно владеет SQL, то внедрение документной базы ради самой гибкости может не окупиться. Особенно в системах учёта, финансовых контуров, складских остатков — там понятные таблицы и связи часто безопаснее и прозрачнее.

Гибридный подход: разные хранилища для разных задач

Компромиссный вариант — использовать документную базу для быстро меняющихся «операционных» данных и отдельное хранилище для аналитики/отчётности (например, реляционную БД или DWH). Такой подход снижает нагрузку на одну систему и позволяет выбирать инструменты под задачу, а не наоборот.

Отдельный практичный вариант гибрида — хранить часть полуструктурированных данных в реляционной базе как JSON (например, в PostgreSQL через JSONB), оставляя транзакционную «ось» в таблицах. Это иногда даёт баланс между гибкостью и строгими ограничениями.

Типовые сценарии использования

Спланируйте эволюцию схемы

Опишите версии документов и миграции в planning mode, затем соберите каркас приложения.

Документные базы данных особенно удобны там, где структура сущностей «плавает»: поля появляются, исчезают, становятся вложенными, а разные записи одного типа реально отличаются друг от друга.

Быстро растущий продукт: каталог, профили, настройки

В каталогах товаров атрибуты зависят от категории: у кроссовок важен размер и материал, у ноутбуков — диагональ и процессор. В документной модели можно хранить базовые поля (id, цена, наличие) и произвольный набор характеристик в JSON‑документе без постоянных изменений таблиц.

Профили пользователей и настройки — похожая история: эксперименты, A/B‑тесты, новые предпочтения, флаги функций. Документы позволяют добавлять новые параметры постепенно, не ломая старые записи.

События и логи с изменяющимися полями

Событийные данные редко бывают стабильными: сегодня вы пишете utm_*, завтра — новые параметры кампаний, послезавтра — поля для антифрода. В документной базе можно хранить события разных типов в одной коллекции, а новые поля просто начнут появляться в новых документах.

Контент и CMS‑подобные структуры

Страницы, блоки, виджеты, карточки контента часто имеют вложенную структуру и вариативные наборы полей. Документы хорошо отражают «дерево» контента: секции, элементы, настройки отображения, локализации.

Интеграции с внешними API и «разные форматы входа»

Когда данные приходят из нескольких источников (партнёры, маркетплейсы, платежные провайдеры), форматы могут отличаться. Практичный паттерн: хранить «сырое» входящее payload‑поле целиком + нормализованную часть для ключевых сценариев. Так вы не теряете детали и не переписываете модель при каждом изменении API.

Чек‑лист выбора и внедрения для команды

Документная база выигрывает, когда модель данных часто меняется, но это работает только при дисциплине команды. Ниже — практичный список, который помогает принять решение и внедрить хранилище без сюрпризов.

1) Сначала — запросы, потом документы

Соберите топ реальных сценариев чтения/поиска и ранжируйте их:

- какие запросы важнее всего: поиск по нескольким полям, выборка по времени, фильтры по статусам, агрегации, сортировки;

- какие SLA: задержки, частота запросов, объём данных, пиковые нагрузки.

Если критичны сложные join’ы и отчётность «как в SQL», фиксируйте это заранее: возможно, документная модель потребует денормализации или отдельного аналитического контура.

2) Договорённости по полям и версиям

Определите правила именования и обязательные метаданные документа:

- единый стиль ключей (camelCase/snake_case), запрет «почти одинаковых» полей;

- поле версии схемы (например,

schemaVersion) и дата обновления; - политика удаления/переименования: только через деприкацию и переходный период.

3) Индексы: минимум и постоянный контроль

Зафиксируйте минимальный набор индексов под ключевые запросы и включите мониторинг медленных операций.

Проверяйте план выполнения запросов после каждого изменения модели и перед релизом: индексы должны соответствовать реальным фильтрам и сортировкам, а не появляться «на всякий случай».

4) План миграций и тесты совместимости

Составьте план эволюции: «двойная запись», ленивая миграция, фоновые джобы, критерии завершения и отката.

Обязательны тесты совместимости до релиза: новые сервисы читают старые документы, старые сервисы не падают от новых полей. Это дешевле, чем чинить прод после изменения схемы.

Как TakProsto.AI помогает быстрее проходить изменения модели

Быстро меняющаяся модель данных почти всегда означает не только выбор СУБД, но и нагрузку на процесс разработки: нужно успевать обновлять DTO/контракты, обработчики версий, миграционные джобы и индексы — и при этом не ломать продукт.

В таких сценариях полезен подход, где инфраструктура и каркас приложения собираются быстрее, а изменения можно безопасно откатывать. TakProsto.AI — это vibe‑coding платформа для российского рынка, которая позволяет создавать веб‑, серверные и мобильные приложения через чат: вы формулируете требования, а платформа помогает собрать решение (фронтенд на React, бэкенд на Go, база PostgreSQL) и поддерживать быстрые итерации.

Практически это удобно именно при эволюции данных: в режиме planning mode можно заранее проговорить, какие версии схемы будут поддерживаться, какие индексы нужны под ключевые запросы, как будет выглядеть стратегия «read old, write new». А за счёт snapshots и rollback проще экспериментировать с изменениями и возвращаться к стабильному состоянию, если новая версия модели неожиданно ухудшила производительность или совместимость. Для команд, которым важно держать данные в России, дополнительно значимо, что TakProsto.AI работает на российских серверах и использует локализованные модели.