06 авг. 2025 г.·8 мин

Почему eventual consistency подходит многим приложениям

Разбираем, когда eventual consistency подходит: какие риски и выгоды, примеры сценариев, способы работы с конфликтами и как выбрать модель консистентности.

Что такое eventual consistency и почему это не «баг»

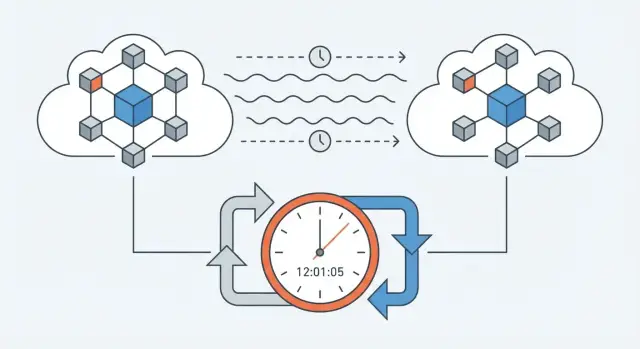

Eventual consistency («согласованность со временем») — это модель консистентности данных в распределённых системах, где изменения не обязаны быть видны всем мгновенно. Если данные реплицируются между несколькими узлами, то после записи разные копии могут какое‑то время расходиться, но при отсутствии новых обновлений они сойдутся к одному состоянию.

Ключевой момент: это не про «данные потерялись», а про то, что распространение изменений занимает время — из‑за сети, очередей, кэшей, географии дата‑центров или offline-first сценариев.

Чем это отличается от сильной консистентности

При сильной консистентности ожидание простое: «я сохранил — значит, все и везде сразу увидели одно и то же». Это удобно для критичных операций, но часто увеличивает задержки и снижает доступность, особенно при сбоях связи.

При eventual consistency ожидание другое: «я сохранил — система приняла изменение, но другим может понадобиться немного времени, чтобы его увидеть». На практике это выглядит как временное «эхо» прошлого: старая сумма на балансе, старый статус заказа, непроснувшийся кэш.

Почему временная рассинхронизация — не всегда ошибка

Такое поведение часто является осознанным компромиссом: ради меньших задержек, лучшего SLA и высокой доступности, когда сеть нестабильна или нагрузка велика. В терминах CAP-теоремы это означает, что система готова терпеть временную неконсистентность, чтобы не «останавливаться» при сетевых проблемах.

При этом «не баг» не значит «можно игнорировать». Eventual consistency требует продуманного дизайна: как показывать пользователю обновления, как объяснять состояние «в обработке», как работать с конфликтами и что мониторить.

Какие вопросы поможет решить эта статья

Дальше разберём, как eventual consistency выглядит на практике (репликация, кэширование, offline-first), где она приемлема, а где опасна, какие есть альтернативы и гибриды, и по каким признакам команде проще выбрать подходящую модель консистентности.

Какие компромиссы заставляют выбирать её в реальности

Eventual consistency редко выбирают «из любви к неточности». Обычно её выбирают потому, что в распределённых системах нельзя одновременно сделать всё идеально: быстро, дёшево, безотказно и при этом всегда показывать одно и то же состояние данных во всех местах.

Распределённость неизбежно создаёт компромиссы

Как только данные живут в нескольких дата-центрах, регионах или хотя бы в нескольких репликах внутри кластера, появляются задержки сети и сбои связи. Если в такой ситуации требовать «всегда точно сейчас», системе часто приходится останавливать операции, ждать подтверждений от всех узлов и ловить таймауты.

Eventual consistency, наоборот, позволяет принять запись локально и разнести изменения дальше, когда связь восстановится.

Что обычно выигрывают: доступность, задержки и устойчивость

- Доступность. При проблемах сети сервис продолжает принимать действия пользователей, а не отвечает ошибкой.

- Низкие задержки. Можно подтверждать операции ближе к пользователю, не гоняя запросы через весь мир.

- Стоимость. Меньше «дорогих» синхронных подтверждений между регионами и ниже требования к межрегиональной связности.

- Устойчивость к сбоям. Сервис переживает частичные отказы (одна реплика или регион недоступны), сохраняя приемлемый SLA.

Что чаще важнее для бизнеса: «всегда точно сейчас» или «всегда работает»

Для многих продуктов критичнее, чтобы пользователь мог совершить действие (положить товар в корзину, отправить сообщение, поставить лайк), чем чтобы все экраны на планете мгновенно увидели результат. Ошибка «не удалось выполнить операцию» почти всегда болезненнее, чем задержка в пару секунд до появления обновления.

Где пользователи терпимы к задержке обновлений

Eventual consistency обычно нормально воспринимается в сценариях, где небольшая рассинхронизация не ломает смысл:

- счётчики просмотров/лайков/подписчиков;

- ленты и рекомендации (контент может «догнаться» позже);

- статусы «онлайн/оффлайн» и «прочитано»;

- кэширование профиля и настроек, когда задержка обновления не ведёт к финансовым потерям.

Итого: мы осознанно платим временной неодинаковостью данных, чтобы получить более живой, доступный и масштабируемый сервис.

CAP-теорема без усложнений: где возникает «плата»

CAP-теорема часто звучит как абстрактный закон, но на практике это напоминание: в распределённой системе вы неизбежно платите чем-то, когда сеть ведёт себя неидеально.

Три буквы человеческим языком

- C (Consistency, консистентность): если вы записали изменение, то любой следующий запрос к любому узлу должен увидеть одно и то же значение (как будто система «единая»).

- A (Availability, доступность): система отвечает на запросы даже тогда, когда часть узлов недоступна.

- P (Partition tolerance, устойчивость к разделению сети): система продолжает работать, даже если сеть разделилась на «островки», которые не могут связаться друг с другом.

Важный нюанс: P — не опция “включить/выключить”. Если у вас больше одного сервера, сеть, маршрутизация, DNS, мобильный интернет и зоны доступности — разделения и потери связи будут случаться. Вопрос не в том, будут ли они, а в том, как система поведёт себя, когда это произойдёт.

Где именно появляется выбор между C и A

Когда возникает сетевое разделение, у системы два понятных варианта:

-

Выбрать консистентность (C): «Если я не могу подтвердить, что все узлы согласны, лучше не отвечать или отвечать ошибкой». Это снижает риск противоречий, но часть пользователей увидит недоступность.

-

Выбрать доступность (A): «Я отвечу прямо сейчас с тем, что знаю локально». Пользователь получает ответ, но в разных местах могут временно существовать разные версии данных. Позже система “сведёт” их — это и приводит к eventual consistency.

Именно в моменты сетевых проблем появляется «плата»: либо ошибка/ожидание, либо временная неодинаковость данных.

Почему «сетевой сбой» — нормальное состояние

Распределённые системы живут в мире, где запросы теряются, пакеты приходят с задержкой, соединения рвутся на секунды, а иногда — на минуты. Это не редкая авария, а повседневная статистика. Поэтому архитектуры, рассчитанные на «всё всегда связано», часто ломаются в самый неудобный момент.

Как CAP связан с UX: ожидания, задержки и повторы

Выбор между C и A напрямую влияет на пользовательский опыт:

- При выборе C UX страдает от ожиданий: «крутится», «повторите позже», «не удалось сохранить». Зато пользователь реже видит противоречия.

- При выборе A UX кажется быстрым: действие принимается сразу. Но нужно честно обработать последствия: возможные повторы действий, «внезапные» обновления после синхронизации и аккуратные статусы вроде «сохранено локально / синхронизируется».

CAP — это не спор теоретиков, а вопрос о том, что именно вы обещаете пользователю: мгновенный отклик или мгновенную точность — и как объясняете задержки и расхождения, когда сеть ведёт себя непредсказуемо.

Как выглядит eventual consistency на практике

Чаще всего eventual consistency ощущается не как «поломка», а как задержка между действием пользователя и тем, как это действие становится видно везде. Вы нажали «Оплатить» — в одном месте статус уже «успешно», а в другом ещё пару секунд (или дольше) висит «в обработке».

Задержка распространения данных: нормальная и измеримая

Данные расходятся из‑за репликации и очередей: запись сначала фиксируется «рядом» с пользователем, а потом доезжает до других копий.

Диапазон задержек в реальности широкий: от миллисекунд (в пределах одного региона) до секунд и десятков секунд (между регионами), а иногда — до минут, если есть нагрузка, ретраи или временная недоступность части системы.

Важно: это не случайность, а ожидаемое поведение. Команда должна понимать, какая задержка типична, а какая уже сигнал проблемы.

«Устаревшие» чтения и повторные запросы

Пользователь может прочитать старое значение, потому что его запрос попал на реплику, которая ещё не успела обновиться. Практически это решают несколькими приёмами:

- Refresh/повторное чтение: интерфейс предлагает обновить данные, а приложение делает повторный запрос через короткий интервал.

- Read repair: система, заметив расхождение между копиями, «подлечивает» отстающую реплику в фоне, чтобы следующий читатель увидел актуальное.

На уровне UX это часто выражается в статусах вроде «Синхронизация…», «Обновляем данные», «Последнее обновление: 12:41».

Дубли и повторная доставка событий (at-least-once)

Во многих очередях и интеграциях действует гарантия доставки at-least-once: событие может прийти повторно. Отсюда берутся:

- дубли уведомлений;

- повторное начисление/списание без идемпотентности;

- «скачущие» статусы, когда одно и то же изменение обрабатывается дважды.

Поэтому обработчики событий делают идемпотентными (например, по уникальному ключу операции), а данные — способными переживать повторы.

Зафиксируйте допуски: сколько «устаревания» приемлемо

Eventual consistency работает хорошо, когда допуски прописаны заранее: «статус заказа может обновляться до 30 секунд», «баланс может отставать до 1 минуты», «поиск обновляется в течение 5 минут». Эти цифры стоит включать в SLA/SLO, документацию и пользовательские ожидания — тогда «задержка» становится частью продукта, а не неожиданностью.

Типовые сценарии, где она обычно приемлема

Eventual consistency хорошо работает там, где небольшая задержка обновления не ломает смысл действия пользователя. В таких задачах важнее доступность и скорость ответа, чем мгновенная «идеальная» синхронизация между всеми копиями данных.

Счётчики и «мягкие» метрики

Лайки, просмотры, счётчики комментариев, агрегированные метрики аналитики обычно допускают расхождение на секунды или даже минуты.

Пользователь ставит лайк — ему важнее увидеть, что действие принято (кнопка изменилась, появилось уведомление), чем то, что глобальный счётчик на всех устройствах вырос строго на 1 прямо сейчас. Внутри системы такие счётчики часто обновляются асинхронно, батчами или через очереди, чтобы выдерживать пики нагрузки.

Ленты, рекомендации, поиск и индексация

Новости, рекомендации и выдача поиска почти всегда собираются из предвычисленных данных: индексов, кэшей, моделей, фичей. Обновление «контента» и обновление «представления» могут происходить с разной скоростью.

Типичная ситуация: вы опубликовали пост, но в ленте друзей он появится через несколько секунд; товар изменил цену, но поиск ещё минуту показывает старую. Если бизнес-правила это допускают, eventual consistency помогает держать сервис быстрым и доступным даже при проблемах в части хранилищ или индексации.

Кэширование и CDN

Фраза «не сразу обновилось» часто связана не с ошибкой, а с кэшами: в приложении, на API-шлюзе, в CDN. Кэш может отдавать вчерашнюю версию страницы/карточки до истечения TTL или пока не пройдёт инвалидирование.

Это нормально для данных, где кратковременная «устарелость» безопасна: описания, изображения, публичные страницы, справочная информация. Для чувствительных полей (например, баланс) кэширование обычно ограничивают или задают строгие правила обхода.

Offline-first и последующая синхронизация

В оффлайн-режиме приложение неизбежно работает с локальной копией данных. Пользователь создаёт заметку, меняет профиль, собирает корзину без сети — а при восстановлении соединения изменения догоняют сервер и другие устройства.

Здесь eventual consistency — осознанный выбор: лучше позволить работать без сети, чем блокировать сценарий. Главное — продумать синхронизацию, конфликты и понятные статусы вроде «Сохранено локально» / «Синхронизируется».

Когда eventual consistency не подходит: красные флаги

Проверьте поведение кэша на практике

Соберите CRUD плюс очередь и проверьте, где кэш дает устаревшие чтения.

Eventual consistency хороша там, где небольшая задержка в «схождении» данных не ломает смысл продукта. Но есть классы задач, где даже кратковременное расхождение превращается в прямые деньги, риски или юридические проблемы.

1) Деньги и списания: баланс, транзакции, двойная оплата

Если пользователь видит баланс «на вчера», это не просто косметика. Самые опасные сценарии — когда система на разных узлах одновременно принимает решения о списании.

Признаки красного флага:

- возможна двойная оплата/двойное списание из‑за повторов, ретраев или параллельных подтверждений;

- «баланс не может быть отрицательным», но временная рассинхронизация это допускает;

- деньги должны быть точными в любой момент, а не «в среднем скоро».

Для таких операций обычно выделяют строго консистентный контур: единый источник истины для проводок, атомарные транзакции, идемпотентные ключи платежей, журналирование и сверки.

2) Уникальность и инварианты: один купон, одно имя пользователя, одно место

Eventual consistency часто ломает ограничения вида «можно ровно один раз». Пока реплики не синхронизировались, две заявки могут пройти одновременно.

Типовые примеры:

- промокод/купон должен быть использован строго один раз;

- имя пользователя или e‑mail должны быть уникальными;

- ограниченный ресурс: «осталось 1 место», «последний билет», «последний товар».

Если бизнес‑правило звучит как инвариант (всегда должно быть истинно), его лучше проверять там, где нет конкурирующих решений: в одном сервисе/шарде, под транзакцией, либо через механизмы бронирования/резерва.

3) Критичные права доступа и безопасность (ACL/роли)

Права — ещё одна зона, где «потом догонит» не подходит. Запоздалое применение отзыва доступа может открыть данные бывшему сотруднику или оставить активной роль администратора.

Красные флаги:

- доступ к персональным данным, финансам, админ‑панелям;

- требования аудита и соответствия (кто и когда получил/потерял право);

- опасность «окна уязвимости» даже в секунды.

4) Что делать, если нужна строгая точность хотя бы для части данных

Компромисс часто гибридный: оставить eventual consistency для второстепенных данных (лента, счётчики, кэш), а критичные операции вынести в «строгий» слой.

Практичные подходы:

- разделить домены: платежи/права/инварианты — строго; остальное — с допуском задержек;

- проверки на записи (а не на чтении): решение принимается в одном месте, с транзакцией;

- резервация вместо мгновенного списания (hold → confirm), чтобы избежать гонок;

- явные статусы: «в обработке», «ожидает подтверждения», чтобы не обещать то, чего ещё нет.

Если вы не можете сформулировать «какая задержка допустима» и «что будет, если данные расходятся», это почти всегда сигнал, что eventual consistency здесь опасна.

Альтернативы и гибридные подходы

Eventual consistency — не единственный вариант. На практике команды часто собирают «микс»: там, где цена ошибки высока, делают строгую консистентность, а в остальных местах допускают асинхронность.

Сильная консистентность: когда оправдана

Сильная консистентность даёт понятную модель: запись видна сразу и везде. Обычно это достигается через транзакции и/или кворумы (например, запись считается успешной только после подтверждения несколькими узлами).

Плюсы:

- проще объяснить бизнесу и тестировать «как в бухгалтерии»;

- меньше неожиданностей при чтении сразу после записи.

Минусы:

- выше задержки (ждём подтверждения);

- ниже доступность при сбоях сети/узлов (операция может не пройти);

- сложнее масштабировать «на весь мир» без потери скорости.

Гибрид: «строго там, где нужно; мягко там, где можно»

Типичный компромисс: строгая консистентность внутри одного агрегата/объекта (например, баланс счёта, статус заказа), но eventual consistency между подсистемами (уведомления, рекомендации, аналитика, поисковый индекс).

На уровне продукта это выглядит так: критичный шаг подтверждается синхронно, а «вторичные эффекты» догоняют позже.

Саги, Event Sourcing и CQRS

Когда «одна большая транзакция» слишком дорогая, используют паттерны:

- Саги: цепочка локальных операций с компенсирующими действиями (например, отменить резерв, если платеж не прошёл).

- Event Sourcing: хранение фактов-событий, из которых восстанавливается состояние. Удобно для аудита и разборов инцидентов, но требует дисциплины в схемах событий.

- CQRS: разделение модели записи и чтения. Запись идёт в «источник истины», чтение — из оптимизированных проекций/кэшей, которые могут обновляться асинхронно.

Доставка сообщений: практический взгляд

Выбор модели доставки влияет на дизайн:

- at-most-once: быстрее, но возможны потери — подходит для неважных событий.

- at-least-once: события не теряются, но возможны дубликаты — значит, нужны идемпотентность и дедупликация.

- exactly-once: красиво в теории, дорого и ограниченно на практике; часто заменяют комбинацией «at-least-once + идемпотентность».

Гибридные подходы помогают удержать баланс: сохранять точность там, где она критична, и не платить за неё в каждом клике пользователя.

Конфликты данных: как их обнаруживать и разрешать

Проверьте eventual consistency в прототипе

Соберите маленький сервис и посмотрите, как UI переживает задержку репликации.

Eventual consistency почти неизбежно приводит к вопросу: что делать, если одно и то же значение изменили «одновременно», но в разных местах? Это и есть конфликт — ситуация, когда две (или больше) реплики приняли разные обновления и теперь система должна выбрать итоговое состояние.

Как возникают конфликты в реальности

Классический пример: пользователь меняет адрес доставки в мобильном приложении офлайн, а менеджер в веб‑панели параллельно обновляет тот же заказ. Оба изменения валидны локально, но при синхронизации нельзя просто «сложить» их без правил.

Важно уметь обнаруживать конфликты, а не надеяться, что они «редки». Типовые сигналы: разные версии объекта, конкурирующие события в очереди, расхождение полей после репликации.

Базовые стратегии разрешения

Last-write-wins (LWW) — «побеждает последнее». Работает для простых данных, где потеря одного из обновлений не критична (например, статус «последний просмотренный экран»). Но LWW опасен, если время на узлах отличается или если «последнее» не равно «правильное».

Правила домена — система решает по смыслу данных. Например, для остатков на складе можно запрещать отрицательные значения и пересчитывать итог от событий, а не от «последнего числа». Для профиля пользователя можно объединять независимые поля (телефон из одного изменения, адрес — из другого), если они не противоречат друг другу.

Ручное подтверждение — когда цена ошибки высока. Система показывает оператору или пользователю, что есть два варианта, и просит выбрать. Это дороже по UX, но честнее в финансовых и юридических сценариях.

CRDT — когда хочется автоматического “слияния”

CRDT (Conflict-free Replicated Data Types) помогают для некоторых типов данных, где можно гарантированно объединять изменения без конфликтов: счётчики, наборы тегов, совместное редактирование. Математику можно не знать — важно понимать границы применимости: CRDT удобны не для всего, а для «сливаемых» структур.

Гигиена: идемпотентность и дедупликация

Даже лучшая стратегия сломается, если одно и то же событие применится дважды. Поэтому делайте операции идемпотентными (повтор не меняет результат) и внедряйте дедупликацию: уникальные идентификаторы событий, журнал обработанных сообщений, защита от повторной доставки.

UX под eventual consistency: как не терять доверие

Eventual consistency чаще всего «ломает» не данные, а ощущение контроля у пользователя: он сделал действие — а интерфейс показывает старое состояние или внезапно «переобулся». Это решается UX-приёмами, которые делают задержки и асинхронность понятными.

Честно сообщайте, что происходит

Если данные могут обновляться не сразу, интерфейс должен говорить об этом прямо, но спокойно:

- Статусы вроде «Синхронизация…», «Обновляется», «Отправляем изменения…» — рядом с объектом, который меняется, а не где-то в углу.

- Разделяйте «изменение принято» и «изменение подтверждено». Например: «Сохранено локально» → «Синхронизировано».

Важно: статус должен исчезать сам и не требовать от пользователя «закрыть уведомление», иначе это воспринимается как ошибка.

Оптимистичный UI — с продуманным откатом

Оптимистичный UI (когда вы сразу показываете результат действия) снижает ощущение задержки. Но он обязан быть честным:

- Пока подтверждения нет, помечайте элемент как «в процессе».

- Если сервер/другая реплика вернула другой результат (конфликт, отказ, ограничение), откатывайте состояние и объясняйте простыми словами: что произошло и что делать дальше.

Лучше короткое «Не удалось применить изменения. Повторить?» с кнопкой, чем загадочное возвращение старого значения.

Тайм-ауты, повторные попытки и защита от двойных кликов

Асинхронность провоцирует повторные нажатия: пользователь не уверен, сработало ли. Поэтому:

- Блокируйте кнопку на время отправки или заменяйте её на состояние «Отправляем…».

- Используйте понятный тайм-аут: после N секунд меняйте статус на «Есть задержка. Мы продолжим попытки в фоне».

- Разрешайте безопасные повторы: «Повторить» не должен создавать дубликаты (для пользователя это один и тот же запрос).

Проектирование ожиданий: где показывать «последнее обновление»

Показывайте «Последнее обновление: 12:41» там, где пользователь принимает решение на основе свежести данных: список заказов, баланс, остатки, статус доставки.

Если есть риск увидеть устаревшее, заранее обозначьте контекст: «Данные могут обновляться с задержкой до 1–2 минут». Это снижает тревожность и укрепляет доверие — пользователь понимает правила игры.

Наблюдаемость и тестирование: что измерять и как проверять

Eventual consistency работает только тогда, когда вы умеете «видеть» задержку согласования и управлять ею. Иначе команда узнаёт о проблеме от пользователей — слишком поздно.

Метрики, без которых вы летите вслепую

Сведите наблюдаемость к нескольким понятным числам, которые можно обсуждать с продуктом и поддержкой:

- Лаг репликации: сколько времени проходит от записи в одном узле до появления на остальных. Смотрите не только среднее, но и p95/p99.

- Доля конфликтов: какой процент объектов/операций потребовал слияния или был отклонён. Полезно делить по типам конфликтов.

- Повторные события (дубликаты): как часто система получает одно и то же событие повторно и как часто это приводит к повторной обработке.

Логи и трассировка: связываем причины и последствия

Чтобы понимать причинно-следственные цепочки, договоритесь о минимальном наборе идентификаторов:

- Correlation ID для запроса/пользовательского действия (проходит через фронт, API, очереди).

- Event/Message ID для событий в шине/очереди.

- Версия объекта (или номер ревизии), чтобы видеть, какая запись «победила».

В распределённой трассировке полезно помечать этапы: «приняли команду», «записали локально», «опубликовали событие», «применили на реплике». Так быстрее находится место, где растёт задержка.

Тестирование с отказами: проверяем не счастье, а реальность

Планируйте тесты, которые имитируют то, что действительно случается в проде:

- задержки сети и джиттер;

- сетевые разделения (часть узлов недоступна);

- повторная доставка сообщений и изменение порядка;

- частичные падения (очередь доступна, база — нет).

Проверяйте не только «сошлось ли», но и как система ведёт себя до схождения: не теряет ли события, не множит ли дубликаты, корректно ли уведомляет пользователя.

SLO/SLA: формулируем «допустимую задержку согласования»

Вместо абстрактного «быстро» задайте цель: например, 99% записей согласуются за ≤ 5 секунд, а оставшиеся — за ≤ 1 минуту. Отдельно пропишите, что считается «согласованием» (появление во всех репликах, в поисковом индексе, в кэше) — и измеряйте именно это.

Как принять решение: простой чек-лист для команды

Выберите платформу на российских серверах

Работайте с данными в России: платформа использует локальные модели и не отправляет данные за рубеж.

Eventual consistency — это не «включить галочку», а договориться о правилах: где допустима задержка, как вы узнаете о расхождениях и что увидит пользователь.

1) Разделите операции по критичности

Составьте список ключевых действий в продукте и разнесите их по категориям:

- Деньги: платежи, баланс, выставление счетов.

- Права: доступы, роли, блокировки, удаление аккаунта.

- Контент: публикации, комментарии, профили.

- Метрики: просмотры, аналитика, рекомендательные счетчики.

Правило простое: чем выше цена ошибки, тем меньше свободы для отложенной консистентности. Для «метрик» и части контента eventual consistency обычно приемлема, для денег и прав — чаще нет (или нужен гибрид).

2) Определите допустимый лаг и «стоимость устаревания»

Зафиксируйте внятно (лучше в терминах SLA и задержек):

- Сколько времени данные могут быть устаревшими (секунды, минуты, часы)?

- Что ломается, если пользователь видит старое значение?

- Как часто это может происходить без потери доверия?

Пример формулировки: «Счетчик просмотров может отставать до 5 минут; список участников проекта — до 30 секунд; права доступа — без лага».

3) Выберите стратегию конфликтов и обеспечьте идемпотентность

Если есть репликация, offline-first режим или кэширование, конфликты — не исключение, а сценарий.

- Определите стратегию: last write wins, версии/временные метки, merge по полям, ручное подтверждение.

- Заложите идемпотентность (повтор запроса не должен «удваивать» эффект) и уникальные идентификаторы операций.

4) Предзапусковой чек-лист: ограничения, мониторинг, поддержка

Перед релизом зафиксируйте:

- Какие данные «eventual», а какие — строго согласованные.

- Как вы мониторите лаг, ошибки репликации и рост конфликтов.

- Что говорить пользователю в спорных состояниях (тексты, статусы, кнопка «обновить»).

- Инструкции для поддержки: как проверить состояние, как безопасно исправить, когда эскалировать.

Если команда может ответить на эти пункты одной страницей — решение по eventual consistency принято осознанно, а не «по умолчанию».

Практичная ремарка: как быстрее проверить гипотезы и UX для eventual consistency

Многие проблемы с eventual consistency становятся очевидны только в прототипе: какие статусы показывать, где нужны идемпотентные ключи, как выглядит «в обработке» при ретраях, что делать с дублями.

Для таких экспериментов удобно использовать TakProsto.AI — vibe-coding платформу, где можно собрать веб‑ или мобильное приложение через чат, быстро набросать CQRS-проекцию, очередь событий и экраны со статусами синхронизации, а затем итеративно поправить логику. Полезны и инфраструктурные вещи вроде snapshots и rollback (чтобы безопасно откатывать изменения модели), а также planning mode — чтобы заранее зафиксировать допуски по лагу и сценарии конфликтов.

Отдельный плюс для российской разработки: TakProsto.AI работает на серверах в России, использует локализованные open source LLM‑модели и не отправляет данные за пределы страны. Если нужно, можно экспортировать исходники (типовой стек: React на фронте, Go + PostgreSQL на бэкенде, Flutter для мобильных приложений) и продолжить развитие в привычном пайплайне.