20 нояб. 2025 г.·8 мин

Почему горизонтальное масштабирование сложнее вертикального

Разбираем, почему добавлять серверы часто сложнее, чем усиливать один: состояние, сеть, консистентность, деплой, мониторинг и цена ошибок.

Разбираем, почему добавлять серверы часто сложнее, чем усиливать один: состояние, сеть, консистентность, деплой, мониторинг и цена ошибок.

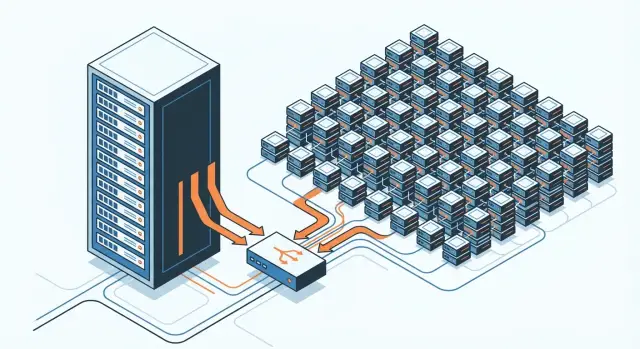

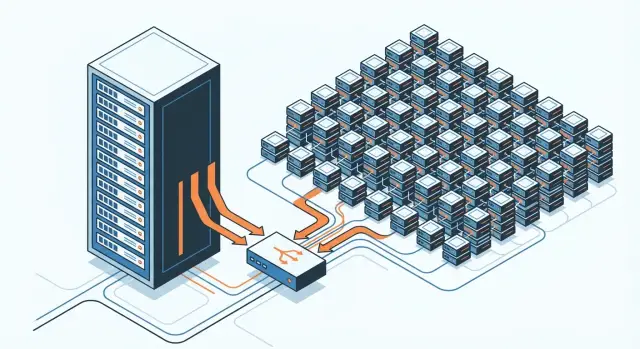

Вертикальное масштабирование — это «усилить один сервер»: добавить CPU, RAM, более быстрый диск, иногда перейти на более мощный инстанс в облаке. Приложение остаётся в целом тем же, просто получает больше ресурсов на одной машине.

Горизонтальное масштабирование — это «добавить серверы»: запустить несколько экземпляров приложения и распределять нагрузку между ними. Ресурсы растут суммарно, но система становится распределённой.

Вертикальный путь часто выбирают, когда:

Горизонтальный путь чаще нужен, когда:

Ключевая разница не в «железе», а в количестве взаимодействий: больше узлов = больше связей между ними. Появляются сеть, координация, согласование состояния, распределение данных и обработка частичных отказов — и именно это обычно делает горизонтальное масштабирование сложнее.

Важно уточнить: сложность сильно зависит от типа приложения и данных. Статический сайт или простое stateless API масштабируется по горизонтали сравнительно легко. А система с сессиями, кэшем, транзакциями и строгой консистентностью почти неизбежно потребует больше инженерных решений.

Вертикальный рост выглядит как прямой и понятный рычаг: нагрузка выросла — увеличили ресурсы узла — получили прирост.

Главная причина простоты — почти всё остаётся локальным. Приложение по‑прежнему живёт на одном хосте, данные рядом, зависимости те же. Многие неприятности не выходят за пределы одной машины:

На практике это часто означает: вы можете масштабироваться без изменения архитектуры. В лучшем случае — поднять лимиты, оптимизировать конфигурацию базы или веб‑сервера, добавить памяти под кэш, и всё продолжает работать «как раньше».

Эта простота заканчивается довольно быстро. У вертикального подхода типичные пределы понятны заранее: максимальная конфигурация железа, резко растущая стоимость топовых инстансов, а также единая точка отказа. Если этот сервер упал, упало всё — даже если он был очень мощным.

Поэтому вертикальный рост часто используют как первый шаг: он даёт быстрый выигрыш. Но когда вы упираетесь в потолок или появляются требования к отказоустойчивости, дальше почти неизбежны архитектурные изменения — и переход к горизонтальному масштабированию уже требует переосмыслить состояние, данные и взаимодействия между узлами.

При вертикальном масштабировании вы усиливаете один сервер: меньше акторов — меньше договорённостей. Горизонтальное масштабирование добавляет новые узлы, и вместе с ними появляется необходимость координации: кто за что отвечает, где лежит состояние, кто «главный» в конкретной ситуации, как узлы узнают об изменениях. Эта координация создаёт накладные расходы и по времени, и по инженерным усилиям.

С двумя узлами у вас немного связей и сценариев: если один «задумался», второй может подхватить трафик, а причины легче найти. С двадцатью узлами резко растёт число потенциальных точек отказа и комбинаций проблем: один узел отстаёт по конфигурации, другой испытывает нехватку памяти, третий потерял связь с базой, четвёртый попал под всплеск запросов. Даже если вероятность сбоя одного узла мала, суммарная вероятность «где-то что-то пойдёт не так» становится заметно выше.

Как только запрос или операция затрагивает несколько узлов, появляется время на согласование и ожидание: блокировки, подтверждения, выбор лидера, синхронизация кэшей. При нагрузке это выливается в очереди (в балансировщике, брокере, базе), таймауты и повторные попытки (retries).

Проблема в том, что ретраи могут усиливать перегрузку: система тратит ресурсы не только на полезную работу, но и на «дожим» неудачных операций.

С ростом числа узлов сложность обычно растёт не линейно. Добавляя серверы, вы увеличиваете не только суммарную мощность, но и количество взаимодействий между компонентами — а именно они чаще всего становятся источником неожиданных задержек, редких ошибок и сложных для воспроизведения инцидентов.

Горизонтальное масштабирование особенно «болит» там, где приложение хранит состояние в памяти конкретного сервера. Пока у вас один узел, это незаметно: пользователь авторизовался — данные сессии лежат рядом, корзина обновляется мгновенно, а веб‑сокет держит постоянное соединение. Но в кластере следующий запрос может попасть на другой сервер — и тот «не помнит» пользователя.

Самый очевидный костыль — sticky sessions (привязка пользователя к одному узлу через балансировщик). Это помогает, если состояние хранится в памяти, но создаёт новые проблемы:

Два типичных пути:

Stateless: сервер не держит пользовательское состояние в памяти. Например, авторизация через токены, а данные профиля и корзины каждый раз берутся из БД/кэша.

Внешнее хранилище сессий: Redis/БД как единое место для сессий и временных данных.

Оба подхода снимают зависимость от конкретного узла, но добавляют цену распределённости: дополнительные сетевые запросы, настройку TTL, контроль целостности, а также новую точку отказа (если Redis недоступен, «ложится» часть функциональности).

При вертикальном масштабировании многие операции остаются «внутри коробки»: вызов функции, доступ к памяти, чтение с локального диска. При горизонтальном — часть работы неизбежно превращается в сетевые запросы между узлами. И тут появляется разница порядков: память — наносекунды, локальный диск — миллисекунды, сеть добавляет миллисекунды (и иногда десятки) плюс непредсказуемость.

На одном сервере задержка обычно стабильнее: нет очередей на коммутаторах, нет конкуренции за общий канал, меньше промежуточных звеньев. В кластере запрос проходит через сетевой стек, инфраструктуру (виртуализацию, балансировщики, overlay-сети), иногда через несколько хопов — и каждый этап может добавить задержку.

Даже если средняя задержка «приемлемая», распределённые системы страдают от хвостов:

Из-за этого один и тот же бизнес‑запрос может то укладываться в SLA, то внезапно вылезать за пределы.

Когда сеть нестабильна, таймауты срабатывают чаще. Проблема в том, что таймаут не всегда означает реальный отказ — возможно, ответ просто «застрял». Ретраи в ответ на такие ситуации могут:

Сфокусируйтесь на измерении и управлении хвостовыми задержками:

Горизонтальное масштабирование почти всегда означает: сеть становится частью вашего критического пути — со всеми её капризами.

Когда вы добавляете второй, третий и десятый сервер, нужен механизм, который решит базовую задачу: какой узел получит конкретный запрос. Балансировщик нагрузки (LB) принимает входящий трафик и распределяет его между экземплярами приложения так, чтобы система в целом работала быстрее, стабильнее и предсказуемее.

Но на практике «раскидать запросы поровну» — лишь старт.

LB скрывает от клиентов внутреннюю структуру кластера: пользователи обращаются к одному адресу, а дальше запросы маршрутизируются к живым узлам. Это упрощает масштабирование, позволяет выводить серверы в обслуживание и снижает влияние единичных отказов.

Даже при одинаковых серверах нагрузка часто распределяется неравномерно:

Локальный кэш на одном сервере обычно понятен: данные прочитали — положили в память, обновили — сразу же поправили кэш (или очистили), и всё. В кластере кэширование быстро превращается в «общую договорённость» между узлами, которую легко нарушить.

Когда сервисов/инстансов много, у каждого может быть свой локальный кэш, плюс часто добавляют общий (например, Redis) как распределённый слой. Проблема в том, что появляется несколько источников «почти актуальной» информации: один узел уже обновил значение, другой ещё отдаёт старое из памяти, третий только что прогрелся после рестарта и шлёт запросы в базу.

Инвалидация — частая причина странных багов: пользователю обновили профиль, но часть запросов ещё минуту видит старое имя. Если инвалидация делается по событию, оно может потеряться; если по TTL — вы сознательно соглашаетесь на устаревание.

«Шторм» промахов (cache stampede) возникает, когда популярный ключ истёк или был очищен: сотни узлов одновременно идут в базу за одним и тем же. Итог — скачок задержек, рост ошибок и эффект домино (очереди, таймауты, повторные попытки).

user:123:v7), и старые значения «умирают» сами.Кэш — это не только про скорость. Это решение о том, сколько несогласованности вы допускаете. Неправильные настройки легко превращают «быстро» в «непредсказуемо»: то данные свежие, то устаревшие, то сервис внезапно «задумался» из‑за шторма промахов. Поэтому кэширование в кластере стоит проектировать вместе с требованиями к консистентности и ожиданиями пользователей.

Когда приложение работает на одном сервере, «истина» обычно одна: одна база данных, один кэш, один порядок операций. При горизонтальном масштабировании данные оказываются распределены — по нескольким узлам, репликам, шардам, очередям — и за согласованность приходится платить сложностью.

Сильная консистентность — ожидание, что после успешной записи любой следующий запрос в любом месте увидит новое значение. Это удобно для бизнеса («оплата прошла — статус сразу “оплачено”»), но часто требует синхронных подтверждений от нескольких компонентов.

Eventual‑консистентность — компромисс: запись разойдётся по системе не мгновенно, и некоторое время разные узлы могут отвечать по‑разному. В итоге все «сойдутся», но секунды (иногда дольше) можно видеть старые данные. Это ускоряет систему и повышает доступность, но требует аккуратной логики на уровне продукта.

Транзакции и блокировки хорошо работают внутри одной базы. Но если операция затрагивает несколько узлов (например, разные шарды или сервисы), «удержать» единый атомарный сценарий становится трудно: сеть добавляет задержки, возможны таймауты, а блокировки начинают тормозить всё вокруг. Попытки сделать «как в одной базе» приводят к дорогой распределённой координации.

Частые проблемы в кластере:

Базовый набор мер:

Эти приёмы не делают распределённость «бесплатной», но заметно снижают число дорогих инцидентов и трудно воспроизводимых ошибок.

Горизонтальное масштабирование почти гарантирует, что «упал один узел» будет происходить регулярно. Не потому что всё плохо, а потому что узлов много: кто-то перезагрузится после обновления, у кого-то закончится диск, где-то отвалится сеть. Важно не «избежать» таких ситуаций, а сделать их безопасными и предсказуемыми.

В одном сервере обычно всё просто: либо сервис доступен, либо нет. В кластере чаще встречаются серые зоны.

Например, часть узлов жива, но недоступна из‑за сетевой проблемы; база данных доступна для чтения, но запись зависает; один датацентр теряет связь с другим. Пользователь видит не «ошибку 500», а медленную работу, периодические таймауты, «то работает, то нет».

Отдельная категория — split brain: когда система из‑за разрыва связи разделяется на две группы, и обе считают себя «главными». Итог — конфликтующие записи и трудное восстановление состояния.

Чтобы переживать такие поломки, распределённые системы опираются на несколько базовых приёмов:

Планы восстановления должны быть проверяемыми. Практика — регулярно делать chaos‑инъекции: искусственно убивать процессы, резать сеть, замедлять ответы, переполнять очереди.

Полезно прогонять сценарии: «упал лидер», «половина узлов недоступна», «откат релиза», «рассинхрон реплик», и заранее определить, что считается успешным восстановлением: допустимая потеря данных, целевые RTO/RPO и поведение системы в режиме деградации.

Когда приложение живёт на одном сервере, «что произошло?» часто отвечает один лог‑файл и пара графиков CPU/RAM. В кластере тот же запрос может пройти через балансировщик, несколько сервисов и очереди — и следы оказываются размазаны по десяткам узлов.

В горизонтальном масштабировании метрики становятся многомерными: важно видеть не только средние значения, но и распределения по инстансам. Один «плохой» узел с утечкой памяти или перегретым диском может портить хвостовые задержки, хотя средняя латентность выглядит нормально.

Поэтому фокус смещается на SLO и хвосты: p95/p99 задержек, долю ошибок (например, 5xx/таймауты) и насыщение ресурсов (CPU throttling, очередь запросов, пул соединений к базе). Без этого легко перепутать реальную проблему с кратковременным всплеском нагрузки.

В кластере логи надо централизовать: иначе расследование превращается в поиск по десяткам машин. Но централизованный сбор — это ещё и нормализация формата (структурные логи), контроль объёма и правила ретенции, чтобы «шум» не вытеснил полезные события.

Дополнительная сложность — интерпретация. Одна ошибка может проявиться каскадом сообщений в разных сервисах, и без связки между ними вы видите лишь фрагменты истории.

Чтобы «склеить» путь запроса, нужны correlation ID/trace ID, которые прокидываются через все сервисы и очереди. Распределённая трассировка показывает, где именно теряется время: сеть, ожидание блокировок, повторные попытки, медленный внешний API.

Централизация наблюдаемости повышает риск утечек: в логах часто оказываются токены, email, номера телефонов. Нужны маскирование чувствительных данных, разграничение доступа (RBAC), аудит просмотров и шифрование на хранении. Иначе система, созданная для диагностики, становится источником инцидентов.

На одном сервере релиз обычно выглядит как «остановили — обновили — запустили». Версия кода одна, состояние предсказуемо, а ошибки проще локализовать.

В кластере всё иначе: релиз почти всегда растянут во времени. Пока часть узлов уже обновилась, другая часть ещё обслуживает трафик на старой версии. В результате некоторое время у вас две (или больше) версии системы одновременно — и именно это делает горизонтальное масштабирование заметно сложнее.

Первый риск — разные версии получают запросы вперемешку. Из‑за балансировки и ретраев трафик может «дрожать»: один и тот же пользователь за минуту попадает то на новый, то на старый узел. Если новые и старые узлы по‑разному интерпретируют данные или формат сообщений, возникают трудноуловимые баги.

Второй риск — несовместимость со схемой данных. Проблема не только в БД: это может быть формат событий, поля в кэше, структура документов в поиске. Если новая версия уже пишет по‑новому, а старая ещё читает по‑старому (или наоборот), сервис начинает ломаться точечно и непредсказуемо.

Чаще всего используют:

Подробные практики часто описывают во внутренних runbook’ах и в /blog/release-process.

Для схем и контрактов помогают дисциплина и обратимость:

Итог: в кластере релиз — это управляемое сосуществование версий, а не одномоментное обновление.

Выбор между вертикальным и горизонтальным масштабированием редко сводится к «что дешевле за один сервер». Горизонтальный рост почти всегда означает больше инженерной работы: нужно проектировать систему так, чтобы она корректно работала на нескольких узлах, переживала частичные сбои и была управляемой.

Начните с ответа на два вопроса: какие SLO вам нужны (время ответа, доступность, допустимые ошибки) и что именно является узким местом (CPU, память, диск, база данных, внешние API). Если цель — просто выдержать рост нагрузки «в ближайшие 3 месяца», иногда разумнее временно усилить одну машину и отложить распределение.

Кстати, на этапе прототипа или ранней версии продукта часто выгодно быстро проверить гипотезу и нагрузочный профиль, прежде чем вкладываться в сложную кластерную архитектуру. В этом помогает TakProsto.AI — платформа vibe-coding, где можно собрать веб‑приложение (React), бэкенд (Go + PostgreSQL) и при необходимости мобильное приложение (Flutter) в формате диалога, а затем выгрузить исходники и развивать проект уже в «классическом» программировании.

Кроме дополнительных экземпляров приложения обычно появляются сопутствующие затраты:

Важно учитывать и «стоимость изменений»: любое небольшое улучшение превращается в работу по согласованию конфигураций, версий и политики деплоя.

Вертикальный вариант часто выигрывает, если нагрузка предсказуемая, приложение — монолит без жёстких требований к отказоустойчивости, данные простые и хорошо помещаются в один экземпляр БД. Это также хороший выбор, когда у команды ограничены сроки, а риски рефакторинга под кластер высоки.

Перед решением пройдитесь по пунктам:

Компромиссная стратегия встречается чаще всего: сначала вертикально «снять напряжение», параллельно подготовив ключевые компоненты к горизонтальному масштабированию там, где оно действительно окупается.

Вертикальное масштабирование — это усиление одного узла (больше CPU/RAM/быстрее диск), при этом архитектура часто не меняется.

Горизонтальное — добавление узлов и распределение нагрузки между экземплярами. Вы выигрываете по суммарным ресурсам и доступности, но получаете распределённую систему со всеми её накладными расходами: сеть, координация, согласование состояния и частичные отказы.

Потому что почти всё остаётся локальным: меньше сетевых вызовов, меньше вариантов рассинхронизации и проще отладка.

Обычно достаточно:

Но простота заканчивается там, где появляется потолок железа/бюджета и единая точка отказа.

Потолок бывает трёх типов:

Если требования к доступности растут или вы упёрлись в лимиты, дальше часто приходится менять архитектуру и переходить к горизонтальному подходу.

Потому что растёт число взаимодействий и сценариев отказа. В распределённой системе «где-то что-то пошло не так» случается чаще просто из‑за количества компонентов.

Практически это выражается в:

Сложность обычно растёт быстрее, чем линейно, потому что увеличивается не только число узлов, но и связей между ними.

Пока один сервер — состояние в памяти «работает само»: сессии, корзина, локальный кэш, веб‑сокеты.

В кластере следующий запрос может попасть на другой узел, который ничего не знает о предыдущем. Типовые решения:

В любом варианте вы платите сетью, дополнительными зависимостями и новыми точками отказа.

Потому что сеть добавляет не только задержку, но и непредсказуемость: джиттер, хвостовые задержки, потери пакетов.

Чтобы не превратить нестабильность сети в инцидент, обычно делают так:

Балансировщик решает не только «раскидать запросы», но и вопросы живучести и предсказуемости:

Сложности появляются из‑за неравномерной нагрузки:

В кластере одновременно существуют несколько уровней кэша (локальный L1 на узлах и общий слой вроде Redis), и легко получить несогласованность.

Самые частые проблемы:

Практики, которые обычно помогают:

Потому что «атомарность как в одной БД» плохо переносится через сеть и несколько компонентов. Появляются таймауты, ретраи и частичные сбои, из‑за которых легко получить:

Минимальный набор защиты:

Релиз в кластере почти всегда означает «смешанные версии»: часть узлов обновлена, часть — нет, а трафик перемешивается балансировкой и ретраями.

Чтобы это было безопасно:

В распределённой системе сеть становится частью критического пути.

Поэтому важно выбирать стратегию (round-robin, least connections, hash, weights) и корректно настраивать проверки здоровья.

Выбор между сильной и eventual‑консистентностью — не теория, а продуктовый и инженерный компромисс.

На практике это и делает горизонтальные системы сложнее в изменениях, чем одиночный сервер.