02 сент. 2025 г.·8 мин

Protobuf vs JSON для API: скорость, размер и удобство

Сравниваем Protobuf и JSON для API: размер и скорость, удобство отладки, схемы и совместимость. Подсказки, когда выбрать каждый формат.

Зачем сравнивать Protobuf и JSON для API

Выбор между JSON и Protobuf — это не спор «какой формат лучше», а решение про стоимость и качество коммуникации между сервисами. От него зависят скорость ответа, расходы на трафик, удобство отладки, стабильность контракта и то, насколько легко подключать новые клиенты.

Что именно сравниваем

Когда говорят «Protobuf vs JSON», часто смешивают несколько уровней:

- Формат представления данных: текстовый (JSON) или бинарный (Protobuf).

- Сериализация/десериализация: сколько CPU и времени уходит на кодирование/декодирование.

- Контракт API (схема): есть ли строгая спецификация полей и типов, как обеспечивается совместимость.

- Транспорт и протокол: JSON часто живёт в REST поверх HTTP, Protobuf — частый выбор для gRPC, но оба могут передаваться по HTTP при необходимости.

Важно сравнивать не «файл JSON против файла .proto», а вашу реальную цепочку: клиенты, серверы, прокси, логирование, мониторинг, требования к совместимости.

Какие вопросы чаще всего решает выбор

На практике формат выбирают, чтобы ответить на несколько прикладных вопросов:

- Производительность и стоимость: размер сообщений, задержки, нагрузка на CPU, цена сетевого трафика.

- Удобство разработки и поддержки: читаемость, дебаг в логах, простота ручных запросов, скорость интеграции сторонних команд.

- Интеграции и инфраструктура: совместимость с кэшами, шлюзами, прокси, возможностями наблюдаемости.

- Долгосрочная эволюция: как безопасно добавлять поля и версии, не ломая старых клиентов.

Короткое резюме

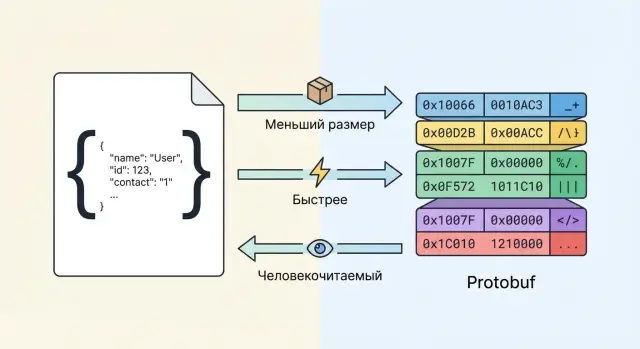

JSON обычно выигрывает там, где важны простота, прозрачность и «быстрый старт»: много инструментов, легко смотреть и воспроизводить запросы, проще подключать внешних партнёров.

Protobuf чаще выигрывает там, где критичны эффективность и строгий контракт: меньше размер сообщений, выше предсказуемость типов, удобнее генерация клиентов и взаимодействие микросервисов (особенно в gRPC).

Кратко: как работают JSON и Protobuf

Как устроен JSON

JSON — это текстовый формат сериализации. Он передаёт данные как комбинацию объектов (пары ключ–значение) и массивов, которые можно вложить друг в друга.

Базовые типы простые и универсальные: строки, числа, булевы значения, null, а также объекты и массивы. За счёт текстовой природы JSON легко читать глазами и править вручную — это удобно для быстрых проверок, логов и работы через инструменты вроде curl или Postman.

При этом JSON не навязывает строгую схему «из коробки»: одинаковое поле в разных запросах может быть то строкой, то числом, а новые поля могут появляться без явного объявления. Строгость обычно достигается отдельными соглашениями (например, JSON Schema) или проверками на стороне приложения.

Как устроен Protobuf

Protobuf (Protocol Buffers) — бинарный формат. Он кодирует значения компактно и быстро, а данные в сообщении идентифицируются не текстовыми ключами, а номерами полей (field numbers).

Ключевая идея — подход schema-first: сначала описывается структура сообщений, а затем на её основе сериализуются и десериализуются байты. Благодаря номерам полей Protobuf обычно эффективнее по размеру и быстрее в обработке, а добавление новых полей чаще всего не ломает старые клиенты (если соблюдать правила совместимости — об этом будет отдельный раздел).

Что такое .proto и что генерируется

Файл .proto — это описание схемы: какие сообщения существуют, какие у них поля, типы, номера, а также (часто) определения RPC-сервисов.

Из .proto генератор создаёт типизированный код для разных языков:

- модели/структуры данных (message-классы) с сериализацией/десериализацией;

- клиентские SDK, чтобы вызывать методы и собирать запросы в типах;

- серверные интерфейсы/заготовки (stubs), чтобы реализовать обработчики.

На практике это означает меньше ручного кода и меньше «сюрпризов» на интеграциях: контракт описан явно, а ошибки типов ловятся раньше — на этапе компиляции или генерации. В обмен вы получаете необходимость поддерживать схему .proto и процесс генерации в сборке/CI.

Размер и производительность: сеть, CPU и задержки

Производительность формата — это не только «быстрее/медленнее». На практике важны три вещи: сколько байт вы отправляете по сети, сколько CPU тратите на сериализацию/парсинг и какую задержку добавляет каждый запрос (особенно на мобильных и при больших объёмах).

Размер полезной нагрузки: почему Protobuf обычно меньше

JSON — текстовый: имена полей повторяются в каждом объекте, числа и даты передаются строками или текстовыми литералами, много служебных символов (кавычки, запятые, пробелы). Protobuf — бинарный: вместо имён полей используются числовые теги, а значения кодируются компактно (например, varint для целых чисел). Поэтому при одинаковой структуре Protobuf часто заметно меньше по размеру, особенно на массивах объектов и «болтливых» схемах.

Важно: выигрыш зависит от данных. Если у вас короткие сообщения с парой полей, разница может быть скромной. Если же ответ — это список из сотен сущностей с одинаковыми полями, экономия обычно становится ощутимой.

Скорость (CPU): парсинг текста vs декодирование бинарных полей

JSON нужно:

- распарсить текст (лексинг/парсинг),

- преобразовать строки в числа/даты,

- сопоставить имена полей.

Protobuf, как правило, декодируется более прямолинейно: читаются теги и значения, заполняются поля. На высоких RPS это даёт меньше нагрузку на CPU и GC, а значит — стабильнее задержки.

Нюанс: если вы используете JSON «как строку» (логирование, проксирование без разбора), CPU может быть не главным фактором. А вот в типичных API, где вы всё равно превращаете запрос в структуру, бинарный формат чаще выигрывает.

Влияние на мобильные сети и стоимость трафика

На мобильных сетях меньший размер ответа даёт двойную пользу:

- быстрее «долетает» по радио (меньше времени в пути),

- меньше шанс упереться в лимиты/пакеты/повторы, особенно при нестабильном соединении.

Если продукт работает в регионах с дорогим трафиком или у пользователей часто включён режим экономии данных, сокращение килобайт на каждом запросе может заметно улучшить UX и снизить расходы (CDN/egress).

Когда компрессия (gzip/brotli) уменьшает разницу

Компрессия сильно помогает JSON, потому что в нём много повторяющихся строк (имена полей, однотипные структуры). С gzip/brotli разрыв по размеру между JSON и Protobuf часто сокращается, а иногда на «очень повторяющихся» данных становится не таким драматичным.

Однако компрессия добавляет CPU и задержку на (де)сжатие и не всегда выгодна на маленьких ответах. Кроме того, Protobuf тоже можно сжимать — и тогда выигрывает уже комбинация «бинарный + компрессия».

Практический вывод: сравнивайте не «голый JSON vs голый Protobuf», а реальные профили — с TLS, с вашим типичным payload, с включённой/выключенной компрессией и на целевых устройствах.

Читаемость и отладка: опыт разработчика и поддержки

JSON выигрывает там, где важна «человеческая» прозрачность. Его легко открыть в логах, быстро понять структуру и значения, а главное — воспроизвести проблему вручную.

Читаемость: логи, curl и быстрые проверки

С JSON удобно работать в повседневной рутине: запрос можно отправить через curl, поправить пару полей прямо в терминале, прогнать через jq и тут же увидеть результат. Это особенно ценно для поддержки и on-call: даже без полного контекста сервиса можно быстро отличить «плохие данные» от «ошибки бизнес-логики».

У Protobuf другая философия: бинарный формат компактнее и быстрее, но «на глаз» его не прочитать. Если в инциденте у вас только дамп байтов или base64 из очереди — без схемы и инструментов понять содержимое почти невозможно.

Отладка и диагностика: трассировка и ручная правка

С JSON удобно делать минимальные воспроизводимые примеры: скопировали тело запроса из логов, поменяли поле, отправили снова. С Protobuf ручная правка сложнее: для корректного сообщения нужна .proto-схема и сериализация тем же набором типов.

В распределённой трассировке (trace/span) оба формата обычно «прячутся» за метаданными, но с JSON легче прикладывать фрагменты payload в события и комментарии к инциденту — при условии маскирования чувствительных полей.

Инструменты для просмотра Protobuf

Чтобы Protobuf не превращался в «чёрный ящик», заранее готовят набор средств: декодирование через protoc, плагины для IDE, gRPC-инструменты (например, grpcurl), а также прокси/перехватчики, которые умеют логировать сообщения в текстовом виде при наличии схемы.

Как логировать и не терять наблюдаемость

Лучший подход — структурированное логирование на уровне «смысловых полей»: идентификаторы, статусы, размеры списков, ключевые параметры, а не полный payload.

Для Protobuf полезно логировать текстовое представление выборочно (по флагу, семплированию, только на ошибках) и обязательно:

- ставить лимиты на размер логируемых данных;

- маскировать PII/секреты;

- сохранять версию схемы/контракта рядом с событием, чтобы логи оставались читаемыми после эволюции API.

Схема и валидация: как удержать контракт API

Контракт API — это не только набор эндпоинтов, но и точное описание того, какие поля, типы и правила допустимы. Чем лучше зафиксирован контракт, тем меньше «сюрпризов» при интеграции и обновлениях.

Schema-first и schema-less: где проще договориться

Protobuf почти всегда schema-first: вы начинаете с файла .proto, где явно заданы сообщения, типы полей и их номера. Клиенты и сервер обычно генерируются из одной схемы, поэтому всем проще оставаться «на одной версии правды».

JSON сам по себе schema-less: формат допускает любые поля и типы, а контракт появляется только если вы отдельно поддерживаете спецификацию (например, OpenAPI или JSON Schema). Это удобно для быстрых прототипов, но требует дисциплины, чтобы схема не «расходилась» с реализацией.

Валидация: типы, обязательность и ограничения

В Protobuf типы (int32, string, bool и т. д.) заданы строго. Однако многие бизнес-ограничения (диапазоны, форматы, «обязательность») потребуют дополнительной логики или правил валидации поверх схемы.

В JSON валидация обычно строится вокруг OpenAPI/JSON Schema: можно описать обязательные поля, min/max, regex-форматы, enum и даже составные ограничения. Плюс — это легко использовать на входе API (валидация запросов) и в документации.

Как выглядят ошибки интеграции

- В Protobuf неверный тип чаще выявится при компиляции/генерации клиента или будет очевиден при десериализации.

- В JSON ошибки проявляются позже: поле может внезапно прийти строкой вместо числа, пропасть обязательный параметр или появится «лишнее» поле, которое кто-то начнёт использовать без согласования.

Что выбрать для удержания контракта

Если важнее всего единый контракт и одинаковое понимание типов всеми клиентами — .proto даёт сильную опору. Если вы в экосистеме REST и опираетесь на документацию/валидацию на шлюзах — связка JSON + OpenAPI/JSON Schema часто практичнее и прозрачнее для команд.

Совместимость и эволюция API со временем

Проверьте формат на практике

Соберите два варианта API и сравните размер сообщений и задержки на своих данных.

API редко живёт в статике: добавляются поля, уточняются типы, меняются правила расчётов. Самая дорогая ошибка — выпустить изменение, которое ломает старых клиентов или заставляет держать параллельные версии годами. Поэтому важно понимать, как именно JSON и Protobuf «переживают» изменения контракта.

Прямая и обратная совместимость — что это значит на практике

- Обратная совместимость: новый сервер/клиент понимает сообщения старого формата. Например, клиент обновился, а сервер ещё нет.

- Прямая совместимость: старый клиент/сервер не падает на сообщениях нового формата. Например, сервер добавил поле, а клиент остался прежним.

На практике чаще всего хотят оба свойства: можно раскатывать изменения постепенно, без единого «часа Х».

Как эволюционировать Protobuf без боли

У Protobuf совместимость строится вокруг номеров полей. Текстовое имя поля вторично: в бинарном сообщении передаётся именно номер.

Что работает хорошо:

- Добавление новых полей с новыми номерами: старые клиенты просто игнорируют неизвестные поля, новые — читают.

- Переименование полей: можно менять имя в

.proto, не трогая номер — это не ломает wire-формат. - Удаление полей: безопаснее не переиспользовать их номера. Для этого есть

reserved(номера и/или имена), чтобы случайно не «переприсвоить» старый смысл.

Важно: если поменять тип поля или семантику, сохранив номер, можно получить тихие ошибки. В Protobuf это дисциплина контракта: номера — как публичный API.

Как эволюционировать JSON: tolerant reader и явное версионирование

JSON не навязывает схему, поэтому совместимость держится соглашениями:

- Добавляйте поля, не меняя смысл старых: старые клиенты должны игнорировать неизвестные ключи (tolerant reader).

- Не делайте обязательное поле необязательным и наоборот без стратегии миграции.

- Меняйте типы осторожно: переход

number → stringчасто ломает парсинг сильнее, чем кажется.

Когда изменения затрагивают смысл или структуру, чаще вводят версионирование: отдельный путь (/v2/...), отдельный медиа-тип или явное поле версии в полезной нагрузке — выбор зависит от инфраструктуры и контрактов.

Стратегии версионирования API без ломки клиентов

Рабочая модель для обоих форматов: сначала расширяйте, затем мигрируйте, и только потом удаляйте.

- Сначала добавьте новые поля/эндпоинты, оставив старые.

- Дайте период, когда сервер пишет и читает оба варианта.

- Следите за фактическим использованием (метрики, логи), и только после этого закрывайте старое.

Итог: Protobuf формализует эволюцию через номера полей и правила схемы, JSON — через договорённости и дисциплину версионирования. В обоих случаях выигрывает тот, кто проектирует изменения как постепенный процесс, а не как разовую «замену формата».

Типы данных и нюансы моделирования

Выбор между JSON и Protobuf часто упирается не в «скорость vs удобство», а в то, насколько предсказуемо вы сможете описывать данные и менять их со временем. Именно на уровне типов и правил «что значит это поле» обычно появляются самые болезненные баги.

Null и «поля нет»: типичные ловушки JSON

В JSON есть как минимум три состояния: поле отсутствует, поле присутствует со значением null, и поле присутствует со значением (например, пустая строка ""). На практике клиенты и бэкенды трактуют это по‑разному:

- «поля нет» может означать «не прислал, оставь как есть» (PATCH‑семантика) или «неизвестно»;

nullможет означать «явно очистить значение» или «значение неизвестно»;- пустая строка/0/false иногда тоже используется как «нет значения», что смешивает смысл с реальными данными.

Если контракт не фиксирует эти правила, поддержка превращается в угадывание: клиент «не менял», а сервер «обнулил».

Presence и значения по умолчанию в Protobuf

В Protobuf важна тема presence (можно ли отличить «не задано» от «задано значением по умолчанию»). В proto3 долгое время скаляры (int/bool и т. п.) не имели presence: неотправленное поле и отправленное как 0 выглядели одинаково.

Сейчас это решается через optional (и поведение зависит от версии компилятора/генератора и языка), а также через:

google.protobuf.*Valuewrapper-типы, где можно выразить «значение отсутствует»;oneof, если нужно строго выбрать один из вариантов и избежать двусмысленности.

Это полезно для API, где «пользователь явно выставил 0» отличается от «не трогал поле».

Непрозрачные и частично известные поля

У JSON «гибкость» обычно реализуют через произвольные объекты: клиент может прислать дополнительные ключи, а сервер их проигнорирует.

В Protobuf похожий эффект достигается неизвестными полями: новый сервер может отправить поле, старый клиент его не знает, но (часто) сохранит и передаст дальше при пересериализации. Это удобно для постепенных релизов, но есть нюанс: если ваш код преобразует сообщение в JSON/Map и обратно, неизвестные поля могут потеряться.

Массивы, карты и вложенные структуры

JSON естественно выражает вложенные объекты и массивы, но типизация «плывёт»: в одном ответе поле может быть объектом, в другом — строкой.

В Protobuf моделирование более дисциплинированное:

- массивы —

repeated(всегда список одного типа); - карты —

map<key, value>(ключ обычно строка или число); - вложенность — отдельные сообщения (структура фиксирована и хорошо документируется).

Итог: JSON проще для произвольных документов, Protobuf — лучше, когда важна строгая модель данных и однозначная интерпретация каждого поля.

Протоколы и экосистема: REST, gRPC и streaming

Размещайте проекты в России

Разрабатывайте и хостите проекты на российских серверах, без отправки данных за рубеж.

Формат данных часто путают с протоколом, хотя это разные уровни. JSON и Protobuf — про представление сообщений, а REST и gRPC — про стиль/протокол взаимодействия. На практике экосистема вокруг них влияет на выбор не меньше, чем «байты на проводе».

Где чаще встречается JSON: REST и веб-интеграции

JSON — стандарт де-факто для REST API и публичных интеграций. Он одинаково привычен браузеру, мобильным приложениям, партнёрам и инструментам вроде Postman.

REST поверх HTTP/1.1 легко проходит через прокси и корпоративную инфраструктуру, удобно логируется, а content-type application/json понятен всем. Поэтому для внешних API и «вебного» мира JSON обычно выигрывает экосистемой и предсказуемостью.

Где чаще встречается Protobuf: gRPC, внутренние сервисы и микросервисы

Protobuf чаще всего раскрывается вместе с gRPC: строгая схема, генерация клиентов/серверов, единые контракты и удобные streaming-вызовы.

gRPC обычно работает поверх HTTP/2, что даёт мультиплексирование запросов и эффективный двусторонний streaming. Внутри компании (микросервисы, сервис-сервис) это часто оказывается проще поддерживать: меньше ручной «склейки» SDK и больше типобезопасности.

Смешанные подходы: снаружи JSON, внутри Protobuf

Распространённый компромисс: публичный слой (API Gateway) отдаёт JSON/REST, а внутри периметра сервисы общаются по gRPC/Protobuf. Так проще обеспечить совместимость с внешними клиентами, сохранив эффективность и удобство контрактов внутри.

Транспорт и формат можно выбирать независимо

Формат не привязан жёстко к транспорту:

- JSON может жить и в HTTP/2, и в streaming (например, SSE или WebSocket), хотя это не «родная» среда.

- Protobuf не обязан быть только в gRPC: его можно передавать и по обычному HTTP как бинарное тело (с

application/x-protobuf).

На практике выбор часто выглядит так: REST/JSON — для максимальной совместимости, gRPC/Protobuf — для внутренних RPC и streaming, а смешанная архитектура закрывает оба сценария.

Инструменты, генерация клиентов и сопровождение

Выбор между JSON и Protobuf часто решается не только скоростью, но и тем, как команда будет жить с API годами: подключать новых клиентов, обновлять контракты и поддерживать документацию.

Поддержка в языках: генерация кода vs ручные модели

С JSON обычно начинают быстрее: формат читаемый, многие HTTP‑клиенты «из коробки» умеют отправлять и принимать JSON, а модели данных можно описать вручную (или сгенерировать по OpenAPI). Это удобно для прототипов и небольших интеграций, но ручные модели легко расходятся с реальным контрактом.

Protobuf почти всегда предполагает генерацию кода из .proto: типы, перечисления, (де)сериализация — всё синхронизировано. Взамен вы принимаете дополнительный шаг сборки и зависимость от инструментов protoc, но получаете меньше «скрытых» ошибок на уровне типов.

Контроль изменений: генерация, CI и линтеры

Для Protobuf естественно выстраивается дисциплина изменений: PR меняет .proto, а CI может проверять совместимость (например, запрет удаления полей, контроль номеров), плюс линтеры на стиль и именование.

В JSON‑мире похожую строгость можно достичь через JSON Schema/OpenAPI и проверки на breaking changes, но на практике это чаще требует больше ручной поддержки.

Документация: OpenAPI и gRPC

Для REST API с JSON обычно выигрывает OpenAPI: документация, примеры запросов, интерактивные «песочницы». Для gRPC документация и контракт живут в .proto, а инструменты вокруг (включая server reflection) помогают держать клиентов в актуальном состоянии.

Время подключения нового клиента

Если у команды уже есть OpenAPI и генерация клиентов настроена, JSON подключается очень быстро. Если API строится вокруг gRPC, Protobuf обычно ускоряет старт: подключили пакет со сгенерированными типами — и меньше вопросов к контракту.

Здесь важно заранее описать процесс: где лежит схема, как версионируется и как запускаются генераторы.

Практика: быстрее пройти путь «контракт → сервис → клиент»

Если вы регулярно собираете новые сервисы и не хотите вручную «склеивать» типы, хэндлеры, документацию и деплой, полезно иметь единый конвейер разработки.

Например, в TakProsto.AI можно в диалоге спроектировать API (REST/JSON или gRPC/Protobuf), получить каркас веб/серверного приложения и дальше итеративно уточнять контракт. Для команд, которым важны воспроизводимость и контроль изменений, особенно удобно, что платформа поддерживает экспорт исходников, деплой/хостинг, снапшоты и откат — то есть эволюцию схемы и реализаций можно проводить более безопасно и быстро. Поскольку TakProsto.AI ориентирован на российский рынок и работает на серверах в России, это также упрощает выполнение локальных требований к данным.

Безопасность: валидация, лимиты и обработка ошибок

Безопасность формата — это не только «можно ли подделать поле», но и насколько легко сервис можно уронить невалидным или слишком тяжёлым запросом. И JSON, и Protobuf требуют дисциплины на входе: по умолчанию они скорее про удобство сериализации, чем про защиту.

Поверхность атак: парсинг и «тяжёлые» payload

JSON уязвим к перегрузке через огромные документы, чрезмерную глубину вложенности и структуры, которые провоцируют дорогой парсинг. В Protobuf классический риск — «раздувание» сообщений (много повторяющихся полей, большие bytes/строки) и ошибки при обработке неизвестных полей/версий.

Практика для обоих форматов:

- лимитируйте глубину/размер входа ещё до полного парсинга;

- отключайте или ограничивайте «гибкие» возможности парсера, если они не нужны (например, не принимать произвольные числа как строки);

- задавайте верхние границы для массивов/повторов и размеров bytes.

Шифрование и подпись: транспорт и приложение

Формат сам по себе не шифрует данные. Обычно достаточно TLS на транспорте. Если нужен контроль целостности на уровне приложения (например, подпись отдельных полей, идемпотентность, защита от реплея), это реализуется поверх JSON/Protobuf одинаково: подписи, nonce/timestamp, HMAC/JWS — в зависимости от требований и инфраструктуры.

Валидация, лимиты и ошибки

- Валидация: проверяйте обязательность, диапазоны, длины строк, допустимые enum-значения. В Protobuf это не «магия схемы» — бизнес-правила всё равно в коде или через дополнительные валидаторы.

- Лимиты: size limits, timeouts, rate limit — обязательны для обоих форматов.

- Ошибки: возвращайте стабильные коды и безопасные сообщения, без утечек внутренней структуры (stack trace, SQL, пути файлов).

Безопасное логирование

Логи — частая точка утечки. Маскируйте токены, персональные данные и секреты (например, email/телефон, access_token, cookies) и в JSON, и в Protobuf. Лучше логировать метаданные (размер, тип запроса, correlation id), а не весь payload.

Кэширование, прокси и совместимость с инфраструктурой

Спроектируйте API контракт в чате

Опишите REST или gRPC и получите основу сервиса в одном диалоге.

Формат ответа влияет не только на скорость сериализации, но и на то, насколько «безболезненно» API проходит через CDN, корпоративные прокси, WAF и инструменты наблюдаемости.

HTTP‑кеши и CDN

JSON чаще проще кэшировать и отлаживать по практическим причинам: многие CDN и промежуточные слои умеют логировать и анализировать текстовые ответы «как есть», а инженеры поддержки могут быстро проверить содержимое глазами.

С Protobuf кеширование тоже работает, но обычно требует более строгой дисциплины: корректные Cache-Control, ETag/If-None-Match, Vary (например, по Accept), а также понимания, что payload бинарный и не предназначен для ручной диагностики. Если вы планируете кешировать ответы на границе, заранее проверьте, как ваш CDN обращается с Content-Type: application/x-protobuf и не пытается ли он применять преобразования, рассчитанные на текст.

Прокси и observability

Во многих организациях прокси и WAF делают body inspection, DLP‑проверки, поиск PII и т. п. С JSON это часто доступно «из коробки». С Protobuf такие проверки либо невозможны без схемы, либо требуют специализированных плагинов/декодеров — иначе вы теряете часть видимости.

Для метрик и трассировки (OpenTelemetry) формат тела обычно вторичен: важнее заголовки и контекст (traceparent). Но для логирования «примеров запросов» и поддержки инцидентов JSON почти всегда удобнее.

Content‑Type и версионирование

Чтобы не ломать инфраструктуру, фиксируйте соглашения:

- используйте явный

Content-Type(application/json,application/x-protobuf); - поддерживайте контент‑неготиацию через

Accept; - для версий — либо отдельный путь (

/v1/...), либо media type с версией (например,application/vnd.company.resource.v1+json).

Сжатие и двоичные форматы

Protobuf обычно меньше, но gzip/brotli для JSON может сократить разрыв. Практичный подход — включить сжатие на сервере и измерить эффект на реальных данных: размер ответа, CPU, p95 задержки. Важно проверить, что CDN/прокси корректно работают с Content-Encoding и не ломают кеш из‑за неправильного Vary: Accept-Encoding.

Как выбрать формат: рекомендации по сценариям и чеклист

Выбор между JSON и Protobuf почти никогда не про «что лучше вообще». Это про то, какие риски вы готовы принять: скорость разработки и отладки, требования к производительности, зрелость контрактов и привычки команды.

Когда JSON предпочтительнее

JSON хорошо подходит, если API публичное или им будут пользоваться внешние команды: его легко прочитать, отправить из curl/Postman и быстро понять, что именно ушло по сети.

Также JSON удобен для ad‑hoc запросов и частых «экспериментов» с формой данных, когда контракт ещё не устоялся. Для REST API и веб-интеграций JSON обычно «по умолчанию» совместим с инструментами, логированием и прокси.

Когда Protobuf предпочтительнее

Protobuf выигрывает, когда на первом месте скорость и размер сообщений: много трафика, мобильные сети, высокие RPS, жёсткие задержки. Он особенно логичен, если вы уже используете gRPC или планируете streaming: строгая схема, генерация клиентов и единый контракт снижают вероятность «неожиданных» полей и типов.

Protobuf также помогает дисциплинировать эволюцию API: изменения проходят через обновление схемы и ревью, а не «тихо» в продакшене.

Компромисс: снаружи JSON, внутри Protobuf

Частый практичный вариант — оставить JSON на внешнем периметре (партнёры, браузер, простая интеграция), а внутри микросервисов и между дата-центрами использовать Protobuf/gRPC. Границу можно оформить как BFF/API Gateway, где происходит трансформация и валидация.

Практический чеклист выбора

- Потребители: внешние/публичные клиенты → чаще JSON; контролируемая среда → можно Protobuf.

- Производительность: узкие места по сети/CPU/latency → склоняет к Protobuf.

- Контракт: нужен строгий, типизированный договор и генерация SDK → Protobuf.

- Инфраструктура: прокси, кэш, наблюдаемость и привычные инструменты заточены под JSON?

- Команда и сроки: кому проще поддерживать и отлаживать формат прямо сейчас.

- Долгая жизнь API: ожидаются частые версии и совместимость назад → продумайте схему и правила изменений заранее (для обоих форматов).