03 окт. 2025 г.·8 мин

RabbitMQ для приложений: очереди, надежность и масштаб

Практическое руководство по RabbitMQ: когда он нужен, как настроить обменники и очереди, надежную доставку, ретраи, мониторинг и масштабирование.

Зачем приложениям RabbitMQ: базовые идеи

RabbitMQ — это брокер сообщений: отдельный сервис, который принимает сообщения от одних частей системы и доставляет их другим. Его ключевая роль — развязать компоненты приложения во времени и по нагрузке. Один сервис может «положить» событие или задачу в очередь, а другой — обработать позже, в своём темпе.

Какую проблему решает брокер сообщений

Без брокера интеграции часто строятся на прямых HTTP-вызовах. Это удобно, пока всё стабильно. Но если получатель временно недоступен или перегружен, запросы начинают падать, растёт время ответа, появляются цепочки ретраев и эффект домино.

RabbitMQ добавляет промежуточный слой: отправитель публикует сообщение и не обязан ждать, пока получатель всё обработает. В результате система становится устойчивее к всплескам трафика и частичным сбоям.

Чем RabbitMQ отличается от «очереди в базе» и HTTP

Очередь в базе данных — это обычно самодельная схема: таблица, статусы, блокировки, фоновые воркеры. Это работает, но часто упирается в конкуренцию за записи, сложность «честной» доставки и влияние на основную транзакционную БД.

HTTP — про запрос/ответ «здесь и сейчас». RabbitMQ — про асинхронную доставку и буферизацию: сообщение можно принять, сохранить и отдать потребителю, когда тот готов.

Типовые роли

- Producer (producer/паблишер) — отправляет сообщения.

- Broker (RabbitMQ) — принимает, хранит и маршрутизирует.

- Consumer (потребитель/воркер) — забирает сообщения и выполняет работу.

Короткий сценарий

Пользователь оформляет заказ. Сервис заказов создаёт запись и публикует событие «Заказ создан». Далее:

- сервис уведомлений отправляет письмо и пуш;

- сервис аналитики пишет событие в хранилище;

- фоновые воркеры запускают проверку оплаты, резервирование товара, генерацию документов.

Важно: если уведомления временно «лежат», заказ всё равно создаётся — сообщения подождут в очереди, а обработка догонит позже.

Когда RabbitMQ подходит, а когда лучше выбрать другое

RabbitMQ стоит добавлять не «для красоты», а когда приложение начинает страдать от непредсказуемой нагрузки и высокой связности между компонентами. Очередь сообщений разрывает прямую зависимость между отправителем и получателем: один сервис быстро кладёт задачу, другой — забирает и выполняет, когда готов.

Признаки, что пора ставить очередь

Если узнаёте хотя бы пару пунктов — очередь почти наверняка упростит жизнь:

- Пики нагрузки: периодически прилетает в 10–100 раз больше запросов, чем обычно, и система «задыхается».

- Долгие операции: генерация отчётов, обработка файлов, отправка писем/SMS, расчёты — всё это лучше выносить в фон.

- Интеграции: нужно надёжно отправлять события/заказы во внешние системы и переживать их временные сбои.

- Нужно управлять темпом: ограничивать количество параллельных обработчиков и не перегружать БД/партнёров.

Когда RabbitMQ может быть лишним

RabbitMQ не обязателен, если поток простой и нагрузка мала:

- обычные CRUD-сценарии без тяжёлых фоновых задач;

- один монолит, мало внешних интеграций, ошибки легко повторить вручную;

- требования к доставке «best effort» (потеряли уведомление — не критично).

Иногда лучше выбрать другое. Например, если нужен строгий порядок и replay событий на длинных промежутках, чаще смотрят в сторону лог-ориентированных брокеров (Kafka-подобные). Если нужна совсем минимальная задержка внутри одного процесса — подойдёт простой job-раннер без отдельного брокера.

Сверяемся с требованиями бизнеса

Перед выбором зафиксируйте: допустимую задержку (мс/сек/мин), уровень надёжности (можно ли терять сообщения), важен ли порядок, и сколько стоит простой/потеря событий. Эти ответы определят сложность решения и бюджет эксплуатации.

Как прикинуть объём сообщений и рост

Оцените текущие сообщения/сек и пиковые значения, средний размер сообщения, сколько потребителей будет обрабатывать параллельно. Добавьте прогноз роста (например, x2 за год) и заложите запас по пикам — это поможет понять, нужен ли брокер уже сейчас и каким должен быть стартовый масштаб.

Ключевые компоненты RabbitMQ и термины

RabbitMQ чаще всего используют через протокол AMQP 0-9-1. Чтобы уверенно читать документацию и настройки, полезно разобраться в базовых сущностях: как приложение подключается, куда «кладёт» сообщения и почему получатель читает их не оттуда, куда вы отправляли.

AMQP «на пальцах»: соединение, канал, публикация, потребление

Приложение устанавливает connection (TCP-соединение) к брокеру. Это относительно «дорогая» штука: её обычно держат открытой.

Внутри connection создаются channels — лёгкие виртуальные потоки. Почти все операции идут через канал: объявление очередей, публикация, потребление. Типичный паттерн: 1 connection на процесс и несколько channels под разные задачи.

Дальше:

- publish: приложение публикует сообщение в exchange (а не в очередь напрямую);

- consume: потребитель подписывается на очередь и получает сообщения из неё.

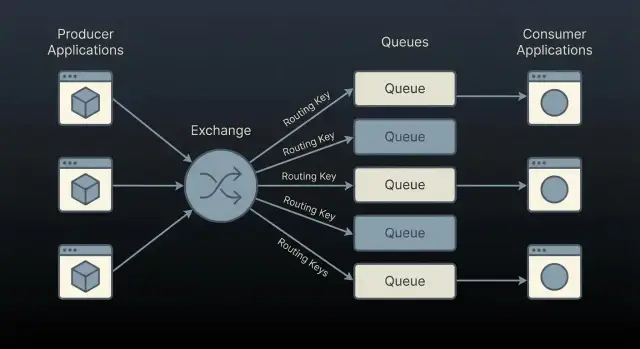

Exchange, Queue, Binding — как связаны

- Exchange — «узел маршрутизации». Он принимает опубликованное сообщение и решает, в какие очереди его доставить.

- Queue — буфер, где сообщения лежат до обработки.

- Binding — правило связи между exchange и queue (часто с ключом маршрутизации).

Упрощённая схема: Producer → Exchange → (Binding rules) → Queue → Consumer.

Важно: если вы опубликовали сообщение в exchange, но ни одна binding не подошла, сообщение может быть потеряно (или возвращено — зависит от настроек публикации и флагов).

Message properties: headers, content-type, delivery-mode

Сообщение состоит из тела (payload) и properties (метаданных). На практике чаще всего используют:

- headers — дополнительные поля (например, версия события, tenant, trace-id);

- content-type — как интерпретировать тело (например,

application/json); - delivery-mode — режим доставки: 2 означает «persistent» (сообщение переживёт перезапуск брокера при условии, что очередь тоже durable).

Properties не заменяют контракт данных, но помогают маршрутизировать, отлаживать и совместимо развивать интеграции.

Виртуальные хосты (vhost): изоляция окружений и команд

vhost — логическая «песочница» внутри одного RabbitMQ. В каждом vhost свои exchange/queue/binding и свои права доступа.

Практичные сценарии:

- разделить

dev,stage,prodна одном кластере (если так принято в компании); - изолировать команды/продукты, чтобы имена очередей не конфликтовали;

- выдавать доступ сервису строго к нужному vhost, уменьшая риск случайных публикаций «не туда».

Это база. Дальше выбор типа exchange, подтверждения и ретраи будут восприниматься как настройка поведения поверх понятной схемы.

Выбор exchange и маршрутизации под задачу

Правильный выбор exchange в RabbitMQ определяет, насколько легко вам будет расширять систему: добавлять новых потребителей, вводить новые типы событий и не превращать маршрутизацию в набор исключений.

Direct: маршрутизация по routing key — простой старт

Direct exchange отправляет сообщение в те очереди, где binding key точно совпадает с routing key.

Это хороший вариант для «команд» и точечных задач: например, billing.charge или email.send. Плюсы — предсказуемость и простая отладка. Минус — при росте количества типов сообщений может появиться много отдельных ключей и биндингов.

Topic: шаблоны ключей — удобно для событий домена

Topic exchange сопоставляет routing key по шаблонам (например, order.* или order.#). Он особенно удобен для событий, когда разные сервисы подписываются на разные подмножества.

Пример: события заказов.

order.createdorder.paidorder.shipped

Сервис аналитики может слушать order.#, а сервис уведомлений — только order.paid и order.shipped. Такой подход хорошо масштабируется: добавили новый сервис — добавили binding, издателя трогать не нужно.

Fanout: широковещательные уведомления

Fanout exchange игнорирует routing key и отправляет сообщение во все привязанные очереди.

Подходит для простых broadcast-сценариев: «сбросить кэш», «обновить конфигурацию», «переоткрыть фичи». Важно помнить: fanout легко создаёт неожиданный трафик, если к exchange привязывают очереди без строгого контроля.

Headers: когда ключей недостаточно, но важны атрибуты

Headers exchange маршрутизирует по заголовкам AMQP (например, type=invoice, region=EU). Его стоит выбирать, когда routing key становится перегруженным или нужна маршрутизация по нескольким независимым признакам.

Обычно это инструмент «последней необходимости»: заголовки хуже читаются в логах и сложнее стандартизируются.

Практические правила именования

Хорошие имена экономят время на поддержке и расследованиях:

- Exchange:

<domain>.<purpose>—order.events,billing.commands. - Routing key (для topic):

<domain>.<entity>.<event>или<domain>.<event>—order.created,user.password_reset. - Queue:

<service>.<domain>.<subscription>—notify.order.paid,analytics.order.all.

Договоритесь о словаре событий и не меняйте семантику существующих ключей: вместо «переопределения» добавляйте новый ключ/событие. Это снижает риск тихих потерь и неожиданных подписок.

Надёжная доставка: persistency, confirms и ack

Надёжность в RabbitMQ складывается из нескольких «слоёв»: что переживёт перезапуск брокера, как издатель (producer) понимает, что сообщение принято, и как потребитель (consumer) подтверждает обработку. Если хотя бы один слой настроен «по умолчанию», вы можете получить потери или неожиданные повторы.

Durable очереди и persistent сообщения

Частая путаница: durable очередь и persistent сообщение — разные настройки.

- Durable queue означает, что сама очередь (её метаданные) будет восстановлена после рестарта брокера.

- Persistent message (delivery_mode=2) просит брокер сохранить сообщение на диск.

Чтобы сообщения действительно переживали перезапуск, обычно нужны оба условия: очередь durable и сообщения persistent. Даже тогда возможны нюансы (например, сообщения могут быть в памяти до записи на диск), поэтому следующий слой — подтверждения от брокера — критичен.

Publisher confirms: брокер принял сообщение?

Publisher confirms — механизм, когда producer получает подтверждение, что брокер принял сообщение (и, в зависимости от конфигурации, успел его зафиксировать).

Смысл простой: если публикация не подтвердилась (таймаут/negative ack), producer должен повторить отправку или сохранить событие для повторной попытки. Без confirms вы можете «успешно» отправить сообщение из приложения, но потерять его при проблемах на стороне брокера.

Consumer ack/nack/reject: когда подтверждать

Consumer должен отправлять ack только после того, как работа реально сделана (например, запись в БД завершилась).

- ack — сообщение обработано, можно удалить из очереди.

- nack — обработка не удалась; можно вернуть сообщение в очередь (requeue=true) или отправить дальше (requeue=false).

- reject — отклонение одного сообщения (похоже на nack для единичного случая).

Если подтверждать «сразу при получении», вы рискуете потерять сообщения при падении consumer.

Prefetch (QoS): контроль параллелизма

prefetch ограничивает, сколько неподтверждённых сообщений RabbitMQ выдаёт consumer одновременно. Это защищает от перегрузки и помогает справедливости: быстрые потребители не простаивают, а медленные не «захватывают» очередь.

«По крайней мере один раз» vs «ровно один раз»

С типичной связкой confirms + ack вы получаете доставку at-least-once: сообщение будет обработано минимум один раз, но иногда — дважды (при ретраях/переподключениях).

Exactly-once на уровне брокера обычно недостижимо в реальных сбоях, поэтому практичная цель — проектировать обработчики так, чтобы повтор не ломал систему (например, через уникальные ключи/дедупликацию на стороне данных).

Повторы, идемпотентность и DLQ без боли

Вынесите работу в фон

Сделайте фоновые задачи для долгих операций и разгрузите API.

RabbitMQ не обещает «ровно один раз». Сеть может моргнуть, потребитель упасть после обработки, а подтверждение (ack) не успеть уйти — и сообщение придёт снова. Поэтому правильный вопрос не «как убрать повторы», а «как сделать повторы безопасными».

Почему повторы неизбежны и как это влияет на дизайн

Даже при аккуратных ack вы обычно получаете семантику at-least-once (как минимум один раз). Значит, обработчик должен выдерживать повторную доставку без двойных списаний, дублей писем и «разъехавшихся» статусов.

Идемпотентность потребителя: ключи дедупликации, уникальные операции

Практичный подход — делать операции идемпотентными:

- Ключ дедупликации: кладите в сообщение

event_id/command_id(UUID) и храните «уже обработанные» в БД/кеше с TTL. - Уникальные ограничения: если вы создаёте запись, используйте уникальный индекс (например, по

event_id) и обрабатывайте конфликт как «уже сделано». - Идемпотентные обновления: применяйте изменения через «версию»/

updated_at/условный апдейт, чтобы повтор не откатывал состояние назад.

Важно: дедупликация должна быть рядом с реальным эффектом (в той же транзакции), иначе появится окно гонки.

Retry с задержкой: TTL + DLX или плагины

Для повторов с паузой чаще всего используют:

- TTL + DLX: сообщение попадает в «задерживающую» очередь с TTL, по истечении уходит через dead-letter exchange обратно в рабочую очередь.

- Delayed Message Plugin: удобнее для разных задержек на одно и то же направление, но это дополнительный компонент — проверьте политику эксплуатации.

Делайте задержку ступенчатой (например, 10с → 1м → 10м) и храните счётчик попыток в заголовках.

DLQ: что туда отправлять и как разбирать причины

DLQ — не «мусорка», а очередь для разбирательств. Туда стоит отправлять сообщения, которые:

- превышают лимит попыток;

- ломаются из‑за схемы/валидации;

- требуют ручного решения (например, неизвестный клиент).

Организуйте процесс: метрики по DLQ, алерты и понятные причины в заголовках/логах.

Poison messages: защита от бесконечных циклов

«Ядовитые» сообщения (всегда падают) опасны тем, что могут занять воркеры. Защита простая: лимит ретраев, перевод в DLQ и отдельная процедура повторной подачи после исправления (с новым event_id, если это важно для дедупликации).

Паттерны интеграции: события, команды, outbox

RabbitMQ часто воспринимают как «универсальный клей» между сервисами. На практике устойчивые интеграции строятся на понятных паттернах и чётких ожиданиях: кто инициатор, кто отвечает за результат, какие гарантии доставки нужны.

Команды vs события

Команда — адресное намерение: «сделай X» (обычно одному получателю). Отправитель ожидает, что работа будет выполнена, и зачастую важен контроль ошибок.

Событие — факт: «X произошло» (полезно многим подписчикам). Публикатор не должен знать, кто и как отреагирует. Это снижает связность, но повышает требования к идемпотентности и совместимости сообщений.

Хорошее правило: команды помогают управлять процессом, события — информировать. Не подменяйте одно другим — иначе сложнее отлаживать ответственность.

RPC поверх RabbitMQ: допустимо, но осторожно

RPC (request/reply) поверх очередей используют, когда действительно нужен синхронный ответ, но прямой HTTP-вызов невозможен.

Риски: рост задержек, таймауты, накопление «висящих» запросов, сложности с ретраями (можно случайно выполнить операцию дважды). Если выбираете RPC, обязательно задавайте таймауты, correlation-id, лимиты параллелизма и продумывайте поведение при повторной доставке.

Саги и оркестрация

Для бизнес-процессов из нескольких шагов применяют саги: либо оркестратор координирует команды и слушает события, либо используется хореография на событиях.

Важно не превращать брокер в «магическую шину», где логика процесса размазана по подписчикам без явного владельца. Обычно проще сопровождать процесс, когда есть один сервис-«дирижёр» и прозрачные компенсирующие действия.

Outbox-паттерн: согласованность БД и публикации

Типичная проблема: сервис записал изменения в БД, но не смог опубликовать сообщение (или наоборот). Outbox решает это: вместе с бизнес-транзакцией в БД пишется запись в outbox-таблицу, а отдельный воркер надёжно публикует события в RabbitMQ.

Так вы уменьшаете риск «потерянных» событий и упрощаете повторную отправку.

Версионирование сообщений и совместимость

Сообщения живут дольше кода. Добавляйте поля так, чтобы старые потребители могли их игнорировать, а новые — работать при отсутствии поля. Полезно иметь явную версию схемы (например, в заголовке) и заранее договориться о правилах: изменения «только добавлением» и постепенное удаление полей после периода совместимости.

Масштабирование и производительность очередей

Проверьте поведение под пиками

Настройте деплой и хостинг проекта, чтобы быстрее проверить нагрузку и стабильность.

RabbitMQ хорошо масштабируется, если заранее договориться о модели параллелизма: сколько consumer’ов вы запускаете, сколько потоков/воркеров внутри каждого и какая «единица работы» у сообщения. Частая ошибка — увеличивать число consumer’ов без контроля prefetch: один быстрый потребитель забирает слишком много сообщений и держит их «в обработке», пока другие простаивают.

Сколько consumer’ов и как планировать потоки

Практика: начинайте с небольшого числа процессов (например, 2–4 на инстанс) и регулируйте prefetch так, чтобы в работе у каждого было ровно столько сообщений, сколько он реально успевает обработать. Если обработка CPU‑тяжёлая — масштабируйте по числу ядер. Если I/O — можно больше параллелизма, но следите за ростом задержки.

Порядок и распараллеливание: per‑key ordering

Если важен порядок «по ключу» (например, по userId), один общий поток сообщений быстро станет бутылочным горлышком. Решение — очереди‑шарды: маршрутизируйте сообщения по ключу в N очередей (consistent hash или явный номер шарда), сохраняя порядок внутри каждой очереди, но позволяя параллельность между шардами.

Автомасштабирование: что мерить

Автомасштабирование обычно строят по одному из сигналов:

- длина очереди (backlog);

- задержка (age of oldest message);

- throughput (сообщений/сек) и время обработки.

Длина очереди полезна, но задержка часто отражает пользовательскую боль точнее.

Кластер и очереди: зеркалирование vs quorum

Для высокой надёжности чаще выбирают quorum queues: они устойчивее к сбоям и предсказуемее по консистентности. Классическое зеркалирование (mirrored) встречается в старых установках и требует осторожности: сложнее в эксплуатации и может давать неприятные сюрпризы при сетевых проблемах.

Ограничения: память, диск, размер сообщений

Большие сообщения — главный враг производительности: растут сетевые расходы, давление на память и диск, время репликации. Хороший ориентир — передавать через очередь «указатель» (id) и метаданные, а payload хранить отдельно.

Также учитывайте: persistent‑сообщения и durable‑очереди увеличивают нагрузку на диск, поэтому важны быстрые диски и контроль объёма очередей, чтобы не упереться в alarm по памяти/диску.

Мониторинг и диагностика проблем RabbitMQ

Хороший мониторинг RabbitMQ — это способность быстро ответить на вопросы: где узкое место, что именно тормозит доставку и что делать прямо сейчас.

Встроенные метрики: что смотреть в первую очередь

Начните с показателей, которые почти всегда объясняют происходящее:

- Ready vs Unacked: ready — сообщения ждут потребителя, unacked — уже выданы, но не подтверждены.

- Publish / Deliver / Ack rate: скорость публикации, выдачи и подтверждений. Важно сравнивать их между собой.

- Consumers: сколько активных потребителей на очереди и не «флапают» ли они (то появляются, то пропадают).

- Memory / Disk и watermark: приближение к лимитам часто приводит к замедлениям и блокировкам.

- Connections / Channels: резкий рост — типичный симптом утечек или неправильного пула соединений.

Логи и трассировка: correlation-id и цепочки причин

Метрики показывают «что», а логи — «почему». Договоритесь, что каждое сообщение несёт correlation_id (или свой trace-id) и ключевые сервисы пишут его в логи. Тогда можно восстановить цепочку: публикация → маршрутизация → получение → обработка → ack/nack.

Если есть распределённая трассировка, связывайте спаны по тому же идентификатору — так проще отличить проблему в RabbitMQ от медленной БД или внешнего API.

Алёрты: что должно будить

Полезные сигналы для оповещений:

- рост unacked (потребители «зажевали» сообщения или долго обрабатывают);

- рост ready при стабильном publish rate (не хватает consumers или они падают);

- disk usage близко к порогу + признаки блокировок;

- внезапное падение числа consumers на критичных очередях.

Тестовая нагрузка: как воспроизводить пики и деградации

Чтобы ловить проблемы до продакшена, делайте короткие нагрузочные прогоны: разгоните publish rate, искусственно замедлите обработчик (sleep/ограничение внешнего API), посмотрите, где первым «сыпется» — потребители, сеть, диск или лимиты RabbitMQ.

Чек‑лист, когда «очередь растёт»

-

Очередь растёт в ready или в unacked?

-

Есть ли consumers и стабильны ли они?

-

Deliver rate ≈ Publish rate? Если нет — где провал.

-

Выросло время обработки у потребителя (логи по correlation_id)?

-

Нет ли блокировок по disk/memory и ошибок соединений?

Безопасность: доступ, TLS и изоляция

RabbitMQ часто становится «центральной шиной» между сервисами — и именно поэтому его стоит защищать так же внимательно, как базу данных. Хорошая новость: базовые меры несложны, если внедрить их с самого начала.

Аутентификация и права

Начните с разделения окружений и команд через vhost. Один vhost на dev/stage/prod (или хотя бы отдельный для prod) помогает изолировать очереди, обменники и права.

Создавайте отдельных пользователей для приложений и для людей. Людям обычно нужен доступ через Management UI, а приложениям — только AMQP.

- Теги пользователей (например,

administrator,monitoring) выдавайте строго по необходимости. - Разрешения на vhost задавайте на чтение/запись/конфигурацию и ограничивайте регулярками только нужные сущности. Приложению почти никогда не нужен

configureна.*.

TLS: когда включать и что учесть

TLS стоит включать всегда, когда трафик выходит за пределы одного доверенного сегмента сети: между хостами, в Kubernetes, через VPN, в облаке или при доступе внешних потребителей.

Что важно учесть:

- Клиентам понадобится правильный CA/сертификат и корректный hostname (SNI).

- Убедитесь, что включены безопасные версии протокола/шифры и настроена проверка сертификата, а не «шифрование ради галочки».

- Часто удобно держать отдельный порт для TLS (обычно 5671) и отключить небезопасный доступ там, где он не нужен.

Секреты и ротация паролей в окружениях

Не храните пароли в репозитории и в .env на ноутбуках. Используйте менеджер секретов (Vault/Secret Manager/Kubernetes Secrets) и разные учётные данные для dev/stage/prod.

Ротацию делайте планово:

- создайте нового пользователя/пароль,

- обновите конфиги приложений,

- убедитесь, что старые подключения исчезли,

- удалите старый секрет.

Ограничение доступа по сети и портам

Ограничьте доступ на уровне сети: разрешайте подключения к AMQP‑портам только от приложений, а к Management UI (обычно 15672) — только из админской сети/VPN.

Идеально, когда RabbitMQ вообще не «смотрит» в интернет, а доступ возможен лишь через внутренний firewall/security groups.

Защита от злоупотреблений

Чтобы один сервис не «положил» брокер:

- ограничьте размер сообщений (лучше передавать ссылки на объекты, а не мегабайты данных);

- настройте политики очередей (например,

max-length,max-length-bytes, TTL), чтобы очереди не росли бесконечно; - задайте лимиты на уровне vhost/пользователя (подключения/каналы), если у вас много клиентов.

Эти меры дают понятную изоляцию: кто может подключаться, что может делать и сколько ресурсов способен потребить.

Развёртывание и эксплуатация: от dev до продакшена

Спланируйте переход на очередь

Запланируйте изменения архитектуры в planning mode и оцените риски заранее.

RabbitMQ часто «взлетает» быстро на ноутбуке и неожиданно начинает капризничать в продакшене. Разница обычно не в очередях как таковых, а в эксплуатационных мелочах: политиках, лимитах, порядке обновлений и том, как вы управляете конфигурацией.

Минимальный набор для продакшена

Начните с базовых правил, которые предотвращают самые частые аварии:

- Политики очередей: выставьте

x-queue-type(classic/quorum), лимиты на длину/размер (max-length,max-length-bytes) и (при необходимости) TTL для сообщений/очередей. - Пределы ресурсов: контролируйте рост очередей и соединений, чтобы один «шумный» сервис не съел память и диск.

- Нейминг и изоляция: отдельные vhost’ы по окружениям/командам, отдельные пользователи с минимальными правами.

Конфигурация как код

Держите настройки в репозитории и применяйте их автоматически:

rabbitmq.confиadvanced.config— как часть инфраструктурного проекта.- definitions.json (пользователи, vhost, permissions, exchanges, queues, bindings) — удобно накатывать одинаково на dev/stage/prod.

- Политики и параметры — через код и CI/CD, а не вручную из UI.

Обновления и миграции: безопасный порядок действий

Планируйте обновления как изменения в базе данных: заранее и по шагам. Сначала проверьте совместимость версий Erlang/RabbitMQ и плагинов. Затем делайте rolling update (по одному узлу), контролируя состояние кластера и репликацию очередей.

Любые изменения типа очереди или ключевых аргументов (например, quorum вместо classic) лучше оформлять как миграцию: новая очередь → переключение продюсеров/консьюмеров → удаление старой.

Резервное копирование: что можно восстановить и чего нельзя

RabbitMQ можно восстановить по-разному:

- Конфигурацию (definitions, политики, пользователи) — почти всегда.

- Сообщения — только если они персистентные и вы понимаете, как восстанавливать данные конкретного типа очередей и хранилища.

На практике часто делают ставку на повторную публикацию событий/команд, а не на «бэкап очереди».

Среда разработки без сюрпризов

Поднимайте RabbitMQ локально через Docker с теми же definitions и политиками, что и в продакшене (только с меньшими лимитами). Так ошибки маршрутизации, отсутствующие очереди или неверные права проявятся до релиза, а не после.

Быстрый прототип очередей на TakProsto.AI

Если вы собираете сервис на TakProsto.AI (vibe-coding платформа для российского рынка), удобно проверять архитектурные гипотезы с очередями ещё на раннем этапе: вы описываете сценарии в чате, а платформа помогает быстро собрать приложение (типичный стек — React на фронтенде и Go + PostgreSQL на бэкенде) и подключить инфраструктурные компоненты вроде RabbitMQ.

Практически это полезно, когда вы хотите:

- вынести долгие операции в фоновые воркеры и посмотреть поведение под пиками;

- добавить ретраи/DLQ и убедиться, что обработчики идемпотентны;

- быстро сделать «планирование» изменений (planning mode) и откатиться на снапшот/rollback, если эксперимент оказался неудачным.

Отдельный плюс для проектов с требованиями по локализации и данным: TakProsto.AI работает на серверах в России и использует локализованные/opensource LLM‑модели, не отправляя данные в другие страны.

Частые ошибки и как их избежать

Даже правильно настроенный RabbitMQ может начать «сыпаться» из‑за нескольких типовых промахов. Ниже — самые частые и практичные способы их предотвратить.

1) Слишком большие сообщения

Большие payload (десятки/сотни КБ и больше) увеличивают задержки, нагрузку на диск/память и время восстановления.

Правило: в очередь — только «конверт», а данные — отдельно. Вынесите тяжёлый payload в объектное хранилище (S3/MinIO), а в событии передавайте ссылку, ключ и контрольную сумму/версию. Так проще ретраи и меньше риск «раздуть» брокер.

2) Смешивание разных типов сообщений в одной очереди без схемы

Когда в одной очереди живут события, команды и «техничка» без явного контракта, потребители начинают обрастать условными ветками и ломаются при изменениях.

Решение: разделяйте по назначению (разные очереди/маршруты) и фиксируйте схему. Минимум — поле type и version в каждом сообщении, описанный JSON Schema/Avro/Proto и правила совместимости (например, только добавление необязательных полей).

3) Нет ограничений prefetch — и память «уезжает»

Если потребитель забирает слишком много сообщений «в полёт», он может накапливать их в памяти и увеличивать время обработки.

Решение: задайте prefetch (QoS) под время обработки и объём памяти. Начните с 10–50 на поток и измеряйте. Если обработка тяжёлая — уменьшайте, если лёгкая — повышайте.

4) Нет DLQ и стратегии retry

Без DLQ сообщения либо теряются, либо бесконечно падают и «крутятся».

Решение: делайте retry с ограничением попыток и задержкой (TTL + dead-lettering или отдельная delay-очередь), а после лимита — в DLQ с причиной ошибки. В DLQ должны быть понятные метаданные (счётчик попыток, timestamp, error).

5) Непродуманное именование и отсутствие версионирования

Хаотичные имена очередей и exchange усложняют поддержку и миграции.

Решение: договоритесь о шаблоне имён (например, app.env.domain.event.v1), версионируйте публичные маршруты и не меняйте смысл существующих ключей маршрутизации — добавляйте новые.

FAQ

Зачем приложению RabbitMQ, если можно вызывать сервисы по HTTP?

RabbitMQ добавляет промежуточный слой между компонентами: отправитель публикует сообщение и не ждёт, пока получатель выполнит работу.

Это снижает связность и делает систему устойчивее к всплескам трафика и временной недоступности отдельных сервисов: сообщения «подождут» в очереди, а обработка догонит позже.

Как понять, что RabbitMQ уже нужен, а не «для красоты»?

Как правило, очередь помогает, если появляются:

- пики нагрузки (в разы выше среднего);

- долгие операции (файлы, отчёты, письма/SMS, расчёты), которые лучше выполнять в фоне;

- интеграции, где нужно переживать временные сбои партнёров;

- необходимость управлять темпом обработки (ограничить параллелизм, не перегружать БД/API).

Если у вас простой CRUD и низкая нагрузка, брокер может быть лишним усложнением.

Какие базовые сущности RabbitMQ нужно понимать в первую очередь?

Основная схема такая: Producer → Exchange → (bindings) → Queue → Consumer.

Producer публикует сообщение в exchange, а consumer читает из очереди. Routing происходит через bindings (часто с routing key). Это важно помнить: «публикация в очередь» обычно на деле означает «публикация в exchange, который маршрутизирует в нужную очередь».

Как выбрать тип exchange (direct/topic/fanout/headers) под задачу?

Выбор зависит от того, как вы хотите подписывать потребителей:

- direct — точное совпадение routing key (просто для команд/задач);

- topic — шаблоны ключей (

order.*,order.#), удобно для доменных событий; - fanout — широковещательно во все привязанные очереди (broadcast);

- headers — маршрутизация по заголовкам, когда ключей недостаточно (используйте осторожно).

Практика: для событий чаще начинают с topic, для адресных задач — с direct.

В чём разница между durable-очередью и persistent-сообщением?

Это разные уровни надёжности:

- durable queue — очередь переживёт перезапуск (восстановятся метаданные);

- persistent message (

delivery_mode=2) — сообщение стараются сохранить на диск.

Чтобы сообщения обычно переживали рестарт, нужны оба условия: очередь durable и сообщения persistent. Для реальной гарантии добавьте ещё и publisher confirms со стороны producer.

Что такое publisher confirms и почему без них легко потерять сообщения?

Publisher confirms — механизм, по которому producer получает подтверждение от брокера, что сообщение принято (и в нужной степени зафиксировано).

Без confirms вы можете «успешно» отправить сообщение из приложения, но потерять его при проблемах на стороне сети/брокера. С confirms появляется понятная стратегия: таймаут/negative ack → повторить отправку или сохранить событие для повторной публикации.

Когда consumer должен делать ack и чем отличаются nack/reject?

Consumer должен отправлять ack только после того, как реальный эффект выполнен (например, запись в БД успешно завершилась).

ack— обработано, удалить из очереди;nack/reject— обработка не удалась (можно вернуть в очередь или отправить в DLQ в зависимости от настроек).

Если подтверждать сразу при получении, при падении consumer вы потеряете сообщения (они уже будут «подтверждены»).

Зачем настраивать prefetch (QoS) и что будет, если его не ограничить?

prefetch ограничивает число неподтверждённых сообщений, которые брокер выдаёт consumer одновременно.

Это помогает:

- не перегружать воркер (и его память);

- распределять работу справедливее между разными consumer’ами;

- контролировать параллелизм и давление на БД/внешние API.

Частая практика — начать с небольшого значения и подбирать по времени обработки и ресурсам.

Как правильно делать retry и DLQ, чтобы не получить бесконечные циклы и дубли?

Повторы нормальны для схемы at-least-once: consumer мог упасть после обработки, а ack не успел уйти — сообщение придёт снова.

Чтобы повторы были безопасны:

- добавляйте

event_id/command_idи делайте дедупликацию рядом с эффектом (часто в БД); - используйте уникальные индексы (конфликт = «уже обработано»);

- вводите retry с задержкой (TTL + DLX или delayed message plugin) и лимит попыток;

- после лимита отправляйте в DLQ с причиной ошибки.

DLQ — это очередь для разбирательств, а не «свалка без мониторинга».

Что такое outbox-паттерн и зачем он нужен при публикации событий?

Проблема: сервис записал изменения в БД, но не смог опубликовать сообщение (или наоборот) — получаются «дыры» в событиях.

Outbox решает это так:

- в одной транзакции с бизнес-изменением пишется запись в outbox-таблицу;

- отдельный воркер надёжно публикует outbox-события в RabbitMQ.

Итог: проще повторная отправка и меньше риск потерять событие из-за временных сбоёв брокера/сети.