09 окт. 2025 г.·8 мин

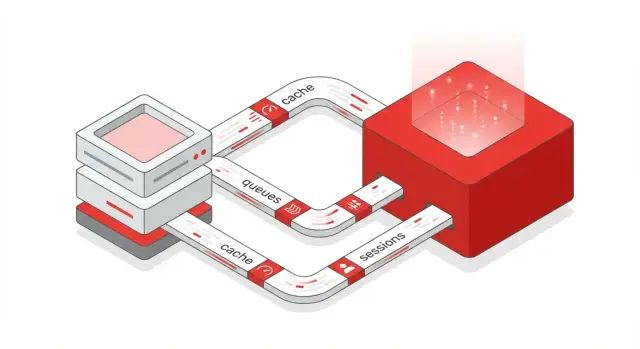

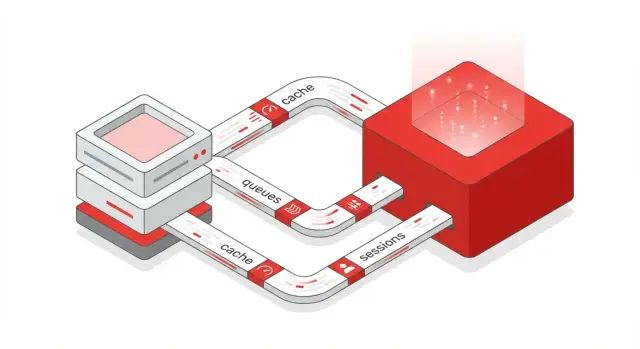

Redis для приложений: кэш, очереди и быстрые операции

Понятное руководство по Redis: когда он нужен приложению, как выбрать структуры данных, настроить кэш и очереди, обеспечить надежность и безопасность.

Понятное руководство по Redis: когда он нужен приложению, как выбрать структуры данных, настроить кэш и очереди, обеспечить надежность и безопасность.

Redis — это хранилище «ключ–значение», которое чаще всего работает в памяти. Поэтому он отвечает очень быстро: чтение и запись обычно сводятся к операциям над значением по ключу — без сложных JOIN и тяжёлых запросов.

При этом Redis поддерживает не только строки, но и структуры данных (списки, множества, хэши и др.), что превращает его из «просто кэша» в универсальный инструмент для прикладных задач: временных состояний, счётчиков, очередей, обмена событиями.

Правильная модель — воспринимать Redis как дополнение к основной базе данных.

Простая формула: БД хранит, Redis ускоряет.

Чаще всего Redis используют для:

Redis не обязателен для любого проекта. Он может не окупиться, если приложение небольшое, запросов мало, нет заметных пиков нагрузки, а данные редко читаются повторно.

Также не стоит добавлять Redis «на всякий случай», если в команде нет времени поддерживать дополнительный сервис: конфигурацию, персистентность/бэкапы (если нужны), мониторинг, правила инвалидирования кэша.

Если же вы упираетесь в задержки из‑за частых одинаковых чтений или вам нужны быстрые временные данные и координация — Redis обычно даёт заметный выигрыш.

Redis редко заменяет основную БД — чаще он работает рядом с ней и делает приложение быстрее и стабильнее под нагрузкой. Удобно думать о Redis как о слое ускорения, временном складе и слое координации.

Самый частый сценарий — разгрузить основную БД на популярных чтениях: карточка товара, настройки витрины, результаты поиска по фильтрам, список рекомендаций.

Типовой поток такой:

Важно: кэш — это не место, где «данные обязаны быть». Ключ может отсутствовать (очистили, истёк TTL, случился eviction), поэтому приложение должно уметь пересчитать значение из БД.

Redis отлично подходит для данных, которые должны «жить недолго»: одноразовые коды, промежуточные результаты, черновики, флаги «пользователь уже видел подсказку», временные токены.

TTL позволяет автоматически удалять такие записи без отдельной уборки. Это снижает риск разрастания таблиц в БД из‑за временных сущностей и упрощает бизнес‑логику: записали — и забыли, через N минут ключ исчезнет сам.

Когда несколько экземпляров приложения работают параллельно, нужны общие «правила движения»: лимиты, счётчики, блокировки.

Здесь Redis ценен тем, что многие операции атомарны — меньше шансов на гонки и дубли.

Если данные критичны (заказы, платежи, учет), первичная запись и консистентность остаются в основной БД. Redis дополняет её: ускоряет доступ, хранит временное и помогает синхронизировать параллельные действия, но не должен быть единственной опорой для важных бизнес‑данных.

Redis ценят не только за скорость, но и за набор структур данных, которые «подсказывают» правильный способ хранить и доставать информацию. Если выбирать структуру под задачу, код становится проще, а нагрузка на базу данных — меньше.

String — универсальный тип для коротких значений: JSON‑ответы, флаги, токены, результаты вычислений.

SET cache:product:123 "{...json...}" EX 60

GET cache:product:123

Hash удобен, когда у объекта много полей, и вы хотите обновлять их выборочно. Типичный пример — профиль пользователя: имя, email, роль, настройки.

Плюс в том, что вы не обязаны перезаписывать весь JSON целиком, и можно получать только нужные поля.

HSET user:42 name "Анна" plan "pro" locale "ru"

HGET user:42 plan

HGETALL user:42

List часто используют как простую очередь задач: добавить в конец, забрать с начала. Это хорошо для базовых сценариев, где достаточно «взял и обработал».

Streams — более «событийный» вариант: сообщения идут с ID, можно читать группами, подтверждать обработку и держать несколько потребителей. Это удобно для обработки заказов, логов, уведомлений.

Set помогает обеспечивать уникальность и быстрые проверки «состоит ли элемент в наборе»: например, отметки «пользователь уже проголосовал» или список подписок.

ZSet добавляет сортировку по числовому score — идеальный вариант для топов, рейтингов, лидеров продаж, очередей с приоритетами.

ZINCRBY leaderboard:week 10 user:42

ZREVRANGE leaderboard:week 0 9 WITHSCORES

Спросите себя: значение одно или много полей? нужна уникальность? важен порядок? нужна сортировка по весу/времени?

Если вы автоматически тянетесь к «положим JSON в строку, как привыкли», проверьте, не дадут ли Hash/Set/ZSet более простой доступ и меньший трафик между приложением и Redis.

Кэш ускоряет чтение, но цена ошибки — «не те» данные у пользователя. Чтобы не ловить странные баги, важно заранее выбрать паттерн кэширования, договориться о формате ключей и продумать поведение при массовых промахах кэша.

Самый популярный вариант: приложение сначала читает из Redis, а при промахе — из базы данных, затем кладёт результат в кэш.

Плюсы: простота и контроль на стороне приложения.

Минусы: нужно аккуратно обновлять кэш при изменениях в БД, иначе данные могут устареть.

Практика: используйте TTL почти всегда, даже если кажется, что данные «вечные». Это снижает риск бесконечного хранения неправильного значения.

Write-Through: при записи приложение пишет и в БД, и в кэш (или пишет в кэш, который синхронно «прокидывает» запись дальше). Это уменьшает шанс прочитать старое значение сразу после обновления.

Write-Behind (Write-Back): приложение пишет в кэш, а в БД изменения уходят асинхронно. Быстрее по записи, но сложнее по надежности: нужна очередь/воркер, ретраи, контроль потерь, а также понятная стратегия восстановления.

Если вам важна строгая консистентность, Write-Behind подходит хуже: при сбое вы можете потерять часть записей или увидеть откат.

TTL — «страховка», но не гарант свежести. Инвалидация (удаление/обновление ключа при изменении данных) точнее, но сложнее: нужно найти все связанные ключи и сделать это корректно.

Компромисс: короткий TTL для «часто меняющегося», длинный TTL для «почти статичного», плюс явная инвалидация в критичных местах (например, при смене тарифа или прав доступа).

Единый формат ключей экономит часы отладки. Хороший шаблон: app:entity:version:id[:field], например shop:product:v3:123.

prod:/staging:.v3 → старое само отомрёт по TTL.Когда популярный ключ истекает, тысячи запросов могут одновременно пойти в БД.

Эти меры заметно снижают риск пиковых просадок и лавинообразной нагрузки на БД.

Redis часто используют как быстрый слой для сессий и данных авторизации, чтобы не дергать основную БД на каждом запросе. Главное — заранее решить, какие данные можно держать в памяти, как их протухать и как безопасно инвалидировать.

В Redis удобно хранить минимум, необходимый для проверки сессии: идентификатор пользователя, роли/права (если они редко меняются), время последней активности, флаги (например, «2FA пройдена»), служебные метаданные (IP/UA — если вы их используете).

Не стоит класть туда чувствительные данные «как есть»: пароли, секреты, длинные персональные профили, платёжные данные. Также опасно хранить «полный слепок пользователя», который часто меняется: получите рассинхронизации и сложные правила обновления.

Сессия в Redis почти всегда должна иметь TTL. Типичный подход — продлевать TTL при активности (sliding expiration), но делать это аккуратно: например, продлевать не на каждом запросе, а раз в N минут.

Для выхода пользователя недостаточно «ждать, пока TTL истечет». Нужна явная инвалидация:

Кэшировать результат проверки прав можно, но учитывайте отзыв прав: при изменении ролей нужно либо инвалидировать кэш, либо держать очень короткий TTL.

Если вы храните токены в Redis (например, refresh‑токены или allowlist/denylist), защищайте Redis как систему хранения секретов: шифрование на уровне приложения, минимальные ACL, изоляция сети. И никогда не логируйте токены целиком.

Один общий Redis упрощает SSO и централизованный logout, но повышает «радиус поражения» при сбое/перегрузке. Раздельные инстансы (или отдельные базы/кластеры) лучше изолируют сервисы и нагрузку, особенно если рядом есть очереди, счётчики и кэши.

Практичный компромисс — отдельный кластер/неймспейс под сессии и отдельные политики TTL и мониторинга для него.

Redis хорош там, где нужно быстро посчитать «сколько раз» и принять решение прямо в момент запроса: пропустить, притормозить, отклонить или поставить в очередь. Это помогает защитить API, уменьшить нагрузку на базу и внедрять простые антифрод‑правила.

Самый понятный вариант — фиксированное окно. Например, «не более 100 запросов в минуту на пользователя». Для этого заводят ключ вида rl:user:123:2025-12-23T10:15 и делают INCR + EXPIRE 60 (или задают TTL при первом создании). Если значение больше лимита — отвечаем 429.

У фиксированного окна есть эффект «края»: можно сделать 100 запросов в конце минуты и 100 в начале следующей.

Упрощённая версия скользящего окна — хранить два счётчика (текущий и предыдущий интервал) и считать взвешенную сумму по доле прошедшего времени. Это чуть сложнее, но сглаживает пики без тяжёлых расчётов.

Счётчики легко превращаются в правила:

А множества помогают отслеживать уникальные сущности. Например, SADD fraud:cards:user:123 <card_hash> с TTL на сутки: если количество уникальных карт за день превышает порог — повышаем риск. Аналогично можно считать уникальные IP, устройства или получателей.

Чтобы не обрабатывать повторно один и тот же запрос (двойной клик, ретраи), создают «замок идемпотентности»: SET idem:<request_id> 1 NX EX 60. Если ключ уже есть — значит, запрос недавно выполнялся, и можно вернуть сохранённый результат или аккуратно отказать.

Блокировки нужны, когда нельзя параллельно выполнять критическую секцию: например, списание денег, выдача купона «первым N», генерация единственного ресурса.

Минимальный безопасный шаблон — SET lock:<resource> <token> NX PX 10000, где <token> случайный. Снимать блокировку важно только владельцу (обычно через Lua‑скрипт, который сравнивает токен).

Опасности: слишком длинный TTL «замораживает» ресурс при сбое, слишком короткий — приводит к одновременной работе двух воркеров. Блокировка не заменяет транзакции в базе и требует аккуратного проектирования, особенно при долгих операциях.

Redis часто используют как быструю прослойку для фоновых задач: веб‑приложение складывает работу в очередь, а воркеры забирают и выполняют её вне критического пути запроса. Это разгружает API, сглаживает пики и надёжнее обрабатывает длинные операции (письма, генерация отчётов, обработка файлов).

Базовый вариант — producer добавляет задания, consumer их забирает. В Redis это обычно делается через списки: producer делает LPUSH, а воркер — блокирующее BRPOP, чтобы не крутить опрос в цикле.

Важно учесть два момента:

Списки решают первый пункт автоматически, а второй требует дополнительной логики (например, «в работе» и таймаутов).

Если вам нужна история событий, несколько групп потребителей и подтверждения обработки, лучше смотреть в сторону Redis Streams. Streams дают consumer groups и ACK: воркер может взять запись, обработать и подтвердить. Если воркер упал, сообщение остаётся «неподтвержденным», и его можно перераспределить.

Списки проще, но в них нет встроенного механизма подтверждений и повторного распределения «зависших» задач.

Повторы неизбежны: из‑за таймаутов, перезапусков, сетевых сбоев. Поэтому обработчик должен быть идемпотентным: одно и то же задание, выполненное дважды, не должно ломать данные.

Практичный подход — хранить job_id и отмечать «уже выполнено» в Redis (например, SET job:done:<id> 1 NX EX ...) или в основной базе. Тогда дубль станет безопасным no‑op.

Для задач «выполнить через N минут» часто используют sorted set: score = время выполнения, воркер периодически забирает все с score <= now. Это удобно, но требует аккуратной атомарности (забрать и удалить одним шагом, обычно через Lua).

Альтернатива — специализированные библиотеки очередей поверх Redis или отдельный планировщик. Важно заранее решить: насколько критична точность расписания и как вы будете восстанавливаться после простоя воркеров.

Redis Pub/Sub — простой способ разослать сигнал нескольким компонентам приложения одновременно. Один сервис публикует сообщение в канал, другие сервисы, подписанные на него, получают сообщение почти мгновенно.

У Pub/Sub нет очереди и подтверждений: если подписчик был отключён или перегружен, сообщение может быть пропущено. Redis не хранит историю сообщений в канале — «дослать позже» нечего.

Поэтому Pub/Sub лучше воспринимать как транспорт для эфемерных уведомлений, а не как механизм надёжной доставки.

Pub/Sub подходит, когда:

Лучше выбирать Redis Streams или очередь задач, когда:

Типичные сценарии Pub/Sub:

Чтобы подписчики не «захлёбывались», ограничивайте частоту событий (debounce/throttle), объединяйте мелкие события в батчи и фильтруйте по каналам (например, per‑user/per‑room).

Полезно логировать:

Практичное правило: Pub/Sub — для быстрых сигналов, Streams/очередь — для того, что нельзя потерять.

Redis работает в памяти, поэтому его часто воспринимают как «временное» хранилище. Но на практике персистентность полезна даже для кэша: она ускоряет перезапуск (warm start), помогает пережить рестарт контейнера или узла и снижает нагрузку на основную базу после аварии.

Персистентность — страховка от потери состояния. Если Redis хранит сессии, счётчики лимитов, очереди задач или данные для дедупликации, потеря памяти может вызвать массовые разлогины, скачки нагрузки и повторную обработку задач.

RDB (snapshot) периодически сохраняет снимок базы на диск.

AOF (append-only file) записывает изменения (команды) в журнал.

appendfsync everysec).Для контроля размера используется переписывание AOF (rewrite).

На практике выбирают компромисс: RDB как «точка восстановления» и AOF для уменьшения окна потери данных — или один режим, если требования простые.

Продумайте заранее:

Важно иметь понятный RTO/RPO: сколько времени сервис может быть недоступен и сколько данных допустимо потерять.

Если данные критичны и их нельзя восстановить из основной БД или повторной обработки (например, деньги, юридически значимые события), Redis лучше использовать как ускоритель, а «истиной» делать транзакционную БД.

Redis подходит для критичных данных только при осознанной архитектуре: репликации, бэкапах, контроле записи на диск и регулярных проверках восстановления.

Redis часто становится «точкой скорости» в приложении — и одновременно потенциальной точкой отказа. Поэтому стоит заранее продумать, как переживать падение узла и как расти по нагрузке.

Базовый шаг — репликация (primary/replica). Реплика получает данные асинхронно и может подхватить чтения, разгрузив основной узел.

Если основной узел падает, репликация сама по себе не переключит приложение на реплику — для этого нужна автоматизация (Sentinel) или внешний оркестратор.

Важно помнить: из‑за асинхронности возможна небольшая потеря последних записей при аварии. Для кэша это часто терпимо, для очередей и счётчиков — уже не всегда.

Sentinel — это про высокую доступность без горизонтального масштабирования данных: один основной узел, реплики и автоматический failover. Выбирайте Sentinel, если:

Redis Cluster — это про масштабирование по данным (и по нагрузке): ключи распределяются по нескольким мастерам (шардам), у каждого — свои реплики. Берите Cluster, если упираетесь в память/CPU одного узла или нужен рост без остановок.

Шардирование в Cluster меняет подход к ключам: данные распределяются по слотам, и некоторые операции «между ключами» требуют, чтобы ключи оказались в одном шарде.

Для этого используют hash tags — часть ключа в фигурных скобках, например user:{42}:profile и user:{42}:sessions. Тогда связанные ключи попадут в один слот.

Перед продом полезно прогнать сценарии отказов: отключение мастера, потеря сети, перезапуск узлов, деградация диска (если включена персистентность). Проверьте:

Так вы заранее поймёте, где Redis — просто ускоритель, а где компонент, требующий уровня надежности как у основной базы.

Redis часто считают «внутренним» компонентом, которому не нужна защита. Это опасная иллюзия: Redis умеет выполнять команды управления данными, а ошибки в сети или настройках могут превратить кэш в точку компрометации всего приложения.

Начните с простого: включите пароль и не оставляйте Redis доступным «без ключа». Но одного пароля мало — в Redis есть ACL (списки контроля доступа), которые позволяют:

app:*).Практика: выделяйте отдельные учётные записи для чтения/записи кэша, для фоновых задач и для администрирования. Так даже при утечке токена одного сервиса ущерб будет ограничен.

Если Redis и приложение живут на разных хостах/нодах, трафик может быть перехвачен или подменён. TLS особенно важен:

Внутри одного сервера шифрование может быть избыточным, но между машинами — это базовая гигиена. При этом TLS не заменяет сетевые ограничения.

Правило по умолчанию: Redis не должен быть доступен из публичного интернета. Ограничьте доступ на нескольких уровнях:

bind) и контроль порта;Ошибки операторов и скриптов случаются чаще атак. Снижайте риск:

Даже если Redis используется как кэш, потеря данных может вызвать лавину обращений к базе и падение сервиса — поэтому безопасность напрямую влияет на стабильность.

Redis обычно работает «быстро», пока вы не начинаете упираться в память, сетевые задержки или неожиданные паттерны запросов. Чтобы не гадать, что происходит, стоит заранее определить набор метрик и регулярно их проверять.

В первую очередь следите за:

used_memory, used_memory_peak, фрагментация (mem_fragmentation_ratio). Резкий рост — повод искать утечки (например, бесконечные TTL) или «раздувшиеся» ключи.keyspace_hits и keyspace_misses. Полезно считать долю hit‑rate и сравнивать с целевыми значениями для вашего сценария.connected_clients, blocked_clients, ошибки аутентификации, переподключения. Внезапный рост часто означает проблему в пуле соединений приложения.Включите и регулярно просматривайте slowlog — он показывает команды, которые выполнялись дольше порога. Это помогает поймать, например, слишком большие ZRANGE, SMEMBERS или операции с крупными структурами.

Отдельно ищите большие ключи: они дают скачки задержек (Redis однопоточный на выполнение команд) и усложняют вытеснение. Практика — периодически делать аудит ключей (по префиксам) и ограничивать размер коллекций на уровне приложения.

Если включён maxmemory, Redis при нехватке памяти начнёт вытеснять данные согласно политике eviction (например, LRU/LFU для ключей с TTL или для всех ключей). Важно заранее выбрать политику под ваш кейс и понимать последствия: при неудачной настройке Redis может начать выкидывать «важные» ключи или возвращать ошибки записи.

Настройте алерты на: рост памяти и фрагментации, падение hit‑rate, увеличение latency p99, рост blocked_clients, частые eviction/ошибки OOM.

Добавьте регулярные проверки конфигурации (лимиты памяти, TTL по кэшу, размер ключей) и фиксируйте «нормальные» значения — так аномалии будут видны сразу.

Если вы собираете веб‑ или мобильное приложение, Redis обычно появляется в одном из двух моментов:

В TakProsto.AI эти сценарии встречаются постоянно: платформа ориентирована на vibe‑coding (создание web/server/mobile приложений через чат), а типовой стек (React на фронтенде, Go + PostgreSQL на бэкенде, Flutter для мобильных приложений) как раз выигрывает от Redis‑слоя для кэширования, сессий, лимитов и фоновых задач.

Практичный подход при прототипировании в TakProsto.AI:

Если проект уже выходит за рамки прототипа, у TakProsto.AI есть возможности, которые упрощают эксплуатацию: экспорт исходников, деплой и хостинг, снапшоты и откат, кастомные домены и режим planning mode для более аккуратного проектирования изменений. Плюс важно для российского рынка: платформа работает на серверах в России и использует локализованные/opensource LLM‑модели, не отправляя данные за пределы страны.

Redis — быстрое хранилище «ключ–значение», чаще всего работающее в памяти. Его используют, чтобы:

Обычно Redis работает рядом с БД: БД хранит, Redis ускоряет.

Redis может не окупиться, если:

Если данных мало и все работает стабильно, добавление Redis «про запас» часто усложняет систему сильнее, чем ускоряет.

Ориентируйтесь на форму доступа к данным:

Cache-Aside (Lazy Loading) выглядит так:

Практика:

TTL — удобная «страховка»: ключ исчезнет сам, даже если вы забыли его обновить. Но TTL не гарантирует идеальную свежесть.

Инвалидация точнее, но сложнее: нужно найти и удалить/обновить все связанные ключи при изменении данных.

Рабочий компромисс:

Cache stampede — ситуация, когда популярный ключ истекает и много запросов одновременно идут в БД.

Помогают:

Цель — чтобы при промахе кэша в БД шел один пересчет, а не тысяча.

В Redis обычно кладут минимум, нужный для проверки сессии:

user_id, роли/права (если редко меняются), флаги (например, 2FA), метаданные.Практика:

Если права могут быстро отзываться — либо инвалидируйте, либо держите очень короткий TTL.

Базовый rate limiting часто делают через атомарный счетчик:

rl:user:123:<time_bucket>INCR + EXPIRE (TTL окна)Нюансы:

Если нужна простая модель producer/consumer, часто хватает Lists:

LPUSHBRPOP (блокирующее ожидание)Если важны подтверждения, группы потребителей и перераспределение «зависших» сообщений — берите Streams:

Минимальный набор:

Если вы постоянно кладете «всё в JSON в String», проверьте, не упростит ли задачу Hash/Set/ZSet.

Важно выбирать ключи (по пользователю/IP/токену) и TTL так, чтобы лимит отражал реальный риск, а не случайно блокировал нормальных клиентов.

ACK;В любом случае закладывайте повторы и делайте обработчики идемпотентными (например, через job_id и отметку «done»).

used_memory, used_memory_peak, mem_fragmentation_ratio;keyspace_hits и keyspace_misses (hit-rate);connected_clients, blocked_clients, частые переподключения.Практика:

maxmemory и политику eviction под ваш сценарий;