14 окт. 2025 г.·8 мин

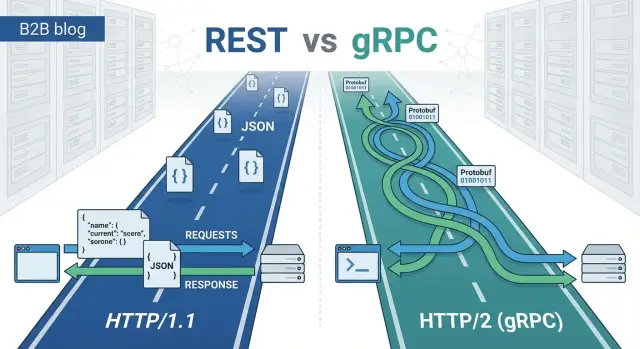

REST или gRPC: что выбрать для ваших приложений и API

Сравниваем REST и gRPC: протоколы, форматы данных, производительность, совместимость, инструменты и практические критерии выбора для команд.

REST и gRPC: что сравниваем и зачем

Выбор между REST и gRPC редко бывает «про технологии ради технологий». Он влияет на скорость разработки, удобство для клиентов, стоимость поддержки и то, насколько уверенно вы сможете развивать API через год-два.

Если вы делаете продукт в формате «веб + мобильное + интеграции», полезно сразу думать не только о протоколе, но и о процессе разработки: как быстро вы проверите гипотезу, зафиксируете контракт и выкатите изменения. Например, в TakProsto.AI (vibe-coding платформа для российского рынка) часто начинают с простого REST-фасада для внешних клиентов, а внутренние сервисы проектируют на gRPC — это помогает быстрее собирать рабочие приложения из чата и при росте нагрузки аккуратно «уплотнять» межсервисные вызовы.

Зачем сравнивать именно для ваших сценариев

REST и gRPC решают одну задачу — обмен данными между системами, — но делают это разными способами. Поэтому один и тот же продукт может выиграть от смешанного подхода: где-то удобнее REST, где-то — gRPC.

В этой статье мы сравниваем не «кто круче», а практические свойства, которые проявляются в реальных проектах: как выглядят запросы и ответы, как проверяется контракт, как работает стриминг, как вести версионирование и что проще дебажить.

Кратко: что такое REST и что такое gRPC

REST — подход к проектированию API поверх HTTP, где вы работаете с ресурсами (например, /users) и стандартными методами (GET, POST и т. д.). Чаще всего данные передаются в JSON.

gRPC — фреймворк для вызова удалённых методов (RPC) поверх HTTP/2. Контракты описываются в .proto, а данные обычно сериализуются в Protocol Buffers. Клиентские SDK часто генерируются автоматически.

Какие вопросы эта статья поможет решить

- У вас будут веб-клиенты, мобильные приложения или партнёрские интеграции — и что из этого важнее.

- Где критичны задержки и пропускная способность (микросервисы, внутренние API) и стоит ли оптимизация усложнения.

- Как обеспечить поддерживаемость: эволюцию контракта, совместимость версий, наблюдаемость и диагностику.

Что не является целью

Цель — не доказать, что «REST устарел» или что «gRPC нужен всем». Оба подхода полезны; правильный выбор зависит от ваших клиентов, инфраструктуры и требований к развитию продукта.

Модель взаимодействия: ресурсы vs вызовы методов

Главное различие между REST и gRPC — в том, как вы «мысленно» описываете систему. REST предлагает смотреть на предметную область как на набор ресурсов, а gRPC — как на набор действий (методов), которые можно вызвать.

REST: ресурсный подход и семантика HTTP

В REST вы проектируете API вокруг сущностей: /users, /orders/123, /payments. Клиент взаимодействует с ними через стандартные HTTP-методы: GET (прочитать), POST (создать), PUT/PATCH (изменить), DELETE (удалить). Поведение дополнительно описывается HTTP-статусами (например, 200, 201, 404, 409), заголовками и правилами кэширования.

Сильная сторона такой модели — предсказуемость: многие инструменты (прокси, CDN, браузеры) «понимают» HTTP и помогают с кэшированием, условными запросами и идемпотентностью. Компромисс в том, что сложные операции иногда трудно уложить в чистую ресурсную модель — и появляются компромиссные эндпоинты вроде /orders/123/cancel.

gRPC: RPC-модель, сервисы и методы

gRPC описывает API как набор сервисов и методов: OrderService.CancelOrder, PaymentService.Capture. Клиент вызывает метод и получает ответ в формате, заданном контрактом .proto. Здесь нет необходимости подгонять всё под CRUD: если бизнес-операция естественно выражается как команда или процедура, gRPC обычно ощущается прямолинейнее.

Как это влияет на дизайн и где что лучше

REST обычно удобнее для публичных API и интеграций с широким кругом клиентов: понятные URL, стандартные статусы, простая диагностика через привычные HTTP-инструменты.

gRPC чаще выбирают для внутренних взаимодействий между микросервисами: когда важны строгие контракты, единообразные вызовы методов и минимальная неоднозначность в том, «что именно делает endpoint».

Практический критерий: если вы чаще говорите «получить/обновить ресурс», REST ложится естественно. Если чаще звучит «выполнить операцию/команду», модель методов gRPC чаще приводит к более ясному интерфейсу.

Транспорт и протокол: HTTP и особенности HTTP/2

Когда говорят «REST против gRPC», часто спорят о стиле API. Но на практике разница заметнее на уровне транспорта: какие свойства дает протокол и как это влияет на задержки, параллельность и требования к инфраструктуре.

REST и HTTP/1.1 (и иногда HTTP/2)

REST чаще используют поверх HTTP/1.1. Это знакомая всем модель: запрос/ответ, текстовые заголовки, удобная диагностика через браузер и инструменты вроде cURL.

При большом числе параллельных запросов ограничения HTTP/1.1 проявляются быстрее: несколько соединений, конкуренция за них, «очереди» запросов. HTTP/2 может улучшить ситуацию и для REST (мультиплексирование), но на практике REST-стэки и промежуточные компоненты используют HTTP/2 не везде и не всегда одинаково.

gRPC и HTTP/2 «по умолчанию»

gRPC построен на HTTP/2 изначально. Вместо текстового обмена «как в обычном API» он использует бинарные фреймы и долгоживущие соединения.

Что это дает:

- Мультиплексирование: много вызовов одновременно через одно соединение, меньше накладных расходов на установку/поддержание множества TCP-сессий.

- Более предсказуемая параллельность: в микросервисных вызовах, где сервис постоянно общается с другими сервисами, это часто снижает задержки под нагрузкой.

Ограничения инфраструктуры

Важный нюанс: не вся сеть «любит» HTTP/2. Старые прокси, балансировщики, WAF, API-шлюзы или корпоративные периметры могут частично поддерживать HTTP/2, отключать определенные возможности или требовать специфической настройки (например, для gRPC нужны корректные правила для HTTP/2 и длительных соединений).

Поэтому при выборе стоит заранее проверить путь трафика: клиент → CDN/прокси → балансировщик → сервис, и убедиться, что HTTP/2 и gRPC проходят без деградации и неожиданных таймаутов.

Форматы данных: JSON vs Protocol Buffers

Выбор формата данных напрямую влияет на удобство разработки, скорость передачи и стабильность контрактов. В REST чаще всего «по умолчанию» используют JSON, а в gRPC — Protocol Buffers (Protobuf).

REST и JSON: читаемость против «веса»

JSON стал де‑факто стандартом для публичных API: его легко читать глазами, логировать, быстро проверить запрос в curl или Postman, а также без усилий разбирать в браузере. Это упрощает интеграции с партнёрами и фронтендом.

Компромисс — размер: JSON избыточен (названия полей повторяются в каждом объекте, значения передаются в текстовом виде), а вложенные структуры раздувают payload. Для мобильных сетей и частых вызовов это бывает заметно.

gRPC и Protobuf: компактность и строгая схема

Protobuf — бинарный формат со строгой схемой. Он обычно компактнее JSON и быстрее сериализуется/десериализуется, что полезно при высоком RPS и межсервисном обмене.

Плюс — контракт «зашит» в .proto: типы, структура, правила эволюции. Клиентские SDK генерируются автоматически, а ошибки несоответствия типов всплывают раньше.

Версионирование сообщений и совместимость полей

В JSON эволюция часто держится на договорённостях: добавлять поля можно относительно безопасно, удалять — рискованно, менять тип поля — почти всегда breaking change. Нужны чёткие правила и тесты контрактов.

В Protobuf совместимость проще формализовать: нельзя переиспользовать номера полей, удалённые поля лучше резервировать (reserved), новые поля добавляются без поломки старых клиентов. Это дисциплинирует, но требует аккуратного управления схемой.

Валидация и ошибки сериализации: что учесть

С JSON типичные проблемы — «плавающие» типы (строка вместо числа), разные форматы дат, null и отсутствующее поле, неявные значения по умолчанию. Без явной схемы такие ошибки часто доходят до бизнес-логики.

В gRPC/Protobuf часть ошибок ловится на этапе декодирования: неправильный тип или битый payload приводят к ошибке сразу. Но валидацию бизнес‑ограничений (например, диапазоны, обязательные поля, правила для строк) всё равно нужно делать отдельно — через валидаторы, middleware или правила валидации для сообщений.

Производительность: где разница заметна на практике

Производительность API обычно сводится к трём вещам: задержка (сколько времени занимает запрос), пропускная способность (сколько запросов/данных выдерживает система) и размер полезной нагрузки (сколько байт вы гоняете по сети).

Задержка, пропускная способность и размер полезной нагрузки

REST часто использует JSON поверх HTTP/1.1 или HTTP/2. JSON удобен, но «тяжелее» по объёму и часто дороже по сериализации.

gRPC по умолчанию использует Protocol Buffers — бинарный формат, который обычно даёт меньший размер сообщений и быстрее кодируется/декодируется. На практике это может снижать задержку и нагрузку на CPU при больших объёмах данных и высокой частоте вызовов.

Накладные расходы заголовков и сериализации

У REST запросы нередко содержат больше заголовков и метаданных, особенно при активном использовании прокси, авторизации и кеширования.

У gRPC поверх HTTP/2 заголовки сжимаются (HPACK), а один TCP‑канал мультиплексирует много вызовов. Выигрыш заметнее, когда у вас много мелких запросов между сервисами или высокая конкуренция.

Когда REST «достаточно быстрый», а когда gRPC дает выигрыш

REST обычно «достаточно быстрый», если:

- запросов немного, а ответы небольшие;

- основное время уходит в базу данных или внешние сервисы, а не в транспорт;

- вам важнее совместимость с браузером и простота интеграции.

gRPC чаще выигрывает, если:

- сервисы общаются часто и «болтливо» (много вызовов на одну операцию);

- ответы большие или их много (каталоги, телеметрия);

- критичны задержки p95/p99 и стоимость CPU на сериализацию.

Как корректно измерять

Сравнивайте не «вакуумную скорость протокола», а ваши реальные сценарии: одинаковые данные, одинаковая бизнес‑логика, одинаковая инфраструктура.

Полезный минимум:

- профилирование CPU/памяти на сериализации и обработке запросов;

- нагрузочные тесты с целевыми метриками (p50/p95/p99, RPS, ошибки);

- измерения размера ответов и сетевого трафика;

- тесты под типичным уровнем параллельности (соединения, пул потоков, лимиты).

Часто выясняется, что gRPC даёт ощутимый прирост именно в межсервисном контуре, а для публичного API разницу «съедают» задержки клиентов и сетевые условия.

Совместимость клиентов: веб, мобильные, партнеры

Мигрируйте без страха

Делайте изменения в API смелее со снапшотами и быстрым откатом.

Выбор между REST и gRPC часто упирается не в скорость, а в то, кто и как будет вызывать ваш API. Один и тот же сервис может быть удобен для внутренних микросервисов, но неудобен для браузера или партнеров.

Веб: браузер, DevTools и «быстрый старт»

REST обычно проще для фронтенда: запросы естественно ложатся на HTTP, их легко отправлять из браузера, проверять в DevTools и воспроизводить через curl или Postman. Это важно, когда API используют разные команды и нужно быстро разобраться без генерации кода.

С gRPC в браузере сложнее. Классический gRPC использует HTTP/2 и бинарный протокол, поэтому напрямую из браузера он не всегда доступен. Вариант gRPC-web помогает, но добавляет ограничения: часть возможностей (особенно вокруг стриминга) может работать иначе, а иногда нужен прокси (например, Envoy) между браузером и сервисом.

Мобильные клиенты: удобство SDK vs привычный HTTP

Для мобильных REST — это понятный стек и масса готовых библиотек, но контракт API поддерживается «на дисциплине»: схемы, версии, ручная синхронизация моделей.

gRPC выигрывает там, где важны типизация и единый контракт: из .proto генерируются клиенты, модели и методы. Это снижает риск ошибок при обновлениях и ускоряет разработку, особенно если у вас несколько платформ и языков.

Публичные API и партнерские интеграции

Для внешних клиентов и партнеров REST чаще удобнее: почти у всех есть опыт с HTTP+JSON, проще подключиться из любой среды, легче дебажить и логировать запросы.

gRPC для партнеров подходит, когда вы контролируете окружение, готовы помогать с генерацией клиентов и можете обеспечить совместимость по версиям.

Практическое правило: для публичного «входа» часто оставляют REST, а для внутреннего взаимодействия сервисов — gRPC. Это сочетание обычно даёт лучший баланс доступности и эффективности.

Контракты и эволюция API: OpenAPI vs .proto

Когда API растёт, главная боль — не написать новый эндпоинт, а договориться о «правилах игры»: какие поля обязательны, как выглядят ответы, что будет, если поле исчезнет, и как обновляться без поломок у клиентов.

REST: OpenAPI/Swagger, документация и мок‑серверы

В REST контракт чаще всего фиксируют через OpenAPI (Swagger). Это удобный, человеко‑ориентированный формат: его читают продуктовые команды, партнёры и тестировщики.

Плюсы:

- Документация как продукт: из OpenAPI легко собрать портал, примеры запросов/ответов и сценарии.

- Мок‑серверы и тестирование: по спецификации можно поднять мок и начать интеграцию ещё до готовности бэкенда.

- Гибкость: можно описывать разные стили (ресурсы, фильтры, пагинацию) и типовые HTTP‑коды.

Минус в том, что OpenAPI иногда остаётся «договором на бумаге»: сервер и клиенты могут разъехаться со спецификацией, если не встроить проверки в CI.

gRPC: .proto как контракт, генерация кода, рефлексия

gRPC опирается на файл .proto — это одновременно схема данных и описание методов.

- Генерация кода: клиенты и сервер получают типизированные модели и интерфейсы, меньше ручной работы и ошибок на стыке.

- Единый источник правды:

.protoобычно действительно становится контрактом, потому что от него зависит сборка. - Рефлексия: в зрелых системах можно исследовать сервисы и методы без отдельной «вики», хотя для внешних партнёров всё равно часто готовят человеко‑читаемую документацию.

Как устроены изменения API: добавление полей и депрекейты

В обоих подходах безопаснее добавлять, чем менять/удалять.

- В REST (JSON) добавление полей обычно не ломает клиентов, если они игнорируют неизвестное. Риск — нестрогие типы и разночтения в форматах.

- В gRPC/Protocol Buffers добавление полей — штатный сценарий: новые поля получают новые номера, старые клиенты их просто не видят.

Для «мягкого» вывода из эксплуатации используют депрекейты: в REST — через документацию и заголовки, в gRPC — через пометки в .proto и плановую замену методов.

Версионирование: URL/заголовки vs эволюция схем

В REST распространены версии в URL (/v1/...) или в заголовках. Это прозрачно для внешних потребителей, но увеличивает число поддерживаемых веток.

В gRPC часто стараются дольше жить без «жёстких v2»: эволюционируют сообщения, добавляют новые поля и методы, а радикальные изменения оформляют как новый сервис/метод. Это снижает дробление, но требует дисциплины в работе со схемой.

Стриминг и «длинные» операции

Не привязывайтесь к прототипу

Когда прототип готов, выгрузите исходники и продолжайте разработку в своём репозитории.

Когда API должен не только вернуть результат «здесь и сейчас», но и передавать события, прогресс или поток данных, различия между REST и gRPC становятся особенно заметны.

Стриминг в gRPC: четыре модели

gRPC изначально поддерживает несколько способов обмена данными поверх одного соединения:

- Unary — привычный запрос-ответ (аналог «обычного» REST-вызова).

- Server streaming — клиент отправляет запрос, сервер возвращает поток сообщений (например, лента обновлений или выгрузка больших данных порциями).

- Client streaming — клиент отправляет поток, сервер отвечает один раз (например, загрузка большого файла чанками).

- Bidirectional streaming — обе стороны могут отправлять сообщения параллельно (чаты, совместное редактирование, телеметрия).

Практически это означает меньше «склеивания» решений из разных технологий: модель потоков уже встроена в контракт и инструменты.

Долгие операции: прогресс и события

Для операций, которые занимают секунды или минуты (генерация отчета, обработка видео, импорт данных), важно заранее продумать:

- как вернуть идентификатор операции;

- как передавать прогресс и промежуточные статусы;

- как сообщать о завершении/ошибке.

gRPC-стриминг удобен, когда клиенту нужен непрерывный поток статусов. В REST чаще строят схему: «создать задачу → получать статус → забрать результат».

REST-альтернативы: polling, long polling, SSE, WebSocket

В REST-мире для «почти-стриминга» обычно выбирают одно из решений:

- Polling: просто, но создает лишний трафик и задержки.

- Long polling: меньше запросов, но сложнее балансировать и отлаживать.

- SSE (Server-Sent Events): удобно для событий сервер → клиент (уведомления, статусы).

- WebSocket: двунаправленный канал, хорош для интерактива, но требует отдельной инфраструктуры и дисциплины протокола.

Как выбрать подход для уведомлений и потоковых данных

Если нужно много событий, низкая задержка и строгий контракт — чаще выигрывает gRPC streaming (особенно внутри микросервисов). Если клиенты — браузер и внешние партнеры, а поток в основном «сервер → клиент», то REST + SSE или REST + WebSocket обычно проще принять и поддерживать.

Безопасность и надежность: ошибки, ретраи, таймауты

Безопасность и отказоустойчивость у REST и gRPC строятся на схожих принципах (TLS, контроль доступа, лимиты), но реализуются по‑разному из‑за протокола и моделей взаимодействия. Важно заранее договориться о правилах: какие ошибки считаются временными, сколько раз ретраим, как задаем таймауты и что считаем идемпотентным.

Аутентификация и авторизация: токены, mTLS, метаданные

В REST чаще всего используют OAuth 2.0 / OpenID Connect: клиент кладет Bearer‑токен в заголовок Authorization. Это удобно для браузеров, мобильных приложений и партнерских интеграций.

В gRPC тоже можно передавать токены, но обычно через metadata (например, authorization: Bearer …). Для взаимодействия «сервис‑сервис» часто выбирают mTLS: сертификат клиента подтверждает его идентичность, а авторизацию дополняют ролями/claims в токене или данными из сервис-меша.

Обработка ошибок: HTTP-коды vs gRPC status codes

В REST базовая семантика ошибок задается HTTP‑кодами (401/403/404/409/429/500). Детали обычно кладут в JSON‑тело, часто в стиле RFC 7807 (problem+json). Это прозрачно для прокси и логов.

gRPC возвращает status codes (например, UNAUTHENTICATED, PERMISSION_DENIED, NOT_FOUND, ALREADY_EXISTS, RESOURCE_EXHAUSTED, UNAVAILABLE) и опционально details. Плюс — единая матрица ошибок для методов; нюанс — при работе через промежуточные HTTP‑компоненты нужно аккуратно маппить статусы (например, через gRPC‑Gateway).

Таймауты, ретраи и идемпотентность

Таймауты в REST задаются на клиенте и инфраструктуре (балансировщик, gateway). В gRPC таймаут обычно передают в запросе как deadline, и он автоматически распространяется по цепочке вызовов.

Ретраи опасны без идемпотентности: повторный POST может создать дубликат. Для REST применяют idempotency key и корректные семантики методов (PUT/DELETE). В gRPC идемпотентность задается на уровне метода и бизнес‑логики; часто добавляют request‑id и дедупликацию.

Лимиты и защита от перегрузки: что предусмотреть заранее

Для обоих подходов нужны rate limiting и квоты (429/RESOURCE_EXHAUSTED), circuit breaker, контроль размера запросов и таймауты на чтение/запись.

В gRPC отдельно продумайте параметры HTTP/2: лимиты на количество одновременных стримов, keepalive‑политику, максимальный размер сообщения и поведение при backpressure. Это помогает не «положить» сервис, даже если клиент ведет себя агрессивно или сеть нестабильна.

Наблюдаемость и отладка: что проще поддерживать

Наблюдаемость — это способность быстро ответить на вопросы: что сломалось, где именно, как часто, и какой у этого эффект для пользователей. В REST и gRPC базовые принципы одинаковы (логи, метрики, трассировка), но «удобство руками» и набор инструментов заметно отличаются.

Логи, трассировка и метрики: база одинакова

И REST, и gRPC хорошо дружат с современными практиками наблюдаемости:

- Логи: фиксируете входящие запросы/вызовы, параметры (с осторожностью), идентификаторы корреляции, результат, время выполнения.

- Метрики: RPS, распределения latency (p50/p95/p99), процент ошибок, таймауты, ретраи.

- Трассировка: цепочка вызовов между сервисами — особенно важна в микросервисах.

Разница в том, насколько стандартизировано это «из коробки». У REST многое исторически завязано на HTTP-семантику (методы, статусы, заголовки) и зрелость middleware/проксей. В gRPC телеметрия обычно встраивается через интерсепторы и общие библиотеки: работает отлично, но требует дисциплины настройки.

Дебаг: человекочитаемые запросы REST vs бинарный трафик gRPC

REST проще для «быстрой проверки руками»: запросы и ответы обычно JSON, их легко прочитать в логах, увидеть в devtools, повторить в терминале.

С gRPC сложнее по двум причинам:

- Бинарный формат (Protocol Buffers) не читается глазами без декодирования.

- HTTP/2 и особенности фрейминга мешают привычной инспекции трафика.

Это не значит, что gRPC «не дебажится» — просто у него другой путь: вы чаще опираетесь на трассировку, структурированные логи и корректно настроенные интерсепторы.

Инструменты: Postman/curl vs grpcurl/Insomnia

Для REST набор максимально доступный:

- curl и любые HTTP-клиенты

- Postman

- вкладка Network в браузере

Для gRPC потребуются инструменты, которые понимают .proto и/или умеют рефлексию:

- grpcurl — аналог curl для gRPC

- Insomnia (где применимо)

Практический нюанс: чтобы ручная отладка gRPC была комфортной, часто включают server reflection на тестовых окружениях и следят за доступностью актуальных .proto в репозитории или артефактах.

Проксирование и инспекция трафика в корпоративных сетях

REST чаще «проходит везде»: корпоративные прокси, WAF, инспекция TLS, журналы балансировщиков — инфраструктура годами заточена под HTTP/1.1 и JSON API.

gRPC опирается на HTTP/2, и это иногда создаёт трения:

- не все прокси корректно поддерживают HTTP/2 end-to-end

- некоторые системы безопасности лучше умеют анализировать REST/JSON, чем gRPC-трафик

Если у вас строгие корпоративные сети или много внешних клиентов/партнеров, этот фактор может сделать поддержку REST заметно проще.

Что в итоге проще поддерживать

- REST выигрывает в «наглядности» и привычности: легче повторить запрос, легче понять по логам, проще инфраструктурно.

- gRPC выигрывает в системности при хорошей дисциплине: интерсепторы + трассировка + стандартизованные метрики быстро дают целостную картину по цепочкам вызовов.

Если команда часто «дебажит руками» и у вас много разнообразных клиентов, REST обычно снижает операционные затраты. Если основная боль — межсервисные взаимодействия и производительность, gRPC хорошо окупается при правильно выстроенной телеметрии.

Типовые сценарии и критерии выбора

Смешанная схема без боли

Сделайте REST-фасад для внешних клиентов и оставьте gRPC для внутренних вызовов.

Выбор между REST и gRPC обычно упирается не в «что лучше вообще», а в то, кто потребляет API, какая нагрузка и нужны ли потоковые взаимодействия. Ниже — типовые ситуации, где решение становится очевиднее.

Сценарий 1: публичный API для внешних разработчиков

Чаще выигрывает REST: он понятен «из коробки», легко тестируется через браузер и простые инструменты, хорошо стыкуется с документацией в формате OpenAPI и экосистемой API‑шлюзов.

gRPC тоже возможен, но потребует от партнеров генерации клиентов и поддержки Protocol Buffers, что повышает порог входа. Если нужен и REST, и gRPC, иногда делают два фасада над одной бизнес‑логикой.

Сценарий 2: внутренние микросервисы с высокой нагрузкой

Здесь часто выбирают gRPC: компактные сообщения, строгие контракты и эффективная работа поверх HTTP/2 обычно дают лучшую пропускную способность и стабильную задержку. Это особенно заметно при большом числе межсервисных вызовов и «болтливых» сервисах.

REST остаётся вариантом, если у команды уже зрелая HTTP‑инфраструктура (прокси, кеширование, observability) и важна простота дебага.

Сценарий 3: мобильные приложения и нестабильные сети

Если вам важна совместимость и предсказуемость поведения через прокси/корпоративные сети, обычно проще REST.

Если же требуется экономить трафик и ускорять ответы (при контролируемой инфраструктуре и чётко управляемых клиентах), gRPC может быть выгоднее — но закладывайте время на интеграцию и диагностику сетевых проблем.

Сценарий 4: события и потоковые данные в реальном времени

При необходимости стриминга (серверного, клиентского или двунаправленного) чаще выбирают gRPC, потому что модель потоков поддерживается протоколом напрямую. Для REST это обычно означает дополнительные технологии (например, SSE/WebSocket) и отдельную архитектуру.

Короткая таблица критериев выбора

| Критерий | REST | gRPC |

|---|---|---|

| Публичные интеграции и низкий порог входа | ✅ | ⚠️ |

| Внутренние сервисы и высокая нагрузка | ⚠️ | ✅ |

| Строгая типизация и генерация клиентов | ⚠️ | ✅ |

| Стриминг и real-time потоки | ⚠️ | ✅ |

| Простота ручной отладки и тестирования | ✅ | ⚠️ |

Если сомневаетесь, начните с ответа на два вопроса: «кто клиент?» и «нужен ли стриминг/высокая частота вызовов?». Это обычно сразу сужает выбор.

Практический план: как внедрять и как мигрировать

Переход на gRPC (или добавление REST поверх него) лучше делать как проект по изменению контракта и операционных практик, а не как «переписать все вызовы». Ниже — план, который помогает внедрять поэтапно и без простоя.

1) Можно ли сочетать: REST на границе, gRPC внутри

Частый вариант — оставить REST/JSON для внешних клиентов (браузер, партнеры, публичные SDK), а между внутренними сервисами перейти на gRPC. Так вы получаете совместимость «на входе» и эффективность/стриминг «внутри».

На практике это выглядит так:

- Публичный API остается REST (например,

/api/v1/...). - Внутренние сервисы общаются по gRPC.

- На границе стоит gateway/edge, который принимает HTTP-запросы и вызывает gRPC-методы.

2) Стратегия миграции без остановки: параллельные endpoints

Самый безопасный подход — параллельное существование старого и нового пути:

- Опишите новый контракт (

.proto) и поднимите gRPC-сервис рядом с текущим REST. - Добавьте адаптер: либо gateway, либо слой в приложении, который может ходить и в REST, и в gRPC.

- Включайте миграцию по флагу (feature toggle) и постепенно переводите трафик (canary).

- Сравнивайте ответы и метрики (ошибки, задержки) на реальных запросах.

- После стабилизации — отключайте старые REST endpoints по версии (например,

/v1→/v2) с периодом поддержки.

3) API gateway и транскодирование: что учитывать

Если вы делаете REST→gRPC транскодирование, заранее проверьте ограничения:

- Как будут маппиться ошибки и коды статуса.

- Поддержка стриминга (часто ограничена для браузерных клиентов).

- Лимиты на размер сообщений и таймауты на прокси.

- Логи и корреляция запросов (trace-id должен проходить через gateway).

4) Чек-лист перед решением

- Требования клиентов: нужен ли веб без дополнительных прокси, есть ли партнеры.

- Команда: готовы ли поддерживать

.proto, генерацию клиентов и дисциплину версионирования. - Инфраструктура: есть ли HTTP/2 end-to-end, observability для gRPC, единые ретраи/таймауты.

- Миграционный путь: сможете ли вы держать параллельные интерфейсы и измерять качество.

Если сомневаетесь, начните с одного сервиса и одного сценария (например, внутренний сервис с высокой нагрузкой) — это даст реальную картину затрат и выигрыша, прежде чем масштабировать подход.

Отдельно про практику «быстро попробовать, а затем закрепить контракт». На TakProsto.AI удобно стартовать с прототипа: собрать React-веб, Go-бэкенд с PostgreSQL и базовые REST-эндпоинты, а затем — по мере роста — добавить gRPC для внутренних вызовов и включить более строгую контрактность. Платформа поддерживает экспорт исходников, деплой и хостинг, снапшоты и откат, а также режим планирования (planning mode), что помогает аккуратно пройти миграцию без хаоса в интерфейсах. Для команд есть тарифы от Free до Enterprise, а ещё можно получать кредиты за контент про платформу или по реферальной программе — полезно, если вы параллельно делаете публичные материалы про архитектурные решения вроде REST vs gRPC.

FAQ

В чем ключевая разница между REST и gRPC простыми словами?

REST — это стиль проектирования API поверх HTTP, где вы оперируете ресурсами (/users, /orders/123) и стандартными методами (GET/POST/PUT/PATCH/DELETE).

gRPC — RPC-фреймворк поверх HTTP/2: вы описываете сервисы и методы в .proto, получаете типизированные сообщения (обычно Protobuf) и часто генерируете клиентские SDK автоматически.

Выбор обычно определяется клиентами (браузер/партнёры vs внутренние сервисы), требованиями к производительности и потребностью в стриминге.

Когда REST — более практичный выбор?

Чаще всего REST проще, если API:

- публичный или партнёрский (низкий порог входа: HTTP+JSON);

- активно используется из браузера (DevTools, простое воспроизведение запросов);

- должен хорошо работать через разнообразные прокси/WAF/CDN.

Практика: REST часто оставляют «на границе» (edge), даже если внутри системы используют gRPC.

Когда стоит выбирать gRPC?

gRPC обычно оправдан, когда:

- много межсервисных вызовов и важны p95/p99 задержки;

- нужна строгая типизация и единый контракт, чтобы меньше «разъезжались» клиенты и сервер;

- важен стриминг (server/client/bidi) без добавления отдельного протокола;

- вы контролируете инфраструктуру и можете обеспечить корректный HTTP/2 end-to-end.

Особенно хорошо gRPC ложится на микросервисы и внутренние API.

Можно ли использовать REST снаружи и gRPC внутри одной системы?

Да, это распространённая и часто оптимальная схема:

- внешние клиенты (веб, партнёры) → REST/JSON;

- внутренние сервисы → gRPC/Protobuf;

- на границе — gateway, который принимает HTTP-запрос и вызывает gRPC-метод.

Так вы сохраняете совместимость «для всех» снаружи и получаете эффективность/контракты/стриминг внутри.

Что важнее при выборе формата данных: JSON или Protocol Buffers?

Основные отличия такие:

- JSON читаем глазами, удобен для ручной отладки и интеграций, но обычно «тяжелее» по размеру и дороже по сериализации.

- Protobuf компактнее и быстрее, но бинарный: для диагностики чаще нужны инструменты и

.proto.

Если сеть/CPU критичны (частые вызовы, большие ответы), Protobuf часто даёт выигрыш. Если важнее простота интеграции и дебага — JSON удобнее.

Почему HTTP/2 так важен для gRPC и как он влияет на инфраструктуру?

gRPC по умолчанию использует HTTP/2: одно соединение может мультиплексировать много параллельных вызовов, заголовки сжимаются (HPACK), а долгоживущие соединения снижают накладные расходы.

REST часто работает поверх HTTP/1.1, где при высокой параллельности быстрее проявляются ограничения (конкуренция за соединения, очереди запросов). REST тоже может работать на HTTP/2, но поддержка по всей цепочке (клиент → прокси → балансировщик → сервис) бывает неоднородной.

Проверьте инфраструктуру заранее: старые прокси/WAF могут ухудшать работу HTTP/2 и gRPC.

Как версионировать API в REST и gRPC без поломок клиентов?

В REST чаще версионируют явно: /v1/..., /v2/... или через заголовки. Это прозрачно для внешних клиентов, но увеличивает число поддерживаемых веток.

gRPC обычно стараются дольше жить без «жёсткого v2», эволюционируя схемы:

- добавляют новые поля (не переиспользуя номера);

- резервируют удалённые поля через

reserved; - радикальные изменения оформляют как новый метод/сервис.

В обоих случаях безопаснее добавлять, чем менять тип/удалять поля, и полезно иметь проверки контрактов в CI.

Как решать стриминг и «длинные» операции в REST и gRPC?

gRPC из коробки поддерживает 4 модели:

- unary (запрос–ответ);

- server streaming;

- client streaming;

- bidirectional streaming.

В REST «почти-стриминг» обычно делают через:

- polling/long polling;

- SSE (сервер → клиент);

- WebSocket (двунаправленно).

Если вам нужны частые события и низкая задержка внутри системы — gRPC streaming обычно проще и естественнее. Если основной клиент — браузер и поток в основном «сервер → клиент» — часто достаточно SSE/WebSocket поверх HTTP.

Как различаются ошибки, ретраи и таймауты в REST и gRPC?

В REST семантика ошибок обычно выражается HTTP-кодами (401/403/404/409/429/500) и деталями в JSON (часто в формате problem+json).

gRPC возвращает status codes (UNAUTHENTICATED, NOT_FOUND, RESOURCE_EXHAUSTED, UNAVAILABLE и т. д.) и может передавать details.

Практические советы:

- заранее определите, какие ошибки ретраятся, а какие нет;

- используйте таймауты: в gRPC удобно через deadline, чтобы он «тянулся» по цепочке вызовов;

- для небезопасных повторов (создание сущностей) применяйте идемпотентность: idempotency key/request-id + дедупликация.

Что проще отлаживать и поддерживать: REST или gRPC?

REST проще дебажить «вручную»: JSON видно в логах, запрос легко повторить через curl/Postman/DevTools.

gRPC сложнее для глаз из-за бинарного трафика и HTTP/2, но хорошо поддерживается инструментами и практиками:

grpcurlдля ручных вызовов;- Insomnia (где применимо);

- server reflection на тестовых окружениях;

- интерсепторы для логов/метрик и распределённая трассировка.

Если команда часто диагностирует проблемы «по сырому запросу», REST обычно снижает операционные затраты. Если основная сложность — межсервисные цепочки, gRPC окупается при хорошей телеметрии.