03 апр. 2025 г.·8 мин

SK hynix: как память и упаковка меняют ИИ‑серверы

Разбираем, как HBM, DDR5 и инновации в упаковке памяти SK hynix влияют на скорость ИИ‑серверов, энергопотребление, плотность и экономику владения.

Разбираем, как HBM, DDR5 и инновации в упаковке памяти SK hynix влияют на скорость ИИ‑серверов, энергопотребление, плотность и экономику владения.

ИИ‑серверы редко упираются только в «чистую» вычислительную мощность CPU или ускорителей. На практике ограничителем часто становится память: сколько данных можно подать к вычислительным блокам за единицу времени и с какими потерями по энергии и задержкам.

Модели для обучения и инференса постоянно гоняют большие тензоры между вычислителями и памятью. Если пропускной способности не хватает, ускоритель простаивает, а вы платите за дорогие ватт‑часы и железо, которое не загружено. Поэтому разговор о DDR5, HBM и упаковке чипов — это не про «детали компонентов», а про реальную производительность стойки и экономику дата‑центра.

Раньше рост производительности часто «лечился» добавлением ядер. В ИИ всё иначе: объёмы параметров и активаций растут быстрее, чем способность системы их подвозить.

Ключевые причины:

Отсюда и внимание к производителям памяти (включая SK hynix) и к технологиям упаковки: прогресс идёт не только в «кремнии», но и в том, как кристаллы соединяются, питаются и охлаждаются.

Материал построен без рекламных тезисов — с опорой на архитектурные причины:

Читать лучше «сверху вниз»: сначала различия DDR5/HBM, затем упаковка и ограничения по питанию/теплу, и только потом — выводы для закупки.

Когда говорят о «лидерстве» в серверной памяти, речь обычно не про громкие заявления и не про абстрактную «скорость». Для дата‑центра это набор практичных факторов: можно ли купить нужные объёмы в нужный срок, будет ли качество стабильным от партии к партии, и насколько предсказуемо поведение памяти в круглосуточной эксплуатации.

В индустрии памяти «лидерство» чаще всего складывается из четырёх измеримых вещей:

Если упростить, в ИИ‑сервере чаще встречаются два «мира» памяти:

SK hynix — один из ключевых поставщиков в обоих направлениях: и в серверной DDR5, и в HBM для ускорителей. Для заказчика это означает больше вариантов конфигураций и меньше рисков «узкого горлышка» на стороне памяти.

В современных модулях и особенно в HBM значительная часть сложности уходит в упаковку, сборку и проверку: многослойные стеки, вертикальные соединения, тонкая настройка тепловых и электрических режимов. Если на этих этапах не хватает мощностей или зрелости процессов, рынок видит дефицит даже при наличии произведённых кристаллов.

Поэтому, говоря о роли SK hynix, важно учитывать не только «память как микросхему», но и способность довести продукт до состояния, когда он массово и стабильно отгружается в дата‑центры: с предсказуемыми характеристиками, в нужных объёмах и с понятным жизненным циклом поставок.

DDR5 и HBM часто обсуждают как «какая память быстрее», но в ИИ‑сервере это две разные роли — и поэтому у них разные метрики эффективности. DDR5 в первую очередь даёт ёмкость и универсальность на уровне CPU‑узла, а HBM — экстремальную пропускную способность рядом с вычислением на ускорителе. Сравнивать их напрямую по одной цифре (например, ГБ/с) — почти всегда ошибка.

DDR5 — это рабочая «площадь» хоста: память, с которой живёт операционная система, фреймворки, сервисы, пайплайны данных и CPU‑часть вычислений.

Типичные места, где DDR5 критична:

Метрики, по которым DDR5 «делает разницу», — это не только пропускная способность каналов, но и задержка, количество каналов/рангов, поддерживаемые объёмы DIMM, а также энергоэффективность (ватты на ГБ и на ГБ/с в реальной нагрузке).

HBM ставится рядом с кристаллом ускорителя и рассчитана на сценарии, где вычисление упирается в подачу данных: обучение и инференс больших моделей, особенно при интенсивных матричных операциях.

Где HBM наиболее заметна:

Ключевые метрики для HBM: пиковая и устойчиво достижимая пропускная способность, энергия на бит и способность держать эту скорость при реальном теплопакете ускорителя.

Если система упирается в DDR5, симптомы часто такие: CPU не успевает готовить данные, очереди на I/O и препроцессинг растут, ускорители простаивают из‑за «голодания». Здесь улучшения DDR5 (больше каналов, выше частота, правильная конфигурация DIMM) дают прямой эффект.

Если же узкое место — HBM, ускоритель загружен, но производительность не растёт пропорционально числу вычислительных блоков: модель ограничена памятным каналом на самом ускорителе. Тогда наращивание DDR5 почти не помогает — нужен ускоритель/платформа с более сильной HBM‑подсистемой.

Ориентир простой:

В итоге DDR5 и HBM — не конкуренты, а элементы одной системы: DDR5 обеспечивает «базу» по ёмкости и гибкости, HBM — скорость там, где решают гигабайты в секунду рядом с вычислением.

ИИ‑ускоритель часто упирается не в «чистую» вычислительную мощность, а в то, как быстро он получает данные для матричных операций. Для обучения и инференса больших моделей решающими становятся пропускная способность памяти и энергопотребление на переданный бит. Чем меньше джоулей тратится на движение данных, тем выше реальная производительность на ватт и тем легче уложиться в лимиты стойки.

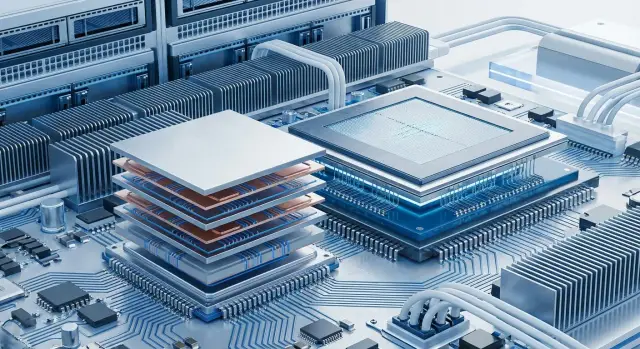

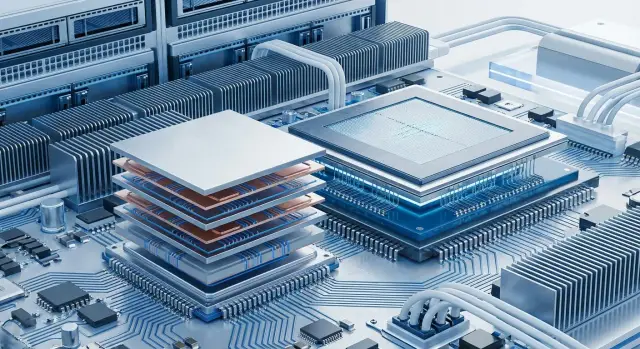

HBM (High Bandwidth Memory) — это стек DRAM‑кристаллов, соединённых вертикально (обычно через TSV), который располагают очень близко к вычислительному кристаллу ускорителя. Ключевой фокус не в экстремальной частоте, а в очень широком интерфейсе (тысячи линий), благодаря чему суммарная пропускная способность получается огромной.

Практический эффект: ускоритель меньше простаивает в ожидании параметров модели, активаций и градиентов. Это особенно заметно в задачах, где рабочие наборы данных постоянно «ездят» между памятью и вычислением.

Ширина канала и близость к вычислениям уменьшают задержки и повышают устойчивость производительности под нагрузкой.

Энергоэффективность на бит часто оказывается лучше, чем у «дальней» памяти, потому что сигналу не нужно преодолевать длинные трассы по плате.

Высокая суммарная пропускная способность повышает «утилизацию» вычислительных блоков: меньше циклов тратится впустую.

HBM — это сложная сборка, и у неё есть естественные «потолки»:

При сравнении конфигураций (в том числе решений SK hynix) полезно фиксировать не маркетинговые цифры, а параметры, которые влияют на итог:

Даже правильная по цифрам память может «не взлететь» организационно:

Итог простой: HBM ускоряет ИИ не магией, а дисциплиной в «движении данных». Выигрывает тот, кто смотрит на пропускную способность, ватты и тепловые ограничения как на единую систему.

Производительность ИИ‑серверов часто обсуждают через «топовые ускорители» и терафлопсы, но в реальности многое упирается в то, как физически соединены вычисления и память. Упаковка (packaging) определяет, сколько данных можно «прокачать» за ватт и за миллисекунду — и именно поэтому вокруг HBM и технологий сборки столько внимания.

TSV (Through‑Silicon Via) — это вертикальные металлизированные переходы через кремний, которые соединяют кристаллы памяти в стеке. Вместо длинных дорожек по плате данные проходят по коротким вертикальным каналам прямо между слоями DRAM.

Практический эффект: выше плотность соединений, меньше задержки на линии, ниже энергия на передачу бита. Именно TSV делает многослойную HBM возможной не «в теории», а в массовом производстве.

Ускорение даёт не только «быстрая память», но и физика соединений:

В результате упаковка становится таким же «ускорителем», как и микроархитектура: она определяет достижимую пропускную способность и стабильность под нагрузкой.

Подход 2.5D обычно означает, что рядом с логическим кристаллом (GPU/ASIC) размещают стеки HBM на интерпозере — тонкой подложке с высокой плотностью межсоединений. Это компромисс между классической платой (слишком «дальние» связи) и полноценным 3D‑склеиванием логики и памяти.

Ключевой плюс: можно сделать очень широкие и короткие соединения между логикой и HBM, что даёт высокую пропускную способность при приемлемом энергопотреблении.

За высокую скорость приходится платить: интерпозеры, TSV и многошаговая сборка повышают стоимость и требования к выходу годных. Но в ИИ‑сервере это часто окупается за счёт:

Для дата‑центра решает не рекорд в бенчмарке, а повторяемость параметров между партиями и узлами. В продакшн‑сборках критичны контроль термомеханических напряжений, стабильность контактов, тестирование на уровне модулей/пакетов и прослеживаемость (traceability).

Если вы планируете кластер под обучение, заранее согласуйте с поставщиком требования к квалификации и испытаниям — это снижает риск сюрпризов уже на этапе развертывания (см. также /blog/kak-zakupat-i-vnedryat-checklist).

Рост пропускной способности памяти (DDR5 и особенно HBM рядом с ускорителями) почти всегда означает рост плотности тепла на небольшом участке платы. Поэтому «быстрее» нередко упирается не в паспортные цифры модулей, а в то, как сервер умеет отводить тепло и стабильно питать память и соседние компоненты.

Ускорители с HBM и плотные серверные конфигурации создают локальные «горячие точки»: тепло выделяется неравномерно, и температура критична именно в зоне вокруг ускорителя, стека памяти и силовых цепей.

Если охлаждение не справляется, система начинает снижать частоты (троттлинг) или ограничивать энергопотребление — и фактическая производительность падает, даже если формально установлена «самая быстрая» память. На практике это означает, что выбор памяти нельзя отделять от выбора радиаторов, вентиляторов, направляющих потоков и профиля работы шасси.

Чем выше скорость и плотность, тем жёстче требования к:

Для дата‑центра это превращается в инженерную задачу: обеспечить нужную мощность на стойку и при этом сохранить безопасные температуры во всех режимах нагрузки.

При наращивании доли ИИ‑серверов стоит заранее оценить:

Высокие температуры ускоряют деградацию материалов и повышают риск отказов из‑за термоциклов (нагрев–остывание). Поэтому важны качество пайки, подложек и стабильность механики — особенно в плотной компоновке, где малейшие деформации сильнее сказываются на контактах.

Итог простой: конфигурация памяти и ускорителей должна соответствовать возможностям охлаждения и питания. Иногда более «скромная» по характеристикам память в хорошо охлаждаемом и правильно питаемом сервере даст выше среднюю производительность и меньше простоев, чем максимальная спецификация в стойке, работающей на пределе.

Производительность ИИ‑сервера сегодня часто упирается не в «сырой» TFLOPS ускорителя, а в то, насколько быстро и экономно он получает данные. Поэтому память (и то, как она упакована) влияет не только на бенчмарки, но и на TCO: сколько вы платите за стойку, киловатт‑часы, охлаждение и простой.

Для принятия решения полезно смотреть на несколько «нормированных» метрик:

HBM повышает пропускную способность и локальность доступа для ускорителя, что чаще всего приводит к росту его фактической загрузки. Да, HBM‑решения дороже: сложная сборка, 2.5D‑компоновка, TSV и более строгие требования к питанию/теплу. Но в TCO это может окупаться, если:

DDR5 обычно про ёмкость и гибкость: выбор числа модулей, рангов, частот. В экономике важны нюансы:

Сведите расчёт к понятным статьям: электроэнергия (ИТ + потери на охлаждение), амортизация/лизинг, обслуживание, стоимость простоя и риски дефицита комплектующих (модули памяти, серверные платформы, сроки поставок). Практично сравнивать варианты по «стоимости 1 единицы полезной работы» за год: так видно, когда более дорогая память выигрывает за счёт сокращения времени выполнения задач.

Проверяйте не только цену «за модуль», но и то, что влияет на итоговую конфигурацию:

В итоге «лидерство в памяти» (включая решения SK hynix в HBM и DDR5) — это про способность собрать сервер, который не просто быстрый, а предсказуемо окупаемый в ваших лимитах по стойке, энергии и срокам.

Выбор памяти для ИИ‑сервера лучше начинать не с «самых быстрых модулей», а с понимания, где именно ваша нагрузка упирается: в пропускную способность, в ёмкость или в задержки. Ниже — прикладной разбор типовых сценариев и признаков, которые помогают не переплатить и не получить «бутылочное горлышко».

Обучение (training) чаще всего чувствительно к пропускной способности на стороне ускорителя (HBM), особенно на больших моделях и при высокой параллельности. Если HBM не хватает по скорости или объёму, ускоритель простаивает, а время эпох растёт.

Инференс бывает разным:

RAG/поиск обычно «любит» ёмкость (индексы, кэши, большие эмбеддинги) и хорошую работу DDR5 на хосте. При этом пропускная способность тоже важна, но часто вторична по сравнению с тем, помещаются ли данные в память без постоянного чтения с диска.

Ориентируйтесь на профилирование и практические симптомы:

Практическое правило: HBM решает «скорость подачи данных» в ускоритель, а DDR5 — «склад» для датасетов, индексов, кэшей и параллельных потоков.

Ёмкость важнее, когда:

Пики пропускной способности важнее, когда:

Перед тем как фиксировать спецификацию, проверьте:

Если вы уже понимаете профиль нагрузки, следующий шаг — сверить его с планом масштабирования (по ускорителям и по объёму данных), чтобы память не стала ограничителем через 3–6 месяцев эксплуатации.

Память (DDR5 и особенно HBM) — один из самых дорогих и чувствительных компонентов ИИ‑сервера. Ошибки на этапе закупки и пилота часто превращаются в простои, недогруз ускорителей и неожиданные расходы на замену партий. Ниже — практичный чек‑лист, который помогает приземлить разговор с поставщиком/интегратором на измеримые критерии.

Отдельно полезно помнить, что «железо» — это только половина истории. В продакшне много времени уходит на внутренние инструменты: инвентаризация конфигураций, сбор метрик, расчёт TCO «по факту», проверка профилей нагрузок. Такие утилиты часто выгоднее не писать месяцами, а собирать итеративно.

Например, в TakProsto.AI можно через чат быстро сделать внутренний веб‑инструмент (React + Go + PostgreSQL) для расчёта «стоимости единицы полезной работы», учёта партий модулей и сверки лимитов стойки по питанию/охлаждению. За счёт planning mode удобно сначала зафиксировать KPI и источники данных, а затем собрать прототип и при необходимости экспортировать исходники.

Сформулируйте требования так, чтобы их можно было проверить:

HBM может быть ограничена по доступности, поэтому заранее продумайте:

Просите только проверяемое:

Заранее закрепите:

Если вы считаете экономику внедрения, полезно связать пилот с расчётом TCO и стоимостью простоя — для этого удобно держать под рукой внутренние материалы в /blog и сверяться с коммерческими параметрами в /pricing.

ИИ‑серверы всё чаще упираются не в «сырой» вычислительный потенциал, а в то, как быстро ускорители получают данные и насколько стабильно система держит теплопакет. Поэтому ближайшие годы будут про память, питание и упаковку — как про единый комплекс.

Главный вектор — рост роли HBM в составе ИИ‑ускорителей. Модели становятся больше, а параллелизм — агрессивнее, поэтому ценность высокой пропускной способности памяти продолжит расти. Одновременно усложняется и упаковка: больше стеков, выше плотность контактов, больше требований к качеству соединений и контролю тепла.

Для производителей памяти (включая SK hynix) это означает конкуренцию не только по гигабайтам и гигабайтам в секунду, но и по тому, насколько предсказуемо модуль/стек ведёт себя в реальных серверных условиях: температура, питание, длительная нагрузка, повторяемость партий.

Инновации в TSV, 2.5D‑интерпозерах и компоновке в целом будут «тянуть» за собой серверную инфраструктуру:

Чтобы тренды не ударили по срокам внедрения и бюджету, полезно действовать системно:

Инновационная упаковка окупается там, где вы монетизируете время: быстрее обучение, выше плотность инференса, меньше простоев из‑за перегрева и нестабильности. Практический следующий шаг — оценить текущие узкие места (пропускная способность памяти, питание, температура, размещение в стойке) и составить план модернизации памяти и платформы на 12–18 месяцев с понятными KPI по TCO и производительности.

«Узкое место» часто не в вычислениях, а в том, как быстро данные попадают в вычислительные блоки.

DDR5 и HBM выполняют разные роли, поэтому «кто быстрее» — некорректный вопрос.

Сравнивайте их по метрикам, важным для конкретной части системы: задержки/каналы/ёмкость для DDR5 и устойчивую пропускную способность/энергию на бит для HBM.

DDR5 особенно полезна, когда проблемы сидят в хост‑части:

Усиление DDR5 (правильное заполнение каналов, адекватная ёмкость DIMM) часто напрямую снижает простои ускорителей из‑за «голодания» по данным.

HBM даёт выигрыш там, где ускоритель упирается в подачу тензоров:

Если узкое место именно HBM‑подсистема, наращивание DDR5 почти не меняет картину — нужен ускоритель/платформа с более сильной HBM.

Обычно видно сочетание симптомов:

Лучший подход — подтвердить гипотезу профилированием и сопоставить с тем, где именно тратится время: на хосте (DDR5) или на ускорителе (HBM).

Потому что скорость упирается в физику соединений между логикой и памятью.

Итог: упаковка влияет на достижимую пропускную способность, целостность сигнала и повторяемость характеристик под реальной нагрузкой, а не только на «паспортные цифры».

Высокая скорость почти всегда означает более жёсткие требования к теплу и питанию.

Практика: конфигурацию памяти нужно выбирать вместе с шасси/охлаждением/лимитами стойки — иначе «самая быстрая» спецификация даст ниже среднюю производительность.

Считать полезно не «скорость модуля», а нормированные метрики для вашей задачи:

HBM обычно дороже в закупке, но может окупаться за счёт более высокой фактической загрузки ускорителя и меньшего числа серверов/стоек для той же работы.

В контексте серверов это про предсказуемость и масштабирование поставок, а не про лозунги.

Обычно оценивают:

Для дата‑центра «лидерство» важно тем, что снижает риски дефицита и разнобоя конфигураций в кластере.

Зафиксируйте требования и проверяемые критерии ещё до заказа:

Если нужен практичный ориентир, используйте внутренний чек‑лист из статьи: /blog/kak-zakupat-i-vnedryat-checklist.