03 сент. 2025 г.·8 мин

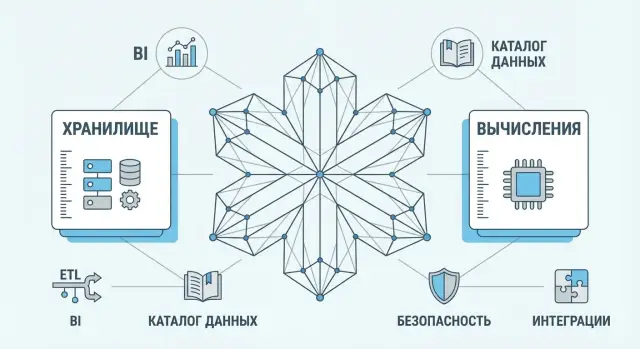

Snowflake: разделение хранения и вычислений и сила экосистемы

Разбираем, как разделение хранения и вычислений изменило подход к DWH на примере Snowflake и почему экосистема интеграций важнее «скорости».

Что изменилось в хранилищах данных за последние годы

DWH (Data Warehouse, хранилище данных) — это место, где компания собирает данные из разных систем (продажи, маркетинг, финансы, продукт, логистика) и приводит их к единому формату, чтобы строить отчёты и принимать решения на основе «единого источника правды». Когда DWH сделано правильно, вопросы уровня «сколько мы заработали по сегментам и почему просела маржа» перестают превращаться в спор между командами и выгрузками из разных таблиц.

Какие боли были у «классических» DWH

Традиционные хранилища обычно строились вокруг фиксированной инфраструктуры, где вычисления и хранение жили вместе. Это порождало типовые проблемы.

Во‑первых, масштабирование было медленным и дорогим: чтобы ускорить запросы, часто приходилось апгрейдить весь кластер целиком, даже если узким местом были только вычисления или, наоборот, диски.

Во‑вторых, возникали очереди и конфликты ресурсов. Один тяжёлый отчёт мог «положить» производительность для остальных: аналитики ждут, BI тормозит, бизнес нервничает. Приходилось вручную разруливать приоритеты, вводить окна для загрузок, ограничивать пользователей.

В‑третьих, стоимость и планирование были непрозрачными. Капитальные закупки, резерв под пики, простаивающие мощности и сложная поддержка превращали DWH в проект «про инфраструктуру», а не «про данные».

Почему облако изменило ожидания от аналитической платформы

С переходом в облако бизнес стал ждать от хранилища более сервисного поведения: быстро подключили источник, быстро дали доступ, быстро масштабировали под сезонный пик, а затем вернулись к обычным объёмам. Появился запрос на эластичность, самообслуживание для команд, предсказуемую работу при росте числа пользователей и более понятный контроль затрат.

Ещё одно изменение — скорость изменений в аналитике. Данные нужны не только для «месячного отчёта», но и для продуктовых экспериментов, операционных метрик, near real‑time мониторинга. Это повышает требования к параллельности и к тому, как платформа вписывается в инструменты ETL/ELT, BI и управления данными.

О чём эта статья

Дальше разберём, как подход Snowflake с разделением хранения и вычислений меняет архитектуру DWH, что это даёт по производительности и параллельной работе, и почему «сила экосистемы» (интеграции ETL и BI, управление витринами данных, безопасность, комплаенс) часто влияет на успех не меньше, чем скорость запросов. В финале — критерии выбора платформы и практичный план внедрения: от пилота до промышленной эксплуатации.

Идея Snowflake: разделить хранение и вычисления

Классические DWH часто росли по принципу «всё в одном»: данные хранятся и обрабатываются на одном и том же наборе ресурсов. Snowflake предлагает более простую мысль: хранение и вычисления — это разные слои. Данные живут в общем хранилище, а запросы выполняются на выделяемых под задачу вычислительных мощностях.

Простая модель: отдельно лежит, отдельно считается

В этой схеме вы платите за хранение независимо от того, есть ли сейчас нагрузка, и отдельно — за вычисления, когда запускаете запросы, загрузки или трансформации. В итоге «где лежит» и «кто считает» перестают быть одним и тем же узким местом.

Как это выглядит для пользователя: разные «кластеры» под разные задачи

На практике это ощущается как возможность поднять несколько независимых вычислительных «кластеров» (в терминологии Snowflake — виртуальных вычислительных складов) под разные сценарии:

- один — для регулярных отчётов BI,

- второй — для тяжёлых ad‑hoc запросов аналитиков,

- третий — для загрузок и трансформаций.

Все они читают и пишут в одно и то же хранилище, но не мешают друг другу по ресурсам. Если отчёты должны быть стабильными, вы просто не делите их мощности с экспериментальными запросами.

Что даёт разделение: независимое масштабирование и предсказуемость

Главный эффект — масштабирование становится более управляемым. Нужно ускорить отчёты — увеличиваете вычисления для «отчётного» кластера, не трогая процессы загрузки. Появляется предсказуемость: проще договориться о «гарантированной» скорости критичных задач, потому что конкуренция за CPU/память локализуется.

Возможные компромиссы

Разделение не отменяет нюансов:

- Задержки: при старте/остановке вычислений или при кратковременном «прогреве» кэшей скорость может отличаться от непрерывно работающего сервера.

- Стоимость «холостого» времени: если вычислительный кластер оставляют включённым без нагрузки, за него продолжают начисляться расходы.

- Сложность управления: приходится вводить правила — кто какими кластерами пользуется, когда включать/выключать, какие лимиты и приоритеты ставить.

Именно поэтому архитектура «хранение отдельно, вычисления отдельно» — не только про скорость, но и про дисциплину: без базовых практик управления ресурсами экономический эффект может оказаться ниже ожидаемого.

Производительность на практике: меньше конфликтов, больше параллельности

Главная «боль» классических DWH — конкуренция за одни и те же ресурсы. Один тяжёлый запрос или загрузка данных способны замедлить всё: отчёты начинают «тормозить», аналитики ждут, бизнес недоволен. В модели с разделением хранения и вычислений производительность чаще упирается не в общий «потолок», а в то, как вы распределяете вычислительные кластеры под разные задачи.

Что такое параллельность запросов простыми словами

Параллельность — это когда несколько людей могут работать в одном и том же архиве документов, но у каждого свой стол и свой набор инструментов. Данные лежат в одном месте, а вычисления выполняются на разных «рабочих местах» (вычислительных кластерах). Поэтому запросы меньше мешают друг другу.

Типовой сценарий: отчёты и ad‑hoc аналитика не мешают друг другу

На практике часто разделяют нагрузки:

- Отчётность (BI) под SLA — отдельные вычисления, предсказуемая скорость.

- Ad‑hoc аналитика — другой кластер, где можно запускать тяжёлые эксперименты без риска «уронить» дашборды.

- Загрузка/трансформации — третий контур, чтобы обновления не конкурировали с потреблением.

Такой подход особенно заметен в конце месяца, в сезонных пиках или перед ключевыми совещаниями: отчёты остаются стабильными, даже если аналитики параллельно гоняют сложные выборки.

Когда стоит «расширять вычисления», а когда — «ужимать»

Расширять имеет смысл, когда запросы стабильно не укладываются в SLA, растёт очередь, или вы запускаете расчёты пакетами (например, утренние витрины). Ужимать — когда нагрузка волнами и большую часть времени кластер простаивает: проще держать меньший размер и временно увеличиваться в пиковые окна.

Как это влияет на SLA аналитики для разных команд

Разные команды получают «свой» прогнозируемый уровень сервиса: финансы — быстрые отчёты к дедлайну, продукт — свободу экспериментов, data team — спокойные регламентные прогрузки. В итоге производительность становится управляемой величиной, а не лотереей из‑за общего ресурса.

Экономика и контроль затрат: почему модель «по факту» не всегда проще

Одно из главных обещаний Snowflake — платить отдельно за хранение данных и отдельно за вычисления. На бумаге это выглядит логично: хранение — относительно предсказуемая часть по объёму, а вычисления — переменная часть, зависящая от того, сколько и как часто вы запускаете запросы, загрузки и трансформации.

Две статьи расходов — две разные логики управления

Хранение обычно растёт плавно: новые источники, историчность, резервные копии, промежуточные слои. Это проще прогнозировать, но важно заранее договориться о сроках хранения, политиках архивации и о том, какие данные действительно нужны.

Вычисления — другая история. Здесь стоимость зависит от выбранных «размеров» вычислительных ресурсов и времени их работы. И именно эта часть чаще всего приносит сюрпризы.

Где возникает перерасход

Типовой риск — «перестраховаться» и выделить слишком крупные вычислительные ресурсы под всё подряд: ежедневные загрузки, ad‑hoc аналитика, BI‑дашборды и тяжёлые витрины. При такой модели один неверный выбор размера или параллельности превращается в заметный счёт. Ещё одна частая причина — ресурсы, которые простаивают, но формально остаются включёнными.

Практики контроля затрат

Рабочий набор мер обычно включает:

- лимиты и алерты по потреблению (на команды, проекты, среды dev/test/prod);

- расписания: тяжёлые пересчёты — ночью, отчёты — в «окна» активности;

- автоотключение простоя и стандарты «размеров по умолчанию»;

- правила доступа: кто может запускать тяжёлые запросы и с какими квотами.

Как прикинуть бюджет без обещаний «в два раза дешевле»

Лучше начинать с замеров: 1–2 недели реальных нагрузок (ETL/ELT, BI, ad‑hoc), затем сценарное моделирование — «базовый», «рост на 30%», «пиковый месяц». И обязательно фиксировать допущения: частота пересчётов, число пользователей, SLA по времени отклика.

Модель «по факту» даёт гибкость, но не отменяет финансовой дисциплины: без неё переменная часть бюджета становится неуправляемой.

От данных к отчётам: как меняется пайплайн вокруг DWH

Оплачивайте разработку кредитами

Зарабатывайте кредиты за контент о TakProsto или приглашайте коллег по рефералке.

Разделение хранения и вычислений меняет не только ресурсы под запросами, но и то, как команда строит путь данных от источников до дашбордов. Если раньше пайплайн часто подгоняли под ограничения одного кластера, то теперь его проще проектировать вокруг задач: регулярная загрузка, быстрые трансформации, стабильные отчёты и предсказуемые затраты.

Загрузка данных: пакетно и потоково — где границы применимости

Пакетная загрузка остаётся самым простым и дешёвым способом для большинства случаев: ежедневные/почасовые обновления витрин, пересчёт агрегатов, догрузка справочников. Она хорошо контролируется (окна загрузки, откаты, контроль качества) и легче объясняется бизнесу.

Потоковая загрузка нужна, когда ценность данных быстро падает: мониторинг операций, антифрод‑сигналы, оперативные статусы заказов. Но «стриминг ради стриминга» часто усложняет жизнь: больше точек отказа, сложнее идемпотентность, выше требования к наблюдаемости. Практичная граница — если отчёты реально используют данные с задержкой в минуты, а не по принципу «когда‑нибудь пригодится».

Трансформации: где выполнять — внутри DWH или во внешних инструментах

Есть два типовых подхода:

- ELT внутри DWH (SQL‑модели): удобно для прозрачности и повторяемости; проще обеспечить единые правила расчётов и версионирование моделей.

- Трансформации во внешних ETL/оркестраторах: полезно, когда нужно много нестандартной логики, сложная обработка файлов, интеграции с API или жёсткое разделение ответственности между командами.

Часто выигрывает гибрид: «сырые» данные приводятся к базовому качеству снаружи, а бизнес‑логику (метрики, витрины, семантику) держат ближе к DWH.

BI и визуализация: отзывчивость и кэширование

Пользователь BI оценивает систему по одному критерию — как быстро открывается отчёт. Поэтому важно заранее договориться о:

- целевых SLA по времени ответа (например, 2–5 секунд для основных дашбордов);

- стратегии кэширования в BI и обновления агрегатов;

- разделении «тяжёлых» аналитических запросов и типовых интерактивных срезов.

Что важно проверить в пилоте

Пилот должен отвечать не на вопрос «работает ли», а «какой будет эксплуатация». Проверьте: типы данных (полуструктурированные поля, даты/таймзоны), реальные объёмы и рост, частоту обновлений и пики нагрузки, а также воспроизводимость расчётов (одинаковые цифры в разных отчётах).

Полезно включить 2–3 ключевых дашборда, один потоковый или околопотоковый сценарий и один тяжёлый «разбор полётов» запрос — так пайплайн проявит слабые места ещё до промышленного запуска.

Почему экосистема важна не меньше производительности

Высокая скорость запросов важна, но в реальном проекте ценность хранилища данных определяется тем, насколько быстро и безопасно вы доводите данные до людей и процессов. Поэтому «платформа» — это не только ядро хранения и вычислений, но и набор интеграций и практик вокруг него: загрузка данных, контроль качества, управление доступом, наблюдаемость и удобство сопровождения.

Платформа = цепочка от источника до отчёта

Даже самый быстрый движок не поможет, если данные сложно подключать, невозможно нормально описывать и трудно объяснять бизнесу. Экосистема закрывает «стыки» между командами и инструментами: где данные появились, кто их изменил, что считается эталоном, почему метрика в отчёте такая.

Критичные слои, которые чаще всего определяют успех внедрения:

- ETL/ELT и оркестрация: регулярные загрузки, инкременты, расписания, ретраи, контроль SLA.

- Каталог и линейность (lineage): где находится датасет, как считается поле, откуда оно взялось.

- Качество данных: проверки, пороги, алерты, «стоп‑краны» на плохие партии.

- MDM/справочники: единые сущности (клиент, товар, договор) и правила сопоставления.

- Наблюдаемость: метрики пайплайнов и запросов, расход ресурсов, причины деградаций.

Отдельно стоит помнить про «потребительский слой» — внутренние сервисы и приложения, которые используют витрины и метрики. На практике именно они превращают аналитику в действие: алерты, операционные панели, workflows для команд.

Например, такие прикладные инструменты (внутренние порталы, дешборды для команд, формы для ручного разбора инцидентов по данным) можно быстро собирать на TakProsto.AI — платформе vibe-coding для российского рынка. Вы описываете в чате, что нужно (роль‑модель, экраны, источники данных, сценарии), а TakProsto.AI помогает сделать веб‑приложение (React), бэкенд (Go + PostgreSQL) и при необходимости мобильную часть (Flutter), с возможностью деплоя, хостинга, снапшотов и отката. Это не заменяет DWH, но сокращает время от «данные готовы» до «команда реально пользуется».

Партнёрские коннекторы и маркетплейсы интеграций

Готовые коннекторы к популярным источникам и BI‑инструментам экономят месяцы работы: меньше самописных скриптов, меньше точек отказа, быстрее обновления под изменения API. Маркетплейсы интеграций добавляют «пакеты ценности» — от загрузчиков до инструментов безопасности — и дают возможность выбирать подходящее под ваш стек без длинных циклов разработки.

Как экосистема снижает сроки и риски

Чем больше готовых и поддерживаемых интеграций, тем короче путь от пилота к промышленной эксплуатации: проще собрать прототип, быстрее наладить качество и доступы, легче передать систему в сопровождение. В итоге снижается риск, что проект «застрянет» на операционных мелочах — и производительность так и не превратится в бизнес‑результат.

Безопасность и комплаенс: что нужно предусмотреть заранее

Безопасность в облачном хранилище данных — это не только «поставить галочки» в настройках. Чем раньше договориться о правилах доступа, аудита и изоляции, тем меньше риск, что платформа вырастет быстрее, чем процессы вокруг неё.

Управление доступом: роли, права, разделение по командам и проектам

Базовая модель — RBAC (role‑based access control): пользователям не выдают права напрямую, вместо этого назначают роли. Практичный подход — разделить роли по функциям (аналитик, инженер данных, администратор) и по зонам ответственности (проект/домен/команда).

На старте важно зафиксировать:

- принцип наименьших привилегий: доступ ровно к тому, что нужно для работы;

- разделение сред (dev/test/prod) и запрет «случайных» прав на прод;

- правила для сервисных аккаунтов и автоматизаций (отдельные роли, ограниченные права, ротация секретов).

Если в данных есть чувствительные поля, заранее обсудите маскирование и политики доступа на уровне строк/столбцов: это позволяет отдавать один и тот же набор данных разным группам с разной степенью детализации.

Требования к соответствию и аудит: какие вопросы задаёт безопасность

Команды безопасности обычно спрашивают про аудит действий: кто получил доступ, кто выгружал данные, кто менял роли и политики. Важно убедиться, что журналы событий доступны, сохраняются нужное время и могут выгружаться в ваш SIEM/хранилище логов.

Отдельный блок — требования к хранению: регион размещения данных, шифрование «на диске» и «в канале», управление ключами (включая варианты с ключами клиента), а также процедура реагирования на инциденты.

Изоляция данных и мультиарендность: что уточнить у провайдера

В облаке неизбежна мультиарендность, поэтому уточните, как обеспечивается логическая изоляция, какие есть варианты выделенных ресурсов и как ограничиваются сетевые пути доступа (например, приватные подключения).

Практика: минимальные политики, которые стоит закрепить до масштабирования

Минимальный набор, который окупается почти всегда: единый каталог ролей и владельцев данных, обязательные ревью прав доступа, шаблоны для новых проектов, правила хранения/удаления данных и регулярные отчёты по аномальным действиям (массовые выгрузки, неожиданные изменения прав).

Управление данными: модели, витрины и ответственность

RBAC для внутренних инструментов

Настройте роли и доступы в приложении так же строго, как в вашем DWH.

Когда DWH становится «общим холодильником» для всех команд, быстро появляется два симптома: сотни похожих таблиц с непонятными названиями и отчёты, которые считают одно и то же разными способами. Управление данными — это не бюрократия, а способ сохранить понятность и доверие к цифрам, особенно когда платформой пользуются многие.

Домены и витрины без «зоопарка» таблиц

Практичный старт — разложить данные по доменам (например, продажи, маркетинг, финансы, продукт) и закрепить за каждым понятные «контуры»:

- Raw/Staging: как получили из источников, с минимальными изменениями.

- Core/Model: очищенные и согласованные сущности (клиент, заказ, платёж), с едиными ключами и правилами.

- Mart: витрины под конкретные задачи BI и аналитики (например, воронка продаж или LTV).

Так вы избегаете ситуации, где каждая команда делает свои «почти те же» расчёты и плодит таблицы для одного отчёта.

Моделирование: когда нужны витрины, а когда достаточно сырья

Если потребители данных — в основном аналитики с SQL‑навыками, а вопросы часто меняются, иногда достаточно качественного Core‑слоя и хорошо документированных сырых данных.

Витрины становятся обязательными, когда:

- отчётность должна быть стабильной и одинаковой для всех;

- много самообслуживания (business users в BI) и нужны «готовые» показатели;

- есть требования к контролю качества и воспроизводимости метрик.

Главное — не превращать витрину в копию сырых таблиц. Витрина — это про смысл: единые определения и удобные поля.

Версионирование и договорённости: схемы, нейминг, качество

Договоритесь заранее о трёх вещах: нейминг, контракты и проверки. Простой пример: core_customers, mart_sales_daily, поля в snake_case, даты в *_date, суммы в *_amount. Для изменений используйте версионирование (например, mart_sales_v2) или управляемые миграции, чтобы не ломать отчёты внезапно.

Качество лучше закреплять не словами, а правилами: уникальность ключей, допустимые значения, полнота критичных полей. Даже базовые проверки резко снижают количество «почему цифры не сходятся».

Кто владелец данных: простыми словами про роли

- Data owner — бизнес‑владелец смысла: утверждает определения показателей и решает, «какая правда правильная».

- Data steward — хранитель порядка: следит за описаниями, качеством, соблюдением договорённостей.

- Платформенная/данная команда — обеспечивает инструменты, доступы, мониторинг и изменения без простоя.

Роли могут быть совмещены в небольшой компании, но ответственность должна быть явной — иначе Snowflake и любая другая платформа быстро превратятся в склад без инструкции.

Риски привязки к поставщику и переносимость решений

Даже если платформа быстро масштабирует запросы и «просто работает», важно заранее оценить технологическую зависимость (vendor lock‑in). В DWH она возникает не только из‑за хранения данных, но и из‑за того, как построены модели, пайплайны и аналитика вокруг них.

Признаки технологической зависимости

Чаще всего привязка проявляется в мелочах, которые незаметно превращаются в «без этого уже нельзя»:

- Диалект SQL и специфические функции: удобные конструкции, расширения, типы данных, особенности работы с полустрруктурированными данными.

- Процедуры и автоматизация внутри платформы: задачи по расписанию, обработчики, встроенные механизмы загрузки и трансформаций.

- Инструменты вокруг: BI/ETL‑решения, настроенные «под платформу», готовые коннекторы, каталоги данных, мониторинг — всё это со временем становится частью архитектуры.

Как снизить риск: стандарты, абстракции, переносимость

Полностью избежать зависимости почти невозможно, но её можно контролировать:

- Держите ядро запросов ближе к стандартному SQL, а платформенные «фишки» используйте точечно и осознанно.

- Разделяйте слои: сырые данные, очищенный слой, витрины/модели. Чем проще контракты между слоями, тем легче перенос.

- Абстрагируйте пайплайны: храните логику трансформаций в репозитории, фиксируйте версии, тесты, входы/выходы. Тогда перенос — это в большей степени смена адаптеров, а не переписывание всего.

- Планируйте экспорт: периодически проверяйте, что можете выгрузить данные и ключевые таблицы в нейтральном формате (например, Parquet/CSV) без потерь по схемам и кодировкам.

«Мультиоблако» и его цена

Стратегия «сразу в нескольких облаках» оправдана, когда есть жёсткие требования по отказоустойчивости, регуляторике или по географии данных. Но она почти всегда увеличивает стоимость: дублирование данных, усложнение доступа, мониторинга и инцидент‑менеджмента.

Вопросы для договора и эксплуатации

До запуска в промышленную эксплуатацию полезно зафиксировать:

- Как устроены бэкапы и каков процесс восстановления (RPO/RTO, ответственность сторон).

- Как выполняется экспорт и миграция: сроки, ограничения, стоимость, форматы.

- Что происходит при расторжении: сроки хранения, удаление, подтверждения, доступ к журналам и аудитам.

Эти договорённости помогают сохранить управляемость, даже если через пару лет понадобится сменить платформу или архитектуру.

Как выбрать платформу: критерии и типовые сценарии

Приложение из чата

Создайте веб-приложение на React и бэкенд на Go + PostgreSQL по одному ТЗ.

Выбор платформы данных редко сводится к «быстрее/дешевле». Важно понять, какие нагрузки будут доминировать, кто будет поддерживать решение и как вы будете контролировать стоимость и безопасность в реальной эксплуатации.

1) Базовые критерии: нагрузка, команда, бюджет, безопасность

Типы нагрузок. Уточните долю ad‑hoc аналитики, регулярных отчётов, ELT/ETL, потоковой загрузки, ML/feature store, совместного использования данных с партнёрами. Платформа, идеальная для BI, может быть неудобной для дата‑саенса и наоборот.

Команда и операционная модель. Есть ли у вас сильные инженеры данных и админы, или вы хотите максимум «управляемости»? Чем меньше ресурсов на поддержку, тем важнее автоматизация: изоляция вычислений, авто‑масштабирование, мониторинг, разграничение доступа.

Бюджет и контроль затрат. В модели «оплата по факту» ключевой вопрос — насколько предсказуемы запросы. Если много неконтролируемых пользователей и нерегламентированных запросов, понадобится дисциплина: лимиты, квоты, расписания, оптимизация витрин.

Требования к безопасности и комплаенсу. Проверьте: шифрование, управление ключами, аудит, роли и политики, поддержка резидентности данных, интеграции с IAM/SSO.

2) Сравнение подходов: DWH, lakehouse, управляемые сервисы

Отдельный DWH удобен, когда основная ценность — SQL‑аналитика, стабильные витрины и понятные SLA для отчётности.

Lakehouse чаще выигрывает, если вы храните много сырых файлов/полуструктурированных данных и хотите единый контур для аналитики и ML.

Управляемые сервисы «под ключ» подходят, когда важнее скорость запуска и минимум администрирования, но обычно меньше свободы в архитектуре и оптимизациях.

3) Когда Snowflake обычно подходит — и когда лучше смотреть альтернативы

Snowflake часто выбирают, если нужно быстро масштабировать параллельные SQL‑нагрузки, разделять ресурсы между командами, подключать широкий набор ETL/BI‑инструментов и получать управляемую инфраструктуру.

Альтернативы стоит рассмотреть, если у вас: жёстко фиксированный бюджет без возможности «пульса» в расходах, сильная зависимость от open‑source‑стека и требований к переносимости, или основная работа идёт вокруг файлового озера и ML‑пайплайнов, где другой подход может быть естественнее.

4) Чек‑лист вопросов к вендору и интеграторам

- Как считаются и ограничиваются вычисления: квоты, бюджеты, алерты, «стоп‑краны»?

- Какие есть практики оптимизации запросов и витрин под наши типовые отчёты?

- Как устроены роли, аудит, маскирование/политики доступа и хранение ключей?

- План миграции: сроки, риски, что переносится автоматически, что придётся переписать?

- Стратегия отказоустойчивости и восстановление: RPO/RTO, резервные копии, тесты DR?

- Какие интеграции уже проверены (ETL/ELT, BI, каталог данных), и кто отвечает за поддержку?

Пошаговый план внедрения: от пилота до промышленной эксплуатации

Внедрение Snowflake чаще всего «ломается» не на технологиях, а на ожиданиях: команда начинает грузить всё подряд, пользователи получают доступ без правил, а затем внезапно растут расходы и появляется недоверие к данным. Ниже — практичный маршрут, который помогает избежать этого.

1) Сформулируйте цели пилота

Пилот должен отвечать на конкретные вопросы бизнеса, а не демонстрировать «как быстро работает SQL». Выберите 2–3 бизнес‑кейса (например: ежедневная выручка по каналам, маржинальность по продуктам, единый отчёт по продажам и остаткам) и заранее зафиксируйте метрики успеха.

Обычно это:

- время обновления данных (SLA),

- скорость подготовки отчёта/витрины,

- стабильность результатов (одни и те же цифры при одинаковых входных данных),

- прогнозируемость затрат.

2) Соберите минимальный, но полный стек

Важно не просто загрузить таблицы, а пройти путь «от источника до отчёта». Минимальный состав:

- загрузка данных (batch/stream — по необходимости),

- трансформации и тесты качества,

- BI‑слой для потребителей,

- каталог/документация: что означает поле, откуда оно взялось, кто владелец.

Так пилот сразу проверит, насколько хорошо работает пайплайн целиком — включая поддержку и разбор инцидентов.

Если помимо BI вам нужен «тонкий слой» для процессов (например, форма для ручной разметки причин расхождений, кабинет для владельцев метрик, простые approvals по данным), его полезно собрать сразу в пилоте. Здесь может помочь TakProsto.AI: такие внутренние приложения можно быстро поднять из описания в чате, подключив их к витринам/мартам, и параллельно отработать роли, доступы и аудит на прикладном уровне.

3) Настройте правила расходов и доступов заранее

До подключения широкого круга пользователей задайте базовые «ограничители»: роли и права, стандарты именования, лимиты и алерты на потребление, расписания для тяжёлых задач, правила остановки/возобновления вычислений.

Если вы не уверены в модели затрат, полезно заранее посмотреть, как устроены тарифы и типовые подходы к контролю: /pricing.

4) Спланируйте миграцию по волнам и обучите пользователей

Переезд лучше делать волнами: сначала отчёты с высокой ценностью и понятными зависимостями, затем — более сложные домены. Для каждой волны подготовьте чек‑лист: источники, витрины, владельцы, тесты, критерии «готово», дата переключения.

Параллельно проведите короткое обучение: как искать данные, как правильно запускать запросы, куда писать при расхождениях, как читать документацию.

5) Закрепите операционную модель

Перед промышленной эксплуатацией договоритесь о регулярных ритуалах: еженедельный обзор качества данных, ежемесячный обзор затрат, процесс изменений схемы, ответственность за витрины и KPI.

Подборки практик и разборов кейсов удобно держать под рукой в корпоративной базе знаний и обновлять по мере роста — например, добавляя материалы из /blog.

FAQ

Зачем компании вообще нужно DWH и что значит «единый источник правды»?

DWH собирает данные из разных систем и приводит их к единому формату, чтобы отчёты и метрики считались одинаково для всех.

Практический критерий «работает»: на вопрос «сколько заработали и почему изменилась маржа» команда получает один ответ без ручных сверок выгрузок.

Какие главные проблемы были у «классических» хранилищ данных?

Классическая модель часто «сцепляет» хранение и вычисления в одном кластере. Отсюда типовые проблемы:

- дорого и долго масштабировать (надо апгрейдить всё целиком);

- очереди ресурсов: тяжёлый запрос тормозит BI и других пользователей;

- сложно планировать стоимость и пики нагрузки.

В чём суть подхода Snowflake «разделить хранение и вычисления»?

Идея — хранение данных и вычисления живут в разных слоях. Данные лежат в общем хранилище, а запросы выполняются на выделяемых под задачу вычислительных ресурсах.

Это даёт независимое масштабирование: ускоряете отчёты, не затрагивая загрузки, и наоборот.

Как разделение вычислений помогает параллельной работе команд и стабильности BI?

Обычно выделяют отдельные вычислительные контуры (виртуальные кластеры) под разные нагрузки:

- BI-отчётность под SLA;

- ad-hoc анализ и «тяжёлые» эксперименты;

- загрузки и трансформации.

Так запросы меньше конфликтуют за CPU/память, а критичные дашборды остаются стабильными.

Когда имеет смысл «расширять» вычисления, а когда — «ужимать»?

Расширять вычисления стоит, если:

- запросы не укладываются в SLA;

- растёт очередь и пользователи ждут;

- есть пакетные пересчёты в пиковые окна.

Ужимать — когда нагрузка волнами и ресурсы простаивают: лучше меньший размер по умолчанию и временное увеличение в пики.

Где обычно возникают сюрпризы в затратах и как их контролировать?

Чаще всего перерасход появляется из‑за двух вещей:

- слишком крупные вычисления «на всякий случай» для всех сценариев;

- включённые ресурсы без нагрузки.

Минимальный набор контроля: автоотключение простоя, стандарты размеров, лимиты/алерты по командам и раздельные контуры для BI, ad-hoc и загрузок.

Что выбрать: пакетную загрузку или потоковую, и где практичная граница?

Пакетная загрузка подходит для большинства витрин и регламентных обновлений: проще контролировать окна, откаты и качество.

Потоковая загрузка оправдана, если ценность данных быстро падает и отчёты реально используют задержку «в минуты». Если данных «почти в реальном времени» не требуют пользователи, стриминг часто добавляет лишнюю сложность.

Что важно проверить в пилоте перед промышленным запуском?

Пилот должен проверять эксплуатацию, а не только «что SQL работает». Возьмите:

- 2–3 ключевых бизнес-кейса и 2–3 дашборда;

- реальные объёмы, рост и пики;

- один тяжёлый ad-hoc запрос;

- проверки качества и воспроизводимость цифр.

Заранее зафиксируйте SLA обновления и времени отклика, а также правила затрат и доступов.

Как правильно подойти к ролям, доступам и аудиту в облачном DWH?

RBAC — базовая модель: права выдаются через роли, а не напрямую пользователям.

Практично закрепить на старте:

- принцип наименьших привилегий;

- разделение dev/test/prod;

- отдельные роли для сервисных аккаунтов и ротацию секретов;

- аудит действий и срок хранения логов.

Для чувствительных данных полезны маскирование и политики доступа на уровне строк/столбцов.

Что такое vendor lock-in в DWH и как снизить зависимость от поставщика?

Привязка возникает из-за диалекта SQL, встроенной автоматизации и «обвязки» (ETL/ELT, BI, каталоги, мониторинг).

Снизить риск помогают:

- держать ядро запросов ближе к стандартному SQL;

- разделять слои (raw/core/mart) и фиксировать контракты;

- хранить логику трансформаций в репозитории с версиями и тестами;

- периодически проверять экспорт ключевых таблиц в нейтральные форматы (например, Parquet/CSV).

До продакшена зафиксируйте в договорённостях RPO/RTO, процесс восстановления и условия экспорта/удаления данных.