06 апр. 2025 г.·8 мин

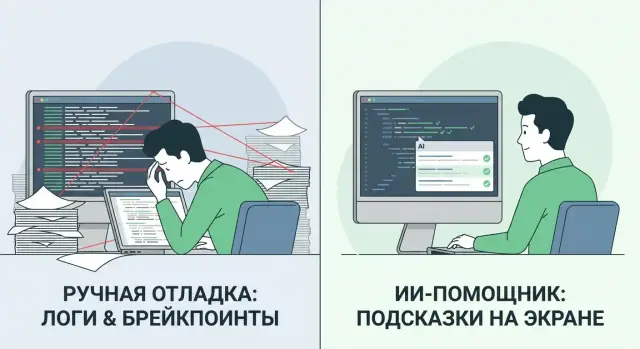

Отладка с ИИ и ручная отладка: сравнение workflow

Сравниваем отладку с помощью ИИ и классический ручной подход: скорость, точность, риски, требования к данным и как выбрать лучший workflow для команды.

Зачем сравнивать два подхода к отладке

Отладка — это не «починить строку кода». В реальном проекте она включает несколько шагов: воспроизведение проблемы, локализацию причины, исправление, а затем проверку, что фикс не породил новых багов. Если хотя бы один этап выпадает (например, «починили», но не смогли стабильно воспроизвести), команда платит временем и репутацией.

Этот материал полезен не только разработчикам. Тимлидам важно понимать, как меняется скорость и качество работы команды, QA — как строить сценарии воспроизведения и регресс, владельцам продукта — как прогнозировать сроки и риски релиза.

Что именно сравниваем

Мы сравниваем два workflow:

- Классический ручной: логи, стек-трейсы, отладчик, тесты, чтение кода, гипотезы и их проверка.

- Отладка с ИИ: те же входные данные (ошибки, логи, контекст изменений), но часть анализа и генерации гипотез ускоряется с помощью подсказок и рекомендаций.

Смотрим на шаги процесса, входные данные (логи и метрики, стек-трейс, diff, конфигурации), выход (фикс, тест, описание причины), а также риски — от неверных гипотез до утечек данных.

Критерии оценки

Сравнение имеет смысл только по понятным метрикам:

- Время до фикса и время до подтверждения исправления.

- Качество: повторяемость, отсутствие регресса, ясность причины.

- Стоимость: лицензии/инфраструктура, время инженеров, цена ошибок.

- Обучаемость команды: как подход влияет на рост джунов и эффективность сеньоров.

ИИ в этой истории — инструмент, который помогает быстрее перебрать варианты и структурировать анализ, но не заменяет инженерное мышление: ответственность за диагноз, правки и проверку остаётся на команде.

Как выглядит классическая ручная отладка

Классическая ручная отладка — это управляемый процесс, где разработчик сам собирает факты, строит гипотезы и проверяет их на системе. Главная ценность подхода — точное понимание контекста: что именно делает продукт, какие есть допущения в архитектуре и какие последствия повлечёт исправление.

Типичный цикл работы

Обычно процесс выглядит так: воспроизвести баг → сузить область поиска → найти первопричину → исправить → проверить регрессию.

Ключевой момент — «сузить область»: вместо попытки понять всё сразу разработчик уменьшает неопределённость. Например, сначала подтверждает симптом (ошибка в UI, падение сервиса, некорректные данные), затем локализует место (конкретный модуль, сценарий, изменения в последних коммитах), и только потом углубляется до конкретной правки.

Инструменты, которые чаще всего используют

Ручная отладка опирается на проверенные средства:

- брейкпоинты и пошаговое выполнение в IDE, чтобы увидеть фактические значения и порядок вызовов;

- логирование (включая корреляционные ID), чтобы восстановить цепочку событий на проде;

- дампы и stack trace для анализа падений;

- профилировщики, когда проблема в производительности или утечках;

- логи и метрики, чтобы отделить ошибку в приложении от инфраструктурной.

Роль опыта и сильные стороны

Опыт здесь решает многое: знание домена и типовых классов ошибок (гонки, неверные границы, состояния, кэш, таймзоны) ускоряет постановку гипотез. Плюс разработчик контролирует решение: понимает, почему именно так, какие крайние случаи покрыты, что нужно добавить в тесты.

Ограничения

Главный минус — стоимость времени. Сложные баги могут «съедать» часы и дни, а скорость сильно зависит от конкретных людей: кто лучше знает систему, тот и эффективнее. Это повышает риск «узких мест», когда экспертиза сосредоточена у пары ключевых разработчиков.

Как устроен workflow отладки с помощью ИИ

ИИ-отладка — это не «волшебная кнопка», а ускоритель привычного процесса. Он помогает быстрее выдвигать гипотезы, разбирать симптомы и находить место, где ошибка действительно возникает. Но финальное слово всё равно за разработчиком: любые выводы нужно подтверждать тестами и наблюдаемостью (логи, метрики, трассировки).

Практический вариант такого подхода — когда ИИ доступен прямо в рабочем чате или в среде разработки. Например, на TakProsto.AI можно вести диалог по инциденту, прикладывать обезличенные логи/стек-трейсы и получать структурированный план проверки, при этом платформа ориентирована на российский контур (серверы в России и локализованные модели), что упрощает соблюдение требований по данным.

Что делает ИИ в процессе отладки

На практике ИИ чаще всего полезен в четырёх типах задач:

- Подсказывает гипотезы: какие причины наиболее вероятны по симптомам (например, гонка, NPE, несовместимость версий, некорректный формат данных).

- Объясняет стек-трейсы и ошибки: переводит «машинный» контекст в понятные шаги, на что смотреть в первую очередь.

- Предлагает патчи и варианты исправления: от точечного изменения до рефакторинга с оговорками про риски.

- Генерирует тесты: юнит-тесты или проверки на крайние случаи, чтобы поймать регрессию и зафиксировать баг.

Важно воспринимать предложения ИИ как черновик: иногда он «угадывает» правдоподобное объяснение, которое не связано с реальной причиной.

Какие данные ИИ обычно использует

Качество ответа почти всегда зависит от входных данных. Для отладки ИИ обычно опирается на:

- фрагменты кода (минимально достаточные, связанные с симптомом);

- логи и метрики (включая корреляционные идентификаторы, временные метки);

- трассировки и стек-трейсы (полные, без обрезки ключевых кадров);

- описание симптомов (что сломалось, когда началось, как воспроизвести);

- diff/последние изменения (что поменялось перед появлением бага).

Чем точнее контекст (версии зависимостей, окружение, условия воспроизведения), тем меньше «догадок» и тем больше практической пользы.

Где ИИ встраивается в рабочий процесс

ИИ может быть встроен в разные точки workflow, и это не обязательно одна «кнопка в IDE»:

- В IDE: подсказки по стек-трейсу, быстрый анализ подозрительных участков, генерация теста рядом с кодом.

- В чате: разбор инцидента по логам/трассировкам, помощь с формулировкой гипотез и планом проверки.

- В код-ревью: поиск потенциальных ошибок в diff, подсказки по краевым случаям.

- При анализе инцидентов: структурирование причин, выделение точек наблюдаемости, предложение дополнительных метрик/логов.

- В triage задач: уточнение шагов воспроизведения, оценка приоритета, предложение минимального исправления.

Типовой цикл: от запроса до фикса

Удобно мыслить ИИ-отладку как итеративный цикл:

-

Сформулировать запрос: симптомы, ожидаемое поведение, как воспроизвести, артефакты (логи, стек-трейс, diff).

-

Получить гипотезы: 2–5 вариантов причин с признаками, по которым их можно подтвердить или опровергнуть.

-

Проверить гипотезы: воспроизвести баг, добавить точечные логи/метрики, написать минимальный тест.

-

Уточнить запрос: дать ИИ результаты проверки (например, «гипотеза A не подтверждается, потому что…»), приложить новые данные.

-

Применить исправление: выбрать патч, внедрить и обязательно закрепить тестом.

Обязательная верификация: тесты и наблюдаемость

Даже если предложенный патч выглядит логичным, его нужно проверить:

- тестами: хотя бы один тест, который падал до исправления и проходит после;

- наблюдаемостью: убедиться, что исчезла ошибка в логах, нормализовались метрики, а трассировки не показывают новых узких мест.

Это защищает от ситуации, когда ИИ предлагает «косметическое» исправление (убрать симптом), но первопричина остаётся и возвращается в следующем релизе.

Скорость и точность: что выигрывает на практике

ИИ в отладке почти никогда не «побеждает» сам по себе — он выигрывает в одних стадиях workflow и проигрывает в других. Практический эффект зависит от качества контекста (логи, стек-трейс, шаги воспроизведения) и типа багов.

Скорость: где ИИ реально ускоряет, а где тормозит

ИИ чаще всего экономит время на рутинных задачах: расшифровать стек-трейс, подсказать типовую причину исключения, напомнить про частые ошибки в обработке null, форматах дат, границах массивов, неверных SQL-параметрах. Он быстро предлагает несколько гипотез и список мест, которые стоит проверить в коде.

Но ИИ может замедлять, если:

- контекст неполный (нет логов, версий зависимостей, данных запроса, конфигурации окружения);

- во вводных много «шума» (длинные логи без фильтрации, разрозненные симптомы);

- проблема зависит от конкретного состояния системы (кэш, сессии, данные пользователя), а это не описано.

В таких случаях время уходит на уточняющие итерации и проверку предположений, которые звучат правдоподобно, но не попадают в реальность.

Точность: главная ловушка — убедительные, но неверные объяснения

Классическая ручная отладка обычно медленнее на старте, зато точнее, когда инженер выстраивает причинно‑следственную цепочку: воспроизвёл → сузил область → подтвердил наблюдением (брейкпоинт/лог/метрика) → исправил.

ИИ может дать «логичное» объяснение, которое не следует из фактов. Снижать риск помогают простые проверки:

- требуйте 2–3 альтернативные гипотезы и признаки, по которым их отличить;

- просите указать, какие факты из логов/стек-трейса поддерживают гипотезу;

- проверяйте исправление минимальным тестом или воспроизведением на тех же данных.

Покрытие и устойчивость: стандартные баги против редких случаев

ИИ лучше справляется со стандартными ошибками и типовыми паттернами. Хуже — с редкими гонками, сложными состояниями, распределёнными системами, «плавающими» таймингами и проблемами согласованности данных. Там решает дисциплина: наблюдаемость, корреляция событий, трассировка, понимание домена.

Устойчивость результата падает при неполных логах или неточном описании: модель начинает «достраивать» детали. Поэтому полезно сначала привести контекст в порядок, а уже затем подключать ИИ.

Какие метрики фиксировать

Чтобы спор про «быстрее/точнее» был предметным, начните измерять:

- время до воспроизведения;

- время до локализации (определили конкретный модуль/функцию/запрос);

- время до фикса (PR готов и проверен).

С этими числами легко увидеть, на каком этапе ИИ помогает именно вашей команде — и где лучше полагаться на ручную проверку.

Стоимость, окупаемость и затраты команды

Деньги в отладке — это не только цена инструмента, но и время людей, риск ошибок и влияние на скорость релизов. Поэтому сравнивать «отладку с ИИ» и традиционную отладку удобнее через полный цикл: запуск, владение, экономию и скрытые издержки.

Затраты на запуск

У ручного подхода входной билет ниже: IDE, дебаггер, логи, доступы — и можно работать. Но рост команды почти всегда требует формализации (гайдлайны, шаблоны логирования, правила работы с инцидентами).

ИИ-workflow обычно добавляет стартовые расходы:

- обучение команды: как проверять ответы, как писать запросы, как оформлять результат в PR;

- настройка инструментов: интеграции в IDE/репозиторий, доступ к логам и стек-трейсам;

- доступы и политики: какие данные можно отправлять, кто и где хранит контекст, как ведётся аудит.

Стоимость владения

Ручная отладка «платится» зарплатой и временем: чем сложнее система, тем дороже час поиска причины.

Для ИИ добавляются подписки или собственная инфраструктура, а также постоянные затраты на поддержку процесса: обновление политик, контроль качества результатов, выбор моделей/настроек.

Если вы выбираете платформу с полным циклом разработки (где ИИ помогает не только в отладке, но и в создании фич, тестов и прототипов), имеет смысл учитывать и сопутствующие функции. Например, в TakProsto.AI есть планирование (planning mode), снапшоты и откат, а также экспорт исходников — это упрощает безопасные эксперименты с фиксом и быстрый возврат к рабочей версии, если гипотеза не подтвердилась.

Экономия времени: где выигрыш максимальный

Обычно больше всего выигрывают роли и задачи, где много рутины:

- дежурные инженеры и мидлы — быстрое резюмирование инцидента по логам и стек-трейсу;

- разработчики фич — ускорение анализа «почему упало» и поиск вероятного участка кода;

- QA/аналитики — формулировка гипотез по воспроизведению и проверке.

При этом экономия выше на типовых ошибках (NPE, неверные параметры, регрессии), а ниже — на архитектурных сбоях и гонках.

Скрытые издержки

Главный риск ИИ — «дешёвые» патчи, которые быстро закрывают симптом, но увеличивают технический долг. Ещё одна статья — переработка неверных подсказок: время уходит не на исправление бага, а на проверку того, что предложено.

Как считать ROI

Считайте не «сколько сэкономили часов», а метрики процесса:

- частота и тяжесть инцидентов;

- MTTR (среднее время восстановления);

- скорость релизов и доля откатов;

- процент задач, где ИИ-сессия дала проверяемую гипотезу и PR без дополнительной переработки.

Если после внедрения ИИ MTTR падает, а число повторных инцидентов не растёт — окупаемость, как правило, становится видимой уже в первые спринты.

Влияние на навыки: джуниоры, мидлы и сеньоры

Нужен контроль над кодом

Заберите исходники и продолжайте отладку привычными инструментами команды.

ИИ меняет не только скорость поиска багов, но и то, какие навыки закрепляются у разработчиков. Если встроить его без правил, он может «замазать» пробелы в понимании. Если встроить правильно — ускорит рост и повысит качество решений.

Джуниоры: быстрее вход, но больше соблазн «скопировать и забыть»

Для новичков ИИ часто полезен как переводчик ошибок: помогает расшифровать стек-трейс, подсказать вероятные причины и предложить план проверки. Это ускоряет онбординг и снижает фрустрацию.

Риск в другом: джун может перенести предложенный фикс без понимания, почему он работает, и не научиться читать логи, строить гипотезы и проверять их тестами. Хорошая практика — требовать короткое объяснение причинно‑следственной связи и подтверждение через минимальный воспроизводимый пример.

Мидлы: быстрый перебор гипотез и автоматизация рутины

Для мидлов ИИ полезен как ускоритель: он помогает быстро накидать список гипотез, предложить точки для логирования, подсказать, какие метрики посмотреть, и набросать черновик теста. Но ключевое — мидл остаётся владельцем решения: проверяет предположения, выбирает самый безопасный фикс, оценивает регрессии.

Сеньоры: контроль качества и обучение команды

Сеньорам ИИ удобен для «первого прохода» по симптомам, поиска похожих классов ошибок и генерации вариантов диагностики. При этом именно сеньоры должны задавать границы: какие данные можно отправлять, какие шаблоны запросов использовать и как оформлять отчёты об ошибках, чтобы команда говорила на одном языке.

Командная динамика: стандарты запросов и отчётов

Чтобы ИИ помогал, а не размывал ответственность, договоритесь о едином формате: что считать «готовым» запросом и как фиксировать результат в тикете.

Чек-лист: что указать в запросе к ИИ при отладке

- Симптом: что именно ломается и где это видно (сообщение, текст ошибки).

- Контекст: версия, окружение, конфигурация, что менялось перед появлением.

- Стек-трейс/логи (с обезличиванием), ключевые метрики и временное окно.

- Минимальный пример: шаги воспроизведения или небольшой фрагмент кода.

- Ожидаемое поведение и фактическое.

- Что уже пробовали и какие гипотезы исключили.

Так ИИ становится тренажёром мышления, а не заменой понимания.

Риски безопасности и приватности при использовании ИИ

Использование ИИ в отладке почти всегда означает передачу контекста: фрагментов кода, стек-трейсов, логов, конфигураций. Именно здесь чаще всего возникают риски — не из‑за «вредного» ИИ, а из‑за того, что в данных для анализа случайно оказываются секреты и персональная информация.

Конфиденциальность: что нельзя отправлять

Под запретом должны быть любые секреты: токены доступа, API-ключи, пароли, приватные ключи, содержимое .env, данные из секрет-хранилищ.

Не стоит передавать персональные данные и коммерческие идентификаторы: ФИО, телефоны, email, адреса, номера заказов, а также внутренние URL, имена серверов и структуру сети. Даже «обычный» стек-трейс иногда содержит пути к репозиторию, имена пользователей, параметры запросов.

Как случаются утечки через логи и дампы

Логи и дампы памяти — частая причина инцидентов. В них могут быть:

- тела запросов/ответов (включая токены и cookies);

- SQL-запросы с реальными данными;

- содержимое переменных окружения;

- фрагменты пользовательских сессий.

Поэтому правило простое: если артефакт можно использовать для восстановления реальных данных — его нельзя отправлять «как есть».

Подготовка контекста: маскирование и минимизация

Перед запросом к ИИ полезно сделать три шага: (1) вырезать всё лишнее, оставив минимальный воспроизводимый пример, (2) замаскировать чувствительные значения (например, TOKEN=***), (3) заменить реальные сущности на синтетические (user_id=123). Чем меньше контекста — тем ниже риск и тем легче проверять ответ.

Интеллектуальная собственность и лицензии

Если вы вставляете большие фрагменты кода, убедитесь, что это допустимо политикой компании и контрактами. Отдельно осторожно с копированием чужого кода из ответов ИИ: проверяйте лицензии, совместимость и происхождение решений.

Зафиксируйте правила с безопасностью и юристами

Лучший способ снизить риски — заранее согласовать регламент: какие данные можно отправлять, какие инструменты разрешены, как хранить историю запросов, кто и как проводит аудит. Это снимает неопределённость и защищает команду в спорных ситуациях.

Отдельный практический критерий при выборе инструмента — где физически обрабатываются данные и как устроено хранение истории запросов. В российском контуре это часто критично: удобнее, когда платформа не отправляет данные за пределы страны и работает на российской инфраструктуре.

Где ИИ чаще ошибается и как это распознать

Стандартизируйте отладку в команде

Соберите шаблон запроса для отладки и используйте его в каждом баг-репорте.

ИИ хорошо ускоряет рутину, но чаще всего «спотыкается» там, где у команды нет проверяемых фактов или проблема живёт в динамике выполнения. Полезно заранее знать типичные зоны ошибок и признаки, что подсказку лучше не принимать на веру.

Плохие логи и слабая наблюдаемость

Если логи нерелевантны, метрики не покрывают ключевые места, а алерты срабатывают «по шуму», ИИ будет строить догадки на неполной картине. Он не заменяет телеметрию.

Признаки ошибки:

- совет «добавить логирование везде» без указания конкретных точек и полей;

- игнорирование уже имеющихся метрик и трассировок;

- выводы, не опирающиеся на стек-трейс, коды ошибок, корреляционные ID.

Сложные баги: гонки, дедлоки, память, распределённые транзакции

Проблемы конкурентности и времени (race condition, deadlock) часто не воспроизводятся стабильно и требуют фактических измерений: профилирования, дампов, трассировок, анализа блокировок. ИИ может предложить «правильное на бумаге» исправление, которое не затрагивает реальную причину.

Что настораживает:

- рекомендация поменять порядок операций без доказательств (тайминги, локи, очереди);

- «универсальные» советы про пул потоков/GC без данных профайлера;

- игнорирование границ распределённой транзакции и идемпотентности.

Неверные предпосылки: ИИ может «додумать» архитектуру

Если в запросе не уточнены версии библиотек, схема данных, контракты API, окружение, ИИ нередко заполняет пробелы предположениями. В результате вы получаете убедительную, но неверную цепочку причин.

Хороший тест: попросите ИИ перечислить, какие факты ему нужны для проверки гипотезы. Если ответ расплывчатый — это сигнал, что предпосылки не зафиксированы.

Симптомы без воспроизведения: как комбинировать ИИ с трассировками и профилированием

Когда бага нет локально, используйте ИИ как генератор гипотез и план эксперимента, а подтверждение делайте через наблюдаемость: добавьте точечные структурированные логи, включите распределённые трассировки, снимите профиль CPU/памяти на горячем пути.

«Стоп-сигналы»: когда переходить к ручному разбору

- ИИ несколько итераций подряд меняет версию причины, не требуя новых фактов.

- Предлагаемое исправление не объясняет, почему исчезнут конкретные симптомы.

- Нельзя проверить гипотезу наблюдаемостью (нет метрик/трассировок) — сначала улучшайте измеримость.

- Риск высокий: финансовые операции, безопасность данных, критичная доступность — лучше сразу подключать ручной разбор и ревью.

Лучшие практики комбинированного подхода

Комбинированный подход работает лучше всего, когда ИИ используется как ускоритель мышления, а человек — как финальный арбитр качества. Ниже — практики, которые помогают получить скорость без потери надёжности.

Три уровня участия ИИ

-

Помощь в чтении ошибок: попросите ИИ расшифровать стек-трейс, объяснить типичную причину, подсветить «подозрительные» модули. Это особенно полезно при незнакомых библиотеках.

-

Генерация гипотез: пусть ИИ предложит 3–5 возможных причин, опираясь на логи, метрики и контекст изменений (например, что поменялось в последнем PR). Важно требовать: «с вероятностями и признаками, по которым проверить».

-

Предложение патчей: используйте как черновик решения, но не как готовый ответ. Просите минимальный diff и объяснение, какие сценарии он покрывает и какие может сломать.

Контроль качества обязателен

Даже удачный патч от ИИ должен проходить тот же путь, что и любой другой: тесты (unit/integration), код-ревью, статический анализ, линтеры. Хорошее правило — считать ответ ИИ «подсказкой», пока не доказано обратное автоматическими проверками.

«Две независимые проверки»

Практика проста: ИИ дает версию причины/фикса → разработчик вручную верифицирует через воспроизведение, локальные логи, сравнение до/после, просмотр коммитов. Если ИИ предложил исправление, попросите альтернативу — расхождения часто выявляют слабые места.

Ограничение прав и данных

Не давайте инструменту доступ к прод-секретам, ключам, персональным данным без крайней необходимости. Лучше передавать обезличенные фрагменты логов и минимальный контекст, достаточный для анализа.

Документирование результата

Фиксируйте в тикете или постмортеме: причину, решение, как обнаружили, какие проверки добавили, уроки. Это снижает повторяемость багов и делает подсказки ИИ со временем точнее за счёт лучшего контекста команды.

Как правильно формулировать запросы к ИИ при отладке

ИИ помогает быстрее накидать гипотезы и подсветить подозрительные места, но качество ответа почти полностью зависит от того, как вы описали проблему. Хороший запрос — это мини-отчёт об инциденте: что болит, где болит и как воспроизвести.

Базовый шаблон запроса

Держите структуру, которую удобно копировать в тикет или заметку:

- Симптомы: что именно ломается (ошибка, зависание, неверный результат, деградация скорости).

- Ожидаемое / фактическое: «должно быть X, получается Y».

- Окружение: версия приложения, ОС/платформа, конфиги/флаги, версия зависимостей.

- Шаги воспроизведения: минимальные и повторяемые (желательно 3–7 шагов).

- Логи и метрики: релевантный фрагмент (вокруг события, с корреляционным id).

- Стек-трейс: целиком или до первого «вашего» кадра + контекстные строки кода.

Если данных много, сначала дайте краткое резюме, а затем приложите «приложение» с логами.

Как просить варианты: 3–5 гипотез

Формулировка: «Предложи 3–5 возможных причин с вероятностями (в сумме 100%). Для каждой — конкретная проверка, ожидаемый результат и что делать дальше». Так вы получите план действий, а не поток общих советов.

Как просить патч: минимальный diff и тест

Просите так: «Сделай минимальный diff для фикса. Не делай рефакторинг “заодно”. Добавь тест, который падает на текущей версии и проходит после фикса». Если есть стиль команды (линтер, форматтер, соглашения по именованию) — укажите.

Как просить тесты: unit/integration и негативные кейсы

Уточняйте: «Предложи unit и integration тесты для воспроизведения регрессии. Добавь негативные кейсы (невалидный ввод, таймауты, пустые данные), и объясни, какую ветку/условие покрывает каждый тест».

Типовые антишаблоны

- Слишком общий вопрос: «Почему падает?» без шагов и фактов.

- Нет контекста: нет версии, конфигурации, примера входных данных.

- «Мусорный» лог: большие объёмы без вырезки вокруг ошибки и без ключевых id.

- Вставка секретов: токены, приватные ключи, персональные данные. Перед отправкой редактируйте и маскируйте (например,

TOKEN=***).

Как выбрать подход для вашей команды и проекта

План расследования за минуты

Сформулируйте шаги расследования в planning mode, чтобы ничего не забыть.

Выбор между ручной отладкой и отладкой с ИИ — это не «или/или», а настройка пропорций под ваш контекст. Начните с простого: оцените риск ошибки, ограничения по данным и то, насколько команда умеет стабильно воспроизводить баги, читать стек-трейсы и работать с логами и метриками.

Критерии выбора

Критичность системы. Чем выше цена ошибки (платежи, безопасность, медицина), тем больше ценится проверяемость: воспроизводимость, статический анализ, ручная валидация гипотез.

Регуляторика и чувствительность данных. Если нельзя отправлять логи/дампы наружу или есть строгие требования к приватности, ИИ подключают либо в закрытом контуре, либо используют только на обезличенных фрагментах.

Зрелость команды. Для джуниоров ИИ полезен как «второй взгляд», но может закреплять неверные привычки. Сильные мидлы/сеньоры обычно быстрее фильтруют советы и превращают их в проверяемые шаги.

Таблица рекомендаций

| Контекст | Больше ручной подход | Усиливать ИИ |

|---|---|---|

| Высокий риск и строгие требования | Да: воспроизведение, ревью, статический анализ | Ограниченно: идеи, поиск причин на обезличенных данных |

| Типовой продукт, умеренный риск | Частично | Да: разбор стек-трейса, генерация гипотез, подсказки по логам |

| Низкий риск, быстрые итерации | Минимально необходимое | Максимально: ускорение triage и фиксов с обязательной проверкой |

Пилот и внедрение

Сделайте пилот: выберите 1–2 команды, 2–3 типовых сценария багов (регрессия, race condition, падение по стек-трейсу), измерьте метрики до/после (время до воспроизведения, время до фикса, доля откатов).

Дальше — внедрение: короткое обучение, гайды и чек-листы, критерии «готовности изменения» (тесты, логи, подтверждение причины). Полезно закрепить политику использования инструментов в одном месте — например, /blog/ai-tools-policy.

Выводы и чек-лист внедрения

ИИ в отладке сильнее всего там, где нужно быстро сузить круг причин: разобрать стек-трейс, подсказать гипотезы по логам, предложить варианты исправления и тест-кейсы. Ручная отладка выигрывает, когда требуется глубокое понимание домена и архитектуры: сложные гонки, неочевидные побочные эффекты, деградации производительности, ошибки в требованиях и интеграциях.

Короткий итог: где что работает лучше

ИИ ускоряет старт расследования и рутину (поиск по коду, чтение больших логов, генерация проверок). Человек нужен для подтверждения причинно-следственных связей, выбора безопасного решения и оценки влияния на продукт.

Обязательная верификация (без исключений)

Любые рекомендации ИИ должны проходить проверку теми же «воротами качества», что и обычный фикс:

- тесты (минимум: воспроизведение бага + регрессионный тест)

- наблюдаемость: логи, метрики, трассировки до/после

- код-ревью с акцентом на побочные эффекты и безопасность

Рекомендации по старту внедрения

Начинайте не с «подключить ИИ», а с подготовки данных и процесса:

-

Улучшите логи: понятные сообщения, корреляционные ID, контекст ошибок.

-

Стандартизируйте баг-репорты: шаги воспроизведения, ожидаемое/фактическое, окружение, ссылки на логи.

-

Запустите пилот: выберите 1–2 команды и типовые классы багов, зафиксируйте метрики (время до локализации, время до фикса, количество откатов).

Практика для читателя

Соберите список 10–20 самых частых дефектов (например, NPE, таймауты, ошибки валидации, проблемы миграций). Для каждого сравните два сценария: «с ИИ» и «без», измеряя время и качество (количество повторных инцидентов, объём правок, покрытие тестами).

Чек-лист обновления внутренних инструкций

- какие данные можно передавать ИИ, а какие — нельзя

- шаблон запроса к ИИ (контекст, ограничения, формат ответа)

- правило: фикс принимается только после тестов и ревью

- ретроспектива пилота и корректировка процесса

Следующий шаг — честно оценить текущий workflow отладки и обновить внутренние инструкции так, чтобы ИИ стал помощником, а не источником случайных правок. Если вы уже используете чат-ориентированные платформы для ускорения разработки (например, TakProsto.AI), логично включить туда и стандартизированный сценарий отладки: единый шаблон запроса, обезличивание артефактов, обязательные тесты и фиксацию выводов в тикете — так скорость растёт, а управляемость не теряется.

FAQ

По каким метрикам реально сравнивать ручную отладку и отладку с ИИ?

Сравнивать имеет смысл по метрикам, которые отражают весь цикл:

- Время до воспроизведения (можете ли стабильно повторить проблему).

- Время до локализации (нашли модуль/функцию/запрос, где рождается ошибка).

- Время до фикса и подтверждения (PR готов, тесты зелёные, симптомы исчезли в логах/метриках).

- Качество: есть тест, который падал до фикса и проходит после; нет повторного инцидента.

- Побочные эффекты: доля откатов/горячих фиксов после релиза.

Когда лучше выбирать ИИ-отладку, а когда — классическую ручную?

Почти всегда выигрывает комбинация:

- ИИ используйте для быстрого старта: расшифровать стек-трейс, накидать 3–5 гипотез, подсказать точки логирования и черновик теста.

- Ручная проверка обязательна для подтверждения причинно‑следственной связи: воспроизведение, наблюдаемость (логи/метрики/трассировки), минимальный фикс.

Практическое правило: чем выше цена ошибки (деньги, безопасность, доступность), тем больше доля ручной валидации и ревью, а ИИ — только как источник идей.

Как правильно формулировать запрос к ИИ при отладке, чтобы не получить общие советы?

Короткий шаблон, который даёт качественные ответы:

- Симптом: что ломается и где это видно (сообщение, код ошибки).

- Ожидаемое vs фактическое поведение.

- Окружение: версии приложения/зависимостей, конфиги/флаги.

- Шаги воспроизведения (минимальные и повторяемые).

- Артефакты: релевантный фрагмент логов + корреляционный ID, полный стек-трейс, последний diff/коммиты.

- Что уже пробовали и какие гипотезы исключили.

Полезная формулировка: «Дай 3–5 причин с признаками проверки и ожидаемым результатом каждой проверки».

Как проверять исправления, если ИИ предложил патч или объяснение причины?

Минимальный набор, который закрывает риск «вроде починили, а потом вернулось»:

- Тест: хотя бы один (unit/integration), который падает до и проходит после.

- Наблюдаемость: проверьте, что исчез конкретный симптом в логах/алертах и нормализовались метрики.

- Код-ревью: попросите проверить не только фикс, но и крайние случаи и возможный регресс.

Если ИИ предложил патч, просите минимальный diff без «рефакторинга заодно» и явное перечисление, что может сломаться.

Почему ИИ может ошибаться в отладке и как это быстро распознать?

Потому что ИИ часто даёт убедительные, но неверные версии причины, особенно при неполном контексте.

Чтобы снизить риск:

- Требуйте 2–3 альтернативные гипотезы и признаки, которые их различают.

- Просите указать, какие факты из логов/стек-трейса поддерживают каждую гипотезу.

- Проверяйте гипотезы экспериментом: воспроизведение, точечные логи/метрики, минимальный тест.

Стоп-сигнал: модель меняет «причину» несколько итераций подряд без новых фактов — переходите к ручному разбору и улучшению наблюдаемости.

Какие риски безопасности у ИИ-отладки и как безопасно передавать контекст?

Риск возникает из-за того, что в логах/дампах/конфигах часто «случайно» живут секреты и персональные данные.

Что нельзя передавать:

- токены, API-ключи, пароли, приватные ключи, содержимое

.env; - персональные данные и коммерческие идентификаторы;

- внутренние адреса и детали инфраструктуры, если это запрещено политиками.

Практика подготовки контекста:

- минимизация (оставить только нужное);

- маскирование (

TOKEN=***); - синтетические заменители (

user_id=123).

Закрепите правила единым документом (например, /blog/ai-tools-policy) и следуйте ему в каждом инциденте.

Как посчитать окупаемость (ROI) внедрения ИИ в отладку?

Обычно да, если измерять не «ощущения», а показатели процесса:

- MTTR (среднее время восстановления) и время до локализации.

- Доля задач, где ИИ дал проверяемую гипотезу, которая привела к PR без переработок.

- Доля повторных инцидентов и откатов (не должна расти).

Рекомендация по внедрению: сделайте пилот на 1–2 командах и 2–3 типовых классах багов, зафиксируйте базовую линию, затем сравните до/после по одинаковым метрикам.

Какие данные и артефакты нужно подготовить, чтобы ИИ реально помогал в расследовании?

Чтобы ИИ ускорял, а не замедлял, заранее договоритесь о стандарте входных данных:

- корелляционный ID и структурированные логи;

- понятные временные метки и окно вокруг события;

- полный стек-трейс без обрезки ключевых кадров;

- ссылка на diff/коммиты перед появлением бага;

- воспроизводимый сценарий.

Если наблюдаемость слабая, начните с улучшения логирования и метрик — тогда и ручная отладка, и ИИ станут заметно эффективнее.

Как ИИ влияет на навыки команды (джуны/мидлы/сеньоры) и как избежать деградации качества?

Для джуниоров ИИ полезен как «переводчик» ошибок и генератор плана проверки, но есть риск копировать фикс без понимания.

Практики, которые помогают обучению:

- требовать короткое объяснение «почему это причина» и «почему фикс работает»;

- просить минимальный воспроизводимый пример;

- принимать исправления только с тестом и описанием проверок.

Для сеньоров фокус — на правилах: какие данные можно передавать, как оформлять результат и как делать ревью решений, подсказанных ИИ.

Как выстроить комбинированный процесс «ИИ + ручная отладка» без потери надёжности?

Быстрый практический чек-лист:

- Используйте ИИ на этапах triage и генерации гипотез, но фикс принимайте только после тестов и наблюдаемости.

- Всегда просите несколько гипотез и план проверок, а не один «правильный ответ».

- Ограничьте данные: только обезличенный и минимально достаточный контекст.

- В тикете/постмортеме фиксируйте: причину, решение, как проверили, какой тест добавили.

Так ИИ становится ускорителем workflow, а ответственность и качество остаются управляемыми.