11 окт. 2025 г.·8 мин

Как управление памятью влияет на скорость и безопасность языков

Разбираем стратегии управления памятью в языках: GC, подсчет ссылок, владение и ручной подход. Как они влияют на скорость, паузы и безопасность.

Разбираем стратегии управления памятью в языках: GC, подсчет ссылок, владение и ручной подход. Как они влияют на скорость, паузы и безопасность.

Управление памятью — это набор правил и механизмов, которые отвечают за жизненный цикл данных в программе: где они размещаются, когда выделяются, кто имеет право их менять и когда их можно освободить. На практике это означает, как часто программа обращается к памяти, насколько регулярно выполняет «дорогие» операции выделения/освобождения и может ли она случайно прочитать или записать не туда.

Одна и та же логика может вести себя по‑разному в разных языках, потому что у каждого языка своя модель: часть работы делает программист, часть — рантайм, часть — компилятор. Например, в одном языке создание объектов может быть очень дешёвым, но иногда сопровождаться паузами на уборку; в другом — пауз почти нет, зато каждое изменение ссылок требует дополнительных операций.

Скорость и предсказуемость. Важно не только «сколько в среднем», но и «как стабильно». Программа может показывать высокий средний throughput, но иметь редкие задержки в десятки миллисекунд — и это критично для игр, аудио, трейдинга или высоконагруженных API.

Безопасность и простота. Чем больше контроля вручную, тем выше риск ошибок вроде use-after-free или утечек. Чем больше автоматизации, тем проще писать код, но тем сложнее гарантировать отсутствие пауз и накладных расходов.

Дальше разберём, как эти подходы проявляются в конкретных местах программы — начиная с того, где вообще «живут» данные.

Почти любая программа постоянно размещает данные в памяти. Где именно они «живут» — на стеке или в куче — напрямую влияет и на скорость, и на риск ошибок. Полезно понимать эту разницу, даже если язык скрывает детали.

Стек — это область памяти, которая растёт и «схлопывается» вместе с вызовами функций. Локальные переменные, параметры, временные значения часто оказываются именно здесь.

Главный плюс: выделение и освобождение происходят автоматически. По сути, стеку обычно достаточно сдвинуть указатель на несколько байт — это очень дёшево по времени и почти не требует сложной логики.

Ограничения тоже заметны: стек хорошо подходит для данных с понятным временем жизни (в пределах вызова функции) и обычно имеет фиксированный лимит. Большие структуры или данные, которые должны жить дольше, чем текущая функция, часто нельзя (или нежелательно) хранить на стеке.

Куча используется, когда нужно создать объект с более сложным временем жизни: например, вернуть данные из функции, хранить их в коллекции, разделять между компонентами.

Цена гибкости — накладные расходы:

Если программа постоянно создаёт маленькие объекты в куче (например, в цикле), она тратит время не только на полезную работу, но и на обслуживание памяти: вызовы аллокатора, запись метаданных, возможные блокировки, давление на кэш. В результате падает пропускная способность и растут задержки.

Практический вывод: старайтесь держать короткоживущие данные ближе к стеку, а для кучи — уменьшать количество мелких выделений (например, через буферы, переиспользование объектов или предварительное резервирование в контейнерах).

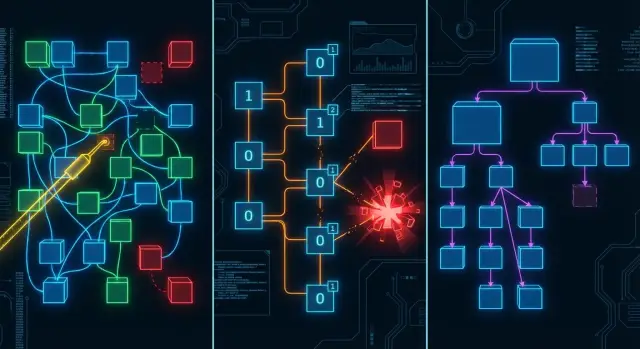

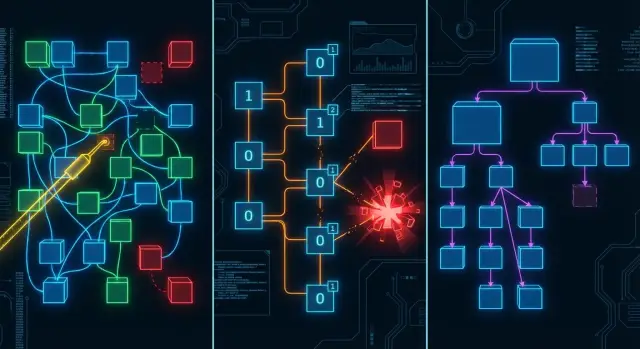

Сборщик мусора (Garbage Collector, GC) снимает с разработчика обязанность вручную освобождать память: вы создаёте объекты — среда выполнения сама находит те, которые больше недостижимы, и освобождает их. Это резко снижает вероятность утечек и «двойного освобождения», упрощает поддержку кода и ускоряет разработку, особенно в больших командах.

Главный плюс — меньше ручной работы и меньше ошибок управления памятью. В типичном приложении много мелких объектов, временных структур и «связанных» данных (например, графы объектов в UI, деревья документов, кэши). GC хорошо справляется с такими сценариями: он умеет обходить сложные графы ссылок и освобождать циклы, которые при подсчёте ссылок часто требуют дополнительных ухищрений.

Минусы проявляются в предсказуемости. Чтобы освободить память, GC должен оценить, что ещё «живое». В простейшем варианте он останавливает выполнение программы, делает работу и запускает её снова. Это и есть пауза, которая может быть незаметна в бэкенде, но критична в играх, аудио, торговых системах и любых задачах с жёсткими требованиями к задержкам.

GC чаще выигрывает там, где важнее пропускная способность и скорость разработки, а не строгие миллисекундные дедлайны: сервисы с большим количеством объектов, сложными графами ссылок и частыми изменениями модели данных.

Подсчёт ссылок — это подход, где у каждого объекта есть счётчик: сколько «сильных» ссылок на него сейчас существует. Как только счётчик становится равен нулю, объект сразу же освобождается. То есть момент удаления определяется не «когда-нибудь потом», а строго событием: исчезла последняя ссылка.

Главный выигрыш — детерминизм. Память освобождается предсказуемо и обычно быстро, без крупных глобальных пауз, характерных для некоторых реализаций GC.

На практике это даёт:

Подсчёт ссылок добавляет постоянные накладные расходы: при каждом копировании/присваивании ссылки нужно увеличить счётчик, а при уничтожении ссылки — уменьшить. Даже если операция выглядит «мелкой», она происходит очень часто и влияет на производительность.

Сложнее всего в многопоточности. Чтобы счётчик был корректным, обновления обычно делают атомарными. Атомики и барьеры памяти заметно дороже обычных операций и создают дополнительное давление на кеши CPU. В коде с большим количеством передач объектов между потоками это может стать значимой частью времени выполнения.

Подсчёт ссылок не умеет сам по себе собирать циклы. Если объект A ссылается на B, а B — на A, их счётчики никогда не станут нулевыми, даже когда «снаружи» на них никто не ссылается. Это приводит к утечкам памяти.

Обычно применяют один из обходных путей:

Итог: подсчёт ссылок часто даёт предсказуемость освобождения и меньшие «паузы», но расплачивается постоянными накладными операциями и необходимостью отдельно решать проблему циклов — особенно заметно в конкурентных программах.

Идея владения проста: у каждого участка данных есть один «владелец», который отвечает за время жизни этого ресурса. Когда владелец выходит из области видимости, память освобождается автоматически — без сборщика мусора и без ручного free().

Помимо владения, язык вводит правила заимствования: временный доступ к данным можно получить либо как «чтение» (несколько одновременных), либо как «изменение» (строго один на время заимствования). Эти правила проверяются компилятором, поэтому ошибки ловятся до запуска программы.

На практике это выглядит так:

Главный выигрыш — защита от целого класса уязвимостей, связанных с неправильным временем жизни объектов. В частности:

Важно: модель не «магическая». Она не заменяет проектирование потоков, блокировок и очередей, но делает опасные варианты по умолчанию невозможными.

Минус — более высокий порог входа. Иногда приходится менять структуру программы: вместо общего изменяемого состояния чаще используют передачу сообщений, явные области владения, копирование небольших структур или специальные контейнеры для разделяемого владения.

Это может ощущаться как «борьба с компилятором», особенно в коде с богатой связностью объектов (графы, кэши с обратными ссылками).

Подход хорошо раскрывается там, где важны предсказуемые задержки и контроль над ресурсами: системные компоненты, сетевые сервисы с низкими задержками, прокси/балансировщики, библиотеки для встраивания и критичные по безопасности части продукта. Здесь отказ от пауз GC сочетается с сильными гарантиями безопасности памяти.

Ручное управление памятью (как в C или частично в C++) — это подход, где разработчик сам решает, когда выделять и освобождать память. Главная ценность здесь — прямой контроль: вы видите «жизненный цикл» объекта и можете подстроить его под требования к скорости, задержкам и потреблению RAM.

Ручное управление позволяет:

Этот потенциал особенно ценен в системном программировании, встраиваемых устройствах и низкоуровневых библиотеках.

Обратная сторона — риск критических дефектов:

Такие ошибки часто проявляются нестабильно: «работает на тестах, падает в проде». Кроме крашей, они могут открывать уязвимости — вплоть до выполнения чужого кода.

Даже без GC программа не становится автоматически быстрее. Скорость могут ухудшать:

Рабочие меры защиты обычно комплексные: чёткие правила владения (кто освобождает и когда), код-ревью и аудит критичных мест, запуск санитайзеров (ASan/UBSan/LSan), статический анализ, а также дисциплина в API (например, явные функции init/free, запрет «сырых» указателей в интерфейсах там, где можно).

Ошибки управления памятью — это не только «падает программа» или «тормозит сервер». Во многих случаях это прямой путь к уязвимостям: от утечки данных до выполнения чужого кода. Ниже — самые частые сценарии и почему они так опасны.

Утечка возникает, когда объект больше не нужен, но ссылка на него где-то «застряла», либо разработчик забыл освободить ресурс вручную. В итоге процесс постепенно раздувается, чаще обращается к ОС за памятью, начинает чаще промахиваться по кэшу и может уйти в своп.

С точки зрения безопасности это тоже риск: перегруженный сервис легче «уложить» простым потоком запросов (DoS). Плюс в памяти могут дольше оставаться чувствительные данные (токены, фрагменты документов), которые при других ошибках проще извлечь.

Use-after-free — когда код продолжает использовать указатель/ссылку на объект после освобождения. «Повезёт» — будет падение. «Не повезёт» — освобождённый участок уже занят другими данными, и программа начнёт читать или писать «чужое».

Именно поэтому use-after-free часто превращается в эксплойт: атакующий пытается добиться контролируемого размещения данных на месте освобождённого объекта и направить выполнение по нужному пути.

Переполнение буфера (buffer overflow) — запись за границы выделенного блока. Чтение за пределами массива (out-of-bounds read) — похожая ошибка, но на чтение. Они возникают из-за неверных проверок длины, ошибок индексации, работы со строками/пакетами данных.

Запись за границы может повредить соседние структуры памяти: указатели, размеры, таблицы виртуальных функций. Чтение — раскрыть секреты из соседних областей памяти.

Механика простая: ошибка нарушает целостность памяти, а дальше всё зависит от того, насколько предсказуемо атакующий может влиять на входные данные и размещение объектов. Падение — самый мягкий исход. Худший — когда повреждение памяти становится управляемым и позволяет обойти проверки, украсть данные или выполнить произвольный код. Поэтому модели с проверками границ, безопасными ссылками и строгими правилами владения часто дают заметный выигрыш именно в безопасности, даже если требуют дисциплины или дополнительных ограничений.

«Быстро» у языка может означать разные вещи: максимальную пропускную способность (сколько запросов/кадров/сообщений в секунду) или низкую и, главное, стабильную задержку (как быстро отвечает система в худших случаях). Управление памятью влияет на обе метрики — и особенно на предсказуемость.

Среднее время ответа легко выглядит хорошо, пока единичные «провалы» не начинают портить опыт пользователей. Поэтому важнее смотреть на p95/p99: 95% и 99% запросов укладываются в целевое время или нет.

Сборщик мусора, крупные перераспределения памяти или остановки на синхронизацию могут давать редкие, но заметные пики. Даже если среднее отличное, p99 может «вылетать» из SLA.

Если цель — обработать максимум данных за минуту (batch, аналитика), допустимы более длинные паузы при высокой общей скорости. Если цель — мгновенный отклик (UI, игры, торговые системы), важнее минимизировать джиттер и хвостовые задержки, даже ценой небольшой потери throughput.

Когда растут объёмы данных и число одновременных операций, увеличивается количество выделений, чаще срабатывает очистка/освобождение, усиливается фрагментация, а кэши процессора промахиваются чаще. В итоге задержки становятся «неровными», а система — менее стабильной.

Веб‑сервис обычно чувствителен к p99 (всплески задержек заметны клиентам). UI критичен к стабильности кадра (например, 16,6 мс для 60 FPS). Потоковая обработка данных ценит стабильный throughput и контроль памяти при длительной работе. Игры требуют предсказуемых кадров и часто избегают непредсказуемых пауз, заранее планируя выделения.

Когда частые выделения/освобождения памяти становятся узким местом, разработчики часто переходят от «много маленьких аллокаций» к более крупным и предсказуемым схемам. Пулы, арены и пакетное освобождение могут заметно ускорить код — но почти всегда ценой гибкости и рисков перерасхода памяти.

Арена (arena allocator) выделяет память крупными блоками, а затем раздаёт её маленькими кусками почти без накладных расходов. Главное преимущество — скорость и локальность данных (кэш процессора выигрывает). Освобождение обычно делается «пачкой»: вы выбрасываете всю арену целиком, когда заканчивается фаза работы (например, обработка одного запроса).

Это отлично подходит для временных объектов с одинаковым жизненным циклом: парсинг, построение AST, подготовка ответа, однопроходные вычисления.

Объектный пул хранит заранее созданные объекты и выдаёт их повторно. Он помогает, когда:

Но пул усложняет дизайн: нужно аккуратно «сбрасывать» состояние объектов, следить за потокобезопасностью и не получать скрытые зависимости (объект вернулся в пул, а кто-то ещё держит на него ссылку).

Часто самый простой выигрыш — меньше выделять: переиспользовать буферы, работать со срезами/представлениями вместо копирования, заранее резервировать ёмкость коллекций, объединять мелкие структуры в более крупные.

Компромисс у «пакетного» подхода один: память может жить дольше, чем реально нужна. Арена держит всё до конца фазы, пул — до тех пор, пока вы его не очистите или не ограничите размер. Итог — рост пикового потребления и неожиданные всплески RAM под нагрузкой. Поэтому пулы и арены стоит вводить там, где жизненные циклы действительно хорошо очерчены и измерения подтверждают пользу.

Даже если язык «по умолчанию» использует GC, подсчёт ссылок или владение, финальная скорость часто зависит от того, насколько хорошо компилятор и рантайм уменьшают количество выделений памяти, копирований и проверок. Хорошая новость: многое можно понять без глубокого погружения в теорию компиляторов.

Ключевая оптимизация — escape analysis (анализ «выхода» объекта за пределы функции). Если компилятор видит, что объект не переживёт текущий вызов и не будет использован где-то «снаружи», он может:

Для прикладного кода это означает: аккуратные области видимости и отсутствие лишних возвращаемых ссылок/замыканий часто помогают производительности без ручных трюков.

Инлайн (inlining) подставляет тело маленьких функций в место вызова. Это снижает стоимость вызовов и открывает дорогу другим оптимизациям: удалению временных объектов, упрощению проверок, лучшему размещению данных.

Специализация (например, под конкретный тип в дженериках) позволяет компилятору генерировать более прямой код без универсальных «обёрток». Цена — больший размер бинарника, но часто — меньше аллокаций и лучше кэш‑поведение.

Рантайм обычно оптимизирует горячие места: быстрые аллокаторы, thread-local выделение, батчинг, поколенческие алгоритмы GC, оптимизация операций инкремента/декремента ссылок. Всё это снижает среднюю стоимость, но не отменяет худшие случаи (например, паузы GC).

Интуиция часто ошибается: «мелкая оптимизация» может не дать эффекта, а одна лишняя аллокация в цикле — стать узким местом. Начинайте с измерений (профили CPU/памяти, количество аллокаций, задержки), фиксируйте базовую линию и проверяйте изменения экспериментально.

Многопоточность почти всегда упирается в две вещи: как потоки договариваются о доступе к данным и сколько это «стоит» по времени. Стратегия управления памятью напрямую влияет на оба пункта — иногда сильнее, чем выбор алгоритма.

В подсчёте ссылок каждый «плюс один/минус один» к счётчику должен быть корректным при одновременной работе потоков. Поэтому счётчик часто делают атомарным. Атомарные операции — не магия: они заставляют процессоры синхронизироваться, ухудшают работу кэшей и могут создавать узкие места, когда множество потоков трогают один и тот же объект.

На практике это проявляется так: код, который в одном потоке быстрый, в нескольких потоках начинает заметно тратить время на «учёт ссылок», особенно если объекты активно передаются между потоками.

Сборщик мусора упрощает жизнь разработчику, но ему нужно время от времени «осмотреть» память. Для этого рантайм договаривается с потоками о специальных моментах остановки — сейфпоинтах. Проще говоря, это места, где поток может безопасно притормозить, чтобы GC понял, какие объекты ещё живы.

Цена — возможные паузы и дополнительная координация потоков. Современные GC стараются делать это параллельно и короткими порциями, но полностью убрать эффект сложно, особенно при высокой нагрузке.

Даже «безопасная» стратегия памяти не спасает от гонок данных: когда два потока одновременно меняют одно значение без правил. Модель памяти языка объясняет, какие чтения/записи могут быть переупорядочены и какие гарантии дают атомики, мьютексы и другие примитивы. Чем яснее эти правила и чем сильнее проверки (вплоть до запрета некоторых паттернов), тем выше шанс избежать ошибок, которые превращаются в уязвимости.

Для параллельных задач часто выигрывают модели, где потоки меньше делят общие объекты:

Чем меньше совместно используемого состояния — тем меньше синхронизации и тем предсказуемее производительность.

Выбор управления памятью — это не «лучше/хуже», а набор компромиссов. Ошибка чаще всего возникает, когда берут язык/рантайм «по привычке» и не проверяют ключевые требования: задержки, безопасность и цена эксплуатации.

Задержки (latency): если важны предсказуемые отклики (а не только высокая средняя скорость), избегайте сценариев, где возможны заметные паузы или «хвосты» задержек. Для интерактивных систем, трейдинга, аудио/видео важнее стабильность, чем рекорды бенчмарков.

Безопасность памяти: если продукт работает с недоверенными данными (пользовательский ввод, сеть), приоритет — модели, минимизирующие use-after-free, переполнения и гонки. Это снижает риск уязвимостей и стоимость аудита и поддержки.

Команда и скорость разработки: GC и богатая экосистема часто ускоряют поставку фич, но могут усложнить работу с пиками памяти и паузами. Модели владения или ручное управление требуют дисциплины и опытных ревью, зато дают больше контроля.

Экосистема и интеграции: иногда решающим фактором становится наличие библиотек, драйверов, ML‑стека или требований к сертификации.

Ставьте измерения раньше оптимизаций: RSS/heap, частота и время пауз, скорость аллокаций, p95/p99 задержек, количество объектов, фрагментация. Добавьте профилирование (heap/alloc), трассировку «горячих» аллокаций и алерты на рост памяти и хвосты latency.

Если вы собираете сервисы и приложения «под ключ» и хотите быстрее дойти до измеряемого результата, удобно, когда платформа уже даёт предсказуемый стек и контроль деплоя. Например, в TakProsto.AI можно собирать веб‑приложения на React, бэкенд на Go с PostgreSQL и (при необходимости) мобильные клиенты на Flutter через чат‑интерфейс: это ускоряет итерации, а дальше вы уже профилируете реальные точки нагрузки и решаете, где важнее детерминизм, а где — скорость разработки. Плюс полезны снапшоты и откат (rollback) для безопасных экспериментов с оптимизациями, а также экспорт исходников, чтобы не упираться в «чёрный ящик».

Если нужна помощь с выбором подхода, практическими ограничениями и примерами внедрения, посмотрите /pricing и разборы кейсов в /blog.

Управление памятью определяет:

Одинаковый алгоритм может вести себя по‑разному из-за стоимости аллокаций, пауз рантайма и гарантий модели памяти.

Стек обычно подходит для короткоживущих данных (в пределах вызова функции): выделение/освобождение происходит почти бесплатно за счёт сдвига указателя.

Куча нужна для объектов со сложным временем жизни (возврат из функции, хранение в коллекции, совместное использование), но за гибкость платят аллокатором, метаданными, синхронизацией и риском фрагментации.

Частые мелкие аллокации в куче создают «налог»:

Практика: заранее резервируйте ёмкость контейнеров, переиспользуйте буферы, группируйте выделения (арены/пулы) там, где жизненный цикл однородный.

GC упрощает разработку: меньше ручного освобождения, меньше ошибок вроде double free, проще работать с графами объектов и циклами.

Риски для производительности — паузы и хвостовые задержки:

Если у вас жёсткие дедлайны по кадру/запросу, измеряйте p99 и время пауз GC, а не только throughput.

Подсчёт ссылок освобождает объект сразу, когда счётчик падает до нуля — это даёт более детерминированное поведение и часто ровнее задержки.

Цена:

Практика: проектируйте слабые ссылки для обратных ссылок и внимательно смотрите на передачу объектов между потоками.

Цикл — это когда A ссылается на B, а B на A, и внешних ссылок уже нет. Счётчики не станут нулевыми, и память «утечёт».

Обычно решают так:

Лучше всего закладывать схему владения/ссылок заранее, а не «латать» утечки постфактум.

Модель владения делает время жизни данных проверяемым компилятором:

Это снижает вероятность:

Практический совет: заранее продумывайте границы владения (модули/компоненты) и избегайте «общего изменяемого» состояния без необходимости.

Пулы и арены уменьшают стоимость аллокаций за счёт «выделения пачкой».

Подход хорошо работает, если жизненный цикл объектов одинаков:

Риски:

Компилятор и рантайм могут существенно сократить аллокации:

Практика: пишите код так, чтобы объекты не уезжали наружу без необходимости (лишние замыкания/возврат ссылок часто мешают оптимизациям).

Выбирайте не «по привычке», а по требованиям:

Минимальный набор метрик для старта: RSS/heap, число аллокаций, частота/время пауз (если есть), p95/p99 latency, «горячие» места аллокаций по профилю.

Вводите пулы/арены только после измерений и с ограничениями по размеру.