11 сент. 2025 г.·6 мин

Уроки Андрея Карпати для AI-инженеров: доводим до релиза

уроки Андрея Карпати для AI-инженеров: как превратить нейросети в продукт - формулировать допущения, выбрать метрики и доводить фичи до релиза.

уроки Андрея Карпати для AI-инженеров: как превратить нейросети в продукт - формулировать допущения, выбрать метрики и доводить фичи до релиза.

Андрей Карпати стал заметным не потому, что придумал одну «волшебную» архитектуру, а потому что показал: нейросети можно превратить в нормальную инженерную практику. Он постоянно переводил идеи deep learning на язык команды, которой нужно выпускать работающий продукт, чинить ошибки, держать сроки и объяснять результат бизнесу.

Его вклад хорошо виден по тому, как менялась культура вокруг ML. Курсы и разборы вроде CS231n учили не только формулам. Они приучали смотреть на задачу целиком: где взять данные, как проверить качество, что считать успехом и как быстро получить базовый результат.

Сделать deep learning практичным в реальной команде значит сместить фокус со споров про архитектуру на вещи, которые решают судьбу релиза. Зачем фича нужна пользователю и каким выглядит полезный ответ. Какие данные доступны сейчас, а какие придется собирать после запуска. Чем измерять качество, включая ошибки, которые нельзя допускать. Какие ограничения по задержке, стоимости и поддержке есть у модели в продакшене.

Если вы добавляете автосортировку обращений в поддержку, важнее не «самая новая модель», а понятные классы, примеры из реальных тикетов, простая базовая линия (хотя бы правила) и метрика, которая отражает цену ошибки. Поэтому уроки Карпати для AI-инженеров часто звучат как здравый смысл: фиксируй допущения, измеряй результат, улучшай по фактам.

Дальше - про то, как из его работ и подхода вытащить прикладные выводы: как выпускать AI-функции так, чтобы можно было честно сказать, что именно обещаем, как это проверяем и что делаем, если реальность окажется хуже ожиданий.

Одна из причин, почему про Карпати говорят не только исследователи, - его стиль объяснений. Без «магии» и без лишних усложнений. Когда модель выглядит как набор понятных блоков, у команды появляется уверенность: это можно собрать, проверить и улучшить.

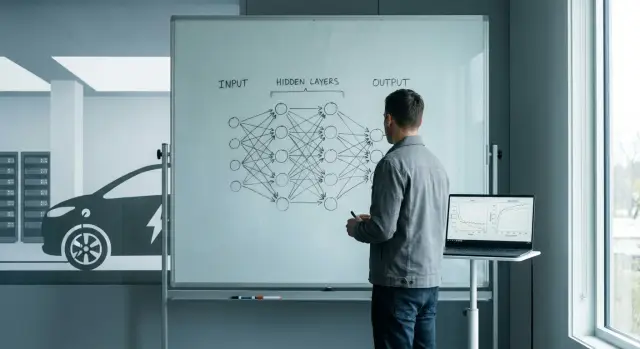

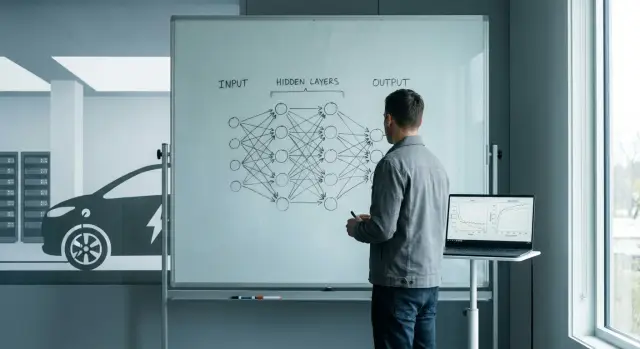

Его идея проста: нейросеть - это композиция знакомых деталей (слои, функция потерь, оптимизация), а не непостижимый объект. Такая интуиция меняет поведение инженеров. Они перестают спорить «по ощущениям» и начинают задавать нормальные вопросы: что именно модель видит на входе, где она ошибается, какой сигнал обучения мы ей даем.

Публичные разборы и учебные материалы делают индустрию взрослее. Они создают общий язык: как описывать архитектуру, как читать графики обучения, как формулировать гипотезы. Сильнее становится не отдельный «гуру», а команда, которая умеет мыслить одинаково строго.

Из подхода «показать на примерах» обычно рождаются несколько полезных привычек. Во-первых, рисовать путь данных от входа до выхода и отмечать места, где вероятна ошибка. Во-вторых, проверять идею на маленьком примере до тяжелого обучения. В-третьих, уметь назвать 1-2 главные причины, почему модель может не сработать. И наконец, отличать проблемы данных от проблем модели.

Практический вывод простой: если вы не можете объяснить модель «на пальцах» коллеге из продукта, вы почти наверняка не сможете защитить ее в релизе. Простое объяснение заставляет заранее проговорить допущения, границы применимости и способ понять, что стало лучше, а не просто «похоже, работает».

Вклад Карпати в компьютерное зрение важен тем, что он помог «приземлить» нейросети до инженерной рутины. Когда сверточные сети начали стабильно выигрывать в распознавании, разговор сместился с «магии архитектуры» на то, что можно проверить: какие данные, какая разметка, какая метрика и какой прирост после изменения.

В практической работе это выглядит как простая цепочка: фиксируем входные данные, поднимаем воспроизводимую базовую модель, выбираем метрику и порог «достаточно хорошо», затем улучшаем по одному изменению за раз, чтобы каждый шаг давал измеримый эффект.

Самый частый сюрприз в задачах зрения: качество датасета почти всегда важнее «умной» архитектуры. Если в разметке плавают классы, часть фото темнее, чем в проде, а часть снята на другой объектив, модель выучит этот шум. Можно неделями тюнить слои и оптимизаторы, получать косметический выигрыш, а затем потерять его на реальных данных.

Хороший инженерный прием - сначала стабилизировать вход. Если вы делаете детектор брака по фото товара, прежде чем менять модель, договоритесь о простых правилах съемки (фон, расстояние, освещение). Проверьте, что разметчики одинаково понимают «царапину». И заведите отчет по ошибкам: какие типы снимков ломают качество.

Вывод здесь прямой: сначала приводим в порядок данные и измерение, затем улучшаем модель. Так вы быстрее понимаете, что реально помогает, и меньше рискуете выпустить фичу, которая работает только в лабораторных условиях.

Сильная сторона Карпати - умение превращать сложную тему в маленький работающий прототип. В задачах про последовательности (текст, код, временные ряды) это особенно важно: такие модели легко выглядят как «магия», пока вы не сделаете простой пример и не увидите, где именно он ошибается.

Маленький прототип полезен не тем, что «почти решает задачу», а тем, что быстро дает сигнал. Он заставляет пройти базовый цикл: выбрать цель, собрать минимальные данные, обучить, измерить, понять провал, поправить гипотезу. Этот цикл лучше пройти за день, чем месяц обсуждать архитектуру.

Демо еще и меняет разговор внутри команды. Когда есть маленькая штука, которая принимает вход и возвращает ответ, обсуждение становится предметным: «на этих 200 примерах точность 78%, а на длинных сообщениях падает до 40%». Так появляется AI-инженерная культура, где решения принимаются по наблюдениям.

Чтобы короткий эксперимент был честным, достаточно нескольких вещей: одна ясная задача, один простой вариант для сравнения (шаблоны или поиск по базе), маленький набор тестов и метрика, явные допущения и итоговое решение (продолжать, менять подход или остановиться).

Уроки Карпати для AI-инженеров часто звучат просто: ценность дает не «самая умная» нейросеть, а команда, которая может повторить результат, объяснить его и довести до пользователя. Модель без понятного процесса быстро превращается в набор удачных случайностей.

Полезная привычка - фиксировать наблюдения как инженерные факты. Не «кажется, стало лучше», а что именно изменили, на каких данных, какой сигнал ожидали увидеть и что получилось. Через месяц это спасает от кругов по тем же идеям и споров на уровне вкуса.

Чтобы скорость команды не зависела от героизма отдельных людей, нужны простые, но обязательные артефакты.

Во-первых, версии данных и разметки: что именно было в обучении и валидации.

Во-вторых, воспроизводимый запуск: конфиги, сиды, окружение, понятная команда запуска.

В-третьих, короткий отчет по эксперименту: цель, изменение, метрики, вывод.

В-четвертых, лог изменений в пайплайне: что сломали и как починили.

Понятный пайплайн ускоряет сильнее, чем «ночной подвиг». Если новичок может за день прогнать обучение и получить те же метрики, команда растет без узких мест. И проще расследовать инциденты: откуда взялся регресс, какой коммит данных его принес, на каких классах ошибок стало больше.

Представьте, вы добавляете автоклассификацию обращений в поддержку. Если нет версий данных и отчета, вы не сможете честно ответить: качество реально улучшилось или просто поменялось распределение запросов на неделе.

В исследованиях победа выглядит просто: модель в ноутбуке дает красивую метрику на тестовом датасете. В продукте победа другая: функция работает каждый день, для разных людей и входов, не ломает остальную систему и стоит приемлемых денег.

Главная поломка при переносе - вы начинаете отвечать не на вопрос «насколько умная модель», а на вопрос «насколько надежна услуга». И тут всплывают ограничения, которые в ноутбуке не мешали: задержка, стоимость, надежность, приватность, совместимость.

Вторая поломка - «грязные» входы. В продукте люди загружают размытые фото, пишут с ошибками, шлют пустые поля, пытаются обмануть систему. Если не продумать это заранее, качество будет выглядеть случайным, даже если модель сильная.

Поэтому нужны деградационные режимы: заранее заданное поведение при ошибках и плохих данных. Самый простой набор: вернуть «не уверен» и попросить уточнить, включить ручной ввод ниже порога уверенности, сделать фолбэк на более простое правило или более дешевую модель, добавить повторную попытку с лимитами по времени и бюджету.

Хороший продуктовый перенос начинается с одного документа: выпишите допущения (какие входы нормальны, какая задержка допустима, какая цена запроса) и заранее решите, что система делает, когда эти допущения нарушены.

Практичность, за которую ценят Карпати, начинается не с «более умной модели», а с понятного контракта: что пользователь получает на выходе, в каких условиях и как вы поймете, что это работает.

Не формулируйте задачу как «сделать лучше рекомендации». Описывайте измеримый выход: «сформировать краткое резюме на 5 пунктов», «подсветить 3 риска», «сгенерировать черновик ответа в 120-200 слов». Выход должен быть проверяемым, чтобы два человека могли согласиться, хорошо или плохо.

AI-фичи ломаются не от математики, а от контекста. Запишите, на чем держится решение: какие данные доступны, какой язык и тон ожидаются, какие входы считаются нормальными, что делать с пустыми или странными запросами, какие ограничения важны (время ответа, стоимость, приватность).

Удобно собрать план в пять шагов: описать формат результата, прописать допущения и ограничения, развести метрики модели и метрики продукта, установить пороги допуска к релизу, подготовить сбор обратной связи и мониторинг после запуска.

Не путайте «качество модели» (точность на тесте, доля правильных ответов по ручной разметке) и «качество продукта» (конверсия, удержание, время до результата, доля повторных попыток). Порог релиза должен быть известен заранее и выражен числами: «ошибки критического типа не больше X%», «время ответа не выше Y секунд», «не менее Z% пользователей принимают результат без правок».

После запуска договоритесь, какие сигналы смотрите регулярно: долю жалоб и отказов, рост ручных правок, частоту «непонятных» запросов, дрейф данных, стоимость на запрос и задержку. Так AI-фича становится инженерным продуктом: с допущениями, измерением и понятными решениями, что делать дальше.

Когда команда спорит про качество модели, часто спорят не про цифры, а про ожидания. Инженерный подход простой: сначала договориться, что считается успехом и чем вы это меряете.

Метрика начинается не с формулы, а с цены ошибки. Для поиска по базе знаний обычно важнее не пропустить правильный ответ, а для антифрода важнее не заблокировать хорошего пользователя. Решение принимается вместе с теми, кто потом будет жить с последствиями: поддержкой, модерацией, юристами.

Чтобы не обманывать себя, нужна базовая линия: то, что работает уже сегодня. Это может быть правило или простая эвристика (регулярки, словарь), простая модель без сложной архитектуры, или человек как ориентир по качеству и стоимости.

Средняя метрика часто прячет провалы. Делайте срезы по типам запросов, устройствам, длине текста, языку, новым и старым пользователям. Модель может быть «в целом хорошей», но стабильно хуже на одной группе - и именно там появятся жалобы.

В проде измерения не заканчиваются. Следите за дрейфом данных, долей отказов (пустой ответ, таймаут, фолбэк), латентностью, стоимостью и долей ручных исправлений. Если мониторинга нет, «успех на тесте» ничего не гарантирует: мир меняется, данные меняются, и модель начинает ошибаться тихо и дорого.

Самая частая ловушка - принять красивую демку за готовый продукт. Модель может выглядеть «умной» на нескольких примерах, но развалиться в реальном потоке: другие формулировки, шумные данные, новые устройства, нестандартные пользователи.

Полезно относиться к модели как к части системы, а не как к магии. Ошибки обычно не в «плохой нейросети», а в том, как сформулировали задачу, собрали данные и настроили контроль качества.

Чаще всего релиз тормозят или приводят к откату такие вещи: прототип делают «чтобы впечатлить», но не проверяют на реальных входах и под нагрузкой; допущения не фиксируют и незаметно меняют задачу по ходу экспериментов; смотрят на одну среднюю метрику и пропускают редкие, но болезненные провалы; запускают без страховки (нет безопасного режима, порога уверенности и быстрого отката); собирают данные «как получится» и потом не могут найти причину падения качества.

Простой пример: вы добавляете AI-помощника в поддержку. Если измерять только среднюю оценку ответа, можно не заметить, что 1% запросов приводит к уверенным, но неправильным рекомендациям. Поэтому заранее определите критические категории, заведите отдельные метрики по ним и продумайте, что система делает, когда «не уверена».

Перед релизом AI-фичи полезно на минуту переключиться из режима «доделаем еще чуть-чуть» в режим инженера, который отвечает за результат. Идея в том, чтобы приземлить нейросети до проверяемых обещаний: что именно система делает, при каких условиях и как вы поймете, что она работает.

Пять пунктов, которые хорошо отрезвляют перед запуском:

Представьте продукт с поддержкой в чате: 10-15 операторов, сотни обращений в день, часть вопросов повторяется. Команда хочет добавить AI-помощника, но не «умного собеседника», а инструмент, который дает измеримую пользу и не ломает доверие.

Сначала фиксируют, что именно выходит из модели. Не «помогает отвечать», а конкретные поля, которые можно проверить и улучшать: категория запроса (например, оплата, доступ, баг, возврат), черновик ответа в нужном тоне (коротко, без обещаний) и оценка уверенности с понятной причиной, если уверенность низкая.

Дальше выписывают критичные допущения, потому что они определяют границы риска: язык только русский; тон нейтральный и без шуток; запреты на юридические советы и компенсации; факты брать только из утвержденной базы ответов, иначе помечать «нужно уточнение».

Метрики выбирают так, чтобы спорить цифрами. Для классификации смотрят точность по классам, потому что редкие категории часто самые дорогие. Для ответов в целом считают долю эскалаций к человеку и время первого ответа. Отдельно считают долю «опасных» случаев, когда модель нарушила запрет.

Раскатка идет по ступеням, чтобы ошибки были дешевыми: пилот на одном типе обращений, режим «черновик только для оператора», сбор ошибок с разметкой причин, затем расширение на новые категории после улучшения базы и подсказок.

Чтобы подход Карпати работал в продукте, нужен маленький, но повторяемый ритуал: выбираем задачу, фиксируем допущения, меряем результат, делаем безопасный релиз. Меньше споров о «крутизне» модели, больше фактов.

Начните с 1-2 функций, где эффект можно посчитать: автоподсказки в форме (время заполнения), разбор обращений в поддержку (время первого ответа), поиск по базе знаний (доля решенных кейсов).

Помогает короткий документ на одну страницу: цель, допущения, метрики и базовая линия, план релиза (сегмент, сроки, мониторинг, критерии остановки), риски и откат. Затем сузьте объем до одного сценария, одного сегмента и одного канала. Сразу подготовьте откат: фича-флаг, переключатель на старое поведение, запасной маршрут без модели.

Если вы делаете прототипы и внутренние инструменты через TakProsto, удобно закладывать эти же принципы с самого начала: план изменений, быстрые проверки гипотез и возможность вернуться к предыдущему состоянию проекта. Платформа TakProsto (takprosto.ai) как раз рассчитана на сборку веб, серверных и мобильных приложений через чат, поэтому первые версии можно получить быстро, а дальше улучшать уже по метрикам.

Закрепите практику как привычку: каждую AI-фичу начинать с измеримых обещаний и базовой линии, а заканчивать выводами по фактам и списком следующих проверок.

Полезен тем, что показывает инженерный подход к ML: ясная постановка задачи, базовая линия, измеримые метрики, разбор ошибок и воспроизводимые эксперименты. Это помогает выпускать функции, которые стабильно работают в продукте, а не только в ноутбуке.

Сформулируйте выход как проверяемый артефакт: например, «категория тикета из 12 классов», «резюме на 5 пунктов», «черновик ответа 120–200 слов». Затем заранее задайте критерии приемки: что считается хорошим результатом и какие ошибки недопустимы.

Минимальный набор:

Начните с простой «базовой линии», которая уже дает пользу: правила, словарь, поиск по базе, простая модель. База нужна, чтобы честно отвечать на вопрос «мы реально улучшили систему или просто усложнили ее».

Выбирайте метрику от цены ошибки.

Обязательно добавьте срезы: по типам запросов, длине текста, устройствам, редким классам — средняя метрика часто скрывает провалы.

Потому что часто проблема не в модели, а во входе: разная съемка, «плавающая» разметка, другой контраст, новые устройства. Сначала стабилизируйте данные: правила съемки/сбора, единые инструкции разметчикам, отчет по типам ошибок. Уже потом имеет смысл тюнить архитектуру.

Сделайте короткий цикл за 1–2 дня:

Ценность прототипа — быстро получить сигнал, а не «почти решить задачу».

Добавьте деградационные режимы:

Так вы защищаете продукт от редких, но дорогих ошибок.

Минимальные артефакты:

Это снижает зависимость от «героев» и ускоряет расследование проблем.

Для начала удобно собрать пилот в режиме «черновик для оператора», фича-флаг, мониторинг и быстрый откат. В TakProsto можно быстро собрать веб/бэкенд/мобайл-обвязку вокруг модели через чат, а затем улучшать по метрикам: фиксировать допущения, хранить снимки состояния проекта и откатываться при регрессах.