19 окт. 2025 г.·8 мин

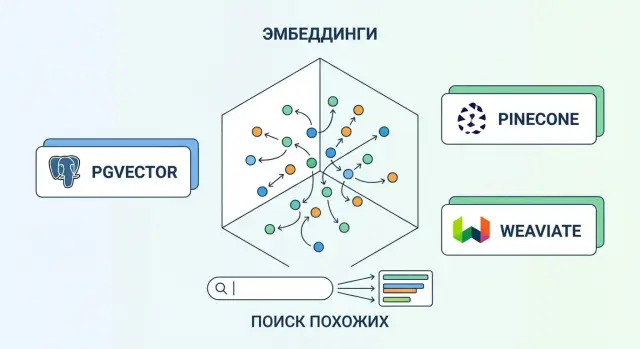

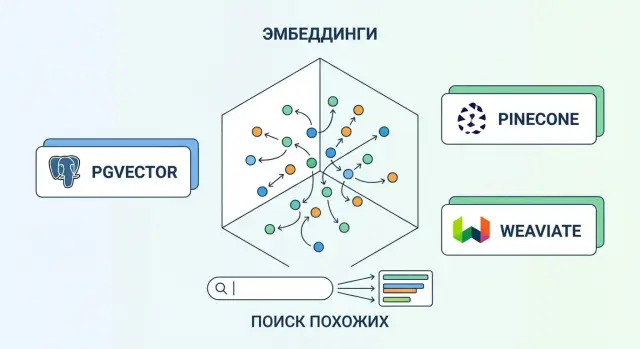

Векторные базы данных: pgvector, Pinecone и Weaviate

Что такое векторная БД: хранение эмбеддингов и поиск похожих объектов. Сравниваем pgvector, Pinecone и Weaviate и помогаем выбрать вариант.

Что такое векторная БД: хранение эмбеддингов и поиск похожих объектов. Сравниваем pgvector, Pinecone и Weaviate и помогаем выбрать вариант.

Векторная база данных — это хранилище, в котором данные представлены не только «как есть» (текст, картинка, товар), но и в виде числовых векторов — эмбеддингов. Такие векторы можно сравнивать между собой и быстро находить «похожие» объекты: не по совпадению слов, а по смыслу.

Проще говоря, векторная БД отвечает на вопросы вида: «покажи то, что максимально похоже на этот запрос/документ/изображение», и делает это эффективно даже на больших объёмах данных.

Обычные методы поиска в SQL чаще всего опираются на совпадение символов и слов:

LIKE ищет подстроки (удобно для точных фрагментов, но плохо понимает смысл).Векторный поиск сравнивает эмбеддинги и находит близкие по «направлению» и «расстоянию» представления. Поэтому запрос «как вернуть товар» может находить документы, где нет этих слов, но описаны возврат и условия.

Чаще всего векторные базы используют для:

Если у вас маленький объём данных, достаточно точного поиска по атрибутам (фильтры, категории, даты) или важно строгое совпадение терминов (артикулы, номера договоров), то векторная БД может быть лишней.

Также она не заменяет обычную БД: транзакции, отчёты и сложные связи по-прежнему удобнее хранить и обрабатывать в реляционной модели.

Эмбеддинг — это «упаковка смысла» объекта (фразы, изображения, аудио) в набор чисел, то есть вектор. Модель берёт исходные данные и превращает их в компактное представление, которое удобно сравнивать и искать.

Для текста модель читает предложение целиком и выдаёт один вектор на фразу/абзац (или на каждый фрагмент, если вы режете документ на куски). Для изображений работает похожий принцип: нейросеть смотрит на картинку и кодирует её содержание (объекты, стиль, композицию) в вектор.

Для аудио обычно сначала строят представление звучания (интонации, фонемы, тембр) и тоже превращают его в вектор; иногда аудио дополнительно транскрибируют в текст и считают текстовый эмбеддинг.

Модели обучают так, чтобы похожие по смыслу примеры оказывались рядом, а разные — далеко. Например, «как вернуть товар» будет ближе к «оформить возврат», чем к «поменять пароль».

Поэтому, когда вы ищете ближайшие векторы, вы фактически находите объекты с похожим смыслом, даже если слова не совпадают.

Размерность — это длина вектора (например, 384, 768, 1536). Чем она больше, тем точнее модель может «разложить» смысл по признакам, но тем больше памяти нужно хранить данные и тем тяжелее вычисления при поиске.

На практике размерность задана моделью эмбеддингов, а качество проверяют на своих примерах.

Нормализация — это приведение векторов к одинаковой длине (обычно к 1). Она важна, когда вы используете метрики, чувствительные к масштабу.

Например, для cosine similarity часто нормализуют векторы, чтобы сравнение отражало именно направление (смысл), а не «величину» вектора. Это делает результаты стабильнее и снижает число неожиданностей при смешанных данных.

Идея простая: каждый объект (текст, картинка, товар, документ) превращается в набор чисел — вектор. Дальше мы ищем не «точное совпадение слов», а ближайшие векторы: чем они ближе в выбранной метрике, тем более похожими считаются объекты.

kNN (k-nearest neighbors) — точный поиск ближайших соседей. Он просматривает много кандидатов и гарантирует, что вы действительно нашли топ‑k самых близких. Минус: при больших объёмах данных это может быть медленно.

ANN (approximate nearest neighbors) — приближённый поиск. Он быстрее, потому что «умно» отбирает кандидатов и не перебирает всё. Цена скорости — иногда он пропускает часть идеальных соседей.

На практике почти все системы на больших коллекциях используют ANN: пользователю важнее получить ответ за десятки миллисекунд, чем математически идеальный топ‑k.

Векторная БД должна понимать, как считать расстояние/сходство:

Важно: метрику обычно выбирают не «по вкусу», а под конкретные эмбеддинги и задачу.

Чтобы ANN был быстрым, строят индекс:

Компромисс везде один: скорость vs качество.

Ключевые ручки настройки:

Хорошая настройка — это не максимальные значения, а стабильный баланс под ваш SLA и качество ответа в продукте.

Чтобы векторный поиск был полезным в продукте, одной «таблицы с векторами» недостаточно. Почти всегда запись в векторной базе состоит из трёх частей: вектор, метаданные и исходный объект (или ссылка на него).

Такой подход помогает разделить ответственность: векторная БД отвечает за поиск, а «источник правды» — за хранение полнотекстового контента и бизнес-логику.

Один из самых частых запросов: «найди похожее, но только среди моих документов», «только за последний месяц», «только на русском», «только в категории X». Поэтому важно, чтобы система поддерживала фильтр по метаданным одновременно с поиском по похожести.

Практическое правило: метаданные лучше делать как можно более предсказуемыми (типы, формат дат, нормализованные значения), иначе фильтры начнут «промахиваться» и усложнят отладку.

В реальных задачах часто нужен гибридный поиск: классический текстовый (BM25/полнотекстовый поиск) хорошо ловит точные термины и редкие слова, а векторный — смысловые перефразирования.

Комбинация особенно полезна, когда в запросе есть артикулы, имена или точные формулировки, которые важно не «размыть» семантикой.

Контент меняется: документ перезаписали, доступ отозвали, кусок текста удалили. Это означает, что нужно обновить или удалить соответствующие векторы.

Сложность в том, что один документ часто превращают в несколько фрагментов (chunks) — значит, придётся управлять множеством записей по одному исходному ID.

Хорошая практика — хранить в метаданных: document_id, chunk_id, версию, время индексации и признаки доступа. Тогда массовые удаления/переиндексация становятся управляемыми, а не ручной «охотой» за устаревшими векторами.

Векторная база данных особенно полезна там, где «точное совпадение» не работает: запрос сформулирован по‑разному, в тексте есть синонимы, опечатки или смысл выражен косвенно. Вместо поиска по ключевым словам система сравнивает эмбеддинги и находит ближайших соседей по смыслу.

Самый частый сценарий: у вас есть инструкции, политики, тикеты, заметки, статьи — и нужно быстро находить релевантные фрагменты.

Практика: документы режут на небольшие куски (chunks), строят эмбеддинги и сохраняют вместе с метаданными (раздел, дата, продукт, язык). Тогда запрос «как восстановить доступ» найдёт ответ, даже если в тексте написано «сброс пароля».

Векторный поиск помогает делать рекомендации без сложной ручной разметки. Вы можете сравнивать:

Это удобно для блоков «Похожие товары», «Читайте также», «Похожие инциденты» — особенно когда каталог или база кейсов постоянно меняется.

Если данные приходят из разных источников, часто появляются дубликаты: один и тот же клиент, компания, документ или задача, но записаны по‑разному. Поиск ближайших соседей помогает находить кандидатов на дубль и объединять их.

Кластеризация по векторам полезна и для аналитики: выделить повторяющиеся темы в отзывах, сгруппировать запросы в поддержку, понять, какие проблемы «болят» чаще.

RAG (Retrieval-Augmented Generation) — это когда перед ответом LLM вы сначала находите релевантные фрагменты в базе знаний, а затем просите модель ответить, опираясь на найденный контекст.

Плюсы: меньше галлюцинаций, проще обновлять знания (достаточно переиндексировать документы), можно ограничивать выдачу фильтрами по метаданным (например, «только актуальные политики» или «только для продукта X»).

Практический момент для команд в РФ: в RAG важны не только качество и задержки, но и контур данных (где крутятся модели и где хранятся векторы). Например, в TakProsto.AI такие сценарии можно быстрее собрать в формате «vibe-coding»: от чата — к рабочему веб-приложению с поиском по базе знаний, при этом код экспортируемый, а инфраструктура и модели развёрнуты на серверах в России.

pgvector — это расширение для PostgreSQL, которое добавляет тип данных vector и функции для поиска по похожести. Идея простая: вы храните эмбеддинги прямо в обычных таблицах, рядом с привычными полями (id, текст, даты, статусы), и выполняете запросы через SQL.

Обычно схема напоминает классическую таблицу документов, только с дополнительной колонкой для вектора:

CREATE EXTENSION IF NOT EXISTS vector;

CREATE TABLE docs (

id bigserial PRIMARY KEY,

title text,

body text,

embedding vector(1536),

created_at timestamptz default now()

);

Дальше вы можете сортировать результаты по близости к запросному вектору и получать топ‑N совпадений. Важный плюс: метаданные и векторы живут вместе, поэтому фильтрация (например, по дате, языку, типу документа, правам доступа) делается обычным WHERE.

pgvector часто выбирают за прагматичность:

pgvector — не «магическая кнопка ускорения» для любого масштаба. На практике ограничения проявляются так:

pgvector обычно выигрывает, когда нужен быстрый старт и простая эксплуатация: малые/средние проекты, пилоты RAG, внутренний поиск по базе знаний, приложения, где Postgres уже центральное хранилище, а объём векторов пока не измеряется сотнями миллионов.

Отдельный плюс для продуктовых команд: если ваш бэкенд и так на Postgres, то прототип семантического поиска можно поднять без отдельной платформы. В TakProsto.AI такой подход тоже часто оказывается самым быстрым, потому что типовой стек включает Go + PostgreSQL, и векторный слой можно «приземлить» рядом с остальными таблицами.

Pinecone — это управляемая векторная база данных (vector database), которую вы используете как облачный сервис: без установки, настройки кластеров и постоянного «дежурства» по инфраструктуре. Вы создаёте индекс, загружаете эмбеддинги и метаданные, а дальше выполняете семантический поиск и поиск ближайших соседей через API.

Главная ценность — эксплуатация почти «из коробки». Pinecone берёт на себя типичные задачи, которые в self-hosted вариантах требуют времени и компетенций: масштабирование под нагрузку, управление ресурсами, обновления сервиса и стабильную доступность.

Это удобно, когда важнее скорость запуска RAG/поиска по похожести, чем тонкая настройка железа и индексов. Команда может сосредоточиться на качестве эмбеддингов, структуре метаданных и логике выдачи, а не на обслуживании базы.

Перед тем как «закрепиться» на Pinecone, полезно заранее проверить несколько пунктов:

Pinecone особенно хорош, когда трафик непредсказуемый или быстро растёт: поддержка пользователей 24/7, поиск по базе знаний, рекомендации, RAG для поддержки клиентов. Если вы ожидаете резкие всплески запросов (например, маркетинговые кампании), управляемый сервис часто снижает риск «упасть» и ускоряет масштабирование без переделки архитектуры.

Weaviate — это самостоятельная векторная платформа, которая запускается как отдельный сервер или кластер. Его часто выбирают, когда хочется отделить векторный поиск от основной транзакционной базы и при этом сохранить контроль над инфраструктурой. Разворачивать можно самостоятельно (например, в Kubernetes) или использовать облачные варианты Weaviate Cloud Service.

В Weaviate данные организованы через классы (по сути — коллекции) и схему: вы заранее описываете, какие объекты храните и какие у них свойства. Помимо вектора, у каждого объекта есть метаданные (поля), по которым удобно фильтровать и строить более «бизнесовые» запросы: тип документа, язык, дата, источник, права доступа и т. п.

Важно, что метаданные — не просто «прицеп» к вектору: они участвуют в запросе наравне с похожестью, помогая отсекать нерелевантное ещё до ранжирования.

Типичный запрос в Weaviate — это поиск по похожести (nearest neighbors) с дополнительными фильтрами по метаданным. Например: «найди похожие фрагменты, но только из раздела “Договоры” и только за 2024 год». Платформа поддерживает разные варианты индексации для приближённого поиска ближайших соседей (ANN), что позволяет получать ответы быстро даже на больших объёмах.

Weaviate хорош, когда нужен:

Если вам важно держать векторный слой как отдельный сервис с понятной структурой данных — Weaviate часто оказывается комфортным компромиссом между «всё внутри PostgreSQL» и полностью управляемым SaaS.

Выбор векторной БД обычно упирается не в «у кого лучше поиск», а в ваши ограничения: объём данных, нагрузку, требования к надёжности и то, кто будет всё это сопровождать.

Если у вас умеренный объём эмбеддингов и запросов, а данные часто нужны вместе с привычными таблицами (пользователи, заказы, права), pgvector часто оказывается самым прямым путём: один PostgreSQL, один стек, одна модель доступа.

Если ожидаются высокие QPS и жёсткие требования по задержке, а векторный поиск — отдельный критичный сервис, проще смотреть в сторону Pinecone (как управляемого сервиса) или Weaviate (как отдельной платформы, которую можно держать у себя).

Также оцените частоту обновлений: при постоянных upsert/удалениях и «живом» каталоге важно, насколько удобно поддерживать индексы и пересборки, и какой SLA по деградациям во время обслуживания.

Pinecone снимает большую часть рутины: масштабирование, мониторинг, обновления. Вы платите деньгами, но экономите время команды.

pgvector — это ваши привычные бэкапы/репликации/миграции PostgreSQL, но ответственность за производительность векторных индексов и настройки остаётся на вас.

Weaviate требует дисциплины как у отдельного кластера: бэкапы, наблюдаемость, обновления, планирование ресурсов. Зато больше контроля над окружением.

Если критична изоляция (регуляторика, чувствительные данные), часто выбирают pgvector (внутри существующего контура) или Weaviate on‑prem.

Для облачного сервиса (Pinecone) заранее проверьте: шифрование «на платформе», модель доступов, аудит, регионы, требования к ключам и журналированию.

Если у вас есть жёсткое требование «данные не покидают РФ», продумайте это заранее на уровне всей цепочки: где считаются эмбеддинги, где хранится индекс, где работает LLM. В российских контурах иногда удобнее стартовать с локальной инфраструктуры и/или платформ, которые изначально развёрнуты в РФ (в том числе TakProsto.AI, где используются локализованные и open-source LLM-модели и российские серверы).

Есть сильная SQL‑экспертиза и уже живой PostgreSQL — pgvector обычно даёт минимум трения.

Нужно быстро запустить семантический поиск/RAG без отдельной SRE‑нагрузки — Pinecone часто самый быстрый старт.

Готовы держать отдельную платформу ради гибкости и контроля — смотрите на Weaviate.

Практика: сначала зафиксируйте целевые метрики (QPS, p95 latency, объём, SLA), а затем сделайте маленький POC на ваших данных — он быстрее выявит реальную стоимость и «узкие места», чем сравнение по описаниям.

Когда выбирают векторную БД, чаще всего спорят про «быстрее/точнее». Но на практике важнее другое: как система ведёт себя на ваших данных, при ваших фильтрах и при вашей нагрузке.

Одинаковая конфигурация может давать разные результаты на разных коллекциях: длина текстов, язык, структура документов, доля «шумных» записей, наличие метаданных. Поэтому ориентируйтесь не на «среднюю скорость» из обзоров, а на мини-бенчмарк:

Важно: фильтры по метаданным нередко «съедают» больше времени, чем сам поиск ближайших соседей.

Хранение — это не только сами векторы. Индекс приближённого поиска может занимать сопоставимый объём, а метаданные (тексты, идентификаторы, теги) иногда растут быстрее векторов.

Планируйте запас по памяти/диску и продумайте, где хранится «полный текст»: внутри БД или во внешнем хранилище с ссылкой.

Считайте бюджет по компонентам:

Слишком большие чанки: модель «размывает» смысл, и top‑k становится менее точным.

Плохие фильтры: либо их нет (мусор в выдаче), либо они слишком узкие (почти нечего искать), либо фильтрация сделана так, что тормозит каждый запрос.

Неверная метрика похожести: разные эмбеддинги ожидают разные подходы (часто используют cosine similarity, но не всегда). Если метрика не соответствует модели, качество падает без очевидных причин.

Отсутствие мониторинга: без p95, процента пустых результатов и качества на контрольной выборке вы не заметите деградацию после обновления данных или модели.

Сначала зафиксируйте «источник истины»: статьи базы знаний, тикеты, PDF, карточки товаров, переписки. Важно привести всё к одному формату текста и убрать шум: дубли, пустые страницы, служебные шапки/футеры, повторяющиеся навигационные блоки.

Дальше определите, какие метаданные понадобятся для фильтров: язык, продукт, версия документа, дата, доступ (роль), тип источника. Метаданные лучше продумать до загрузки — потом миграция бывает болезненной.

Разбивайте документы на небольшие смысловые куски: абзацы, разделы, «вопрос–ответ». Слишком длинные фрагменты ухудшают точность, слишком короткие теряют контекст.

Часто помогает небольшое перекрытие между фрагментами (overlap), чтобы важная фраза не «резалась» пополам.

Выберите модель эмбеддингов и зафиксируйте её версию. Любая смена модели означает, что индекс нужно пересчитать.

Нормализуйте текст одинаково для индексации и для запросов (регистр, пробелы, языковые особенности).

Шаги пайплайна: подготовка данных → разбиение на фрагменты → эмбеддинги → загрузка. Сразу храните связку: id фрагмента, текст, вектор, метаданные, ссылка на оригинал.

Минимум состоит из трёх частей: индексирование (ingestion), retrieval (поиск top-k), сбор контекста (объединение найденных фрагментов и передача в LLM).

На этом этапе заранее решите: сколько фрагментов брать, как удалять дубликаты, что делать с конфликтующими источниками.

Если делаете это в прикладном продукте, удобно иметь «режим планирования» и быстрые откаты изменений пайплайна (настройки чанков, k, фильтров, промпта). В TakProsto.AI для таких итераций полезны snapshots и rollback: можно быстро проверить гипотезу и вернуться к стабильной версии без ручной возни с окружениями.

Начните с ручных примеров: 20–50 типовых запросов и «ожидаемые» документы. Затем добавьте метрики (например, доля запросов, где нужный источник попал в top‑k) и A/B для выдачи: сравнивайте разные настройки chunking, k, фильтры и модель эмбеддингов.

Логируйте: исходный запрос, применённые фильтры, top‑k результаты, расстояния/score, какие фрагменты ушли в контекст, а также клики/оценки пользователей. Эти данные быстро покажут, что ломается — индекс, фильтры, качество эмбеддингов или сбор контекста.

Чаще всего — отдельно. Векторная БД хорошо хранит вектор + идентификатор + метаданные (например, doc_id, раздел, язык, даты, права доступа), а сам текст и «источник правды» остаются в вашем хранилище: PostgreSQL, S3/объектное хранилище, CMS, документооборот.

Хранить текст в векторной БД удобно для быстрого прототипа и простого RAG, но это может осложнить:

Практика: кладите в векторную БД короткий snippet (1–3 предложения) для превью, а полный текст подтягивайте по doc_id.

Смена модели почти всегда означает, что старые и новые векторы нельзя смешивать: у них разные «координаты смысла».

Делайте миграцию через версионирование:

Если нужно обновляться без простоя — держите две версии параллельно и постепенно переводите трафик.

Обычно лучше начинать с 300–800 токенов на чанк (или 1–3 абзаца) с небольшим overlap. Слишком маленькие чанки теряют контекст, слишком большие ухудшают точность и увеличивают стоимость.

Проверяйте на своих запросах: цель — чтобы один найденный чанк содержал достаточно информации для ответа без «склейки» из десятка фрагментов.

Да, если у вас:

Векторная база данных нужна, когда пользователи формулируют запросы по-разному, есть синонимы и «похожий смысл», а также когда вы строите RAG и хотите доставать релевантные фрагменты даже без совпадения ключевых слов.

Векторная БД оптимизирована под поиск по похожести: вы храните эмбеддинги и быстро находите ближайшие векторы (семантически похожие тексты/картинки/товары).

Обычная SQL‑БД (LIKE/FTS) в основном ищет совпадения слов и символов. Поэтому векторный поиск лучше справляется с перефразированиями и синонимами, но не заменяет реляционную модель для транзакций, отчётов и связей.

Чаще всего — когда нужен поиск «по смыслу»:

Если запросы сильно варьируются по формулировкам, векторный слой обычно даёт заметный выигрыш.

Да, часто достаточно FTS/BM25 и фильтров, если:

Практичный компромисс — гибридный поиск: FTS ловит точные термины, векторы — смысловые перефразирования.

Эмбеддинг — это числовой вектор, который «кодирует смысл» объекта (фразы, абзаца, изображения, аудио). Модель обучают так, чтобы похожие по смыслу объекты имели близкие векторы.

В результате запрос «как вернуть товар» может находить фрагменты про «оформить возврат», даже если слова не совпадают.

Зависит от модели: текстовые эмбеддинги часто используют cosine similarity, потому что важнее направление вектора (смысл), чем его длина.

Практика такая:

kNN — точный поиск ближайших соседей, но на больших объёмах может быть медленным.

ANN — приближённый поиск: быстрее, потому что перебирает не всё пространство, но может пропустить часть «идеального» топ‑k.

В продуктовых сценариях чаще выбирают ANN (HNSW/IVF), потому что важнее задержка (latency) и стабильная работа под нагрузкой.

Типичная запись — это три части:

Часто в векторной БД хранят только ID и короткий snippet, а полный текст остаётся в «источнике истины» (PostgreSQL/S3/CMS).

Потому что «похожее» почти всегда должно быть ещё и разрешённым/актуальным/в нужном срезе: только мои документы, только RU, только за период, только продукт X.

Чтобы фильтры работали предсказуемо:

Обычно один документ превращают в множество chunks, поэтому обновление/удаление — это массовые операции по группе записей.

Хорошая практика:

document_id, chunk_id, версию и время индексации;Ориентируйтесь на ограничения и эксплуатацию:

WHERE. Хорош для пилотов и умеренных объёмов.Практично зафиксировать цели (QPS, p95, объём, SLA) и сделать небольшой POC на своих данных.

document_idmodel_version и переиндексировать в новую коллекцию/таблицу.